Команда VK Cloud перевела статью о том, что ждет дата-инжиниринг в новом 2023 году. Предсказания на грядущий год редко претендуют на серьезность, но и у них есть своя цель. Они помогают нам отвлечься от повседневности и задуматься о том, на что стоит ставить в долгосрочной перспективе.

Зачем вообще нужны прогнозы

Когда мы прогнозируем, мы пытаемся нарисовать согласованную общую картину отрасли, которая быстро развивается в разных направлениях. Попробуйте найти хотя бы одну отрасль, в которой нужно прилагать больше усилий, чтобы оставаться на плаву, чем при работе с данными.

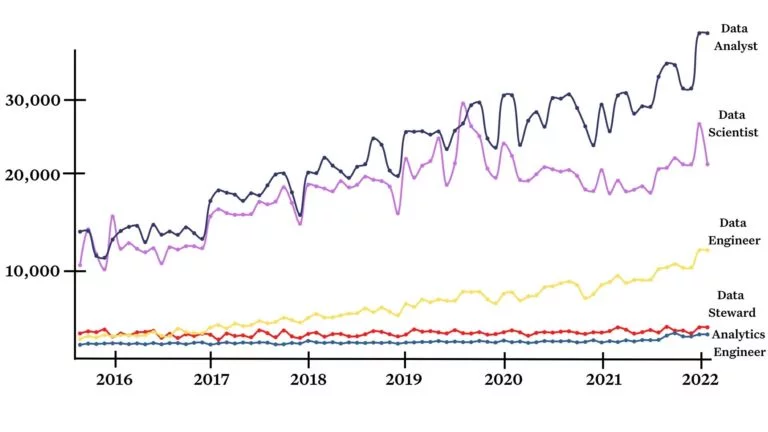

Количество запросов о разных профессиях, связанных с данными, за последние шесть лет. Составлено с использованием данных ahrefs и Монте-Карло

Компании, работающие с данными, сейчас расставляют и периодически меняют приоритеты в свете надвигающегося спада. Это позволяет воспринимать разные направления дата-инжиниринга более осмысленно. При этом именно от ваших инвестиций в эту сферу зависит конкурентоспособность, гибкость и инновационность вашей компании.

Есть ли хорошие новости? По моим прогнозам, 2023-й станет звездным годом для технологий, которые помогают специалистам увеличивать прибыль, экономить время и ресурсы на DataOps. Благодаря этим решениям инженеры смогут всерьез заняться созданием, масштабированием и повышением эффективности.

Вот мои прогнозы самых важных тенденций следующего года в несколько хаотичной последовательности.

Прогноз № 1: команды дата-инженеров будут тратить больше времени на FinOps и оптимизацию расходов на Data Cloud

По моим прогнозам, чем больше операций с данными переезжает в облако, тем больше средств компании будут тратить на облачные решения и тем строже к этим расходам станут относиться финансовые отделы.

В макроэкономической среде виден переход от быстрого роста доходов к более сдержанным акцентам на оптимизацию и рентабельность. Финансовые специалисты все активнее сотрудничают с командами по работе с данными, и разумно предположить, что это сотрудничество распространится и на сферу текущих расходов.

Команды по работе с данными должны прежде всего увеличивать ценность бизнеса, выступая мультипликатором силы для эффективности других отд��лов и повышая доходы с помощью монетизации данных. Однако оптимизация расходов станет более важным направлением работы.

В этой области передовые методы еще только формируются. Стремясь выполнить предъявляемые к ним чрезмерно жесткие требования, команды дата-инженеров сосредоточились на скорости и гибкости. Большую часть времени они занимаются составлением новых запросов или подключением новых источников данных, а не оптимизацией слишком объемных или усложняющихся запросов.

Оптимизация расходов на Data Cloud также отвечает основным интересам поставщиков хранилищ и озер данных. Они хотят, чтобы потребление росло, но неэффективное использование ведет к оттоку клиентов. Они предпочли бы рост потребления за счет продвинутых кейсов, таких как дата-приложения, которые создают ценность для клиента, а потому улучшают удержание заказчиков.

Если присмотреться, остальные крупные компании — BigQuery, RedShift, Snowflake — тоже продвигают передовые методы работы и функции, связанные с оптимизацией.

Видимо, увеличение времязатрат связано с ростом количества сотрудников, непосредственно занимающихся ROI. Этот рост трудочасов легко объясняется тем, что сотрудники становятся объектом повышенного внимания. По прогнозам опроса FinOps Foundation, количество специалистов по FinOps возрастет в среднем на 5–7 человек. Скорее всего, нынешние сотрудники команды по работе с данными тоже будут по-другому распределять свое рабочее время, переходя на новые процессы и технологии. Это позволит повысить эффективность в других областях, например в надежности данных.

Прогноз № 2: профессии по работе с данными станут более узкоспециализированными

Сегодня сегментация таких профессий в основном привязана к этапам обработки данных:

- дата-инженеры создают пайплайны обработки данных;

- инженеры-аналитики очищают данные;

- дата-аналитики и дата-сайентисты визуализируют данные и по крупицам собирают из них необходимую аналитику.

Эти профессии никуда не исчезнут, но произойдет дополнительная сегментация по ценности для бизнеса или целям:

- инженеры, отвечающие за надежность данных, будут обеспечивать качество;

- менеджеры по дата-продуктам будут заниматься внедрением и монетизацией;

- DataOps-инженеры будут отвечать за Governance и эффективность;

- дата-архитекторы будут бороться с изолированностью отделов и процессов, повышать эффективность работы остальных специалистов и планировать долгосрочные инвестиции.

Эти изменения вторят развитию родственной области — разработки программного обеспечения, где профессия «инженер-разработчик» стала разделяться на такие специализации, как DevOps-инженер и инженер SRE. Это естественный ход вещей, ведь эти профессии становятся более зрелыми и сложными.

Прогноз № 3: Data Mesh покоряет отрасль

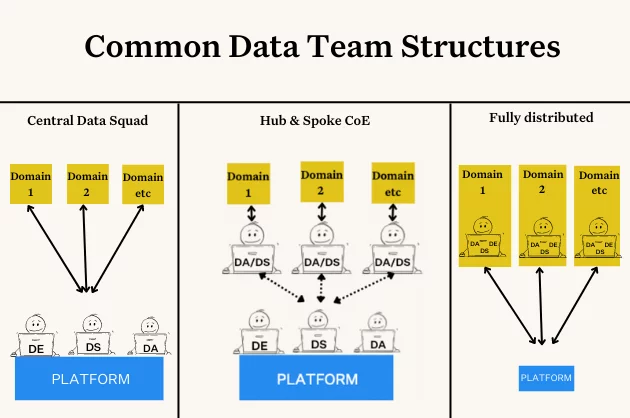

Команды по обработке данных продолжат переход к Data Mesh, о чем уже говорила Жамак Дегани. Нельзя сказать, что это неожиданный прогноз: вот уже несколько лет Data Mesh остается горячей темой для обсуждения.

Но я заметил, что все больше команд по обработке данных делают на пути к Data Mesh небольшую остановку, застывая в переходном состоянии. Причем это делают и опирающиеся на предметные области, и команды инновационного центра или развития платформы. Для многих этот переходный период вбирает в себя преимущества разных подходов: гибкость и возможности подстройки, характерные для децентрализованных команд, и единые стандарты централизованной работы.

Думаю, некоторые команды продолжат идти по направлению к Data Mesh, а некоторые так и останутся на этом рубеже. Они будут применять принципы Data Mesh: самообслуживание, Domain-first Architecture и отношение к данным как к продукту, — но сохранят мощную центральную платформу и «спецназ» из дата-инженеров.

Прогноз № 4: больше половины моделей машинного обучения будут успешно запускаться в продакшен

Полагаю, в следующем году среднестатистическая компания сможет успешно запускать в продакшен больше моделей машинного обучения.

Если в 2022 году вы участвовали в каких-нибудь ИТ-конференциях, вам могло показаться, что мы все попали в машинно-обученческую нирвану. Ведь успешные проекты часто оказываются показательными и рассказывать о них интересно и увлекательно. И это скрывает тот факт, что большинство ML-проектов проваливаются еще в самом начале.

В октябре 2020 года Gartner опубликовал данные, что только 53% проектов машинного обучения проходят путь от прототипа до продакшена — и это в компаниях, которые накопили опыт работы с ИИ. Для тех же, кто только начинает внедрять культуру Data-driven, ситуация хуже: по некоторым оценкам, доля провалов выходит за 80%.

Проблем множество:

- требования бизнеса не соответствуют целям машинного обучения;

- обучение модели не позволяет делать обобщения;

- возникают проблемы с тестированием и валидацией;

- сложности с деплойментом и обслуживанием.

Почему я думаю, что для команд по машинному обучению настал поворотный момент? Потому что внимание к качеству данных в сочетании с экономическим давлением может повысить полезность ML. И здесь удобные интерфейсы, такие как блокноты и приложения для обработки данных вроде Steamlit, играют важную роль.

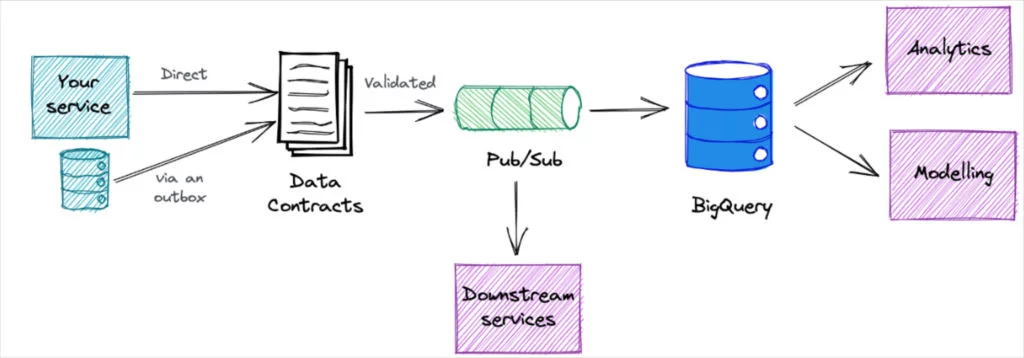

Прогноз № 5: контракты данных будут заключать на более раннем этапе

Каждый, кто почитывает ИТ-дискуссии на LinkedIn, знает, что контракты данных входят в число наиболее обсуждаемых тем года. И вот почему: контракты — это ответ на одну из основных проблем качества данных, с которой сталкиваются специалисты.

В большинстве проблем с качеством виноваты неожиданные изменения схемы. Во многих случаях это результат действий ничего не подозревающего программиста, который решил обновить сервис, не осознавая, что это приведет к хаосу на следующих этапах работы с данными.

Но важно отметить, что, несмотря на всю онлайн-шумиху на эту тему, контракты данных еще не вошли в пору зрелости. Инициаторы этого подхода Чад Сандерсон и Эндрю Джоунс показали, как внедрить идею в жизнь. И все же они не скрывают, что и их компании еще не закончили переход.

По моим прогнозам, в 2023 году внедрение контрактов данных ускорится в силу важности вопроса. Это создаст условия для будущего перелома в 2024 году, когда тенденция либо укоренится, либо сойдет на нет.

Прогноз № 6: различия между хранилищами и озерами данных начнут стираться

Возможно, вы сами недавно говорили (или думали): «Озера данных лучше подходят для потоковой передачи, ИИ и использования в сфере Data Science. А хранилища данных лучше решают аналитические задачи». Повторите это в 2023 году, и вы тут же станете объектом насмешек.

В прошлом году в хранилищах данных стали появляться функции потоковой передачи. Snowflake анонсировали службу непрерывного приема данных Snowpipe и оптимизировали свой коннектор для Kafka: теперь, когда данные попадают в Snowflake, к ним сразу же можно сформулировать запрос, что снижает задержку в 10 раз. Google объявили о стриминге данных непосредственно из Pub/Sub в BigQuery, так что теперь подключать потоковую обработку в хранилище стало просто как никогда.

В то же время озера данных тоже претерпели изменения. Например, Databricks анонсировали решение для управления данными Unity Catalog, позволяющее легко добавлять в ресурсы данных структуру, такую как метаданные.

На фронте новых табличных форматов разыгралась гонка вооружений. Snowflake анонсировали Apache Iceberg для потоковой обработки данных, а Unistore — гибридные таблицы для аналитической обработки транзакций (HTAP). Databricks продолжили развивать табличный формат Delta, который поддерживает и ACID, и метаданные.

Прогноз № 7: специалисты научатся быстрее устранять аномалии данных

В 2022 году опрос более 300 специалистов по работе с данными, проведенный Wakefield, выявил, что на повышение качества данных уходило в среднем 40% рабочего дня респондентов. Это много.

Потери времени из-за низкого качества сводятся к простому уравнению: количество инцидентов x (среднее время на обнаружение + среднее время на устранение). По данным опроса Wakefield, компании сталкиваются в среднем с 61 инцидентом в месяц. В среднем 4 часа уходит на его обнаружение и еще 9 часов — на устранение.

В этом году я разговаривал с сотнями специалистов и пришел к выводу, что у многих компаний сократилось время обнаружения инцидента благодаря переходу от статического, жестко заданного тестирования данных к их мониторингу на базе машинного обучения. Это здорово.

Радует и потенциал для создания инноваций в автоматическом анализе первопричин. Такие функции, как анализ сегментации, обнаружение изменений запросов, Data Lineage и многие другие, могут сократить количество вариантов ответа на вопрос «Что не так с данными?» с бесконечного множества причин до ограниченного набора альтернатив — независимо от того, где возникла проблема: в системах, коде или самих данных.

2023-й: год, когда большие данные становятся меньше, а их управляемость — лучше

В конце 2022 года я бы сказал, что дата-инжиниринг находится в уникальной точке во времени, когда удалось в массе своей преодолеть ограничения в области вычислений и хранения данных — теперь большие данные могут быть настолько большими, насколько это нужно. Возможно, маятник по традиции качнется в другую сторону, но, скорее всего, не в следующем году.

Таким образом, основные тенденции будут связаны не столько с оптимизацией или масштабированием инфраструктуры, сколько с процессами, стремящимися сделать эту вселенную более организованной, надежной и доступной.

Команда VK Cloud развивает ML Platform. Она помогает построить процесс работы с ML-моделями от дизайна до деплоя, контролировать качество экспериментов и моделей. Новым пользователям даем бонус 3000 рублей на тестирование.