Бизнес доверяет ЦОДам самый ценный и уязвимый актив — данные. Поэтому дата-центрам так важно быть надежными и безопасными на многих уровнях.

Бесперебойную работу оборудования обеспечивают множество взаимосвязанных элементов: промышленные кондиционеры, распределительные щиты, несущие и ограждающие конструкции и т.д.

Но чем масштабнее система, чем больше в ней элементов, тем уязвимее она становится. В публикации покажем на примере нашего ЦОДа, как дата-центр может сохранять надежность на уровне, не допускающем простоя более чем на 1,6 часа в год.

Выбор ЦОДа: наш подход к требованиям

Каждый новый ЦОД нашей инфраструктурной сети должен соответствовать высоким требованиям МТС по надежности. В первую очередь речь идет о соответствии требованиям к инженерной инфраструктуре и системам безопасности.

Если говорить про GreenBushDC, то наши инженеры перед вводом в эксплуатацию дата-центра провели детальный аудит и приняли результаты двух экспертиз.

Предыдущий собственник здания выполнил работы по усилению конструкций ЦОДа: фундаментной плиты, колонн, перекрытий. После этого была повторно проведена проверка различных элементов конструкции, начиная от несущих стен и заканчивая отделочными покрытиями.

В 2021 году мы провели испытания всех инженерных систем, проверили их готовность к сертификации. Программа подготовки к сертификации в целом соответствует программе сертификационных испытаний Uptime Institute.

Весной 2022 года совместно с экспертами Uptime Institute провели сертификацию. Получив подтверждение, что площадка может нести проектную нагрузку и гарантирует необходимый клиентам SLA, дата-центр был открыт для размещения серверного оборудования (colocation).

Как обеспечивается связность

Связность — это наличие каналов связи (волоконно-оптические линии связи, ВОЛС) от ЦОДа до основных площадок обмена трафиком. Этот параметр влияет на удаленную доступность данных и ИТ-систем для ваших сотрудников и клиентов. Чем ближе дата-центр к потребителю, тем меньше задержка сигнала, что критически важно для работы с большими данными, видеопотоком, работы онлайн-платформ IoT.

Чтобы организовать связность GreenBushDC на уровне, необходимом клиентам с разными запросами, проложены шесть ВОЛС по несколькими непересекающимися маршрутами до основных узлов обмена трафиком М-9 и М-10. Имеется высокоскоростное подключение и к сети МТС с ее практически неограниченными ресурсами магистральной связности по всей России.

Расстояние до узлов (67 км до М-10 и 74 км до М-9) позволяет передавать сигнал с минимальными задержками и устанавливать любое оборудование для организации канала (с поддержкой стандартов от SFP до WDM). ВОЛС выходят с разных сторон площадки, что защищает от случайных обрывов кабеля (например, такое возможно при строительных работах в городской черте).

В GreenBushDC присутствуют помимо МТС 7 операторов связи: ЭР-Телеком, Мастертел, Акадо, Ростелеком, Мегафон, Микрон-Медиа и ДатаПлэнет. Сделано это для удобства клиентов: компаниям не нужно менять телеком-операторов, с которыми они работали ранее.

Как выполняются требования к надежности энергообеспечения

Сегодня очень актуально создание катастрофоустойчивых систем. Важно обеспечить независимость в плане энергетики, что не всегда возможно сделать в Москве, где все ресурсы для подключения столь энергоемких объектов, как ЦОДы, уже исчерпаны.

Наша площадка в Зеленограде в этом отношении находится в выгодных условиях. Внешнее электроснабжение GreenBushDC осуществляется по двум независимым кабельным линиям 10 кВ от подстанций Особой Экономической Зоны (ОЭЗ). Каждая питающая линия способна нести полную электрическую нагрузку объекта, обеспечивая резервирование 2N.

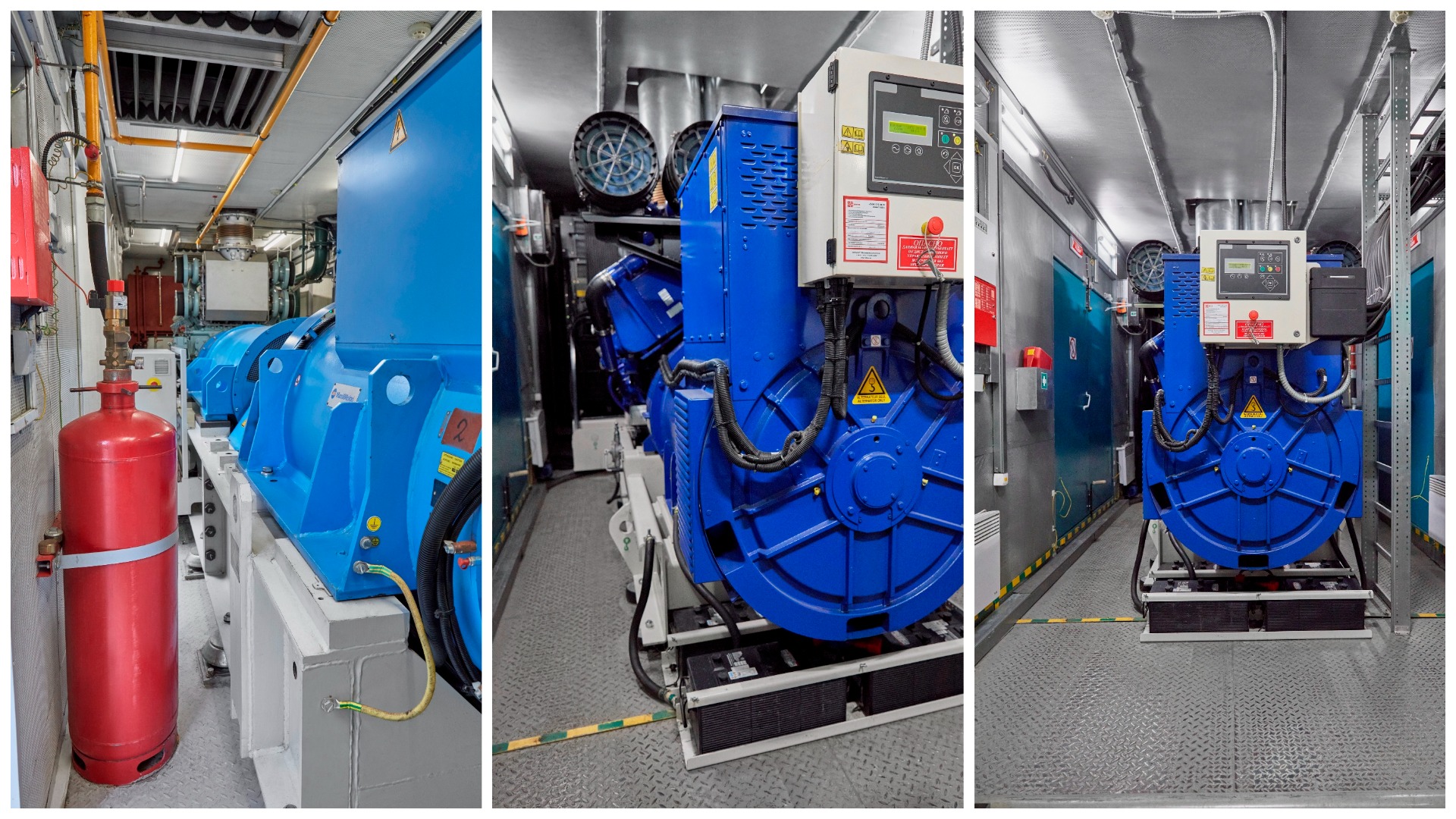

В случае аварии на линиях электроснабжения в дело вступают четыре ДИБП (динамических источников бесперебойного питания), которые поддержат работу клиентского оборудования и части критически важной инженерной инфраструктуры. Так же две ДГУ (дизель-генераторные установки) обеспечивают независимость от городского питания остальных инженерных систем.

Динамические источники бесперебойного питания от статических отличаются принципом работы:

- ИБП запасают энергию химическим способом – аккумуляторами;

- ДИБП запасают энергию механическим способом и функционируют как электрическая машина.

В стандартном режиме ДИБП выполняет роль электродвигателя и вращает маховик, накапливая энергию, а при сбоях накопленную энергию устройство передает электрической машине, которая становится генератором. Одновременно стартует дизельный двигатель, который будет поддерживать вращение генератора до появления внешнего электроснабжения.

ДИБП — первая линия защиты работоспособности ЦОД. Они включаются в работу мгновенно, выдавая 1630 кВА каждый. В течение 15 секунд после отключения основного источника питания автоматически запускается один из двух дизель-генераторов Wilson номинальной мощностью 2500 кВА. Если отключится один, в работу включится другой.

Для генераторов в ЦОД есть запас топлива на сутки. У GreenBushDC топливохранилище пополняют два поставщика. Их контракты дублируются на случай, если первый контрагент опоздает с поставкой или не выполнит обязательства.

Мы доработали наши серверные залы, в частности, построили современную систему распределения электроэнергии на базе шинопроводов. Сейчас инженерная инфраструктура позволяет устанавливать мощные стойки до 20 кВт.

Шинопроводы оборудованы системой мониторинга, благодаря которой можно контролировать питание каждой стойки клиента. При необходимости этой информацией мы можем делиться с клиентом, показывая в реальном времени потребление электроэнергии до каждой стойки.

Шумоизоляция

В соответствии с предписаниями Санитарно-эпидемиологической службы дата-центр должен соответствовать требованиям по предельно допустимым уровням шума. Основной источник возможного акустического загрязнения на площадке — оборудование для резервного энергоснабжения.

Мы пользуемся высоко-эффективными глушителями шума для ДИБП и ДГУ. Дополнительно вдоль границы земельного участка установлены шумозащитные экраны.

От Санэпидемнадзора мы получили экспертное заключение по экологии санитарно-защитной зоны вокруг ЦОД. Этот документ подтверждает, что шумовая нагрузка от нашего оборудования не превышает установленные требования.

Транспортная доступность

Этот параметр особенно важен, когда в ЦОДе есть услуга colocation. Разместив свое оборудование в дата-центре, вы должны быть уверены, что всегда сможете оперативно получить к нему доступ.

Даже если ЦОД находится внутри третьего транспортного кольца Москвы, то с учетом трафика добраться до него не всегда можно быстро.

GreenBushDC находится на территории Зеленограда. Сюда идут и обычная дорога, и платная, поэтому в случае необходимости можно «долететь» быстрее, чем внутри Москвы. Можно быстро добраться как на личном автомобиле, так и разными видами общественного транспорта: на автобусе от станции метро «Ховрино», на электричке от Ленинградского вокзала до станций «Алабушево» либо «Крюково». На личном автомобиле по Пятницкому, Ленинградскому шоссе и платной трассе М11.

На оформление и подключение стоек клиентов уходит менее 2 часов, если заранее заказать пропуск (дата-центр является объектом повышенной безопасности).

Защита от катаклизмов

ЦОД должен пережить любой ливень, снежный шторм и аномальную жару – такая погода не редкость в центральном регионе.

Газовое пожаротушение

Система пожаротушения в ЦОДе должна защищать не только оборудование, но и людей. Поэтому мы используем жидкость без цвета и запаха («сухая вода») Novec 1230, которая не вытесняет кислород, а вступает в химическую реакцию с продуктами горения и безопасна для человека. Механизм тушения пожара основан на физическом эффекте охлаждения путем интенсивного отбора тепловой энергии от источника горения. Вещество в исходном виде нетоксично, не влияет на работающую электронику, не разрушает бумажные документы.

Защита от протечек

Российская и мировая история помнит случаи, когда прорыв трубы вызывал масштабные сбои. Например, из-за потопа в дата-центре Национального управления океанических и атмосферных исследований США в 2019 году часть сервисов организации не работала на протяжении месяца. Похожая история произошла в центре обработки данных Вашингтонского университета.

Всегда ли для защиты от затопления требуется строить гермозоны? Практика показывает, что нет. В случае GreenBushDC залы с ИТ-оборудованием расположены на первом, втором и четвертом этажах, но автозалы не стыкуются с крышей — между ними есть технический этаж, на котором расположены вспомогательные помещения, и сделан водоотвод.

Для защиты от прорыва линии системы кондиционирования и охлаждения стоек на нашей площадке предусмотрена система аварийного слива этиленгликоля.

Несущая способность стен

Чтобы безопасно размещать оборудование в ЦОДе, несущие способности плит перекрытий должны отвечать определенным требованиям. Здесь мы ориентируемся на общепризнанные стандарты Uptime Institute.

Наши специалисты провели несколько экспертиз несущей способности строительных конструкций GreenBushDC, в том числе с бурением, и установили, что расчетная несущая способность плит перекрытия превышает 1250 кг/м². Этот показатель соответствует проекту Tier III (не менее 1225 кг/м²).

Климат-контроль и система мониторинга

Охлаждение — одно из ключевых направлений технологического развития дата-центров. 40% (и более в отдельных случаях) всей энергии, которую потребляют ЦОД, может уходить на работу систем охлаждения.

Микроклимат отражается на надежности работы оборудования и потреблении электроэнергии, и, как следствие, цене услуг по размещению серверов. Если температура в машинном зале увеличивается на 13°C (до 35°C), то энергопотребление серверов растет следом — на 20%.

В Японии даже стали экспериментировать со «снежным охлаждением». Трубы системы кондиционирования пропускают под сугробом за пределами дата-центра, который снижает температуру антифриза. Однако наиболее распространенным способом температурного регулирования остаются классические системы климатического контроля и грамотное инженерное планирование.

В GreenBushDC установлена жидкостная система охлаждения на базе фреоновых холодильных машин (чиллеров) и прецизионных кондиционеров. Они поддерживают постоянный микроклимат в машинных залах: от 20 до 27 °С.

В помещениях также предусмотрена изоляция горячих и холодных коридоров. В этом случае холодный и горячий воздух не перемешиваются, а оборудование охлаждается более эффективно.

Чиллеры GreenBushDC позволяют использовать фрикулинг — одну из самых энергоэффективных систем охлаждения. В холодное время года теплоноситель охлаждается в специальном теплообменнике за счет обдува наружным воздухом.

Уже после сертификации мы создали систему мониторинга, которая снимает данные о температуре воздуха на входе в каждую стойку. Эта информация помогает нам в режиме реального времени контролировать соответствие требованиям ASHRAE (Американского общества инженеров по отоплению, охлаждению и кондиционированию воздуха), а еще мы сможем делиться ею с клиентом.

К слову, требованиями АSHRAE по диапазону температуры воздуха для серверных помещений ЦОД руководствуются во всем мире. Сегодня рекомендованная температура находится в диапазоне 18-27°C.

Физическая безопасность площадки

В эту категорию входит ограждение территории дата-центра, охрана, сканеры отпечатков пальцев, и так далее. Их задача — предотвратить физический доступ посторонних к информации на серверах клиентов. Так один из крупных дата-центров в Нидерландах вообще окружен не забором, а настоящим рвом.

В контексте подавляющего большинства бизнесовых задач нет смысла гнаться за «ультимативной» безопасностью. Но все же важно, чтобы на территории ЦОД работал пропускной режим, была установлена система видеонаблюдения и охранная сигнализация.

Периметр нашего дата-центра огорожен забором — вход только через КПП с проверкой документов. Все происходящее внутри записывают более 300 камер видеонаблюдения и хранят записи 3 месяца. Кроме того, мы имеем дополнительную физическую защиту: первый периметр безопасности — самой ОЭЗ, второй — собственно ЦОДа.

PUE: оценка энергоэффективности ЦОД

Помимо надежности и безопасности, ключевой характеристикой центров обработки данных является эффективность использования электроэнергии (Power Utilization Effectiveness, PUE). Для расчета PUE необходимо разделить общее количество энергии, поступающее в ЦОД, на мощность, которая используется для работы ИТ-оборудования в нем. Если дата-центр получает из сети 10 МВт, а оборудование потребляет 5 МВт, то показатель PUE будет равен 2. Идеальным значением считается 1,0.

Мониторинг PUE полезен для сравнительного анализа эффективности ЦОДов. Дата-центры, которые работают не эффективно, будут потреблять больше энергии, что приведет к дополнительным расходам и\или проблемам с оборудованием. Кроме того, с помощью этой метрики можно измерять меры, которые применяют для снижения затрат на электроэнергию.

Впрочем, идеальной метрикой этот показатель тоже считать нельзя. Для охлаждения дата-центров в южных регионах очевидно потребуется больше электроэнергии, чем у ЦОДов на севере.

PUE у GreenBushDC при полной загрузке составляет 1,5 единицы — это сравнимо со средним общемировым уровнем (по данным Uptime Institute).

Как суммировать параметры надежности ЦОД

Сегодня не существует единого стандарта и списка требований к ЦОД. Однако есть набор отдельных документов, применяемых на практике. Вот уже более двадцати лет компании, занимающиеся проектированием и строительством центров обработки данных, ориентируются на нормативы Uptime Institute. Это — известная классификация Tier, описывающая критерии физической инфраструктуры дата-центров.

Регулярно появляются новые стандарты, которые расширяют и дополняют список требований. Например, в России с 2020 года действуют ГОСТ Р 58811-2020 и ГОСТ Р 58812-2020, регулирующие построение и оснащение ЦОД.

Каждый стандарт — будь то государственный или международный — имеет свои особенности. Но среди них можно выделить общие требования, на которые стоит ориентироваться при выборе локации для размещения серверного оборудования.

Согласно общепризнанным критериям Uptime Institute все ЦОДы характеризуется уровнем Tier и оцениваются по 4-балльной системе:

- Tier I не подразумевает резервирования критически важных элементов. Допустимое время простоя в год — 28,8 часа, в процентном соотношении устойчивость к отказу — 99,671%.

- Tier II — закладывается резервирование и запасные ресурсы, однако при замене оборудования работа ЦОД может остановиться. Допустимый простой — 22 часа (99,741%).

- Tier III — полное резервирование критичных систем, ЦОД можно ремонтировать и обновлять без остановки. Простой не более 1,6 часа (99,982%).

- Tier IV — полное резервирование всех компонентов и бесперебойная работа при возникновении системных сбоев. В течение года ЦОД может останавливаться не более чем на 0,4 часа.

Uptime institute оценивает и сертифицирует дата-центры на трех этапах:

- Dеsign: проверяется проектная документация и присваиваются Tier I–IV.

- Facility: на уже построенном объекте проверяется инженерная инфраструктура и ее соответствие проекту. ЦОДы уровня Tier III и выше должны работать бесперебойно в случае отказа городского электроснабжения, а также некоторого количества чиллеров, прецизионных кондиционеров, генераторов, ИБП и т.д.

- Operational Sustainability: комплексная оценка процессов обслуживания и управления ЦОДов, которые уже имеют сертификат Facility. В свою очередь подразделяются на подуровни: Bronze, Silver и Gold.

Что должны знать инженеры дата-центра

ЦОД — это не просто автономный завод по обработке данных. Дата-центр работает круглосуточно и для его обслуживания очень важно иметь квалифицированную инженерно-диспетчерскую службу.

Без правильно выстроенных процессов и квалифицированной команды даже самый надежный ЦОД превратится в склад с железом, а сертификаты Tier окажутся бесполезны.

На рынке фактически отсутствуют свободные «специалисты по ЦОД», поэтому мы берем специалистов по областям (электроэнергия, холодильные машины и т.д.) и обучаем на месте всем тонкостям.

Дежурная смена мониторит состояние инженерной инфраструктуры, совершает обходы, может локализовывать аварии и занимается оперативным переключением оборудования. Специалисты дата-центра отвечают за монтаж, коммутацию и обслуживание стоечного оборудования. От их компетенций зависит бесперебойность работы оборудования.

На смене всегда находятся инженер-механик, который хорошо понимает работу системы охлаждения, и инженер-электрик, ответственный за ИБП, трансформаторы 10/0,4 (которые понижают напряжение с 10 кВ до 380 В — 0,4 кВ), распределительные щиты, подключение клиентов к электропитанию. Работу оборудования клиентов контролируют дежурные инженеры эксплуатации клиентских сервисов.

Персонал действуют согласно подробным и четким инструкциями, стандартизированным по нескольким типам процедур:

- Standard Operating Procedures (SOP) — стандартная функциональная или административная операционная процедура, в которой детально прописан порядок выполнения действий. SOP регламентирует все процессы отключения и включения оборудования — например, чиллеров.

- Methods of Procedure (MOP) — пошаговая инструкция работ на каждую единицу инженерного оборудования, которое способно прямо или косвенно воздействовать на критическую нагрузку. MOP описывает технические сложные операции — например, замену батарей у ИБП.

- Emergency Operation Procedures (EOP) — процедура реагирования на потенциальный или уже случившийся отказ. Задействуется при аварийных переключениях — например, в случае отключения городского электроснабжения нужно удостовериться, что дизель-генераторные установки сработали штатно.

Помните, что самое дорогостоящее оборудование и даже сертификат Tier IV не гарантируют надежность без команды квалифицированных инженеров.

Заключение

Выбор дата-центра часто обусловлен стоимостью услуг. Но для бизнеса не меньшее значение имеет безопасность и надежность.

Сертификация Uptime Institute — не единственный, но важный критерий, по которому можно выбирать дата-центр.

GreenBushDC получил сертификаты Tier III Design и Constructed Facility: есть гарантия, что построенный в соответствии с сертифицированным проектом дата-центр прошел серию тестовых испытаний отказоустойчивости работы инженерных систем.

Также подтверждена заложенная работоспособность и надежность дата-центра. Резервирование всех критичных узлов и оборудования ЦОДа соответствует всем требованиям Tier III.