Навыки агентов (Agent Skills): что это такое и почему это больше, чем «папка с промптами»

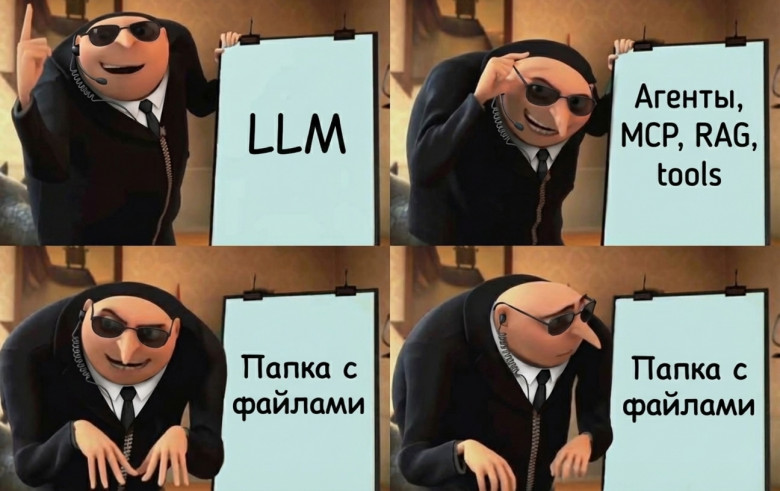

Сначала были LLM. Потом - агенты, MCP, RAG, tools: сложная архитектура, протоколы, оркестрация.

А в конце 2025 индустрия внезапно формализует следующий “большой шаг” как… папку с файлами.

Похоже, это как раз тот случай, когда простая форма скрывает важный сдвиг: сообщество зацепилось за skills в конце 2025, а в 2026, судя по всему, станет, мейнстримом в проектировании ai-систем, примерно как когда-то вокруг MCP. Я постарался разобрать эту штуку по-простому, чтобы не пришлось собирать картину из десятка разрозненных источников. Постарался ответить на возникающие у меня самого вопросы вроде "в чем суть?" и "как сейчас решается похожая проблематика?"

В статье разберу:

- что такое Agent Skills;

- как работает схема Discovery → Activation → Execution;

- чем skills отличаются от tools, RAG и MCP, и какое место занимают в архитектуре LLM-агента.