Хабр Курсы для всех

РЕКЛАМА

Практикум, Хекслет, SkyPro, авторские курсы — собрали всех и попросили скидки. Осталось выбрать!

# zpool iostat 10

capacity operations bandwidth

pool alloc free read write read write

---------- ----- ----- ----- ----- ----- -----

bkp 799G 1.94T 0 0 0 0

zfs 5.95T 4.61T 799 0 14.0M 0

---------- ----- ----- ----- ----- ----- -----

bkp 799G 1.94T 0 0 0 0

zfs 5.95T 4.61T 773 0 15.3M 0

---------- ----- ----- ----- ----- ----- -----

bkp 799G 1.94T 0 0 0 0

zfs 5.95T 4.61T 813 0 17.1M 0

---------- ----- ----- ----- ----- ----- -----

Очень странно видеть сравнение не со схожей конфигурацией под управлением mdraid, а одним диском под XFS.

Непонятно также почему выбран Virtio-Block, хотя прокс рекомендует Virtio-Scsi

то наверное будет несколько виртуалок, иначе какой смысл в прослойке

желательно тестить c помощью fio непосредственно на хосте

Непонятно также почему выбран Virtio-Block, хотя прокс рекомендует Virtio-Scsi.Именно в вопросе производительности это не сильно важно. Proxmox рекомендует virtio-scsi скорее из-за большего количества функций (полноценное scsi устройство, поддержка blkdiscard, масштабируемость и т.д.) при примерно той же производительности (при некоторых паттернах нагрузки она хуже из-за большего количества прослоек).

ну меня в этих тестах интересовало что именно дойдет до виртуалки.

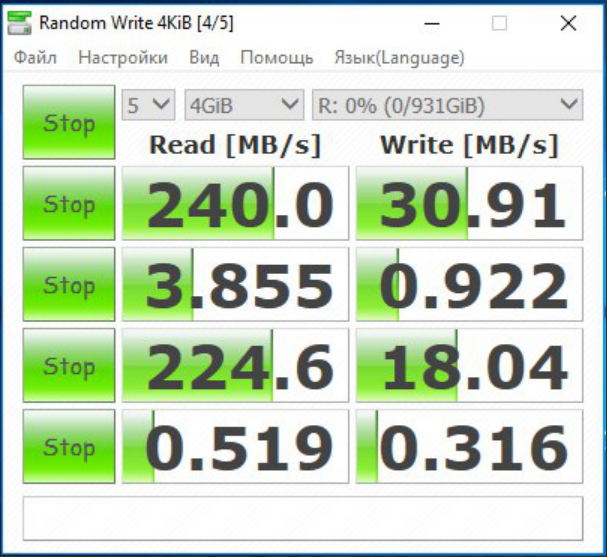

Вот для сравнения, да простят меня все линуксоиды, сравнительный тест в среде MS

Гипервизор (не Hyper-V) на Server 2016 (это уже на другой железке тесты)

Из статьи и из моего опыта можно сделать грустный вывод. Сколько дисков zfs не дай, а скорость записи будет просто смешной. Да и xfs в вашей виртуалке в 100мб/сек — тоже отстой. В ntfs win эти диски могут показывать более 180мб/сек, верно?

Сколько дисков zfs не дай, а скорость записи будет просто смешной.

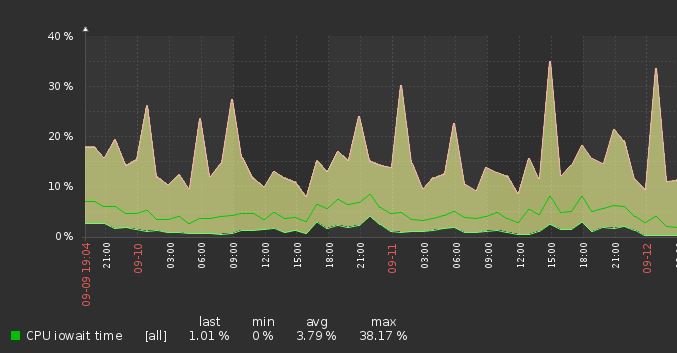

ZFS и скорость доступа к диску в гипервизорах