Примерно с 9 вечера до часу ночи по Московскому времени были перебои с работой облачного хранилища Amazon S3. Началось это с сообщения в твиттер «S3 is experiencing high error rates. We are working hard on recovering», хотя мир узнал об этом раньше: перестали работать (полностью или частично) сайты Medium, Slack, Coursera, Trello, Adobe и еще куча.

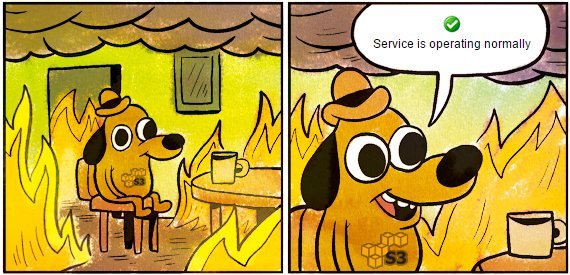

Примерно с 9 вечера до часу ночи по Московскому времени были перебои с работой облачного хранилища Amazon S3. Началось это с сообщения в твиттер «S3 is experiencing high error rates. We are working hard on recovering», хотя мир узнал об этом раньше: перестали работать (полностью или частично) сайты Medium, Slack, Coursera, Trello, Adobe и еще куча. При этом некоторое время не работала страница со статусами status.aws.amazon.com. Ну как не работала — она работала, но показывала, что все хорошо, в Багдаде всё спокойно, «Service is operating normally».

Дополнение от ValdikSS: пользователи мышек фирмы Razer не могли изменить DPI, т.к. для этого нужно, вероятно, соединение с Amazon.

В отличие от падения гитлаба, где в момент эпик фейла ребята запустили онлайн трансляцию восстановления, Amazon лишь иногда выдавал скупые сообщения в твиттер из серии «мы обнаружили корень проблемы и работаем над этим».

Детальной информации о том, в чем был корень проблемы, пока что нет, надеюсь, будет какой-то подробный пресс-релиз

[Исправлено] Service Level Agreement с допустимым uptime можно посмотреть здесь.

Официальный твиттер