Комментарии 127

Фанаты AMD ликуют! :)Да, ликуем! УРА! :)

+4

Почему «ускоритель»? Неужели история сделала виток, и мы вновь возвращаемся к 3D-ускорителям?

0

Мне кажется в какой-то мере да. Сегодня у нас уже как правило есть видеоядро в процессоре, которого не хватает только для требовательных к графике игрушек.

+3

Дополню: современная AMD графика в процессоре может прозрачно объединять свою мощность со слотовой видеокартой от AMD, и это здорово.

0

Говорят, от этого больше вреда, чем пользы, учитывая катастрофическую разницу в производительности и сложность асимметричного распределения нагрузки…

+1

По тестам этого не заметно, однако и обещанный прирост оказался так же весьма скромным.

0

Заметно — www.tomshardware.com/reviews/dual-graphics-crossfire-benchmark,3583-3.html

Весь профит от объединения вычислительной мощи (он тем меньше, чем быстрее дискретная карта) съедается джиттером, который в бенчмарках не отображается, но который вызывает визуально заметное дерганье картинки. Грубо говоря: если в течение определенного интервала времени первый фрейм был отображен на 70% экрана, второй на 10% экрана и третий на 60% экрана, то это НАМНОГО хуже, чем три фрейма по 50% экрана, потому что в последнем случае будет плавность.

Весь профит от объединения вычислительной мощи (он тем меньше, чем быстрее дискретная карта) съедается джиттером, который в бенчмарках не отображается, но который вызывает визуально заметное дерганье картинки. Грубо говоря: если в течение определенного интервала времени первый фрейм был отображен на 70% экрана, второй на 10% экрана и третий на 60% экрана, то это НАМНОГО хуже, чем три фрейма по 50% экрана, потому что в последнем случае будет плавность.

0

Ого, не знал. А как сия фича «по ихнему» называется? А с интелом кооперироваться, «красные» карты, разумеется, не желают?

0

Наоборот, CrossFire как раз на Intel чипсетах поддерживается (причем даже на серверных бывает поддержка), а у NVIDIA SLI все свое. Хотя вроде в последних чипсетах Intel держат и то и то.

0

При чём тут CrossFire и SLI вообще?

0

Ну вы спрашивали могут ли AMD карты кооперироваться с Интелом.

С чипсетами могут.

Если вы имели ввиду может ли AMD дискретная карта работать в гибридном режиме со встроенной Intel HD Graphics — то нет. Так оно и с Nvidia тоже вроде не умеет

С чипсетами могут.

Если вы имели ввиду может ли AMD дискретная карта работать в гибридном режиме со встроенной Intel HD Graphics — то нет. Так оно и с Nvidia тоже вроде не умеет

0

Ну да, я имел ввиду как раз взаимодействие, например, дискретной графики от AMD и встроенной от Intel. Было бы здорово.

0

Было бы здорово

Наверное да, но гибридные штуки реализуются в драйвере, который как правило один для видеокарт одного производителя. Я вот не представляю как можно сделать гибрид из двух железяк под управлением разных драйверов

0

Взаимодействие с intel есть — в некоторых ноутбуках дискретная карта отключается при малой нагрузке, отдавая лёгкие задачи встроенному, но экономичному gpu.

0

То о чем Вы говорите, это переключаемая графика, а тут имеется ввиду одновременная работа встроенного в CPU видео и дискретного GPU.

0

Особенно интересно, что Radeon R9 295X2 позволяет запускать игры в разрешении 4К, что открывает новые перспективы в использовании мониторов и телевизоров высокой четкости.

Я с мобильной Nvidia 780M играю, и Radeon HD7870 на десктопе тоже работала нормально. Я понимаю, что на максимальных настройках 120 fps не выжимают, но 50-60 fps на средних вполне можно получить.

P.S. А карта хороша)

+2

в 4к играете? :)

0

Ну да.

В L4D2 не получается комфортно в силу того, что монитор выдает только 30 Hz, так что переключаю в 1080p 120 Hz, а вот в Portal шикарно, детализация и атмосферность очень радуют.

Portal (1/2) в 4k 780M вытягивает на максимуме.

В L4D2 не получается комфортно в силу того, что монитор выдает только 30 Hz, так что переключаю в 1080p 120 Hz, а вот в Portal шикарно, детализация и атмосферность очень радуют.

Portal (1/2) в 4k 780M вытягивает на максимуме.

+2

А можно подробности о мониторе? Какая модель?

+1

Seiki SE39UY04

4k 30 Hz

FHD 120 Hz

FHD 3D

Такое вот. Единственное — не хватает 30 Hz в активных игрушках, а для кодинга самое то (при такой то цене, даже с учетом того, что покупался и доставлялся из США).

4k 30 Hz

FHD 120 Hz

FHD 3D

Такое вот. Единственное — не хватает 30 Hz в активных игрушках, а для кодинга самое то (при такой то цене, даже с учетом того, что покупался и доставлялся из США).

0

Интересуюсь, и в курсе про этот монитор. Только что у samsung, что у lenovo стоят TN матрицы.

Сам облизываюсь на Sony KDL-55X9005A с VA матрицей и поляризационным 3D, только дороговат. Особенно учитывая то, что сейчас мне нечего и не с чего выводить на него изображение в таком разрешении.

Сам облизываюсь на Sony KDL-55X9005A с VA матрицей и поляризационным 3D, только дороговат. Особенно учитывая то, что сейчас мне нечего и не с чего выводить на него изображение в таком разрешении.

0

Надо не максимальный и не средний FPS смотреть, а минимальный. Когда на экране взрыв, пламя, дым FPS проваливается в минуса (Crysis, Crysis 3). Нафиг так играть!

Сужу по GTX 670, а она несколько круче чем упомянутая мобильная карточка.

Из-за того, что нормальную/полноценную/полновесную видеокарту не поставить (ибо TDP), а тем более SLI/CrossFire, я не люблю ноутбуки.

Сужу по GTX 670, а она несколько круче чем упомянутая мобильная карточка.

Из-за того, что нормальную/полноценную/полновесную видеокарту не поставить (ибо TDP), а тем более SLI/CrossFire, я не люблю ноутбуки.

+2

Хм… мою карту можно разогнать примерно до вашей, TDP должно хватить (ибо вышла 880M, которая перемаркированная 780M, и частоты в ней выше).

На счёт SLI/CrossFire — почему нельзя? У меня ноут собран на базе Barebone Clevo 150SM, есть 17-дюймовая аналогичная модель с двумя картами. Пара 780M это очень даже ничего производительность:)

А вообще в игры я играю редко, так что меня устраивает такой расклад (да и упомянутого Crysis под Linux по-моему пока нет).

Всё зависит от задач, вот мне иногда нужно перемещаться с рабочим местом — пересел недавно на ноутбук.

На счёт SLI/CrossFire — почему нельзя? У меня ноут собран на базе Barebone Clevo 150SM, есть 17-дюймовая аналогичная модель с двумя картами. Пара 780M это очень даже ничего производительность:)

А вообще в игры я играю редко, так что меня устраивает такой расклад (да и упомянутого Crysis под Linux по-моему пока нет).

Всё зависит от задач, вот мне иногда нужно перемещаться с рабочим местом — пересел недавно на ноутбук.

-2

>мою карту можно разогнать примерно до вашей…

Интересно, что мобильная 880 всё равно оказывается слабее чем полновесной 670. Т.е. разгон ничего не даст.

>Пара 780M это очень даже ничего производительность

Очень любопытно! Я пока не представляю ноута, из которого можно успешно отвести 200 Вт. Это особенно сложно представить потому, что корпус моего компа при максимальных нагрузках прогревается градусов до 40 — 43 (не измерял, но по ощущениям именно столько). Думаю, обычный ноут от такого кол-ва теплоты должен задымиться.

Интересно, что мобильная 880 всё равно оказывается слабее чем полновесной 670. Т.е. разгон ничего не даст.

>Пара 780M это очень даже ничего производительность

Очень любопытно! Я пока не представляю ноута, из которого можно успешно отвести 200 Вт. Это особенно сложно представить потому, что корпус моего компа при максимальных нагрузках прогревается градусов до 40 — 43 (не измерял, но по ощущениям именно столько). Думаю, обычный ноут от такого кол-ва теплоты должен задымиться.

0

Слабее разве что по памяти, ядро гораздо более производительное на больших частотах.

У меня БП 180 Вт для ноута, две системы охлаждения — по одной на CPU и GPU (процессор тоже не самый слабый i7-4900MQ), и перегревом не пахнет. Так что в чуть большем корпусе с более мощной системой охлаждения запросто можно поставить ещё одну карточку, и ничего не случится.

Сегодня драйвер для Linux обновился, добавили поддержку разгона, нужно проверить как оно будет на частотах 880M греться.

У меня БП 180 Вт для ноута, две системы охлаждения — по одной на CPU и GPU (процессор тоже не самый слабый i7-4900MQ), и перегревом не пахнет. Так что в чуть большем корпусе с более мощной системой охлаждения запросто можно поставить ещё одну карточку, и ничего не случится.

Сегодня драйвер для Linux обновился, добавили поддержку разгона, нужно проверить как оно будет на частотах 880M греться.

0

>Слабее разве что по памяти, ядро гораздо более производительное на больших частотах.

Я на тесты смотрю, и только если их нет на характеристики.

>У меня БП 180 Вт для ноута…

А у меня 700 Вт. Это ни о чём не говорит.

Разве что, можно предположить, что в пиковых нагрузках просядут линии +3.3 и +5. Видел такое, и именно поэтому вместо БП 400 Вт был куплен брэндовый семисотватник.

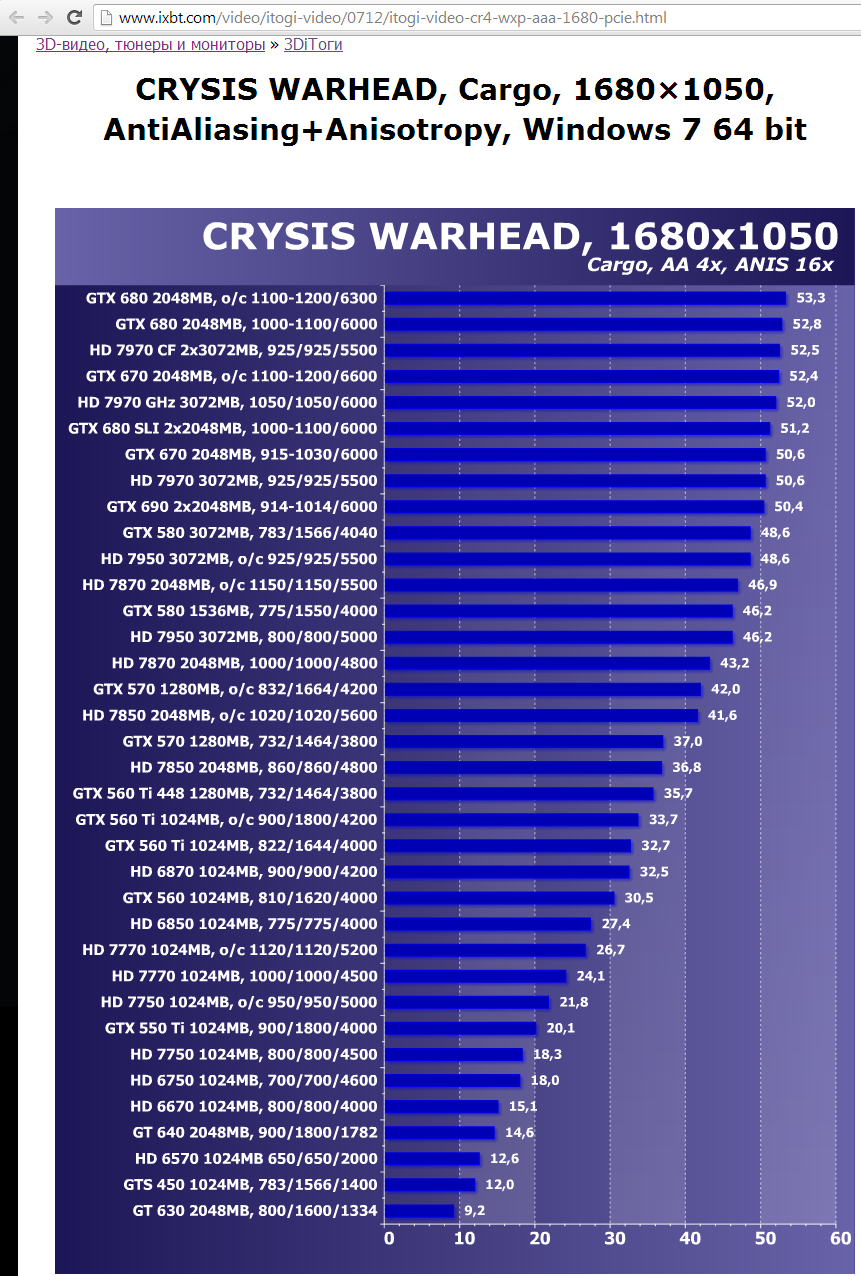

L4D2, кстати, не очень требовательная игрушка. Нужно смотреть нечто вот такое:

Зачем нужна хорошая видюха видно из вот этих тестов:

Я на тесты смотрю, и только если их нет на характеристики.

>У меня БП 180 Вт для ноута…

А у меня 700 Вт. Это ни о чём не говорит.

Разве что, можно предположить, что в пиковых нагрузках просядут линии +3.3 и +5. Видел такое, и именно поэтому вместо БП 400 Вт был куплен брэндовый семисотватник.

L4D2, кстати, не очень требовательная игрушка. Нужно смотреть нечто вот такое:

На диаграммке названия игрушек

Зачем нужна хорошая видюха видно из вот этих тестов:

CRYSIS WARHEAD, AntiAliasing+Anisotropy, 1680×1050

Metro 2033, AntiAliasing+Anisotropy, 1680×1050

0

Может лучше на Metro Last Light? Он есть под Linux. Хотя сравнивать в лоб win и lin версии всё равно нельзя…

Даёшь FurMark!

Даёшь FurMark!

0

Тестов 880M нормальных пока не видел. Судя по характеристикам и сравнениям/тестам которые нашел вполне на уровне полноразмерной 680.

БП это я о мощности, на которую рассчитан ноутбук. Можно предположить, что большую часть из 180 Вт будут рассеивать CPU и GPU (47 Вт + 100 Вт заявлено при полной нагрузке), то есть

Очень легко представить, и конфигурация будет рассеивать до 250 Вт по факту.

Играл в Metro: Last Night под Linux на 780M — вполне играбельно при 4k даже с 30 Hz монитором.

Star Coflict на максимуме при взрывах и прочем не проседает ниже 55-60, а так 105-110 fps при 1080p.

Вся ветка началась с того, что можно будет играть с разрешением 4k, я вот попытался доказать, что это уже вполне реально, даже на ноутбуке.

БП это я о мощности, на которую рассчитан ноутбук. Можно предположить, что большую часть из 180 Вт будут рассеивать CPU и GPU (47 Вт + 100 Вт заявлено при полной нагрузке), то есть

Я пока не представляю ноута, из которого можно успешно отвести 200 Вт.

Очень легко представить, и конфигурация будет рассеивать до 250 Вт по факту.

Играл в Metro: Last Night под Linux на 780M — вполне играбельно при 4k даже с 30 Hz монитором.

Star Coflict на максимуме при взрывах и прочем не проседает ниже 55-60, а так 105-110 fps при 1080p.

Вся ветка началась с того, что можно будет играть с разрешением 4k, я вот попытался доказать, что это уже вполне реально, даже на ноутбуке.

-1

А я сижу на старенькой 555M =( для игр наверное надо будет купить либо плойку, либо ящик или собрать хороший пк.

0

Ха. Я до сих порсижу с AMD HD 5650м + прибавьте то, что экран 3D.

И проблем с играми нет. Главное не ориентироваться на максимальные настройки и 60fps. Но последнее время со мной что-то не так (смайл)

Очень хочется 60 фпс, и сглаживание X8. И в глаза бросаются места, где девелоперы сэкономили (смайл) — вот там просто текстура вместо модели, вот тут упростили, вот там урезали и так далее.

И проблем с играми нет. Главное не ориентироваться на максимальные настройки и 60fps. Но последнее время со мной что-то не так (смайл)

Очень хочется 60 фпс, и сглаживание X8. И в глаза бросаются места, где девелоперы сэкономили (смайл) — вот там просто текстура вместо модели, вот тут упростили, вот там урезали и так далее.

0

>Я до сих порсижу с AMD HD 5650м + прибавьте то, что экран 3D

>Очень хочется 60 фпс

В шутеры не играешься потому что, иначе первым требованием было бы минимум 40 FPS. Когда активная пальба начинается, то от фрэймрэйта твоя успешность зависит (в сетевых баталиях ещё и от лага). От фрэймрэйта зависит скорость прицеливания. Если на поле брани вот такое происходит, то выживает тот, у кого выше фрэймрэйт и меньше сетевой лаг. Я это ещё по Сталкеру заметил: с низким фпс из пистолета практически невозможно в снорка или тушкана попасть (я в него на слабой видюхе начинал играться).

>Очень хочется 60 фпс

В шутеры не играешься потому что, иначе первым требованием было бы минимум 40 FPS. Когда активная пальба начинается, то от фрэймрэйта твоя успешность зависит (в сетевых баталиях ещё и от лага). От фрэймрэйта зависит скорость прицеливания. Если на поле брани вот такое происходит, то выживает тот, у кого выше фрэймрэйт и меньше сетевой лаг. Я это ещё по Сталкеру заметил: с низким фпс из пистолета практически невозможно в снорка или тушкана попасть (я в него на слабой видюхе начинал играться).

+1

Если на поле брани вот такое происходит, то выживает тот, у кого выше фрэймрэйт

Надо ли говорить, что ради этого в серьезных баталиях люди не то что выкручивают настройки графики на самый минимум (за исключением разрешения), но и иногда применяют специальные хаки, чтобы текстуры не прорисовывались?

А в видео крайсис на максимальных…

0

Играюсь в шутеры — теперь приходится снижать настройки и в 3D часто прибегать не к «честному» рендеру обоих ракурсов, а к ухищрениям.

0

Это ж сколько электричества она жрет и сколько тепла выделяет, что на нее такое охлаждение идет по дефолту?..

+1

НЛО прилетело и опубликовало эту надпись здесь

У меня на игровом ПК установлены две GTX680, в пиках вся система потребляет до 750 Вт. Если играю зимой, то отопление в квартире отключаю. Без шуток.

0

Интересно, на этом можно майнить?

+9

Вы о-очень долго будете окупать эту видеокарту майнингом.

Если сейчас у вас нет домашнего специализированного мэйнфрейма, думаю, можно забыть уже о майнинге.

Если сейчас у вас нет домашнего специализированного мэйнфрейма, думаю, можно забыть уже о майнинге.

+3

Почему же? Лайткоин и его аналоги в самый раз. Под них вроде ещё нет спец железа.

0

Помайнил как-то на своей asus hd 7950, теперь ловлю артефакты (экран скачет, полосы появляются). Хоть и совсем редко, но раздражает. Как добить видеокарту, чтоб заменить по гарантии? :) Или есть другие способы доказать, что карта умирает?

-3

Есть и появляется с каждым днем больше. Потому лайт в цене полетел.

0

darkcoin, hirocoin и прочие на солянке алгоритмов X11 (это не протокол X-сервера, если что) — для них асиков еще года два не предвидится

0

НЛО прилетело и опубликовало эту надпись здесь

Ну вот тут написано, что у GTX Titan 4495 GFLOPS, то есть 4,5 TFLOPS. Ну то есть R9 295X2 в теории быстрее где-то в два с половиной раза.

+3

Зима уже закончилась, поздновато обогреватели новые выпускать.

+16

Что-то терзают смутные сомнения насчет производительности. Tesla K40 при цене ~200т.р. имеет производительнось в пике на флотовой арифметике двойной точности ~1.4 терафлопса и кушает при этом ~250 Вт. А тут предлагают 11.5 терафлопс за 1500$ при потреблении 500 Вт? Или AMD сделали какой-то огромный технологический скачок, или они меряли производительность на интовой арифметике:-) Вообщем пока не увижу цифер полученных на Linpack(процентов 60% от пика на нём получить должны), не поверю в такую ацкую мощь)

з.ы. а всего каких-то 3 года назад Tesla M2090 с 400 гигафлопсами считалась последним достижение в производительном железе))

з.ы. а всего каких-то 3 года назад Tesla M2090 с 400 гигафлопсами считалась последним достижение в производительном железе))

+1

НЛО прилетело и опубликовало эту надпись здесь

В любом случае меня тут сильно смущает цена. Полторы тысячи баксов за такие можности — это ведь копейки, особенно когда тутже вдвое более слабая карта продается за 5600$)

0

НЛО прилетело и опубликовало эту надпись здесь

Не посчитайте за холиварные предпосылки, но нвидия всегда славилась завышенными ценами, бывали случаи, когда +\- аналогичные по характеристикам от АМД были на порядок дешевле, например R9 290x от 18к и GTX TITAN от 34к. Разницы в современных играх вообще никакой не будет (да и в будущих, на пяток лет вперёд), а цена ощутима ещё как.

0

Что нвидиа, что амд безбожно завышают цены на карты неигровой направленности.

7970 =400уе, а аналог firepro w9000 уже под 3-4тыс.уе

аналогично, titan =1000уе, tesla 40k =5000уе.

Поясняют это надежностью и разблокированными некоторыми возможностями, но не в 5-10 раз же…

7970 =400уе, а аналог firepro w9000 уже под 3-4тыс.уе

аналогично, titan =1000уе, tesla 40k =5000уе.

Поясняют это надежностью и разблокированными некоторыми возможностями, но не в 5-10 раз же…

0

В моём примере сравниваются игровые карточки — NV титан и самый простой референс AMD R9 290x, с разницей в цене в 2 раза при одинаковых характеристиках. Взять хотя бы Titan Z (сила и могущество NV) и приведённую в топике, которая по характеристикам круче этой самой Titan Z, а по цене разе в полтора-два дешевле — 1500$ против 2999$

0

Тесла — это те же карты, с парой замкнутых резисторов для идентификации. Погуглите, как из обычных топовых карт делают теслы простым перепаиванием пары резисторов. А остальное — чистый маркетинг.

0

Вообще-то мы тут видеокарту обсуждаем. Это если вы вдруг не заметили. 4K там всякие, etc. Видеокарты не работают с двойной точностью. Вернее формально-то поддержка есть, но чуть ли не в 10 раз медленнее чем для одинарной точности. Tesla — редкое, чуть не единичтое исключение: видеокарта, специально заточенная под даблы. Пускать на ней L4D2 — кощунство (хотя некоторые делают). Не для игр она совсем.

Так что я не понимаю ни ваших сомнений, ни удивлений. Честно.

Так что я не понимаю ни ваших сомнений, ни удивлений. Честно.

0

По идее, терафлопсы не могут быть «интовыми», в самом названии заложено. Хотя, считать по-разному можно, конечно.

0

Мм, у меня есть маленький кипятильник, он заставляет вскипеть кружку воды за какие-то 1,5-2 минуты. И его мощность 500 Вт. ИМХО скоро компьютер таки сможет заваривать чай/кофе!

+5

Мой телефон уже яичницу делает, а вы про компьютер.

+2

Идею на кикстартер :) тепловые трубки выводятся из корпуса в ёмкость на 5-10 литров из которой можно в течении четырёх дней пить горячий чай :) заодно пассивное охлаждение выходит :)

Сделать ёмкость в виде радиатора чтобы внешняя часть охлаждалась воздухом вокруг. Плюс эта штука может греть зимой. А летом будет включается активное охлаждение + создаёт поток воздуха в комнате.

Сделать ёмкость в виде радиатора чтобы внешняя часть охлаждалась воздухом вокруг. Плюс эта штука может греть зимой. А летом будет включается активное охлаждение + создаёт поток воздуха в комнате.

0

Тогда уже не так, а круче) Если просто вывести тепловые трубки в ёмкость с водой, то когда мы воду выпили — видюха перегреется. А если долго воду не пьём — она начнёт портиться, и пить её станет нельзя.

Надо сделать двухконтурную систему охлаждения, водно-водяную, как на атомных станциях. :) Первый контур — водяной, вода из него никогда никуда не уходит, гуляет по пути «тепловые трубки видюхи — тройниковый кран — большой радиатор воздушного охлаждения — тройниковый кран — тепловые трубки видющи». Её температура немного выше 100 градусов за счёт повышенного давления. Захотели чаю — оба крана переводятся в другое положение, и теперь вода течёт по пути «тепловые трубки видюхи — тройниковый кран — маленький водно-водяной змеевик — тройниковый кран — тепловые трубки видюхи». Змеевик расположен в ёмкости с питьевой водой и кипятит её. Тройниковые краны можно сделать управляемые электричеством и программно, чтоб чай можно было заварить кликнув по ярлыка на компе)))

Но всерьёз вряд ли такое можно запустить в серию) Разве что как прикол или для какой-нибудь компьютерной выставки.

Надо сделать двухконтурную систему охлаждения, водно-водяную, как на атомных станциях. :) Первый контур — водяной, вода из него никогда никуда не уходит, гуляет по пути «тепловые трубки видюхи — тройниковый кран — большой радиатор воздушного охлаждения — тройниковый кран — тепловые трубки видющи». Её температура немного выше 100 градусов за счёт повышенного давления. Захотели чаю — оба крана переводятся в другое положение, и теперь вода течёт по пути «тепловые трубки видюхи — тройниковый кран — маленький водно-водяной змеевик — тройниковый кран — тепловые трубки видюхи». Змеевик расположен в ёмкости с питьевой водой и кипятит её. Тройниковые краны можно сделать управляемые электричеством и программно, чтоб чай можно было заварить кликнув по ярлыка на компе)))

Но всерьёз вряд ли такое можно запустить в серию) Разве что как прикол или для какой-нибудь компьютерной выставки.

0

Не видно сверху разъема для CrossFire.

я что, не смогу четыре таких карточки в свой домашний комп втулить?

0

Присмотритесь внимательней, он есть.

0

И по мерцающему от падения напряжения свету в своих квартирах соседи через месяц-другой уже смогут определять, в какую же игру вы сегодня играете :)

+9

Этот разъём больше не нужен.

Видеокарты AMD R9 работают в CrossFire без мостика, всё через PCI express.

Видеокарты AMD R9 работают в CrossFire без мостика, всё через PCI express.

+4

В качестве нового мерила, надо писать количество килохешей, которые она выдает )

+2

Судя по wiki, сейчас подобное из продающегося — это две GTX 780 Ti, которые дадут порядка 10.9 ТФлопс с примерно тем же уровнем TDP и чуть более низкой ценой.

Вообще занятная печка, жду реальных сравнений.

Вообще занятная печка, жду реальных сравнений.

+2

К сожалению, только в одинарной точности. В двойной точности GTX 780 Ti на уровне старых 580.

0

Так ведь в посте про одинарную точность и написано. По ней и сравнивал.

Для двойной вот есть GTX Titan Black, которые вместе дадут 10.2Tflops одинарной и 3.4Tflops двойной.

Да и вот анонс Titan Z с 16Tflops и 12ГБ оперативки.

Для двойной вот есть GTX Titan Black, которые вместе дадут 10.2Tflops одинарной и 3.4Tflops двойной.

Да и вот анонс Titan Z с 16Tflops и 12ГБ оперативки.

+1

Ну, 790 на подходе. Будет примерно то же самое.

0

Ну, самый — не самый. Пожалуй, самый доступный из линейки «заоблачных». А так есть и покруче непрофессионалка: www.nvidia.ru/object/announcing-the-geforce-gtx-titan-z-25032014-ru.html

0

Нет, R295X2 как раз выкатили в ответ на Titan Z, и думается, что R9 295X2 будет чуть-чуть быстрей, нет же смысла выкатывать в ответ менее производительную карту?:)

0

Ну война AMD и NVIDIA далеко не всегда состоит из адекватных ответов что с той, что с другой страны. Если судить по характеристикам, то зелёную карту не удалось переплюнуть. Ждём сравнительных тестов.

0

Если судить по характеристикам, то удалось. Шина памяти 512 бит x2 против 384 бит x2, 11 тфлопс против 8, СОЖ в комплекте.

Titan Z имхо получился бестолковой видеокартой — только как музейный экспонат, так как если нужна именно видеокарта, то и две 780ti и две Titan BE окажутся предпочтительнее, да много чего окажется предпочтительнее.

Titan Z имхо получился бестолковой видеокартой — только как музейный экспонат, так как если нужна именно видеокарта, то и две 780ti и две Titan BE окажутся предпочтительнее, да много чего окажется предпочтительнее.

0

Жду ответ от Nvidia, я их больше люблю ;)

+5

Ответ от nvidia может быть только один: снизить цену на двухголовый Titan Z.

+5

Я вот аналогично не понимаю политику ценообразования.

Если в амд получив из двух карт по 700уе одну за 1500 я ещё могу накинуть там на надежность, пару сотен долларов за топовость и т.п.

То как из двух титанов за 1000уе получить титан z за 3000 не понимаю. Тут или выход годных чипов у нвидиа менее 50% или маржа за топовость более 1000уе.

Если в амд получив из двух карт по 700уе одну за 1500 я ещё могу накинуть там на надежность, пару сотен долларов за топовость и т.п.

То как из двух титанов за 1000уе получить титан z за 3000 не понимаю. Тут или выход годных чипов у нвидиа менее 50% или маржа за топовость более 1000уе.

0

Если вам нужна одна топовая карта, то можно взять одну за 1500 или 2 за 700 и получить одно и то же. Если на деньги все равно и нужен выставочный хайэнд, то вы ставите 4 по 1500. Не спрашивайте только «зачем».

0

Ну да, я так и написал, 2 по 700 против одна по 1500 я могу принять.

Но две по 1000 против одной за 3000 — уже перебор.

Но две по 1000 против одной за 3000 — уже перебор.

0

А 4 по 3000 против 4 по 1000, если нужна максимальная производительность любой ценой?

0

За разницу в цене 12 тыс — 8тыс = 4 тыс.уе я бы присматривался к материнкам с 8 pci-express слотами.

лишних 4 тыс. как раз на пару-тройку дополнительных CPU, что для загрузки 8 карт будут не лишними.

www.supermicro.nl/products/motherboard/Xeon/C600/X9QR7-TF-JBOD.cfm

лишних 4 тыс. как раз на пару-тройку дополнительных CPU, что для загрузки 8 карт будут не лишними.

www.supermicro.nl/products/motherboard/Xeon/C600/X9QR7-TF-JBOD.cfm

0

Компания NVIDIA официально представила двухпроцессорную видеокарту GeForce GTX TITAN Z, которая оснащена 12 ГБ видеопамяти и разработана для игр с разрешением 5K и обладателей многомониторных систем.

В конфигурации используется два чипа GK110, которые суммарно наделяют ускоритель 5.760 ядрами CUDA. При этом для охлаждения используется система с одним вентилятором. Производительность видеокарты равна 8 TFLOPS, а стоимость составляет $3000.

www.youtube.com/watch?feature=player_embedded&list=UUHuiy8bXnmK5nisYHUd1J5g&v=_j5WaLr0DJk

Наконец то можно собирать новый ящег за тонну денег для игры в Симулятор Козла на мониторе 4к (который тоже буду брать). Нищебродская ATI как сосала так и сосет, ИМХО

В конфигурации используется два чипа GK110, которые суммарно наделяют ускоритель 5.760 ядрами CUDA. При этом для охлаждения используется система с одним вентилятором. Производительность видеокарты равна 8 TFLOPS, а стоимость составляет $3000.

www.youtube.com/watch?feature=player_embedded&list=UUHuiy8bXnmK5nisYHUd1J5g&v=_j5WaLr0DJk

Наконец то можно собирать новый ящег за тонну денег для игры в Симулятор Козла на мониторе 4к (который тоже буду брать). Нищебродская ATI как сосала так и сосет, ИМХО

-16

Наконец то можно собирать новый ящег за тонну денег для игры в Симулятор Козла на мониторе 4к (который тоже буду брать). Нищебродская ATI как сосала так и сосет, ИМХО

— Я надеюсь, это ирония?

— Я надеюсь, это ирония?

0

Все правильно! Купите же скорее приложение «Я богат» на айфоне!

+12

Единственное, в чем видеокарта от ATI уступает — количеством памяти, а именно 8 GB против 12 GB.

Производительность же 11.5 TFLOPS против 8 TFLOPS.

Если учесть цену 1500$ против 3000$, можно сделать объективные выводы.

Производительность же 11.5 TFLOPS против 8 TFLOPS.

Если учесть цену 1500$ против 3000$, можно сделать объективные выводы.

+1

Ошибся веткой.

0

Одиннадцать терафлопов за полторы тысячи долларов 0_o

Это нечто. Скоро небольшие лаборатори смогут позволить себе собирать мини-фермы.

Это нечто. Скоро небольшие лаборатори смогут позволить себе собирать мини-фермы.

0

Вообще такие вычислительные ресурсы логично использовать на что то кроме игрушек…

Например воткнуть ее в вебсервер и отдать ей работу по шифрованию https (первое что пришло в голову)

Например воткнуть ее в вебсервер и отдать ей работу по шифрованию https (первое что пришло в голову)

0

Производитель обещает низкую температуру и небольшой уровень шума в купе со стабильной производительностью.

«В купе» — это в мягком вагоне, а здесь всё-таки надо писать вместе.

+3

Именно примерно такище мощности я ожидал увидеть в текущих «next-gen» консолях от Sony и Microsoft, чтобы работали игры в 4K.

+1

Интересно, сколько гигахешей оно выдает? ))

0

Я как-то пропустил момент, когда производительность видеокарт стала измеряться в террафлопах… Круто!

0

По моему рост вычислительных мощностей видеокарт стал несколько обгонять закон Мура)

0

Закон Мура не о вычислительной мощности а о кол-ве транзисторов.

Но тенденция мне нравится: видеокарты нынче слабенькие — даже рэйтрэйс нормальный не сделать. Вырастет производительность видюшек в тысячу раз — будут красивые, реалистичные игры, а пока нет таких мощей, геймдевелоперы так и будут со всякими шэйдерами (и прочими костылями) играться. Вырастет производительность CUDA во столько же раз — будет динамика жидкостей и газов в играх, а пока так и будем на рэгдол смотреть.

Но тенденция мне нравится: видеокарты нынче слабенькие — даже рэйтрэйс нормальный не сделать. Вырастет производительность видюшек в тысячу раз — будут красивые, реалистичные игры, а пока нет таких мощей, геймдевелоперы так и будут со всякими шэйдерами (и прочими костылями) играться. Вырастет производительность CUDA во столько же раз — будет динамика жидкостей и газов в играх, а пока так и будем на рэгдол смотреть.

0

Проблема в том, что с ростом производительности растет рост стоимости разработки игр, причем довольно сильно. Соответственно будет еще меньше новых игр от крупных компаний, потому что это огромные финансовые риски. Выгоднее сделать очередной Call of Assasins Creed.

И для инди это тоже будет тяжело, потому что разрыв между графоном и инди вырастет еще сильнее, что тоже не на руку инди.

И для инди это тоже будет тяжело, потому что разрыв между графоном и инди вырастет еще сильнее, что тоже не на руку инди.

0

Эххх. Такую бы красоту да пару лет назад. Биткойники помайнить. Купил бы остров и выращивал бананы уже, для личного потребления. )))

0

Ждем выпуска Microsoft Word 2015 с новым анимированным и видео интерфейсом, который будет тормозить даже на AMD Radeon R9 295X2! :)))

-1

Зарегистрируйтесь на Хабре, чтобы оставить комментарий

Анонсирован самый быстрый в мире ускоритель AMD Radeon R9 295X2