Комментарии 145

Например, интуиция — прямое получение знания о будущем состоянии реальности без постройки детальной модели

Ну и как сделать это прямое получение знаний? Опишите этот процесс в виде формул, структуры данных для знаний, алгоритмов. Ведь все это придется программировать. Нельзя компьютеру сказать: «получи прямым образом знания из базы!» Это так не работает.

В том-то и дело, что это никак не сделать…

Я не вижу большой проблемы описать бессознательные процессы в рамках этой концепции. Просто мне придется тогда изменить определение «сознания», поэтому я и написал что нужно время.

На вскидку — логично предположить что сознание — некий фокус на текущем моменте, а построение и анализ модели может происходить и за пределами этого фокуса…

В том-то и дело, что это никак не сделать…

Это сделано в мозге, значит это можно повторить.

Механистический подход к жизни не единственный

Кто бы спорил…

Мне тоже близка концепция в стиле «органы чувств не столько источник информации о мире, сколько фильтр», но…

Что-то мне говорит, что одно другому не мешает. Иметь чисто механистическую парадигму, хотя бы для того, что бы допустим на практике доказать, то она не работает — уже не плохо! ;)

А насекомые?

Пока склоняюсь к мысли, что насекомые просто реагируют. Так, как заложено природой. У них просто нет такого количества нейронов, что бы строить модель.

Есть мнение, что обучением, построением прогнозов и абстракциями занимается неокортекс — сравнительно позднее нововведение. В таком случае проблемы не только у насекомых, но и у рептилий, например.

Одна из функций сознания — осознание, т.е. обработка данных с рецепторов…

Это конечно вопрос терминологии, но я бы сказал, что обработка данных с рецепторов — это восприятие, а не сознание. Большую часть этой информации вы обрабатываете бессознательно.

Но кроме поверхностной части сознания есть совсем темная и неизученная часть — подсознание…

Мне нужно время, что бы подумать над этим.

Муравейник это сложнейшее техническое сооружение, а не куча мусора, в которой живут муравьи…

Вы же понимаете, что техническая сложность и интеллектуальная деятельность коррелируют весьма относительно? Например: фракталы…

Но с моей точки зрения это глупость, потому что тогда можно сколь угодно сложное поведение объяснять не разумом, а инстинктом.

Да в принципе — можно. Вопрос — нужно ли? Есть же принцип Окама и здравый смысл… У муравьев просто нет нужного количества нейронов… да и некоторые факты, вроде хороводов смерти говорят о достаточно простой, хоть и весьма занятной организации этих насекомых.

Вот например, я прямо сейчас чисто инстинктивно прочитал ваш ответ и аналогичным образом написал свой.

Если так — то Тест Тьюринга вы прошли, т.к. я не смог отличить имитацию разума от настоящего! ;)

Тогда вопрос поставлю так — чем восприятие вообще отличается от сознания?

Восприятие может быть сознательным и бессознательным. Значит как минимум это не одно и то же.

Хорошо, что вы обьяснили. Плохо, что я не понял… (

Так можно продолжать до бесконечности, жонглируя не определенными философскими терминами. На данный момент невозможно дать нормального определения сознанию. Да и разуму тоже. Лучший вариант: «выглядит как утка и крякает как утка», т.е. действует похоже на человеческий разум. А что значит «похоже»? Насколько похоже, в каких единицах измерять эту похожесть — тоже не определено.

И нет, вы не правы. Приведенное мной определение сознания несколько подробнее, чем утверждение «Разум есть модель». Я первым делом указал, что модель не абы чего а реальности, и формируемая не кем иным, как существом, которое воспринимает данную реальность непосредственно. Т.е. большая часть элементов модели не являются абстракцией. Например «пространство» имеет значение только в том случае, если оно воспринимаемо: возможность перемещения в пространстве, локализация себя и других объектов в нем, восприятие формы и размера и тп.

Мозг помимо создания модели мира, имеет также механизмы эффективного поиска по этой модели. Причем похоже, что этот поиск (выбор лучших ассоциаций, да и вообще формирование самих ассоциаций) был подобран эволюцией через биологию происходящих процессов в мозге, например с какой скоростью нейромедиаторы перемещаются в пузырьках везикул от сомы к синаптической щели и т.д…

Просто ряд соображений:

Когда я сталкиваюсь с решением какой-то задачи, будь то выбор в магазине или размышления над серьезной проблемой — у меня нет ощущения «высокой размерности». Может поэтому я паршиво играю в шахматы и вообще не люблю игр с высокой вариативностью, где у меня слишком мало критериев для выбора «правильного» хода.

И мне кажется, что это не какой-то волшебный механизм, подобранный эволюцией! просто в рамках любой конкретной ситуации полнота модели и процессное восприятие обеспечивают довольно ограниченный набор подходящих решений… Блин, сложно объяснить, нужен пример.

Это как с нейронной сетью — она же не ищет (перебором), правильно? Она просто автоматически по весам нейронов получает нужный выход, по входным данным. Правильно? Так и здесь — выходом будет классификация ситуации определенным образом, до тех пор, пока не будет одной подходящей стратегии для развития в нужном направлении.

Понимание это построение правильной модели. Правильная — это когда информационные элементы модели соответствуют элементам реальной системы. Чем больше соответствий, тем более правильная модель.

Но это не делает такого робота разумным.

Во-первых, как он должен двигаться, чтобы набрать статистку для построения этой внутренней модели мира? Случайно и как-то иначе?

Во-вторых, как на базе этой модели мира (полной, адекватной, правильной), ему теперь действовать, чтобы он по команде человека отправился мыть посуду?

Но это немного не то. Это скорее ближе к концепции Джеффа Хоккинга «память-предсказание», которую он изложил в книге «ОБ интеллекте».

Для того, что бы это было ближе к нашему представлению о модели робот скорее должен строить карту доступного к перемещению пространства, локализовать себя в нем, иметь какую-то модель будущего (например «отсутствие белых пятен на карте»), и следовать этой модели. как он будет при этом перемещаться — не столь важно, но может продемонстрировать степень интеллектуальности. Например, если он будет продолжать двигаться случайно при небольшой необследованной зоне — это не тот вариант поведения, который хотелось бы ожидать от машины с зачатками разума. ;)

В латентном слое этого VAE будет содержаться модель реального мира

Нет, там будет модель кадров. Ассоциативный массив jpg -> jpg. Модель мира — это наличие для каждого реального объекта, их взаимодействия или взаимного расположения соответствующего элемента модели. Если сеть не может представить человека отдельно на произвольном фоне без предъявления фотографии, значит у нее нет модели этого человека. Если сеть не может выделить общее движение у двух шагающих людей и потом его узнать, значит у нее нет понятия "шагать". Нет элементов, к которым можно привязать слово или словосочетание, поэтому правильной модели нет, поэтому и команды он не поймет, тем более с собирательным понятием "посуда". Кстати, мысль "меня просят помыть посуду" это тоже модель того, что происходит в реальности.

Конечно, там много технических сложностей, чтобы эти концепции сформировались. Размер внутреннего слоя, обучающая выборка. Это ведь происходит не просто так, а вынужденная мера из-за сжатия информации. Если будет более простой способ, то сеть использует его. Но уверяю вас, это работает. Есть масса примеров, когда предобученные на одной задаче сети, например выделяющие котиков, потом используются для совсем других. Например строят карту глубины, или выдают кватернион поворота камеры. Не учатся с нуля, а используют полученные ранее концепции что мир трехмерный, что котик имеет длину, что хвост может быть загорожен лапами и т.д…

Я же хочу строить такую модель, в которой действие и мотивация к действию — часть модели.

Есть такое направление в машинном обучении — Goal ориентированное обучение. Вы просто строите модель мира вместе с предпринятыми действиями. А потом на входе модели (нейросеть в данном случае) подаете цель (goal), которую хотите достичь. А модель сразу выдает действия, которые нужно для этого предпринять. Довольно близко к тому, как вы излагаете в статье. Почти чистый Model-based.

Обучение для этого делается инвертированным: робот совершает какие-нибудь действия и смотрит, к чему это привело. А потом делает финт ушами: на вход нейросети кроме текущих наблюдений подает также награду (goal), которую он получил. А на выходе ставит последовательность действий, приведших к этой награде. И обучается так на всем опыте, даже на плохих наградах. А потом просто подает на вход явно завышенную высокую награду, которую хочет получить, а обученная нейросеть выдает действия, которые нужно предпринять для ее достижения.

Интересная концепция, хоть в чистом виде и не работает (только в отдельных частных случаях, с подбором гиперпараметров).

Я довольно много (но безуспешно) экспериментировал с этим.

Блин, вот это было бы интересно… Расскажите! Можно в общих чертах — что пробовали, почему не получилось.

Интересная концепция, хоть в чистом виде и не работает (только в отдельных частных случаях, с подбором гиперпараметров).

Может ее надо просто немного развить/поменять? ;)

Кроме стандартных алгоритмов RL, я пытался добавлять туда эффекты, которые обычно не используют — усталость/бодрость, любопытство, сытость/голод, случайный микротремор конечностей и т.д… Думал, что это может привести к более реалистичному результату. Ведь нет необходимости, чтобы в алгоритме обучения была искусственно встроена экономия усилий путем штрафов к награде за резкие движения, как это обычно делают в Reinforcement Learning. Если персонаж будет уставать и просто не сможет шевелиться от усталости, то это автоматически должно приводить к обучению с экономными движениями (иначе цели просто не достигнет).

Но никаких особых успехов я не достиг, столкнулся с теми же проблемами, с которыми сталкивались все в обучении с подкреплением — нестабильные градиенты, жесточайшая зависимость от подбора начальных условий, подбора гиперпараметров, частоты наград и т.д…

Там будет именно модель мира. Просто берете этот внутренний слой нейронов

Берем первый нейрон внутреннего слоя. Какому объекту или явлению в реальности соответствует сигнал с него равный 1? Можно группу взять, неважно. Если мы не можем это сказать, если там это распределено по весам и срабатывает только всё вместе, то это не модель.

Суть в том, чтобы у нас срабатывали одни и те же информационные элементы для каждого знакомого понятия, и чтобы каждым понятием можно было оперировать отдельно без его предъявления.

и линейной регрессией получаете из него контур человека на любой фотографии.

Ага. Берем фотографию другого человека и той же регрессией получаем контур. Значит сеть не отличает одного человека от другого. Убираем фотографию, и никак не можем получить контур человека. А если и можем, то усредненный, а не конкретного Васи или Пети.

Это не модель. Модель это четко заданное соответствие между реальными объектами и информационными.

Если обучалась по видео, то выделит концепцию «шагать».

Как определить, что она выделила именно концепцию "шагать"?

Если мы не можем это сказать, если там это распределено по весам и срабатывает только всё вместе, то это не модель.Я так понимаю идея такая: прогоняем через подобную систему 100500 фоток или что там еще. Потом даем «чистое» (т.е. выделенное) изображение человека… Или несколько разных людей. То, что будет на выходе — это «сигнал», соответствующий понятию. Насколько он будет постоянным (будет ли в нем хоть что-то постоянное, без специального натаскивания именно на людей) — как раз и показывает, насколько сеть смогла выделить в своей модели понятие «люди».

Как определить, что она выделила именно концепцию «шагать»Так же. Дать ряд примеров, где шагают и извлечь постоянную составляющую — это и будет понятие «шагать»…

Как я понимаю — это сферическая концепция в вакууме, которая в лоб работает не очень хорошо. Ее можно и нужно иметь ввиду, но с разумной степенью осторожности.

Так проблема нейросетей в том, что обычно нельзя выделить эту составляющую. Даже отдельное направление есть для разработки сетей, которые могут объяснять свой вывод.Не, не, не… ;)

Это разные задачи: Выделить составляющую и объяснить свой вывод. Объяснить свой вывод сеть не может — это просто подобранные веса во внутренних слоях.

А вот выделить некую корреляцию — вполне реально.

«Чистое изображение человека» тоже не нужно, это классы, а сначала нужны конкретные объекты, которые потом будут объединяться в классы на основе сходства признаков.Я немного общее представление имею, но DesertFlow поправит, если что: то, о чем вы говорите, так примерно работают сверточные сети. В случае с анализом изображений, сначала работает сеть, обученная извлекать графические примитивы (линии, углы, контуры и тп) — результат ее работы подается на вход следующей сети, которая умеет находить элементы, типа глаза/уха/крыла/хвоста (а так же колеса/окна и прочего). Из них собираются объекты и в теории можно продолжать дальше. Могу ошибаться.

Берем первый нейрон внутреннего слоя. Какому объекту или явлению в реальности соответствует сигнал с него равный 1?

А у человека где хранится сигнал, соответствующий концепциям? В нейросети так же. Это уже доказанный факт, что там формируются аналогичные структуры, как у людей.

Пруфы:

1) в сверточных сетях по слоям формируются такие же паттерны, как у животных в биологическом мозге.

2) в нейросетях, как и у людей, формируются «нейроны места» (нейроны, отвечающие за позиционировании в пространстве): https://habr.com/ru/post/438526/

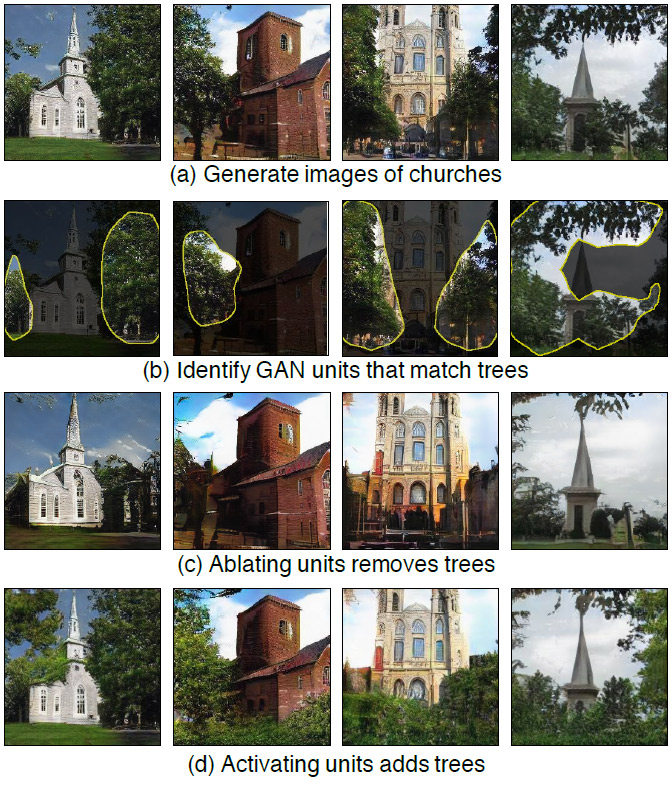

3) Недавняя работа GANpaint , показавшая что в нейросетях формируются концепции, аналогичные как в биологическом мозге. Как раз то, о чем вы говорите: в этой программе искусственно активируют нейроны, ответственные например за концепцию «трава», и она добавляет траву на картинку. Фокус в том, что это именно концепция травы, а не просто рисование травы где угодно. Так, на фоне неба она траву не добавит, потому что на облаках трава не растет.

Ну и тому подобное, все это уже довольно хорошо изучено и экспериментально доказано.

Если мы не можем это сказать, если там это распределено по весам и срабатывает только всё вместе, то это не модель.

Ха, ну тогда и человек не строит модель мира, раз не можем указать конкретные нейроны, да? Просто это сложно, большое количество весов и все такое. Но какие-то зоны мозга, ответственные за конкретные эмоции и концепции уже умеют выделять. Просто МРТ показывает области с миллионами и миллиардами нейронов (этот аппарат ведь всего лишь регистрирует резонансные колебания атомов водорода в воде в крови, а вовсе не активность самих нейронов. просто активные нейроны потребляют больший приток крови, что и фиксирует МРТ). Даже тыканье тончайшей иголкой-электродом фиксирует активность сразу сотен нейронов. Отследить активность одного нейрона это очень сложная задача. Не говоря о том, что эксперименты с электродами доступны только на уже больных людях — эпилептиках и т.д., а не на всех подряд.

Это не модель. Модель это четко заданное соответствие между реальными объектами и информационными.

Вы говорите о математической модели с четкими формулами. Но даже математическая модель может иметь не жесткое соответствие — бывают вероятностные модели и т.д… Не вижу смысла вдаваться в терминологию. Если вы можете предсказать куда прилетит мяч и заранее поднимаете руки в это место, чтобы его поднять — то в вашем мозгу есть модель физического мира.

А у человека где хранится сигнал, соответствующий концепциям?

Мне это конечно неизвестно. Но есть факт — мы можем представить каждое понятие отдельно, узнавать его как "то же самое" при последующем наблюдении, и комбинровать с другими понятиями произвольным образом. Значит оно каким-то образом представлено. Я специально говорю "информационный элемент", а не нейрон. Это может быть "бабушкин нейрон", или постоянный набор сигналов, который может создаваться разными нейронами, или еще что-то.

Про пруфы.

1)

В статье с этой картинкой есть такая фраза:

"this is only an example: real life convolution filters may detect objects that have no meaning to humans"

Это на мой взгляд неправильное поведение. Информация приходит только извне, значит любой сигнал с нейронов должен означать что-то с ней связанное, значит и человек сможет эту связь найти.

В работе, на которую там ссылаются, конкретно такой картинки нет. Но написано, что сеть тренировали на конкретных классах изображений — лица, машины и т.д. Там есть фраза "The images were unlabeled in that the position of the object is unspecified", что как я понимаю означает, что правильная категория, к которой надо отнести изображение, все-таки задавалась извне. То есть это классификация, а не выделение конкретных объектов.

Также я не нашел информации про устойчивость к сдвигу и повороту. Если сеть при небольшом сдвиге перестает определять объект как "тот же самый", то это тоже не та модель, о которой я говорю.

2) Я согласен, что есть движение в правильном направлении, как и картинка из предыдущего пункта, особенно "Layer 1". Просто этого мало, и это еще не такая модель, которая нужна.

3) Да, это уже ближе к истине. Если они смогут приделать к этим концепциям слова и генерировать картинку по текстовому описанию, будет круто. Практически настоящее воображение. А там и до переводов текста недалеко. Только они почему-то решили ограничиться рисованием.

Ха, ну тогда и человек не строит модель мира, раз не можем указать конкретные нейроны, да?

Нет. Потому что мы не можем указать нейроны по другим причинам. Они просто очень маленькие, и нет возможности отслеживать каждый. А в компьютерных программах к любой ячейке памяти есть доступ.

Вы говорите о математической модели с четкими формулами.

Совсем не об этом, у меня нет ничего про формулы. Модель это заданное соответствие реальных и информационных объектов. Информационный объект может не иметь известных деталей. Если человек видит пещеру на склоне холма, у него в воображении появляется некий объект, который ее обозначает. Но пока он не зайдет внутрь, у него не будет модели того что внутри.

Если вы можете предсказать куда прилетит мяч и заранее поднимаете руки в это место, чтобы его поднять — то в вашем мозгу есть модель физического мира.

Да, именно об это я и говорю. Только с предсказанием цвета пикселей на следующем кадре это никак не связано. Для этого нужно иметь в воображении отдельные информационные объекты, соответствующие мячу и характеру его движения.

тогда и человек не строит модель мира, раз не можем указать конкретные нейроны

Можем, нейроны «бабушки» / «Дженнифер Энистон».

Я тоже думал в этом направлении. Наверно в этом что-то есть.

Черт, я ведь искал же, что есть на хабре на эту тему, но вашу статью почему-то не увидел...

Если бы увидел — заранее изучил бы комментарии и возможно внес бы коррективы в текст...

Добавлю ссылку на вас в шапку статьи, как буду у компа.

Вот представьте, что у вас есть полная модель мира (база знаний), а дальше что? Как в ней ориентироваться, как искать нужные ответы? Модель мира не может дать ответа на вопрос «Какую ногу надо поднять, чтобы сделать шаг?». Она, как и любая база знаний, может отвечать только на конкретные вопросы по динамике мира. Например: «На сколько градусов поднимется нога, если я буду развивать мышцами усилие 40 Н в течении 2 секунд?».

Чувствуете разницу? Чтобы получить ответы, характерные для разума, нужно эти ответы как-то искать в имеющейся модели мира (или базе данных). И никто не знает, как разум это делает в таком огромном разнообразии возможностей (пространстве решений). Надо что, спрашивать у модели мира про все возможные усилия с шагом 1 Н и временем 0.1 сек (а почему не с меньшим или большим?), чтобы потом выбрать вариант, который поднимает ногу выше всего? А если нужно сделать длинную последовательность действий, как ходьба?

Поэтому голый Model-Based подход не работает. Даже если у нас есть идеальная модель мира и мы будем перебирать в ней все возможные варианты, проклятие размерности быстро сводит такие попытки на нет.

Разум не просто строит модель мира. Он еще как-то осуществляет в ней поиск (через ассоциации, очевидно), чтобы выбрать действия, которые приведут к награде. Проблема создания разума не в модели, а в том как реализовать этот поиск. Сейчас считается, что преднастройку физиологии мозга произвела эволюция. Настроила работу нейромедиаторов, скорость формирования новых связей между нейронами и забывания старых, что и формирует образование ассоциаций в мозге, исходя из того, что было выгодно для выживания конкретной особи животного. Точнее, особи с худшими настройками просто вымерли, а выжили только такие, что есть сейчас.

Я поясню насчет эволюции. Как сейчас обучают нейронные сети? Сравнив выход сети с тем, который должен быть (в случае обучения с покреплением — награда оказалась выше или ниже), мы всегда знаем, нужно увеличить или уменьшить конкретную связь между двумя конкретными нейронами. Но насколько именно ее нужно изменить — неизвестно. Надо умножить текущую ошибку на 0.001, 0.1, на 0.0000001? Сейчас условно берут скорость обучения (learning rate), скажем, 0.0001. На это число умножают ошибку и прибавляют к текущему весу нейрона.

Это число 0.0001 применяется ко всей сети и подобрано экспериментально, потому что так заработало. Но из-за того что это число везде одинаково, где-то связи слишком сильно меняются, а где-то слишком мало. Обычно делают это число очень маленьким, чтобы изменения были небольшие, но из-за этого требуется показывать нейронной сети миллионы примеров, чтобы связи между нейронами доросли с такой скоростью обучения до нужного размера. Но главное — в задачах с нестабильными градиентами, где они прыгают и бывают направлены в разные стороны (как это происходит в большинстве задач reinforcement learning), таким образом нейросеть вообще не может обучиться!

В живом мозге это число подобрала эволюция. Если взять обычную нейронную сеть, где learning rate у каждого нейрона или у кластеров нейронов будет свой, и сделать его динамическим, как-то привязав к получению награды. То получится очень похоже на то, что происходит в живом мозге. Будет возможность обучаться на единичных примерах, обучаться в течении всей жизни и т.д… Но ни как сформировать такие кластеры (и как их соединять с другими кластерами), ни как подобрать правила изменения learning rate для отдельных нейронов или кластеров — на данном этапе неизвестно.

В живом мозге все это сделала эволюция.

Я просто хочу пояснить.

Я не говорю о том, что знаю, как работает мозг и как реализовать его подобие на уровне, так сказать, аппаратном. Речь на данном этапе о концепции. Если мы принимаем (а у меня складывается ощущение, что принимаем — так или иначе) концепцию, то дальше перед нами большой ряд вопросов технических. А там — море нюансов! Например в случае с нейронной сетью вопрос может быть в настройке веса, а может быть в том (в отношении изображений), что мы пытаемся (пытались) анализировать статичную картинку целиком а в реальности присутствуют саккады и динамика. Как только это поняли — сверточные сети и вобщем-то прорыв в распознавании. Т.е. технические проблемы преодолимы. Можно пытаться реализовать все, как в природе, а можно использовать гибридный подход… Ну собственно все так и делают — ничего нового я не написал.

Они строят модель мира именно как у вас описано — полную, непротиворечивую и так далее.

Нет, но это не принципиально. Они строят модель того, с чем не взаимодействуют непосредственно. Т.е. это все еще китайская комната.

Вот представьте, что у вас есть полная модель мира (база знаний)

А на каком основании вы вывели тождество база знаний=модель мира? Это далеко не одно и то же.

а дальше что? Как в ней ориентироваться, как искать нужные ответы?

А как вы это делаете в реальной жизни? Вот я у вас спрошу: какую ногу надо поднять, что бы сделать шаг? Вы соотнесете вопрос с моделью: что такое шаг, как вы его делаете… Это совершенно конкретное ощущение вашего организма. Ответ: любую.

Вы не задаете себе таких вопросов — ваш организм является частью модели и он умеет соответствовать ей.

И никто не знает, как разум это делает в таком огромном разнообразии возможностей (пространстве решений).

А вы твердо уверены, что разнообразие огромно? Ваш пример про ногу некорректен: организм почти случайным образом учится управлять телом и не занимается такой ерундой, как что бы решать какие мышцы в каком порядке напрягать: у него было около двух лет в начале жизни на то, что бы выбрать оптимальную схему и ей следовать.

Ну и вообще по жизни — приведите пример анализа «огромного разнообразия и пространства возможностей»? В каждом конкретном случае работает правило прецедента: в прошлый раз в такой же (на определенном уровне обобщения) ситуации действие было такое-то, результат — такой-то. Оценочная функция определяет считать ли опыт успешным, или, как вариант — попробовать что-то новое…

Проблема создания разума не в модели, а в том как реализовать этот поиск.

Давайте наберем пару-тройку примеров, что бы можно было понять в чем проблема поиска… В глобальности модели? Но она хорошо «индексирована» и связана ассоциациями. Я пока не вижу серьезной проблемы поиска, хотя вполне вероятно, что она есть.

Вообще не хватает, конечно практической реализации… Я все хочу запилить нечто в сильно условном мире, но пока и руки не доходят и скил не тот.

Нет, но это не принципиально. Они строят модель того, с чем не взаимодействуют непосредственно. Т.е. это все еще китайская комната.

Китайская комната — это мнимый философский парадокс. На самом деле его не существует.

Насчет взаимодействия — а как же роботы, которые обучаются в виртуальных физических симуляторах? Они как раз строят свои модели мира только на основе своего опыта. С чем взаимодействуют непосредственно. Да, их мир очень упрощенный, но принципиально не отличается от нашего.

Но и по внешним данным можно построить адекватную модель мира. Смотрите, пусть у нас будет набор фотографий из реального мира. Мы подаем на вход нейросети фотографию и требуем, чтобы на выходе она выдала эту же самую фотографию. Это принципиальная схема обычного автоэнкодера. Фокус здесь в том, что внутренний слой делаем из меньшего числа нейронов, чем вход и выход. Нейронная сеть вынуждена сжимать информацию, пропуская ее через этот узкий внутренний слой. А это ни что иное, как формирование модели мира в этом внутреннем слое h.

Теперь мы можем взять только этот внутренний слой h, содержащий модель мира, и на его основе строить любые выводы, любые рассуждения. Проблема создания разума как раз в том, что дальше делать с этой моделью мира.

p.s. Модель мира в автоэнкодере будет вполне адекватной. Можно вместо картинок взять видео, и тогда модель будет содержать динамику. Можно камеру поставить на робота, и тогда модель будет включать взаимодействия с миром.

Давайте наберем пару-тройку примеров, что бы можно было понять в чем проблема поиска… В глобальности модели? Но она хорошо «индексирована» и связана ассоциациями. Я пока не вижу серьезной проблемы поиска, хотя вполне вероятно, что она есть.

Я наверно неправильно использовал слово "поиск". Как раз любые известным нам вида поиска, вроде случайного поиска, на имеющихся моделях реальности (физических симуляторах, внутренних слоях нейронных сетей и т.д.) не работают. Слишком велика размерность ландшафта решений. Не существует никаких индексированных и хорошо связанных ассоциациями баз, отражающих всю сложность реального мира. Делать такие еще не научились.

Чтобы получить такую базу, нужен механизм снижения размерности, как это происходит в мозге. И как-то выдавать приоритеты разным ассоциациям. И непонятно как вообще строить ассоциации. Не на словах, а чтобы это можно было запрограммировать.

Китайская комната — это мнимый философский парадокс. На самом деле его не существует.

Как я понимаю, существуют как минимум две категории людей: тех, для которых это вполне реальный пример, иллюстрирующий несостоятельность теста Тьюринга, и их противников, имеющих обратное мнение. ;) Причем автор парадокса Сёрл был таки из первых!

Насчет взаимодействия — а как же роботы, которые обучаются в виртуальных физических симуляторах?Симуляторы как раз — замечательно! Я думаю так и нужно делать — создавать симуляцию реального мира (упрощенную) и симуляцию взаимодействия. Об этом я хотел написать во второй части. Но симуляция мира и база знаний с фактами не имеющими воплощения хотя бы в симуляции — не одно и то же.

Модель мира в автоэнкодере будет вполне адекватной.Я не совсем уверен, что к автоэнкодеру применимо даже определение модели из википедии, ибо это явно не модель мира, а суперпозиция набора фотографий… Нейронные сети, особенно сверточные — прекрасный инструмент классификации и распознания, анализа входящей информации вообще, но их использование для постройки модели… НЕ то, что бы не возможно, но я пока не понимаю — как.

Проблема создания разума как раз в том, что дальше делать с этой моделью мира.в приведенной мной концепции модель мира включает развертку модели во времени, с вариантом некоего «светлого будущего», для достижения которого необходимо предпринимать некие активные действия. Более развернуто об этом — во второй части… Т.е. модель должна включать в себя действие.

Не существует никаких индексированных и хорошо связанных ассоциациями баз, отражающих всю сложность реального мира. Делать такие еще не научились.

Ы этом главная ошибка. Нам не нужно «всю сложность»! Нам нужно всего мира. А насколько детально — вопрос. Меня бы устроил уровень трехлетнего ребенка. Не нужно пытаться на стадии проектирования впихивать в ИИ информацию, не имеющую значения для него. Пусть научится ходить в виртуальной симуляции, взаимодействовать с предметами, чего-то хотеть, а чего-то не хотеть. Различать объекты и строить модель с разверткой во времени. Нам не нужна база знаний, нам нужен разум!

Чтобы получить такую базу, нужен механизм снижения размерности, как это происходит в мозге.

Ну вообще, это называется индукция. Обобщение. Если два, формально разных объекта не различаются в плане использования — стратегии их использования одинаковы и в этих стратегиях указано обобщенное представление обоих объектов.

Но на само деле нужно наоборот — не детализировать без необходимости. Пока для тебя нет разницы — красный куб или зеленый шар — и то и то физический объект. они становятся разными, только при наличии разных кейсов использования.

Я вполне допускаю, что это сложно и размерность все равно получается заоблачная. НО я готов на то, что бы в начале получить тупой и медленный интеллект, но что бы он был реализацией заявленных принципов.

Понимаете, с парадоксом китайской комнаты вот какая штука получается… Ее приверженцы заявляют, что два состояния отличаются: 1) человек внутри понимает(осознает) что делает, и 2) не осознает, а просто действует по правилам.

То есть они заявляют, что это два разных состояния. А раз они заявляют, что их два, то значит могут отличить эти состояния. Но по какому критерию они их отличают, не говорят). Назовите цифру-критерий, которая покажет что в одном случае человек действует осознанно, а во втором бездумно по правилам. Не получается? То-то же...

Это проблема людей с гуманитарным складом ума, они не вдаются в технические детали. Мол, раз существует две фразы "действия с сознанием" и "неосознанные", то обе вещи должны существовать в реальности. Но это совсем не так.

Китайская комната это не парадокс, а иллюзия мышления. Слова, которые на первый взгляд звучат как логичные, но на самом деле являются бессмысленной чушью. Как "небо, слон, паровоз". Все слова знакомые, но фраза не имеет смысла. Только бессмысленность этой фразы сразу ясна, а с китайской комнатой разобраться сложнее. Так же, как сложно разобраться с какой-нибудь оптической иллюзий.

Это проблема людей с гуманитарным складом ума

Зря вы так. ;) С той же википедии: Только с 2010 по 2014 год было выпущено более 750 статей в научных журналах, где обсуждается мысленный эксперимент Сёрла. Все прям гуманитарии?

Вы впадаете в ошибку того же Тьюринга. Он долго размышлял о природе интеллекта и не смог вывести критериев проверки ДЛЯ НЕСПЕЦИАЛИСТОВ. Т.е. чтоб любому гуманитарию было понятно, что вот эта вот штуковина не просто так тут гудит, а МЫСЛИТ! Поэтому он пошел по традиционному пути утиной типизации: «если крякает, как утка, плавает как утка, то...». Т.е. если не можем отличить от человека — значит думает.

И это ввергло отрасль в пучину чат-ботов! ;) Хотя вот мне кажется очевидным, что если есть машина, известны принципы ее построения и есть прямое проявление разумного поведения (в самых разных его проявлениях) то, даже если ее мышление не похоже на человеческое, а разговаривать она не может совсем, или только на своем особом языке, то оценить степень ее разумности вполне возможно. А чат-бот, он чат-бот и есть.

Что касается китайской комнаты — вы не совсем правы. Дело не в том, что раз невозможно разделить понимает или нет ПО ВНЕШНИМ ПРОЯВЛЕНИЯМ, то значит и нет разницы — вы правы. Нет. Просто нельзя судить о разумности по внешним проявлениям. Тут недавно было — мол людям же в голову не влезешь, откуда мы знаем, что они разумны? Может половина сплошь чат-боты! Так а я и не спорю! Может быть. Я знаю за себя — ибо осознаю. Буду знать за машину, если она будет по моим принципам построена. А за людей — не знаю! Наверняка — не знаю. Над более корректной проверкой, чем тест Тьюринга я еще не размышлял…

Кстати, я почти уверен, что довольно значительная часть людей не пройдет тест Тьюринга.

Так что для меня по комнате ответ простой — человек внутри комнаты не понимает иероглифов. И комната вместе с человеком не понимает. Это просто чат-бот, каким бы умным он не казался. И если он проходит тест Тьюринга, то или экзаминатор слабоват, или тест ни к черту! ;)

Я не пытался принизить людей с гуманитарным складом, а говорил только про этот случай. Инженеру чисто по профессии приходится работать с материальными вещами, поэтому его естественный вопрос про китайскую комнату: чем измерить отличия в этих двух состояниях? Раз мы утверждаем, что это два разных состояния и что они существуют в реальности, то значит должны отличаться чем-то материальным — показаниями стрелок приборов. Или хотя бы цифрами в теоретических расчетах. Ну и где они?

Вы говорите, что эти два состояния невозможно отличить извне китайской комнаты. А изнутри их можно отличить? Человек может показать прибор или назвать цифру, отличающую эти два его состояния?

А то получается забавно — говорят о двух отличающихся вещах, но чем они отличаются, сказать не могут.

А то получается забавно — говорят о двух отличающихся вещах, но чем они отличаются, сказать не могут.Вот! Именно так оно и работает… Если не отличается — то суть одно. Это правильно.

А изнутри их можно отличить?Можно! Можно посмотреть устройство, алгоритм, принцип действия и тп. ;)

Вот, скажем, нейронная сеть, распознающая символы. Самое первое, что реализовали — OCR. Если провести определенный реверс, то можно выделить/подобрать определенные изображения, которые абсолютно, никак не похожи на буквы/символы, но опознаются сетью как определенный символ с высокой (выше 90%) степенью вероятности (не могу что-то пруф найти, но точно встречал такое).

Получается, что если глянуть (пристально) в исходники чат-бота, который смог меня обмануть и пройти тест Тьюринга — весьма вероятно не только понять, что он таки «китайская комната», но и найти «те самые» вопросы, на которых он спалится!

Я не спорю — во многих отношениях вы правы. НО есть и обратные аргументы — нельзя возводить принцип подобия в абсолют! Думаю истина где-то посередине…

Т.е. в модели мира допустимо использовать два понятия как одно, если между ними нет различий, но… Здесь они есть. Я же вижу, что я думаю не как китайская комната! НЕ смотря, на возможное формально неотличимое поведение.

Как бы вы доказали сами себе, что у вас есть Сознание? Физическими материальным способами, а не словами. Ведь если «сознание» существует в нашем мире, то есть может своим существованием оказывать влияние на физический мир, то значит оно должно так или иначе оставлять физические следы! Закон сохранения энергии и все такое.

Вы можете сказать, что можно электродом отследить активность какого-нибудь нейрона в вашем мозге, когда вы осознаете себя. Тогда что, определение сознания получается такое: сознание — это электрическая активность конкретного моего нейрона. Ну глупость же.

P.S. Сознание конечно же существует, не может быть такого, чтобы «слово есть, а ж… пы нету». Просто это более широкое понятие, появившееся исторически с развитием языка. Когда потребовались местоимения, то вот они с сопутствующими эффектами и стали называться осознаванием себя в мире. Физически сознания (в философском смысле, а не медицинском) не существует, а значит и идеи вроде китайской комнаты — это когнитивное искажение, не более. Физически наиболее близкое к сознанию это активность групп нейронов, вызванная различными соответствующими факторами, например всплывающими ассоциациями после слов «я», «мир», «чем я отличаюсь от остальных» и т.д… Как-то так. Сознание это больше медицинская тема, чем проблема, касающаяся разума.

Нет, человек изнутри китайской комнаты тоже никак не может различить, есть у него сознание или нет.Зачем мне человек внутри китайской комнаты! ;) Мне он не нужен. Это, вы правы, философия. Я говорю о порочности «утиной типизации» относительно вещей, которые мы можем разложить на составляющие и понять устройство. Я полагаю, что именно это внутреннее устройство нужно оценивать и исходя из этого определять разумность, а не по внешнему проявлению. По крайней мере не только по нему. Скорее всего — и так и так.

Как бы вы доказали сами себе, что у вас есть Сознание?Вся эта статья — мое описание моего сознания. Проблема ведь не доказать, что оно у меня есть (себе — нет смысла, я это и так знаю, вам -невозможно, для вас я — китайская комната). Проблема так изложить что именно у меня есть (и что мы называем сознанием), что бы это можно было воспроизвести! Я не описываю сознание через «что он делает», по крайней мере — вовне. Я описываю, как оно устроено (в моем понимании). И если я встречу устройство, которое работает по тем же принципам, то я много чего пойму:

- или оно будет работать так и будет демонстрировать разумное поведение и это лучший из вариантов,

- или оно будет не будет работать, либо будет, но не будет демонстрировать ничего путного и тогда нужно дорабатывать теорию

- или оно будет работать так и будет демонстрировать поведение, условно разумное, но не человеческое, например. Это тоже интересный опыт.

Вот, скажем, нейронная сеть, распознающая символы. Самое первое, что реализовали — OCR. Если провести определенный реверс, то можно выделить/подобрать определенные изображения, которые абсолютно, никак не похожи на буквы/символы, но опознаются сетью как определенный символ с высокой (выше 90%) степенью вероятности

Это называется Adversarial Attacks. Классический пример: добавление специального шума к картинке заставляет нейросеть думать, что там нарисован гиббон вместо панды.

Но опять, дьявол кроется в технических деталях. Такое возможно из-за того, что с нейросетью можно быстро экспериментировать. Она дает ответ с некоторой вероятность, скажем, 97% что это панда. Теперь случайно чуть изменяем пиксели и смотрим, что покажет сеть. Если она покажет чуть меньше, скажем 96.999%, то продолжаем изменять пиксели в этом же направлении (по этому же градиенту). В итоге найдем картинку, где сеть будет думать, что это не панда. Проценты упадут, скажем, до 10%.

Единственное, параллельно при изменении пикселей добавляем проверку, чтобы две картинки были визуально похожи (по любому критерию, их сотни, хотя бы по синусному расстоянию).

Так и получаются эти волшебные картинки с атаками на нейронные сети. Есть целая область, изучающая как создавать нейросети, устойчивые к таким атакам. Да, это доказывает, что тут нейронная сеть панду определяет по какому-то паттерну среди пикселей. Как был известный случай, что нейросеть научилась определять есть в комнате кровать по наличию штор! (шторы определить оказалось легче, а они чаще всего занавешены в спальнях).

Теперь, зная технические детали как это сделано, должно стать понятно, что такие атаки говорит совсем о другом, а не о том, что им тут приписывают. У человека тоже есть такие глюки — оптические иллюзии.

Более того, искусство, комедии, ужасы, политическое ораторство — все это тоже Adversarial Attacks, только на человека! Люди искусства, художники, сценаристы ищут такие уязвимости в нейронной сети нашего мозга, и используют их. Усиливая эти эффекты по направлению градиента. Все как и в нейросети в примере выше. Только мы не можем за несколько секунд провести миллионы таких экспериментов со своим мозгом, поэтому этот процесс занял столетия, начиная с античных театров.

Проблема этих Adversarial Attacks, что в нейросетях, что в нашем мозге — не в принципе работы нейронной сети. А в недостаточно обученной модели, в том что где-то обучение пошло по более простому пути (не определились панды во всех их позах, т.к. нейросеть не видела видео в движении, а определилась по двум крупным черным пятнам на белом фоне на морде), и тому подобное.

Теперь, зная технические детали как это сделано, должно стать понятно, что такие атаки говорит совсем о другом, а не о том, что им тут приписывают.

Да нет же! Я ничего им не приписываю! Я именно об этом и говорю! Что, зная технические детали как это сделано, можно делать выводы о том чем оно является, а чем — не является! Бот может демонстрировать какие угодно чудеса, но когда вы влезете внутрь вы его раскроете. Или не раскроете, потому, что поймете, что это и правда работает!

Я не пытался сказать, что сеть плоха, потому, что «глючит»! Я полностью согласен, что человек глючит и похлеще! Я лишь о том, что понимание принципов дает сильно больше, чем анализ того, что на выходе. В случае с нейронной сетью Adversarial Attacks не демонстрация критических проблем, а скорее демонстрация нашего понимания, как оно работает — демонстрация, что это не черный ящик, а вполне понятная РАБОТАЮЩАЯ модель со своими ограничениями.

Это интересная мысль. Значит разумное существо должно быть либо настолько сложным и проявлять насколько сложное поведение, чтобы человек не мог его до конца понять. Либо по своим принципам умело адаптироваться и оперативно повышать свою сложность до нужной степени (обучаться), пока снова не станет непонятным и непредсказуемым для наблюдателя (т.е. снова будет выглядеть разумным).

Ведь вот нейронная сеть. Ее устройство, с точки зрения концепции — понятно. Однако, обученная нейронная сеть со всеми своими весами выдает результат, который крайне сложно объяснить исходя только лишь из устройства…

Т.е. тут скорее дуализм некий — принципы понятны, но именно принципы. Но накопленный опыт (будь то веса нейронов или еще каким-то образом организованная «модель») — он не… Ну как минимум он сформирован самостоятельно, а не под действием заранее заложенных инструкций. Поэтому — не тривиален…

Мне просто не очень нравятся термины «не понятен» и «не предсказуем». ;) Больше «не предопределен» или что-то вроде.

Так что для меня по комнате ответ простой — человек внутри комнаты не понимает иероглифов. И комната вместе с человеком не понимает. Это просто чат-бот, каким бы умным он не казался.

Комната вместе с человеком обладает тем же пониманием, что и человек со знанием китайского. Во втором случае модель находится у человека в голове, в первом в правилах и шкафах с карточками. Во втором случае слова на китайском связаны с понятиями, знакомыми человеку, в первом, даже если человек запомнит правила и состояние карточек, они не будут связаны со знакомыми ему понятиями. Состояние карточек задает свой набор понятий и связей между ними. Понимать китайский будет программа, процесс исполнения инструкций. А потому человека можно заменить на процессор, на понимание это не повлияет.

Тут уже идет некоторая нестыковка на уровне понятий…

Я не уверен, что можно поставить знак равенства между инструкциями/правилами, связями и моделью. Связи не равно инструкции. А модель — это не только связи.

Китайская комната работает по принципу «раздражитель»-«реакция». Это модель простейших насекомых.

Так же, как база знаний — граф высокой плотности в узлах которого понятия не есть модель реальности.

Но вы же сейчас спросите в чем разница, да? ;)

Комната вместе с человеком обладает тем же пониманием, что и человек со знанием китайского.

Вы это так с такой уверенностью утверждаете, что я вам даже немного завидую!

А что значит «понимание», которое вы так опрометчиво использовали в своем утверждении? Сможете привести любой объективный критерий (показания приборов, формулу, цифры), по которым вы отличите комнату, которая обладает пониманием и комнату, которая не обладает пониманием? То-то же…

С чего и началась эта ветка, что жонглируя такими терминами можно получить что угодно, хоть макароны, хоть бога.

Так я написал уже) Понимание это построение правильной модели. В китайской комнате информационные элементы это состояние карточек, которые перекладывает человек. К примеру, второй вопрос "А 2 и 2?". Если первый вопрос был "Сколько будет сложить 1 и 1?", то комната должна ответить "4", если "Сколько будет вычесть 1 и 1?", то "0". Вот этот характер предыдущего вопроса находится в состояниях карточек, так же как у человека в состояниях нейронов.

В Вики написано "However, the thought experiment is not intended to be a reductio ad absurdum, but rather an example that requires explanation". Вот я и даю объяснение. С этой точки зрения всё сходится, никаких парадоксов не возникает.

А что значит «понимание», которое вы так опрометчиво использовали в своем утверждении?Согласен с michael_vostrikov — Понимание, размещение в модели… Мне вот сейчас начало казаться, что на карточках тоже можно замутить модель! ;) Но нет! Стоп. Есть непосредственное восприятие, которое собственно вероятно и отличает модель от базы знаний!

Кстати, я склонен соглашаться, что во многих отношениях нейронные сети как раз проявляют черты «разумности», причем не только по внешнему поведению, но именно и по внутреннему устройству…

Назовите цифру-критерий, которая покажет что в одном случае человек действует осознанно, а во втором бездумно по правилам. Не получается? То-то же...

О, у меня как раз есть такой критерий) В первом случае в процессе восприятия информации появляются информационные элементы, соответствующие объектам/процессам ситуации, во втором нет. Ключевой момент именно в появлении. В обычных программах тоже есть модель, есть информационные элементы, соответствующие реальным объектам, но их назначение заложено извне и не меняется. Поэтому программы могут заменять человека, но только в конкретных ситуациях.

То есть критерий — это наличие информационных элементов, которые обозначают понятия, нужные для решения задачи, и учет их влияния на результат. Оценка влияния на результат это ведь тоже модель, модель будущей ситуации. Это же дает и объясняемость действий.

Для человека тоже можно определять наличие информационных элементов, через специальный тест Тьюринга. Он должен быть направлен на проверку новой, ранее неизвестной информации. Это давно применяется при обучении людей, называется "Расскажите своими словами". Проверяющий по словам представляет модель того что знает ученик и сравнивает со своей. Это не дает гарантию, но при повторении повышает вероятность.

Вот вы говорите, появляются информационные элементы модели. А как они появляются, какие именно? На входе мозга электрические сигналы от 100 млрд. нервных клеток. Как из них выделить эти информационные элементы? И раз вы утверждаете, что они выделяются, будьте любезны, поясните подробнее что это за элементы. В каких единицах они измеряются, какого они размера. Хоть что-то, поддающееся измерению в цифрах. Иначе как мы отличим, появляются эти информационные элементы или нет.

Иначе как мы отличим, появляются эти информационные элементы или нет.

По соответствию их реальным объектам и их взаимодействию. По предсказанию результата. Если модель правильная, то поведение реальных объектов будет соответствовать представляемому поведению информационных. Единицы измерения — штуки. Чем больше правильных объектов, тем точнее модель. Но так как у объекта могут быть детали, то у величины "соответствие" появляются дробные значения.

Как мозг это делает, это другой вопрос. Просто обычно все упирается в "мы не можем дать точное определение, потому что не знаем что это такое". Вот у меня есть такое определение, его можно применить к ИИ и определить, есть ли у него собственно интеллект и достаточно ли его для задачи. Или к китайской комнате. Также его можно косвенно применить к живым существам, даже представителям другой цивилизации.

Но это не является критерием определения разума как такового — после какого числа правильных предсказаний можно считать машину разумной?

Но можно сравнить это число со своими правильными предсказаниями! Если компьютер по любым произвольным темам будет делать прогнозы точнее (и действовать лучше), чем это делает человек, то определенно можно считать, что он стал разумным. По крайней мере, разумнее человека :).

В этом плане это можно использовать для определения момента, появился ИИ или нет. Только это напоминает обычный тест Тьюринга или утиное сравнение — мол, делает ли компьютер все не хуже человека. А у такого сравнения куча своих проблем — нужно определить некоего среднего разумного человека (5% населения, 90% населения?), с кем сравнивать. Нужно набирать большую статистику (насколько большую?), чтобы избежать разных частных случаев и так далее.

«а входе мозга электрические сигналы от 100 млрд. нервных клеток. Как из них выделить эти информационные элементы?»Ведь именно этим занимается сверточная нейронная сеть — выделяет эти информационные элементы. В чем проблема то?

Вот смотрите — первый этап: берем растровую картинку — скармливаем сети. Пытаемся заставить находить котиков. Получается, но так себе.

Этап второй: берем три сети друг за другом. Первая ищет примитивы, вторая элементы, третья объекты. Выход первой на вход второй, выход второй на вход третьей. Стало сильно лучше — котиков находит уже почти как человек.

Наверное не ошибусь, если скажу, что можно как обобщать котиков с собачками до зверушек, так и различать пару тройку разных котиков.

А чего не применить тот же принцип в анализе процессов? почему не подойти так же к собственным действиям (перемещению в пространстве, например)?

Ведь именно этим занимается сверточная нейронная сеть — выделяет эти информационные элементы. В чем проблема то?

Потому что существующие нейросети не универсальный инструмент, как многим представляется. А тонко настроенный на конкретные условия. К примеру, если вы пытаетесь распознавать котиков, но котик у вас попадается только на 1 из 20 картинок, то нейросеть никогда не обучится. Дисбаланс классов. Надо искусственно пересортировать картинки, чтобы коты и пустые картинки попадались примерно в равных пропорциях. И таких нюансов там сотни.

Или, к примеру, пусть персонаж в симуляторе совершает случайные движения. А как только случайно попадет по мячу, давайте обучим нейросеть повторять последние 2 сек действий. Казалось бы, она должна выявить общие признаки, и из любого положения с 2-х секундной доступностью мяча, бить по нему. Но нет, так нейросеть не обучится. Почему так происходит, есть объяснения лишь по факту, мол градиенты взаимнокомпенсируются, дисбаланс классов, переобучение, недостаточная емкость сети и т.д… А методики как сделать, чтобы она все же обучилась — нет.

С анализом процессов (то есть задач, связанных со временем) совсем беда… Ко всем этим сложностям добавляются еще и проблемы с временной корреляцией. Пока найдены удачные архитектуры только для отдельных случаев, например для работы со звуком. Есть нейросети, которые способные отличить единичный всплеск тысячи шагов назад (вроде каскадной 1D сверточной как WaveNet), но их принцип основан на хорошем анализе локальных признаков, а если применить ее к анализу например движений человека, она тупо не работает.

Другие, которые хорошо строят взаимосвязи между отдаленными во времени событиями (построенные на механизмах внимания, например), чисто по своей структуре из-за этого механизма внимания не могут принимать на вход длинные последовательности. Максимум пару сотен шагов истории. Чего для нормальной памяти мало. Это всего несколько секунд при 30 кадрах/сек.

Но прогресс постепенно идет. Появляются новые архитектуры и методы обучения. Теоретически, даже простая сеть прямого распространения способна стать разумной. Только пока никто не умеет ее правильно обучать для этого. В биологических системах правильно обучать нейросети научилась эволюция.

С анализом процессов (то есть задач, связанных со временем) совсем беда…Потому, что мы пытаемся взять со входа сигналы и анализировать их в развертке по времени! Это та же ошибка, что была до сверточных сетей в распознавании образов.

Нужно все, что приходит извне свернуть в модель. Модель, где не наборы пикселей и даже не объекты в кадре, а где иерархия процессов в континуме пространство-время. И их уже подавать на вход сети, принимающей решения. Цель которой — полная, непротиворечивая и т.д. ;)

Поэтому голый Model-Based подход не работает. Даже если у нас есть идеальная модель мира и мы будем перебирать в ней все возможные варианты, проклятие размерности быстро сводит такие попытки на нет.

Ну не перебирает мозг все возможные варианты! В условиях ограниченного времени это часто первое попавшееся решение, а далеко не оптимальное. именно поэтому скил большинства людей в большинстве процессов весьма низок.

Опять же — не будь возможности брать первое, что подвернется — буриданов осел сдох бы таки от голода! ;)

Ну не перебирает мозг все возможные варианты!

Совершенно верно! Вы уловили самую суть. Вопрос создания сильного ИИ как раз и заключается в вопросе — как бы нам так сделать, чтобы не перебирать все варианты? ) Мозгу удалось решить эту проблему, нам пока нет.

АльфаЗеро — очень специализированный алгоритм, в котором проблемы обучения, про которые я писал выше, удалось преодолеть рядом математических трюков. Там вообще разновидность Monte-Carlo обучения по результатам эпизодов, которая мало где в жизни применима. Если АльфаЗеро применить к роботу или любой другой задаче, например для создания чат-бота, то он не работает.

Мы говорим об одном), я просто пытаюсь объяснить с какими трудностями дальше столкнулись исследователи. У вас в статье много хороших мыслей по формированию модели мира, что мышление это часть построения этой модели и т.д. Я понимаю, что вы имели ввиду. Но попробуйте разбить эту задачу на две составляющие: модели мира уже прекрасно строятся на базе тех же нейросетей (с устранением противоречий, с включением своих действий в модель и т.д.). Непонятно что дальше делать с этой моделью, как ее использовать.

У вас жизнь уже как бы часть модели, а действия плавно вытекают из нее. Но на практике это не так — модель реальности отдельно, действия и принятия решений отдельно. И вот со вторым проблема.

Но на практике это не так — модель реальности отдельно, действия и принятия решений отдельно. И вот со вторым проблема.

А почему? Почему я не могу иметь модель в которой будущее задано, пошлое — постоянно уточняется, а мои действия — переход от одного к другому?

Я просыпаюсь с утра и мне нужно на работу. В принципе я вижу всю последовательность действий, необходимых для того, что бы там оказаться, с достаточной степенью как подробности, так и определенной вариативности. Т.е. в моей модели мира я завтра проснусь в шесть и через полтора часа буду на работе… И так в общем-то достаточно далеко. У меня есть планы и на выходные и на лето. И почему все мои действия не могут быть просто отработкой этой модели для сохранения соответствия?

О, это голубая мечта всех исследователей — чтобы ИИ строил модель мира, и его действия вытекали из этой же модели. Вы правильно понимаете, живой мозг именно так и работает.

Это уже потом, в попытках понять почему не получается сделать такую модель, пришли к разделению. Что формировать модель это один процесс, а принимать решения на основе этой модели — другой. Первый у нас уже получается, второй нет. Из-за таких-то и таких-то проблем.

Ну или проще говоря, мы пока не знаем как встроить принятие решений в саму модель. Как сделать, чтобы проснувшись, первая и единственная мысль была — мне нужно на работу. А не бесчисленное число любых других мыслей. С точки зрения компьютера на входе миллионы или миллиарды цифр, на выходе 700 цифр, отвечающих за сокращения мышц (чтобы подняться и идти на работу). Как из первого получить второе — неясно.

И почему все мои действия не могут быть просто отработкой этой модели для сохранения соответствия?

У вас (и у меня) могут, потому что они у нас уже есть. Вот вы говорите: "в моей модели мира я завтра проснусь в шесть и через полтора часа буду на работу". Это готовая последовательность слов, которую выдал ваш мозг. Но она совсем не очевидна, как она получена? Есть 500 тысяч слов (ну пусть 30 тыс. наиболее употребительных), которые можно использовать. И в этой фразе аж 16 последовательных слов. Представляете какое это число комбинаций из комбинаторики… А вы выдали эту фразу сразу. Это удивительно.

И вы правы, перебирать все варианты не нужно, да и невозможно. Разум оперирует ограниченным числом действий. Но как он их получает? У младенца еще нет никакой информации о мире. Его мозг на входе получает электрические сигналы от миллионов/миллиардов нервных клеток по всему организму. Аналогично компьютеру выше. Но на выходе выдает всего несколько главных действий: кричать, ползти, встать. Как он выбрал именно их? Как построил модель мира с настолько эффективными ассоциациями? Вот в чем вопрос… Поэтому обязательно пишите вторую часть, интересно читать. И может натолкнуть на какие-нибудь мысли.

Но она совсем не очевидна, как она получена? Есть 500 тысяч слов (ну пусть 30 тыс. наиболее употребительных), которые можно использовать. И в этой фразе аж 16 последовательных слов. Представляете какое это число комбинаций из комбинаторики… А вы выдали эту фразу сразу. Это удивительно.

Если подходить к ИИ, как к черному ящику у которого вход и выход — да, но… Давайте на примере!

Есть робот-пылесос. Ему нужно построить карту комнаты и выбрать оптимальный маршрут, что бы за меньшее количество пути пройти всю комнату (считай быстрее закончить, но не пропускать участков).Простой мир, простая задача. Простые сенсоры вида датчиков касания и энкодеров.

Есть Три подхода к решению задачи.

Первый: разработать мат модель произвольной комнаты, определить понятие оптимальной траектории, короче решить задачу в общем виде и ее захардкодить. Заложить в робота. В рамках заданного мира и возможных действия его поведение вероятно будет не слишком отличаться от интеллектуальной системы в тех же условиях (скорее даже будет превосходить оную, т.к. как мы уже говорили — интеллектуальный, далеко не всегда значит оптимальный). Это — китайская комната.

Второй: нейронная сеть в ваших интерпретациях. Мы стараемся построить и обучить такую сеть, что бы, получая на вход данные с датчиков, она в том или ином виде решала задачу. Я не знаю, как вам, а мне кажется, что в данном случае предется применить гораздо большую изворотливость и нетривиальный подход, чем в первом случае! Я пока не представляю с ходу, как оно на сетях — будь они сверточные или рекурентные!

Вариант третий: построитель модели. Как я уже говорил (или только собирался?), мне кажется, что понятие пространства, как и идея перемещения в нем является фундаментальными. Т.е. в данном случае это то, что воспринимается непосредственно и не требует выражения через другие абстрактные понятия. Таким образом модель пространства может и должна быть заложена изначально. Движение, особенно собственное… Ну можно конечно сделать, как природа и дать возможность системе самой научится, но для простоты — предлагаю тоже захардкодить! Т.е. система знает, что значит перемещение и что нужно делать, что бы из точки А в пространстве, попасть в точку Б. Дальше — самое интересное! Нужно что бы система сама построила модель от «я в точке старта и не знаю что вокруг» до «мир вот такой, я имею полную модель, и нахожусь здесь». Для начала. Мне почему-то кажется, что на основе изначально практически хаотичных действий с рекурсивным применением полученного в результате опыта это сделать реально. С нейронными сетями или без… И после решения первой задачи (с картой) — дальше система должна уже проще решать проблему оптимального пути. Причем чем больше будет итераций — тем более вероятно оптимальное решение.

Вот в моем понимании это будет система, демонстрирующая разумное поведение, которая хоть и схожа с первой по внешним проявлениям, но имеет принципиальное отличие по внутреннему устройству.

Поэтому обязательно пишите вторую часть, интересно читать. И может натолкнуть на какие-нибудь мысли.

Спасибо за поддержку. Напишу да…

И после решения первой задачи (с картой) — дальше система должна уже проще решать проблему оптимального пути.

Как раз тут и кроется проблема, которую я пытаюсь объяснить. Вы подразумеваете, что построенная модель как-то автоматически даст ответ какой путь будет оптимальным. Но это не так.

Модель может спрогнозировать что будет дальше, но не более того! В случае робота-пылесоса, модель ответит «да» или «нет» на вопрос: «если я буду двигаться прямо, то упрусь в стену?». Модель мира не может ответить на вопрос «как оптимально двигаться, чтобы не врезаться в стены?». А разум, интеллект как раз решает эту задачу, ищет ответ на такие вопросы. Используя модель мира как базу знаний. Но как именно он это делает, мы пока не понимаем.

Смотрите, выше вы говорили что ваша модель мира говорит вам, что завтра утром вы пойдете на работу и т.д. И вы это воспринимаете, будто модель дала вам оптимальное поведение, нашла для вас оптимальный путь. Но это не так!

Это поведение по умолчанию, которое вы обычно делаете. То же самое, что ничего не делать. Ваша модель мира прекрасно отвечает на вопрос «если я ничего не буду делать, то что случится?». Она спрогнозирует, что проголодаетесь и т.д. Все нормально, это же модель мира, она и должна прогнозировать такие вещи.

Ваш пример с работой, это то же самое что спросить: «Что будет дальше, если я буду делать все как обычно?» Будучи моделью мира, она спрогнозирует: «Завтра утром вы встанете и пойдете на работу», ну и так далее, вплоть до планов на много лет вперед. Это тоже нормально, модель так и должна работать, по определению.

А теперь представьте ситуацию, вы задаете этот вопрос своей модели, а она отвечает: «Завтра вы пойдете на работу, и послезавтра, и после, и так всю жизнь, и ничего в итоге не добьетесь в жизни!». И вы вдруг понимаете, что такой вариант будущего вас совсем не устраивает!

И что же тогда делать?!

Ваша модель мира вообще никак, в принципе не может ответить, как поступить, чтобы изменить это спрогнозированное моделью будущее. Ну верно же?

Вы можете начать делать случайный поиск, перебирая возможные варианты. И спрашивая у своей модели, что будет в каждом из этих случаев. -«А может мне сменить работу? -Нет, это не поможет, ничего принципиально не изменится». -«А может мне уйти в монастырь? -Нет, это тоже не поможет, пустая трата времени». Ну и так далее.

Теперь понимаете, о чем я говорил, что модель мира отдельно, а принятие решений отдельно?

И как вы правильно где-то выше заметили, вы не начинаете в такой ситуации делать абсолютно случайные вещи, например не начинаете случайно дрыгать ногами и руками, чтобы изменить жизнь (как это сейчас реализовано во всех алгоритмах Reinforcement Learning, ха-ха). Вы перебираете ограниченный набор наиболее подходящих к случаю вещей.

И вот это самое удивительное в разуме — как он из огромного жизненного опыта выделяет эти несколько наиболее подходящих вещей? Из всего того сенсомоторного опыта, который вы имели за всю жизнь, ваш мозг вдруг выдает единичное событие, которое было много лет назад: "-А вот в детстве я увидел картинку с самолетом и подумал, что хочу стать летчиком. Может мне пойти учиться на пилота?". И ваша модель мира отвечает: "-Да, то что надо! Это будет круто."

Как ваш мозг среди всех воспоминаний выбрал именно этот вариант? Наиболее подходящий к ситуации. Загадка… Никто не знает ни как мозг запомнил это событие среди миллионов других (как выделил его на фоне сенсомоторных входных данных), ни как определил что оно будет самым подходящим кандидатом на решение проблемы в этом случае.

Надеюсь, теперь понятнее что я имел ввиду, что модель мира сама по себе не ведет к разумному поведению. Нужно как-то принимать решения, какие действия лучше совершить для достижения цели. Модель мира просто прогнозирует что случится дальше при конкретных действиях. Но сами оптимальные действия не выдает.

Как раз тут и кроется проблема, которую я пытаюсь объяснить. Вы подразумеваете, что построенная модель как-то автоматически даст ответ какой путь будет оптимальным.Не совсем. Она не даст ответ. Она вообще ответ не дает. Она просто есть. Она — строится. Просто сам по себе вопрос — это нестыковка в модели. Ее надо устранить. Скорее всего определенно комбинаторным путем, но сугубо из подходящих элементов.

Модель мира не может ответить на вопрос «как оптимально двигаться, чтобы не врезаться в стены?».Чтобы не врезаться в стены — надо просто не двигаться. Это не так работает. В модели есть робот. Он находится в точке А. В модели есть карта пространства. В модели есть результат — обход карты за конечное время. Обход — это очевидно движение. Образ движения в модели тоже есть…

Хорошо, я понимаю о чем вы. Но вот скажите: есть механизм предположений? Есть же бэктрекинг, есть рекурентные сети… Я согласен, что это вероятно не нейронная сеть в чистом виде, но ведь по большому счету и сверточная сеть — сетью является только условно! Это по факту три «сети», т.к. каждый слой натаскивается на свои задачи…

И вот это самое удивительное в разуме — как он из огромного жизненного опыта выделяет эти несколько наиболее подходящих вещей?Так-то да — это удивительно. Но механизмы поиска решений — это первое, что начали строить в ИИ! И тот факт, что это не нейронная сеть, еще не значит, что это не работает!

Не совсем. Она не даст ответ. Она вообще ответ не дает. Она просто есть. Она — строится. Просто сам по себе вопрос — это нестыковка в модели. Ее надо устранить.

То что ограниченный набор подходящих кандидатов будет встроен в саму модель, не значит что их не нужно выбирать и как-то ранжировать по полезности при построении этой модели. А это и есть процесс принятия решений ) (нерешенный на данном этапе развития).

Я примерно предлагаю работать с поиском варианта действия так же. на вход подаются обстоятельства и необходимый результат, а выходы — возможные действия. Сеть ранее обучалась на подобных же кейсах (тут вопрос абстракции — насколько она будет считать те или иные кейсы подобными) и нет-нет да опознает ситуацию, как похожую. А дальше вот это вот «обучение с подкреплением», «награда» и тп.

Я не знаю как это сделать, я знаю, куда мне было бы интересно, если бы развитие завернуло!

Это в обучении с подкреплением уже используется, такой вариант называется стохастическая политика (stochastic policy). Когда на выходе нейросети есть сразу несколько вариантов действий и для каждого указаны проценты, насколько нейросеть считает этот вариант удачным.

Но если использовать такую нейросеть как модель мира, то выбор все равно делает не нейросеть! Решение какой из предложенных сетью вариантов выбрать, приходится принимать разработчику. Например, можно всегда выбирать действие с максимальными процентами. Но чаще действия выбирают пропорционально их вероятности, т.к. они обычно уже нормированы по softmax. Например если для трех разных действий сеть выдает такие вероятности: 10%, 70%, 20%. Чем выше проценты, тем чаще выбираем это действие. Здесь второе будет выбрано в 70% случаев, третье в 20%, а первое лишь в 10% случаев.

Плюс стохастической политики в том, что она позволяет автоматически проводить исследование окружающей среды, так как иногда выбираются непопулярные действия. Но при этом остается довольно логичной — чем больше сеть уверена в правильном ответе, тем с большей вероятностью выберет его. А если нет предпочтительного варианта, например когда варианты: 33%, 33%, 33%, то будет выбрано случайное из них с равной вероятностью.

Проблема тут все та же — сеть (модель) не предлагает новые варианты! А всего лишь классифицирует известные. Это равносильно как задать сети столько вопросов, сколько выходов у сети. И для каждого вопроса сеть ответит, насколько конкретно этот вариант хорош. Как видите, сеть (модель мира) сама не принимает решений и не ищет новые решения, как это делает настоящий разум.

Вы можете подумать — вот есть у человека 700 мышц (а для виртуальной модели человека достаточно 17-25 "мышц", т.е. степеней свободы). Пусть нейросеть для каждой мышцы выдает такое вероятностное распределение сокращений. И это покроет все возможные действия человека. А значит будет включать оптимальное поведение, предсказанное и предлагаемое моделью мира.

Но нет, это так не работает. Это будет вероятностью для одного действия. Например, для действия "ходьба" в текущий момент времени нужно с вероятностью 70% сократить такую-то мышцу, и с вероятностью 45% сократить другую. Чтобы получить вероятности для разных действий, например чтобы сеть выдавала, что чтобы спастись от хищника нужно с 70% "бежать" и с 30% "идти", нужно эти действия как-то заранее выделить, кластеризовать. Чтобы можно было потом из них выбирать. Мозг это делает автоматически, потому что биология работы нейронов подобрана эволюционно. Но ни одна искусственная система (ни нейросети, ни любые другие) на данный момент не умеют выделять такие кластеры (понятия) из своего обычного повседневного жизненного опыта, сравнимого по сложности с жизненным опытом животного или человека.

P.S. Алгоритмы обучения с подкреплением (reinforcement learning) так устроены, что как раз кластеризуют и выдают эти новые действия, а не просто являются моделью мира. Они по-настоящему принимают решения и являются самым настоящим разумным ИИ. Только существующие алгоритмы RL работают на настолько удручающе низких размерностях (буквально единицы), что разглядеть там разумность очень сложно. За такое время расчета и на таких низких размерностях и случайный поиск выдает схожие результаты. Мне кажется, проблема в том, что все современные RL алгоритмы повторяют по сути одну и ту же архитектуру, которая похоже тупиковая. Нужен какой-то другой, кардинальный прорыв в архитектуре, как это произошло со сверточными сетями. Я попытался это описать в статье https://habr.com/ru/post/437020, но не знаю насколько понятно удалось выразить что хотел сказать (подозреваю, что не очень ;).

Первое, что приходит на ум — некоторое противоречие. Сначала вы сказали, что сеть не умеет делать выбор из большого числа возможных вариантов, теперь — что умеет, но варианты задает разработчик. Хотя признаете что то самое «ранжирование по полезности» таки возможно за счет обучения с подкреплением. ;)

Второе. Счас будет сложная мысль (сложная для меня — в плане сформулировать сложно): проблема не найти новый ответ. Проблема так классифицировать вопрос/ситуацию/проблему, что бы ответ оказался очевиден! ;) Т.е. вы говорите, что сеть не может найти ответ, которого не было (нечто новое). Ок — пусть не может. А я говорю — человек тоже не может! Что бы найти ответ ему нужно свести ситуацию/вопрос к чему-то, что ответ имеет. Т.е. классифицировать/опознать/найти место в модели. Этому помогает высокий уровень обобщения (читай свертки), когда ситуации не имеющие в первом приближении ничего общего с опытом, позволяют таки найти это общее при все большем и большем повышении абстракции. Есть такая задача про лампочки: есть три «лампочки Ильича» в подвале, есть три выключателя наверху. Спускаться в подвал и подниматься обратно более одного раза — лень. Как выяснить какой выключатель от какой лампочки за один раз? ;) Решение этой задачи не требует чего-то нового, но…

Третье. Да почему же вы не хотите применить логику сверточных сетей к другим областям той же науки! ;) Почему вы считаете, что должен быть прямой путь от «спастись от хищника» до прямого управления 700 мышцами? Вы же свернули чертову уйму сигналов в «спастись от хищника», так сверните 700 мышц в «бежать»! В моем понимании неокортекс не взаимодействует ни с зрительными нейронами (где-то мне попадалась информация, что непосредственно в глазу происходит довольно приличная часть свертки и на вход мозгу уже подается далеко не bitmap), ни с двигательными мышцами! Неокортекс дает команду бежать (а я бы пошел дальше и сказал, что он просто создает модель в которой «я бегу» — данность), а «старый мозг» уже занимается реализацией. И так оно с первых лет жизни:

- неокортекс: вот в том направлении что-то интересное! Нам туда.

- старый (как он там? Рептильный?): ок, идем/ползем/хаотично двигаем всем-чем-можем, авось получится (в зависимости от уровня развития).

Статью я читал, но… Нужно еще читать. Вдумчиво. Пока мне кажется, что у Дипмайнда хорошо получается именно в силу комбинации подходов. Т.е. чуть ли не все уже есть, нужно немного изменить подход и собрать все вместе! Но это без сомнения просто следствие моей недостаточной компетенции в вопросе… Однако иногда это может помочь взглянуть на проблему с неожиданной стороны.

Первое, что приходит на ум — некоторое противоречие. Сначала вы сказали, что сеть не умеет делать выбор из большого числа возможных вариантов, теперь — что умеет, но варианты задает разработчик.

Тут произошла путаница понятий. Делать выбор из готовых вариантов (предоставленных разработчиком) сеть умеет. Ранжировать предложенные варианты по полезности тоже умеет. Но это умеет любая модель, неважно на базе нейросетей она построена или нет. А вот предложить новые варианты, как это делает разум, существующие нейросети не могут (за исключением RL, см. ниже).

В примере выше сеть не может сама сформулировать понятие «бежать», чтобы использовать его.

А вот нейросети из Reinforcement Learning как раз могут! Формулируют и используют. Но почему-то не масштабируются свыше размерности в единицы степеней свободы. А на такой низкой размерности и случайный поиск выдает такие же результаты за это время.

Т.е. классифицировать/опознать/найти место в модели.

Так опознать место в модели — это и есть система принятия решений. Алгоритм поиска. Подниматься вверх по дереву абстракций, если на текущем уровне нет решений это хорошая мысль. Все упирается в то, как создать такую модель и по какому алгоритму по ней подниматься/опускаться между уровнями абстракций.

Третье. Да почему же вы не хотите применить логику сверточных сетей к другим областям той же науки! ;)

Почему же не хочу? Это первое что я попробовал. И в RL это активно используется. Например, картинка с камеры с помощью сверточной сети преобразуется в вектор из 512 чисел (это последний слой сверточной сети, по сути снижение размерности до 512). А уже эти 512 чисел подаются на вход второй нейрости, обученной по Reinforcement Learning. Или вообще, каким-нибудь эволюционным алгоритмом, без всяких нейросетей. А выход с нее отправляется на третью систему — ПИД контроллер, которые уже управляет моторами. Все как вы описываете: здесь сверточная сеть — это зрительная кора, вторая RL нейросеть это неокортекс, выдающае общие команды, а ПИД контроллер (или моторная третья сеть) — двигательные мышцы.

Все это красиво в теории, но на практике не работает. Даже до уровня мухи не дотягивает, не то что мыши или человека. Поэтому искать какие-нибудь высокоуровневые решения как работает интеллект, по прежнему остается актуальным.

Все это красиво в теории, но на практике не работает.

Верю. Но пока не понимаю почему… Может мы немного о разном?

Я имею ввиду, что для движения гуманоида, будь там 17 или 67 степеней свободы переход от модели к движению должен проходить через понятия даже не идти/бежать прямо/налево/направо и уж тем более не через прямое управление отдельными мышцами, а через «мы здесь, надо — туда, чем быстрее, тем лучше!». Не должно быть прямой связи раздражитель-действие — это действительно слишком сложно. Раздражители должны актуализировать модель, которая должна достраивать действия (в весьма высоком уровне абстракции), как часть модели, а ДРУГАЯ система должна исполнять обратный переход — от абстракции к конкретным мышцам…

Эти системы не обязаны в первом приближении учится в виде единой системы по методу того же RL — вовсе нет. Они вполне могут быть предобучены отдельно или даже запрограммированы в лоб. Вполне вероятно, что использовать обучение нужно только там, где без этого никак… Хотя это сложная тема.

Разум — это способность существа строить полную, адекватную и непротиворечивую модель реальности.

Ваш постулат нужно ставить в начало книги о логике. Вы пытаетесь моделировать очередной компьютер, а не разум. Так сказать — профессиональная деформация. Дело в том, что разуму не нужна ни полнота, ни адекватность, ни непротиворечивость.

Просто вы хотите оперировать в рамках математической логики, но это абсолютно тупиковый путь развития. Вы сможете построить иллюзию разума, но не разум. Хорошим примером этой иллюзии является «парадокс китайской комнаты».

Ваши тезисы, кстати, легко опровергнуть конкретными примерами из биологии. Просто задам несколько простых вопросов:

1. Мыслит ли муравейник?

2. Разумен ли душевнобольной с неадекватной картиной мира?

3. Как соотносятся язык и мышление?

4. Как отличить разум от инстинкта?

Дело в том, что разуму не нужна ни полнота, ни адекватность, ни непротиворечивость.тонкость в том, что по определению — разум стремится к этому, однако, как я уже писал раньше — это недостижимо. Т.е. закончивший строить модель разум вероятно остановится. ВАжен сам процесс построения, устранения противоречий и тп.

Просто вы хотите оперировать в рамках математической логикида не совсем математической… Логика может быть любая, хоть женская! Вопрос модели. Там скорее уместно говорить о теории множеств, или даже категорий.

1. Мыслит ли муравейник?полагаю, что нет. Просто реагирует. НО возможно у меня недостаточно данных о примерах разумного поведения муравейника, которые нельзя объяснить уровнем реакции.