Восстановление виртуальных машин из «снэпшотов» SAN с помощью Veeam Backup & Replication

4 мин

25 октября вышла новая версия нашего флагманского продукта – Veeam Backup & Replication 6.5. Новая версия включила в себя ряд интересных усовершенствований, одна из которых – восстановление виртуальных машин (ВМ) из “снэпшотов” SAN (аппаратных снимков). Ниже я коротко расскажу про эту технологию подробнее.

После появления виртуальных сред в компаниях появилась возможность запуска на одном сервере нескольких ВМ. Со временем количество серверов, ВМ и приложений в компании растет, а емкости и производительности систем хранения данных (СХД) становится недостаточно. Эта проблема решается добавлением дополнительных дисковых полок до того момента, пока контроллерная пара СХД не станет узким местом в развитии инфраструктуры. При наступлении такой крайней ситуации обычно компании решают либо заменить контроллерную пару (upgrade), либо поставить новую СХД.

С точки зрения архитектуры HP SAN Left Hand Storage (HP SAN) принципиально отличается от стандартных СХД тем, что масштабируются не только по емкости, но и про производительности. HP SAN не имеет отдельных контролеров и отдельных дисковых полок, а каждый массив обладает своими ресурсами (процессор, диски, кэш, порты ввода / вывода), поэтому наращивая массив компания не только увеличивает дисковые ресурсы, но и процессорную емкость, кэш, т.д.

Таким образом, HP SAN представляет из себя кластер из узлов хранения, где каждый узел – это полноценное хранилище данных. Между узлами происходит автоматическое перераспределение данных, и все это управляется через единую консоль. При добавлении новых узлов производительность и надежность HP SAN только возрастает.

Подробнее можно посмотреть хорошее поясняющее видео (на английском).

Кратко об СХД HP LeftHand Storage

После появления виртуальных сред в компаниях появилась возможность запуска на одном сервере нескольких ВМ. Со временем количество серверов, ВМ и приложений в компании растет, а емкости и производительности систем хранения данных (СХД) становится недостаточно. Эта проблема решается добавлением дополнительных дисковых полок до того момента, пока контроллерная пара СХД не станет узким местом в развитии инфраструктуры. При наступлении такой крайней ситуации обычно компании решают либо заменить контроллерную пару (upgrade), либо поставить новую СХД.

С точки зрения архитектуры HP SAN Left Hand Storage (HP SAN) принципиально отличается от стандартных СХД тем, что масштабируются не только по емкости, но и про производительности. HP SAN не имеет отдельных контролеров и отдельных дисковых полок, а каждый массив обладает своими ресурсами (процессор, диски, кэш, порты ввода / вывода), поэтому наращивая массив компания не только увеличивает дисковые ресурсы, но и процессорную емкость, кэш, т.д.

Таким образом, HP SAN представляет из себя кластер из узлов хранения, где каждый узел – это полноценное хранилище данных. Между узлами происходит автоматическое перераспределение данных, и все это управляется через единую консоль. При добавлении новых узлов производительность и надежность HP SAN только возрастает.

Подробнее можно посмотреть хорошее поясняющее видео (на английском).

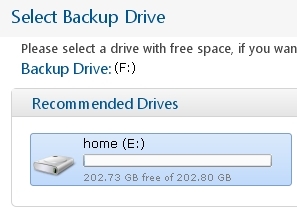

IT-специалистам несложно настроить резервное копирование дома, например, с помощью rsync, созданием rar-архивов планировщиком задач, инкрементальным копированием в интернет (не говоря уже о настройке tar+cron или bacula на работе). Однако неспециалисты (для дома) будут использовать программы резервного копирования, которые много проще. Рассмотрим программу, скрывающей за привычной простотой для домашнего пользователя, гибкий и хорошо продуманный инструмент резервного копирования.

IT-специалистам несложно настроить резервное копирование дома, например, с помощью rsync, созданием rar-архивов планировщиком задач, инкрементальным копированием в интернет (не говоря уже о настройке tar+cron или bacula на работе). Однако неспециалисты (для дома) будут использовать программы резервного копирования, которые много проще. Рассмотрим программу, скрывающей за привычной простотой для домашнего пользователя, гибкий и хорошо продуманный инструмент резервного копирования.