Учёные Калифорнийского университета в Сан-Франциско разработали нейроинтерфейс, который считывает электроимпульсы мозга человека, и подключили его к искусственному интеллекту, который преобразует сигналы в слова, пишет Ars Technica. Статья о разработке опубликована в журнале Nature.

При создании подобных интерфейсов учёные сталкиваются с проблемой того, что до сих пор неизвестно, каким образом мозг человека составляет свою речь. Сначала мозг пытается осознать, что именно нужно сказать — и отправляет информацию об этом в речевую зону коры (область Вернике). При этом в процессе он может несколько раз пересмотреть то, что и как человек хочет сказать. Затем область Вернике составляет набор звуков, информация о которых отправляет мышцам, ответственным за их воспроизведение — и человек начинает говорить. Однако стоит вопрос, что именно нужно распознать учёным для воспроизведения речи — отдельные звуки составляют слова, слова составляют предложения. Сложность в том, что в случае неправильного произношения или произношения с акцентом мозг посылает совсем другие импульсы по сравнению с обычным говорением.

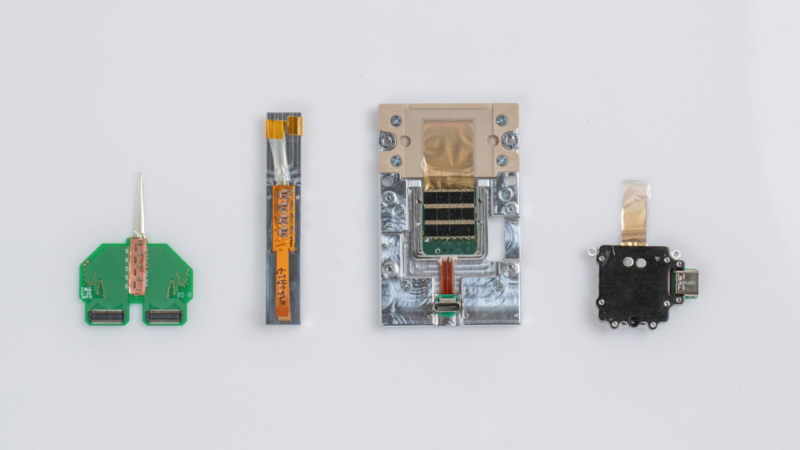

Это изобретение позволит решить проблему людей с ограниченными возможностями, которые по той или иной причине не могут говорить. Учёные установили электроды людям на участки мозга, отвечающие за речь, и попросили их читать текст, чтобы понять, как именно нервная система будет реагировать на попытку произнести слова. Всего в наборе было 50 предложений, которые в сумме содержали 250 уникальных слов. Нейронная активность участников эксперимента была записана, а затем обработана с помощью рекуррентной нейронной сети — та превратила её в промежуточное представление о том, что хотел сказать человек, и попыталась определить полный текст.

Основным ограничением в разработке интерфейса был маленький набор предложений, доступных для обучения нейросети — на это требуется слишком много времени. Учёные опасались, что нейросеть начнёт определять значение «произносимого», всего лишь измеряя время, которое мозг затрачивает на обдумывание речи и попытку говорить. При этом некоторые из итоговых результатов действительно были всего лишь полной заменой других предложений в этом же наборе. Однако исследователи считают, что система хорошо справилась со своей работой — они посчитали частоту ошибок в слова, при этом двое из участников показали всего лишь 8% ошибок.

Учёные также поочерёдно отключали электроды, считывающие импульсы с тех или иных участков мозга. Оказалось, что даже без них система показывает приемлемый результат, процент ошибок в котором, однако, всё же был выше. Наибольшее влияние на работу интерфейса оказывали участки, ответственные за воспроизведение и обработку речи; также очень важной для системы стала зона, которая обращает внимание на звук собственного голоса, чтобы дать мозгу обратную связь о том, соответствует ли сказанное намерениям говорящего.

Исследователи отметили, что массово такие нейроинтерфейсы распространяться не будут, пока они не станут безопасными и не начнут казаться людям обычным делом. Но есть и обратная проблема — интерес к ним со стороны учёных, которые смогли бы реализовать подобные импланты с практической точки зрения, не будет прикован без демонстрации потенциальных возможностей. Таким образом, до реальных успехов в этой сфере могут пройти десятилетия, если исследователи не покажут то, насколько подобные устройства могут быть полезны.