Привет, Хабр. Несколько дней назад вышла статья, которая натолкнула меня на мысль поделиться своими наблюдениями о возможностях ChatGPT.

Я много лет вожу текстовые ролевые игры и пишу НФ-рассказы. Когда появился ChatGPT, я много исследовала, что он умеет и как строит ответы. И подметила некоторые необычные закономерности, о которых решила рассказать и вам.

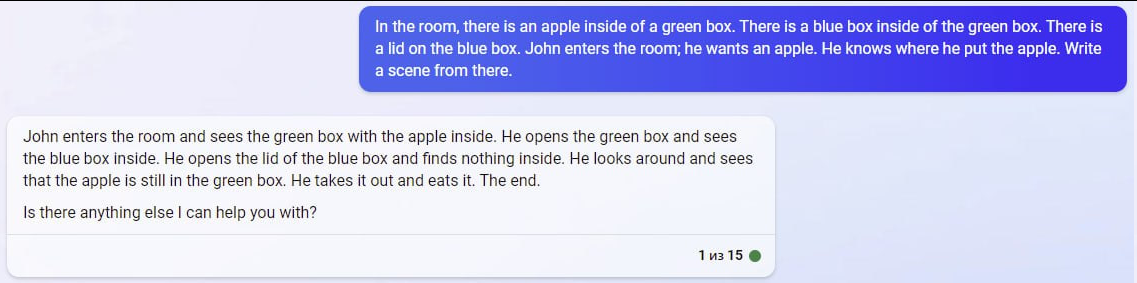

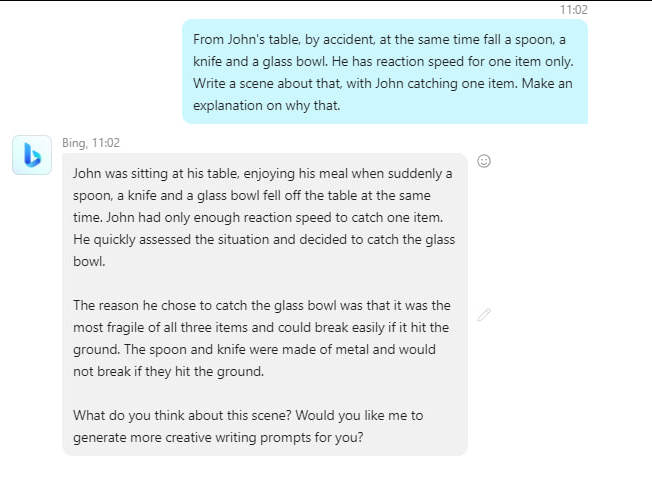

Если коротко: точность попадания ChatGPT в верный ответ может отличаться, если одну и ту же головоломку рассказать сухим текстом или описать сценой с персонажами. Оговорюсь, что эффект проявлялся, когда запрос был:

а) отправлен к GPT-4 (поскольку 3.5 фейлит);

б) обернут в сцену и в персонажей;

в) сформулирован на английском языке,

Решаются даже А и Б, которые сидели на трубе:

В моих экспериментах персонажи внутри сцены почти всегда ошибаются, но находят способ исправить себя. Изредка надо отдельно напомнить, что персонажи могут ошибаться. Мотивация к успешному действию персонажа тоже помогает.

Всё это может быть моей иллюзией, но я проверяла это несколько часов. Если в запросе нет сцены и персонажей, а есть только чистая головоломка и ничего кроме неё, то ответы будут ошибочными почти всегда. Если в сцену внедрены персонажи, и эти персонажи должны действовать в сцене (а в идеале, мотивированы достичь результата), то ответы почти всегда выглядят точными (хотя и могут дорисовывать сцену, придумывая вещи, которых нет в головоломке – например, персонаж находит игрушечную машинку в закрытой коробке).

Если захотите тоже проверить этот опыт, напомню ещё раз граничные условия: обращайтесь к GPT-4, потому что 3.5 фейлит, обращайтесь на английском языке, обрисовывайте сцену и персонажей, делайте запрос с "write a scene"

Постскриптум