Таблица как параметр в Postgresql

4 мин

Часто видно жалобы на то, что параметры "не работают". Как же они не работают?

А вот так:

А вот так:

select * from $1 where ...;

Свободная объектно-реляционная СУБД

select * from $1 where ...;

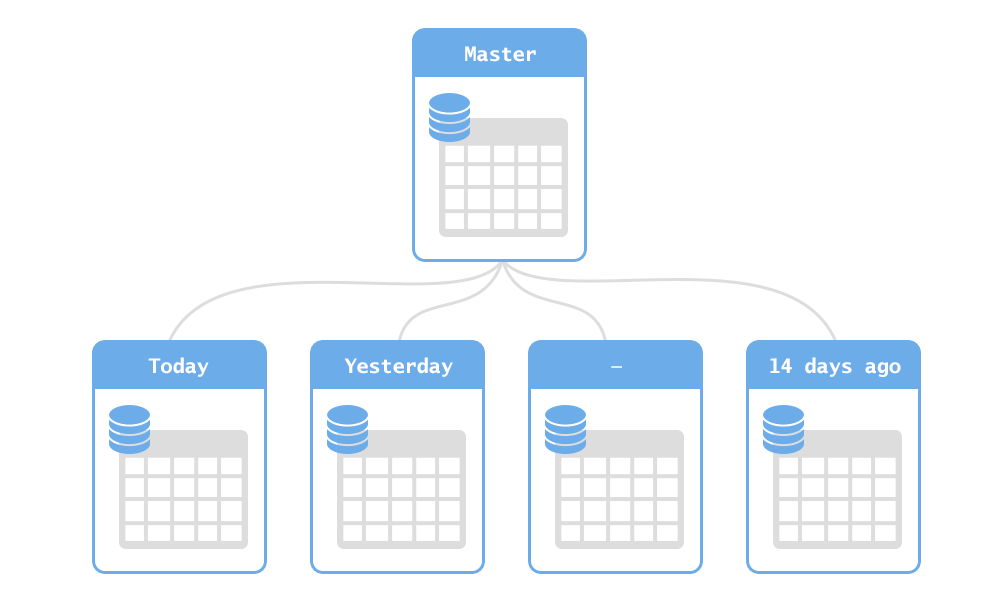

В ежедневной работе часто встает задача ясно и просто ссылаться на большие списки колонок и выражений в выборке, и/или обходиться с громоздкими и неясными условиями в предложении where. Обычно для этих целей используются представления, что вполне удобно и наглядно.

QUERY PLAN

---------------------------------------------------------------------------------------------------------------------------

Sort (cost=146.63..148.65 rows=808 width=138) (actual time=55.009..55.012 rows=71 loops=1)

Sort Key: n.nspname, p.proname, (pg_get_function_arguments(p.oid))

Sort Method: quicksort Memory: 43kB

-> Hash Join (cost=1.14..107.61 rows=808 width=138) (actual time=42.495..54.854 rows=71 loops=1)

Hash Cond: (p.pronamespace = n.oid)

-> Seq Scan on pg_proc p (cost=0.00..89.30 rows=808 width=78) (actual time=0.052..53.465 rows=2402 loops=1)

Filter: pg_function_is_visible(oid)

-> Hash (cost=1.09..1.09 rows=4 width=68) (actual time=0.011..0.011 rows=4 loops=1)

Buckets: 1024 Batches: 1 Memory Usage: 1kB

-> Seq Scan on pg_namespace n (cost=0.00..1.09 rows=4 width=68) (actual time=0.005..0.007 rows=4 loops=1)

Filter: ((nspname <> 'pg_catalog'::name) AND (nspname <> 'information_schema'::name))

As such, there’s really no “standard” benchmark that will inform you about the best technology to use for your application. Only your requirements, your data, and your infrastructure can tell you what you need to know.