Comments 1205

Однако от признаных экспертов я ожидаю взвешенного освещения ситуации, которое, как минимум, не содержит грубых фактических ошибок

И напрасно.

Эксперты — они потому и эксперты, что узкая специализация.

Чем больше времени потрачено на что-то одно, тем меньше его на всё остальное.

Чем больше набито шишек, тем больше предубеждение, что «там» всё еще хуже и нежелание набивать их еще раз. Всяк кулик своё болото хвалит.

В качестве канонічного примера можно почитать спичи Линуса о C++.

Я так понял, что Роман выступает не «за» или «против» а за профессионализм и за научный подход.

Аргументы Линуса вполне осмысленны, потому что многие плюсовые абстракции не zero cost все же, но это все вполне решаемо адекватным стайл гайдом. Другое дело, что он явно не хочет с этим заморачиваться. Впрочем, не помню, чтобы он хейтил раст в этом же контексте.

Другое дело, что он явно не хочет с этим заморачиваться.Не то, что «не хочет». Он «не может».

Подавляющий по объёму (но, конечно, не по важности) объём кода Linux написан людьми, которые имеют слабое представление о C и C++ в прицнипе — они вообще железячники, из просто драйвера нужны, чтобы железяку продать.

Когда они карго-култят драйвер дёргая куски C кода — результат получается слегка вменяемым и его можно, итерационно, довести до чего-то разумного.

Когда они чего-то напишут с полным игнорированием Style Guide на C++ — это можно будет только выкинуть и переписать с нуля. Кто будет это делать?

Очень сильное заявление, особенно, что люди имеют слабое представление о Си. Пример, приведёте из кода?

Memory leak в драйвере megaraid. Могли быть устранены в зародыше — при внимательном и вдумчивом написании кода. Либо прогоне kmemleak на рабочей системе. Пришлось патчить самому

Отлично, баги есть, есть откровенный говнокод. Но вы тоже будете обобщать, что среди разработчиков Linux люди не понимают Си.

P/S. Я не согласен с утверждением: «людьм, которые имеют слабое представление о Си»Я даже не спорю о их представлениях о С++ или rust или python.

Погодите. Вы просили пример. Я привел. Если бы разработчики этого конкретного драйвера были чуточку "умнее среднего" — проблемы не было. Но она есть. Никаких обобщений я не делал. Вы меня с кем-то перепутали

Нет, возможно я вас ввёл в заблуждение, но я просил пример не понимания Си. Не баг, а именно не понимание Си.

Т.е вы мне предлагаете посмотреть дискуссию, где обсуждаются конкретные проблемы драйвера exfat. Но при этом утверждаете, что люди не понимают в Си?

И смысл у него в том, что чем больше человек знает, тем более осторожны его суждения в своей и особенно в смежных областяхНет, всё вообще не так. Оригинальное исследование не утверждает того, чего ему приписывают.

Начнём с того, что мужика звали не «Даннинг-Крюгер». Это два разных исследователя, их фамилии пишутся через тире с пробелами: «эффект Даннинга — Крюгера».

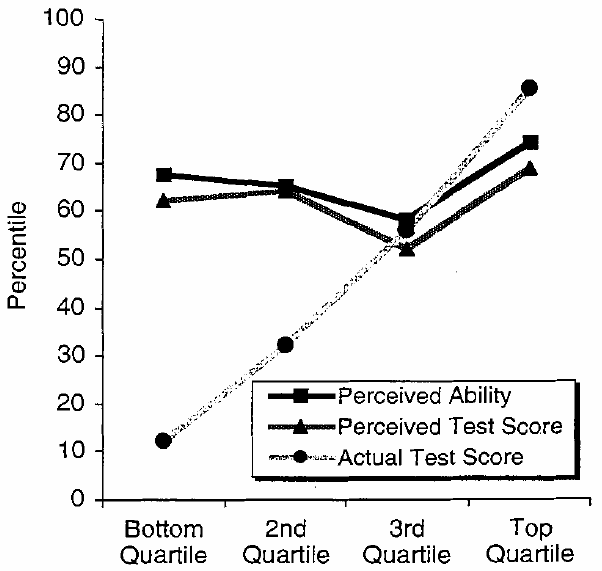

Оригинальное исследование 1999 года заключалось в следующем: студентам раздали опросники на разные темы. Также студенты оценили, насколько хорошо они ответили.

Студентов разбили на квартили по успешности ответов. Получилось что-то такое:

То есть всё полностью наоборот: чем лучше себя человек оценивал, тем лучше он себя проявил. При этом в среднем первая квартиль пусть и отвечала хуже второй, но оценила себя ниже, вторая — хуже третьей, но и оценила себя ниже третьей, и так далее.

Да, первая, квартиль отвечала куда хуже, чем ожидала сама. Но это не даёт право в Интернете затыкать рты всем, демонстрирующим уверенность в чём-либо: «У вас Даннинг-Крюгер, азаза».

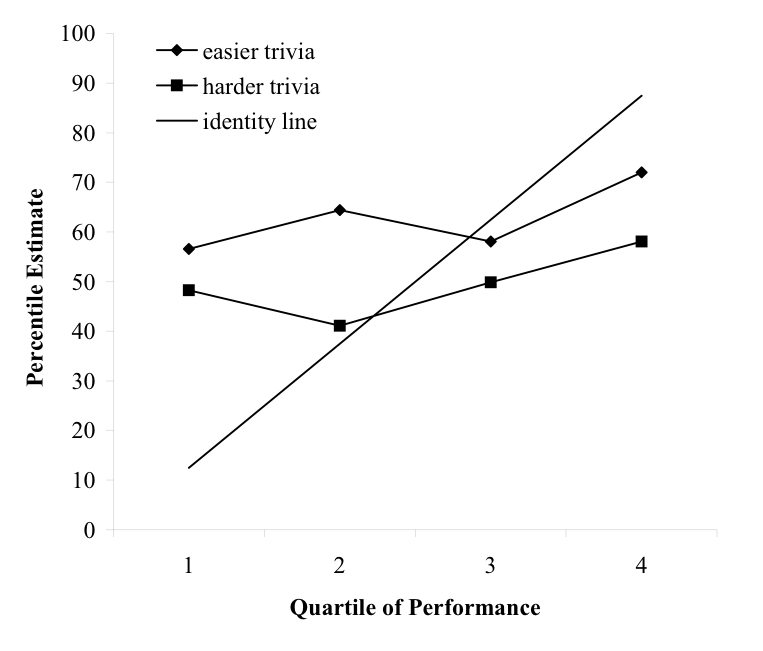

Само исследование невнятное: какие-то статистические выкладки с регрессией к среднему. Выше был дан график для опросника по юмору. График для опросника по логике выглядит более непонятно:

Каких-то больших различий нет: 5—10 процентов. При этом хорошо себя оценили как те, кто плохо ответил, так и лучшие. Получается, что если человек в себе уверен, то это либо профан, либо эксперт?

Я тут разве что могу заключить, что все люди себя оценивают выше среднего. Вот это интересно.

В 2006 году исследование повторяли. Результаты совсем невнятные. Люди себя оценивают хуже, если тест был сложный?

Нет никаких эффектов. Если вы с кем-то не согласны, то нужно опровергать чужую точку зрения.

Rust убьёт C++ и, возможно, C в перспективе 10 лет, это уже просматривается сейчас. Даже если Rust проигрывает в каких-то микробенчмарках, это ничего не значит. Миру слишком давно нужен такой язык как Rust, с богатыми. типами, с ручной, но безопасной памятью, с системой пакетов/библиотек, близкий к железу. Единственное, что может помешать Rust, это появление аналогичного по характеристикам языка, с поддержкой от крупного вендора, с более простой семантикой управления памятью.

А зачем кому-то переписывать мегатонны существующего кода? Вот в один день бизнес примет решение: мы писали свой софт 10 лет на c++, а давайте потратим ещё 10 лет на переписывание на другой язык, чтобы через 10 лет получить тот же функционал, что у нас есть сегодня, но собирающийся из другого языка.

Давайте будем немного реалистами.

Язык хороший. В своей ниже отличный. Но переписывать на него legacy — кому это надо и чем это в деньгах выгодно?

Хотите действительно безопасности? Тогда пропагандируйте Idris/Agda/Coq и DeepSpec. Но все мы живём в реальном мире и понимаем, что это на данном этапе развития невозможно :)

Вообще любой продукт, от которого зависит пол мира, очень даже имеет смысл переписать. OpenSSL приводят часто как хороший пример. Был бы он на расте мы, как минимум, избежали бы пачки уязвимостей, которые поставили эти пол мира на уши. Имеет смысл? Я думаю да.

И это не пропаганда раста, на котором я даже не пишу. Это просто здравый смысл. Нужно использовать лучший инструмент там, где это важно. Какой-нить игровой движок переписывать на раст? Там это не важно. Драйвер сетевой карты? Очень важно.

Я бы предпочёл переписывание на С++, на котором также ошибки подобного уровня не допускаются. Не хочешь переполнений — используй арифметику без UB на переполнениях. Не хочешь отрыва конечностей при работе с памятью — без проблем, просто не работай с сырой памятью. Не получается? Оберни в безопасные с как можно более низким оверхедом обёртки.

И да, Rust достаточных гарантий не предоставляет. Например, многопоточка. Посмотрите, что происходит при двойном локе мьютекса (происходит unspecified behaviour. А что это такое на самом деле — вы инфы, кроме предположений на гитхабе, не найдёте).

Не хочешь переполнений — используй арифметику без UB на переполнениях.И где вы в C++ нашли «арифметику без UB на переполнениях»? Или вы при -trapv? Так он во-первых не работает в GCC уже больше 10 лет, а во-вторых при попытке включить его для уже существующего кода в Clang тот начинает «сыпаться». Потому что оказывается что там реально происходят переполнения, просто результат работа никем не используется и потому «всем пофиг».

Каждую строчку перепроверить и убедиться что там всё хорошо? Так в этом случае уже и на Rust можно перевести всё.

Посмотрите, что происходит при двойном локе мьютексаА что для таких случаев предоставляет C++?

И где вы в C++ нашли «арифметику без UB на переполнениях»? Или вы при -trapv?

Не, я про обычные вещи уровня safe_int

А что для таких случаев предоставляет C++?

Ровно то же самое, что и Rust. Чёрт пойми что.

Ровно то же самое, что и Rust. Чёрт пойми что.

Не совсем. Гарантируется, что функция не вернёт после второго лока:

However, this function will not return on the second call (it might panic or deadlock, for example).

Тут скорее platform specific behaviour, которое для большинства популярных платформ означает deadlock, что не нарушает гарантий Раста (т.е. memory safety и отсутствие data races).

А можно небольшую просьбу от человека, знакомого с C, Rust, но плюсы знающего исключительно на уровне "Си с классами"?

В дискуссиях "C++ vs Rust" регулярно используется довод, что в C++ можно делать всё не менее безопасно, чем на Rust, и наверняка хорошо известно, что именно для этого требуется. Скорее всего, и компиляторы / линтеры это должны уметь.

Не могли бы вы (в значении "эксперты по языку C++", не обязательно лично Вы) показать пример конфигурации открытого компилятора и/или открытых линтеров, обеспечивающих адекватную степень безопасности? Чтобы была возможность начать проект на C++, включить их в этой конфигурации и быть уверенным, что они дадут мне по рукам, когда я случайно использую malloc вместо make_unique / напишу код с ошибкой инвалидации итератора / сделаю какую-нибудь ещё глупость, про которую я просто не в курсе. Потому что за себя я уверен, что даже если я прочитаю от корки до корки C++ Core Guidelines, как минимум поначалу такие ошибки всё равно будут.

Вот, например, clang-tidy --checks=cppcoreguidelines-*,modernize-* — это адекватно, избыточно или недостаточно?

Так в том-то и дело, что меня вполне устроит в качестве ответа линтер, который банит потенциально корректный код. Если он скажет "написанный так код потенциально опасен, так нельзя, пользуйтесь абстракцией такой-то" — оно и к лучшему. Если мне действительно будет нужно — найду в документации, как разрешить данное конкретное нарушение правил линтера (а заодно прочитаю, чем именно оно опасно, на что именно нужно проверить код вручную и о чём нужно предупредить комментарием следующего разработчика).

Не устраивает меня ситуация, в которой "разумеется, C++ позволяет всё это безопасно написать, но чтобы быть уверенным хотя бы на 90% в безопасности написанного, обязательно необходим ревьюер с опытом в современном C++ от N лет". Новые проекты в опенсорсе нередко начинаются с одного человека (или маленькой команды), и я не понимаю, как сейчас начать проект на современном C++ без хождения по всем стандартным граблям с нуля.

[Forwarded from Denis]

блин, нашёл тут на работе в своём старом коде

std::vector<_> vec = ...; auto it = vec.begin(), end = vec.end(); while (it != end) { if (/* some conditions on `it` */) { ++it; continue; } else { // ... it = vec.erase(it); } }

[Forwarded from Denis]

это просто п**дец, как я мог так ошибиться

[Forwarded from Denis]

переписал в иммутабильном стиле, планирую грепнуть и всё нафиг переписать так

[Forwarded from Stanislav Popov]

а в чем проблема?

[Forwarded from Denis]

vec.erase(it) инвалидирует все итераторы, которые распологались «после» it, в том числе и vec.end()

[Forwarded from Denis]

а я его закэшировал какого-то хрена

[Forwarded from Denis]

еб*чие плюсы, и ни один сраный линтер из тех, что мы юзаем, не заметил х**ни :(

[Forwarded from Denis]

у меня щас горит на самом деле, потому что ни clang'овский scan-build, ни cppcheck не находят говна

[Forwarded from Denis]

придётся видимо грепать проект по .erase(

[Forwarded from Denis]

плюсы — дно

[Forwarded from Denis]

даже когда вроде вот знаешь всё х**ню и умеешь их готовить

[Forwarded from Denis]

на секунду отвлёкся/забылся — проиграл

Когда у тебя в проекте куча

unsafe — это тревожный признак, но это можно терпеть. Когда ты оборачиваешь unsafe в функцию, которой нужно «правильно» пользоваться — ты возвращаешься в ситуацию «на секунду отвлёкся/забылся — проиграл».И тогда зачем весь этот «цирк с конями»? Один такой язык у нас уже есть…

unsafe, даёт доступ к внутренностям без проверок. Вот после этого можно и в rust «в трех безобидных строчках UB можно схватить».Причём автор объяснял что всё в порядке, просто не нужно лезть в потроха, функция не публичная, так что всё Ok.

Именно после этого — можно утверждать, что в Rust — всё на порядок проще с этим. Потому что небезразличный человек, буквально со стороны, — пробежался по ансейфам и нашёл этот баг.

Люди совершают ошибки. Это не случайность, это — норма.

Rust — язык созданный для упрощения борьбы с ошибками и в этом вся его прелесть. Хотя компилятор по прежнему не может думать за человека, но довольно таки большую часть работы он с человека снимает. Остаётся выполнить свою часть.

Фишка в том, что в расте такой код "за забором". И я как-то считал, в СТД (в котором ужас-ужас сколько ансейфа) его значение порядка 0.1% от общей кодовой базы (считал очень грубо, по строчкам). Это значит, что у вас не миллион строк кода где можно "на секунду отвлечь/забыться", а тысяча. А теперь допустим что программист в среднем "забывает/отвлекается" раз на тысячу строк кода. В итоге в одной программе будет тысяча багов из-за этого, а в другой — один.

Это грубо, без претензии на точные выкладки. Просто это та выгода, которую люди получают за "ублажение компилятора", который ни что иное, как по сути кланг с некоторыми обязательными линтами, за которые так ратовал кто-то в комментариях тут.

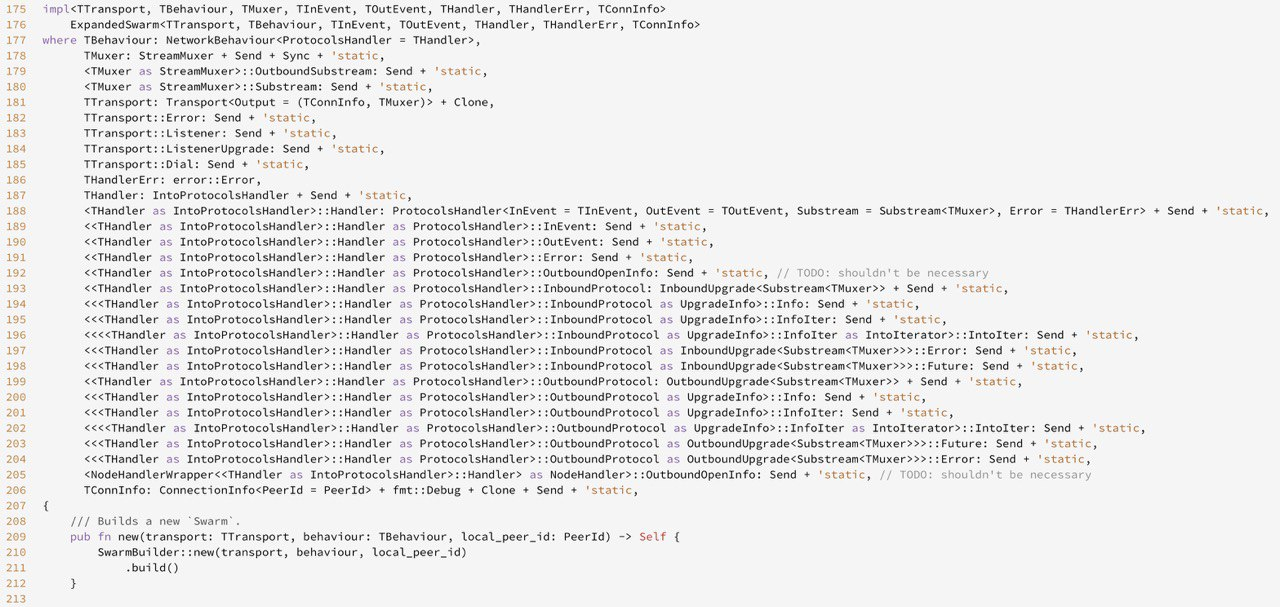

Фишка в том, что в расте такой код «за забором».Когда он за забором, то всё в порядке. А когда у вас вот такое вот:

pub(crate) fn get_mut(&mut self) -> &mut T {

unsafe { &mut *self.inner.as_ref().get() }

}

Это реальный код, из реального проекта.

Такими методами я вам могу в любом проекте достичь ультрабезопасности: будет у меня всего две

unsafe функции. peek и poke. Каждая в одну строку. И всё. Всё остальное — «офигеть как безопасно».Если на этом проекте был хотя бы 1 ревьювер этот код бы не прошел ревью.

Такими методами я вам могу в любом проекте достичь ультрабезопасности

Такими темпами я могу вам в любом коде любую хрень сделать: bool тип в сишарпе которые не true и не false, монаду в хаскелле которая не монада, и всё остальное. Если вы написали unsafe и нагородили ерунды, то это вы виноваты, а не язык.

И да, то что в огромном проекте как актикс смогли за полчаса найти все места которые могут вызывать УБ это и есть польза от этого unsafe.

Кстати, два момента

- с этой функцией нет проблем, потому что из &mut self можно возвращать &mut на дочерние элементы

- если её нарочно сломать (например, вместо &mut self использовать &self), то мири скажет, что код невалидный и починили бы вы свои ансейфы, дорогие товрищи:

Почему тогда столько шума было от этой функции?!

Посмотрите здесь. UnsafeCell используется вроде бы правильно, но прикол в том что там оно завёрнуто в Rc, и нарушается контракт Rc!

Кароче уб в расте такое же не очевидное как и в плюсах

Вот плейграунд c демонстрацией. Я скопировал весь код из actix/cell.rs, чтобы показать уб

Кстати miri ловит, но естественно только при использовании. Т.е. сама библиотека для мири выглядит вполне ок, а вот её использование через сейф апи приводит к уб (которое мири ловит).

Да, согласен, проглядел, в оригинальном исполнении тоже есть ошибка.

Кароче уб в расте такое же не очевидное как и в плюсах

Не совсем — мне неизвестен тул, который ловит УБ в плюсах. Есть всякие санитайзеры, но они такие, ненадёжные товарищи. А если закинуть этот код в MIRI то можно получить замечание от машины:

error: Undefined Behavior: trying to reborrow for SharedReadWrite, but parent tag <4320> does not have an appropriate item in the borrow stack

--> src/main.rs:50:5

|

50 | v1.push(4); //v2 mutated through v1

| ^^ trying to reborrow for SharedReadWrite, but parent tag <4320> does not have an appropriate item in the borrow stack

|Впрочем, я сторонник не писать unsafe вообще и дать это на откуп популярным библиотекам и std.

Кстати miri ловит, но естественно только при использовании. Т.е. сама библиотека для мири выглядит вполне ок, а вот её использование через сейф апи приводит к уб (которое мири ловит).

Не так, скороее МИРИ это интерпретатор который ловит уб который происходит. То есть оно может найти УБ если оно триггерится где-то в программе, но оно не найдет потенциальное УБ которое не эксплуатируется. Ситуация похожа с тестами.

В своём проекте подобный саботаж полностью перекрывается #![forbid(unsafe_code)] в корне проекта.

Я думаю, что проблема с актикс следующая:

У чела в голове было полуинтуитивное понимание того как это работает и почему оно сейф (оказалось в итоге не полностью правильным). Ему нужно было напрототипировать производителый веб сервер, а доказывать все компилятору лень. Выносить ансейф вверх по стеку в публичное апи, тоже не хочется. В итоге получаем такой говнокод (по меркам раста) как приведен в комментарии выше. Не все же такие фанатики как уважаемый 0xd34df00d, которые пишут доказательство корректности gcd на 200 строк.

и камень в огород с++ => если бы компиляторы умели сами когда можно кешировать .end(), .size() и прочее — никому бы в голову не пришло руками выносить их из цикла. а так — после того как вынос i< vec.size() ускоряет цикл и позволяет его векторизовать — начинаешь на автомате везде это делать. ну и провтыкиваешь в вышеприведенном случае.

Забавно, но в данном случае виновата как раз недооптимизация. Если бы алгоритм был выбран не квадратичный, а линейный — ошибки бы не было...

Надо просто бежать двумя итераторами, а не одним:

auto i = vec.begin(), j = vec.begin(), end = vec.end();

for (; j != end; ++j) {

if (/* some conditions on `j` */) {

if (i != j) *i = std::move(*j); // или swap

++i;

continue;

} else {

// ...

}

}

vec.erase(i, end);Как-то так, если я ничего не напутал.

На любой баг всегда найдется ответ "а вот в той книжке/той статье/5пункте 6 главы спеки сказано, что вот так делать не надо". Вопрос не в том, что человек так написал, вопрос в том, что кмк это вполне себе могло бы быть ошибкой компиляции. К слову, раст в таком случае выдаст ошибку компиляции, оно и понятно, он ведь не разрешает две мутабельных ссылки, как раз по схожим соображениям.

Tmad PsyHaSTe я нормальный и здоровый человек. Я не хочу думать о том, где мне компилятор С++ подсунет очередную жирную свинью. Я хочу сконцентрироваться на решении бизнес задачи. Тупо. Дешево. Сердито. Надежно. Без этих выкрутасов. Пускай меня компилятор страхует от ошибок. А не тупо молчит как партизан.

Помню, я купил книжку про умные указатели и всю дичь, что с ними вытворяли . Это был далекий 2000. Я просто тащился с того, что эти ребята с Саттером, Александреску творили. Но тащить это в прод. За ради чего ?

В Rust две мутабельные (исключительные) ссылки на одно и то же — не могут быть валидным кодом. И попытка их создать — это всегда UB. Поэтому нет смысла и в ослаблении ошибки до предупреждения.

Тогда, получается, невозможность присвоить строку целочисленной переменной — это проблема С++? Это же совершенно валидный код, только не компилируется :-)

Ну так и в расте можно — если сделать дереф в какой-нибудь Rc, и практика тоже так себе.

Я всеми руками за безопасность, но имхо это — перебор.

Во-первых нужно понять что &mut это не "мутабельный", а уникальный. Да, надо было изначально нормально назвать, были пропозалы чтобы это переделать, но оставили как есть в угоду обратной совместимости. По понятным причинам, уникальная ссылка должна быть уникальной.

Во-вторых различать уникальность и мутабельность нужно не так уж часто: на графовых структурах, и подобных случаях. В хаскелле вон вообще никакой мутабельности нет, и отлично живут, иногда даже плюсы аутперформят.

Уточнение: только не в Rc, а в Cell

Я просто хочу получить ссылку, а не использовать новые абстракции.

> Во-первых нужно понять что &mut это не «мутабельный», а уникальный.

И что даст это понимание?

> В хаскелле вон вообще никакой мутабельности нет

Хаскелль — функциональщина со сборщиком мусора. Rust же претендует на другую нишу.

Ну так и гипотетический я в С++ хочу присвоить строку целочисленной переменной, а не писать неявное преобразование (видимо, вместе со своим классом строки).

И что даст это понимание?

Понимание того, почему Cell, RefCell, мьютекс и атомарные типы можно мутировать по "неизменяемой" ссылке и при этом всё в порядке и никакие гарантии не нарушаются.

В С++ можно присвоить строку целочисленной переменной, если определить соответствующее неявное преобразование.

В Rust тоже можно так сделать через явные преобразования. Напишите мне код на C++, дам вам код на Rust.

То есть вы предпочтёте иметь в своей программе возможность обратиться к разделяемой переменной из разных, не захватив при этом предварительно блокировку? Ну ок.

Вот те абстракции, которые я перечислил, как раз и дают те специальные способы обращения, которые гарантируют защиту от гонки. И их там много не просто так, а потому что у каждого способа свои компромиссы.

А умный лок-фри контейнер это не абстракция?

Centimo, на мой взгляд, указывал на то, что в случае lock-free программирования подстроиться под гарантии Rust'а не получится — придется все писать на unsafe'е. Но это всего лишь моя интерпретация, конечно.

Вы не правы. Вот например https://github.com/xacrimon/dashmap отличный пример как lock-free структура данных спокойно живет с гарантиями Rust. Реализовано это через внутренюю мутабельность и имея immutable ссылку на непосредственно словарь (обычно разделяемую через Arc) можно удобно обращаться к ней из многих потоков. Понятно что внутри реализации есть определенный процент магии атомик переменных и страшных вещей, но при этом внешний интерфейс простой и удобный для прикладного программиста

с гарантиями Rustс типичными гарантиями, я бы сказал =)

github.com/xacrimon/dashmap/blob/master/src/iter.rs:238

unsafe {

let k = util::change_lifetime_const(k);

let v = &mut *v.as_ptr();

return Some(RefMutMulti::new(guard, k, v));

}

...

let mut guard = unsafe { self.map._yield_write_shard(self.shard_i) };

let sref: &mut HashMap<K, V, S> = unsafe { util::change_lifetime_mut(&mut *guard) };vec.erase(std::remove_if(vec.begin(), vec.end(), [](auto&& item){return !some_condition(item);}), v.end());Я ещё в свою библиотеку велосипедов-обёрток над std добавил шаблон remove_if(container, predicate), чтоб не писать begin()/end() (и не писать end() два раза). Думаю, с появлением концептов и рейнджей в С++ это будет так же легко делаться из коробки, без обёрток.

Ага, абсолютно логичный и понятный синтаксис. Понятно, что это устойчивая remove-erase idiom, но она все равно очень многословна. Что мешало в стандартную библиотеку добавить такой вариант:

std::remove_if(vec, [](auto&& item) { return !some_condition(item); });В C++20 у всех контейнеров появится метод erase_if: http://www.open-std.org/jtc1/sc22/wg21/docs/papers/2018/p1209r0.html

ЧЯДНТ?

Пишите на плюсах.

Всегда вопрос в системе типов. Чем она мощнее, тем меньше нужда в дебаггере, но тем лучше нужно читать, что за ошибку компилятор пишет. У меня например до сих пор ошибки в хаскель коде иногда вызывают оторопь — непонятно, что не так. Хуже, чем дебажить то, что если ошибка непонятна то просто "пройтись по строчкам и сравнить ожидаемое поведение с реальным" нельзя. Из плюсов — вы доказываете работоспособность в общем случае, а не тот сценарий который протыкан. Ну и навык понимать ошибки компиляции и избегать частых проблем — нарабатывается, а дебажить меньше не приходится. Встречал в хаскель чате людей, которые много лет в прод на нём пишут, а дебажиться не умеют вообще, не слышали про watch window и вот это всё. Забавно, но факт.

Имеет смысл переписать это на языке, который предоставит гарантии защиты от таких ошибок?

Проблем я вижу две

- Переписывание на Rust не убережет от логических ошибок

- Железо тоже имеет тенденцию подводить. Rust не поможет от того, что благодаря сбою на аппаратном уровне случится флип бита. А между прочим такое случается реально постоянно.

Знаете, если язык будет беречь от логических ошибок, то зачем ему вообще программист?

idris не спасает от логических ошибок.

Так наоборот — максимальный уровень verbosity компилятора, а еще лучше — обработка ворнингов как ошибок компиляции и пускай разработчик дорабатывает )

Только не решили проблему компиляции с++ кода часами и отжора компиляторов всех ресурсов системы )))))

Ну если в плюсах еще докидать тонну атрибутов для лайфтайм ворнингов, а потом все это объявить ошибками при помощи флагов компиляции, то да, один из источников UB мы устраним :) Останется еще 1023)

За 10 лет продакшн работы я встречал наверное тысячи баги, из которых ноль связанных с железом. По-вашему, стоит забить всё же на техники, уменьшающие баги в софте, ведь железо все равно глючит?

Вы сделали неправильный вывод ) баги в железе — это объективная реальность. Вот недавно была статье на Хабре, где рассказывались разные кейсы. Например, при передаче по сети бьётся бит и запрос уходит на другой домен, отличающийся одним символом. Или при чтении с диска. Или в памяти. В половине случаев — это все решается валидацией параметров. Немного помогают контрольные суммы.

В общем, это все не означает, что Раст плохой язык, но беда может прийти оттуда, откуда не ждёшь )

Может, но как верно сказали ниже, нужно предполагать корректную работу железа, математики, ОС и остального чтобы не сойти с ума и сделать хоть что-то полезное.

Но пока у вас на 100 (а то и 1000) багов в софте случается один такой аппаратный баг… нужно фиксить софт. А с железом потом уже бороться. Когда в софте не будет столько «косяков».

P.S. В том случае, кстати, софт фиксить не стали. Написали прогу, которая за день прогона определяет — есть бага в CPU или нет и если бага в наличии — выключает Turbo. Ну а потом эти процы по гарантии поменяли.

Вы только что своими словами пересказали историю fdiv bug'а из pentium. Первых которых. Не ммх ещё. Это какой год? 1993?

Или вот опять, снова по тем же граблям ?

Или вот опять, снова по тем же граблям ?Глабли похожие, но другие. В FDIV-баге всё было детерминировано. Тут же — всё зависело от температуры процессора. Что делало, конечно, баг очень весёлым для поимки. В итоге эта модификация «в свободную продажу» не пошла, насколько я знаю. Если вы не Amazon/Facebook/Google (которые получают новые процессоры до их официального объявления да ещё и со скидкой — именно чтобы «в случае чего» такие баги отловить), то вам на эту бяку без разгона нарваться не грозит.

За 10 лет продакшн работы я встречал наверное тысячи баги, из которых ноль связанных с железомПовезло. За почти 20 лет Delphi видел: битую память, битые сидюки (этих штук 10), битые сети — то постоянно. Переразозногнанные процы, несколько раз. Первое вот что вспоминается.

Напомню, что хороший программист на фортране может писать на фортране на любом языке. И с приличной вероятностью при переписывании на раст будет ощутимая доля разработчиков, которые будут фигачить get_unchecked оборачивая в unsafe не задумываясь о соблюдении необходимых инвариантов, как они делали в си, или, с обоснованием что так быстрее, сделают свой RefCell, позволяющий получить &mut T дважды и рассказывая потом что нигде в коде его дважды не дёргают.

С переписыванием криптографии всё очень непросто (хотя есть rustls/ring, как пример), но получение гарантированного поведения (в том числе по влиянию на кэши, предсказатель переходов и т. п.) даже в случае шифров использующих банальный ARX или проверки MAC может быть нетривиально из-за оптимизаций.

> Хотите действительно безопасности?

Мы хотим адекватного компромисса.

То есть любой возможный будущий репорт стоит 100% ресурсов и полной заморозки проекта на срок равный его прошлой разработке? И у нас точно нет других, чуть менее дорогостоящих, способов с этим жить?

Вы ещё спросите, зачем нужен рефакторинг. Можно ведь хяк-хяк и в продакшн

А какая разница, если в результате код становиться лучше и удобнее для использования, расширения и масштабирования в будущем? Ну кроме наверное переучивания программистов.

При рефакторинге кодовая база та же, процесс улучшений контролируемый и итеративный. Как бы… Отличия фундаментальны.

В одном случае, речь о более-менее протестированном и известном коде с известными нюансами и особенностями работы, в другом — о подобии черного ящика, который еще тестировать-не_перетестировать… И, что самое забавное, в итоге получить примерно то же самое и это еще в лучшем случае.

Справедливости ради, они всё-таки не переписывали "с минимальными правками", а наоборот всячески экспериментировали.

Впрочем, переписывать всё на свете я не призываю. В этом действительно далеко не всегда есть смысл.

Параллельно. Итого мне теперь надо не 100% ресурсов, а 200%. Плюс "старая" команда, поддерживающая продукт будет демотивирована постоянно и бонусом мы получаем внутренний конфликт в компании.

Кроме этого, новый код будет постоянно отставать от плюсового. Не получим ли мы не 10 лет на разработку, а 15?

Кто это оплатит?

Продукты часто переписывают даже в рамках одного и того же языка. Например, в сишарпе я вот переписывал недавно с фулл фреймворка на неткор. Зачем? Чтобы переехать с виндовых виртуалок на линуксовые и сэкономить приличную сумму на этом.

Уменьшение багов и увеличение скорости внедрения новых фич тоже вполне себе переводится на $$. Если мозилла даже четверть браузера смогла переписать (и если кто помнит это изначальная причина почему раст вообще появился), то наверное какой-то смысл в этом есть, не так ли?

Беда только… Ну не наблюдается роста доли раста в Firefox.

расширения на могильных платформах

Понимаю, что опечатка, но не могу не спросить — это на Windows Phone, что ли?..

висящий в фоне и играющий музыку плеер?

у меня не убивает — что я делаю не так? А, точно — это ж у меня в фоне ютуб премиум фигачит

Есть мнение, что Раст уже перерос давно мозиллу.

Ну так даже если МС от него откажется, то он и правда останется жить, разве нет?

Как у классика: Ничего не будет. Ни

Когда проект Windows Phone «накрылся медным тазом» и стало понятно, что аргумент «C# отлично работает на Windows и за будьте про всё остальное», скорее, заставляет разработчиков выбирать Java (Python и прочее) и уходить с Windows — произошёл разворот на 180 градусов, Visual Studio начала поддерживать вот это вот всё… и C# начали птытаться сделать «кроссплатформенным».

Но… поздно метаться: слишком много вещей, которые считаются «само собой разумеющимися» в C#-мире по прежнему привязаны к Windows.

Так что сегодня C# добрался только лишь до стадии: «хорошо под Windows и, если очень надо, можно чуть-чуть для чего-то ещё».

Этот статус позволяет ему жить, но если Microsoft от C# откажется — смысл в нём исчезнет немедленно.

Но… поздно метаться: слишком много вещей, которые считаются «само собой разумеющимися» в C#-мире по прежнему привязаны к Windows.

Это каких таких в контексте .net core? Если убрать UI (WPF/WinForms) составляющую

Это каких таких в контексте .net core? Если убрать UI (WPF/WinForms) составляющую.Понятия не имею какую там нужно составляющую убирать и откуда, но у меня несколько знакомых (не программистов) искали хостинг для своих ASP.NET проектов — на дешёвых хостингах с Linux не заработал ни один.

Что там технически происходит — я не в курсе, но связь «C# = Windows, а C# под Linux — для тех, кому нужно приключений на свою задницу» это поддерживает устойчиво.

Я не знаю, что там на дешевых хостингах, но в контейнерах все работает прекрасно у кучи компаний (из российский на слуху озон, додо, каспер и т.д)

А у энтузиастов бюджета нету: если у вас выбор, условно, платить $10 в месяц или $20, но перед этим заплатить программисту $300-$500 для адаптации… то простая логиика подсказывает, что вы таки будете платить $20.

В Java, к примеру, этого нет, потому что все пакеты изначально проектировались и затачивались, в том числе, под Linux.

Если пилить проект изначально под .net core, то все прекрасно будет работать под Linux.

Ну так пусть живут не под Linux. Выгодно будет переписать — перепишут. Это не так и сложно, если нет компонент, прибитых к винде. Но это уже не относится к .net

До праздников переписал последний проект который оставался в компании с фулл фреймворка на кор. Да, пришлось страдать, потому что там архитектура была Г (как часто бывает в легаси), библиотечные проекты напрямую лазили в конфигурационный файл (которых вообще нет в коре, и этот функционал замёнён специальным механизмом опций), но в итоге всё заработало, и не очень дорого оказалось.

Можно было бы обойтись куда меньшими правками и перенести вообще в несколько раз быстрее. Но решили попутно еще пару проблем с архитектурой порешать.

В общем, кор жив, и все компании которые пишут на шарпе и не хотят остаться за бортом либо переписывают на кор, либо уже переписали свои основные продукты. Кто-то даже на питон переписывает (не спрашивайте меня, почему, я сам задал тот же вопрос), но на виндовом фреймворке оставаться не желает никто.

В общем, кор жив, и все компании которые пишут на шарпе и не хотят остаться за бортом либо переписывают на кор, либо уже переписали свои основные продукты. Кто-то даже на питон переписывает (не спрашивайте меня, почему, я сам задал тот же вопрос), но на виндовом фреймворке оставаться не желает никто.По-моему вы яростно соглашетесь со мной. Вот смотрите — сейчас ситуация такая, что «на виндовом фреймворке оставаться не желает никто», но при этом часть «переписывают на кор», а часть «даже на питон переписывает».

Что будет если Microsoft, ну вот прям завтра скажет: «всё, мы передумали, нам играться в кор более не интересно, проворачиваем фарш назад, мясо — корове в зад… возвращаемся на Windows»?

Скорее всего тех, кто будет продолжать «переписывать на кор» — станет резко меньше, а тех кто будет «даже на питон» — резко больше.

И всё. И кончится C#, который, якобы, давно перерос Microsoft.

Вот лет через 5-10, когда на версии для Windows останется только небольшая часть сурового Legacy. И когда разработчиков C# вне Microsoft будет больше чем внутри… да, тогда можно будет сказать «да, C# уже перероc Microsoft».

А сейчас — ещё нет. Да, движение в этом направлении идёт… но пока ещё — C# очень сильно завязан на Microsoft…

По-моему вы яростно соглашетесь со мной. Вот смотрите — сейчас ситуация такая, что «на виндовом фреймворке оставаться не желает никто», но при этом часть «переписывают на кор», а часть «даже на питон переписывает».

Понятное дело что есть процент легаси всегда. В тех проектах, на которых я работал и они были мне интересны цифра виндвого фреймворка была 5-30%.

А сейчас — ещё нет. Да, движение в этом направлении идёт… но пока ещё — C# очень сильно завязан на Microsoft…

Я нигде не говорил что C# будет отвязан от майкрософта, скорее наоборот. Это как котлин и жетбрейнс, умрут последние — котлин резко потеряет в коммьюнити. Умрёт гугл — скорее всего го резко исчезнет с радаров.

C# отвязан от винды, уже давно и это так. Но он совсем не отвязан от майкрософта, и скорее всего, никогда не будет.

Так что сегодня C# добрался только лишь до стадии: «хорошо под Windows и, если очень надо, можно чуть-чуть для чего-то ещё».

Вот с этим утверждением.

С ним можно было бы спорить, если бы массовый переход на core уже состоялся

Состоялся. О чем я уже не раз говорил. Сидят всякие легаси-монстры, которым и COM нужен, и AD, и прочие. Все b2b SAAS — уже там.

Но нет — он в самом разгаре «у компаний в теме». А «мелочь пузатая» подтянется лет через 5-10.

Всё наоборот, мелочь пузатая как раз быстро и чутко адаптирует новые стеки, а догоняющими являются "компании в теме".

Всё наоборот, мелочь пузатая как раз быстро и чутко адаптирует новые стеки, а догоняющими являются «компании в теме».В данном случае я имею в виду не стартапы какие-нибудь, а булошные и кафешки. Которые вообще своего IT-отдела не имеют и заказывают переработку своего сайта/бухгалтерии раз 3-5-10 лет. Ну те, которые плачут горючими слезами про то, что поддержка Windows 7 закончилась (а некоторые — так и с Windows XP не слезли). Они ещё даже не почесались со времени появления .NET core, не то, что не перешли.

В данном случае я имею в виду не стартапы какие-нибудь, а булошные и кафешки.

ну компании у которых айти не является основным направлением мне и правда не интересны, и я их не считаю.

А те булошные и кафешки что с нами работают, например, получают от нас мобильные приложеньки или веб-морду и не знают, что работают на кор2.0-3.1

Wiki:

Как было объявлено, следующая версия будет называться .NET 5 (без использования «Core» в названии). В .NET Core 3.0 был почти полностью устранен разрыв в возможностях с .NET Framework 4.8. Новая версия станет единой платформой для .NET разработки, заменяя Mono и .NET Framework.

Последние 3-4 года пишу исключительно под докер (и сооветственно, линукс). Ни с одной софтиной никаких проблем не было (прям линух-специфических), ни на одном из 3 мест которые я за это время сменил.

основной причиной переписывания Firefox на Rust является популяризация Rust

Не только, ты же знаешь что в Rust есть несколько вещей, которые позволяют компилятору лучше генерировать код и вот прямо сейчас это уже работает правда пока ещё не так идеально как если бы работало в полную силу, но ничего, frontend допилят, особенно после того как древние баги clang на middlend починят.

Mozilla foundation преследует вполне понятные цели: обезопасить код, работающий с пользовательскими данными (код сайтов для них ведь тоже пользовательские данные) именно поэтому у них многослойные тесты на всё и всех для участков кода на всех используемых языках. Rust тут помогает некоторую, вполне конкретную, часть дыр прикрыть на корню, что явно на пользу. В общем то было бы удивительно что если бы новый системный язык (дефакто это 3 системный язык после C и C++) с первой спецификацией в 15 году не был бо лучше предшественников.

Да и я бы не сказал что в Mozilla не осилили C++, наоборот. Они просто выбрали альтернативный вариант. Они могли бы переписать однопоточный и даже одно процессный свой старый движок тоже на C++, но поскольку очевидно, что архитектура проекта будет принципиально иная много где они решили эти места написать на Rust. По мне это довольно разумное решение. Кроме того, насколько я вижу они сейчас переписывают разный код который «по быстрому адаптировали» в интерфейсе браузера за последние несколько лет с JS на C++. В общем по мне всё у них всё последовательно и логично.

Уменьшение багов? Я вот, ради интереса, перевёл проект с Mono на Net Core и с удивлением обнаружил, что багов стало больше. Пришлось писать workaround-ы.

Есть подозрение, что это скорее перестали работать хаки, которые работали под моно.

Не поделитесь ссылкой, какие баги там где всплывают и в какой версии рантайма?

1. Приложение — мультиплексирующий прокси, который держит единственное соединение с сервером по https и несколько клиентских. Сервер иногда дропает соединение, приложение это отлавливает и переподключается.

Так вот: SslStream не всегда ловит ситуацию, когда соединение было закрыто, вместо этого уходит в бесконечное ожидание. Дальнейший анализ проблемы показал, что он висит на Socket.ReceiveAsync. Причём асинхронщина используется, даже если используются только синхронные вызовы в SslStream.

Но при этом он зависает не намертво. Если при этом отключатся все клиенты, то после этого таки происходит завершение Socket.ReceiveAsync.

Проблема устойчиво воспроизводится в Net Core 3.1.201 под Ubuntu. Под Mono и в Windows она не возникает.

Более детально разбираться не стал, решил проблему использованием велосипеда — библиотеки для оптимизированной работы с сокетами, которую я написал пару лет назад, когда реализация асинхронщины в Mono был сделана через одно место.

2. Проблема при использовании SafeHandle и interop. Дело в том, что в Linux дескриптор имеет тип int (32 bit), а внутри SafeHandle используется IntPtr (64 bit в 64-битных системах). Mono об этом знает, и если функция выдаёт значение -1 (некоррекный дескриптор), то делает знаковое расширение до 64 bit, а вот NetCore делает беззнаковое расширение, в итоге функция SafeHandle.IsInvalid работает некорректно.

Как раз пример того, что может случитс на платформе, на которой мало кто из разработчиков работает…

- Нужно проверять в одинаковых условиях, работа моно под винду совсем не гарнатирует работу того же моно под убунту

- А вот на это я бы заводил issue, выглядит как серьёзная проблема.

Вы правы, legacy переписывать не очень выгодно. Тем не менее COBOL и FORTRAN практически исчезли, уйдёт и C++ по тем же причинам. Rust тоже исчезнет, но C++ грозит упадок гораздо раньше.

Не уверен, c++ развивается. И это заметно среди c++ разработчиков. Лично знаю нескольких, которые крепко думали о переводе проектов на rust, но c++ 20 в итоге перевесил.

Поймите правильно, я вообще golang разработчик, который для себя изучает rust и я не сильно тут предвзят, мне просто интересно, как развиваются языки программирования.

- Он ещё официально не вышел

- Поддержка компиляторов всё ещё совсем такая себе (имхо — недостаточно стабильно для серьезного прода)

Или это проекты в пару единиц трансляции и не являющиеся серьёзным продом?

Думаю имеется в виду "хотели начинать/переводить проект на Rust из-за недовольства C++, но новые фичи из C++20 потенциально делают C++ менее раздражающим, а значит можно продолжать писать пока на нём".

Поддержка компиляторов всё ещё совсем такая себе

Через год-другой, думаю можно будет уже постепенно тащить в прод.

Раст может позволить себе выкатывать фичи и опробывать их на смелых пользователях, после чего вкатывание фичи происходит только после успешной перекомпиляции всех публичных крейтов.

Я рад, что Rust может позволить себе перекомпилировать все крейты, только это всё равно ничего не гарантирует, хоть и увеличивает шанс, что всё хорошо :)

К счастью, Российской Федерацией мир не ограничивается.

В Яндексе, может быть, и не добавят Rust в список разрешённых языков. Не успеют…

Причем раст они не добавят именно стараниями Полухина, судя по всему.

Интересно, что же начнется, если например гугл решит юзать в хроме куски servo и это дойдет до яндекс браузера.

Все ведь потихоньку в этом направлении и движется, тот же микрософт вот уже сапера на расте пару дней назад выложил.

В определённый момент Яндекс превратился из инновационной компании в оплот консерватизма.

Почему? Потому что я не вижу смысла в переходе на этот язык и дроблении экосистемы на ещё один ЯП. И если растоманы постоянно его везде рекламируют — что же, пора просто начинать пропаганду в обратном направлении, чтобы компании меньше переходили на Rust и больше думали о том, что будет с их кодом через 20 лет.

Здесь тоже самое, только в случае ЯП.

Ну так звёздочки на гитхабе это вполне объективный способ выбора библиотеки.

Чем больше звёздочек => тем больше юзеров => больше гайдов.

Причём если у тебя появляется какая-то проблема, то с 99% вероятностью её решение ты найдёшь только для той либы, которая имеет тысячу звёздочек а не 10.

Вторая же сразу начала активно пиарится, но при этом уступает первой по всем вышеперечисленным параметрам. По моим наблюдениям звёздочек у первой будет больше. Хотя скорее всего вам бы больше понравилась первая либа.

Ну а дробление экосистем — в C++ экосистема и так уже раздроблена. Есть-буст-нет-буста, есть-исключения-нет-исключений, такая-система-сборки-другая-система сборки. Не говоря уж о куче версий языка C++. И если возникнут реальные потребности (а они возникают всё больше и больше), то индустрия безжалостно перейдёт на другой язык, не задумываясь о дроблении экосистемы.

И если вам приходится отвечать на рекламу пропагандой — ну, видать дела у вас совсем плохи :)))

А что с их кодом будет через 20 лет? А что сейчас с кодом, которому даже не 20, а хотя бы 10 лет?

Сейчас C++ по отношению к Rust оказывается в том же положении, в каком был C по отношению к С++. И даже аргументы те же. Скажите, вот что в вашем комментарии не применимо к переходу с C на С++? И где теперь этот C?

То есть вы не видите смысла для себя, и прикладываете усилия для того, чтобы проект не начинали другие люди? :)

Да, совершенно верно. Потому что мне с их кодом потенциально работать.

И если вам приходится отвечать на рекламу пропагандой — ну, видать дела у вас совсем плохи

Это ровно то же самое, что делает Rust. Не вижу ничего зазорного отвечать в той же манере :)

А что с их кодом будет через 20 лет? А что сейчас с кодом, которому даже не 20, а хотя бы 10 лет?

А что, там все либы Rust, написанные за какие-то там 5 лет, успешно собираются последними релизами?

Сейчас C++ по отношению к Rust оказывается в том же положении, в каком был C по отношению к С++. И даже аргументы те же. Скажите, вот что в вашем комментарии не применимо к переходу с C на С++? И где теперь этот C?

Не применим относительно «бесшовный» переход. Потому что С++ хоть и не является полным надмножеством С, но очень-очень с ним совместим. И это значительно облегчает переезд. А где С? Он везде. Ровно там, где ему и место :) Никто в здравом уме не потянет С++ или Rust в код, который испокон веков был написан на С и будет дальше на нём писаться.

Потому что С++ хоть и не является полным надмножеством С, но очень-очень с ним совместим.Ага, конечно. Есть только C программа не испольщует

malloc/calloc и работу с памятью.Дурацкий вопрос: вы вообще много C-программ без

malloc/calloc видели?А вообще и ваши истерики и статьи Полухина — это не просто хорошо, это прекрасно.

Потому что такое уже случалось в истории много раз. Когда представители платоформы-лидера начинают выпускать статьи и телепередачи «да не нужен вам XXX, бросьте каку» — это значит что всоре они будут уже называться «бывшим лидером». И неважно — речь идёт о переходе с Lotus 1-2-3 на Excel или с Microsoft IIS на Apache. Результат один и тот же.

Никто ведь не выпускает статей на тему «почему вам не стоит переписывать ваш код с C++ на C#»… а почему? А потому что тот код, который можно перевести с C++ на C# — уже перевели, переписали, а тому, который не переписали — это и не грозит.

А выдеоролики, подобные обсуждаемому, появляются… то значит пора, по крайней мере, начинать играться с Rust.

P.S. Впрочем как показал опыт перехода с C на C++… никуда C++ не денеться. И через 10 и через 20 лет будут люди, который будут на нём писать. Так что в этом смысле вам ничего не грозит.

Ага, конечно. Есть только C программа не испольщует malloc/calloc и работу с памятью.

А если использует, то что, она совсем иной становится? Да, я знаю про начала лайфтаймов и различие в этом плане между new/malloc. Но даже учитывая это, я считаю эти два ЯП сильно похожи.

А выдеоролики, подобные обсуждаемому, появляются… то значит пора, по крайней мере, начинать играться с Rust.

Так это наоборот правильное решение! Я настоятельно рекомендую многим людям попробовать Rust. Это действительно полезный опыт. Например, хорошо людей приучает, чтобы всё было константным by-design. И много чего ещё полезного.

P.S. Впрочем как показал опыт перехода с C на C++… никуда C++ не денеться. И через 10 и через 20 лет будут люди, который будут на нём писать. Так что в этом смысле вам ничего не грозит.

Я за это не переживаю. Я прекрасно понимаю, что сейчас рождено столько кодовой базы, что мне до моей смерти хватит работы. Я не хочу, чтобы люди на ровном месте бросались переписывать всё на Rust, вот и всего. Также как и начинали писать что-то новое на технологии, которая не показала такой уровень стабильности, как C++.

Я не хочу, чтобы люди на ровном месте бросались переписывать всё на Rust, вот и всего

это хорошее замечание. И действительно — не нужно тратить силы на переписывание чего-то, если их можно направить на создание чего-то принципиально нового. А если силы остались — начать то что называют housekeeping.

Также как и начинали писать что-то новое на технологии, которая не показала такой уровень стабильности, как C++.

ну, это фанатизм. По мне там C# и Java куда более стабильные, чем C++

А если силы остались — начать то что называют housekeeping.

Да! Это абсолютно верная стратегия.

ну, это фанатизм. По мне там C# и Java куда более стабильные, чем C++

А я ничего плохого в их сторону и не говорил. Я слабо знаком с их миром, но насколько я знаю — они тоже достаточно стабильны. Но точной инфы у меня нет.

А если использует, то что, она совсем иной становится?А если использует, то она не скомпилируется. Потому что в C++ нельзя написать

struct S s = malloc(sizeof s);. Надо struct S s = (S*)malloc(sizeof s); как минимум. Но кто-то может «для красоты» и в S s = new S; превратить. Оставив, по прежнему, в точке деаллокации free(s);.Опять-таки в C11 вы можете написать

struct S s = {0}; и потом сравнить две такие структуры через memcmp. А в C++ — не можете.В общем переход с C на C++ — это большая работа. Не просто опии компилятора поменять.

Согласно текущим стандартам C++, недостаточно просто скастовать. См. http://wg21.link/p0593r6, там первым примером идет объяснение того, почему так. Если/когда этот документ будет принят, то будет можно — в C++20 или С++23.

А пока для полного соответствия стандарту надо писать

S* s = new(malloc(sizeof S)) S;Миф про то, что переход с C на C++ тривиален, был показательно развенчан в видео https://www.youtube.com/watch?v=0dkzLdqH9V4, где автор 10 часов потратил на то, чтобы только скомпилировать исходный код Chocolate Doom (причесанный портабельный С-код) в режиме C++

Я не знаю, что в C++ стабильно, кроме job security на некоторых кодовых базах.

отличный троллинг! А еще, наверное, и не только job security, но и з/п выше среднего по рынку? Ну, с++ники — же элита и все как один с 10+ лет синьорского опыта

Ну, с++ники — же элита и все как один с 10+ лет синьорского опыта

Кто вам такое сказал? :) Это ровно такие же работяги, как и условные фронтендщики. Пришёл на завод, смену отпахал за gcc-станком, ушёл. Насчёт ЗП — да хз, вроде вполне себе средне\медианная по рынку.

когда о поддержке C++98/03 можно было говорить лет через 7 после его релиза

В тоже самое время С++20 ещё до своего выхода очень неплохо поддержан GCC 10. Времена меняются. Но это не касается всяких проприетарных компиляторов.

когда компиляторы учатся адекватно оптимизировать новые конструкции через 3-7 лет после их релиза в языке

Тут я тоже не знаю, что ответить. Потому что практически все известные мне оптимизации происходят там, где от С++ кода уже ничего не осталось.

Я не знаю, что в C++ стабильно, кроме job security на некоторых кодовых базах.

Совместимость.

Совместимость.

Ну давайте, расскажите мне про совместимость того же манглинга в минорных версиях одного компилятора, к примеру, гцц))

Ну ё-моё.

Всё верно. Для прода — не годится. Пробовать фичи — годится. Вон кому-то Nightly версии компилятора нормально. Кому-то грейдить страшно компилятор до выхода нескольких патчей. Так что нет никакого противоречия.

Что не мешает хорошо оптимизировать std::min({ a, b, c }) в изолированных примерах, но спиллить регистры, когда окружающий код не столь тривиален.

Репорты на перф-дефекты отправлены? Каков ответ?

Это было бы так, если бы компиляторы не переставали принимать код, который они ранее некорректно принимали.

Баги есть везде :) Это очевидно, вроде как.

В шланге 10 починили, но этой фиче, блин, 9 лет.Недочинили, кажется. Чуть-чуть усложняем… и получаем занесение константы в регистр с плясками и бубном.

-stdlib=libc++, то это фигни не будет.Разница в том что в

libstdc++ tuple — non-trivial for the purposes of calls, а в libc++ — как раз trivial (сравните). Соответственно когда этот самый tuple оказывается в одном регистре дальнейшая попытка это распутать обламывается.Тут, как бы, проблема даже не в том, что такое имеет место быть, а в том, что это, блин, банальный инлайниг. Без какого-то сложного control flow. С которым, как нам говорили, уже много лет назад «всё хорошо». И вот — регулярно вылазят такие косяки… в 2020м году, блин.

P.S. Или если увеличить результат, так чтобы он перестал влазить в регистр… то крабс-бамс-бемс… всё перестало влазить в регистр, «расклеилось» и свернулось.

Это было бы так, если бы компиляторы не переставали принимать код, который они ранее некорректно принимали.

Справедливости ради, в Rust это тоже есть — при переходе со старого borrow checker-а на NLL выловили несколько мест, которые в переходный период (около года, если не ошибаюсь) выдавали предупреждение, а потом стали ошибками. Но — единичный случай ввиду крупной перестройки, и, да, с предупреждением за несколько версий до слома.

Причем раст они (яндекс) не добавят именно стараниями Полухина, судя по всему.ваше утверждение основано на большом количестве спекуляций. Например на том, что мнение Полухина имеет решающий вес будет ли принят раст, на том, что раст экономически целесообразен для яндекса, на том, что профит от переписывания десятков тысяч человеколет плюсового кода на раст превзойдет затраты…

Все ведь потихоньку в этом направлении и движется, тот же микрософт вот уже сапера на расте пару дней назад выложил.тут такое «потихоньку», что к тому времени когда раст станет полноценной заменой с++ разовьется достаточно чтобы смысла писать на расте не было…

Например на том, что мнение Полухина имеет решающий вес будет ли принят раст, на том, что раст экономически целесообразен для яндекса, на том, что профит от переписывания десятков тысяч человеколет плюсового кода на раст превзойдет затраты…

Выше предложили еще отличный аргумент, что не хотят дробить экосистему еще одним языком. Я поддерживаю такой подход. Не хотите, не дробите.

Но когда люди стоят перед выбором "а не начать ли нам новый проект на Rust?", а им попадается доклад Антона, тогда получается уже не очень хорошо.

… тогда получается уже не очень хорошо.

Получается хорошо. Чтобы люди брали проверенные временем и поддерживаемые десятилетиями технологии. Всё так.

А наколенные вещи можно действительно писать на чём угодно, хоть на Rust, хоть на Python.

Получается хорошо. Чтобы люди брали проверенные временем и поддерживаемые десятилетиями технологии.

То есть вы поддерживаете позицию "ложь во благо"? Ну, не очень инженерный подход, прямо скажем.

Прочитал. Все еще придерживаюсь позиции, что по большей части, все перечисленное в статье — так.

А про дезинформацию: возьмем конкретный пункт "Плюсы Rust только в анализе времени жизни объектов." Это откровенная, явная неправда в такой формулировке, потому что как минимум раст похволяет не только контролировать лайфтаймы, но и отсутствие 2-х мутабельных ссылок на данные (ownership), в отличии от C++. Более того, ниже автор доклада явно повторил эту формулировку "Поэтому да — только lifetime", так что вопросы некорректной интепретации видео снимаются.

Так что да, я все еще считаю, что здесь есть "ложь во благо". И я считаю ее неприемлемой для технической дискуссии, даже если это всего лишь один раз за все выступление.

Я никакой лжи в своей речи не вижу. Я вижу только то, что как Rust-community насаждает Rust, так и я, как представитель C++-community, насаждаю С++. И своими словами я нигде, вроде как, ложь про Rust как про ЯП, не сказал пока что.

Я просто говорю о том, чтобы и дальше продолжали писать на С++, а не на Rust, так как толку от переезда сильного нет (если он вообще будет в долгосрочной перспективе).

"Все" действительно лишнее, вы правы.

Я никакой лжи в своей речи не вижу

А вас я во лжи и не обвинял нигде. Давайте восстановим, как было дело:

Но когда люди стоят перед выбором "а не начать ли нам новый проект на Rust?", а им попадается доклад Антона, тогда получается уже не очень хорошо.

Переформулирую: плохо, когда люди будут делать выбор, основываясь на неточной информации (и здесь я сделал вывод, что неточность в докладе была намеренная, так что — ложь).

Далее вы пишите:

Получается хорошо. Чтобы люди брали проверенные временем и поддерживаемые десятилетиями технологии. Всё так.

То есть поддерживаете позицию, что можно говорить что угодно, главное — чтобы выбрали вашу любимую ("проверенную временем") технологию. И вот эту позицию я не разделяю.

Rust-community насаждает Rust

Вы преувеличиваете. Люди просто рассказывают про хороший инструмент. Но вы воспринимаете это как-то в штыки, будто вас насильно заставляют на нем писать. Просто многим зашел этот инструмент, поэтому складывается ощущение, что "он везде". Возможно, это как раз свидетельство того, что он "взлетел" и действительно не так плох. А может и нет, не знаю.

То есть поддерживаете позицию, что можно говорить что угодно, главное — чтобы выбрали вашу любимую

Ну нет, такой вывод тут не следует ни разу, вы что. Я всего лишь придерживаюсь позиции, что если они останутся на С++, то это с моей точки зрения хорошо. По какой причине они останутся — это меня уже не касается. Если из-за неточностей других людей — да, будет совсем некрасиво, но конечный итог меня устраивает. Я повторюсь — я ни в коем случае не пропагандирую намеренное введение в заблуждение.

Вы преувеличиваете

Я был бы рад ошибаться. Но когда налетают коршуны со словами «Переписывайте на Rust» вместо дальнейшего поддержания существующего кода и допиливания в него новых фичей вместо тупого переписывания — мне это очень и очень не нравится. Лучше пусть пилят что-то новое (как хороший пример — самый адекватный Matrix сервер сейчас пишется как раз на Rust и это круто).

Я всего лишь придерживаюсь позиции, что если они останутся на С++, то это с моей точки зрения хорошо.

зачем? Цель какая? Типа все, кто не на С++ пишут — не развивают экосистему? Ну, так и те кто пишут — не все развивают. Не понимаю

Но когда налетают коршуны со словами «Переписывайте на Rust» вместо дальнейшего поддержания существующего кода и допиливания в него новых фичей вместо тупого переписывания

ну, тролли есть всегда и везде )

зачем? Цель какая? Типа все, кто не на С++ пишут — не развивают экосистему? Ну, так и те кто пишут — не все развивают. Не понимаю

Да, совершенно верно. Если они останутся, то шанс развития экосистемы выше, чем они не останутся. Да, я понимаю, что далеко не все развивают экосистему (и это абсолютно нормально).

ну, тролли есть всегда и везде )

Так ладно если б тролли — троллинг это хорошо. Так не троллинг ведь зачастую. Потроллить и я могу, зайдя в условный diesel и сказать, что чот медленно как-то, го перепишем на нормальный быстрый бумерский С++ :)

Ну так и пусть тогда пишут на С++98.

У меня для вас два слова: MSVC и шаблоны. Ну и где-то эхом разносится "зависимостии-и-и".

msvc как реализация давно славился своей «интересной» трактовкой Стандарта. На это можно только сказать, что все претензии к вендору :) Сейчас и сам msvc исправляется очень быстро, и Clang на винде уже доступен. Если у вас msvc-specific код — что ж, тогда больно будет (но и тут мб поможет clang-cl).

А почему не COBOL или не C или не Java или не Lisp и т.д.

Но когда люди стоят перед выбором «а не начать ли нам новый проект на Rust?», а им попадается доклад Антона, тогда получается уже не очень хорошо.то есть вы считаете что люди не должны обладать полной информацией и не должны иметь доступ к обеим точкам зрения по поводу раста?

Этот доклад не претендует на полноту информации, а скорее пропаганда "раст плохой, бросьте бяку". Притягиванием за уши каких-то сценариев и откровенной ложью.

Этот доклад не претендует на полноту информацииточка зрения «раст огонь я не буду слушать контраргументы» не претендует ни на полноту, ни на адекватность

Притягиванием за уши каких-то сценариеваргументы за раст всегда основаны на «притягивании за уши каких-то сценариев». Почему-то вам ок

откровенной ложью.примеры в студию

примеры в студию

unsafe не отключает борровчекер, в статье есть ссылка на статью которая так и называется «Вы не можете ансейфом отключить борровчекер», где подробно объясняется, почему это так.

Есть и другие моменты, но чтобы доказать что в статье есть прямая ложь мне достаточно одного примера.

unsafe не отключает борровчекерна это вам ответил сам автор утверждения. А вообще если бы в расте нельзя было отключить borrow checker, невозможно было бы написать большинство контейнеров эффективно (как минимум список и мапу)

Это возражение переносится один-в-один на С++: "Один UB может убить все проверки С++, так что С++ не даёт никаких преимуществ перед C."

если бы в расте нельзя было отключить borrow checker

Borrow checker в Rust не отключается. То есть не отключается в том же смысле, что в С++ не отключается RAII. Да, можно написать код, который borrow checker не будет проверять (с использованием raw pointers и unsafe), но это не значит, что borrow checker в этом коде отключен.

Да, можно написать код, который borrow checker не будет проверять (с использованием raw pointers и unsafe), но это не значит, что borrow checker в этом коде отключен.borrow checker в таком коде не работает, «но это не значит что borrow checker в этом коде отключен»? Противоречие

Он работает, но не проверяет лайфтаймы сырых указателей.

Только ансейф и нужен чтобы работать с сырыми указателями. Все ансейф блоки которые я встречал работали внутри на 95% именно с сырыми указателями. То что 5% ансейф кода прочекается — это сомнительное достижение. С учетом того что уб сделанное в ансейф коде может выстрелить абсолютно в любой момент, уже после ансейф.

Он работает, но не проверяет лайфтаймы сырых указателей.ну сами посудите. unsafe в большинстве случаев нужен либо для того чтобы работать с сырыми указателями, либо чтобы вызывать unsafe функции которые вызывают unsafe функции… которые работают с сырыми указателями. Итак, вопрос: если я пишу unsafe чтобы поработать с сырыми указателями вместо ссылок/Box'ов, отключаю ли я borrow checker?

Итак, вопрос: если я пишу unsafe чтобы поработать с сырыми указателями вместо ссылок/Box'ов, отключаю ли я borrow checker?

Нет, не отключаете ¯\_(ツ)_/¯

Да какой пример то? Отключить borrow checker нельзя. Вам уже сказали — borrow checker продолжает работать в unsafe секциях, но он не предназначен для указателей by design. Но при этом продолжает проверять ссылки. Хотите пример — держите https://play.rust-lang.org/?version=stable&mode=debug&edition=2018&gist=29e9aef02a12d840b81919c83166a31f. А ваша аргументация — это что-то в стиле "я отключил ПДД, так как лечу на самолете".

Акценты не так расставлены. Борроу чекер не занимается спасением от ошибок при работе с сырыми указателями (и некоторыми другими), для спасения от которых он не предназначен. Такие ошибки можно совершить только в unsafe блоке.

Борроу чекер не занимается спасением от ошибок при работе с сырыми указателями (и некоторыми другими), для спасения от которых он не предназначенА. борроу чеккер не покрывает сырые указатели

Б. работать с сырыми указателями можно только в unsafe блоке

Складываем А и Б, делаем вывод: в unsafe блоке можно нарушить гарантии borrow checker'а (используя сырые указатели), о чем я и писал выше.

А если бы это было невозможно, невозможно было бы например передать в сишную либу объект во владение по указателю.

работать с сырыми указателями можно только в unsafe блоке

Кто сказал?

fn ptr_is_null<T>(p: *const T) -> bool {

p.is_null()

}

fn main() {

let x = 42;

let is_null = ptr_is_null(&x as *const _);

dbg!(is_null);

}А если бы это было невозможно, невозможно было бы например передать в сишную либу объект во владение по указателю.

Поправлю. Передать без unsafe можно (если не учитывать unsafe для вызова внешней функции): Box::leak(). А вот забрать владение без unsafe действительно нельзя, так как нет компилятор не может гарантировать, что возвращается валидный указатель.

То есть не отключается в том же смысле, что в С++ не отключается RAII. Да, можно написать код, который borrow checker не будет проверять

Можно пожонглировать определениями, только какой в этом смысл?

Времена жизни ссылок всегда проверяются. Времена жизни указателей всегда не проверяются (но учитываются, см. stacked borrows). Нужно как-то сильно пожонглировать определением слова "отключается", чтобы назвать это отключением.

Формализация семантики unsafe кода (в частности). https://plv.mpi-sws.org/rustbelt/stacked-borrows/paper.pdf

Ох очередная пдф-ка в мой to read лист. Лайфтаймы в расте доказывают что программа коректна по памяти. Что делает эта штука? Она ничего не доказывает но частично ловит ошибки, правильно? Вообщем-то как это делает другие анализаторы из miri? Значит ли это что то что в расте везде навешаны лайфтаймы то их проще вывести и для указателей* из окружающего кода? Потому что явных лайфтаймов в указателях я что то не помню.

Про алгоритмы MIRI можно еще тут почитать: https://www.ralfj.de/blog/2018/11/16/stacked-borrows-implementation.html

Ох очередная пдф-ка в мой to read лист.

Ссылка что я дал — куда меньше, там минут на 15 чтения.

Спасибо, но 15 минут, это вы слишком хорошего мнения обо мне. Конечно если речь про скорочтение как в 1ом классе то в 15 минут я уложился :)

Я то понял что это эвристика MIRI. Но, хмм, вроде там ограничения такие же как у борроу чекера, хотя по идее должно быть более "flexible".

Нет, у них разные алгоритмы. Борровчекер не использует stacked borrows, он вообще игнорирует сырые указатели, а мири — нет.

Да я прочёл но ещё не до конца. Вроде как для обычных референсов они тэгаются полностью через Unique(t), и пофиг stacked или не stacked оба в результате дают правило вложенности. А вот для сырых там какой то SharedRW(bottom), который не тегается. У меня сложилось впечатление что это хорошо сработает на границах safe-unsafe но не внутри unsafe. Если честно мне пдф-ка понравилась больше чем блог, там больше разжёвано.

Но когда люди стоят перед выбором «а не начать ли нам новый проект на Rust?», а им попадается доклад Антона, тогда получается уже не очень хорошо.

Что не хорошо то? Люди хотят начать новый проект в продакшене на Rust. Это означает что его потребуется поддерживать. При всём уважении к Rust и моей радостью что его активно развивает Mozilla, подавляющее большинство компаний это не осилят ибо язык слишком сырой, а самое главное нет вообще никаких гарантий, что не выйдет новая версия которая потребует переписать всё.

Э-э-э, а какого рода гарантии дают другие языки?

Мне нравится Rust, но у себя (не в pet проекте) использовать я его буду очень не скоро ибо это очень большие риски для компании.

На C++ у меня есть проекты с кодовой базой в т. ч. по 15+ лет и они работают и потихоньку переписываются на свежее, благо, что С++20 уже везде поддерживается, за исключением нескольких мест в Embedded. Когда в конце 10х участвовал в разработке FlylinkDC++ там тоже были места родом ещё из середины 90х и это работало «из коробки».

Ну так какие гарантии, что комитет C++ внезапно не решит всё ломать? (:

Или этого не случится потому что противоречит здравому смыслу и никому не нужно? Ну так и с растом такая же ситуация.

Как это отражается на дизайне языка — легко отследить по тем же модулям и спорам вокруг них.

Вон как модули завезли, то как я понимаю в С++ становится реально завезти механизм эпох (аналог Editions из Rust, за что им спасибо).

Вон как модули завезли, то как я понимаю в С++ становится реально завезти механизм эпох (аналог Editions из Rust, за что им спасибо).Я надеялся на это, как на способ выхода из тупика… но пообщавшись с людьми, участвующими в стандартизации C++, выяснил, что они в этом направлении даже и не думают.

Комитет C++ активно «блюдёт» возможность «не сломать всем всё».

Это на бумаге так.

А разработчики компилятора раста могут позволить перекомпилировать все публичные крейты, чтобы проверить, что новое изменение ничего не поломает.

Не забываем еще про двустороннюю совместимость редакций, когда крейт 2015 редакции может иметь зависимость крейта с редакцией 2018. Плюсам такой стабильности никогда не добиться.

Это на бумаге так.

А это разве не так?

Плюсам такой стабильности никогда не добиться.

А не добиться почему? Что мешает сделать это с потенциальным механизмом эпох на основе С++ модулей?

Так давно уже ломают совместимость: https://stackoverflow.com/questions/6399615/what-breaking-changes-are-introduced-in-c11

Что мешает сделать это с потенциальным механизмом эпох на основе С++ модулей?

В C++30? Посмотрим.

В C++30? Посмотрим.

Конечно посмотрим :)

Комитет C++ активно «блюдёт» возможность «не сломать всем всё

Простите, но чем это отличается от раста? С первой версии (вышла пять лет назад) у раста такой же подход.

Простите, но С++ даже 3 года не продержался. Первый результат: https://twitter.com/timur_audio/status/1055771081993269248?s=20

because the lexer now eats <=> as a single token:Видимо его личный гипотетический лексер, а не настоящий. В реальном мире это будет перевариваться не хуже чем такой побитовый сдвиг:

vector<vector<int>>В ответах к твиту скинули код, который компилируется по разному в C++17 и предварительном режиме C++20

<=> встречаются настолько редко (буквально одна-две коллизии на миллион строк по исследованиям), что ни в компиляторах поддержки нет, ни в страндарте не будет, скорее всего.struct Foo {

Foo() = delete;

};

Foo foo = {};

Комитет, принимающий простые изменения по несколько лет ¯_(ツ)_/¯

Скорее всего не потребует. Rust специально проектировался так, чтобы можно было развивать язык, не ломая старый код. Уже сейчас сущестуют две редакции языка: Rust 2015 и Rust 2018. И вы спокойно можете использовать crate одной редакции с программой другой.

раст станет полноценной заменой с++

Он уже стал.

с++ разовьется достаточно чтобы смысла писать на расте не было…

В рамках С++ без того, чтобы напрочь сломать обратную совместимость (и в таком случае это будет уже не С++), можно с уверенностью сказать, что это невозможно.

Он уже стал.

Он не стал

В рамках С++ без того, чтобы напрочь сломать обратную совместимость (и в таком случае это будет уже не С++), можно с уверенностью сказать, что это невозможно.

А невозможно что именно? :) Вон С++ развивается семимильными шагами и новые фичи постоянно завозят. Так чего там невозможного то, а? Или так хочется, чтобы в С++ сломали обратную совместимость и конкурента точно убрали?

Он не стал

К счастью стал и интерес со стороны системных программистов к нему все выше и выше. Браузеры профит от него получили. Настал черед драйверов и ядер ОС, где расту самое место.

Так чего там невозможного то, а?

Невозможно заставить компилятор ругаться на небезопасный код, потому что для С++ он является корректным. До тех пор, пока С++ на уровне семантики (читай стандарта) не начнет давать гарантии, безопасным он не станет.

К счастью стал

К счастью не стал. Интерес пусть будет. Я приложу все усилия, чтобы он только интерес и вызывал, а прод как писали так и продолжат писать на С++. Не знаю, черёд чего там настал.

Невозможно заставить компилятор ругаться на небезопасный код, потому что для С++ он является корректным. До тех пор, пока С++ на уровне семантики (читай стандарта) не начнет давать гарантии, безопасным он не станет.

Именно поэтому и нужно развитие, чтобы если не весь C++, но хоть какая-то его часть сделалась безопасной и могла давать гарантии.

Именно поэтому и нужно развитие, чтобы если не весь C++, но хоть какая-то его часть сделалась безопасной и могла давать гарантии.

Уже давно ходит шутка, что Rust это C++2050.

А можно по пунктам, из счего это развитие состоит? Только не надо про "100500 библиотек и поддержку от гцц", это уже следствие, если язык хороший. Речь про уровень языка.

Так вот, что надо расту ещё развить? Можно перечень?

Перечень. И я там, кстати, забыл про placement new ещё упомянуть.

Ну тут много чего полезного, половины из этого перечня и в плюсах нет, значит ли это что на них нельзя писать пока не сделают (те же генерики, хоть higher-kind, хоть каких)?

половины из этого перечня и в плюсах нет

Какой половины? Из всего перечисленного в C++ нет разве что генераторов.

Ну в плюсах нет генериков, например (шаблоны это не генерики, как нам любезно подсказывает тот же msdn), значит нет и всех связанных с ними фичей.

В расте есть asm! макрос, где-то его вроде я даже слышал что используют. У нас, правда, стараются писать переносимый код, и влиять на ассемблер путём манипуляций с атрибутами и инстринками, так что лично не сталкивался.

Вот тут ошибочка, встроенный ассемблер отсутствует в стандарте Си или плюсов, это все вендорные расширения.

То есть ситуация не особо отличается от llvm_asm! макроса в nightly rust.

То есть ситуация не особо отличается от llvm_asm! макроса в nightly rust.Отичие в том, что в тех компиляторах, где они есть — они документированы и поддерживаются.

В рамках С++ без того, чтобы напрочь сломать обратную совместимость (и в таком случае это будет уже не С++), можно с уверенностью сказать, что это невозможно.способы развивать язык поддерживая обратную совместимость существуют, а вот поддерживать обратную совместимость на языке, который её не гарантирует, несколько сложнее

Можно их написать на раст без оборачивания в с++? можно ли на раст писать под микроконтроллеры там где нет ОС? Голый раст и компиляция под конкретное железо. AtMega, PIC, STM?

Да. Да. Да. STM.

Вот коммент с примером, чтобы не повторяться: https://habr.com/post/467901/#comment_20638103

Раст самодостаточен? На раст можно раст написать?Написать можно, но пока никто не сделал. Впрочем и LLVM далеко не в 2003м стало возможным для компиляции LLVM использовать.

Так что этот факт меня меньше всего напрягает.

можно ли на раст писать под микроконтроллеры там где нет ОС? Голый раст и компиляция под конкретное железо. AtMega, PIC, STM?Да, этим разные безбашенные люди занимаются. Почему безбашенные? Потому что там нужны фичи, которых в стабильном Rust нету, есть только Nightly.

Написать можно, но пока никто не сделал.

Cranelift-бэкенд потихоньку прогрессирует, кстати.

можно ли на раст писать под микроконтроллеры там где нет ОС? Голый раст и компиляция под конкретное железо. AtMega, PIC, STM?Да, этим разные безбашенные люди занимаются. Почему безбашенные? Потому что там нужны фичи, которых в стабильном Rust нету, есть только Nightly.

Если я ничего не путаю, базовый embedded на стабильной версии работает.

Если я ничего не путаю, базовый embedded на стабильной версии работает.В стабильной версии нет ассемблера. А в embedded без этого очень тяжело. Там ещё каких-то вещей не хватает, проде бы, но уже не столь критичных.

Справедливости ради, в случае сообщество Rust серъезно прорабатывает вопрос с embedded, есть специальная рабочая группа, в то время как в случае с плюсами есть лишь вендорные экстеншены для того, чтобы плюсы или сишка могли в embedded.

Ну в самом деле, за все годы существования как плюсов так и Си так и не появилось никакого стандарта на inline asm.

До тех пор, пока они локализованы, можно обойтись крейтами, собирающими и подключающими отдельные ассемблерные файлы. Quickstart для ARM не требует ночника.

Вот для чего потребуется nightly-версия — так это для тех архитектур, для которых недоступен собранный крейт core. Вот для его сборки, в первом приближении, обязательна nightly-версия.

Но без этапа «поиграться» я бы вооще никакую технологию не рекомендовал использовать, так что если вы хотите использовать Rust в embedded — можно уже пробовать.

Выход LLVM почти наверняка будет быстрее, потому что cranelift заточен под быструю компиляцию, а не под быстрый результирующий код.

Замену в чём именно? В идеале предполагается заменить им LLVM для дебаг-билдов, потому что производительность LLVM — один из ключевых факторов, ограничивающих скорость их сборки.

Можно ли написать на Расте бэкенд с производительностью кода не хуже, чем у LLVM? Зависит от того, сколько человеко-лет в него вложить...

Я к тому, что внутри можно создать safe подмножество. Точно также, как это сделано в Rust. Только весь старый код считать как unsafe C++. А новый на этом подмножестве — safe C++. Возможно это или нет — действительно хороший вопрос.

Для такого подмножества весь внешний код будет unsafe, причем многие вещи тупо не пролезут через границу подмножеств напрямую. А в таком случае это подмножество не имеет никаких преимуществ перед rust.

К тому же, как мне кажется, что начать делать несовместимые edition'ы языка нужны модули, когда они будут? В 27 году?

Модули уже в С++20. Или вы про то, когда они появятся в реальных проектах?

Чаще всего пользователю нужна безопасность в целом, иначе бы и на расте все по всюду расставляли unsafe. В итоге какой смысл начинать новый проект на плюсах, если раст безопаснее и удобнее.

Rust первого пока что не показал. Если покажет и докажет временем, что он также умеет — можно и на Rust начинать новые проекты :)

Обратная совместимость это ОЧЕНЬ важно. И это касается всей существующей на сегодняшний момент кодобазы в мире.

(чтобы не бояться за код через условные 10 лет)

давайте честно — с дефолтными флагами код через 10 лет тупо не скомпилируется. Да, наверняка, можно подобрать параметры компиляции, да, обернуть код какими-то обертками — возможно, что он заработает, но будет ли он после этого корректен и исходное поведение соблюдено? А вот не факт. Поэтому… Ну, не знаю — может ли это быть аргументом.

Да, я таскал код еще в 2003-2007 между версиями C++ и это была боль найти общее подмножество, чтобы все работало идентично, собиралось под разными средами и все такое. Но не у всех есть такая задача — тот же Яндекс наверняка МОЖЕТ себе позволить выбрать некий стандартный для себя тулинг и потихоньку со временем его менять. Но это специфика веб-разработки в противовес системному программированию (разработка ОС, драйверов, библиотеки и пр) или коробочному (те же игры, например)

давайте честно — с дефолтными флагами код через 10 лет тупо не скомпилируется.

Я уже тут не согласен. Я компилировал такой код с дефолтными для всей С++ инфры флагами код с 1989 года емнип (компилил на gcc 5, msvc какой-то там, кто идёт в Visual Studio 2017). Не могу припомнить боли. Скомпилировался, работал, хоть и было очень много предупреждений. Больше опыта сборки такого доисторического кода не имел.

но будет ли он после этого корректен и исходное поведение соблюдено

Такой гарантии строго говоря нельзя всё равно дать без покрытия тестами, чтобы мы не использовали.

Мне кажется или лет 10 назад культура разработки была хуже, чем сейчас? Тесты — согласен — без них никуда, но есть языки, в которые тесты более нативные, их проще едлать, чем в с++. Тот же голанг.