Комментарии 129

Disclaimer: я там работаю.

Похоже многое взяли у Dialogflow/Api.ai.

В общем понятна целевая аудитория этой штуки, но есть нюансы. Например у вас очень мало встроенных типов. «Листовых» встроенных типов похоже вообще нет. И как бы ясно конечно что листовые типы любые пользователи могут сами объявлять и что есть волшебное автоматическое расширение, но…

Там куча проблем. Например вы делаете музыкальный проигрыватель для индии. В индии скажем 15 миллионов исполнителей (на самом деле должно быть больше) и у вас даже есть соответствующая библиотека с музыкой. Гл чтобы все работало хорошо — вам нужно всех их загнать в тип и желательно снабдить синонимами (это чтобы разворачивать «RHCP» в «Red hot chili peppers» во время запроса). Какое железо нужно чтобы натренировать модель с этим типом, а какое нужно чтобы поместить ее в память на клиентском устройстве? А если полагаться на авто расширение контекстное то начнутся разные приколы с опечатками, неполными названиями, отсутствием синонимов, путаница с между названиями треков и исполнителями (этого и с соттветствующей разметкой не избежать, конечно).

Встроенные типы тут не спасут, но в менее клиническом случае помогли бы, т.к. они не являются частью непосредственной модели, и их можно очень сильно заоптимизировать. Но опять же — как их в вашем кейсе обновлять? И в целом тут спасет только облако на сегодняшний день.

А небольшие случаи с управлением внутренностями машины или умным домом должны хорошо работать. Было бы качество.

И я так понял — модели тренируются только онлайн?

Дисклеймер:… а ну его.

Есть «магазин приложений», где можно взять уже готовые модели, созданные компанией либо обычными энтузиастами. Как раз пример с музыкой на сегодня существует (не уверен, в публичном ли уже доступе), проиндексировано порядка пары тысяч композиций.

То есть, говоря о втором примере целевой аудитории, предполагается такой конструктор, где можно как собрать всё самому с нуля, так и загрузить уже предоставленное кем-то, что сильно снизит трудозатраты.

Вопрос про обновление, действительно, мне видится самым больным. Работа полностью оффлайн накладывает сильные ограничения. Даже для банального «какая погода сейчас в Париже?» надо иметь доступ к интернету, пусть само NLU и происходит оффлайн. Да и музыку просто так не запустить, даже если точно понять, что именно надо запускать — нужна интеграция с проигрывателем. Работы в этом направлении тоже ведутся, но тут я не могу сказать больше.

Второй козырь (помимо оффлайн работы) — работа с персональными данными. Они никуда не утекут просто потому, что не могут (оффлайн же всё). Насколько это важнее потенциально более удобного использования условной Алексы — решать каждому самому. В моем понимании, «в светлом будущем» Snips видит себя как полноценный игрок на рынке голосовых помощников, за счет магазина типичных приложений, а также интеграции со сторонними железками типа колонок, телевизора, стиралки и тд.

И про тренировку моделей онлайн: сейчас проверяется работоспособность federated learning для распределенного обучения непосредственно на устройствах, proof-of-concept работает.

Ну и howto для юзеров?

- medium.com/snips-ai/voice-controlled-lights-with-a-raspberry-pi-and-snips-822e53d7ede6

- medium.com/snips-ai/https-medium-com-customize-snips-voice-assistant-with-personal-wake-word-6dac6736fab6

- medium.com/snips-ai/sing-your-heart-out-with-this-voice-controlled-karaoke-app-for-raspberry-pi-f8727e405f02

Там же много более пространных постов о том, как оно всё работает.

Pardon the interruption.

You’ve read 11 stories this month. Let’s make things official.

Или там регистрация бесплатная?

остальное все происходит на гигантских фермах

Вы не забывайте, что на огромную ферму приходится огромное количество юзеров. А мощность десктопов в последнее время (благодаря возвращению AMD на рынок) выросла довольно существенно, и как раз в количестве ядер. Плюс на каждом втором десктопе мощная видеокарта. На ультрабуках, впрочем, наверное, такое и правда будет неудобно запускать — будет включать кулеры и жрать батарейку слабыми U-ядрами

Это все нереальные цифры объема информации, которую надо где-то взять, нормализовать, актуализировать, разметить, поддерживать и перелопачивать при запросе.

Да, там огромное количество юзеров, но это не единственное и не главное препятствие для локального развертывания.

Ну это если про «вроде cortana/siri» говорить. Штуки попроще вроде базового home automation на четыре лампочки и один кондиционер вообще можно безо всякого nlp делать, простыми голосовыми командами (гугл — voice control application pc offline, это не ресурсозатратно).

Мы же о работающем ассистенте сейчас говорим? Частью intent recognition является работа с сущностями, которые в этом интенте теоретически могут присутствовать. Даты, время, коды аэропортов, локации, имена, названия музыкальных групп и фильмов, справочник телефонов организаций в своем и чужом городе,

Это может коммюнити предобучать и предъиндексировать, и выкладывать как приложение

личные предпочтения на аккаунте (как без них реагировать на простое «включи что-нибудь веселое на колонке» — cradle of filth запускать или большого русского босса, или вообще имелся в виду условный акинатор и на какой именно колонке тоже может быть не всегда понятно).

А это можно тренировать в фоне, когда ПК не загружен, вместо скринсейвера

Я понимаю, open source и все такое, но недавняя практика использования npm показывает, что было бы желание — просочить вредоносный код можно, а в связи с этим идея выглядит как "перестаньте сливать данные гуглу и амазону, а начните сливать их третьим, неопределенным, лицам". Или я слишком паранойик?

Вопрос использования чужих программ и устройств всерда упирается в доверие к их создателям. Причем речь не только о злых намерениях, но и о способности создателей предотвратить воплощение в их продукте злых намерений третьих лиц. И это никак не связано с открытостью исходников.

Единственный плюс открытого исходника в этом вопросе — возможность провести аудит кода на предмет закладок и уязвимостей не только спецслужбам.

Кроме того, сливать данные Гуглу и Амазону, как показывает реальная практика, в итоге тоже означает сливать их третьим неопределенным лицам.

Если рассматривать данное устройство, то определенная польза от него все же есть. И риски утечек несколько ниже, чем на голой колонке.

Во-первых, возможен аудит всего кода проекта, включая ОС на RPi (за исключением некоторых вопросов к самой RPi).

Во-вторых, если не оставить устройстау выхода непосредственно в сеть, его взлом будет возможен только при физическом доступе к нему.

Естественно, остаются вопросы потенциальных закладок в RPi и модуле с микрофонами.

Но если без устройства однозначно понятно, что Гуглоамазону сливается все, то с ним есть шанс, что часть времени ничего записано не будет.

Глядя на этот проект, возникает вопрос: а зачем вообще покупать Amazon Echo и Google Home, если распознавание речи выполняется на Raspberry Pi с Tensorflow и Keras?

А много той речи распознает "Raspberry Pi с Tensorflow и Keras" помимо собственного имени?

Умными фишками не пользуюсь, но тут частично дело в том, что русский ещё не завезли полноценно, а английский неожиданно оказался не особо удобен для меня.

В целом доволен, но просто как ещё один способ управления умным домом.

Про радиоприёмники и прочий фоновый шум: не очень то работает при включенной музыке, т.е. включать можно, но потом проблема. С расстоянием тоже не всё отлично, метра 3 и всё, надо голос повышать, а результат не всегда хороший

Периодически пользуюсь в качестве персонального ассистента, для напоминаний/заметок, а теперь и будильника. Хотя с этим вполне справляется и телефон.

Из умного дома пока только пылесос… съемная квартира накладывает ряд ограничений на возможности интеграции, хотя уже подумываю над поиском решений)

Мне жена подарила irbis с Алисой, а потом отобрала на кухню )

Музыку удобно ставить, что нибудь спросить, таймер поставить и пр. Теперь хотим уже Яндекс станцию в гостиную.

Дети знакомых просят Alexa поставить музыку, например.

У меня лежат Amazon Echo и Google Home Mini — не подключаю, паранойя.

— пришел домой, заиграла музыка

— ушел, музыка перестала играть

— попросить играть музыку (тут еще дело в подписках к примеру на youtube premium)

— таймер

— найти рецепт

— включить быстро youtube на тв какой либо ролик

— рассказать погоду по моему маршруту на работу (я на велике 16 км езжу)

это лишь то, что я использую каждый день.

Я просто делаю интернет радиоприемники, без голосового помощника, иногда подумываю, а нужен ли он там?

В Алексе есть куча радиостанций — через Tunnln, еще какие-то сервисы там есть.

Просто говоришь какое радио включить и все.

Есть русские станции.

Поэтому Алекса — конкурент и интернет-радиоприемникам, за счет легкого управления голосом.

Глядя на этот проект, возникает вопрос: а зачем вообще покупать Amazon Echo и Google Home, если распознавание речи выполняется на Raspberry Pi с Tensorflow и Keras? Разве что в качестве подставки…

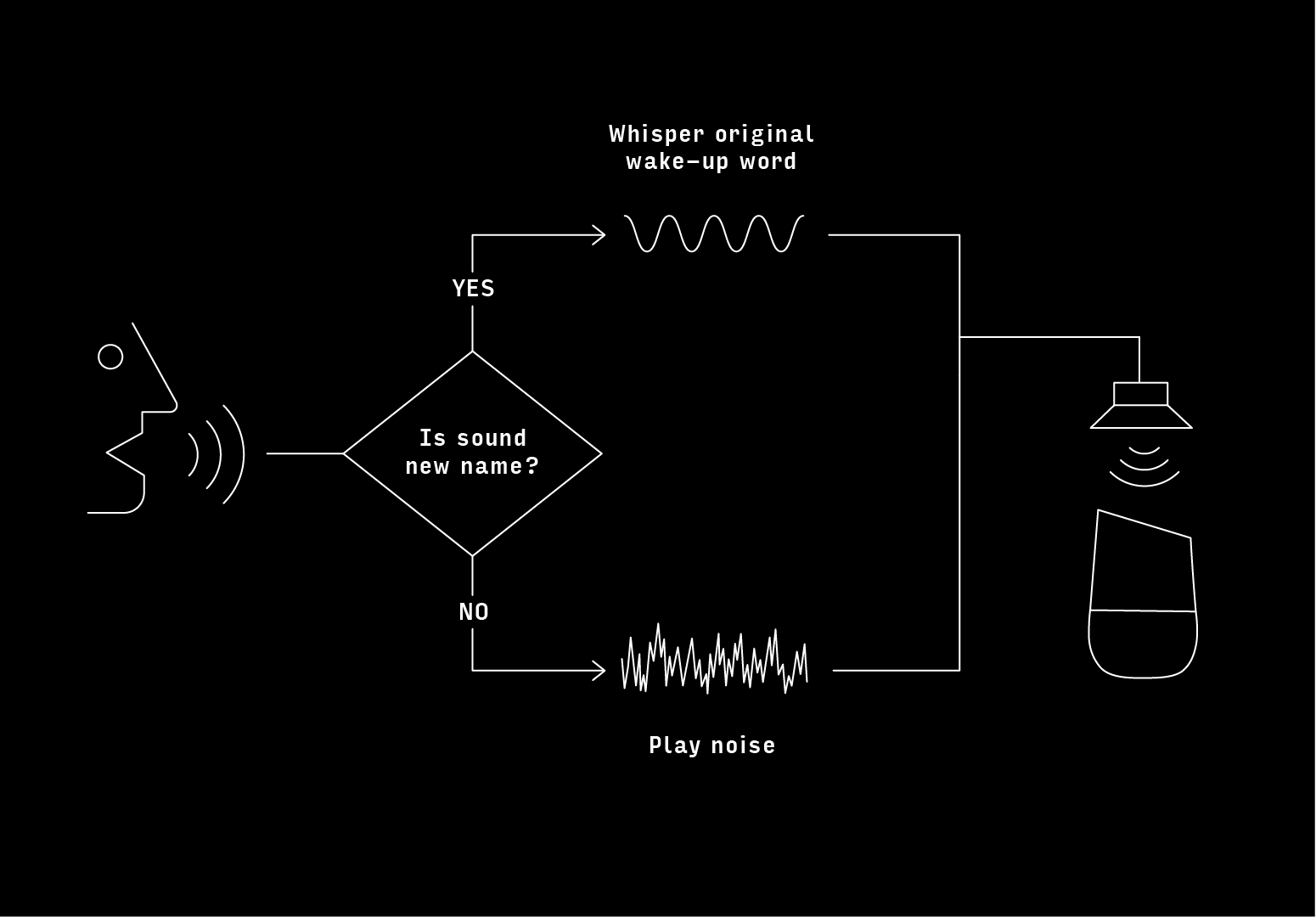

На устройстве обычно распознается только слово триггер, а не любая речь.

И радоваться тому, что данные сливаются в яндекс, а не в амазон/гугл? Ну да, хороший выигрыш.

(кстати, какой конкретно яндексовский API?)

Ну да, хороший выигрыш

выигрыш в том, что при прочих равных не нужно покупать эхо в качестве подставки.

Это если "прочие" — равные, в чем пока нет уверенности.

… затем, что у эхо/хоум больше функциональности, чем у описанной в статье малинки?

Насколько я знаю — нет, не может.

circuitdigest.com/microcontroller-projects/raspberry-pi-amazon-echo

Вы шлете туда голос. Поэтому все проблемы конфиденциальности данных остаются (ну разве что вы немножко лучше контролируете, когда она включается). Плюс, вы не можете пользоваться этим сервисом просто так, вам нужно партнерство с Амазоном — и это вряд ли дешевле, чем просто купить Echo.

Малинка? Нет, не шлет. Сама умная колонка — шлет, конечно.

Но непонятно, в чем выигрыш, если пользоваться тем же самым сервисом.

Выигрыш в том, что обычно злые дяди из трёхбуквенного агентства могут вежливо попросить Амазон удалённо включить микрофон Вашего устройства, и писать все звуки в вашем доме подряд — например, как Вы с женой обуждете устройство суперсекретного бульбулятора с лазерной накачкой, — а не только Ваши поисковые запросы. А "грибок" служит фильтром: когда узнаёт ключевое слово — пропускает следующие надцать секунд звука на Юстасу Алексу, а всё остальное время прилежно шипит в её микрофоны.

(Кстати, интересный вопрос — а не обвалит ли десяток часов белого шума амазоновские сервера?)

А "грибок" служит фильтром: когда узнаёт ключевое слово — пропускает следующие надцать секунд звука на Юстасу Алексу, а всё остальное время прилежно шипит в её микрофоны.

Вы сейчас объяснили, в чем выигрыш от использования грибка, но не самодельного устройства.

Кстати, интересный вопрос — а не обвалит ли десяток часов белого шума амазоновские сервера?

Неа, не обвалит. Почему бы?

… и через недельку-другую обнаружить, что ваше устройство заблокировано в AVS за нарушение Program Terms (причем не важно даже, есть там такой дословный пункт, или нет)

заодно ответьте на вопрос чем программное отключение микрофона принципиально отличается от варианта упомянутого в посте? кстати в amazon echo есть выключатель микрофона.

обоснуете?

А чем обосновывается утверждение "злые дяди из трёхбуквенного агентства могут вежливо попросить Амазон удалённо включить микрофон Вашего устройства, и писать все звуки в вашем доме подряд"? Вот и мое предположение, что Амазон может отключить неудобного ему пользователя сервиса (особенно если этот пользователь ничего не платит), основано приблизительно на том же.

заодно ответьте на вопрос чем программное отключение микрофона принципиально отличается от варианта упомянутого в посте?

Тем, что автор самопального устройства, используя AVS, обязан соблюдать Terms and Conditions разработчика, а владелец — Terms and Conditions пользователя.

Тем, что автор самопального устройства, используя AVS, обязан соблюдать Terms and Conditions разработчика, а владелец — Terms and Conditions пользователя.

вот только в обоих случаях на микрофон не будет поступать «полезной информации», так что разницы нет.

Нет разницы для кого и в чем? В механизмах воздействия Амазона на "пользователя" — есть.

Вот только в том случае, если это "честная" Алекса, он ничего особо больше сделать не может, а в случае, если это самопальный девайс — отключит девайс к чертям, вместе с эккаунтом разработчика, и все. Чтобы неповадно было. Амазону-то одинаково, он в обоих случаях ничего не получил, а вот пользователю девайса — больно.

У амазона сервисы для speech recognition и natural language understanding (Lex, Polly, Transcribe) открыты для всех

Вот только не бесплатны.

вы можете сделать свою умную колонку с блекджеком уже сейчас

… и сколько времени и усилий понадобится на то, чтобы повторить уже существующую функциональность Алексы? Особенно в части интеграции с другими устройствами?

Речь же не о том, что это принципиально невозможно — речь о том, насколько просто заменить Alexa Echo или Google Home в нормальном использовании.

Нет, а должны?

Да нет, просто надо не забывать включать эту стоимость в расходы на свое решение.

но попробую ответить — вы можете сразу строить аналоги «alexa skills»

Мне не нужно строить аналоги, мне нужно, чтобы существующие работали. Чтобы далеко не ходить, вот стоит у меня на кухне Anova Precision Cooker, который прекрасно работает через Google Home и Alexa. Что мне нужно сделать, чтобы все то же самое заработало из моей самописной умной колонки? Или, допустим, я хочу, чтобы моя умная колонка понимала команды, связанные с моей учеткой в Google Music (типа "play radio Wood Works") — как это сделать?

Построить диалоговый интерфейс — (сравнительно) несложно. Сложно сделать небессмысленную интеграцию.

отличный прогресс, вы не находите?

Нахожу.

Что мне нужно сделать, чтобы все то же самое заработало из моей самописной умной колонки?

лишь сделать так, чтоб эта умная колонка работала с сервисами Alexa (ну или гуглхоум). Дальше Alexa сама все сделает, так же как и если бы команда поступила от Echo.

лишь сделать так, чтоб эта умная колонка работала с сервисами Alexa

Что противоречит предложению выше по треду использовать сервисы ASR/NLU без использования Алексы.

Колонка, работающая с сервисами Алексы, обязана соответствовать требованиям этих сервисов, а это не то, чего бы хотелось параноику, который заглушает микрофон на колонке белым шумом.

Нету их нигде, понятное дело.

ну значит и профита нет

Ну вот и я говорю, что профита нет.

значить нужно лишь не быть параноиком и считать что никому твои данные не сдались

А вот тогда можно просто купить Echo и не страдать фигней. О чем и была речь изначально.

считать что никому твои данные не сдались.

Вы забываете про фактор времени.

Вчера школьные фотографии Вовочки действительно никому нафиг не сдавались. А вот сегодня...

А теперь представьте, что к некоторому Васечке через 20 лет подходят добрые дяденьки с нерусским выговором, показывают ему пачку фотографий с корпоратива 25-летней давности, на которых он спит спокойно с лицом в торте, и вежливо интересуются, что он готов сделать, чтобы эти фотографии не попали в руки его противников по избирательной компании на некий государственный пост.

программный «грибок», который будет пропускать через себя стрим с микрофонов только в определенных случаях

Ну, Вы как хотите, а я себе буду делать только хардкор, только аппаратный выключатель, разрывающий пасть льву цепь.

Чукча неКстати, интересный вопрос — а не обвалит ли десяток часов белого шума амазоновские сервера?Неа, не обвалит. Почему бы?

Для кого ключевой продукт "сервис"? Для Амазона? Я бы не был так уверен. На железках проще зарабатывать.

Вопрос в том, насколько эти копеечки окупают сервис — особенно учитывая, что подписочные сервисы (типа Prime Video) прекрасно работают и без алексы.

Стотыщмиллионов копеечек лучше, чем миллион долларов.

Только если эти копеечки есть.

nafikovr

вчера в 17:42

0 а что, стороннее приложение не может отправлять запросы той же алексе?

lair

вчера в 18:07

Насколько я знаю — нет, не может.

Ну как это не может?

Мы давным давно встроили Алексу в мессенджер, даже статья об этом на Хабре есть:

Управляем сотнями разных устройств умного дома голосом и текстом со смартфона. Alexa Echo в мессенджере

Ну значит, я был не прав. Три вопроса, тем не менее:

- Вы интегрируетесь с Alexa Voice Service, или каким-то другим сервисом?

- Вы действительно можете вести диалог с Alexa текстом, а не голосом?

- Есть ли у вас письменное разрешение от Амазона на распространение вашего "мессенджера с Alexa" на территории России?

1. Вы интегрируетесь с Alexa Voice Service, или каким-то другим сервисом?

Конечно, напрямую с AVS, ведь он изначально открыт и бесплатен для разработчиков. Амазон поощряет, постоянно проводит вебинары…

2. Вы действительно можете вести диалог с Alexa текстом, а не голосом?

Да, конечно.

Вы и сами можете убедится с этом скачав и установив наш мессенджер.

А в вышеупомянутой статье написано как делается текст.

Сейчас поддержка Алексы только на Андроиде и iOS, десктопы еще не сделали.

Мы кстати и Алису обучили всем навыкам Алексы — вот статья об этом:

От лампочки до пылесоса и дрона — как мы научили Алису управлять сотнями устройств

3. Есть ли у вас письменное разрешение от Амазона на распространение вашего «мессенджера с Alexa» на территории России?

Да, конечно, за подписью самого Безоса. Показать?

А в вышеупомянутой статье написано как делается текст.

Я вот пошел и прочитал эту статью третий раз, но так и не нашел в ней рассказа про то, как это делается — только скриншоты интерфейса, и даже с этой оговоркой там есть только "часто вызываемые команды", а не полноценный диалог.

С помощью какого API AVS вы делали текстовый диалог с пользователем?

Мы кстати и Алису обучили всем навыкам Алексы — вот статья об этом:

Ссылка ведет на список ваших статей, а не на конкретную статью. И здесь мне тоже интересно, как вы программно вызываете Alexa Skills, учитывая что Skill Messaging API требует поддержки со стороны скила.

Да, конечно, за подписью самого Безоса. Показать?

Да, пожалуйста.

А в вышеупомянутой статье написано как делается текст.

Я вот пошел и прочитал эту статью третий раз, но так и не нашел в ней рассказа про то, как это делается — только скриншоты интерфейса, и даже с этой оговоркой там есть только «часто вызываемые команды», а не полноценный диалог.

Там просто в том же окне набираете команду для алексы и все.

Как объяснить, я даже не знаю…

Вот вы мессенджером каким-нибудь пользуетесь?

Вы пишите в определенном поле слова — верно?

Так же и здесь:

Вот там где введите поисковый запрос, туда команду надо ввести и нажать маленькую иконку микрофона справа (естественно предварительно подключив аккаунт) — мне кажется что там все предельно понятно…

А статья про Алису вот:

habr.com/ru/company/mobile_one/blog/419467

Но в самом блоге она тоже есть, почему-то неправильно ссылка присоединилась…

Так же и здесь:

А где ответы Алексы в текстовом виде? Как выглядит multi-turn interaction?

мне кажется что там все предельно понятно…

Одно непонятно (и я этот вопрос уже задавал, могу повторить): через какое API вы шлете AVS текстовые команды и получаете текстовые ответы?

А статья про Алису вот:

Таки я пошел и прочитал, и мой вопрос остался неотвеченным: как вы программно вызываете Alexa Skills?

API используется стандартный

А конкретнее? Можете показать, какой метод вы вызываете? А то я даже интерфейса подходящего найти не могу.

Именно с текстом провозились, хотя сейчас это может быть легче.

Все там есть, ищите, делайте.

Мы не опенсурс проект.

P.S. Зарекался на Хабре комменты не писать, но по Алексе не выдержал.

Результат не заставил себя ждать — минусы в комментах.

Я принципиально никому на хабре не поставил ни одного минуса, а тут даешь инфу, тебя еще и минусуют, мда…

Тут вообще вопросы у товарищей такого плана:

— Дайте воды попить, а то так жрать хочется что переночевать негде…

Это же вы и ставите, lair?

Больше-то некому, эту статью уже никто не читает.

Что за народ…

lair, забудте про все что я тут говорил, пусть будет по вашему:

вчера в 18:07

Насколько я знаю — нет, не может.

В вашей системе координат не может, да и не нужно вам оно…

Я не прошу ваш код, я прошу ссылку на метод в публичной документации. Не хотите давать ссылку — верить вашему утверждению, что такая интеграция легкодоступна и стандартна, я не буду, особенно учитывая, что это противоречит моим собственным изысканиям.

а тут даешь инфу

В том-то и дело, что вы не даете инфы, только обтекаемые фразы "мы сделали".

Вы сказали фигню — я вас поправил и указал на рабочий пример, на этом все.

Вы начали нести бредятину насчет писем на разрешения (как вы вообще до этого додумались, а?) а закончили тем что стали в позу обженного, потому что я не ткнул вам ссылкой в одно место.

С каких дел я вам должен что-то доказывать?

У нас есть рабочий продукт, который вам западло посмотреть, вы тут выпендирваетесь по полной программе, и думаете что я поведусь на такой стиль общения?

Спрошу с таким же подколом, как и вы — если вы сами в открытой документации не можете ничего найти, то может быть вы просто такой специалист?

Вы сказали фигню — я вас поправил и указал на рабочий пример, на этом все.

"Рабочий пример" как слать в алексу голос обсудили еще до вашего прихода; ваше решение интересно только заявкой "мы шлем в алексу текст/запускаем в алексе скиллы"… которую вы непонятно, каким святым духом делаете.

Вы начали нести бредятину насчет писем на разрешения (как вы вообще до этого додумались, а?)

ToS прочитал внимательно.

С каких дел я вам должен что-то доказывать?

Не должны. Но и верить вашим утверждениям, что это возможно, я тоже не должен.

У нас есть рабочий продукт, который вам западло посмотреть

Дайте инстанс, которым можно воспользоваться без регистрации в вашей системе — тогда и посмотрим.

Спрошу с таким же подколом, как и вы — если вы сами в открытой документации не можете ничего найти, то может быть вы просто такой специалист?

… или там этого просто нет. Учитывая количество публично доступных вопросов "как это сделать" с ответом "возьмите TTS" я склоняюсь к варианту "этого там нет, так сделать нельзя" (а у вас — TTS).

Вы сказали фигню — я вас поправил и указал на рабочий пример, на этом все.

«Рабочий пример» как слать в алексу голос обсудили еще до вашего прихода;

О, господи, вы еще и факты перевираете.

Вы сказали буквально следующее:

«nafikovr

yesterday at 05:42 PM

0

а что, стороннее приложение не может отправлять запросы той же алексе?

Reply

lair

yesterday at 06:07 PM

–1

Насколько я знаю — нет, не может.

Т.е. вы вообще не в теме того что любой производитель железа или софта может слать запросы Алексе.

Тут, понимаете на Алиэкспрессе не найдешь китайских лампочек от любого нонейма, которые не умеют в Алексу, а у вас — не может.

Не должны. Но и верить вашим утверждениям, что это возможно, я тоже не должен.

Какие утверждения?

Это у нас работает с 2017 года уже.

Но вы можете не верить, видимо у вас своя реальность, в которой мы не существуем.

Живите в этой реальности и дальше, вы видимо непробиваемый.

И к тому-же меркантильный и мелочный- ставите втихаря мне минусы.

Я вам ставить их точно не буду, не беспокойтесь, но и общение прекращаю.

О, господи, вы еще и факты перевираете.

O'RLY?

lair 17.01 18:07 Насколько я знаю — нет, не может.

lair 17.01 20:46 Вы шлете туда голос.

Mobile1 18.01 06:53 Ну как это не может?

Более того, я еще и вам прямо написал:

lair 18.01 08:51 Ну значит, я был не прав

.

Тут, понимаете на Алиэкспрессе не найдешь китайских лампочек от любого нонейма, которые не умеют в Алексу,

Вы точно не путаете AVS Device/Product и Alexa Connected Devices?

Это у нас работает с 2017 года уже.

Вопрос, собственно, в том, какое "это" у вас работает. Отправка голоса? Ну да, я еще вчера признал, что так можно. Отправка текста?.. Прямой вызов скиллов?..

а почему до сих пор нет опенсорсного проекта по созданию говорящей колонки? да и зачем колонка? лучше сразу ПК!

я бы не против, что бы мой пк мог озвучивать тексты нормальным и приятным! русским! голосом… мог по моей команде открыть и поставить на воспроизведение выбранный мной фаил… наконец просто запустить консоль и печатать в ней озвученные мной команды и ставить их на выполнение. прогу можно было бы сделать модульной — и каждый мог подобрать нужные для него функционал.

но увы мы этого никогда не увидим. а всё потому, что мало зоопарка линексов и браузеров — нужно соорудить очередной велосипед. нет чтобы сосредоточится на действительно нужном проекте. даже досих пор не имеем опенсорсной видухи или проца который не уступал бы именитым брендам, а чтобы превосходил их… но увы, мечты, мечты.

А еще существует такой проект openassistant.org

Для установки понадобятся: одноплатный компьютер с операционной системой Raspbian, достаточно Raspberry Pi A+;Люди эту хрень в космос запускают, а тут надо пошуметь в динамики да определить ключевое слово. Мало того, что из пушки по воробьям, так ещё и стоимость компонентов сравнима с Echo.

У Амазона такой подход сразу был — все, что имеет микрофон и спикер, может быть превращено в Алексу.

И вот там можно играться микрофонами и с ключевыми словами.

Поэтому полноценную Алексу -колонку можно легко делать и на Ардуино и на raspberry — никто этого не запрещает, таких реализаций вагон.

И вот там можно играться микрофонами и с ключевыми словами.

"you will not use or allow the use of any wake word or other trigger word as part of accessing the Alexa Service in your AVS Products other than the wake or trigger words authorized by Amazon (currently "Alexa");"

https://developer.amazon.com/support/legal/alexa/alexa-voice-service/terms-and-agreements

Взлом Amazon Echo и Google HomeВзлом? Где взлом? Это что, неудачный перевод заголовка?

Ожидал реальный взлом, что-то вроде получение рута или админки и отключения следилок, а тут…

Смартфоны — это уже набившая оскомину тема.

СмартТВ тоже подозреваем в шпионаже.

Недавняя история с аппаратными закладками, опять же.

Теперь вот с ассистентами тоже самое.

Одному мне это кажется странным? Сами испугались того, что напридумывали?

Мы-потребители, хотим удобных фишек предлагаемых новыми технологиями, но не хотим платить за это приватность.

Они-производители, хотят зарабатывать как можно больше денег, и не хотят ограничиваться только продажами железа, которые приносят куда меньше дохода, чем личные данные.

И вот начинается игра в перетягивание каната с заклеиванием камеры и подсовыванием трекинг кук.

Взлом Amazon Echo и Google Home для защиты приватности