Секреты LLM по API: динамическая анонимизация данных для российского бизнеса

Привет, Хабр! На связи Мария Старцева и Катерина Пославская из команды R&D в Just AI.

Один из наиболее востребованных запросов бизнеса сегодня — LLM должна крутиться локально (on-premise). При этом именно проприетарные LLM модели чаще всего демонстрируют SOTA качество для большинства задач. И вот заказчик сталкивается с дилеммой: либо внедрять топовые инструменты, либо рисковать безопасностью, выпуская информацию из контура организации.

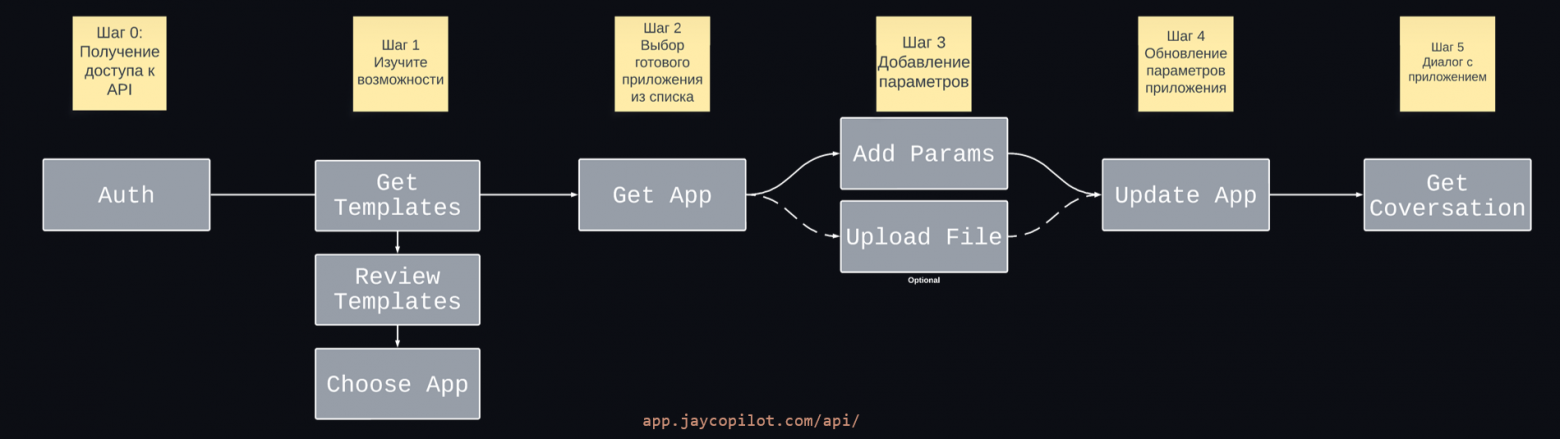

Как обеспечить сотрудникам доступ к мощным внешним LLM-сервисам и при этом не допустить утечки конфиденциальной информации? В этой статье мы расскажем про Jay Guard – шлюз безопасности для работы с LLM: как работает это решение, и что находится под капотом.