Более эффективное предварительное обучение NLP моделей с ELECTRA

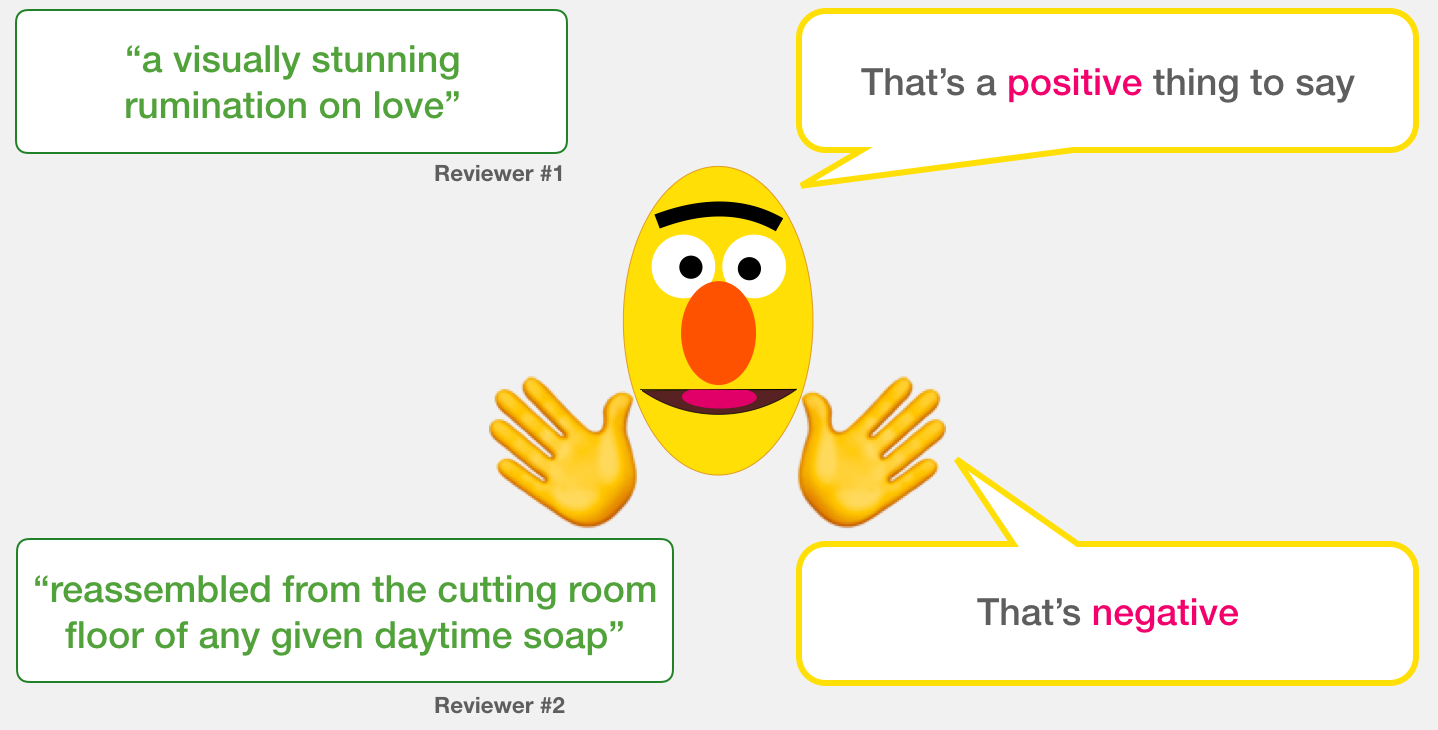

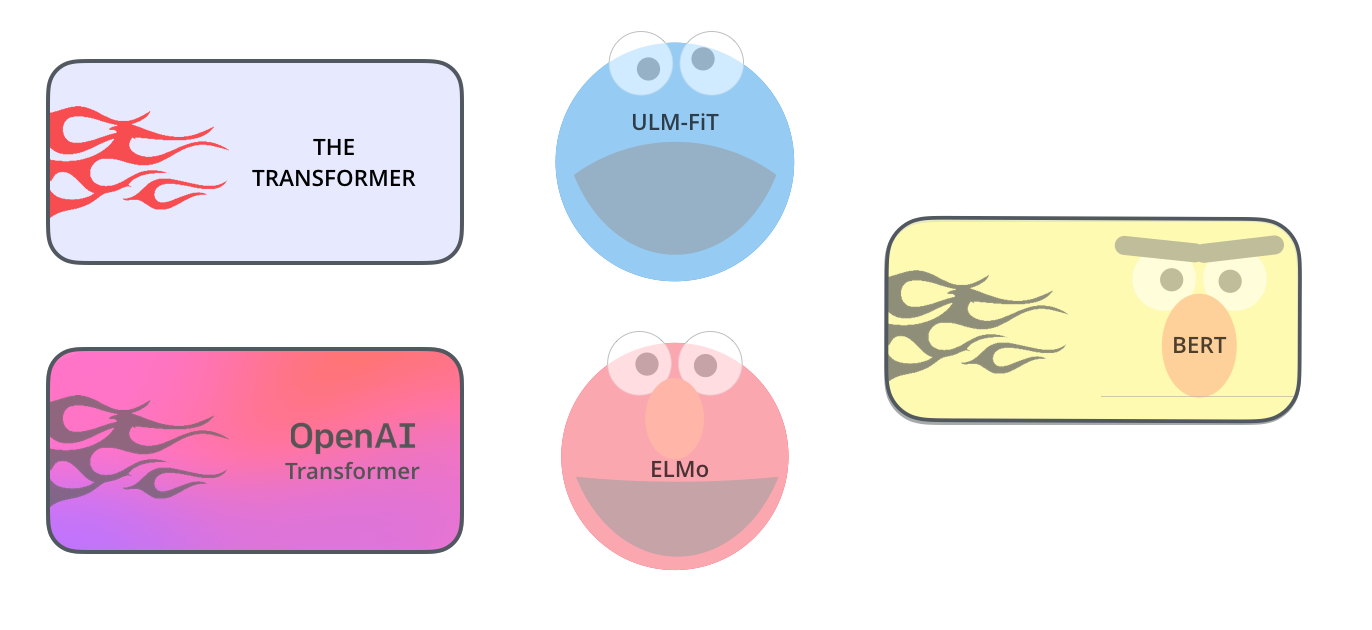

Последние разработки в области предварительного обучения языковых моделей привели к значительным успехам в сфере обработки естественного языка (Natural Language Processing, NLP), породив такие высокоэффективные модели, как BERT, RoBERTa, XLNet, ALBERT, T5 и многие другие. Эти методы, имеющие различную архитектуру, тем не менее, объединяет идея использования больших объемов неразмеченных текстовых данных для создания общей модели понимания естественного языка, которая затем дообучается и тонко настраивается для решения конкретных прикладных задач, вроде анализа тональности или построения вопросно-ответных систем.