В чем отличие маршрута пакета от его пути?

Стандартный механизм маршрутизации пакетов в интернете — per hop behavior — то есть каждый узел в сети принимает решение куда ему отправить пакет на основе информации, полученной от протоколов динамической маршрутизации и статически указанных администраторами маршрутов.

Маршрут — это интерфейс, в который нам надо послать пакет для достижения какого то узла назначения и адрес следующего маршрутизатора (next-hop):

R1#sh ip rou | i 40.

40.0.0.0/8 is variably subnetted, 2 subnets, 2 masks

O 40.0.0.0/31 [110/3] via 20.0.0.0, 00:01:54, FastEthernet0/0

O 40.1.1.1/32 [110/4] via 20.0.0.0, 00:00:05, FastEthernet0/0

Что такое путь? Путь — это список узлов, через которые прошел (пройдет) пакет:

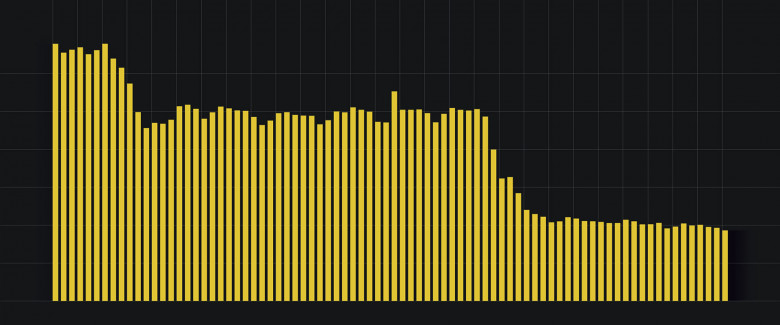

1 10.0.0.1 16.616 ms 16.270 ms 15.929 ms

2 20.0.0.0 15.678 ms 15.157 ms 15.071 ms

3 30.0.0.1 26.423 ms 26.081 ms 26.744 ms

4 40.0.0.0 48.979 ms 48.674 ms 48.384 ms

5 100.0.0.2 58.707 ms 58.773 ms 58.536 ms

Путь пакета можно посмотреть с помощью утилит tracert в OC Windows и traceroute в GNU/Linux и Unix-подобных системах. (другие команды, типа tracepath мы не рассматриваем).

Многие считают что этих утилит один и тот же принцип работы, но это не так. Давайте разберемся.