Когда твоя работа — создавать что-то красивое, о ней можно особенно не рассказывать, потому что результат у всех перед глазами. А вот если ты стираешь надписи с заборов, твою работу никто не замечает, пока заборы выглядят прилично или пока ты не сотрёшь что-нибудь не то.

Любой сервис, где можно оставить комментарий, отзыв, отправить сообщение или загрузить картинки, рано или поздно сталкивается с проблемой спама, мошенничества и нецензурщины. Этого не избежать, но с этим нужно бороться.

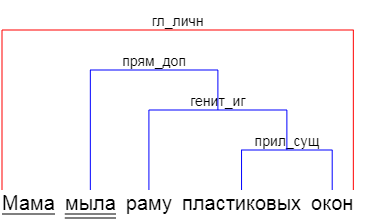

Меня зовут Михаил, я работаю в команде Антиспама, которая защищает пользователей сервисов Яндекса от подобных проблем. Наша работа редко бывает заметна (и хорошо!), поэтому сегодня я расскажу о ней подробнее. Вы узнаете, в каких случаях бесполезна модерация и почему точность — не единственный показатель её эффективности. А ещё мы поговорим о мате на примере кошек и собак и о том, почему иногда полезно «мыслить как матерщинник».