Привет, меня зовут Ирина Барская, и я руководитель службы аналитики и исследований в Яндексе. А это значит, что я и моя команда каждый день думаем, как оценивать качество работы генеративных моделей, какие при этом смотреть метрики, как вообще понять, хорошая ли модель у нас получилась.

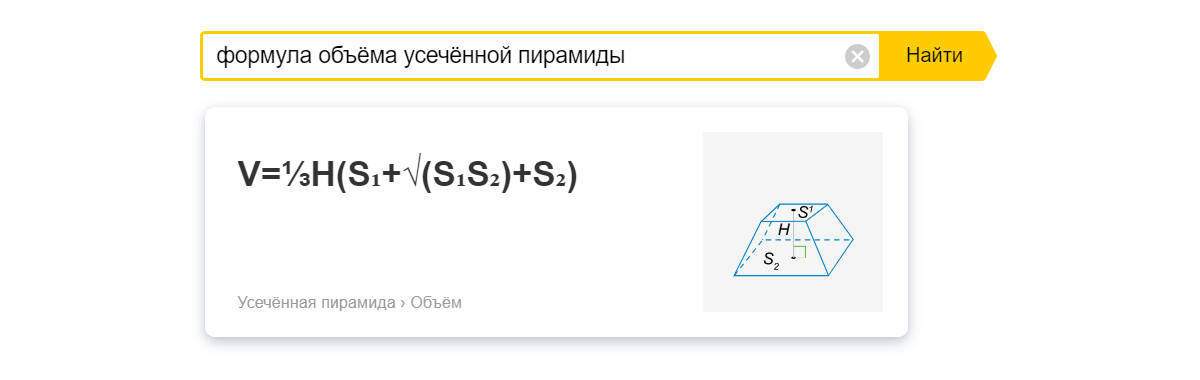

Когда возникает вопрос о том, как измерить «ум» модели, первое, что приходит в голову, — протестировать её так же, как человека: с помощью школьных российских или американских тестов или специализированных профессиональных экзаменов. Так в мире LLM появилось немало бенчмарков: берём вопросы из определённой области с вариантами ответа, модель проходит тест, получаем быстрый автоматический вердикт и таким образом понимаем, насколько умная перед нами модель.

В этой статье предлагаю найти ответ на вопрос: есть ли универсальный метод оценки работы LLM‑моделей? Для этого я расскажу, какие для этого существуют бенчмарки и почему нельзя полагаться только на них, как работает Chatbot Arena LLM Leaderboard, кто такие AI‑тренеры и может ли одна модель правильно оценить другую.