Comments 13

решает проблему vanishing gradients и дает тренировать сколь угодно глубокую линейную систему за одинаковое количество градиентных шагов.

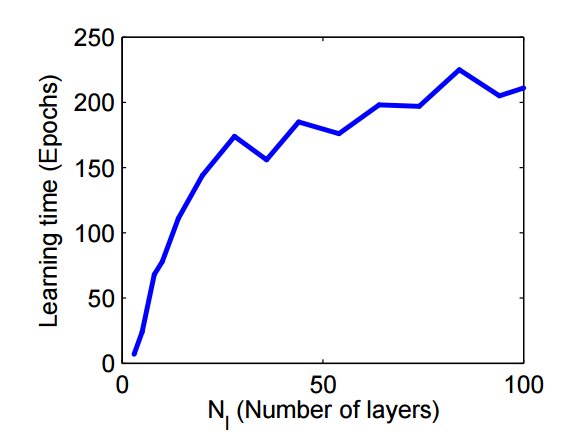

Не одинаковое, а ограниченно растущее. Это значит, что в какой-то момент увеличение числа слоев перестает увеличивать время обучения, но вот что это за момент и насколько скоро он наступает — еще вопрос. Теоретический результат хорош, но применим ли он к нелинейным сетям и к глубине сетей принятой в жизни пока не ясно.

Про второе — хм, он по-моему в докладе прямо говорил, что мол indepedent, график показывал —

Или вы прочитали статью и это все обман?

Какая-то из них врет и вот эта мне кажется гораздо более правдоподобной :)

Поправлю пост

Networks were initialized with decoupled initial conditions and starting initial mode strength u0 = 0.001…

Thus learning times in deep linear networks that start with decoupled initial conditions are only a finite

amount slower than a shallow network regardless of depth

То есть, они уже тут применяют ключевую идею статьи про decoupled initial conditions. Возможно, дальше они дополнительно сделали что-то еще и получили еще более крутые результаты, как на вашей картинке, но я пока не понял, что же именно.

Прежде всего, спасибо за обсуждение — пришлось таки прочитать статью :)

Насколько я понимаю, этот график из секции про экспериментальное подтверждение тезиса, что с ростом глубины сети время тренировки в количестве эпох выходит на константу. Она у них довольно высокая, потому что они выбрали значение главной моды маленьким, а время схождения от нее зависит квадратично.

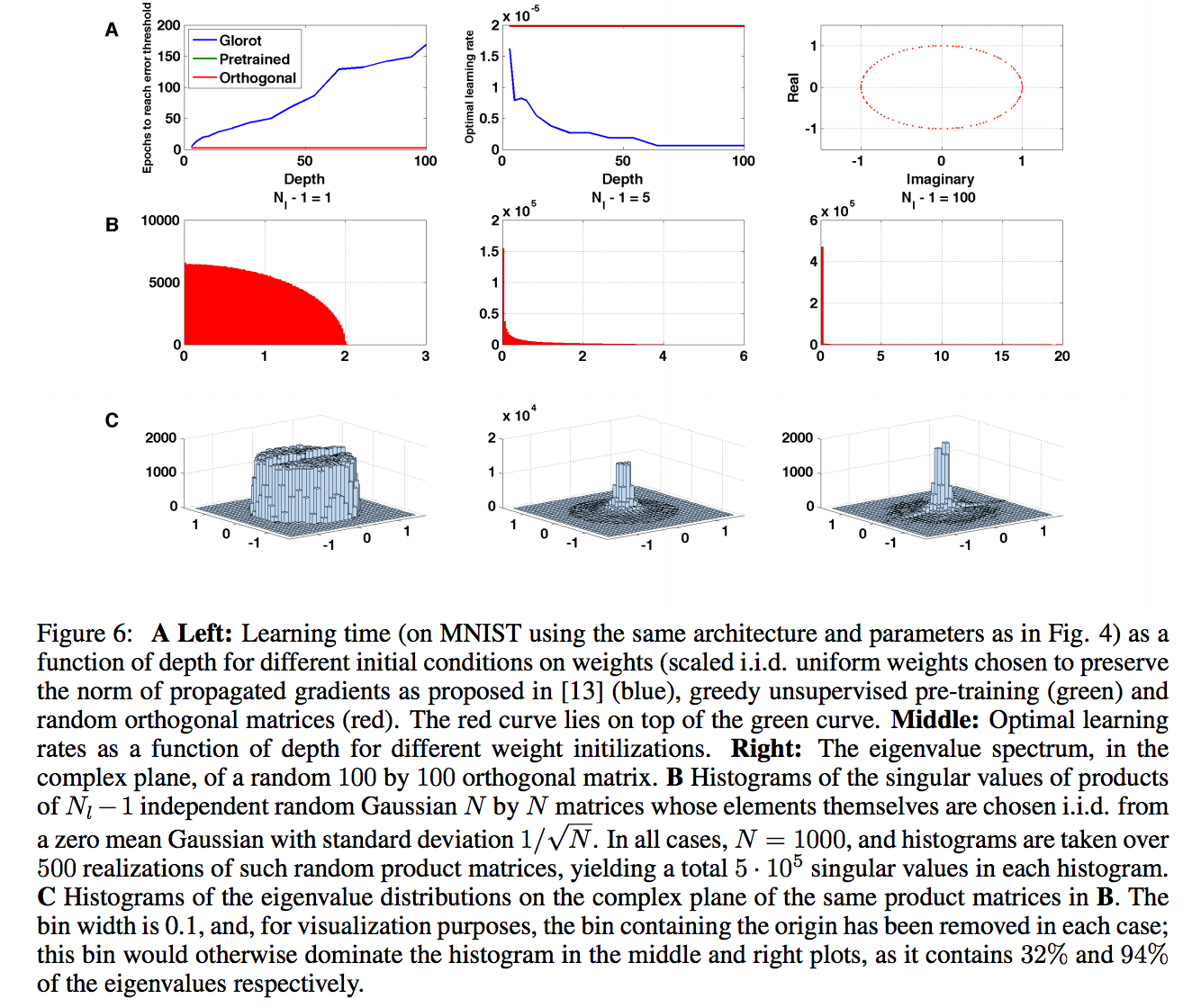

В следующей секции они сначала исследуют возможность делать unsupervised pretraining на input set, который мол получает начальные значения с модой близкой к 1, поэтому сходится гораздо быстрее. Про это у них дальше картинка:

И далее сноска:

(as a technical point: note that learning times under greedy pre-training initialization in Fig. 6A are faster than those obtained in Fig. 4 by explicitly choosing a point on the decoupled submanifold, because there

the initial mode strength was chosen to be small (u = 0.001) whereas greedy pre-training finds a composite

mode strength closer to 1)

Что видимо как раз отвечает на обсуждаемый нами вопрос.

Далее они предлагают вместо дорогой процедуры pretraining использовать тупо ортогональные матрицы для весов (что отличается от depoupled conditions, если я не путаю, потому что decoupled conditions зависят от атупута тоже), и они сходятся тоже с константой скоростью, видимо у них тоже мода хорошая.

Заметки с MBC Symposium: еще о седловых точках