Данная статья посвящена интерфейсам, а также технологиям, которые придут после тачскринов и устройств распознавания голоса.

Часы Apple Watch, которые, к слову, являются далеко не самым мощным компьютером на сегодняшний день, способны обрабатывать гигабайты данных каждую секунду. Наш мозг имеет десятки миллиардов нейронов и более четырех квадриллионов соединений, при этом количество информации, которое он способен обрабатывать ежесекундно, настолько велико, что мы даже приблизительно не сможем его оценить. Тем не менее, мостом между невероятно мощным мозгом человека и не менее быстрым миром высоких технологий 0s и 1s является не что иное, как давно уже ставшие обыденными, скромные устройства – компьютерная клавиатура и мышь.

Apple Watch в 250 раз мощнее, чем компьютер, с помощью которого лунному модулю «Аполлон» удалось осуществить посадку на поверхность Луны. По мере развития компьютеров область их применения становилась все более широкой: от компьютеризации целых зданий и вплоть до обычных компьютерных нанометров. Тем не менее, клавиатура по-прежнему остается самым надежным и широко используемым средством взаимодействия между человеком и компьютером.

Разработка первой компьютерной клавиатуры началась более чем 50 лет назад.

Уже сегодня мы можем наблюдать повсеместное внедрение компьютеров во всевозможные окружающие нас предметы, однако поскольку подключить клавиатуру и мышку к таким компьютеризированным предметам не всегда удобно, то для обеспечения взаимодействия нужно найти другие способы. На данный момент наиболее актуальным решением является взаимодействие с помощью смарт-объектов или IoT – устройств распознавания голоса. Ну что ж, давайте поближе познакомимся с теми методами взаимодействия, над которыми сегодня работают разработчики и исследовательские компании.

Достижения в области мультисенсорных технологий и взаимодействия с помощью мультисенсорных жестов сделали сенсорный экран фаворитом среди интерфейсов. Исследователи и владельцы стартапов ведут изыскания, направленные на улучшение взаимодействия с помощью касаний: так, устройства смогут определять, насколько сильно вы нажимаете на экран, какой частью вашего пальца вы делаете это, а также кто именно прикасается к устройству.

iPhone’s 3D Touch может определить силу, с которой вы прикасаетесь к экрану.

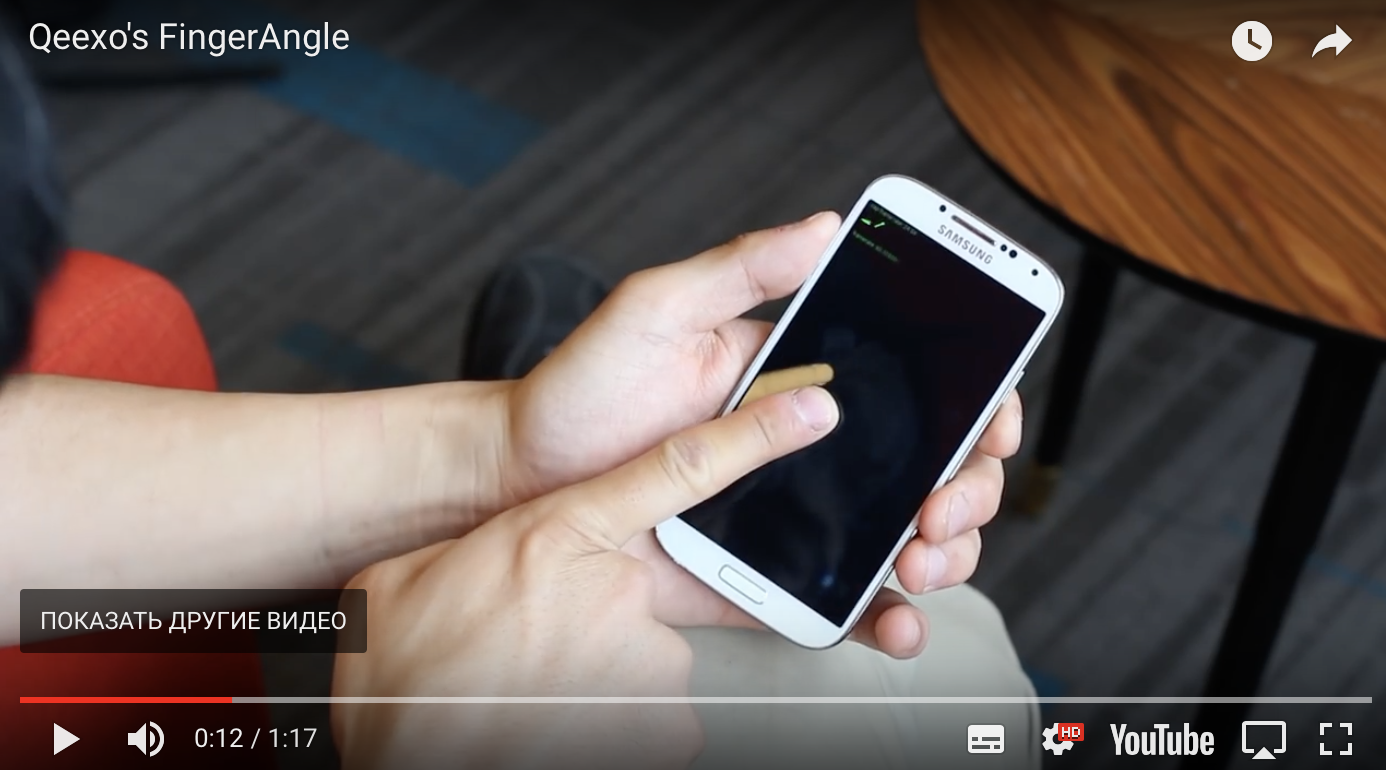

Qeexo способно понять, какой частью вашего пальца вы касаетесь экрана.

Одним из моих любимчиков является метод взаимодействия с помощью емкостных датчиков качающей частоты Swept Frequency Capacitive Sensing (SFCS), разработанный профессором Крисом Харрисоном из Университета Карнеги-Меллона.

DARPA финансировал исследования данной области еще в 70-е годы(!), однако до недавнего времени такие исследования никак не применялись в жизни. Тем не менее, благодаря технологии глубокого обучения современные устройства распознавания голоса получили достаточно широкое применение. На данный момент самая большая проблема с распознаванием голосов состоит не в их расшифровке, а скорее с восприятием и пониманием устройствами смысла передаваемого им сообщения.

Hound отлично справляется с контекстуальным распознаванием речи.

Системы отслеживания движений глаз измеряют либо направление взгляда, либо движение глаза относительно головы. Ввиду уменьшения стоимости камер и датчиков, а также с учетом всевозрастающей популярности очков виртуальной реальности, взаимодействие пользователей и компьютеров с помощью систем отслеживания движений глаз становится как никогда актуальным.

Технология Eyefluence, приобретенная Google, обеспечивает взаимодействие с виртуальной реальностью с помощью движений ваших глаз.

Компания Tobii, которая провела IPO (Initial Public Offering) в 2015 году, и производители бытовой электроники проводят совместные изыскания в области систем отслеживания движений глаз.

На мой взгляд, системы отслеживания жестов являются самыми крутыми среди систем взаимодействия человека и компьютера. Я лично проводил исследования по различным методам отслеживания жестов, и вот некоторые из используемых сегодня технологий:

Данные, поступающие от акселерометра, гироскопа и компаса (все вместе или только некоторые из них) используются для отслеживания жестов. Необходимость повторной калибровки и достаточно низкий коэффициент соответствия между входящей и получаемой информацией — вот некоторые из проблем, присущих данному методу.

Результатом исследования, проведенного группой CMU Future Interfaces Group, стала яркая классификация с использованием данных с высоким показателем частоты дискретизации.

Во многих крутых системах отслеживания жестов, которые представлены выше, используется комбинация камер с высоким разрешением, инфракрасных осветителей и инфракрасных камер. Работают такие системы следующим образом: такая система проецирует тысячи мелких точек на какой-либо предмет, при этом искажение из��еняется в зависимости от того, насколько далеко такой предмет расположен (существуют много других подобных методов, например ToF, однако вдаваться в принцип их работы я не буду). Различные варианты такой технологии используются в следующих платформах: Kinect, RealSense от Intel, Leap Motion, Tango от Google.

Leap Motion — это устройство для отслеживания жестов.

Компания Apple сделала шаг вперед навстречу внедрению подобной системы во фронтальную камеру iPhone X для FaceID.

В этом методе палец или другие части тела являются проводящим объектом, искажающим электромагнитное поле, которое создается при прикосновении антенн передатчика к объекту.

В смарт-часах от компании AuraSense для отслеживания жестов используются 1 передатчик и 4 антенны.

Радары уже давно используются для отслеживания движений различных объектов – от самолетов и до кораблей и автомобилей. Google ATAP провела буквально ювелирную работу, создав радар в виде микрочипа размером 8 на 10 мм. Этот универсальный чипсет может быть встроен в смарт-часы, телевизоры и другие устройства для того, чтобы отслеживать движения.

Проект Project Soli от Google ATAP.

Мускульно-машинный интерфейс от Thalmic Labs.

Если эти современные технологии до сих пор не ввергли вас в легких ступор, тогда давайте не будем на этом останавливаться. Все вышеперечисленные методы измеряют и обнаруживают побочный результат наших жестов.

Обработка сигналов, непосредственно поступающих из мышечных нервов – это еще один шаг вперед на пути к совершенствованию взаимодействия между человеком и компьютером.

Обработка поверхностного электромиографического сигнала (sEMG) обеспечивается путем установки датчиков на кожу бицепса/трицепса или предплечья, при этом на отслеживающее устройство подаются сигналы от различных групп мышц. За счет того, что сигнал sEMG является достаточно шумным, удается определять те или иные движения.

Thalmic Labs была одной из первых компаний, которая разработала пользовательское устройство на основе sEMG – браслет Myo.

Приобретя такой девайс, вы, конечно же, захотите носить его на запястье, однако мышцы запястья находятся достаточно глубоко, поэтому устройству будет сложно получить точный сигнал для отслеживания жестов.

Компания CTRL Labs, на так давно появившаяся на рынке, создала устройство для отслеживания жестов с помощью сигналов sEMG, которое вы можете носить на запястье. Такой девайс от CTRL Labs измеряет сигнал sEMG и обнаруживает нейронный привод, который поступает из мозга вслед за движением. Такой способ является очередным шагом на пути к эффективному взаимодействию между компьютером и мозгом человека. Благодаря технологиям этой компании вы сможете набирать сообщение на своем телефоне, засунув руки в карманы.

За прошедший год много чего произошло: DARPA инвестировала $ 65 млн в разработку нейронных интерфейсов; Илон Маск собрал 27 млн долларов для Neuralink; основатель Kernel Брайан Джонсон инвестировал в свой проект 100 млн долларов; а компания Facebook начала работу над разработкой нейрокомпьютерного интерфейса (НКИ). Существует два типа НКИ:

Устройство для электроэнцефалографии (ElectroEncephaloGraphy) получает сигналы от датчиков, установленных на коже головы.

Представьте себе микрофон, установленный над футбольным стадионом. Вы не будете знать, о чем говорит каждый присутствующий на нем человек, но по громким приветствиям и хлопкам вы можете понять, была ли достигнута цель.

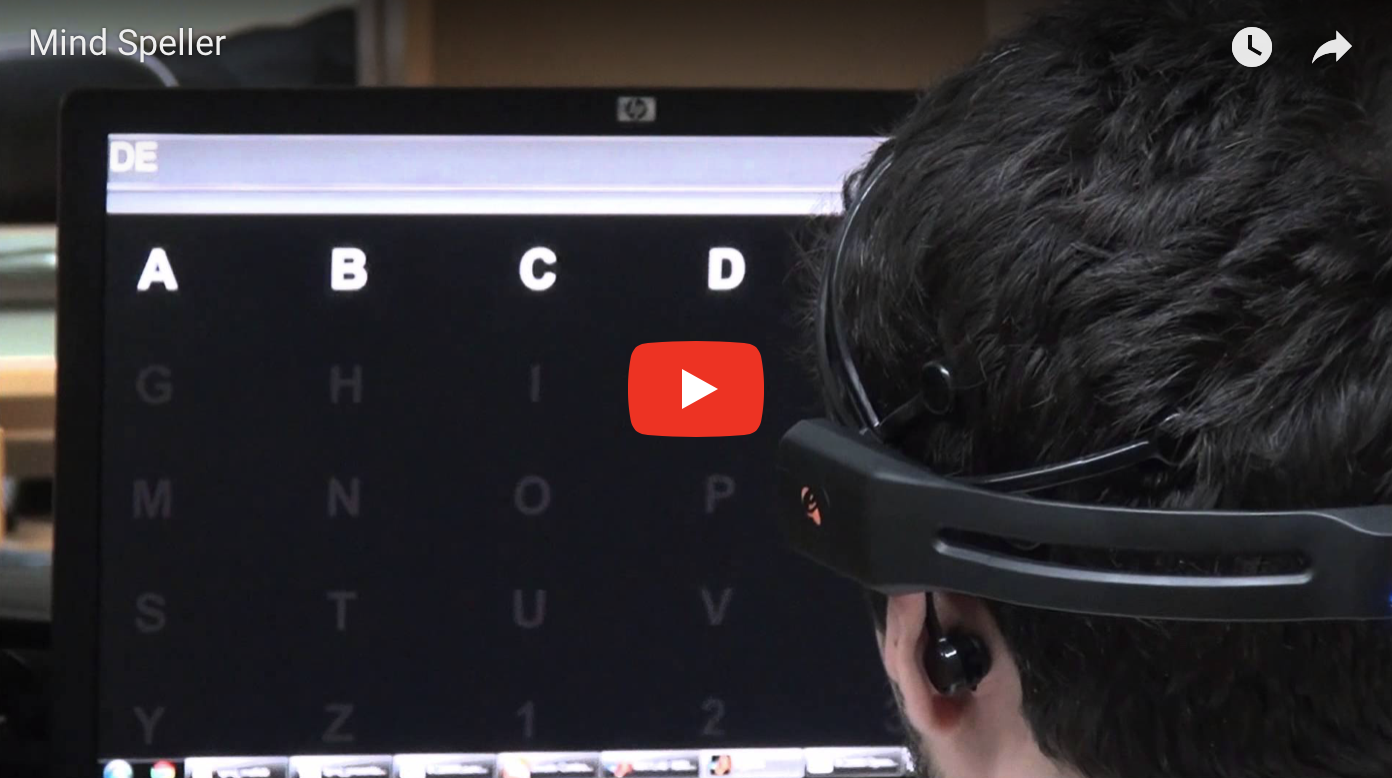

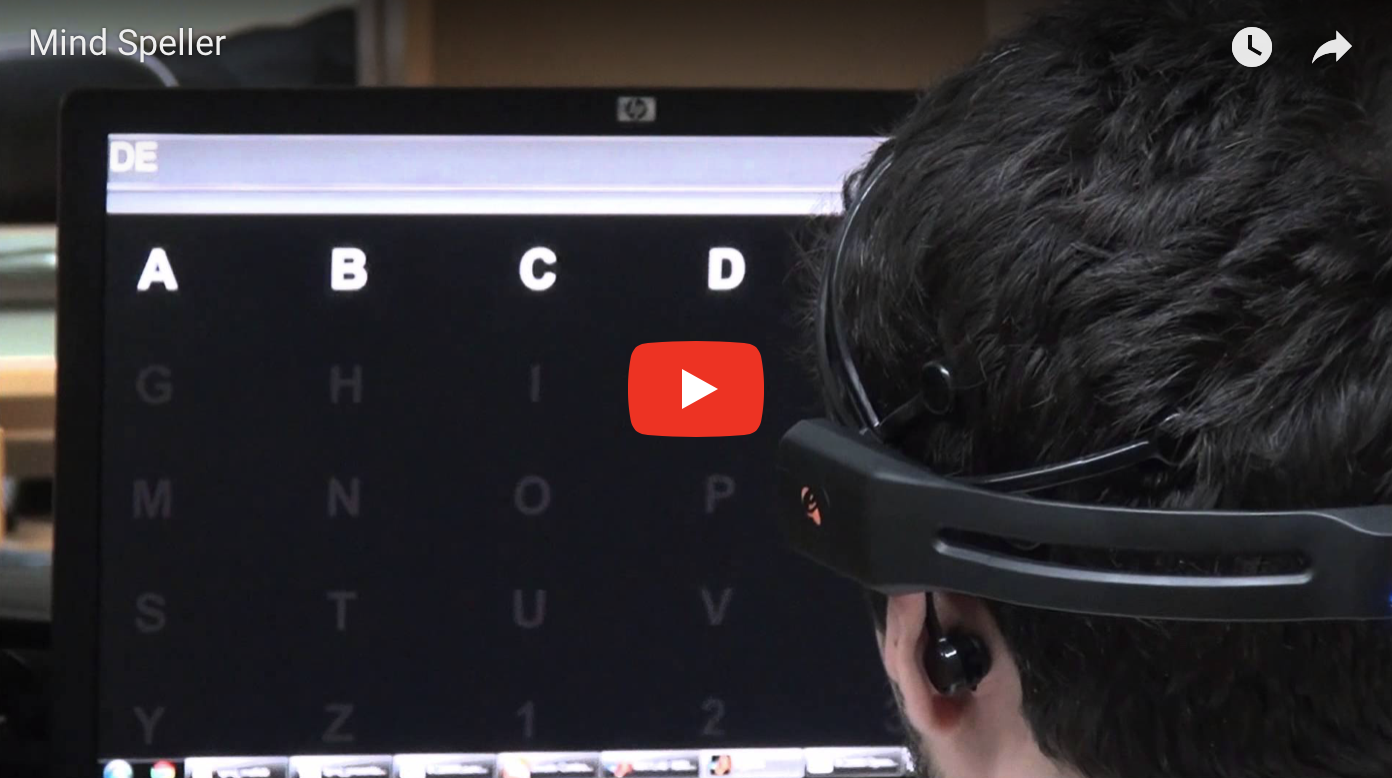

Интерфейсы на основе ElectroEncephaloGraphy (EEG) на самом деле не могут буквально читать ваши мысли. Наиболее часто используемой парадигмой НКИ является P300 Speller. Например, вы хотите набрать букву «R»; компьютер случайным образом показывает разные символы; как только вы увидите «R» на экране, ваш мозг удивляется и подает специальный сигнал. Это достаточно находчивый способ, но я бы не сказал, что компьютер «читает ваши мысли», ведь нельзя определить, что человек думает именно о букве «R», а это скорее похоже на магический трюк, который, теме не менее, работает.

Такие компании, как Emotiv, NeuroSky, Neurable и еще несколько других, разработали гарнитуры EEG для широкого рынка потребления. Building 8 от Facebook анонсировала проект по Brain Typing, который использует еще один метод определения сигналов, поступающих от мозга, который называется функциональная спектроскопия в ближней инфракрасной области (fNIRS), целью которой является отслеживание 100 слов в минуту.

Нейроинтерфейс Neurable.

На данный момент это высшая ступень в области человеко-машинного интерфейса. Взаимодействие человека и компьютера с помощью инвазивного НКИ обеспечивается за счет присоединения электродов непосредственно к мозгу человека. Однако стоит отметить, что перед сторонниками данного подхода стоит ряд нерешенных задач, которые им еще стоит решить в будущем.

Возможно, читая данную статью, вам в голову пришла мысль: мол, если уже сейчас существуют все вышеперечисленные технологии, тогда почему мы до сих пор используем клавиатуру и мышку. Однако для того чтобы новая технология, позволяющая взаимодействовать человеку и компьютеру, смогла стать товаром широкого потребления, она должна обладать некоторыми особенностями.

Вы бы использовали сенсорный экран в качестве основного интерфейса, если бы он реагировал только на 7 из 10 ваших прикосновений? Очень важно, чтобы интерфейс, который будет полностью отвечать за взаимодействие между устройством и пользователем, обладал максимально высокой точностью.

Время ожидания

Только представьте себе: вы набираете сообщение на клавиатуре, при этом слова на экране появляются только спустя 2 секунды после нажатия клавиш. Даже задержка в одну секунду очень негативно повлияет на впечатление пользователя. Человеко-машинный интерфейс с задержкой срабатывания даже в несколько сотен миллисекунд просто бесполезен.

Новый человеко-машинный интерфейс не должен подразумевать изучение пользователями множества особых жестов. Например, представьте себе, что вам бы пришлось выучить отдельный жест для каждой буквы алфавита!

Обратная связь

Звук щелчка клавиатуры, вибрация телефона, небольшой звуковой сигнал помощника голоса – все это служит своеобразным оповещением пользователя о завершении цикла обратной связи (или вызываемого им действия). Цикл обратной связи является одним из наиболее важных аспектов любого интерфейса, на который зачастую пользователи даже не обращают внимания. Наш мозг так устроен, что он ждет подтверждение того, что какое-либо действие завершилось и мы получили некоторый результат.

Одной из причин, по которой очень сложно заменить клавиатуру на любое другое устройство отслеживания жестов, является отсутствие у таких устройств возможности явно оповещать пользователя о завершившимся действии.

На данный момент исследователи уже вовсю работают над созданием тачскринов, которые смогут обеспечить тактильную обратную связь в формате 3D, благодаря чему взаимодействие с помощью сенсорных экранов должно выйти на новый уровень. Кроме того, компания Apple проделала поистине колоссальную работу в данном направлении.

Из-за всего вышеперечисленного вам может показаться, что мы так и не увидим, как что-то новое сменит клавиатуру, по крайней мере в ближайшее время. Так вот, я хочу поделиться с вами своим мыслями насчет того, какими особенностями должен обладать интерфейс будущего:

Часы Apple Watch, которые, к слову, являются далеко не самым мощным компьютером на сегодняшний день, способны обрабатывать гигабайты данных каждую секунду. Наш мозг имеет десятки миллиардов нейронов и более четырех квадриллионов соединений, при этом количество информации, которое он способен обрабатывать ежесекундно, настолько велико, что мы даже приблизительно не сможем его оценить. Тем не менее, мостом между невероятно мощным мозгом человека и не менее быстрым миром высоких технологий 0s и 1s является не что иное, как давно уже ставшие обыденными, скромные устройства – компьютерная клавиатура и мышь.

Apple Watch в 250 раз мощнее, чем компьютер, с помощью которого лунному модулю «Аполлон» удалось осуществить посадку на поверхность Луны. По мере развития компьютеров область их применения становилась все более широкой: от компьютеризации целых зданий и вплоть до обычных компьютерных нанометров. Тем не менее, клавиатура по-прежнему остается самым надежным и широко используемым средством взаимодействия между человеком и компьютером.

Разработка первой компьютерной клавиатуры началась более чем 50 лет назад.

Что придет на смену клавиатуре и мышке?

Уже сегодня мы можем наблюдать повсеместное внедрение компьютеров во всевозможные окружающие нас предметы, однако поскольку подключить клавиатуру и мышку к таким компьютеризированным предметам не всегда удобно, то для обеспечения взаимодействия нужно найти другие способы. На данный момент наиболее актуальным решением является взаимодействие с помощью смарт-объектов или IoT – устройств распознавания голоса. Ну что ж, давайте поближе познакомимся с теми методами взаимодействия, над которыми сегодня работают разработчики и исследовательские компании.

Взаимодействие с помощью касаний

Достижения в области мультисенсорных технологий и взаимодействия с помощью мультисенсорных жестов сделали сенсорный экран фаворитом среди интерфейсов. Исследователи и владельцы стартапов ведут изыскания, направленные на улучшение взаимодействия с помощью касаний: так, устройства смогут определять, насколько сильно вы нажимаете на экран, какой частью вашего пальца вы делаете это, а также кто именно прикасается к устройству.

iPhone’s 3D Touch может определить силу, с которой вы прикасаетесь к экрану.

Qeexo способно понять, какой частью вашего пальца вы касаетесь экрана.

Одним из моих любимчиков является метод взаимодействия с помощью емкостных датчиков качающей частоты Swept Frequency Capacitive Sensing (SFCS), разработанный профессором Крисом Харрисоном из Университета Карнеги-Меллона.

Взаимодействие с помощью голоса

DARPA финансировал исследования данной области еще в 70-е годы(!), однако до недавнего времени такие исследования никак не применялись в жизни. Тем не менее, благодаря технологии глубокого обучения современные устройства распознавания голоса получили достаточно широкое применение. На данный момент самая большая проблема с распознаванием голосов состоит не в их расшифровке, а скорее с восприятием и пониманием устройствами смысла передаваемого им сообщения.

Hound отлично справляется с контекстуальным распознаванием речи.

Взаимодействие с помощью глаз

Системы отслеживания движений глаз измеряют либо направление взгляда, либо движение глаза относительно головы. Ввиду уменьшения стоимости камер и датчиков, а также с учетом всевозрастающей популярности очков виртуальной реальности, взаимодействие пользователей и компьютеров с помощью систем отслеживания движений глаз становится как никогда актуальным.

Технология Eyefluence, приобретенная Google, обеспечивает взаимодействие с виртуальной реальностью с помощью движений ваших глаз.

Компания Tobii, которая провела IPO (Initial Public Offering) в 2015 году, и производители бытовой электроники проводят совместные изыскания в области систем отслеживания движений глаз.

Взаимодействие с помощью жестов

На мой взгляд, системы отслеживания жестов являются самыми крутыми среди систем взаимодействия человека и компьютера. Я лично проводил исследования по различным методам отслеживания жестов, и вот некоторые из используемых сегодня технологий:

Инерциальный измерительный блок (ИИУ)

Данные, поступающие от акселерометра, гироскопа и компаса (все вместе или только некоторые из них) используются для отслеживания жестов. Необходимость повторной калибровки и достаточно низкий коэффициент соответствия между входящей и получаемой информацией — вот некоторые из проблем, присущих данному методу.

Результатом исследования, проведенного группой CMU Future Interfaces Group, стала яркая классификация с использованием данных с высоким показателем частоты дискретизации.

Инфракрасные осветители+камеры (датчик глубины)

Во многих крутых системах отслеживания жестов, которые представлены выше, используется комбинация камер с высоким разрешением, инфракрасных осветителей и инфракрасных камер. Работают такие системы следующим образом: такая система проецирует тысячи мелких точек на какой-либо предмет, при этом искажение из��еняется в зависимости от того, насколько далеко такой предмет расположен (существуют много других подобных методов, например ToF, однако вдаваться в принцип их работы я не буду). Различные варианты такой технологии используются в следующих платформах: Kinect, RealSense от Intel, Leap Motion, Tango от Google.

Leap Motion — это устройство для отслеживания жестов.

Компания Apple сделала шаг вперед навстречу внедрению подобной системы во фронтальную камеру iPhone X для FaceID.

Электромагнитное поле

В этом методе палец или другие части тела являются проводящим объектом, искажающим электромагнитное поле, которое создается при прикосновении антенн передатчика к объекту.

В смарт-часах от компании AuraSense для отслеживания жестов используются 1 передатчик и 4 антенны.

Радары

Радары уже давно используются для отслеживания движений различных объектов – от самолетов и до кораблей и автомобилей. Google ATAP провела буквально ювелирную работу, создав радар в виде микрочипа размером 8 на 10 мм. Этот универсальный чипсет может быть встроен в смарт-часы, телевизоры и другие устройства для того, чтобы отслеживать движения.

Проект Project Soli от Google ATAP.

Мускульно-машинный интерфейс от Thalmic Labs.

Биосигналы

Если эти современные технологии до сих пор не ввергли вас в легких ступор, тогда давайте не будем на этом останавливаться. Все вышеперечисленные методы измеряют и обнаруживают побочный результат наших жестов.

Обработка сигналов, непосредственно поступающих из мышечных нервов – это еще один шаг вперед на пути к совершенствованию взаимодействия между человеком и компьютером.

Обработка поверхностного электромиографического сигнала (sEMG) обеспечивается путем установки датчиков на кожу бицепса/трицепса или предплечья, при этом на отслеживающее устройство подаются сигналы от различных групп мышц. За счет того, что сигнал sEMG является достаточно шумным, удается определять те или иные движения.

Thalmic Labs была одной из первых компаний, которая разработала пользовательское устройство на основе sEMG – браслет Myo.

Приобретя такой девайс, вы, конечно же, захотите носить его на запястье, однако мышцы запястья находятся достаточно глубоко, поэтому устройству будет сложно получить точный сигнал для отслеживания жестов.

Компания CTRL Labs, на так давно появившаяся на рынке, создала устройство для отслеживания жестов с помощью сигналов sEMG, которое вы можете носить на запястье. Такой девайс от CTRL Labs измеряет сигнал sEMG и обнаруживает нейронный привод, который поступает из мозга вслед за движением. Такой способ является очередным шагом на пути к эффективному взаимодействию между компьютером и мозгом человека. Благодаря технологиям этой компании вы сможете набирать сообщение на своем телефоне, засунув руки в карманы.

Нейрокомпьютерный интерфейс

За прошедший год много чего произошло: DARPA инвестировала $ 65 млн в разработку нейронных интерфейсов; Илон Маск собрал 27 млн долларов для Neuralink; основатель Kernel Брайан Джонсон инвестировал в свой проект 100 млн долларов; а компания Facebook начала работу над разработкой нейрокомпьютерного интерфейса (НКИ). Существует два типа НКИ:

Неинвазивный НКИ

Устройство для электроэнцефалографии (ElectroEncephaloGraphy) получает сигналы от датчиков, установленных на коже головы.

Представьте себе микрофон, установленный над футбольным стадионом. Вы не будете знать, о чем говорит каждый присутствующий на нем человек, но по громким приветствиям и хлопкам вы можете понять, была ли достигнута цель.

Интерфейсы на основе ElectroEncephaloGraphy (EEG) на самом деле не могут буквально читать ваши мысли. Наиболее часто используемой парадигмой НКИ является P300 Speller. Например, вы хотите набрать букву «R»; компьютер случайным образом показывает разные символы; как только вы увидите «R» на экране, ваш мозг удивляется и подает специальный сигнал. Это достаточно находчивый способ, но я бы не сказал, что компьютер «читает ваши мысли», ведь нельзя определить, что человек думает именно о букве «R», а это скорее похоже на магический трюк, который, теме не менее, работает.

Такие компании, как Emotiv, NeuroSky, Neurable и еще несколько других, разработали гарнитуры EEG для широкого рынка потребления. Building 8 от Facebook анонсировала проект по Brain Typing, который использует еще один метод определения сигналов, поступающих от мозга, который называется функциональная спектроскопия в ближней инфракрасной области (fNIRS), целью которой является отслеживание 100 слов в минуту.

Нейроинтерфейс Neurable.

Инвазивный НКИ

На данный момент это высшая ступень в области человеко-машинного интерфейса. Взаимодействие человека и компьютера с помощью инвазивного НКИ обеспечивается за счет присоединения электродов непосредственно к мозгу человека. Однако стоит отметить, что перед сторонниками данного подхода стоит ряд нерешенных задач, которые им еще стоит решить в будущем.

Задачи, которые еще предстоит решить

Возможно, читая данную статью, вам в голову пришла мысль: мол, если уже сейчас существуют все вышеперечисленные технологии, тогда почему мы до сих пор используем клавиатуру и мышку. Однако для того чтобы новая технология, позволяющая взаимодействовать человеку и компьютеру, смогла стать товаром широкого потребления, она должна обладать некоторыми особенностями.

Точность

Вы бы использовали сенсорный экран в качестве основного интерфейса, если бы он реагировал только на 7 из 10 ваших прикосновений? Очень важно, чтобы интерфейс, который будет полностью отвечать за взаимодействие между устройством и пользователем, обладал максимально высокой точностью.

Время ожидания

Только представьте себе: вы набираете сообщение на клавиатуре, при этом слова на экране появляются только спустя 2 секунды после нажатия клавиш. Даже задержка в одну секунду очень негативно повлияет на впечатление пользователя. Человеко-машинный интерфейс с задержкой срабатывания даже в несколько сотен миллисекунд просто бесполезен.

Обучение

Новый человеко-машинный интерфейс не должен подразумевать изучение пользователями множества особых жестов. Например, представьте себе, что вам бы пришлось выучить отдельный жест для каждой буквы алфавита!

Обратная связь

Звук щелчка клавиатуры, вибрация телефона, небольшой звуковой сигнал помощника голоса – все это служит своеобразным оповещением пользователя о завершении цикла обратной связи (или вызываемого им действия). Цикл обратной связи является одним из наиболее важных аспектов любого интерфейса, на который зачастую пользователи даже не обращают внимания. Наш мозг так устроен, что он ждет подтверждение того, что какое-либо действие завершилось и мы получили некоторый результат.

Одной из причин, по которой очень сложно заменить клавиатуру на любое другое устройство отслеживания жестов, является отсутствие у таких устройств возможности явно оповещать пользователя о завершившимся действии.

На данный момент исследователи уже вовсю работают над созданием тачскринов, которые смогут обеспечить тактильную обратную связь в формате 3D, благодаря чему взаимодействие с помощью сенсорных экранов должно выйти на новый уровень. Кроме того, компания Apple проделала поистине колоссальную работу в данном направлении.

Что нас ждет в будущем

Из-за всего вышеперечисленного вам может показаться, что мы так и не увидим, как что-то новое сменит клавиатуру, по крайней мере в ближайшее время. Так вот, я хочу поделиться с вами своим мыслями насчет того, какими особенностями должен обладать интерфейс будущего:

- Мультимодальность. Мы будем использовать различные интерфейсы в разных случаях. Для ввода текста мы по-прежнему будем использовать клавиатуру; сенсорные экраны – для рисования и проектирования; устройства распознавания голоса – для взаимодействия с нашими цифровыми персональными помощниками; системы для отслеживания жестов с помощью радара – во время управления автомобилем; системы мускульно-машинного интерфейса – для игр и виртуальной реальности; а нейрокомпьютерный интерфейс – для выбора музыки, которая больше всего подходит для нашего настроения.

- Распознавание контекста. Например, вы читаете статью на своем ноутбуке о лесных пожарах в северной Калифорнии, а затем через смарт-наушники задаете вопрос виртуальному голосовому помощнику: «Насколько сильный ветер сейчас в этой области?». Так вот, виртуальный помощник должен понимать, что вы спрашиваете именно о той области, где в данный момент происходят пожары.

- Автоматичность. В��иду развития ИИ компьютер сможет лучше прогнозировать то, что вы планируете сделать, и, таким образом, вам даже не придется отдавать ему команды. Он будет знать, какую музыку включать, когда вы просыпаетесь, так что для поиска и воспроизведения любимого трека вам уже не нужен будет какой бы то ни было интерфейс.