Комментарии 246

Но он далеко не единственный и уникальный, просто другие не палятся, Спилберг например, в своё время механикам камеры мастер класс показывал ;-) хотя режиссёр и оперпост, на съёмочной площадке, камеры обычно вообще не касаются, тем более в технических аспектах.

Хорошо написано и интересно, спасибо!

Задача, на которую они замахнулись опережала и возможности техники на тот момент, и возможности алгоритмов.

Их монстры не зашли в кино именно потому, что были слишком монстрообразны, фактически они возможности продемонстрировали, а дальше на рынок реально пойдут образцы следующих поколений, которые будут в разы компактнее и работать с которыми будет технически намного проще.

Люди просто не врубаются что они только что купили, у них «разрешение хреновое и фотки мутные». В результате оценка — 2.5-3.

Но и так много букв ), про это можно будет скоро отдельные посты, как железо дозреет.

Тут была задача про пленоптику, которая давно на рынке (и незамеченная!) рассказать.

Их пугает стационарность камеры и её вес.Абсолютно так. И именно это утопило даже относительно компактные бим-сплиттеры в пользу конвертации.

Да и на сплитерах мир не сошелся, были кастомные камеры, были серийные SI-2K которые можно было поставить близко на параллельных осях, всё упиралось в объективы, но у кого были старые элитовские наборы, это не разу не проблема, тк они меньше современных.

Смысл конвертации в получении контролируемого эффекта без косяков. Буржуи быстро догнали, что объём это символ, такой-же как свет и цвет, он вовсе не обязан быть объективным и более того…

Про конвертацию — мы даже хорошо приложились к теме роста ее успешности и популярности.

Но ведь если камеры станут миниатюрными, при этом уменьшится стереобаза? Получается, прощай простое и дешевое стерео?Кто вам такое сказал? ) Важен размер объектива, и для кино в ближайшие 20 лет точно появятся камеры с одним большим глазом объектива, снимающие великолепное стерео.

Только непонятно откуда в названии технологии появилась «пленка», может опять с переводом чего-то не так и подхватили, или маркетологи ничего лучше не придумали.

А так тема знатная, еще если пойдут дальше и соединят матрицу микролинз с фотосенсором которому не нужен объектив, то будет еще копактнее и можно будет на всю ширину смартфона прилепить — и стерео нормальное снимать.

Только непонятно откуда в названии технологии появилась «пленка», может опять с переводом чего-то не так и подхватили, или маркетологи ничего лучше не придумали.от латинского plenus — полный

Камера снимает более полный (четырехмерный) кадр.

признали не перспективными из-за малого количества 3Д-контентаКачественного 3D контента, я бы добавил )

А так — проблема курицы и яйца — классика при выходе на массовый рынок многих технологий

т.к. признали не перспективными из-за малого количества 3Д-контентаИх признали малоперспективными совсем не поэтому. Внезапно выяснилось, что 3D-фильмы не становятся интереснее от того, что они 3D. В «Аватаре» в лицо зрителю кидали комья земли, в «Алисе» упоротый заяц кинул тарелкой. А дальше стало просто скучно.

У кино непростая ситуация. В условиях разгула торрента нужно сохранить сборы фильмов на уровне.

Проводили эксперименты, сравнивали большее разрешение, 48FPS и стерео. Массовый зритель выше всего оценивает стерео, а ниже всего — разрешение. НО при условии, что не болит голова. )

Я не большой фанат Питера Джексона, но на Хоббита ходил только для того, чтобы оценить HFR. И это меня так поразило, что обычные 3Д кино смотреть уже не тянет. А Хоббита я смотрел все три части, специально на другой конец Москвы ездил. Эффект погружения — невероятный, пейзажи такие — будто в большое окно смотришь, четкость и плавность — потрясающие. Потом читал, что им грим и костюмы пришлось переделывать, потому что разрешение высокое и халтура сразу вылазит.

Но я про это: en.wikipedia.org/wiki/High_frame_rate

а про СТЕРЕО на частоте 48 кадровИзвиняюсь, затупил. Да, я это и имел в виду.

Были и реально негативные отклики. То есть — технология, действительно, не всем понравилась. Но, большинство претензий было к сути, а не к форме, что дескать «слишком высокая детализация, больше похоже на тв, хочу обратно теплую и ламповую муть низкого разрешения».

Любой хороший телевизор высоких серий умеет интерполировать до 60fps в том числе и 3D.А какие при этом артефакты возникают вы видели? ) Тема называется FRC — Frame Rate Conversion. Мы ее делали для телевизоров Samsung, чипов Intel, чипов для приставок Broadcom… Когда у вас экран становится киношного размера там все то, что не видно на телевизоре обычным людям (хотя мне, например, и там режет глаз) — становится видно всем.

И наступает карачун )

Давно уже пора снимать фильмы 48/60/120fps. Олдскульные люди пускай смотрят потом в плеерах пропуском каждого второго кадра, это проще, чем заниматься интерполяцией.

Давно уже пора снимать фильмы 48/60/120fps.Просто посмотрите ссылку в посте, на который ответили в первый раз.

И какие впечатления от «трехмерности» картинки?

Вообще, это отдельная линейка шлемов специально для просмотра 3D/Video. Возможно помните, в свое время была серия шлемов Sony HMZ, 3D 720p и аппаратный декодер Dolby/DTS 7.1. Шлем на micro-oled, совсем маленькие дисплейчики, размером с монетку. Производит их массово Sony Semiconductor. Вот HMZ выходил в четырех вариациях (каждая чуть лучше другой, ТТХ почти не менялись, в основном фиксили эргономику) вплоть до 2014 года. Потом началась массовая истерия по VR и Sony на данную ветку развития забила. Хотя были практически пионерами и довольно близки к цели, в самой последней модели Sony HMZ-T3Q сделали даже поддержку хедтрекинга (выпускали ограниченным тиражем только в Японии).

У подобных шлемов FOV (угол обзора) составляет в среднем 45-60 градусов. Т.е. получается большой экран висящий в абсолютной темноте и возникает 100% иллюзия просмотра как будто в кинотеатре. Плюс, дисплеи oled и засчет их миниатюрного размера плотность пикселей задрана до запредельных высот. Если не ошибаюсь, у этого Sony HMZ плотность пикселей составляет 2097 на дюйм. Причем, дисплей меньше самого дюйма по диагонали, 0.71' inch. Для сравнения, в современных VR средние PPI (плотность пикселей) составляет всего 600. И это на «смартфонном» экране 5.5" дюймов. Поэтому и видна так называемая «сетка».

В Cinema шлемах пикселей не видно, т.к. PPI в несколько раз больше и угол обзора в два раза меньше. Т.е. даже вот этот Sony HMZ 2011 года выпуска с разрешением 1280х720 по просмотру кино с легкостью даст фору распиаренным современным Pimax'ам 8К.

Так вот. С приходом VR на Западе внезапно начался бум на 3D в Китае.

qz.com/940399/americans-are-over-3d-movies-but-hollywood-hasnt-got-the-memo

И так получилось, что Sony Semiconductor ровно к тому времени, уже в 2016 году, выпустила новые micro-oled, сделали FullHD (1920x1080).

www.sony-semicon.co.jp/products_en/micro_oled/products/index.html

Китайцы, не долго думая, на таких радостях, у себя там взяли и «перезапустили» Sony HMZ и назвали новоиспеченный девайс — QMER V1. Продавался только у них на родине, по какой-то причине (не знаю по какой) проект провалился, на данный момент бред полностью мертв. Но начало было положено…

В 2017 компания вышеназванная компания NED Optics выпустила шлем Goovis G1. Отличная комфортная эргономика, легкий вес всего 200 грамм, независимая аппаратная регулировка межзрачкового расстояния и независимая аппаратная регулировка диоптрий (от -2 до +8), т.е. люди с плохим зрением могут смотреть фильмы без каких-либо очков или контакных линз. В шлем, чтобы совсем идеально было, даже запихнули очень тихие маленькие вентиляторы, линзы не запотевают. И в комплект доложили компактный автономный пульт упарвления на Андроиде. С кнопками, встроенной батареей на несколько часов, Wi-Fi, BT, MicroSD, встроенная память, полноценный разъем USB и аппаратный выход HDMI. В общем, все чего не хватало Sony HMZ, все исправили и даже с хвостиком. Минусов было два. Один не значительный, версия андроида старовата 4.4. И второе минус существеннее, шлем поддерживал 3D в формате только Side-By-Side. Впрочем, учитывая еще большую плотность пикселей (PPI здесь уже 3147), честно сказать, даже стереопары выглядят так, что закачаешься. Ну и опять же, минус относительно блю рей 3D, для сериальчиков/фильмов и стереопар вполне хватает.

Через год появилась модель Goovis G2. Пришли на западный рынок, собирали краундфаундинг на IndieGoGo. Все тоже самое, увеличили внутреннюю память до 32Gb (против 16Gb у предыдущей модели) и добавили на пульт управления тачпад. Внезапно, тачпад. Отличное решение, можно подключиться к Wi-Fi и в шлеме свободно серфить инет. Впрочем, ОС стоит Андроид, можно и так приложений накачать (Youtube, Netflix и т.д.).

Паралельно вышли еще шлемы от производителя HiSpot. Версии H1 и последующая H2. H1, опять, стартовала только в Китае, а вот H2 уже появился на западных интернет-площадках. В нем аналогично сонивские micro-oled, но отличительной особенностью стал увеличенный FOV. Я так на глаз прикидывал, ориентировочно 65 градусов выходит. Субъективно экран воспринимается как IMAX, стандартные же Cinema шлемы воспринимаются как небольшой кинотеатр. В HiSpot H2 сделали аналогичный пульт управления, только более навороченный. Андроид 5.1 уже, плюс USB 3.0 и USB Type-C. К тому же, в этой версии андроид умел воспроизводить BD3D iso… но, шлем тоже Side-By-Side. BD3D iso лучше смотрится, чем стереопары. Так подозреваю, китайцы как-то извратились и умудрились запихнуть полный фрейм с BD3D в Half-SBS. Ну я так полагаю, а там как оно на самом деле, неизвестно.

В этом шлеме я реально прифигел еще над одной штукой, китайцы сделали очень мелкие, еле заметные програмные цифровые часы в верхнем правом углу экрана, которые каждые полчаса появляются на пару секунд во время просмотра фильма (оверлей эдакий, поверх) и также моментально исчезают (вот реально еле заметные, «поймал» их только спустя месяц использования шлема, думал что там мелькает иногда, мерещиться что ли). Но этих пару секунд хватает, чтобы успеть кинуть быстрый взгляд и понять сколько время. Вроде мелочь, но в своей простоте абсолютно гениальное решение. Можно смотреть фильм и контролировать время во внешнем мире: -Ага, 18:30… надо собираться, потом досмотрю.

Просто молодцы, супер фича.

Вопреки всем указанным выше достоинствам, HiSpot H2 получился несколько противоречевый. Есть косяки по конструктиву, эргономике и главное, не очень хорошая оптика. Сложно подстроить под себя, замыливает изображение (наследие большого FOV, при таких микро-дисплеях качественные линзы сделать технологически очень сложно, иначе весь VR давно уже на микро-дисплеях был). Но вау-эффект, в целом, несравненно крутой. Большой экран, реально огромный, действительно впечатляет. Да еще и в 3D, пусть оно и половинчатое. Неискушенному зрителю, так вообще будет чудо из чудес.

Есть еще Cinema-шлемы, коротко напишу хештеги для поиска в гугле:

Royole Moon — 1080p, интегрирован вместе с наушниками. Потестить не довелось, насчет поддержки Frame Packed не могу ничего сказать.

Avegant Glyph — этот 720p, Frame Packed, по-моему, умеет. Из спешл фич, построен на какой-то там лазерной проекции (Laser Field Technology).

CINERA Dual 2.5K — выглядит страшно (детей отвести от экрана), но говорят реально два экрана в разрешении 2.5К. Но вроде LCD, не oled.

И в конце еще про один напишу, пока вернемся к Goovis.

Goovis Pro умеет Frame Packed, Side-By-Side, Top-Bottom. Поддерживает аппаратные Blu Ray плееры, всякие игровые приставки (3D игры работают) и прочее, куда можно воткнуть HDMI, определяется как 3D TV. Интерфейс HDMI 1.4a, я думаю, про него писать не надо. По резолюшену, как и писал выше, 1920х1080 и поддержка разнообразного количества Гц присущих спецификации 1.4а (основные просто напишу):

2D 1920x1080 50/60

3D 1920x1080 23/24

3D 1280x720 50/60 (3DVision да, работает)

3D идеальное. Черный цвет — черный. Для примера, если включить видео с letterbox, то черные полосы вверху и внизу полностью сливаются с окружающей темнотой, видно только само изображение самого фильма. Субъективно воспринимается как небольшой кинотеатр, картинка ровная, не дрожит, не дребезжит, никаких косяков, присущим поляризационным активным/пассивным очкам, нет. Зрение не устает, голова не болит. Свободно и без проблем высиживаю трехчасовые фильмы без перерывов (буквально три дня назад за один заход, наконец-то, посмотрел Blade Runner 2049, 2.5 часа, в конце снял шлем, ушел курить и думать). По комфорту нареканий нет, засвет снизу практически отсутствует, можно без проблем смотреть фильмы в дневное время, будет абсолютная темнота внутри.

3D в таких шлемах все идет «в глубину», смотришь будто в портал. Никаких, так называемых, дешевых «вылетов», когда клюшкой от гольфа тыкают прямо в лицо, в них нет. 3D смотришь и глаза радуются, без вот этой вот мишуры отвлекающей. В 3D все фильмы выглядят отлично, независимо, сконвертирован он или Real 3D. Что ни включишь, все классно, все здорово.

Я тоже в декабре смотрел свежие шлемы на выставке и был впечатлен прогрессом по качеству даже по сравнению с прошлым годом. Но специализированных киношных там не было.

Вот, как я понимаю G2, www.amazon.com/Virtual-Reality-Theater-Glasses-Advanced/dp/B074DXWG12 но на картинках указан 3147ppi. Чужие картинки?

И, как я понимаю, народ только цена сдерживает. За такие деньги можно хороший проектор с экраном купить и более привычный домашний кинотеатр сделать. Но с ваших слов качество 3D выше всяких похвал, т.е. народ, который может себе позволить, просто не распробовал пока? )

Более того, есть уже выше плотность пикселей, летом Sony Semiconductor выпустила 1600х1200 в размере 0.55 inch (еще меньше), в нем 4000 ppi. Шаг межпиксельного расстояния там в единицах микрон измеряется. Но он для видео-шлемов не подходит, т.к. 1600x1200 это формат 4:3.

Касательно цены и сдерживает… по большей части про такие шлемы никто не знает, все зациклены на VR. И смотрят видео тоже в VR, а цена такая, что приходится выбирать, либо нормальный VR, либо нормальный видео-шлем. Традиционно народ хочет убить сразу двух зайцев и выбор в основном падает на VR (ну смотрят же там фильмы люди, и я тоже буду, зачем же отдельную железку покупать).

И не представляют, что происходит, когда разрешение шлема «размазывается» на большое поле зрения.

Опять же — не представляют, что оптика VR и оптика под просмотр разные и 3D эффект будет меньше.

Как-то так! )

www.youtube.com/watch?v=0KnS3aESNk0

зато в VR — эффект погруженияи плата за это — эффект укачивания и разрешение, которого пока заметно не хватает

А про альтернативу, о которой речь, мало кто знает.

разрешение быстро прогресирует

А про альтернативу, о которой речь, мало кто знает.

это не альтернатива, там нет отслеживания и контролеров.

Вся фишка VR — в эфекте присутвия, и главное это котролеры — которые позволяют взаимодейсвовать с окружением

не укачивает, совсем)))) Поскольку мы плотно занимаемся головной болью от 3D (см серию статей «Почему от 3D болит голова»), к нам ПОСТОЯННО обращаются господа, которые не могут сделать свой квест больше 10 минут — у них регулярно люди срывают шлем с головы, прекращают прохождение и нашатырь — обязательно близко в кармане у ведущего.

Не стоит преуменьшать проблему, она от этого не пропадает и большее количество народу потом скажет «Да ну нафиг».

Со стерео это уже произошло. С VR все идет ровно по тому же сценарию.

просто нужна привычка,Ну я про 3D тоже так говорил ) Собственно доказано, что одна из причина популярности 3D в Китае — они с детства показывают «вырвиглазное» стерео, от которого европеоидов выносят из зала. И вот результат! Везде 3D накрылось, а у них живее всех живых! )

Но люди, к сожалению, недостаточно сознательны, чтобы терпеть ради прогресса! )))

Как следствие — в Китае рынок стерео сохранился и устройства (в том числе VR 3D) там довольно быстро совершенствуются (одна HTC чего стоит!).

Лично меня немного насторожило число восторженных эпитетов в Вашем комментарии (нет, я Вам вполне верю, но ощущения всегда штука субъективная). Мой опыт с 3D очками Oculus Rift (хотя, видимо, по качеству изображения они проигрывают) вовсе не такой радостный; «вау-эффекта» хватило на неделю максимум, потом пришлось сдать «взад», чтобы $400 не пылились.

Касательно же упомянутого Вами гаджета — вот эта хрень — не оно (под другим именем)?

Не знаю, возможно, это из-за сравнительно низкого разрешения, хотя, вероятно, не это основной фактор.

Впрочем, подумываю повторить эксперимент и дать шлему второй шанс у меня дома…

->>>>Лично меня немного насторожило число восторженных эпитетов в Вашем комментарии (нет, я Вам вполне верю, но ощущения всегда штука субъективная)

Насчет восторженных эпитетов… да вроде так уж взахлеб прям не писал, смутили, пойду перечитывать :)

У меня аналогично был Oculus CV1, причем я его получил в первых рядах, один юнит совершал return to base из Штатов для починки и как раз ровно на лонче девайса, попросил зацепить, привезли в РФ и передали лично в руки. Их тогда в РФ по пальцам можно было пересчитать. И на работе потом появился HTC Vive, тоже долго гонял.

С Окулусом у меня наборот, остались исключительно теплые воспоминания, правда я практически все время юзал его с вот такой штукой

www.rseat.net/formula-cockpit/rs-formula-m4a-red

и там не то что «вау-эффект на недельку», а просто самый настоящий отвал башки, месяцами в Project Cars километраж наматывал. Эффект погружения невероятный. Жалко стоит такая хрень как самолет, в регионе можно квартиру купить за эти деньги. Больше для аренды аппарат. Хотя, знаю пару человек, у кого и дома такое стоит. :)

В общем, стаж в VR есть, не столь длительный по протяженности, сколько чрезвычайно яркий и насыщенный. Много разных штук перепробовал в VR, можно на несколько страниц понаписать всего, но суть, как говорится, не в этом. Какая картинка в Рифте/Вайве очень хорошо знаю. Сравнить по качеству изображения есть с чем.

Спустя год плотной и интенсивной возни с виртуальной реальностью, когда все возможное поперепробовал, CV1 был продан и откатился обратно на 3D. В «домашних условиях» мне сейчас VR абсолютно не интересен. Может что-то с гипотетической PS VR 2 на будущей Playstation изменится, единственные кто тащат VR активно.

По вашей ссылке версия Goovis G2. Давайте еще раз, коротко :)

Goovis G1 — 2x1920x1080@60Гц, с андроид пультом, на батарее, 16Gb, MicroSD, Wi-Fi, BT, USB. 2D/3D. 3D стереопары, только Half- Side-By-Side, конечное разрешение для 3D — 960x1080@60Гц.

Goovis G2 — 2x1920x1080@60Гц, с андроид пультом, на батарее, 32Gb, MicroSD, Wi-Fi, BT, USB, тачпад на пульте. 2D/3D. 3D стереопары, только Half- Side-By-Side, конечное разрешение для 3D — 960x1080@60Гц.

В нем еще, забыл написать ранее, есть поддержка хедтрекинга (можно 360 видео смотреть, по-моему). Но при ограниченном FOV 53 градуса смысла нет. Опцию прикрутили для галочки, непонятно зачем. Даже толком и не запускал никогда.

Goovis Pro — 2x1920x1080@60Гц, голый, без андроид пульта (пульт можно отдельно докупить). Есть бандл вместе с андроид медиа-приставкой Zidoo X9 (BD3D крутилка). Предыдущие модели позиционирование for Travel, этот for Home. 2D/3D. 3D для фильмов, конечное разрешение — 1920х1080@24Гц (Blu Ray 3D), 3D для игр — 720p@60Гц (NVidia 3DVision). Продается пока только в Китае и буквально на днях вышли на рынок Тайвань.

Goovis T2 VR — опытный образец для виртуальной реальности. По нему у меня никакой информации нет.

Звучит круто! Появились ли ещё более навороченные новинки за эти 3 года ?

60Hz источник сигнала поддерживают и отображают? Интерполяцию на PC для 3D сейчас можно делать на SVP (включая новомодный нейросетевой RIFE алгоритм) и DmitryRender.

В итоге, две недели мучался с виндой и сочетанием NVidia+HDMI (все еще тот старый прикол, когда по дефолту в NVidia стоит HDMI Range Limited, AMD таким не страдает) плюс нет уверенности в адекватных color profile самой Windows, т.к. про чудеса оные тоже понаслышан. Мучался-мучался, то пересвечено, то слишком темное изображение. И еще там встроенная Intel ходит рядом и посмеивается: -а у меня тоже в драйверах стоит автоконтраст и «улучшалки» видео, не забудь выключить…

Короче плюнул, перенакатил винду, чтоб с чистого листа, апнулся до версии 1809 и аккуратно обновил Nvidia дрова на последние DCH. Смог впихнуть в ноут утилиту ASUS Splendid Video Enhancement, устроил разнос виндовым color профилям, осторожно переключил HDMI Range 0-255 и все стало хорошо. Почти-почти хорошо.

В качестве BD3D софтового плеера использую JRiver Media Center + MadVR. Конфиг на i5 + 1060 6Gb позволяет более менее нормально тонко тюнить изображение. Хотя там разбираться и разбираться, все еще в стадии поиска идеального изображения. Впрочем, после всех экзекуций мне и PowerDVD выдал отличную картинку. Внезапно.

Есть другая проблема. Т.к. на всю морду лица светит здоровенный светящийся OLED (наверное, соразмерно 100" диагональ с двух метров), наблюдаю небольшой color banding. Как лечить, пока еще не знаю, если это возможно конечно. Может это фича шлема, oled'а (тоже самое наблюдал и на Goovis G2 и на HiSpot H2), какой-нибудь не той битности, не совпадения частоты с кадрами, наличие где-нибудь в недрах галочки «оптимизировать видео для быстродействия», да черт его знает что еще может быть, тысяча факторов. В играх вроде как все ок, видео иногда замечаю косяки. Может это и нормально, так и должно быть, не знаю. Нужна аппаратная железка, дабы точно убедиться в оригинальном качестве изображения. Но также, встречал мнение, что у Royole Moon вроде как такой проблемы нет, grayscale не сыпется. Непонятно мне с этим пока.

С другой стороны, сколько на тест-драйв не давал знакомым эту штуку, все в один голос говорят, что придираюсь и девайс абсолютно идеальный, лучше быть уже не может. Может и правда придираюсь. Продавал Goovis G2, так с руками оторвали, а это учитывая, что он 3D Half-SBS.

Про 3DVision.

Работает, но апскейлит 3D 720p@60Гц до 1080p. В принципе, с выкрученным на всю графонием в игре и принудительным Supersampling x4/x8 вполне прилично смотрится. Если вот конкректно только 3DVision хочется, то лучше взять Sony HMZ, там оригинальное разрешение 720p, пиксель в пиксель. Но для Sony HMZ желательно запилить кастомный Comford Mod, эргономика, конечно, плачевная у него…

В плане звука использую по настроению, либо наушники напрямую с ноута и DTS Headphone:X в качестве виртуальных 5.1, либо напрямую с самого шлема (есть выход 3.5" jack) по HDMI и тогда Dolby Atmos. Можно и дефолтный Windows Sonic for Headphones.

Как-то так, наверное. Все грядущие релизы BD3D уже отмечены в календаре с пометкой «Важно!».

item.jd.com/39909147130.html — Goovis Pro (версия Pro без андроид пульта)

www.goovis.cn/new_detail/407 — вот тут что-то написано про RGB 0-255 и YUV 0-255, но на китайском.

www.panelook.com/modelsearch.php?op=advancedsearch&order=panel_id&brand_family=124&inch_low=70&inch_high=71&resolution_pixels=8180 — спеки сонивских микро-олед. Какие точно стоят в шлеме, увы, не знаю.

И еще про один шлем хотел рассказать.

Через месяц на кикстартере стартует краудфаунд на Luci Immers. Аналогично, те же FHD очки для 3D/Video. Рассылка начинается в августе.

luci.one/immers-ks — Luci Immers

www.luci.one/immers/technology — спецификации.

У них первая особенность — интерфейс USB Type-C.

И вторая, заявлен FOV под 70 градусов. Это почти VR (VR стартует от 90 градусов и выше). Т.е экран будет ну очень большой. Здесь лишь бы с оптикой не налажали, больное место для микро-дисплеев.

Увы, пока не ясно, какие режимы 3D поддерживает. Надо ждать начало кампании, укажут или потенциальные бейкеры все с них моментально вытрясут.

В качестве постскриптума: такие очки 3D 1080p ждал 8 лет. С момента выхода Sony HMZ. Дождался. Клевые штуки, реально советую обратить внимание. О них мало кто знает, т.к. VR практически забило весь эфир. Но они существуют, как видите, и не в одном экземпляре. Китайцы, конечно, молодцы. Взяли вот и с легкой руки перезапустили линейку Sony HMZ. Причем, настолько в классном виде, что ранее даже и представить не мог: те же самые фирменные сонивские micro-oled, только уже FHD, отличная эргономика, легкие и удобные, прицепили компактный автономный пульт управления на всеядном Андроиде, тачпад, Wi-Fi, BT, USB, MicroSD, HDMI, аппаратная регулировка линз и диоптрий, и даже впихнули миниатюрные вентиляторы, чтобы линзы не запотевали.

Вот вам и китайцы, остается только восхищаться.

Вам совершенно правильно пишут, у вас УЖЕ материала на хорошую статью достаточно.

Тема совершенно нераскрыта (везде VR HMD) и даже текущий материал будет безмерно интересен.

У подобных шлемов FOV (угол обзора) составляет в среднем 45-60 градусов. Т.е. получается большой экран висящий в абсолютной темноте и возникает 100% иллюзия просмотра как будто в кинотеатре.

То есть экран не на всю область видимости?

Никаких линз Фринеля?

кнопки переключения режимов 3DКрайне интересно! Что поддерживается?

Короче плюнул, перенакатил винду, чтоб с чистого листа, апнулся до версии 1809Да-а-а-а! Это эпично!!!)

Вот вам и китайцы, остается только восхищаться.Ну у них по ряду причин интерес к 3D не падал. В итоге сейчас многие фильмы реально конвертируются в Китае, около десятка компаний (!) производит лазерные 3D проекторы и т.д. Во некоторых областях они скоро будут конкурировать в основном между собой.

наблюдаю небольшой color banding. Как лечить, пока еще не знаю, если это возможно конечно.если шлем берет больше 8 бит на компоненту (что поддерживается с HDMI 1.3) и нормально отдает на oled, то появляются шансы, там самый простой способ — зашумляются младшие биты, более сложный — изменение контента. Со вторым можно поэкспериментировать, это нам ближе ), ибо железо сегодня часто отстает.

Ну когда то люди и 16 fps были рады в начале века, и считали это реалистично и суперкруто.

Что теперь, вечно равняться на устаревшие 100 лет назад технологии ?

Люди даже отличают 120Hz от 60Hz.

Правда, не понимаю, почему мечуться между этим по отдельности, это всё сразу нужно и важно. И 3D, и HFPS (в идеале 120fps), и разрешение. Помню как смотрел Аватар в Imax Капитолий в 2010, и мне не хватало 2 из этих 3 компонентов — видел сплошные пиксели (нехватка разрешения) и стробоскоп (древние убогие 24fps).

И пипл не очень сильно различает разницу (что 2К, что 4К — все едино), поэтому владельцам залов нет большого резона обновлять оборудование на более дорогое.

Посмотрел Человека Паука в Киномакс-Titan Laser Imax 3D в Каширская Плаза, действительно лучший зал страны, построен в 2018 . Действительно, чёткость (4k), яркость и 3D намного лучше, чем существовали в Москве 10 лет назад. Даже на недостаток плавности уже не так обращал внимания, картинка реально была супер.

Не согласенНу вы не согласны, а производители телевизоров согласны.

Когда мимо взгляда пролетает 3D-бабочка — взгляд пытается на ней сконцентрироваться, но обнаруживает, что камера сфокусированна на другом — а бабочка является мутным 3D-пятном. :(

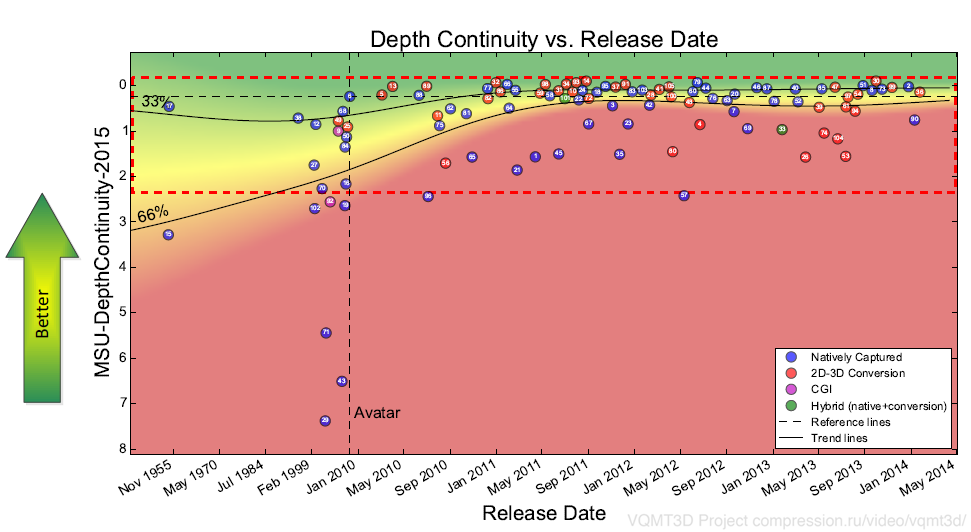

Даже если брать такие сложные параметры как плавность изменения глубины — до Аватара все было намного хуже (в первую очередь потому, что глубину менять не умели):

На графике метрика плавности изменения глубины между сценами (один из пары десятков параметров, влияющих на комфорт восприятия 3D фильма). Чем выше — тем лучше. Зеленый — 30% лучших фильмов на этот момент времени, красный — 30% худших. Аватар обозначен пунктиром. Перед ним были фильмы кардинально хуже.

И такая ситуация по большинству метрик.

Из хороших новостей — постепенно ситуация улучшается. Медленно )

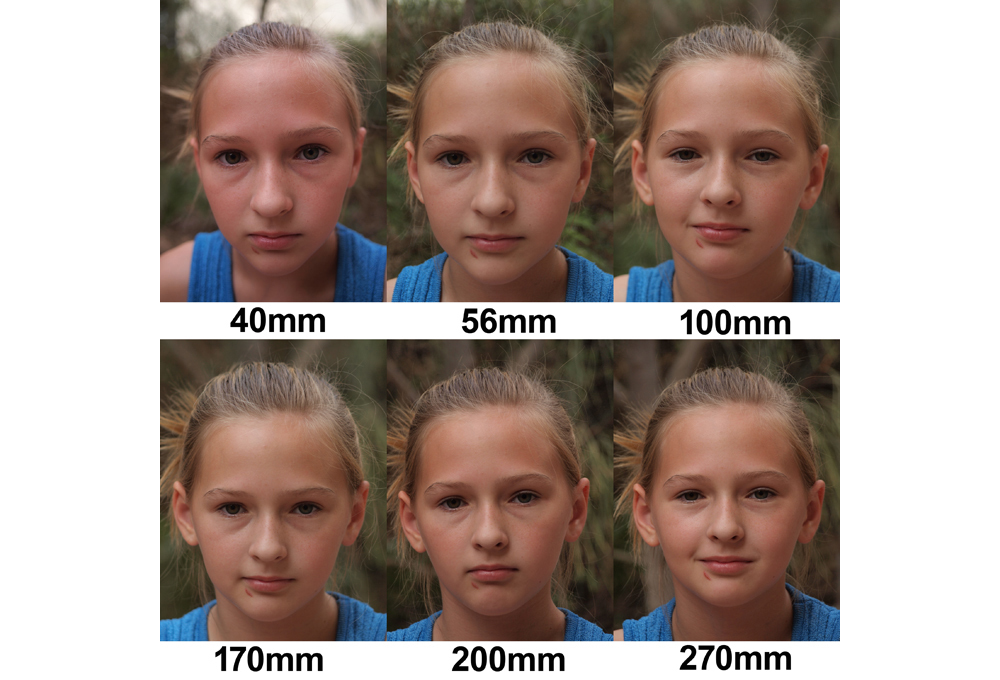

При этом для 2D управлять вниманием зрителя с помощью очень малой глубины резкости — норма (и даже красиво), а в 3D — лучше делать максимальную глубину резкости, ибо куда смотреть человек понимает исходя из трехмерности сцены.

И потенциально это еще один огромный плюс пленоптики!

Можно делать 2D и 3D версии — с разной глубиной резко изображаемого пространства!

Для текущего производства это слишком дорого.

Вот только в эти выходные всей семьёй прсмотрели обеих Алис в 3D. И жена и дочь в восторге.

Их перестали продавать не из-за контента, а из-за слишком маленькой диагонали для 3D => посредственного эффекта погружения. Для сравнения, все современные DLP-проекторы для домашних кинотеатров идут с поддержкой 3D. А контента хватает. Кроме того, сейчас тенденция перехода на 4к. А фильмов в 4к 3D UHD в продаже не встречал. Вероятно, стандарт не приняли?

В телефонах нынче стоят матрицы с размером пикселя 1-2 микрона. При этом длина волны красного света 0,7 мкм. То есть делать разрешение ещё выше — бессмысленно, т.к. мы упираемся в волновой предел. Ну и в крупный пиксель, банально напа́дает больше фотонов, чем в маленький. То есть разрешение, которое может выдать телефон при переходе на пленоптику с четырьмя пикселями наверное в лучшем случае «не ухудшится», но вряд ли улучшится.

Ну а большие девайсы для больших фильмов, возможно станут раза в 2-4 поменьше, что конечно тоже не может не радовать.

Получается, что я немного более осторожен в оценке перспектив, но возможности и правда завораживают. :) Спасибо за статью!

разрешение, которое может выдать телефон при переходе на пленоптику с четырьмя пикселями наверное в лучшем случае «не ухудшится», но вряд ли улучшитсяНо если такой телефон будет давать для ARCore в реальном времени реальную карту глубины — сенсору многое простят, ибо качество AR будет другого уровня.

А про то, как поднимать разрешение смартфонов и как это делается сейчас была прошлая подробная статья. И там далеко не все резервы (смартфонами) использованы ) И просто с ростом вычислительной мощности на борту уже можно будет улучшать результат.

… в ней есть конечно свои плюшки, но они больше в микроскопии актуальны

Будем считать, что вы в курсе, но имеете какой-то резон не палить тему пред лицем вездесущих китайцев.

Я тоже от части промолчу, однако всех практически заинтересованных техникой, математикой и маркетингом данного вопроса, милости прошу ко мне в личку, договоримся, всё что знаю расскажу, покажу, а может и присоединюсь ибо тема сия мне интересна. В прочем умников, раскуривших тему в объёме не сравнимом с литрой не так уж и мало, это-же прикольно…

Литра изначально была мёртворождённой, лишь доказав тезис что математику надо знать и любить, и против неё ну никак не попрёшь. Осознали, сделали нормальную камеру с мозаикой матриц и охладом, которым они пытаются отбиться от некоторых технических проблем сопровождающих такое решение.

Банальные алгоритмы чувствительны к шумам и нелинейностям, а не банальные я и не знаю, раскурили-ли они их, там многие проблемы автоматически решаются. Короче, камера исполин, в некоторых своих качествах не разу не эквивалента микроскопам и даже той, первой, насадке на фантом!

Ребята, серьёзно, если синема-литра так крута, то на фига ей лидар, а?

Но дело, даже не в этом, я ведь тоже кинематографист по образованию, и пообщавшись в роли консультанта с некоторыми "«пионерами» 3D" узнал от них о другой стороне монеты. Наше хорошее, честное стерео, оказалось не нужным, даже с учётом наших знаний, за которые в прочем не плохо тогда заплатили.

Дело в том, что между кино и театром, разницы бездна, и начать надо с того, что кино язык подразумевает сознательное управление точкой зрения зрителя. А эффект присутствия, погружения, для кино всего-лишь эффект, который можно получать дозировано, когда это надо, самыми различными средствами. Ну не нужно в кино переводить фокус постфактум, там каждая сцена, каждый кадр осмыслен, описан и выстроен в сознании опер.поста и режиссёра ещё до съёмки!

Постфактум был-бы интересен на ТВ, и для всяких концертов, театральных постановок итд, НО там обратная задача, как раз-таки присутствие, зритель пересматривает один и тот же концерт, замечая в нём разные детали, тут и стерео за глаза, ну можно несколько ракурсов сделать, и классно…

Короче, сочетание скоростной камер\ы с трэкером\роботом, лидаром и хромакеем, вполне решают большинство проблем современного кино продакшена, про возможность ручной\автоматизированной обработки потока я вообще промолчу. Маркетинговый посыл литры, такой-же как когда-то у меня, что мы запечатлеваем реальность, и можем чего огого… Но ответ Голливуда в том, что у нас тут волшебный мир кино, и реальность не нужен, родной ;-( Как говаривал Джордж Лукас, а у меня лазеры пшикают!

Так-что будущее кино, скорее в изучении потоков данных моушн кэпчи для синтеза идеальных актёров, а вундервафли при всей моей любви к пленооптике, есть гораздо более рациональные и продуктивные пути поиграться с ней (где патенты литры нафиг не упали)… И есть ограниченная область куда это можно продать, на ТВ-бы «пленооптика», а точнее математика из неё, очень-бы пригодилась в виде компактного, законченного решения, но опять-же с оговорками о целях и смыслах.

Ситуации, когда даже (а то и в первую очередь) профессионалы соответствующей индустрии в штыки воспринимают новые технологии — это норма. Далеко ходить не надо — я сам еще совсем недавно нейросети в обработке видео воспринимал предельно скептично (и на то были и остаются серьезные основания). Давно думаю написать про экспоненциальные процессы — это ситуации, когда подавляющее большинство специалистов неверно прогнозируют события. Примеров уйма в куче областей, от первых турбин реактивных самолетов до сопротивления электромобилям, альтенативной энергетике и нейросетям в программировании ) Это нормально! )

Литра изначально была мёртворождённой,У Лайтры полный комплект всех врожденных заболеваний стартапов Кремниевой. В первую очередь разгон финансирования вперед развития продукта. От чего, собственно, и наблюдается бешеная смертность стартапов. У Теслы проблемы того же рода и далее список длинный.

Я спокойно к этому отношусь. Свою роль они играют. А Карафин не зря ушел из Lytro почти сразу после получения ими очередного транша денег (!) )))

синема-литра так крута, то на фига ей лидар, а?Все просто. У нее же глубина из стерео. Т.е. как только текстура стала слабо выраженной (по контрасту) ошибка в определении глубины зашкаливает и начинаются проблемы. А лидар наоборот идеален для ровных поверхностей. Они очень хорошо дополняют друг-друга, особенно учитывая что лидар дает слабый FPS.

у нас тут волшебный мир кино, и реальность не нужен, роднойЭто да, так и есть ) Но спецэффекты быстро и дешево они хотят. И сейчас рентабельность фильмов в среднем падает, а рентабельность сериалов сериалов растет и в технологии ускорения спецэффектов пошло финансирование.

математика из неё, очень-бы пригодилась в виде компактного, законченного решения, но опять-же с оговорками о целях и смыслах.Да, массовый продует точно будет не в сфере кино ).

Сейчас интересная тема — промышленные роботы, но там велика конкуренция со стороны сенсоров других типов. Хотя когда что-то многоуровневое и полупрозрачное — пленоптические рулят пусть и рынок пока невелик. Это позволяет развивать сенсоры.

К обработке сырых данных с пленооптической камеры или растра камер, можно подходить по разному, на качество работы того или иного подхода сказывается качество изготовления системы в целом, ну и выбранная схема конечно. Бытовая пол-литра была в этом плане была редкостным трэшем, почему я и говорю, что она мёртворождённая, тут и простых геометрических каракулей на бумажке и школьной математики достаточно что-бы это понять. Да и прототип\дипломная работа из фантома, как-бы намекала. На что надеялся автор? Понимал ли он? Тут всё не так просто, как кажется.

Вундервафля хороша, в теории, но на практике там есть куча особенностей реализации, от оптики и железа до методов кода, что я-бы не стал строить иллюзий. Да, тут нужен, широкий технический кругозор, да… А что-бы продать продукт, тут чисто технического кругозора мало!

Трэнд к удешевлению, на лицо, я помню как люди места в очереди за первым рэдом продавали, при том, что это было редкостное… А нашествие Сапогов на ТВ продакшены, к чёрту дорогие тв камеры и реальный FullHD, да здравствует мыло в h264 ;-) Вы, точно видите мегаЛайтру в этом ряду?

Если поговорить про эффекты, то обратите внимание как в оптическом потоке камера трэчатся и моушен кэпчится, да это можно сделать круче но нафига. А ещё вместо того что бы трэчить камеру, её можно к старому, списанному, промышленному роботу прикрутить, он сильный и света потянет вписывая живых актёров в 3д декор…

ps.а с картой глубины, это смотря для чего мы её хотим, тут есть варианты, почему мне и думается что это костыль, который и на обычную камеру можно нацепить, (и цепляют-же)как и охлаждение (которое не ставят потому-что пока не надо, хотя есть отдельные образцы)…

К обработке сырых данных с пленооптической камеры или растра камер, можно подходить по разному, на качество работы того или иного подхода сказывается качество изготовления системы в целомКто бы спорил!

Собственно этот пост появился не благодаря Lytro, а благодаря Google, когда стало понятно, что можно сделать сенсор ОЧЕНЬ качественно и при этом пленоптическим. И маленьким. И массовым.

Вы, точно видите мегаЛайтру в этом ряду?К сожалению, точно. Именно из-за удешевления при качестве, которое устроит пипл. И тут можно только возглавить процесс, попытавшись поднять качество (благо там есть огромные резервы).

А ещё вместо того что бы трэчить камеру, её можно к старому, списанному, промышленному роботу прикрутитьА удобство использования на площадке?)

а с картой глубины, это смотря для чего мы её хотим, тут есть варианты, почему мне и думается что это костыль, который и на обычную камеру можно нацепитьПока идет к тому, что глубина будет мастхэв фича.

Сейчас интересная тема — промышленные роботы, но там велика конкуренция со стороны сенсоров других типов.

Знаю ребят (стартап), которые вполне успешно пилят на стандартных копеечных Kinect сенсорах от Xbox One; работает очень прилично, чтобы не сказать больше. Правда, там математика сложная (обрабатываются данные 4 или 8 сенсоров суммарно). Но по любому, учитывая стоимость оборудования, решение из абсолютно другого ценового диапазона, чем подобные камеры и лидары.

А в чем преимущество пленоптических сенсоров над стандартными Kinect-ами?Ну, например, кинект умирает на солнечном свету. ) И даже при облаках солнце засвечивает его сигнал.

Массовость производства сенсоров других типов тоже растет, соответственно, цена падает.

P.S. (не в тему) Кстати, любопытно, что, оказывается, подавляющее большинство промышленных роботов работает под… разными версиями Windows (по крайней мере, «фронт-энд», а не bare metal firmware), и всевозможные RTLinux/QNX для фирмвари тоже практически не используются.

Будем считать, что вы в курсе, но имеете какой-то резон не палить тему пред лицем вездесущих китайцев.Кроме китайцев, как полагаю? )))

Я тоже от части промолчу, однако всех практически заинтересованных техникой...

А если серьезно, что там можно «спалить» в посте на несколько тысяч слов? Деталей не расскажешь, а идеи не патентуются.

2. Про глубину: допустим, мы снимаем под водой коралловый риф через течение. Можем ли мы по одному кадру лайтры восстановить неоднородность плотности среды между объективом и объектом, получить трёхмерную карту фазовых сдвигов и сделать трассировку?

2. Не можем )

Там возможно много чудес, но они не произвольны

На счёт первого.

Сенсоры матрицы стоят не вплотную, между ними есть отступы. Если не фокусировать свет на сенсорах с помощью микролинз, то часть света будет потеряна, это значит что будет хуже съемка при низком освещении (при маленькой площади матрицы смартфонов это очень критично), плюс появится эффект алиасинга.

1. Микролинзы стоят только для увеличения чувствительности, или ещё зачем-то? Такого подхода я у астрономов не встречал, а они на чувствительность молятся.

2. Алиасинг получается так и так, и не факт, что он лучше при массиве микролинз, просто потому, что чем меньше пиксел (апертура), тем выше разрешение матрицы

3. Почему ход лучей от главной линзы объектива показан как плоская волна? По идее, должна быть сферическая.

1. Ну так основная тема этой статьи — пленоптическая камера, там микролинзы отправляют свет на целые группы сенсоров.

2. Я в этом не разбираюсь, просто считаю что лучше регистрировать свет на всём пикселе, а не только в центре.

3. Линзы по краям должны иметь другую форму, это же просто иллюстрация.

Вообще, я знаю не больше чем написано в этой маленько статье на википедии — https://ru.wikipedia.org/wiki/Микролинзы

Микролинзы стоят только для увеличения чувствительности, или ещё зачем-то? Такого подхода я у астрономов не встречал, а они на чувствительность молятся.Для увеличения чувствительности при сверхмалом размере сенсора смартфона. Астрономам нет совершенно никакого смысла ставить сенсоры в 2.5 миллиметра и пытаться на них максимум фотонов поймать, им проще увеличить объектив и матрицу и не мучиться. Так что неудивительно, что не слышали )

cpn.canon-europe.com/content/education/infobank/capturing_the_image/microlenses.do

Т.е., похоже, я не прав — на крупных сенсорах этот способ увеличения чувствительности тоже вполне используется:

«The advantage of using all the light that makes its way to the sensor is that the system is more efficient overall and less amplification is required in the processing circuitry – this leads to improved ISO performance, especially in low light level conditions where the light reaching each pixel can be very minimal.»

А можно ссылку про коррекцию аберраций микролинзами для крупных матриц? Что-то с ходу не нашел. Точнее только теоретические работы (типа www.osapublishing.org/oe/abstract.cfm?uri=oe-13-26-10539 ).

Там изначально была история про виньетирование (затемнение кадра по углам). У зёрен серебра оно «нормальное», т.е. как квадрат косинуса угла падения, а вот у сенсоров уже косинус в четвёртой степени, что приводит прям таки к колодцу на графике чувствительности. Изначально микролинзы ставили, именно чтобы повернуть падающие лучи в удобную для сенсоров сторону. Ну да, бонусом микролинза ещё собирает свет, который иначе попал бы на дорожки и обвязку между отдельными пикселями, и позволяет зарегистрировать ещё сколько-то процентов фотонов.

Потом инженеры покумекали и додумались, что если сдвигать микролинзы на краях, то можно немножко поправить — вот тут не помню, то ли кривизну поля, то ли сферические аберрации. Ну в любом случае, немножко поправить разрешение в углах.

2. Алиасинг и так и так, но (в случае фотоаппаратов, не знаю как там у телескопов) микролинза накрывает не 1 пиксель, а 4 (2х2, у каждого свой светофильтр). В этом смысле она (частично) заменяет собой физический АА-фильтр. Разрешение матрицы давно ни о чём не говорит, всё упирается в физическое разрешение оптики.

3. Не показан, приглядитесь внимательнее.

Дожить бы ..)

VR не воспроизводит световое поле.

Я не хочу очки одевать, хочу именно монитор как окно.

Я не хочу очки одевать, хочу именно монитор как окно.Вы не одиноки ). И это дает шанс взлететь следующему поколению автостереоскопии. У Leia3D (чья технология малых автостереоскопических экранов сейчас доступна в серийном RED Hydrogen One) была в загашнике технология дисплея на 16 ракурсов в 2 направлениях (по вертикали и горизонтали). Смотрелось прикольно, но в серию не пошло.

Stream TV Unveils 8K «Lite» Glasses-Free 3D Monitor

www.soundandvision.com/content/stream-tv-unveils-8k-lite-glasses-free-3d-monitor

Но как по мне, от шлемов полный восторг. Имею ввиду шлемы на микро-оледах, конечно же. Специально заточенные для просмотра 3D и видео, не убогое VR…

хочу именно монитор как окно

со мной это не работает, я не вижу 3D на мониторах

VR не воспроизводит световое поле.

а это что?

я не вижу 3D на мониторахStereoblindness — несколько процентов. Важно чтобы таких людей помнили разработчики (например, предусматривая переключение в 2D режим).

со мной это не работает, я не вижу 3D на мониторах

При точном воспроизведении светового поля это невозможно не увидеть, световой поток от монитора будет идентичен таковому из окна. А не видите Вы потому что современные 3D мониторы так же далеки от воспроизведения светового поля как наскальные рисунки от современных мониторов.

некоторые люди (например я) не видят стерео даже просто глядя в окноКак такое может быть??

за счет движений головы и получающегося обзора с разных угловСкорее — за счет аккомодации.

У нас была мысль свести количество упоминаний Vergence-accommodation conflict продюсором-режиссером и количество перепутанных ракурсов (правый с левым) в фильме… Было бы прикольно! ) (что-то подсказывает — корреляция прямая, ибо это в чистом виде грамотность) Но куча людей обиделась бы, а нас за проект VQMT3D и там многие не любили )

… несколько ракурсов по одной оси, так вообще из валежника и фекалий можно сделать, самая большая проблема в синхронизации съёмки\воспроизведения, это и не проблема вовсе

вот бы еще воспроизводить, да на экране приличных размеров с хорошим разрешением и за разумные деньги… Дожить бы ..)Шансы есть ). Подразделения автостереоскопии есть у каждого крупного производителя телевизоров (в отличие от прошлой волны, когда они кинулись продавать первое, что под руку попало). Эта тема развивается сейчас хорошо, хотя и не созрела до следующей волны продуктов.

Возник вопрос. Немного упустил из вида, позволяет ли вся эта громоздкая конструкция снимать с традиционным фокусным расстоянием?

Горизонталтные стереориги ничуть не менее громоздки но вынуждают снимать акета с противоположного конца планеты. У меня лично от того, что у актеров практически затылок видно, прямо желание смотреть отпадает.

Про это подробно было в этом посте.

Эта конструкция близка к стерео-ригу бим-сплиттеру, т.е. расстояние между оптическими осями можно менять в диапазоне 0-10 см уже после съемки. Равно как и фокусное расстояние при желании.

Как раз изза таких искажений меня аж выворачивало от SW7 (забывая о том что эти эпизоды и без того жесть кошмарная)

side-by-side stereo rig это самое мерзкое что можно было придумать, а если вы говорите, что все очень радужно, посему не используется повсеместно?

Судя по всему, у технологии есть только одна проблема — громоздкость всей системы. Что, все и правда настолько хорошо?

Основные проблемы:

- Большое количество инженерных проблем в железе

- Огромный объем данных при съемке

- Высокая вычислительная сложность алгоритмов обработки

Все проблемы — не из разряда простых. Но есть посмотреть на тренды сенсоров (экспоненциальные (!) по размеру, разрешению, стоимости), тренды роста мощности GPU (тоже экспонента) и тренды снижения стоимости накопителей (опять экспонента, но наиболее скромная), то все будет решено. Но сразу и не всегда легко, но решено. По накопителям, как наиболее узкому месту, можно прогнозы по срокам строить.

И вот еще, с может не внимательно читал — но не увидел цены на этих монстров. Сколько примерно стоит такое чудо? Оно окупится в киноиндустрии, иди его использование будет в минус?

А стоят как (первые) самолеты )

Но хоть на порядок намекните :)

Lytro проели 215 миллионов. Повторить их результат стоит кардинально меньше, а техническая база стала кардинально лучше. Что-то рыночное будет у 2 или даже 3-й попытки. У самолетов было медленнее )

Погуглил сам — от 10 до 50 лямов баксов. Один блокбастер окупит покупку камеру и со второго они начнут приносить прибыль.

Как выше САДКО верно заметил, там все не так просто, но у меня оптимистичный настрой )

Массовый взлет пленоптики пришелся на Google Pixel 2. Скорость и высота полета очень неплохие.

Справедливости ради, DPAF в камерах Canon появился в 2013 году (Canon EOS 70D), задолго до Pixel 2.

Ну а фазовый автофокус в зеркалках появился относительно давно.

И даже у фазового автофокуса зеркалок 20-летней давности — двоящееся изображение было стерео — оно двоилось за счет смещения точки съемки через один объектив. )

Это не то, чтобы мне везде съемка стерео виделась ))) (профессиональная деформация своеобразная))), это оно так и работает. Поправьте, если чего не понимаю.

А то процессоры убыстрять смысла особого нетВсегда есть. Больше мощности > меньше оптимизаций > больше говнокода > лаги на 4 ядрах > больше мощности…

экраны тоже идеальныеНужно решить проблему выгорания OLED-ов.

памяти, чтобы все это хранить, в 10 раз большеБольше, чем в 10 раз.

А если серьезно, интересно что природа могла бы создать такой вариант стереоскопического зрения. Может быть тогда и циклопы не были бы мифом.

Что кстати порождает два вопроса:

1. Не является ли крайне эффективная стабилизация у некоторых насекомых (например ос), следствием восприятия светового поля? Т.е. насекомое при может определять смещения вектор путем поиска точки обзора дающего ту же картинку что раньше.

2. Как нейросеть насекомого справляется с анализом такого объема данных?..

Нейросети ровно в относительно быстрой обработке больших объемов и эффективны, так что тут все логично )

«Каждый омматидий имеет очень ограниченное поле зрения: угол обзора омматидиев в центральной части глаза — всего около 1°, а по краям глаза — до 3°. Омматидий «видит» только тот крошечный участок находящегося перед глазами предмета, на который он „нацелен“, то есть куда направлено продолжение его оси. Но так как омматидии тесно прилегают друг к другу, а их оси в круглом глазу расходятся лучеобразно, то весь сложный глаз охватывает предмет в целом. Причём изображение предмета получается в нем мозаичным, то есть составленным из отдельных кусочков.

Число омматидиев в глазу у разных насекомых различно. У рабочего муравья в глазу всего около 100 омматидиев, у комнатной мухи — около 4000, у рабочей пчелы — 5000, у бабочек — до 17 000, а у стрекоз — до 30 000!»

allforchildren.ru/why/why100.php

или тут «Рецепторная часть омматидия состоит из сильно вытянутых зрительных (ретинальных) клеток, соединенных радиально в общий пучок. Чаще всего таких клеток насчитывается восемь. „

ru.wikipedia.org/wiki/%D0%9E%D0%BC%D0%BC%D0%B0%D1%82%D0%B8%D0%B4%D0%B8%D0%B9

но какое там разрешение 1х1 или больше — не очень ясно)

Ключевое понятие для пленоптической съемки — это световое поле, то есть мы в каждой точке фиксируем не цвет пикселя, а двумерную матрицу пикселей, превращая жалкий двумерный кадр в нормальный четырехмерный (обычно пока с очень небольшим разрешением по t и s)Верно ли я считаю, что единственная разница между тем, что мы считаем пленоптической системой, а что классическим stereo — это лишь значение разрешения по t и s?

Если так, то где она, та граница, за которой multi-view stereo (например, массив камер) превращается в систему светового поля? =) По идее, даже основная математика должна сохраниться.

Если же у нас многокамерная система дающая обычный multi-view, то там другие проблемы — камеры неровно стоят, у них «уходит» цвет при нагреве, какая-то камера может целиком отключиться и ее надо будет интерполировать и т.д. И методы калибровки, и методы восстановления сильно отличаются.

В итоге даже специально разделяют Light Field и Sparse Light Field — первый с микролинзами, а второй — с массивом камер, поскольку там разные проблемы при съемке, разные артефакты и т.д.

А теория — да, теория похожа! )

По поводу интересного. На мой взгляд реально интересное еще не началось ) (потому что дисплеи только подтягиваются на вторую волну).

А так — меняют резкость заднего плана массово, задний план делают ЧБ, меняют фон и далее по списку. Там много всего интересного и сложного алгоритмически.

Я наоборот в видео youtu.be/4qXE4sA-hLQ?t=1373 вижу, как лезут жуткие артефакты если даже они там чуть чуть крутят проекцию камеру в Nuke. То же самое, что в твоей 4 статье habr.com/ru/post/378387 абзац «Как же выглядит реальное изменение видимой глубины». Ведь световой поток не может заглянуть «за объект», приходится придумывать эту информацию, с артефактами.

Чем обычноые стерео не угодило? Там можно и карту глубины сделать, по ней и фокус можно любой сделать (если снимать на зажатой диафрагме, чтобы всё было чётко). Custom Camera Path, для той же стабилизации, после 3d tracking вообще уже лет 20 делают даже для 2d видео, в том же Syntheyes или Nuke, непонятно в чём тут новость.

Почему не приделать этот же лидар к обычной моно-камере, снимать чёткую картинку с высокой диафрагмой, и в постпроцессе управлять фокусом и делать 3d?

Почему нельзя после того же бим-сплиттера довести картинку до идеала? Убрать автоматически разную яркость от бликов и поляризации.

вижу, как лезут жуткие артефакты если даже они там чуть чуть крутят проекцию камеру в NukeСтоит различать качество предпросмотра реального времени и финальный рендер ). Собственно вся конвертация 2D в 3D — это полуручной сдвиг камеры. И вполне заходит. Все блокбастеры конвертируют.

Ведь световой поток не может заглянуть «за объект», приходится придумывать эту информацию, с артефактами.Да, это называется заполнение оклюженов и это большая проблема. Сейчас много методов решения, апробированных на конвертации.

Чем обычноые стерео не угодило?В двух словах — рентабельность ниже, головная боль выше. Если подробно — у меня материал на десяток полноценных постов по конвертации лежит )

Почему не приделать этот же лидар к обычной моно-камере, снимать чёткую картинку с высокой диафрагмой, и в постпроцессе управлять фокусом и делать 3d?Потому что в 4K с минимальным движением ВСЕ границы становятся размыты, а если ГРИП мал — вообще жесть. И двигать размытые объекты хорошо никто пока не умеет.

Почему нельзя после того же бим-сплиттера довести картинку до идеала?Меня, как разработчика алгоритмов обработки видео, этот вопрос мучает уже много лет. Там многие артефакты вообще можно в автоматическом режиме современными алгоритмами лечить. Одной кнопкой. Ответ есть, но он длинный и мало кому понравится.

Ответ есть, но он длинный и мало кому понравитсяПридется уволить кучу людей, которые сидят и чистят руками? :)

Не надо делать малый ГРИП, имея карту глубины лучше сделать его в постпродакшене для 2D, для 3D оставить всё чётким. Ну и само собой снимать надо на 60/120fps, а не 24, чтобы не было всё размытым в движении.

Всё таки длинный ответ про бим-сплиттер очень интересен ) Ведь когда-нибудь наступят такие времена, когда любое отснятое 3d говно, включая старые фильмы, можно будет пофиксить твоими программами в авторежиме :) Пускай даже и подождать придётся месяц на рендеринг.

Ведь световой поток не может заглянуть «за объект»

Может. В пределах сдвига точки зрения в границах линзы. Для стерео, особенно если это съемка для большого экрана (с увеличением) сильно много и не надо. В видео на которое Вы ссылаетесь — крутят сильно больше.

Тут надо учитывать, что мы часто находимся за пару этапов от конечного софта.

Т.е. это реально очень частая ситуация — новый софт уже можно сделать, новые технологии позволяют, однако это расходы:

* доведение прототипов технологий до продуктовых (увеличение их стабильности, ускорение и т.п.)

* реализация продуктов (развлекалово с версиями программ-хостов, поддержка разных платформ и архитектур, интерфейс, отладка и т.п.)

* организация продаж (создание рекламных материалов, вложения в маркетинг, выставки, статьи и прочее продвижение, сами продажи, поддержка и т.п.)

* много административных моментов (налоги, патенты, недружественные действия конкурентов и т.д.)

Короче — когда это все калькулируется и сравнивается с размером рынка, на котором народ вполне себе часто устраивают костыли, но за которые не надо ничего платить… (и это совершенно понятная позиция!)

В общем — принимается решение повременить… )

А люди проклинают костыли…

И лучше ситуация на «богатых» рынках, когда компании готовы купить 2-3 решение одной проблемы, поскольку деньги есть, а двигаться надо быстро. Но большинство рынков не такие.

На последнем CG-Event был доклад «В AR денег нет — расходимся» аккурат про это )

На докладе про дополненную реальность не попал, обязательно посмотрю в архиве конференции, спасибо. А по поводу софта я думаю что если создать комплексное ПО (трекинг, мачмувинг, фотограмметрия) наподобие pftrack, то рынок для него найдётся, но вам, безусловно виднее.

SR даст повышенное разрешние -> меньше шумов меш-сетки?

А в будущем — да, конечно.

Мало того, если говорить об ухищрениях, то они тоже есть: Eyetracking позволяет динамически снижать качество картинки, которая попадает в обширную зону периферийного зрения. Человек все равно не различает деталей и цветов за пределами небольшой центральной зоны — Fovea centralis. Такой-лайф хак называют Foveated Rendering, он позволяет экономить вычислительные ресурсы, а точнее грамотно перераспределять их для повышения качества той области сцены, на которую зритель действительно смотрит.

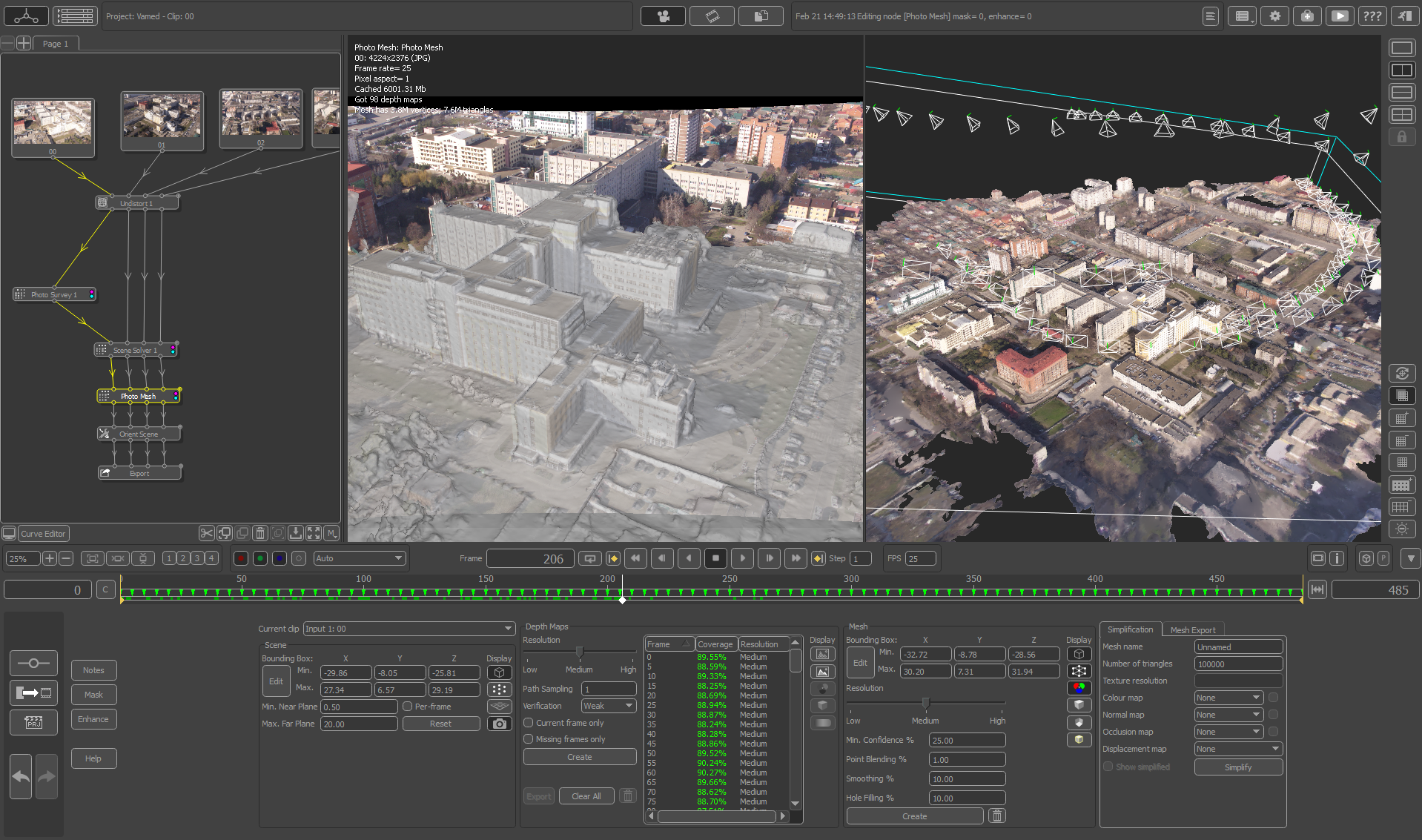

Толстый черный жгут внизу слева на заднем плане — это моток оптоволоконных кабелей примерно 4 сантиметра диаметром, по которым камера отдает чудовищный поток информации в специальное хранилище

При этом если стабильно опаздывать — могут быть разные неприятные эффекты.

Например, даже небольшое отставание при рендеринге поворотов головы вызывает конкретное укачивание.

Снимок ниже с Йоном Карафином, с которым мы примерно одного роста, более точно передает масштабы бедствия

Подразумевается, что читатели Хабра знают рост автора?

Вычисляемое видео в 755 мегапикселей: пленоптика вчера, сегодня и завтра