Наш системный инженер Владимир Емельянов и его коллега – ведущий инженер по виртуализации рассказали мне о серверах Gooxi и поделились первыми впечатлениями. В статье рассказываю, как у них прошел процесс монтирования, какие были сложности с подключением комплектующих и настройкой систем мониторинга, и что там с совместимостью с VMware.

Ни для кого не новость, что большинство западных поставщиков серверного оборудования прекратили поддержку своих решений на территории России. В нашем московском дата-центре бОльшая часть инфраструктуры построена на базе архитектуры FlexPod. Она включает в себя вычислительную часть на основе серверов-лезвий B200/480-M5 и корзин UCS 5108, сетевую часть на high-end маршрутизаторах ASR 9000 и коммутаторах серии Cisco Nexus. Системами хранения данных занимаются производительные контроллеры от Netapp. Но отсутствие поддержки западных поставщиков, увеличение сроков поставки и повышение стоимости предоставления услуги заставили нас посмотреть на восток, а точнее на китайского вендора Gooxi. Впрочем, машины оказались добротные и заслуживают внимания.

Китайские поставщики сегодня активно ориентированы на российский рынок и могут предоставить неплохой продукт. Это, конечно, не идет в сравнение с западными enterprise-решениями, но оборудование довольно достойное.

Кто же такие эти Gooxi?

Gooxi – это китайский поставщик серверного оборудования, который предоставляет стандартные RACK-серверы, многоузловые серверы и многие другие, подробную информацию о которых можно найти на сайте. В нашем случае было решено установить стандартную серверную сборку Gooxi SL101 формата 1U и протестировать для инфраструктуры на базе VMware.

В итоге было установлено 18 хостов со следующей конфигурацией:

Model: Gooxi SL101-D10R

CPU: 2x Intel(R) Xeon(R) Gold 6248R CPU @ 3.00GHz

RAM: 16x Micron Registered DDR4 DIMM 64 Гб PC4-25600 (1TB)

SSD: 2x 480GB SSD SATA 2.5"

Network card: 2x Intel 710 (10Gb)

Raid Card: LSI 9361-8i (1GB)

Материнская плата: GOOXI G3DCL-B Intel®C621/C622 chipset, 2x Intel®Xeon® Scalable, 2* PCIe 3.0 x4 M.2 slot, 2* Mini SSD slot

Сроки поставки оказались рекордными – оборудование было на месте через 1,5-2 месяца. Техническая поддержка отвечает быстро по любым вопросам. Конечно, минусом является отсутствие возможности самостоятельно найти ответ в Интернете, нет какого-то сформированного комьюнити, нет документации или чего-то подобного. Но быстрый отклик саппорта компенсирует этот факт.

Монтирование без плясок с бубном

При поиске оборудования одним из главных параметров являлась совместимость с сетевой частью ЦОД, которая в дата-центре вся на коммутаторах и маршрутизаторах Cisco. Для подключения стольких серверов было принято решение расширить количество портов нашего Cisco Nexus ядра с помощью пары Fabric Extender FEX 2248PQ. Это позволило сформировать отдельную обособленную среду подключения, разместить все оборудование достаточно компактно и с небольшой длиной оптических кабелей.

По конструктивной части Gooxi предлагают современное оборудование с интуитивно понятными инженерными решениями, что позволило подключить железо к сетевой части, к питающим PDU и к управлению без каких-либо проблем. В комплектацию входят удобные рельсы с защелками без болтов, поэтому монтирование происходит по типу «щелчок и само держится». Организован простой доступ во все внутренности, сервер легко выдвигается, одним движением рычажка снимается крышка, и можно в пару движений установить или заменить нужные запчасти.

Так как Gooxi – это RACK-серверы, то приходится иметь дело с большим количеством кабелей. Это в принципе характерная черта всех рэковых машин, поэтому подключение здесь не такое удобное, как с Blade-серверами, которые просто подключаются в слоты, а кабели соединяются напрямую с корзиной. Ну и плюс провода же нужно как-то уместить в шкафу, что тоже становится неким квестом.

Монтирование оборудования заняло около недели (5-6 дней) в том числе привоз, снаряжение, кабельная коммутация, настройка BIOS и удаленного доступа, установка и настройка ОС. А для введения в продуктив в работающий кластер VMware потребовалось 1,5 дня. Процесс установки оказался легким, неожиданных сюрпризов не было.

Совместимость с платформой VMware отличная. Специалисты тестировали стандартный ISO-образ ESXI 7.02, и установка кастомных драйверов не потребовалась.

Без сложностей не обошлось

Gooxi – это в принципе новое оборудование, с которым было непривычно работать, поэтому возникло несколько сложностей при инсталляции. И качество сборки все-таки не Cisco.

Например, слоты под DIMM материнской платы не с первого раза определяли модули оперативной памяти. Возможно, это связано с тем, что некоторые модули были от разных вендоров (Micron, Samsung, Crucial). Вопрос был решен с помощью перенастройки или попросту «перетыкивания», и это помогло, вся память встала на место. Еще – несколько раз не запускались сетевые и RAID карты. Проблема решилась перепрошивкой BIOS.

Отдельная история произошла с системой мониторинга сервера. Протокол SNMP работает хорошо и данные можно спокойно получить. Однако, в интерфейсе управления IPMI сервера при настройке отправки уведомлений на почту поддержки приходило очень много «фантомных» алертов, хотя проблем на сервере не наблюдалось. Это связано с кривой реализацией системы мониторинга алертов именно внутри IPMI сервера. Поэтому стали использовать платформу Icinga 2, на которой все отслеживается. Сейчас с помощью встроенного протокола SNMP мониторятся основные показатели сервера без привязки к почтовым уведомлениям.

Минусом еще стало и отсутствие уникальных UUID идентификаторов BIOS. Все оборудование имеет одинаковый идентификатор, что вызывает неудобства при мониторинге и работе с сервером через vCenter.

Тестирование

Основой для тестирования стал стресс-тест, так как вероятные причины поломки как раз возникают в процессе большой нагрузки. Был установлен ОС ESXI от VMware, и внутри каждого сервера запущен процесс нагрузки процессора и оперативной памяти на 100%. Хосты стояли так около 8 часов, и наблюдение было, в первую очередь, за показаниями датчиков температуры, а также за моментом выхода из строя комплектующих и работоспособности тестовых виртуальных машин. В результате все прошло без происшествий. По температуре серверы показали довольно хороший результат.

Например, процессор Intel (X) Xeon ® Gold 6248R CPU @ 3.00GHz, 24 ядра, 48 vCPU при максимальной нагрузке в течении 4 часов достиг всего 57 ℃. Возможно это еще связано с хорошим охлаждением дата-центра. В залах ЦОД организованы холодные коридоры, откуда оборудование получает воздух для охлаждения, и выдувает его в сторону горячего коридора. Холодный же коридор отделен от горячего, чтобы избежать перемешивания воздуха.

Админы также немного снижали потребляемые ресурсы VM и перегоняли машину с хоста на хост, чтобы посмотреть, как она себя ведет при переезде. Сервер показал себя неплохо, деградации в работе не было. Охлаждение работало штатно, с запасом, без алертов по температуре. При эмуляции отказа сервера в стоке по питанию проблем также не возникло.

Серверы продемонстрировали хорошие показатели и по блокам питания. Когда идет максимальная нагрузка, сервер начинает потреблять почти максимальную мощность, которую держит один из его блоков питания, резервирование (n+1). Если один выходит из строя, второй включается без отключения сервера. Были получены хорошие результаты по температуре и по стабилизации напряжения без колебаний и скачков.

Самое главное, после тестирования ни один аппаратный модуль не вышел из строя.

Что с веб-интерфейсом?

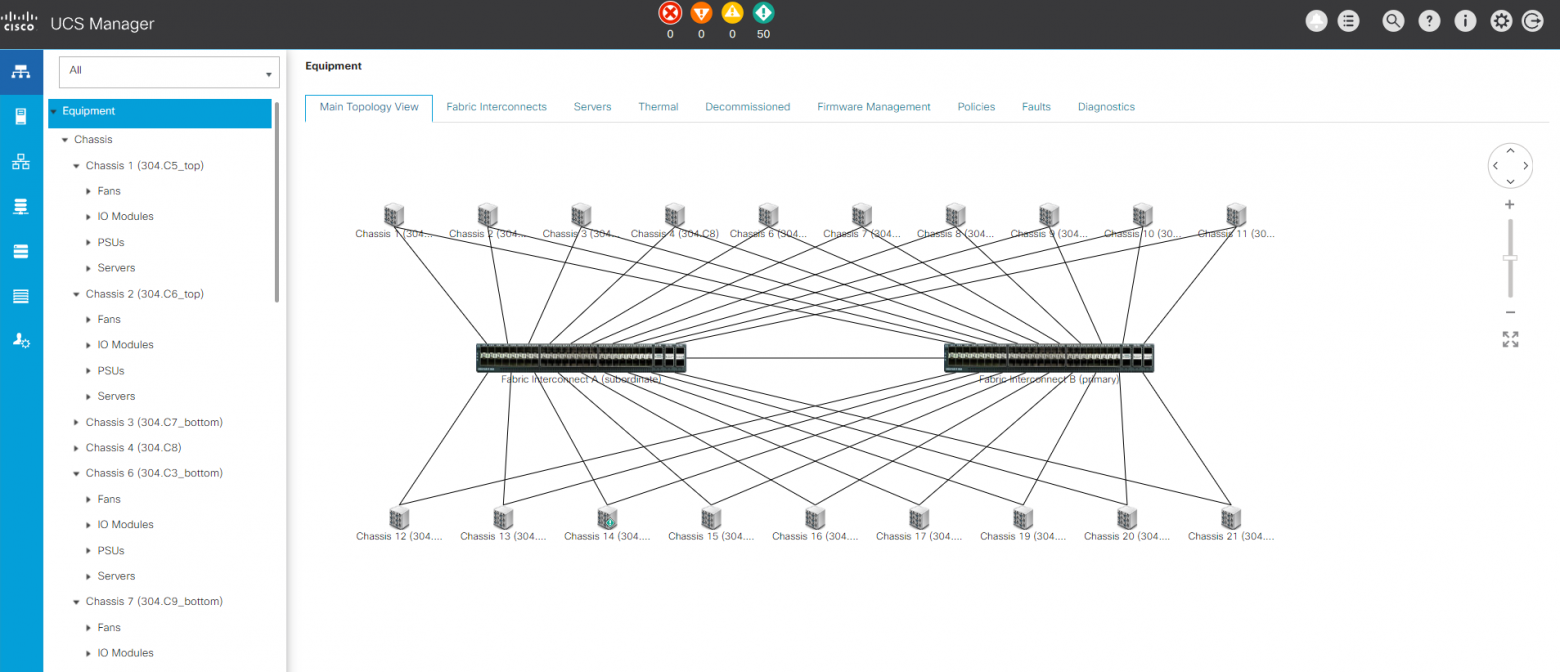

Интерфейс управления HTML5 отзывчивый, понятный и визуально приятный, работает быстро. Удобно, что вся панель на английском языке. Есть информативные графики, и можно мониторить все основные показатели сервера в одном пространстве. Однако в отличие от панели Cisco UCS Manager, где вы управляете целым кластером серверов в одном пространстве, Gooxi не дает такой возможности. Здесь для мониторинга и управления необходимо отдельно заходить на каждый сервер. Однако админы, как цифровые творцы, могут использовать кастомные разработки и исправить это, например, используя утилиту IPMI tool. Для сравнения, ниже представлены оба интерфейса Cisco и Gooxi. В панели Cisco видны все доступные серверы с шасси, вентиляторами, модулями и блоками питания.

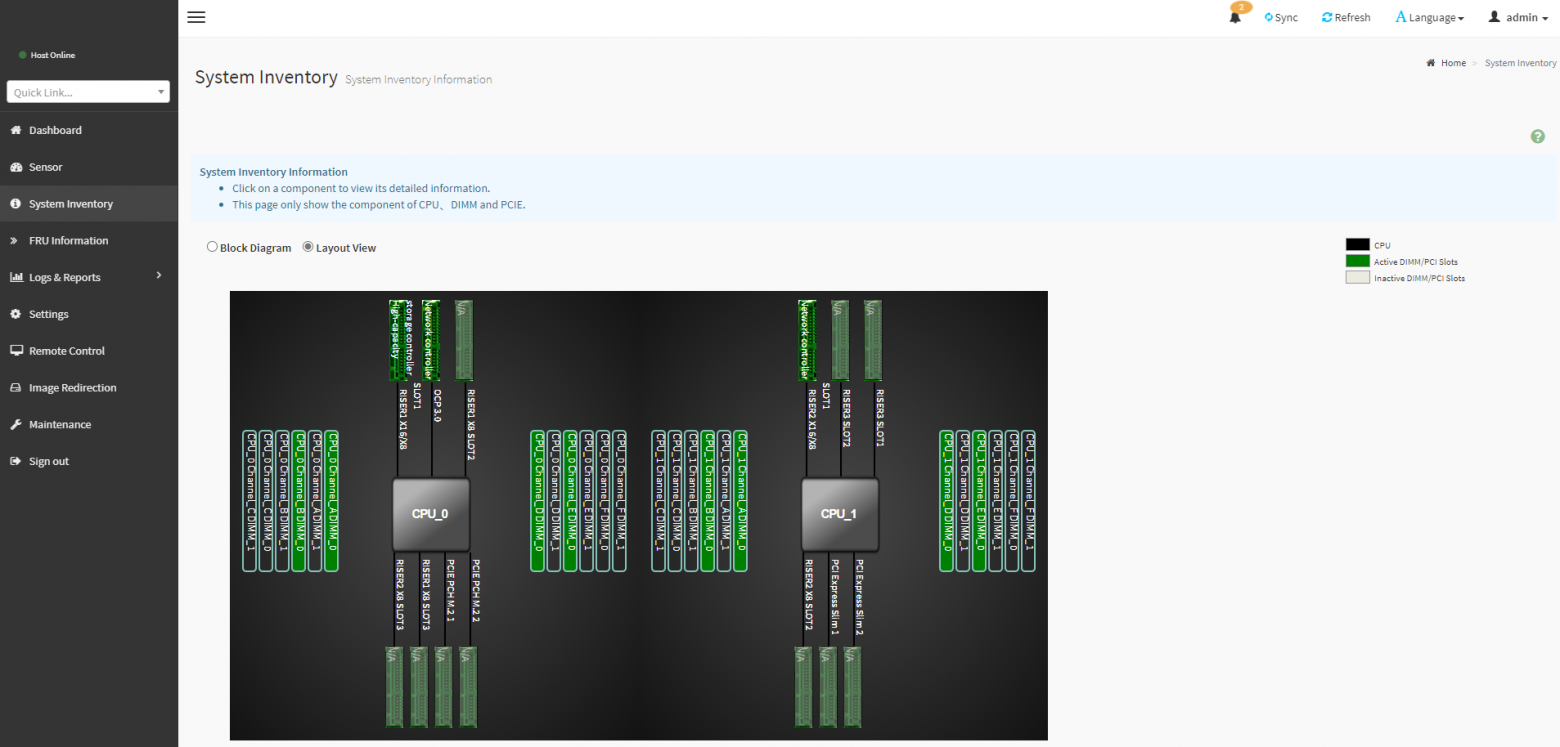

В панели Gooxi видно, что управление идет только одним сервером.

В интерфейсе графически можно увидеть все показания сервера, которые продублированы в логах на английском языке. Однако если сделать выгрузку логов, то получаешь китайские иероглифы. Это не критично, так как в панели все видно, но для удобства, конечно, хотелось бы, чтобы поставщик сделал логи на английском языке. Думаем, впоследствии это исправят.

Из минусов, специалисты, которые привыкли по шагам проходить настройку интерфейса управления сервером, как например с Lenovo, не получат такой возможности. Здесь сразу попадаешь в панель и дальше самостоятельно производишь настройку.

Что в итоге?

К удивлению, был получен надежный кластер из 18 серверов. Благодаря внедрению такого количества хостов была достигнута хорошая отказоустойчивость, обеспечивающая выход из строя 4 из 18 серверов без потери доступности сервисов и качества для клиентов.

Первое впечатление от админов – серверы достойные. По сравнению с другими вендорами Rack-серверов (hp, dell, lenovo, supermicro, intel) Gooxi удобны в монтаже, так как это более современное оборудование. Установка не вызвала проблем, все запустилось с первого раза. Большим плюсом стала быстрая поставка за буквально 1,5-2 месяца. У Gooxi удобная панель управления, по крайней мере она интереснее других, быстрее, информативнее. Есть, конечно, недостатки такие как логи, алерты и невозможность мониторить все хосты в одном пространстве, что без проблем решается сторонними решениями.

В дата-центре кластер сейчас загружен чуть более, чем на 50%, поэтому проседаний по работе серверов не наблюдается. Обеспечивается сбалансированная нагрузка, что позволяет уменьшить износ серверов.

В общем, машины работают хорошо, багов, которые появлялись бы на пустом месте, нет.