После презентации новой линейки видеокарт серии RTX 3000, компания производитель графических чипов Nvidia столкнулась с беспрецедентным спросом на свою новую продукцию. Превышение розничных цен на топовые модели RTX 3080 и RTX 3090 составляет и $500 и более, что больше рекомендованной цены на 30-60%.

Причем просто на завышенных относительно оглашенных на презентации ценах проблемы с новыми RTX не заканчиваются. Так, один из официальных торговых партнеров MSI был уличен в спекуляции новыми видеокартами на онлайн-аукционах, а сами Nvidia заявляют, что купить по адекватной стоимости новые RTX 3080 и RTX 3090 можно будет не раньше следующего года. При этом релиз и поступление в продажу самой «вкусной» карточки RTX 3070 было вовсе отложено на две недели, с 15 на 29 октября 2020 года.

Человек, далекий от ПК-гейминга и релизов флагманских моделей железа справедливо спросит: «вы там что, совсем кукухой поехали? Какие 1200-1500$ за видеокарту? Какой ажиотажный спрос? Что вообще происходит?» Так вот, сейчас я, автор статьи, объясню, почему Nvidia столкнулась с таким ажиотажем вокруг RTX 3000 серии и почему геймеры с нетерпением ждут поступления в продажу этих видеокарт по заявленной стоимости.

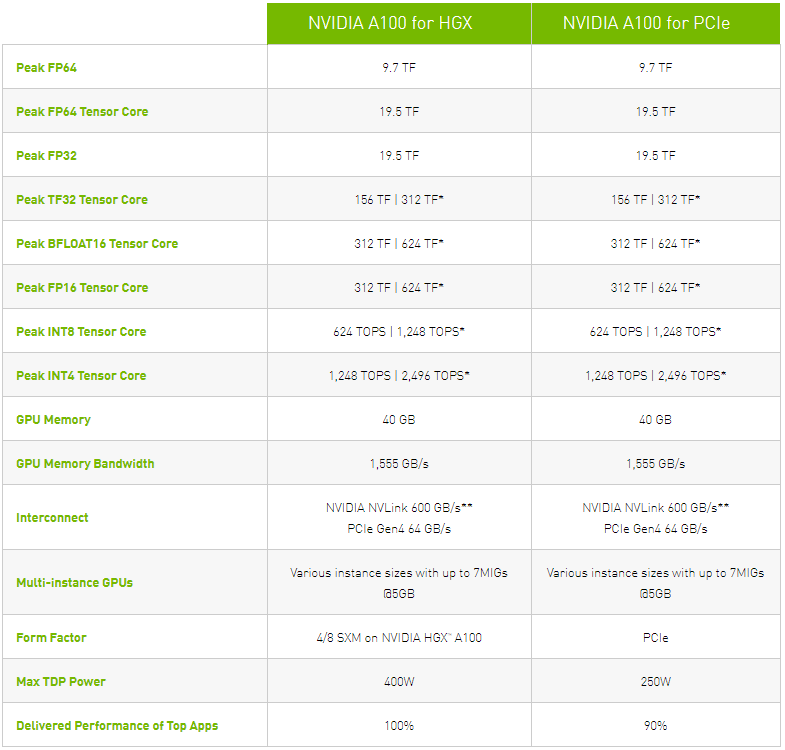

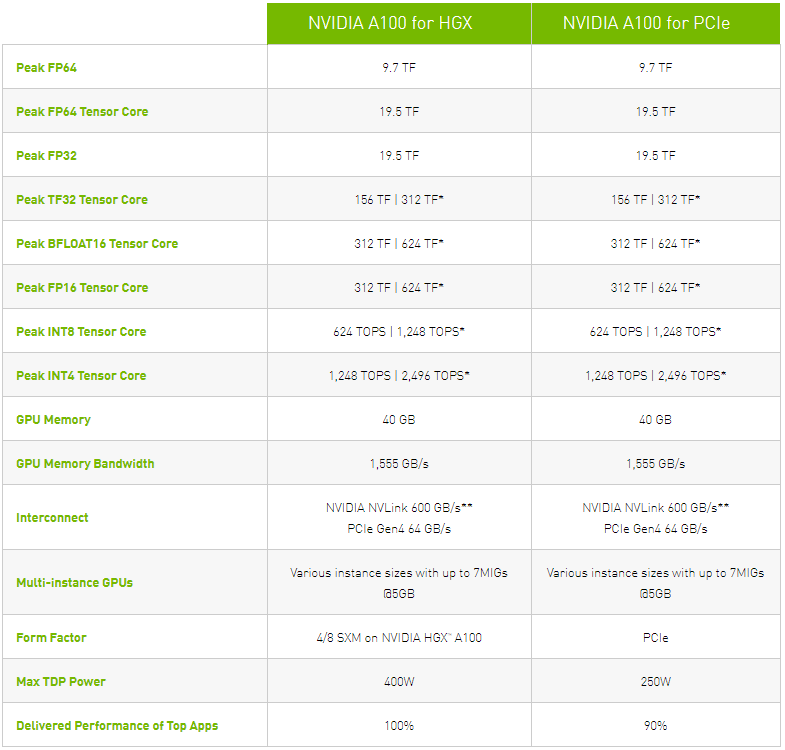

То что RTX 3000 серии — геймерские карты ни у кого сомнений не вызывает. Для вычислений и науки у Nvidia давно есть карты серии Tesla V100 и Tesla A100. Это мощные графические ускорители за тысячи долларов, задача которых крайне проста и очевидна — считать. Причем считать, в основном, всякие «научные штуки» в составе вычислительного кластера. Новые A100, которые сейчас поступают в ограниченный тест, по заверениям Nvidia вовсе в 6 раз производительнее далеко не слабой V100. Собственно, о возможностях этих карт можно судить по официальным спецификациям с сайта Nvidia:

Говорю я о семействе ускорителей Tesla по одной причине: архитектура Ampere. Именно она лежит в основе графических ускорителей Tesla и до этого момента карточки на Ampere стоили до $10 тыс. и имели весьма узкую специализацию. В первую очередь, ускорители Ampere были направлены на тренировку нейросетей и по заверениям производителя справлялись с этой задачей на порядки лучше, чем другие решения. По официальным данным, карты на базе Ampere ускорили обучение нейросетей до 20 раз.

Но тут Nvidia выпускает потребительские видеокарты для геймеров с использованием той же технологии. Это как если бы Intel с 2016 года клепал серверные процессоры на литографии в 2 нм для суперкомпьютеров, каждый из которых стоил бы $10 тыс. и более, а тут внезапно вбросил бы новую серию Intel Core по $500 за штуку на той же технологии. Очередь бы выстроилась знатная.

Для Nvidia все выглядело красиво: больше мощностей по меньшей, по сравнению с триумфальной серией RTX 2000, цене, «научная» архитектура в компьютерах геймеров, поддержка большего разрешения и так далее и так далее. Вот только в коридорах Nvidia не ожидали, насколько потребитель нуждается в мощной видеокарте и что RTX 2080 Ti уже давно не удовлетворяет всех потребностей рынка.

Хотя RTX 3000 серии не показывает кратного превосходства над RTX 2080 и RTX 2080 Ti, а гряду��ий хит продаж — «бюджетная» карточка RTX 3070 всего на десяток процентов производительнее флагмана предыдущего поколения (вдвое меньшую стоимость мы пока опустим), рынок по-настоящему нуждается в этих видеокартах.

Давайте немного проанализируем, чем меряются производители пользовательского железа на своих презентациях, то есть каких «попугаев» для демонстрации своего превосходства они используют.

Если говорить о процессорах и видеокартах, то главным аргументом любого спикера, прогуливающегося по сцене и представляющего новый продукт публике, будет размер техпроцесса и количество логических и прочих ядер. Сколько потоков, какой термопакет у нового камня, какую систему охлаждения придумали прикованные к батареи дизайнеры в недрах компании.

Само собой, идет абстрактное сравнение «производительности» с оборудованием конкурентов и с оборудованием собственного производства, но предыдущего поколения. Все это придает презентации фактуры и заставляет аудиторию качать головой в такт увещеваниями спикера.

На самом деле, тут иронии минимум. Компании на самом деле добиваются впечатляющих результатов по всем этим параметрам. Особенно радует TDP процессоров «красного лагеря»: AMD последовательно увеличивает производительность своих «камней», при этом удерживаясь в стандартном термопакете уровня 65-105 Вт. Это позволяет не городить огромные системы охлаждения, как во времена «электровафельниц» поколения FX, неадекватно большой термопакет которых стал легендой.

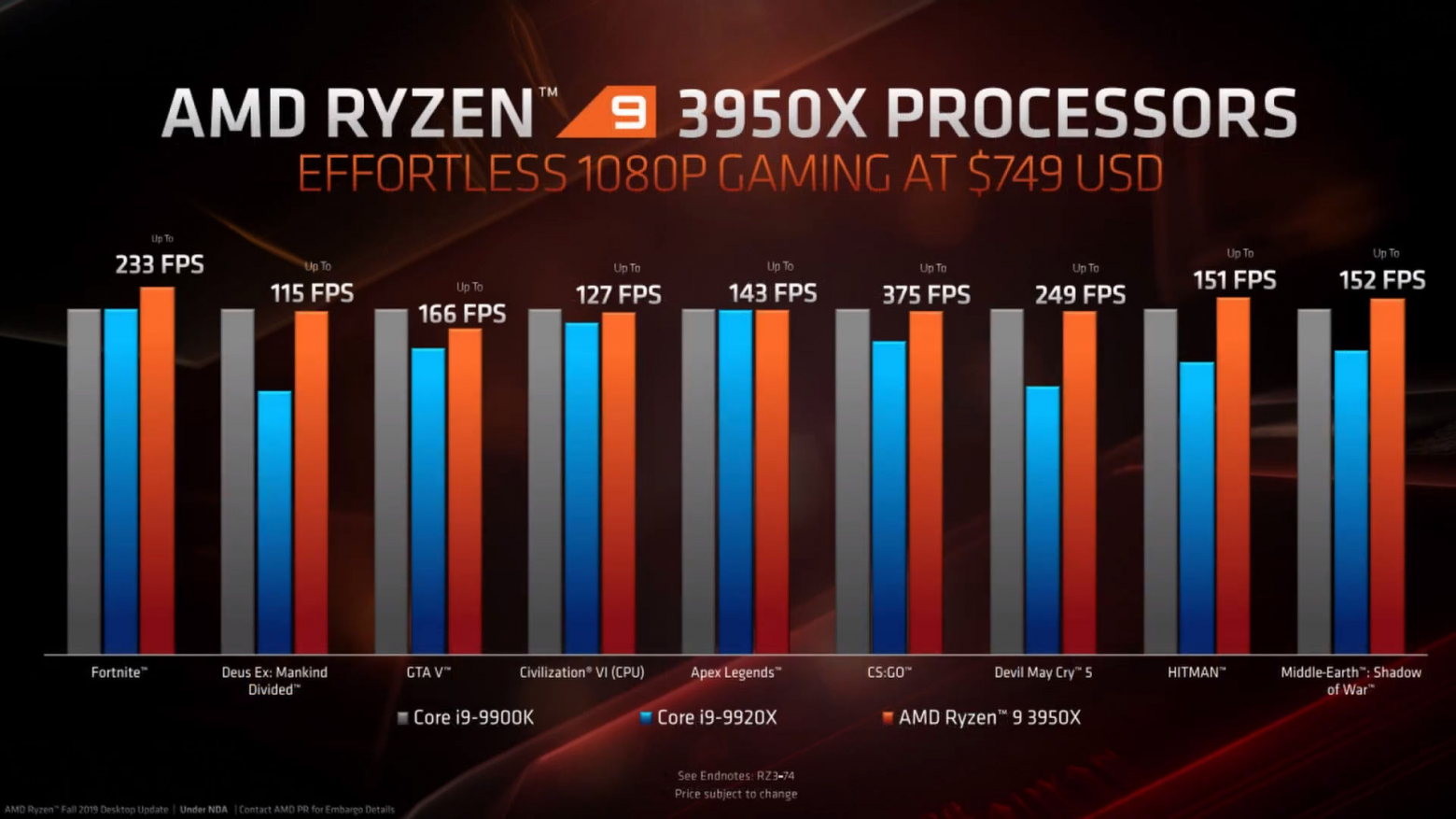

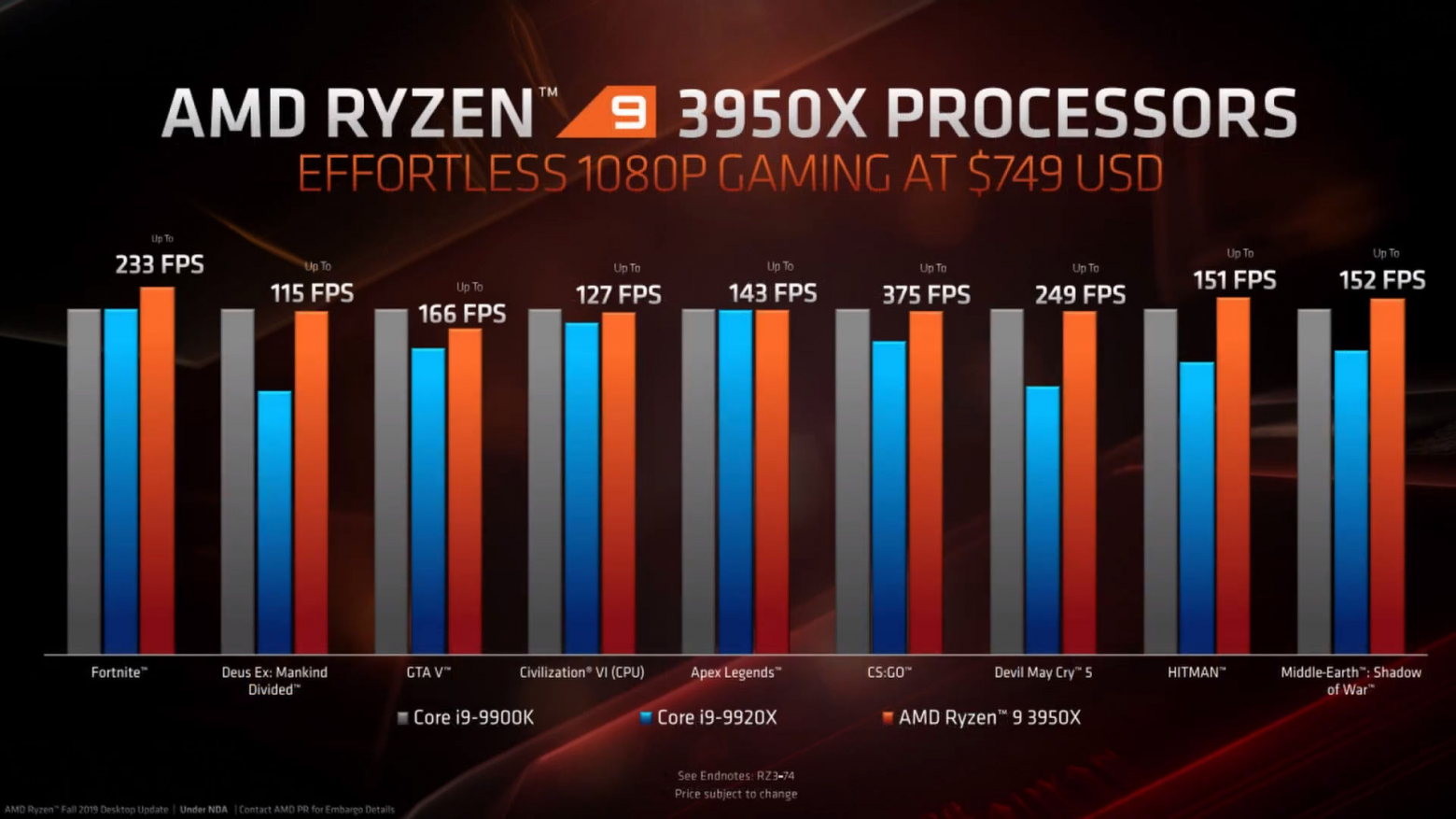

А вот этот параметр всегда стоит отдельно. Как это не удивительно, но и на презентации центральных процессоров, и на презентации видеокарт всегда показывают количество кадров в секунду в самых последних и популярных играх. Вот, последние годы от презентации к презентации мелькают Fortnite, Call of Duty, Battlefield, Apex Legends, Control — короче, все те игры, которые на максимальных настройках графики делают видеокарте больно. Вот в этом году «делали больно» в разрешении 8к.

Для закрепления можно показать точно такой же по своей сути слайд с презентации процессоров Ryzen 5000 серии, которая прошла около двух недель назад:

И все эти столбцы всегда выглядят очень красиво и приятно. С каждым поколением производительность видеокарт и центральных процессорах в играх растет, а именно для игр это железо, в основной своей массе, и производится. Вот только все не так просто.

Одна из главных причин, по которой геймеры всего мира бросились заказывать новые RTX 3080 и RTX 3090 в надежде заполучить карточку любой ценой не в тупости этих самых геймеров, и даже не в желании «опробовать революционные 8к» и так далее. Главная причина — желание получить хоть сколько-нибудь стабильную производительность, которая бы соответствовала бы возможностям современной периферии, в первую очередь, мониторам.

Для людей, далеких от игровой индустрии расскажу одну тайну: 60 FPS уже давно не стандарт. Да, почему-то на презентациях производители до сих пор говорят о «стабильных 60 кадрах в секунду», как будто бы эта производительность дает идеальный игровой опыт, но суть в том, что на рынке игрового оборудования уже давным-давно доминируют мониторы с частотой обновления экрана в 144 Гц, а на пятки им, стремительно дешевея, наступают мониторы с частотой 240 Гц.

Это значит, что для плавной картинки на этих экранах нужен и соответствующий FPS: 144 и 240 кадров соответственно.

И вот тут кроется корень проблем всей индустрии. Если раньше высокогерцовые экраны были прерогативой киберспорта, игроков в CS:GO и Quake, то теперь 144 Гц есть у любого уважающего себя игрока. 60 кадров остались в далекой древности: сейчас это стандарт для бюджетных «офисных» мониторов, потому что частота в 144 Гц дает ощутимое преимущество.

Описать на словах эффект от высокогерцового монитора сложно, но я попробую: представьте, что все внезапно стало двигаться чуть медленнее и намного плавнее. В движении пропадает эффект размытия и вы начинаете замечать малейшие детали. Вращение камеры вокруг своей оси больше не вызывает дезориентацию, вы продолжаете четко видеть окружающий персонажа мир. На рабочем столе движение курсора теперь намного более явно: если на 60 Гц при резком движении мышью вы зафиксируете взглядом курсор мыши в 5-6 местах, то уже на 144 Гц вы увидите его одновременно в 15-20 точках. На 240 Гц экранах эффект еще более впечатляющий, вы буквально взглядом сможете зафиксировать весь путь курсора мыши на высокой скорости. Для иллюстрации хорошо подходит знаменитый кадр из CS:GO, который демонстрирует разницу в тикрейтах сервера. Примерно то же происходит на высокогерцовых мониторах в плане отрисовки движения:

Именно поэтому, для четкого отображения происходящего в малейших деталях, все геймеры планеты уже плавно перешли на 144 и 240 Гц дисплеи, а кто не перешел — либо мечтает перейти, либо играет исключительно в пасьянс.

Но при этом нас до сих пор настойчиво убеждают, что 60 FPS — достаточное значение производительности. На этот параметр ориентируются разработчики игр, ориентируются производители железа. Однако как только речь заходит о работе игры в стабильных 144 FPS или, боже упаси, 240 FPS, пусть и на минимальных настройках графики, начинает происходить непонятное: ни одно существующее оборудование не может толком справиться с этой задачей.

Давайте возьмем две самые «косорукие» игры современности в плане перфоманса: Call of Duty: Warzone и Apex Legends. Обе делались совершенно разными студиями. Первая — производства Activision Blizzard, вторая — Respawn Entertament под патронажем Electronic Arts. Обе из популярного жанра Battle Royale, обе имеют обширные карты и огромную фанбазу.

Для обоих игр буквально с момента их релиза инженеры Nvidia истерично клепают патчи видеодрайвера, чтобы хоть как-то заставить их работать. Именно инженерные команды драйверописателей уж точно в курсе, что игрокам глубоко плевать на 60 FPS, вертикальную синхронизацию и все то, что увеличивает инпутлаг. Им нужны максимально высокие стабильные кадры хотя бы на топовых видеокартах.

Если вы не верите этому утверждению, можете погуглить сами: в сети сотни статей о повышении FPS в Call of Duty и Apex Legends, сотни тредов о конфигах, которые бы уменьшали графику или убирали «лишние» модели для снижения нагрузки на видеокарты, а так же масса рассказов о шаманизме, разгоне железа и прочих плясках с бубном.

Просадки производительности в топовых онлайн-играх, особенно в динамичных шутерах — болезненная реальность игровой индустрии последних лет. Разработчики буквально забивают болт на производительность своих продуктов за пределами 60 FPS и включенной вертикальной синхронизации, которая погружает камеру в «кисель» и создает чудовищный инпутлаг, чем вынуждают игроков вкладываться во все более и более мощное оборудование.

Скажу больше, все настолько плохо, что RTX 2080 Ti в указанных играх способны выдавать стабильные 144-190 кадров в секунду только при минимальных конфигурациях графики, но даже при этом иногда случаются дропы FPS! Любая граната, блик или огонь в кадре — и все, ваши фреймы машут вам рукой и говорят «ну, как это закончится, наберешь», FPS проседает до сотни.

Ситуация достигла уже такой шизы, что Nvidia приходится на своем официальном сайте выпускать официальные гайды по настройке видеокарты и графики в игре, чтобы выжать из нее необходимые комфортные для игроков значения кадров!

Именно по этой причине значительная часть геймеров и ломанулась покупать новые RTX 3080 и RTX 3090, просто в надежде, что уж на этих-то картах любимые игры смогут работать стабильно хотя бы на минимальных настройках графики.

Сейчас рынок находится буквально в западне. С одной стороны с каждым годом выходит все более и более мощное оборудование. Банально память DDR4-1600, которая лет пять назад считалась «неплохой», сейчас уже перешла в категорию «медленной офисной», а топовые когда-то DDR4-2400 сейчас просто середняк. То же происходит с процессорами, видеокартами, скоростью дисков и так далее и так далее.

Неискушенному пользователю, далекому от гейминга, может показаться, что конфигу��ации из i9-10900k, DDR4-3200, разогнанной до 4000 Mhz, все это с быстрым SSD и RTX 2080 Ti должно хватать для чего угодно на ультра настройках, но правда в том, что эта конфигурация с трудом обеспечивает 144-200 FPS в новых проектах. Вычеркните из списка выше любую составляющую и вставьте что-то «попроще и дешевле», например, RTX 2060S или core i7, и показатели кадров упадут минимум на 30%.

И виной всему не жадность производителей оборудования, а именно косорукость разработчиков и жажда наживы их издателей.

На тестирование и оптимизацию потребления ресурсов в 2019-2020 годах в индустрии был забит настолько большой болт, что будь он реальным, его было бы видно с МКС. Самый лучший пример, это сравнение Apex Legends и предыдущей игры Respawn Entertament — Titanfall 2.

Первая делалась в спешке, под постоянным давлением со стороны издателя, который бубнел над ухом команды разработки «нам срочно нужен свой батлрояль со скинами и лутбоксами». В итоге мы получили перспективный в плане геймплея проект (он опирается на многие механики и лор Titanfall 2), с абсолютно нулевой оптимизацией и отвратительным неткодом.

Titanfall 2, который вышел в 2016 году, почти всегда выглядит лучше и работает в разы стабильнее даже на средних конфигурациях железа, нежели быстро слепленный ради создания конкуренции PUBG и Fortnite модный Apex Legends. Не знакомый с проектами человек вообще посчитает, что Apex вышел в 2015-2016 году, а Titanfall 2 — свежий релиз, если показать их ему одновременно, хотя все с точностью, да наоборот.

Та же мрачная история происходит и с Call of Duty и прочими свежими проектами. Потребитель превратился в бесконечного бета-тестера, которому постоянно приходится выбирать между покупкой нового, более мощного железа, либо лагами.

Кстати, именно по этой причине многие с сомнением смотрят на будущее новых Xbox и PS5: если даже современные ПК толком не справляются с современными играми, то что смогут консоли? Будут ли сетевые кроссплатформенные проекты достаточно оптимизированными для игры в них? Опыт PS4 Pro и Call of Duty или Apex Legends показывает, что консоли банально не справляются с продуктами, которые почти полностью состоят из кода сомнительного качества. А про размеры Call of Duty в 200+ Гб уже просто ходят легенды.

Я надеюсь, что когда-нибудь Nvidia надоест тратить силы и ресурсы на выпуск бесконечных патчей драйверов, которые улучшают производительность в проблемных популярных играх. За последние два-три года, с ростом популярности Fortnite, Apex Legends и Call of Duty Warzone компания-производитель оборудования выпустила столько патчей драверов и технологий, которые бы улучшали перфоманс в этих проектах (чего стоит хотя бы Nvidia Reflex, которая значительно снижает инпутлаг в Apex Legends и Warzone программным путем), что начинает кружится голова. Я за этот срок обновлял драйвера чаще, чем за предыдущие 10 лет вместе взятые.

Абсолютно привычная картина при входе в NVIDIA GeForce Experience

Выход из этой ситуации видится только один. Прекратить порочную практику «тяп-ляп и в проду, а Nvidia потом выкатит оптимизационный патч» возможно только в случае, если сами Nvidia объявят, что разработчики игр ведут себя, мягко говоря, нехорошо, и забили болт на оптимизацию. Должна случиться еще одна война в стиле «Epic Games VS Apple» только в этом случае с одной стороны будет производитель видеокарт, а с другой — игровые издатели, которые стоят с плетью и погоняют разработчиков, требуя от них новых лутбоксов и сезонов в ущерб качеству фундаментального кода.

Но случится это, только если Nvidia наконец-то пересилит свое желание продать как можно больше флагманских карт и выступит против творящейся в игровой индустрии вакханалии, у нас есть шанс получить нормальную производительность в игровых проектах и отсутствие ажиотажного спроса на новые модели видеокарт.

Вот только верится в это с трудом.

Причем просто на завышенных относительно оглашенных на презентации ценах проблемы с новыми RTX не заканчиваются. Так, один из официальных торговых партнеров MSI был уличен в спекуляции новыми видеокартами на онлайн-аукционах, а сами Nvidia заявляют, что купить по адекватной стоимости новые RTX 3080 и RTX 3090 можно будет не раньше следующего года. При этом релиз и поступление в продажу самой «вкусной» карточки RTX 3070 было вовсе отложено на две недели, с 15 на 29 октября 2020 года.

Человек, далекий от ПК-гейминга и релизов флагманских моделей железа справедливо спросит: «вы там что, совсем кукухой поехали? Какие 1200-1500$ за видеокарту? Какой ажиотажный спрос? Что вообще происходит?» Так вот, сейчас я, автор статьи, объясню, почему Nvidia столкнулась с таким ажиотажем вокруг RTX 3000 серии и почему геймеры с нетерпением ждут поступления в продажу этих видеокарт по заявленной стоимости.

То что RTX 3000 серии — геймерские карты ни у кого сомнений не вызывает. Для вычислений и науки у Nvidia давно есть карты серии Tesla V100 и Tesla A100. Это мощные графические ускорители за тысячи долларов, задача которых крайне проста и очевидна — считать. Причем считать, в основном, всякие «научные штуки» в составе вычислительного кластера. Новые A100, которые сейчас поступают в ограниченный тест, по заверениям Nvidia вовсе в 6 раз производительнее далеко не слабой V100. Собственно, о возможностях этих карт можно судить по официальным спецификациям с сайта Nvidia:

Говорю я о семействе ускорителей Tesla по одной причине: архитектура Ampere. Именно она лежит в основе графических ускорителей Tesla и до этого момента карточки на Ampere стоили до $10 тыс. и имели весьма узкую специализацию. В первую очередь, ускорители Ampere были направлены на тренировку нейросетей и по заверениям производителя справлялись с этой задачей на порядки лучше, чем другие решения. По официальным данным, карты на базе Ampere ускорили обучение нейросетей до 20 раз.

Но тут Nvidia выпускает потребительские видеокарты для геймеров с использованием той же технологии. Это как если бы Intel с 2016 года клепал серверные процессоры на литографии в 2 нм для суперкомпьютеров, каждый из которых стоил бы $10 тыс. и более, а тут внезапно вбросил бы новую серию Intel Core по $500 за штуку на той же технологии. Очередь бы выстроилась знатная.

Для Nvidia все выглядело красиво: больше мощностей по меньшей, по сравнению с триумфальной серией RTX 2000, цене, «научная» архитектура в компьютерах геймеров, поддержка большего разрешения и так далее и так далее. Вот только в коридорах Nvidia не ожидали, насколько потребитель нуждается в мощной видеокарте и что RTX 2080 Ti уже давно не удовлетворяет всех потребностей рынка.

Хотя RTX 3000 серии не показывает кратного превосходства над RTX 2080 и RTX 2080 Ti, а гряду��ий хит продаж — «бюджетная» карточка RTX 3070 всего на десяток процентов производительнее флагмана предыдущего поколения (вдвое меньшую стоимость мы пока опустим), рынок по-настоящему нуждается в этих видеокартах.

Давайте немного проанализируем, чем меряются производители пользовательского железа на своих презентациях, то есть каких «попугаев» для демонстрации своего превосходства они используют.

Нанометры, число ядер, частоты, TDP и так далее

Если говорить о процессорах и видеокартах, то главным аргументом любого спикера, прогуливающегося по сцене и представляющего новый продукт публике, будет размер техпроцесса и количество логических и прочих ядер. Сколько потоков, какой термопакет у нового камня, какую систему охлаждения придумали прикованные к батареи дизайнеры в недрах компании.

Само собой, идет абстрактное сравнение «производительности» с оборудованием конкурентов и с оборудованием собственного производства, но предыдущего поколения. Все это придает презентации фактуры и заставляет аудиторию качать головой в такт увещеваниями спикера.

На самом деле, тут иронии минимум. Компании на самом деле добиваются впечатляющих результатов по всем этим параметрам. Особенно радует TDP процессоров «красного лагеря»: AMD последовательно увеличивает производительность своих «камней», при этом удерживаясь в стандартном термопакете уровня 65-105 Вт. Это позволяет не городить огромные системы охлаждения, как во времена «электровафельниц» поколения FX, неадекватно большой термопакет которых стал легендой.

FPS в играх

А вот этот параметр всегда стоит отдельно. Как это не удивительно, но и на презентации центральных процессоров, и на презентации видеокарт всегда показывают количество кадров в секунду в самых последних и популярных играх. Вот, последние годы от презентации к презентации мелькают Fortnite, Call of Duty, Battlefield, Apex Legends, Control — короче, все те игры, которые на максимальных настройках графики делают видеокарте больно. Вот в этом году «делали больно» в разрешении 8к.

Для закрепления можно показать точно такой же по своей сути слайд с презентации процессоров Ryzen 5000 серии, которая прошла около двух недель назад:

И все эти столбцы всегда выглядят очень красиво и приятно. С каждым поколением производительность видеокарт и центральных процессорах в играх растет, а именно для игр это железо, в основной своей массе, и производится. Вот только все не так просто.

Почему все геймеры мира хотят оторвать разработчикам игр руки

Одна из главных причин, по которой геймеры всего мира бросились заказывать новые RTX 3080 и RTX 3090 в надежде заполучить карточку любой ценой не в тупости этих самых геймеров, и даже не в желании «опробовать революционные 8к» и так далее. Главная причина — желание получить хоть сколько-нибудь стабильную производительность, которая бы соответствовала бы возможностям современной периферии, в первую очередь, мониторам.

Для людей, далеких от игровой индустрии расскажу одну тайну: 60 FPS уже давно не стандарт. Да, почему-то на презентациях производители до сих пор говорят о «стабильных 60 кадрах в секунду», как будто бы эта производительность дает идеальный игровой опыт, но суть в том, что на рынке игрового оборудования уже давным-давно доминируют мониторы с частотой обновления экрана в 144 Гц, а на пятки им, стремительно дешевея, наступают мониторы с частотой 240 Гц.

Это значит, что для плавной картинки на этих экранах нужен и соответствующий FPS: 144 и 240 кадров соответственно.

И вот тут кроется корень проблем всей индустрии. Если раньше высокогерцовые экраны были прерогативой киберспорта, игроков в CS:GO и Quake, то теперь 144 Гц есть у любого уважающего себя игрока. 60 кадров остались в далекой древности: сейчас это стандарт для бюджетных «офисных» мониторов, потому что частота в 144 Гц дает ощутимое преимущество.

Описать на словах эффект от высокогерцового монитора сложно, но я попробую: представьте, что все внезапно стало двигаться чуть медленнее и намного плавнее. В движении пропадает эффект размытия и вы начинаете замечать малейшие детали. Вращение камеры вокруг своей оси больше не вызывает дезориентацию, вы продолжаете четко видеть окружающий персонажа мир. На рабочем столе движение курсора теперь намного более явно: если на 60 Гц при резком движении мышью вы зафиксируете взглядом курсор мыши в 5-6 местах, то уже на 144 Гц вы увидите его одновременно в 15-20 точках. На 240 Гц экранах эффект еще более впечатляющий, вы буквально взглядом сможете зафиксировать весь путь курсора мыши на высокой скорости. Для иллюстрации хорошо подходит знаменитый кадр из CS:GO, который демонстрирует разницу в тикрейтах сервера. Примерно то же происходит на высокогерцовых мониторах в плане отрисовки движения:

Именно поэтому, для четкого отображения происходящего в малейших деталях, все геймеры планеты уже плавно перешли на 144 и 240 Гц дисплеи, а кто не перешел — либо мечтает перейти, либо играет исключительно в пасьянс.

Но при этом нас до сих пор настойчиво убеждают, что 60 FPS — достаточное значение производительности. На этот параметр ориентируются разработчики игр, ориентируются производители железа. Однако как только речь заходит о работе игры в стабильных 144 FPS или, боже упаси, 240 FPS, пусть и на минимальных настройках графики, начинает происходить непонятное: ни одно существующее оборудование не может толком справиться с этой задачей.

Давайте возьмем две самые «косорукие» игры современности в плане перфоманса: Call of Duty: Warzone и Apex Legends. Обе делались совершенно разными студиями. Первая — производства Activision Blizzard, вторая — Respawn Entertament под патронажем Electronic Arts. Обе из популярного жанра Battle Royale, обе имеют обширные карты и огромную фанбазу.

Для обоих игр буквально с момента их релиза инженеры Nvidia истерично клепают патчи видеодрайвера, чтобы хоть как-то заставить их работать. Именно инженерные команды драйверописателей уж точно в курсе, что игрокам глубоко плевать на 60 FPS, вертикальную синхронизацию и все то, что увеличивает инпутлаг. Им нужны максимально высокие стабильные кадры хотя бы на топовых видеокартах.

Если вы не верите этому утверждению, можете погуглить сами: в сети сотни статей о повышении FPS в Call of Duty и Apex Legends, сотни тредов о конфигах, которые бы уменьшали графику или убирали «лишние» модели для снижения нагрузки на видеокарты, а так же масса рассказов о шаманизме, разгоне железа и прочих плясках с бубном.

Просадки производительности в топовых онлайн-играх, особенно в динамичных шутерах — болезненная реальность игровой индустрии последних лет. Разработчики буквально забивают болт на производительность своих продуктов за пределами 60 FPS и включенной вертикальной синхронизации, которая погружает камеру в «кисель» и создает чудовищный инпутлаг, чем вынуждают игроков вкладываться во все более и более мощное оборудование.

Скажу больше, все настолько плохо, что RTX 2080 Ti в указанных играх способны выдавать стабильные 144-190 кадров в секунду только при минимальных конфигурациях графики, но даже при этом иногда случаются дропы FPS! Любая граната, блик или огонь в кадре — и все, ваши фреймы машут вам рукой и говорят «ну, как это закончится, наберешь», FPS проседает до сотни.

Ситуация достигла уже такой шизы, что Nvidia приходится на своем официальном сайте выпускать официальные гайды по настройке видеокарты и графики в игре, чтобы выжать из нее необходимые комфортные для игроков значения кадров!

Именно по этой причине значительная часть геймеров и ломанулась покупать новые RTX 3080 и RTX 3090, просто в надежде, что уж на этих-то картах любимые игры смогут работать стабильно хотя бы на минимальных настройках графики.

Это не заговор, это нулевая культура разработки

Сейчас рынок находится буквально в западне. С одной стороны с каждым годом выходит все более и более мощное оборудование. Банально память DDR4-1600, которая лет пять назад считалась «неплохой», сейчас уже перешла в категорию «медленной офисной», а топовые когда-то DDR4-2400 сейчас просто середняк. То же происходит с процессорами, видеокартами, скоростью дисков и так далее и так далее.

Неискушенному пользователю, далекому от гейминга, может показаться, что конфигу��ации из i9-10900k, DDR4-3200, разогнанной до 4000 Mhz, все это с быстрым SSD и RTX 2080 Ti должно хватать для чего угодно на ультра настройках, но правда в том, что эта конфигурация с трудом обеспечивает 144-200 FPS в новых проектах. Вычеркните из списка выше любую составляющую и вставьте что-то «попроще и дешевле», например, RTX 2060S или core i7, и показатели кадров упадут минимум на 30%.

И виной всему не жадность производителей оборудования, а именно косорукость разработчиков и жажда наживы их издателей.

На тестирование и оптимизацию потребления ресурсов в 2019-2020 годах в индустрии был забит настолько большой болт, что будь он реальным, его было бы видно с МКС. Самый лучший пример, это сравнение Apex Legends и предыдущей игры Respawn Entertament — Titanfall 2.

Первая делалась в спешке, под постоянным давлением со стороны издателя, который бубнел над ухом команды разработки «нам срочно нужен свой батлрояль со скинами и лутбоксами». В итоге мы получили перспективный в плане геймплея проект (он опирается на многие механики и лор Titanfall 2), с абсолютно нулевой оптимизацией и отвратительным неткодом.

Titanfall 2, который вышел в 2016 году, почти всегда выглядит лучше и работает в разы стабильнее даже на средних конфигурациях железа, нежели быстро слепленный ради создания конкуренции PUBG и Fortnite модный Apex Legends. Не знакомый с проектами человек вообще посчитает, что Apex вышел в 2015-2016 году, а Titanfall 2 — свежий релиз, если показать их ему одновременно, хотя все с точностью, да наоборот.

Та же мрачная история происходит и с Call of Duty и прочими свежими проектами. Потребитель превратился в бесконечного бета-тестера, которому постоянно приходится выбирать между покупкой нового, более мощного железа, либо лагами.

Кстати, именно по этой причине многие с сомнением смотрят на будущее новых Xbox и PS5: если даже современные ПК толком не справляются с современными играми, то что смогут консоли? Будут ли сетевые кроссплатформенные проекты достаточно оптимизированными для игры в них? Опыт PS4 Pro и Call of Duty или Apex Legends показывает, что консоли банально не справляются с продуктами, которые почти полностью состоят из кода сомнительного качества. А про размеры Call of Duty в 200+ Гб уже просто ходят легенды.

Как это изменить

Я надеюсь, что когда-нибудь Nvidia надоест тратить силы и ресурсы на выпуск бесконечных патчей драйверов, которые улучшают производительность в проблемных популярных играх. За последние два-три года, с ростом популярности Fortnite, Apex Legends и Call of Duty Warzone компания-производитель оборудования выпустила столько патчей драверов и технологий, которые бы улучшали перфоманс в этих проектах (чего стоит хотя бы Nvidia Reflex, которая значительно снижает инпутлаг в Apex Legends и Warzone программным путем), что начинает кружится голова. Я за этот срок обновлял драйвера чаще, чем за предыдущие 10 лет вместе взятые.

Абсолютно привычная картина при входе в NVIDIA GeForce Experience

Выход из этой ситуации видится только один. Прекратить порочную практику «тяп-ляп и в проду, а Nvidia потом выкатит оптимизационный патч» возможно только в случае, если сами Nvidia объявят, что разработчики игр ведут себя, мягко говоря, нехорошо, и забили болт на оптимизацию. Должна случиться еще одна война в стиле «Epic Games VS Apple» только в этом случае с одной стороны будет производитель видеокарт, а с другой — игровые издатели, которые стоят с плетью и погоняют разработчиков, требуя от них новых лутбоксов и сезонов в ущерб качеству фундаментального кода.

Но случится это, только если Nvidia наконец-то пересилит свое желание продать как можно больше флагманских карт и выступит против творящейся в игровой индустрии вакханалии, у нас есть шанс получить нормальную производительность в игровых проектах и отсутствие ажиотажного спроса на новые модели видеокарт.

Вот только верится в это с трудом.