Комментарии 327

По поводу курсора на десктопе — брехня. Я когда Wacom Cintiq начал юзать, меня курсор страшно бесил. Полез разбираться — скорость отрисовки аппаратного курсора не связана с частотой обновления экрана и определяется спецификациями каких-то тараканьих годов. По моим наблюдениям — порядка 15 герц, вне зависимости от того, что S3 Trio 3D у вас, или Nvidia RTX100500.

- Мы говорим про аппаратный курсор видеокарты, не про софтовый (как во многих играх)

- Посмотрите в slow-mo, так, чтобы можно было посчитать задержку между движениями курсора.

Возможно, дело в удалении trail'а (послесвечении). Я не про это. Я про фактическое движение. Я начинал с этим разбираться в линуксах, потом проверил — в виндах и на маке одно и то же.

Ощущаться оно может как угодно, но если там те же 15 fps, то толку от 144.

С большой вероятностью, вы видите эффект от black фреймов (или как они там называются), которые уменьшают послесвечение.

Записал сейчас сло-мо, пошевелил курсором — да, как раз 15 кадров в секунду.

Т.е. я про это с криком "брехня" и говорю. А главное, в играх уже, вон, 144, и 250Гц, а десктопный курсор всё так же застрял в VESA 800x600x256 цветов, 15 fps, какая ляпота.

Вы явно дезинформацию пишете. В Windows (за старую XP не скажу, там ещё окошки программно рисуются) указатель рисуется в зависимости от герцовки выставленной монитору в системе. В интернете на специализированных сайтах полно доказательств этому.

В Linux/MacOS понятия не имею как с этим.

Возьмите телефон, сделайте slowmo для движения курсора. (Я про обычный десктопный курсор, не в играх).

На моём 60Гц мониторе получилось ровно 60 кадров в секунду, ЧЯДНТ? https://www.youtube.com/watch?v=vW8gEJ_oavI

(видео местами дёргается потому что мой телефон зачем-то снимает 77 кадров в секунду)

Я открыл плеер с функцией прыжков по кадрам (vlc, 'E'). Проверил.

И, кажется, мне очень стыдно. Я вычел один тайминг из другого и получил… 17. Не фреймов. Милисекунд. Кажется, я просто забыл поделить на единицу.

Мне стыдно.

Интересно, на 144/250Гц мониторе курсор двигается с задержками в 7/4 ms?

Hint: на ютубе тоже можно двигаться по кадрам, тыкая в точку на клавиатуре)

На самом деле по сравнению с моими экспериментами, главное — вы таймер на экран вывели. Я кропел над формулами fps'ов с slow-мо и забыл поделить. Получилось 16-17 (что логично было округлено до 15). Это были милисекунды, но я решил, что это fps.

Видимо, если на 250Гц мониторе быстрый курсор, то я становлюсь фанатом 250Гц мониторов. Потому что 60Гц для рисования никак не хватает.

Если штрихуешь, это порядка 2-5 штрихов в секунду. 60 fps = до 12 кадров на штрих. Если штрих хотя бы 10см (забыли про пикселы), то при условии, что штрих "разгоняется/замедляется", положения курсора выглядят так:

* * * * * * * * *(я сократил число точек, чтобы влезло в одну строку).

Страшно бесило. Да, 60 fps уныло.

Последние iPad не думали приобрести?

Там же принудительная ОС в комплекте. Спасибо, не надо.

Потому что если подёргать курсор на экране (особенно, на 25"+), то будет полная иллюзия, что это 15 фпс. Очень рябит.

А вы в настройках ОС-то включили частоту обновления 144 Гц? Она автоматически не обновляется с 60 при смене монитора.

Я вот долго не мог понять, что означает столь популярное «мыло». И до сих пор не уверен, что правильно понимаю.

На частоту обновления координат курсора сообщаемых операционной системой приложениям его отображение не влияет и зависит от поддерживаемой частоты опроса устройства ввода, мыши, трекпада, планшета. Как правило она значительно выше.

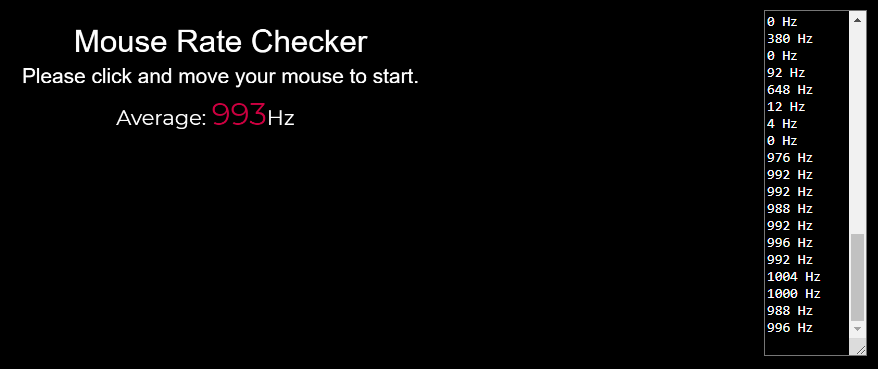

Если у вас курсор обновляется с частотой в 15 кадров в секунду при вводе с Wacom Cintiq, то это проблема исключительно Wacom Cintiq или его драйверов. Можете убедиться в этом хотя бы тут zowie.benq.com/ja/support/mouse-rate-checker.html, сравнив его с нормальной мышью с частотой в 1000Hz.

Частота опроса не связана с частотой отрисовки, но результат отрисовки зависит от частоты опроса. Если устройство ввода предоставляет данные с частотой всего 15 Гц, то отличаться между собой результаты отрисовки будут тоже только 15 раз в секунду, а остальное время будут повторяться.

Отрисовываться будет, а вот сдвигаться в сторону будет не чаще, чем 15 раз в секунду. Т.е. если refresh ratio (условные) 150Гц, то движение курсора будет происходить не чаще, чем раз в 10 кадров.

Enjoy.

В треде выше выяснили — это моя ошибка деления. 15мс vs 15 fps.

Я теперь фанат 250Гц.

При этом частота опроса порта — стандартные 125 Гц.

Отрисовка курсора происходит аппаратно, на каждом кадре. Но положение курсора меняется не более чем 15 раз в секунду. Просто возьмите вашу тысячегерцовую мышку, повозюкайте на вашем 250Гц экране, запишите видео в slow-mo и увидьте самые что ни на есть посконные 15Гц, которые выглядели удивительно хорошо для VESA 640x480, и даже для 1024x768.

Т.е. ввод у вас на ТЫЩУ герц в секунду. Вывод на 250Гц, а обновление — пятнадцать раз в секунду. Не нравится? Отключайте курсор. Именно так я и сделал в krita при рисовании. Я отключил курсор, и krita была способна рисовать размытые сложные текстуры кисти быстрее, чем видеокарта показывала курсор.

И API отрисовки курсора насрать сколько у вас герц. Сказали 15, значит 15.

Как видите на обычном офисном компьютере с Windows 10 курсор вполне себе перемещается 60 раз в секунду. У нас в 2020-м ваши проблемы давно решены.

Это интересно. Вы делали screen capture? Я смотрел на slow-mo и считал задержку между прыжками курсора. У меня получалось 60ms.

Т.к. аппаратный курсор не захватывается с экрана (его нет на bitmap пикселей), то его "пририсовывают" по текущему положению при захвате (для этого есть спецопция — показывать курсор). Может ли быть так, что его пририсовывают чаще, чем видеокарта отрисовывает?

Даже если и может, я вот заснял монитор камерой телефона, и всё равно получилось 60 раз в секунду https://habr.com/ru/company/dcmiran/blog/524256/#comment_22212908

Но визуальные эффекты вызываемые курсором отрисовываются только, если сам курсор отрисовывается на них. Иное поведение сильно бросалось бы в глаза и раздражало бы пользователя как «тормознутость» интерфейса.

Я вижу, что вы уже нашли источник ошибки в определении частоты отрисовки вашего курсора и дополнительные доказательства вам уже вряд ли требуются.

Сто, двести мегабайт?

Кстати для улучшения восприятия мегабайта: 1 мегабайт ~= 1 книга в 300..400 страниц.

То есть 3.5 мегабайта ~= 1 x "Война и мир".

А эта, с картинками, скриптами и камментами — как увесистая книжная полка.

Такие дела.

Хотя даже без картинок много весит, это бесспорно) У меня был «проект» (эксперимент) — страница в 1 пакет (1500б с учётом заголовков после gz). Продуктовая ценность сомнительна, но как челлендж)

Если лет пять назад ругались на кликбейтные гифки по мегабайту весом, то как я заметил, сейчас перестали стесняться даже встройки рекламных видеороликов на 30-50 мегабайт.

p.s.: То что есть ноуты со 120гц и выше на родном мониторе — знаем, речь именно про возможность подключения большго внешнего телека (по хдми) или монитора (по хдми или дп).

Вот в играх да.

Стоит ли оно того _только_ для этих кейсов — вопрос философский (по-моему, не очень; а вот для игр, даже несоревновательных — да, разница невероятная), но разница есть.

а в ютубе видео максимум 60 фпс по-моемуЕсли открыть 60фпс видео и включить скорость 2х, то будет 120, утверждают.

в CSGO есть серваки с 128 hz тикрейтомВот это уже интересно, почитаю, спасибо.

в автосимуляторах физика на клиенте считаетсяЕсли это лишь для красоты ОК, иначе прямой путь для читеров.

позволяет лучше определить нахождение и скорости противниковВсе эти параметры приходят с сервера, если же игра пытается интерпретировать положение игрока то получится, что на клиенте вы выстрелили в противника, а для сервера это ещё/уже пустое место — вы уверены, что попали, а сервер говорит «мимо». Я не прав?

Расскажу на примере движка Source. На клиенте и сервере есть все игровое состояние, клиент выполняет некоторую интерполяцию (если пинг совсем уж большой, то даже екстраполяцию). Также, клиенту известно что находится сзади игрока, то есть если вы повернётесь назад то вы увидите что там есть (или было на сервере несколько мгновений тому). И сможете среагировать на чувака, который на вас целится.

А теперь перейдём к самому интересному: стрельбе. Когда вы стреляете, то вы отправляете эту команду на сервер, сервер знает пинг и временно «в уме» возвращает всех игроков в те позиции, которые были когда клиент стрелял. То есть, если клиент попал, то независимо от ринга он реально попадёт. А вот если в вас стреляли, вы спрятались за стену, то не факт что вы живы — есть небольшой промежуток времени (100-200 миллисекунд) когда вас могли убить.

Подробнее можете почитать здесь: https://developer.valvesoftware.com/wiki/Source_Multiplayer_Networking

Если просчёт идёт на строне игрока — это прямой путь к читерству, тем более, что у кого-то 150 fps, а у кого-то 30 и синхронизироать их практически невозможно.

По приведённой ссылке как раз и описываются методы компенсации сервера, просчитывающего положения игроков 10 раз в секунду.

Частота кадров играет роль. Как минимум, при большей частоте кадров меньше задержка между тем игровым состоянием и рендером на экране. Если брать в пример киберспорт, то на чемпионатах используется локальная сеть, поэтому пинг — абсолютно не проблема. Если пользовательский сегмент — просто плавнее всё.

Частота кадров играет роль. Как минимум, при большей частоте кадров меньше задержка между тем игровым состоянием и рендером на экране.А игры до сиз пор однопоточные? О_о

Если на сервере просчёт идёт условно 10-20 раз в секунду, я не понимаю как это снизит задержку между игровым состоянием и рендером, который и так обновляется 60 раз в секунду, ну будет обновляться 144, и? Синхронизация с сервером то всё равно в большинстве случаев реже.

Следовательно, если на сервере всё считается 10 раз в секунду, на клиенте будет достаточно 10 кадров, верно?

Мы сильно переплачиваем даже за 60 Hz мониторы

Не так часто просчёт на сервере идёт 10-20 раз, разве что медленных играх, к примеру в Minecraft — 20 раз в секунду. Но в быстрых играх эти значения намного выше — в CS GO 64 или 128 тиков за секунду. Рендер не всегда рендерит актуальное состояние, происходит например интерполяция (плавное перекрещение между предыдущим и следующим состоянием происходит несколько кадров) и у вас плавнее картинка.

Если я сейчас на ютубе посмотрю несколько видео стримеров по CS:GO или летсплейщиков я точно ни разу не увижу ситуацию когда они выстрелили точно в противника, а пуля/снаряд/что-то ещё прошли насквозь так как серверная коллизионная модель не совпала с клиентской?

Речь в оригинальной статье шла же только о волшебном мире топовых видеокарт в связке с 144 Гц мониторами, и автор ни разу не обмолвился, что для он-лайн игроков скорость просчёта на сервере может быть даже важнее, а в идеале она должна быть более-менее синхронна частоте кадров.

Кроме прочего, просто движущийся предмет при слежении за ним глазами размывается обратно пропорционально ФПС (посмотрите на тот же «НЛО-тест»).

Еще в играх навроде CS:GO ввод обрабатывается в каждом кадре, т.е. выше фпс == меньше инпут лаг. Поэтому все отключают v-sync и ограничение по фреймам, и рендерят 300-400 фпс, хоть монитор и отдает 144.

Прицеливание локальноеИ поэтому в некоторых играх можно включить серверный прицел?

Локальное прицеливание — открытая дорога для читеров с автовыцеливанием уязвимых зон. Если это так, в CS:GO играть я бы не хотел.

Что такое серверный прицел? Вы про hit reg? Это конечно на сервере.

(Ну и да, вы бы не хотели играть в CS:GO безотносительно. Никто бы не хотел. Просто соревновательных шутеров-то не делают, вот и насилуем потихоньку труп с графикой родом из 2004.)

Никто бы не хотел. Просто соревновательных шутеров-то не делают, вот и насилуем потихоньку труп с графикой родом из 2004Неправда, отличная игра.

Соревновательные шутеры делают — Apex Legends, R6: Siege, Valorant, в конце концов Diabotical и Quake Champions живые. Вот только КС лежит в практически идеальной нише easy to learn — hard to master, который делает её практически «непобедимой» с т.з. и простоты вовлечения игрока, и простоты вовлечения зрителя, если мы говорим о киберспорте.

Я ж её тоже люблю, классная игра. Сделайте мне такую же точно, но с графикой! Нет, вот тебе вместо этого Overwatch, который по сути Дота от первого лица, и вот тебе еще Fortnite, где противник превращается после одного выстрела в девятиэтажный дом.

Беда печаль.

Нет, прицеливание как процесс происходит локально.Можно я с вами не соглашусь, потому как это сильно зависит от реализации игры.

В некоторых играх, где авторы заморочились над античит-системой прицел целиком серверный. Клиент отправляет смещение мыши в условных попугаях (10 вверх, 4 влево), сервер рассчитывает относительно своих данных куда смотрит прицел и высылает клиенту фактическое положение. Процесс может быть асинхронный для компенсации больших пингов, но тогда должна выполнятся периодическая процедура синхронизации.

Если прицеливание будет целиком на клиенте — можно написать программу, которая всегда будет выцеливать уязвимые места противника в пределах видимости.

можно написать программу, которая всегда будет выцеливать уязвимые места противника в пределах видимости.Вы-таки не поверите, но как бы вы ни делали популярную сетевую игру, если в ней в принципе можно читерить (а серверсайд хитрег вас не спасёт от читерства, совсем не спасёт), вам надо будет озаботиться античитом.

Ну а если сервер-сайд расчёты не помогают, то тогда и делать их не стоит, пусть всё считает клиент, правда ведь?

Серверсайд-хитрег не всегда нравится и игрокам в том числе, это вполне буквально вопрос вкуса и конкретных ситуаций, возникающих в игре, прочих аспектов её не кода.

Ещё раз — в шутере разница между клиентсайд-хитрегом и серверсайд-хитрегом как раз совершенно несущественная для читеров — ну будут они попадать не 100% выстрелов, а 95-97% выстрелов, грубо говоря — и на разработку читов влияет примерно никак (найти в памяти или даже на экране модельку вообще не проблема — я знаю людей, которые делали POC чита-эймбота для шутера через распознавание изображения нейронкой), а на их эффективность, как я выше и сказал, минимально влияет. Разница между честным игроком и читером не станет из-за этого существенно меньше. Нужен нормальный античит.

я знаю людей, которые делали POC чита-эймбота для шутера через распознавание изображения нейронкой

Давно интересовало — есть аппаратные устройства типа usb2kbd, которые имитируют клавиатуру и позволяют даже через сеть посылать движения мышкой/нажимание клавиш.

А какие есть аппаратные устройства дл перехвата монитора?

А если мы говорим о софте, то фрейм буфер считать вроде не сложно, было бы желание.

Гм, а банальный сплиттер сигнала видеокарты — не оно? :)

Видимо, оно и есть, спасибо :).

В BF3 тоже всегда отображалось положение прицела взятое с сервера, а не клиентское, но как там синхронизировалось — не разбирался, а потом и не играл уже.

Много нареканий было на стрелялку в духе Сталкера (Сурвариум кажется), жалобы из серии «урон не прошёл» это было в каждом видео по этой игре именно из-за подобной схемы, когда сервер и клиент считали положение игроков и прицелы асинхронно.

В целом если поискать по server-side reticle / crosshair можно найти много интересного.

Первое что нагуглевал — в WOT это по дефолту выключено, т.е. клиент все равно отображает свой прицел, а в момент выстрела берется серверный (и это вызывает фрустрацию у чуваков на форуме).

Интересно, конечно.

Первое что вспоминается — все игры Wargaming с их «server side reticle»Эти игры — буквально единственное, что гуглится по «server side reticle/crosshair», ага. И там, в отличие от шутеров, невозможен ~моментальный разворот камеры/прицела на произвольный угол (потому что у танковой башни в WoT ограниченная скорость вращения, у персонажа в КСах, Апексах, Овервотчах и прочих Квейках — нет). И в обычных шутерах такое не используется, более того, банально неприменимо как раз потому, что фликшоты с разворотами на 90+ градусов являются допустимыми и у честных игроков. Серверсайд-хитрег используется, но про него я тоже написал в других комментариях.

Ну и да, в танках используется serverside reticle, а вот serverside crosshair ничего полезного не выдаёт в гугле, кроме тех же танков (а если отфильтровать их, остаются фанаты выживалок и симуляторов, спрашивающие, как на серверах отключить прицел ради реализма, а не что-то, имеющее отношение к дискуссии).

TL;DR:

1. Высокая частота очень сильно влияет на прицеливание.

2. Разница 60/144, естественно, более заметна, чем 144/240.

3. Чем хуже вы играете, тем больше прирост.

www.youtube.com/watch?v=OX31kZbAXsA

Да просто видишь больше, при обычных 30-45 ФПС видны детали сцены только когда камера неподвижна, поворачиваешь персонажа по сути вслепую, "по памяти". А на 144 ФПС обзор не теряется. Легко заметить поиграв во что — то динамичное, мне дум етернал в этом плане нравится. Если ограничить ФПС на 45 — играть в него практически невозможно, не попадаю :(

И даже если играем по сети — то с низким ФПС противник может попасть в поле зрения в тот момент как я начал поворачивать (т.е., на сервере его движение отработано нормально и он меня увидел), но т.к. я не заметил его за один-два кадра и уже начал двигаться и не могу ничего различить в быстром движении из-за низкого фреймрейта — теряю его, а с высоким фреймрейтом он бы дольше оставался в моём поле зрения и я б его увидел.

Я не могу понять, почему прогресс произошел ВНЕЗАПНО? Ещё в начале 2000х на ЭЛТ- мониторах во все шутеры играли на 100+ ФПС и прекрасно движки HL, Q3 и UT с этим справлялись даже не на топором железе. За 20+ лет ничего не изменилось — во все сетевые шутеры по-прежнему играют на 100+фпс, а для разработчиков таикх игр это слато откровением?

Пледиком надо укрываться сидя не перед ним а за ним. Туда защиту не ставили

Пример apex legends и call of duty warzone в качестве плохо оптимизированной игры некорректно, это одни из самых хороший оптимизированных игр с точки производительности (не считая качество серверов и вылеты warzone). Apex выглядит намного лучше чем 5-ти летний titanfall 2, и работает тоже очень хорошо. В call of duty каждые 3 месяца графику ухудшают, за счет чего растет фпс, хотя игра выглядит заметно хуже чем на момент выхода, но работает получше.

144 hz нужно только заядлым геймерам или для тех кто играет в киберспортивные игры на победу. В остальном 60 hz вполне хватает.

Единственно исключение в этом году это doom ethernal — игра является одной из самых красивых на текущий момент, но при этом выдает спокойно более 100 кадров на средних машинах, загрузка с контрольной точки происходит за 5 секунд(в других играх это может быть и 30 и 60 секунд) на HDD, и игру уже запускали в 1000 фпс. Не уверен что существует другая игра которая поддерживает 1000 фпс.

144 hz нужно только заядлым геймерам или для тех кто играет в киберспортивные игры на победу. В остальном 60 hz вполне хватает.

Звучит как BMW и Mercedes нужны только заядлым гонщикам и тем кто на работу опаздывает, остальным хватит и ВАЗ 2106.

В общем это вот ваше "хватит", у всех разное. И многим хочется комфорта вне зависимости от профессии. Я вот ни разу не гонщик и даже не профессиональный водитель, но предпочту ездить на BMW, а не на ВАЗ-2106, которого (если судить по вашему) вполне хватит ездить на работу...

Затем, что когда-то давно ездил на 2106 и мне было "вполне хватит", а потом поездил на более хорошей машине и 2106 стало уже "не очень".

Тоже самое и здесь, разница не только в скорости, но и в комфорте.

144 даже в обычной работе за компом заметно комфортнее.

Но конечно же будет толпа людей утверждающих, что и 60 хватает для всего)

Как и раньше была толпа утверждающая, что SSD нужен только серверам для скорости, а дома и на HDD хорошо. И т.д. и т.п.

Пример apex legends и call of duty warzone в качестве плохо оптимизированной игры некорректно, это одни из самых хороший оптимизированных игр с точки производительности (не считая качество серверов и вылеты warzone)

То есть постоянные лаги, телепорты, дропы ФПС на топовом железе при минимальных настройках — это для вас "хорошо оптимизированная игра"? Почему?

Если вы хотите пример хорошей оптимизации — посмотримте на Overwatch. Он ухитряется выдавать 60fps даже на видеокарте 740M (мобильной, Карл!), а на 1070 на medium 200+

Apex в это время на 1070 даёт едва ли 100 на минималках

На счёт Apex вы ошибаетесь. Играю год на gtx 970. На почти максималках 60 кадров спокойно выдает. На средне — высоких 100+.

Статейка написана с точки зрения какого-то ничтожного меньшинства игроков, которое «уже давно» играет на мониторах с частотой 144, а то и 240 Гц и жаждет отдать кучу денег за топовое железо.

Подавляющее большинство игроков, будем откровенны, устраивает 60 FPS. Я уже не говорю про пользователей консолей.

Я сильно сомневаюсь, что в двойном слепом тесте поклонники экстремальных фреймрейтов отличат 100 FPS от 200.

Я сильно сомневаюсь, что в двойном слепом тесте поклонники экстремальных фреймрейтов отличат 100 FPS от 200.

На самом деле не зря сомневаетесь.

Если быть максимально точным, то наше зрение не работает в «кадрах в секунду». Это аналоговая система, которая очень упрощенно состоит из двух компонентов: глаза и мозг.

Глаза сбрасывают информацию в мозг по «наполнению» палочек и колбочек, мозг эту информацию анализирует и обрабатывает.

Предельная частота кадров, которые мы способны различить и распознать ограничивается двумя вещами:

1) Характеристиками картинки.

2) Характеристиками мозга.

Если картинка статичная или с крайне медленным движением — ожидаемо, что разницы между 30/60/144/220 Герцами никакой не будет. А вот со вторым пунктом уже чуть сложнее: система аналоговая, если что-то не успело обработаться целиком — оно может обработаться частично и очень упрощённо. Поэтому, в случае типичного человека 80-140 Герц это та максимальная частота кадров в секунду, на которых он может отчётливо различать движение (то есть полностью обрабатывать картинку). Но при этом некоторые люди испытывают дискомфорт от работы с теми же самыми OLED-дисплеями на низких уровнях подсветки и с «медленным» ШИМ. Всё дело в том, что хоть мозг, обычно, не способен полностью обрабатывать смену картинки с частотой выше 140 Герц; но глаз то способен скидывать эту информацию значительно чаще. В итоге мозг перенапрягается в попытке переварить вот это всё, не справляется, скипает и получается дискомфорт выходным сигналом. Глаза же начинают скипать информацию начиная с 1 кГц.

Поэтому лично у меня есть предположение, что единственным способом в слепом тесте определить где 120 Гц, а где 240 Гц (отбросив влияние ШИМ подсветки, если он есть) является возможное появление чувства дискомфорта на более высокогерцовом мониторе.

Вы имеете в виду пропадание чувства дискомфорта на высокогерцовом мониторе?

Нет, я максимально чётко обозначил границу, на которой мозг может полностью обрабатывать сменяющиеся кадры: 140, ну 150 Герц. Всё что находится выше уже не может полноценно обрабатываться мозгом и потенциально может вызывать дискомфорт. Именно по этой причине у некоторых людей вызывают дискомфорт OLED дисплеи с 200Гц ШИМом подсветки.

Поэтому он после 140 Гц может появиться, а пропасть лишь на 1 кГц, так как именно выше этой частоты пасуют уже глаза.

Так всё наоборот, дискомфорт появляется от слишком медленного обновления.

Нет, не так. Если у вас будет слишком медленное обновление, то начиная с определённого порога кадров в секунду мозг будет рассматривать это как набор картинок, а не непрерывное изображение. Ну и плюс от лагов, фризов и плавающей частоты будет дискомфорт у геймера, но это по другому каналу.

И 240 фпс и 240 гц ШИМ — это совершенно разные вещи

Ну да, совершенно верно. Одно это частота кадров в секунду (или скорость в футах в секунду), а другое это широтно-импульсная модуляция.

а ШИМ на 60Гц был бы просто настолько очевидно невыносим, что никто в здравом уме его не стал бы делать.

Как вам сказать… Лампы накаливания, например. Мерцание там компенсируется инерцией спирали накаливания. Электролюминисцентные лампы из-за выпрямителя работают на 100 Гц, например.

ШИМ 240гц же будет выглядеть так

Кажется, вы не очень ясно себе представляете что такое ШИМ. Вы сейчас показали пример для 25% яркости экрана. Так сильно уменьшать подсветку ШИМом явно никто не будет.

а потому что при движении глазами или такого предмета в поле зрения он разваливается на отдельные «скриншоты» и чувствительным людям это доставляет неприятные ощущения, дискомфорт, тошноту и утомление.

Не разваливается он на отдельные скриншоты. Мозг по прежнему формирует единую картинку из движения, но при этом не может полноценно обработать моменты с выключенной подсветкой, в итоге перенапрягается и начинает вырабатывать выходной сигнал «дискомфорт». Потому что глаза это мерцание заметить могут.

А способ отличить более высокие герцы в том, что движущийся объект на высокой частоте кадров будет сохранять чёткость и будет больше похож на объект в реальном мире — меньше блюра, меньше скачки между отдельными кадрами, как здесь:

Я выше уже сказал: мозг (по крайней мере обычного человека) не будет способен в полной мере обрабатывать картинку с частотой выше 140 Гц. Поэтому всё то, что выше 140 Гц с точки зрения восприятия именно целостности будет неотличимо.

Вы сейчас показали пример для 25% яркости экрана. Так сильно уменьшать подсветку ШИМом явно никто не будет.

Я на своём ноутбуке примерно такую яркость и держал — если больше, то глазам уже слишком ярко. И таки да, через фотики был отчётливо виден 300Гц ШИМ

Я на своём ноутбуке примерно такую яркость и держал — если больше, то глазам уже слишком ярко.

Если честно, то я не видел пока таких ноутбуков у которых минимальная яркость была бы именно на 25%. Хотя я может и упустил, но в лучшем случае это одна треть от максимальной.

И таки да, через фотики был отчётливо виден 300Гц ШИМ

Как определили? :)

в лучшем случае это одна треть от максимальной.

Ну, я точных замеров яркости не проводил, но по ощущениям минимально возможная яркость у моего ноута ну очень тёмная — даже ночью в полностью тёмной комнате трудно что-то разглядеть (а выставление нулевой яркости выключает подсветку полностью)

Как определили? :)

Ставим достаточную выдержку (1/50 или типа того), рисуем на экране белую линию на чёрном фоне и фоткаем её, одновременно двигая фотик поперёк линии. Если ШИМ отсутствует, то получится сплошная размазня; если ШИМ есть — получится несколько чётких копий линии (насколько чётких, зависит от уровня яркости). Сравнив число получившихся линий с выдержкой фотика и сделав несколько фоток для уменьшения погрешности, можно примерно прикинуть частоту

(Здесь мог быть спойлер с примером такой фотки, но мой HDD с фотками сдох, фотика под рукой прямо сейчас нет, а на телефон сфоткать не получается по причине его кривости, эх)

Ну, я точных замеров яркости не проводил, но по ощущениям минимально возможная яркость у моего ноута ну очень тёмная — даже ночью в полностью тёмной комнате трудно что-то разглядеть (а выставление нулевой яркости выключает подсветку полностью)

Ну да, нулевая яркость иногда отключает подсветку полностью, но без промежуточных шагов. Но в целом ок, я вас понял. Погуглил и правда есть ноуты у которых минимальная яркость — четверть от максимальной.

Ставим достаточную выдержку (1/50 или типа того),

Не, всё ок. Просто я видел как люди пытались определить частоту ШИМа подсветки с помощью «включаем камеру на телефоне и смотрим в дисплей» :)

Да и эти пороги изучены ещё со времен немого кино и (внезапно) мозг воспринимает как движущуюся картинку уже начиная от 12-16 кадров

Вообще это связано в том числе с расходом плёнки на минуту/час.

а устаканившийся стандарт в кино 24к/с был чуть ли не избыточным хай фиделити поначалу

Эррм, не хотелось бы расстраивать, но увеличение частоты кадров в звуковом кино после немого было связано с необходимостью писать звук.

А стандарт в 24 к/с был выбран исходя из опять же расхода плёнки.

Частоты телевизионных картинок 25/30 к/с вообще связаны с частотой сети.

И какое это отношение имеет к современным проблемам с ШИМом, где пробелы ничем не компенсируются и поэтому-то и стали заметны глазом и мешать?

А чем оно компенсируется в «энергосберегайках»? :)

А как по-вашему уменьшается яркость подсветки в современных устройствах с ШИМом?

Так же как и в любом другом устройстве — скважностью.

какой по-вашему диапазон регулирово яркости в современных девайсах

Зависит в том числе и от ШИМа, так как производители прекрасно понимают эту проблему.

Нет никакой «полной меры обработки картинки» в мозгу

Ну нет так нет.

это всё будет прекрасно видно

То есть ШИМ не видно, а всё остальное прекрасно видно? Ну ок.

реальном мире никакой дискретности нет.

Собственно я про это и говорил.

Почитайте уже какую-нибудь существующую теорию по вопросу, прежде чем придумывать свои предположения про разделение обработки в глазах и мозгах и процессинг в «кадрах в секунду»

В том то и проблема, что как раз я читал. При этом эта теория никак не была связана со 100500 герцовыми мониторами. И даже сейчас эти исследования тоже есть, можете ознакомиться, но будете разочарованы.

процессинг в «кадрах в секунду»

Самое что смешное — именно в этом и измеряют в этих исследованиях. Или в герцах. Или в миллисекундах. Потому что в любом случае физически это всё сводится к «способен ли мозг обработать все изменения за отведённое время».

Результат один: если нечто, что мы видим, длится менее N миллисекунд — мы не способны это распознать целиком. И даже заметить.

P.s. я вам тут ещё пищи для размышления подброшу: в среднем в человеческой популяции не видят и не различают картинки короче 20 мс. Таким образом для многих людей хватит порядка 45 кадров в секунду. А 60 так вообще за глаза doi: 10.3758/APP.71.4.860

Можете дать обзор в двух словах, что именно в этой статье измеряют и обнаруживают?

Серьёзно? То есть вы мне рассказываете что я не читал научные статьи по теме и при этом просите меня кратко пересказать содержимое этой статьи?

Т.е. глазом вот такую картинку увидеть невозможно и курсор мыши вообще должен становиться невидимым при движении, ведь даже на 60гц он отображается в каждой позиции всего на 16мс.

Нет, не так. Просто в обработанном изображении курсор будет где-то в среднем положении на этих кадрах. Как повезёт.

Но если при этом перемещении взять и вообще убрать курсор мышки (и даже выключить экран) на время менее 13 мс — средний представитель человеческой популяции не заметит потери бойца.

Но если вы будете дёргать мышкой слишком быстро — начиная с определённой скорости её и правда можно будет не заметить. Такие дела :(

Поэтому то я и крайне скептически отношусь к тому, что кто-нибудь из тут присутствующих будет в силах правильно выбрать между 144 и 220 Гц монитором в двойных слепых тестированиях.

Если это не пилот истребительной авиации, правда. Некоторые из них по результатам уже других тестирований, могут замечать, отображать и адекватно обрабатывать в том числе и объекты и картинки на времена вплоть до 2мс.

что я прав

Ну ок.

Единственное принципиальное отличие «недостаточной плавности картинка на 144 Гц» от «бескислородная медь улучшает качество звука» в том, что в мире действительно есть исчезающе малый процент людей, которые могут заметить разницу между 144 и 220 Гц.

О чём я и написал чуть выше)

Но если бы вы действительно читали хоть какие-то исследования, то скорее всего бы знали что в качестве единиц измерения там применяются FPS/Hz/время. Потому что это легко конвертируемые друг в друга величины.

есть исчезающе малый процент людей, которые могут заметить разницу между 144 и 220 Гц.Если у вас есть под рукой 144Гц монитор, то попробуйте поделать быстро горизонтальную «восьмёрку» курсором на белом фоне. Если я не попал случайно в этот самый «исчезающие малый процент», то и вы увидите довольно чётко отдельные положения курсора.

я вам тут ещё пищи для размышления подброшу: в среднем в человеческой популяции не видят и не различают картинки короче 20 мсПосиди несколько минут в тёмной комнате, после чего включи на 1мс в ней свет. Будешь сильно удивлён результатом.

У человека — аналоговое зрение, и оно вполне способно различать даже отдельные фотоны.

Да что там вспышки 1мс, люди видят стробоскопический эффект ШИМа до 10кГц, но нет, оказывается в мозгу какой-то есть по-кадровый процессинг, который ограничивает восприятие картинок до 20мс :)

Р — релевантность.

Непонятно какая группа людей непонятно какого возраста видела/осознавала (а это точно научное исследование?) мерцание натриевой газоразрядной лампы высокого давления мощностью 250 Вт с вероятностью 0...20% :)

даже отдельные фотоны.

Ух, надо срочно останавливать разработку приборов ночного видения, тем более там прогресс уже достаточно давно встал)

я максимально чётко обозначил границу, на которой мозг может полностью обрабатывать сменяющиеся кадры: 140, ну 150 Герц. Всё что находится выше уже не может полноценно обрабатываться мозгом и потенциально может вызывать дискомфорт

Почему же дискомфорт? Наоборот, дискомфорт отсутствует когда мозг/глаз перестаёт различать кадры и видит непрерывный видеопоток. В реальности "кадры" то меняются за планковское время но мозг от этого не вскипает ведь. Так что да, от герцовки выше 144 пользы маловато, но вреда и дискомфорта уж точно нет (при том же качестве изображения конечно, многие высокочастотные мониторы грешат плохой цветопередачей и ШИМом).

планковское время

так в том и проблема, что они не меняются.

Почему же дискомфорт?

Ну конкретно в нескольких исследованиях, в том числе вроде и в том, на которое я давал ссылку в этом треде, была эта информация.

ШИМом

Как связано наличие/отсутствие ШИМа в подсветке (и его частота) и герцовка монитора? :)

Большая зависимость от углового размера изображения (от размера экрана). Чем больше экран, тем лучше видна прерывистость движения.

Угловой размер изображения и размер экрана это таки две разные величины. Связаны они будут лишь при неизменном расстоянии до монитора (что, к слову, тоже может быть не очень физиологично и вызывать дискомфорт).

Но вы в данном случае говорите о переферийном зрении (для которого важен как раз таки угловой размер), которое и правда может работать чуть быстрее основного поля, так как там и так часть информации скипается мозгом на «дефолтных настройках». Но работать это будет лишь на участках работы периферийного зрения.

А смысл покупать монитор побольше, и ставить его подальше, оставляя тот же угловой размер? Люди вольны конечно так делать, но всё же кажется, что многие покупают мониторы больше, чтобы получить большую площадь (и я в их числе)

Чтобы вместить на них больший объём информации(большая площадь же). Или чтобы увеличить комфортное расстояние для просмотра. Или чтобы уменьшить вертикальные/горизонтальные прокрутики.

То есть чтобы увеличить физические размеры или сохранить угловые.

Если купить побольше, поставить подальше, сохранив угловой размер — то почему будет больше информации входить?

В моём случае потому что теперь текст и окна там масштабируется не за счёт рендеринга в более высоком разрешении с последующим даунскэйлом и выводом в штатное разрешение монитора; а рендеринг в штатном и вывод в штатном.

Ну и как бы «из коробки» у винды нет варианта рендерить в масштабе, меньшем чем 100%.

Ну и да: рендерить в большем разрешении, а потом даунскэйлить до меньшего это в любом случае ущерб резкости.

Т.е. вы в конечном итоге просто уменьшили элементы интерфейса и размер текста, а то, что новый монитор больше и стоит дальше — это такой physics based даунсемплинг просто? :)

Ну типа того, да. С рендерингом и отображением в нативном разрешении.

Именно для этого и покупался большой монитор в этом случае.

Важно, что большой и маленький монитор на одинаковом расстоянии потребуют разной частоты обновления изображения для создания одинакового восприятия движущихся изображений. Чем больше изображение, тем больше будет расстояние между точками отображения объекта, который «движется» по экрану. На экране смартфона кино в 24 к/с выглядит более плавным, чем на пятидесятидюймовом телевизоре. Поэтому, в частности, пришлось придумывать «уплавнители» картинки.

. Вы, видимо, хотите сказать, что размер объекта и его угловой размер меняются произвольно при изменении расстояния? Я не знаю, как это работает в вашей голове, но речь не об этом.

Элементарно работает. Увеличивая размер объекта и отодвигая его, мы сохраняем его угловой размер неизменным. Увеличивая размер объекта и не перемещая его мы увеличиваем его угловые размеры. Не трогая размер объекта и пододвигая его мы увеличиваем его угловые размеры.

Именно об этом я и написал.

Важно, что большой и маленький монитор на одинаковом расстоянии потребуют разной частоты обновления изображения для создания одинакового восприятия движущихся изображений.

Нет не потребуют, пока не будет задействовано периферийное зрение.

На экране смартфона кино в 24 к/с выглядит более плавным, чем на пятидесятидюймовом телевизоре.

Зависит от угловых размеров и того и другого. Но в общем случае нет.

Поэтому, в частности, пришлось придумывать «уплавнители» картинки.

«Уплавнители» картинки появились как следствие желание получить 100500 кадров в секунду при непонимании матчасти. Ну то есть в следствие маркетинговых запросов.

Ещё автор забывает упомянуть о цветопередаче этих быстрых мониторов.

А то что у нас там 8 миллионов пикселей рендер которых надо уместить в 0.007 секунды — это пофиг. И 8 миллионов если у нас идеально отработал клиппинг. А клиппинг у нас тоже в эти 0.007 секунды входит.

Ну да, ну да. Это разработчики тупые уроды, а не пользователи охренели со своими запросами.

UPD: Ну и в целом автор несет ахинею.

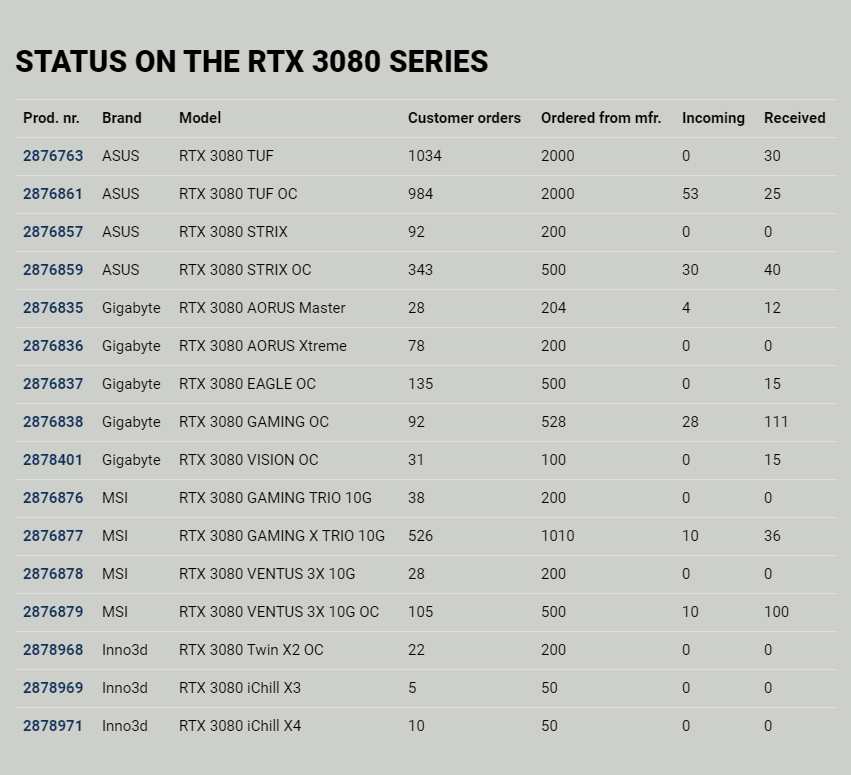

Причина дефицита не в том, что все хотят карты. А в том что их нет.

В Россию всех типов 3080 на момент старта продаж завезли 110 штук. НА ВСЮ РОССИЮ.

Вот вам причина дефицита.

Причина дефицита не в том, что все хотят карты. А в том что их нет.

В Россию всех типов 3080 на момент старта продаж завезли 110 штук. НА ВСЮ РОССИЮ.

У меня тут есть скриншот из одного норвежского магазина, весьма показательно

Согласен, но с разработчиков тоже не стоит снимать вину. За последние годы состояние игр которые релизят сильно отличается (в худшую сторону) от того что было раньше. Считается нормальным релизить сырую игру, а потом выпускать патч за патчем чтобы фиксить баги, которые должны были быть пофикшены до релиза.

Ой да ладно. Помнится, я такое нытье читал уже в Game.EXE образца 2001 года. Собственно как только появилась техническая возможность делать и сравнительно легко доставлять патчи пользователям, так и пошла эта тема с патчингом того, что не успели сделать до релиза.

К тому же сейчас (за последние 20 лет) сильно изменился способ продажи игр. Когда продажи были дисками, то после выхода диска уже ничего не исправить (а издатели и тогда хотели "вчера" и "побольше" — это не изменилось). То есть не было ни финансовой мотивации сделать еще лучше, ни, собственно, вменяемого канала доставки до игрока. Ну и, соответственно, исправлялось только в ОЧЕНЬ удачных играх. Сейчас часто носителя нет совсем, а игры так или иначе приносят доход не только в момент установки, да даже если не приносят деньги, то патч не будет стоить производства нового тиража. Поэтому новые версии технически можно клепать хоть раз в неделю.

Да, так при выпуске игры можно пойти разумные на компромиссы по производительности, но можно и починить их, если будет пользователь. Грань здесь достаточно тонкая, конечно, но того кошмарного "выпустили DVD, защитили от копирования, продали, а там критическая ошибка в конце игры" — этого теперь нет.

Ах эти косорукие разработчики игр. Пишут эти игры своими косорукими руками. А вот не писали бы — не было бы ажиотажа, нормально бы все было.

Давно такого бреда не читал.

Вот, последние годы от презентации к презентации мелькают Fortnite, Call of Duty, Battlefield, Apex Legends, Control — короче, все те игры, которые на максимальных настройках графики делают видеокарте больно

простите, что?

Fortnite, Apex Legends — чистый мультиплеер с батлроялем. Их никто не будет делать так чтоб они делали видеокарте больно. Их цель — нормально работать на как можно большем числе машин. Фортнайт это вообще мультик, он на встроеной видяхе должен на ультрах идти

Call of Duty, Battlefield — понятия не имею. Но если судить по видосам на ютубе, больно пятая батла делает только глазам игроков.

Control — вообще коридорные побегушки в закрытых помещениях, чему там болеть? Чай не опенворлд на пару километров отрисовать.

Прекратить порочную практику «тяп-ляп и в проду, а Nvidia потом выкатит оптимизационный патч»

Nvidia объявят, что разработчики игр ведут себя, мягко говоря, нехорошо, и забили болт на оптимизацию

выступит против творящейся в игровой индустрии вакханалииА Вы точно осознаете, сколько GPU нужно выполнить вычислений, что бы сгенерировать качественное по современным меркам изображение (напомню, даже на «устаревших» 60 Гц на это есть всего 16 миллисекунд)? Или просто нужно было срочно написать какую-нибудь желтуху?

И чем больше ассортимент устройств, на которых планируется запускать игру, тем хуже она будет работать на каждом из них.

Конечно, разработчики могут заранее ограничить круг поддерживаемых устройств, заявив к примеру, что игра заработает только на платформе x86, только под Windows 10 с DX12 и только на карточках NVidia (AMD, Intel — лесом) серий не ниже 2080Ti. Тогда всё будет быстро. Но во-первых геймеры же первыми взвоют, что разработчики охренели для любого тетриса топ-девайс требовать, а во-вторых, это ещё и плохо скажется на продажах игры.

А видеокарточки — так универсальные графические API мало того, что давно изобрели, так к ним уже давно все привыкли, и спускаться ниже — это больше геморроя для геймдева, а не меньше. Драйвера обеспечивают совместимость видеокарт (и их низкоуровневой архитектуры) с этими API, которые все юзают — DX12, Vulkan.

Комментировать поток мыслей по основному тезису статьи не буду — здесь уже достаточно комментариев на эту тему. Автор живёт в какой-то параллельной реальности.

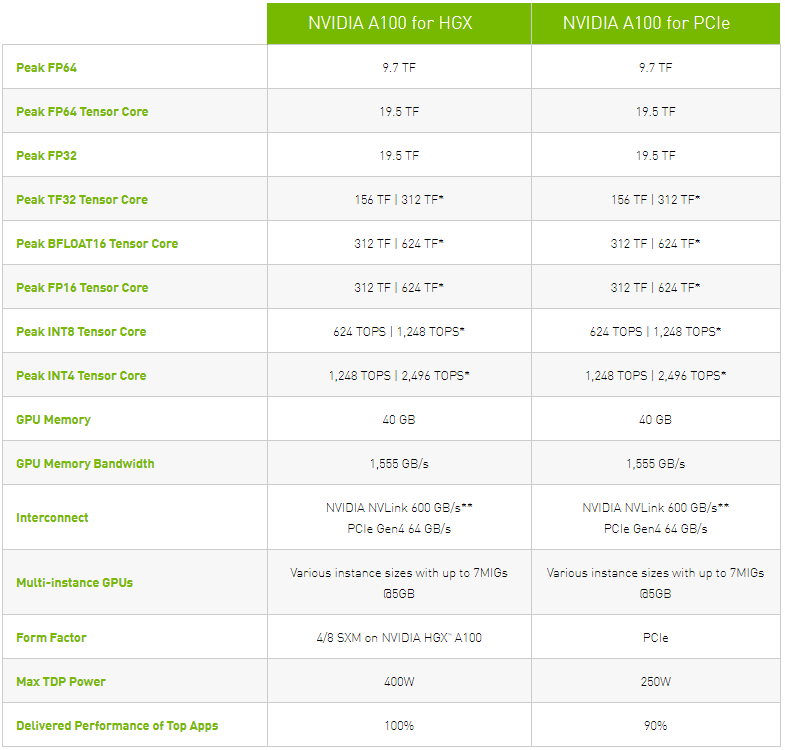

Но вот что эти карточки только для игр, а не для вычислений — это ещё один миф. Те кто не сидят в облаках и кому нужно тренировать нейросети вполне себе используют consumer-grade GPUs — это в разы дешевле с минимальными просадками по производительности в single и half precision по сравнению с топовыми "научными" GPU.

Мы в какой-то момент закупились 1080ti в наши сервера и это покрыло требования целого рисёч юнита в GPU вычислениях.

А как у вас дела обстоят с лицензированием драйверов на nVidia в серверах?)

А с этим есть какая-то проблема? Мы ставим CUDA с официального сайта на линукс и считаем свои сетки. Если там есть какие-то ограничения, то нам о них никто не рассказал.

Ну так мы же не датацентр. И вообще сомнительно что без явного определения что является датацентром они смогут кому-то что-то предъявить в суде по этому пункту.

Но сам факт существования таких пунктов показывает насколько сообществу нужны решения с опенсорсными драйверами — а то купил железку, а пользоваться ей можно только по велению левой пятки компании производителя и только в правильную фазу луны.

Обычно все оправдания сводятся к «ну вот посмотри белый круг на черном фоне скачет, видишь в 60fps плавнее». опустим в сторону холивар о том, сколько людей реально видят разницу 30/60, а сколько верят, что видят (это на 2000 комментов тут будет), вопрос, окей, разница предположим есть, она действительна стоит чтобы переплачивать и гнаться за прогерссом и тп? 8к эти тоже у меня вызывают смех до колик, т.к. не на всяком видео я 720 от 1080 отличу (окей, на каких-то возможно, но в среднем по палате — нет).

Так для чего эта гонка? для собственного успокоения «я теперь не вижу разницы между 100фпс и 1000фпс»? что плохого в том чтобы видеть низкий фреймрейт? Это кому-то эстетику ломает?

(ниже кста комментарий habr.com/ru/company/dcmiran/blog/524256/#comment_22211096 как нельзя в тему — купил 60 фпс но блин фильмы все 24. действительно, почему)

Так может наоборот, вы — феномен, что не понимаете ценности плавного изображения.

Неужели таких людей действительно так много, что на них прям работает вся индустрия

Мне кажется ответ на этот вопрос очевиден если вспомнить что релиз новых процессоров amd и видеокарт nvidia всегда сопровождается тотальным отсутствием оных на полках в течение нескольких месяцев. Опять же — где-то около половины пользователей Steam владеют видеокартами без проблем выдающие 60fps. А это около 11 миллионов человек.

А еще есть шлемы виртуальной реальности где от fps меньше 70-80 банально мутить начинает.

Хм! А я понял! Это как с Hi-Fi аудио! Вот средний человек или разницу не услышит или будет слушать музыку. А аудиофил будет слушать шумы!!!

Так и здесь — и лаги и фреймдропы я на своём достаточно бюджетном оборудовании спокойно терплю — нет, есть игры, где хочется картинку, согласен… и будь времени на игры побольше, я бы, вероятно, раззорился на среднюю игровую станцию… но если не гоняться за киберспортивными достижениями в активных играх мне хватает моих слабеньких 30-60 фпс. Просто потому, что я познакомился с играми ещё в 90х при очень слабом на тот момент железе. И там было — или 10 фпс, или вообще никак.

Хм! А я понял! Это как с Hi-Fi аудио!Это как с бизнес-ланчами. Вот есть чуваки, которые ходят в ресторан, ну или заказывают всякую дорогую нямку. Но можно же из помойки возле макдака достать пол-гамбургера и слопать! Средний человек так наверное и делает. Непременно будьте как средний человек.

Мониторы же нынче стоят копейки, я у локального ретейлера буквально самый дешевый QHD брал по скидке, так он 144 Гц. В начального уровня игровых лаптопах из веточек и желудей мониторы 144 Гц и выше (например).

Я бы понял этот стон на форуме многодетных матерей-одиночек, но мы ж на хабри, тут вроде программисты всякие. Уж на пожрать да компьютер купить им (нам) точно должно хватать.

начального уровня игровых лаптопах из веточек и желудей

Ноут по ссылке — 125 тысяч. Ничего там у вас начальный уровень.

Вы знаете, не все обитают в Москве. Или в Израиле (если судить по вашей ссылке).

С другой стороны, новый айфон сколько стоит в РФ, тысяч 70-80? Игровой ноут от именитого бренда дешевле двух смартфонов же, получается.

В сравнении с айфоном любой ценник не так плох. :)

Хм! А я понял! Это как с Hi-Fi аудио! Вот средний человек или разницу не услышит или будет слушать музыку. А аудиофил будет слушать шумы!!!

60 и 144 это скорей как разница в наушниках за 100-200р и наушников за 2-5т.р. Пока ты сидишь в наушниках за 200 — ты можешь не слышать басов и думать, что это нормально — основную мелодию же слышно! Но если человека пересадить с нормальных наушников на дешёвые — басов ему будет уже не хватать.

Если в играх активно вертеть башкой, то 60гц после 144 будет восприниматься скорей как болезненное мельтешение.

но если не гоняться за киберспортивными достижениями в активных играх мне хватает моих слабеньких 30-60 фпс

Есть понятие комфорта. 30-40 фпс это нифига не комфорт и дело тут не в киберспорте.

Так и тут, вы хотите себе оправдать что покупка более дорогого оборудования стоило того, поэтому любые незначительные детали будут вас бесить и вызывать дискомфорт. Хотя видеть вы их будете 1% времени.

Монитор 27~ 144 чуть больше среднего смартфона стоит — не такая уж это как бы и роскошь. 144гц легко определит слепым тестированием любой человек, в отличии от разницы в звуке от золотых проводов.

144 и 4к это конечно уже совсем другой сегмент и мне сложно представить пепелац (и его цену), который бы выдавал 100+фпс на 4к.

Не-игроки разницу вполне видят, хотя и не особо интересуются, в чём она заключается. В кино исторический стереотип 24 кадра, который ощущается как киношность, в то время как в видеозаписи опять же 60 кадров — и зритель легко отличает кинофильмы от новостных выпусков, а если кино снято с высокой частотой кадров (Хоббит), это ощущается ими как гиперреализм, не-кино.

Где-то он был реально достижим. Приставка NES была очень удачной, в 60 FPS шли почти все игры.

А на ZX Spectrum 60 FPS были только в демо. В играх частым явлением было 12-15 ФПС. А иногда были просадки до 5-6 ФПС, когда что-то красиво взрывалось. Savage и Exolon очень хорошие примеры.

Просадки были даже у аркадных автоматов, хотя это встречалось не так часто.

И даже когда уже хорошо освоили аппаратное ускорение спрайтов, вышла приставка SNES. Там ФПС был очень нестабилен, из-за чего многие одинаковые игры (особенно порты с аркадных автоматов) на Сеге Мегадрайв были с бОльшим ФПС и обладали большей детализацией чем на SNES.

В основном самые продвинутые аркадные автоматы (Capcom, Namco, NEO-GEO) выдавали самую лучшую картинку — большие спрайты или очень много небольших, хорошая анимация, честные 60 ФПС.

А при переходе к 3D честные 60 ФПС были только на аркадах и топовых ПК, это да.

Например, если фон был динамическим, то на некоторых движках течение 1-4 кадров выполнялись все процедуры движка, кроме записи в экранную область, а затем в 1 кадр старались уместить обновление экрана?

А если фон был статический, то перезапись областей экрана могла быть разнесена по разным кадрам? Например в Myth было 25 ФПС, но обновление разных элементов происходило по очереди, примерно раз в 3-4 кадра. Перемещения разных врагов отрисовывались в разные кадры, в разные кадры также попадали разные группы анимаций — воды, огня, вспышек, перекрашивание атрибутов и т.д. Как раз из-за этих особенностей игра выглядела очень плавной и красочной.

Насколько я помню, в буфере делает прокрутку Chronos; прямо в экране R-Type; полная перерисовка в Zynaps, Dark Fusion, Ghouls & Ghosts.

Некоторые техники позволяют получить и 50 FPS, но этого добились уже после коммерческого заката платформы, в основном в отечественных играх. Это, конечно, достигается за счёт сильных ограничений, например, очень малое кол-во разных элементов в прокручиваемом фоне, либо сплошная заливка фона с прокруткой только его краёв.

Я уже не говорю про то, что многие пытаются любительские (youtube) ролики снимать в 24 кадра. При этом явно не понимают, что для получения «нужного» эффета необходимо очень аккуратно работать с экcпозицией и светом. Результат же — слайдшоу. Зато модно c выкрученными, нереальными цветами.

Даешь стабильные 60fps !)

Я прекрасно чувствую разницу в играх не то что между 30 и 60 фпс, а даже между 45-50 и 60+. Без всяких счётчиков фпс.

Много раз уже убеждался в этом — чувствую, что игра в определённый момент становится менее плавной. Включаю счётчик фпс и вижу, что частота кадров упала с 60+ до 50. Помню когда первый раз запустил Assessins Creed 4 Black Flag, то сразу был заметил отвратительную плавность картинки. Включил счётчик фпс — 40-45. Отключил PhysX, который и портил фпс — картинка сразу стала плавной, 60+ фпс.

Про 720 и 1080 — тут тоже был непредвиденный слепой тест. У меня к телевизору (40" 1080p) подключен медиаплеер WD TV Live. Как-то раз включаю плеер, сразу замечаю, что интерфейс как-то хуже отрисовывается. Запускаю фильм — качество неожиданно плохое. Фильм — 40-гиговый ремукс в 1080p. Выхожу назад в интерфейс, лезу в настройки плеера и вижу, что по какой-то причине он переключился в дефолтные 720p.

Нужно хотя бы 90. Стабильных.

Одна из причин — VR.

Либо будет 90 Hz на шлеме либо будут вытекать глаза (если будет 72 Hz — будут вытекать медленно). Не «в среднем 90» а всегда. Разницу очень даже видно. Это с учетом того что пользователь в шлеме может вращать головой и на это тоже надо реагировать как можно быстрее. И с учетом того что надо 2 картинки делать. И с учетом того что у некоторых шлемов надо еще ресурсы тратить на сжатие видео (спасибо Oculus'у за Oculus Link).

Да, сделали репроекцию (там набор методов) которая во многих играх доводит частоту до нормальной за счет интерполяций а если игра совсем тормозит — ей рубят частоту кадров в 2 раза (считая что уж 45 то движок должен выдать) и репроекция спасет.

При этом намеки что будет и 120 Hz на существующем железе — есть, например holographica.space/news/oculus-120-hz-25541

И тут я говорю про соло игры если что.

Для обоих игр буквально с момента их релиза инженеры Nvidia истерично клепают патчи видеодрайвера, чтобы хоть как-то заставить их работать.

Разумеется, ведь под новые игры ещё нет эвристик, и как оптимизировать работу GPU под них ещё предстоит выяснить. Стек очень сложный и там много чего может работать неоптимально для конкретной игры.

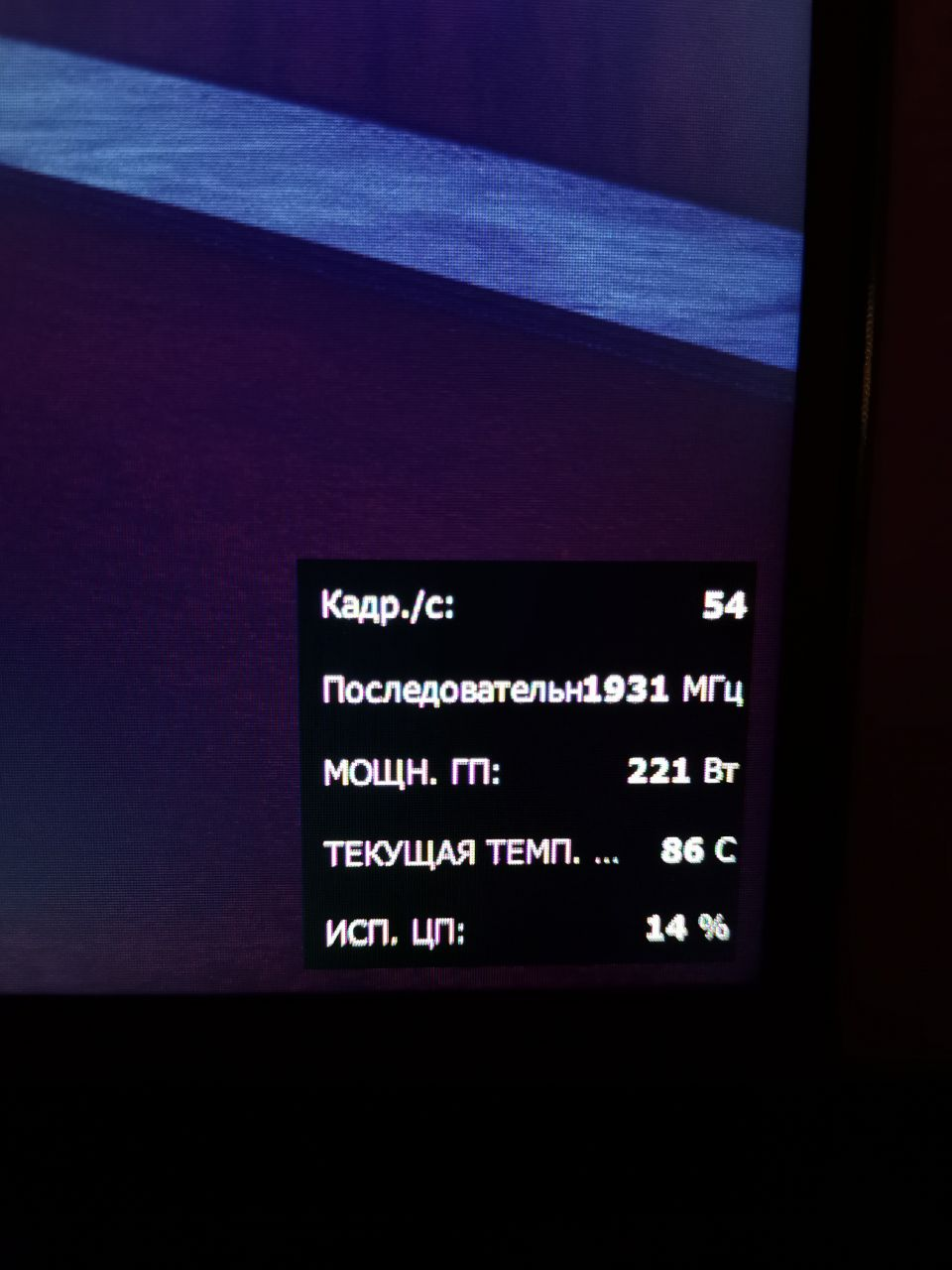

Скажу больше, все настолько плохо, что RTX 2080 Ti в указанных играх способны выдавать стабильные 144-190 кадров в секунду только при минимальных конфигурациях графики, но даже при этом иногда случаются дропы FPS!

???

В играх есть некий объём математики и операций которые нужно выполнить для отрисовки кадра. Хотите красиво, будет 60 фпс, а если хотите многафэпээсов, готовьтесь к тому, что графика будет попроще.

Можно и семь шапок, как говорится.

60 фпс это нативный режим большинства мониторов, телевизоров и представляет собой хороший баланс между играбельностью и сложностью графики.

Я надеюсь, что когда-нибудь Nvidia надоест тратить силы и ресурсы на выпуск бесконечных патчей драйверов, которые улучшают производительность в проблемных популярных играх.

Вы как-то забываете что разработчики игр пишут под абстрактный API и некоторая часть глюков и тормозов вызвана именно драйверами.

Компиляторы C++ пишут десятилетиями и до сих пор находятся ошибки и оптимизируют производительность, а в случае компилятора для конкретного GPU у разработчиков есть буквально несколько лет.

Выход из этой ситуации видится только один.

Нет выхода ^_^

под новые игры ещё нет эвристик, и как оптимизировать работу GPU под них ещё предстоит выяснить

Эх, а как классно было бы, если б можно было оптимизировать код самих игр…

все геймеры планеты уже плавно перешли на 144 и 240 Гц дисплеи, а кто не перешел — либо мечтает перейти, либо играет исключительно в пасьянс.

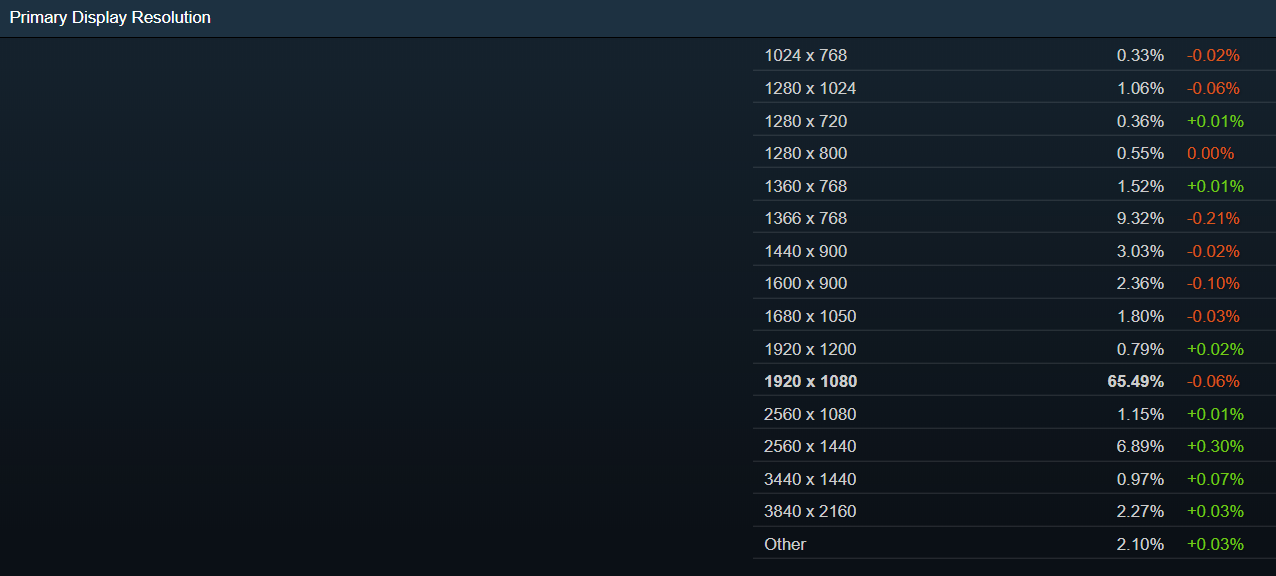

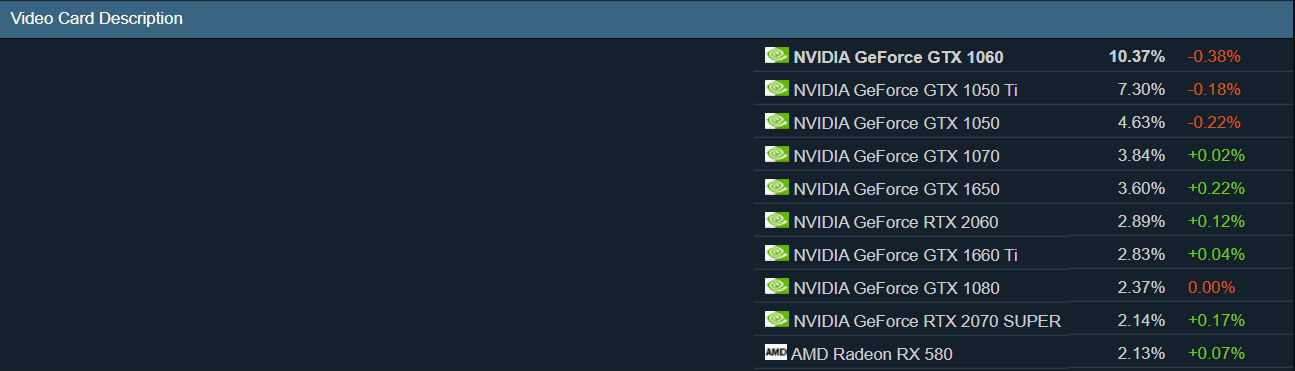

Идём в статистику стим.

Популярное разрешение мониторов

TOP-10 видеокарт

Самые популярные игры

Да, пожалуй автор прав. GTX 1060 сможет в fullHD выдать 144 Hz в контр-страйке и амог ас ) Но что-то мне подсказывает, что при всех маркетинговых усилиях, мониторы 144 Hz — по прежнему экзотика.

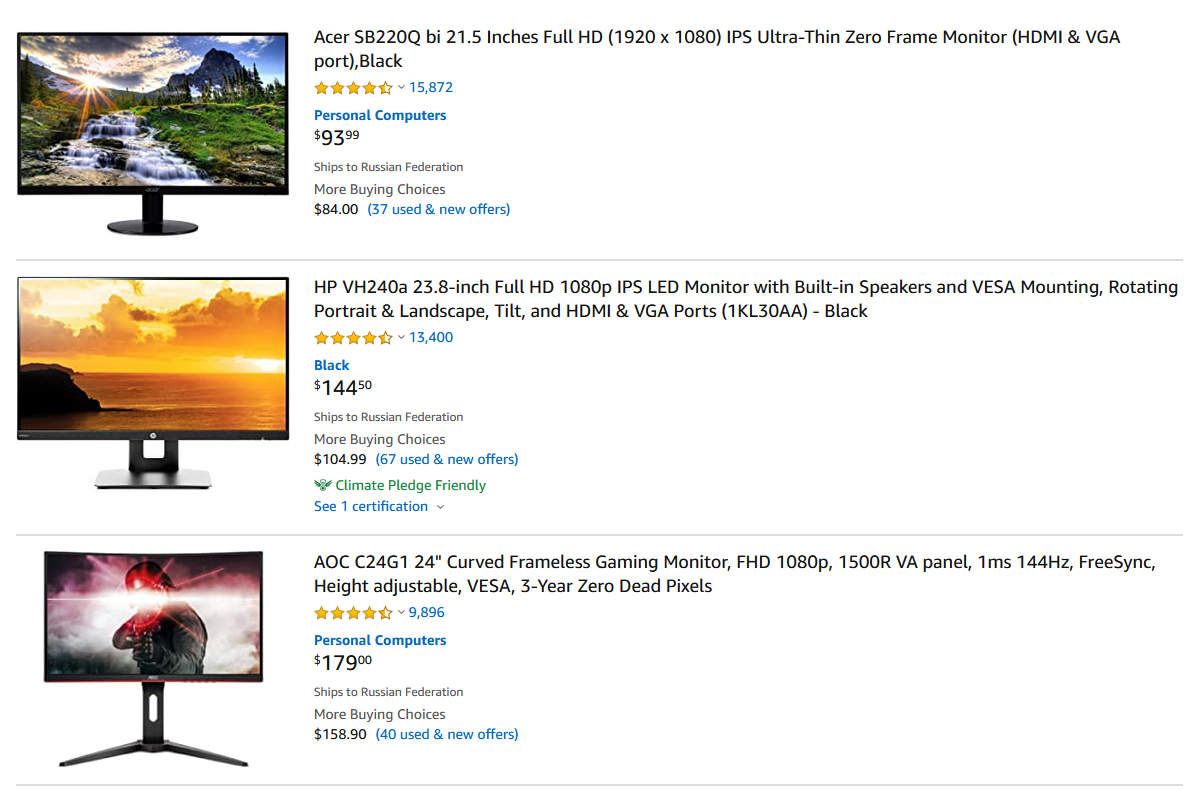

Но что-то мне подсказывает, что при всех маркетинговых усилиях, мониторы 144 Hz — по прежнему экзотика.

А это легко проверяется. Идем на amazon и смотрим мониторы по количеству отзывов. 144Hz монитор на третьем месте.

На newegg в топе вообще почти нет не 144Hz+ мониторов.

Идём в статистику стим. Про частоту мониторов там ничего нет.Зачем приводить статистику, если в ней нет интересующего параметра?

А статистика, самая популярная видеокарта в самом популярном разрешении в самой популярной игре (1060 на фуллхд в контрстрайке) 200 фпс делает запросто, так что эта статистика скорее подтверждает гипотезу про средний фпс выше 60, а не опровергает.

Другие игры из списка, которые я знаю: Rocket League идет на любом железе вообще, а тимфортресс-2 вышла на 10 (?) лет раньше, чем 1060, так что наверное тоже работает хорошо.

Я примерно это и имел в виду: у нас нет однозначных данных, а интерпретировать те, что есть, можно по-разному.

Забавляет ещё как пренебрежительно в каментах отбрасывают сетевой лаг даже в 2-10ms на локалке, отчётливо, тем не менее, «видя разницу» между 60 и 144 Hz. Попробовали бы лучше взять калькулятор и посчитать, сколько у тех самых «разработчиков» есть времени на I/O, логику и рендер кадра на 144 герцах.

PS: «а косоруких разработчиков игр»

и не разбирающихся в предмете авторах статей…

3080 расхватали не из-за каких-то там абстрактных 144Hz, которые сто лет в обед никому не упёрлись (люди выбирают между i5 и i3, какой ещё 144Hz-монитор???), а просто из-за того что карта — дешёвая, и быстрее 2080Ti в полтора раза. (и перекупы, конечно же)

Так что нельзя объединять gameloop с рендеромпри расчете времени кадра.

на 60Hz у вас есть 1/60 = 0.04ms для полной обработки I/O (сеть, game state, ввод игрока, загрузка моделей/текстур/звука если что-то ещё надо грузить и проч и проч), интер/экстраполяция стейтов. На 144Hz это уже 1/144 = ~0.007ms.

Это если вы хотите _действительно_ иметь то о чём пишет автор — неведомым образом отслеживать руками и попадать в бошки на 144Hz. (понятно что это невозможно, но допустим автор — робот или там муха)

В той же самой контре это всё тикает как раз с частотой server tick rate, и как вон выше заметили, она и 128-то не везде.

>>Так что нельзя объединять gameloop с рендеромпри расчете времени кадра.

Это то чего так сильно хочет автор. Мне 60 fps норм.

Ажиотажный спрос на новые карты Nvidia — заслуга не производителя, а косоруких разработчиков игрА что, на АМД карты такой же спрос? Нет. Так может, все же, Nvidia сделали что-то хорошее?

Что же касается оценки рынка по маркету — это бессмысленно. Естественно там будут преобладать свежие модели, но при этом их доля в общем количестве тв/мониторов на руках будет в лучшем случае несколько процентов. Все же речь о устройствах которые пользователи меняют раз в 5-10лет.

Для людей, далеких от игровой индустрии расскажу одну тайну: 60 FPS уже давно не стандарт.Зажрались эти геймеры. На моих школьных затычках 20 фпс в 800х600 было за радость!

Многое даже не запускалось, пока не пошаманишь с дебаггером (чаще всего просто менял флажок при иницализации D3D, чтобы оно переключилось на софтовый T&L).

И да, мне почти позарез нужен новый GPU — текущего RX580 с 8Gb (+16Gb из RAM) маловато будет.

Я к чему это все? Если ранее жилось совсем хреново (даже не про ЦП,… про дисплеи, что про память и дисковые накопители — все это полный шлак), то это не повод так и дальше жить.

Я к чему это все? Если ранее жилось совсем хреново (даже не про ЦП,… про дисплеи, что про память и дисковые накопители — все это полный шлак), то это не повод так и дальше жить.

В те времена вообще не очень хорошо жилось и моя семья долбанный сникерс на четверых членов семьи делила. Поэтому и играли с проседанием до 5-10 фпс. Да и сейчас кто-то играет с минимальным разрешением и минимумом деталей, и радуется. Лучше, чем ничего.

62% карточек — это 1070 или СЛАБЕЕ.

Самая популярная видяха — 1060 с долей 10%

Топ 5 по полулярности:

NVIDIA GeForce GTX 1060 10,37%

NVIDIA GeForce GTX 1050 Ti 7,3%

NVIDIA GeForce GTX 1050 4,63%

NVIDIA GeForce GTX 1070 3,84%

NVIDIA GeForce GTX 1650 3,6%

Имея такой рынок — делать видеоигры под 3000 серию nVidia — безумие.

Да и моники у всех — по 60Гц выдают. Какие сотни FPS? На кой они сдались?

Как итог производитель игр получает релиз быстрее и за меньшие деньги, геймерам выход игрушки раньше тоже на руку, да ещё и в цене игры больше манёвра.

А производители видеокарт от спроса тоже в плюсе.

Из минусов для геймера это обновление железа. В итоге пришли к какому-то балансу…

только если Nvidia наконец-то пересилит свое желание продать как можно больше флагманских карт и выступит против творящейся в игровой индустрии вакханалииу вас тут в слове «никогда» буквы лишние

А по отдельности оно вполне доступно же, причем FullHD@144 по-моему дешевле чем 4k@60. И есть промежуточные варианты, например QHD@144 — и разрешение выше чем FullHD, и компьютер нужен не такой монументальный, чтобы шевелить этим всем.

С какого момента что-то пошло не так?

Видимо, с момента, когда nvidia решила, что такой подход будет офигенным конкурентным преимуществом перед ati.

В комментариях уже прошлись по постулатам (140 Гц есть у любого уважающего себя игрока) и оценкам того, какая игра тормозит и где графика хорошая.

Я же хочу высказаться по поводу последнего раздела "Как это изменить". Автор почему-то считает, что одного желания Nvidia будет достаточно. Но ведь деньги платит не она! Лично я не уверен, что даже если она перестанет оптимизировать драйвера, это заставит создателей условного Call of Doom потратить больше денег на оптимизацию вылизать графическую подсистему следующей игры серии до идеала.

Автор сам говорит, что геймеры — которые покупают и игры, и видеокарты — готовы изучать гайды, шаманить и настраивать именно эти игры. Они не уходят из них стройными рядами толпами (хотя такое случалось с действительно плохими релизами).

Я не играл ни в один из упомянутых шутеров и не знаю, чем они так хороши. Но игроки покупают эти игры, готовы тратить деньги чтобы играть в них. И пока их будет устраивать сумма факторов (качество картинки+фпс — далеко не всё), издатели не будут заинтересованы вкладываться сильнее в качество кода движка.

Хотите, чтобы ситуация изменилась — агитируйте покупать игры с более качественным кодом. Что бы вы ни вкладывали в это понятие.

Так что не могу никак поверить, что почти все игроки перешли на них. К тому же, они (игроки), деньги жмут на мониторы, в отличие от работающих за ними. Короче, ну, это сильно притянуто за уши и попахивает бредом, то что не осталось ни у кого 60 Гц.

Чувствуешь себя идиотом, пытаясь найти различия в такой таблице. Что совпадает — обычно должно находиться в общей, слитой ячейке.

1. Рекомендую всему коллективу дата центра миран проследовать в хардварную статистику Стима и посмотреть на видеокарты у юзербейз этой платформы. Там до сих пор, настолько древнее железо что не может быть и речи о 144гц мониторах с приемлимым разрешением. Выдать фразу, что "Если раньше высокогерцовые экраны были прерогативой киберспорта, игроков в CS:GO и Quake, то теперь 144 Гц есть у любого уважающего себя игрока" мог только далекий от этой темы человек. Высокогерцовые мониторы так и остаются прерогативой киберспорта или достаточно состоятельных людей, потому еще, что это стоит абсолютно невменяемых денег, что бы это стало достаточно широким и массовым рынком.

2Тот же затронутый в статье call of duty продается каждый год грубо говоря по 20 млн копий. Из них 80-90% продаж приходится на консоли и в этом случае ПК это так, небольшой приработок. И вот тут да — действительно разработчикам плевать, что там на этом ПК происходит. Зато на консолях, которые являются сугубо формализированными и стандартизированными устройствами все вылизано и оптмизировано до блеска, правда на 30гц или 60 гц в зависимости от игры. И поэтому, снова утверждать, что "60 FPS уже давно не стандарт." может только полный профан в этом вопросе. 60 фпс только-только стал стандартом на консолях и будет стандартом еще как минимум пяток лет и следующее поколение консолей. Конечно инженеры из сони и майкрософта могли бы создать зверей которые бы тянули 144 гц на 4к, при цене в районе 3к зеленых и продажах 0 экземпляров. Но кому это нужно?

Для сравнения масштабов и понимания кто, и для кого делает игры — в мире за 6 лет продано более 200 млн консолей последнего поколения в общем. За 2019 нвидия и амд по очень грубым прикидкам продали вместе в среднем 350к видеокарт для частных пользователей. Это все что вам нужно знать о сопоставимости этих рынков.

3Как было указано выше, консоль это очень стандартизированное устройство. Все консольные игроки знают это и им плевать на 144гц, потому что «тадам! сюрпрайз мазафака» консоль текущего поколения ни при каких условиях не выдаст 144гц и ее бесполезно даже пытаться подключать к 144гц экрану чего-нибуть. Среднестатистический консольный игрок знает, что он, из-за этого в равных условиях со всеми остальными. Итого мы получаем многомилионную аудиторию геймеров которым плевать на "… максимально высокие стабильные кадры хотя бы на топовых видеокартах. " У них и так стабильные и высокие кадры, потому что, как было сказано, устройство стандартизированно. А кроме того и майкрософт, и сони чрезвычайно щепетильны в вопросах качества игр на их консольных платформах.

4Да, конечно многие игроки ломонулись покупать новые видеокарты, подогрев спрос. Но во многом, Нвидия сама, исскуственно разгоняет дефицит, срывая поставки партнерам и закрывая свои онлайн магазины для заказов.И таким образом набивая себе цену и хайп. Чем дальше — тем это становится очевиднее.

5Вывод первый: Можно долго разглагольствовать о жадности и алчности, но бизнес должен зарабатывать деньги. И исходя из вышеописанного мы видим куда бизнес сориентирован и уж поверьте там все отполировано до сияния золотого руна. Поэтому утверждение про «кривуруких разработчиков» снова из разряда той же компетенции автора статьи, что и все предыдущие. Есть много примеров и на ПК, когда проекты оринтированы сугубо на эту платформу и оптимизированы просто на 10 баллов.

Второй вывод: я надеюсь что дата-центр миран разбирается в дата-центрах лучше чем в игровой индустрии и в месте видеокарт в этой индустрии.

З.Ы. И еще напоследок открою небольшой секрет автору, что основательно так болт был забит "На тестирование и оптимизацию потребления ресурсов" не 2019-2020 годах, а еще в далеком 2007 году, когда вышел первый Crysis. Ну и ничего, как то же прожили 13 лет с этим.

Ажиотажный спрос на новые карты Nvidia — заслуга не производителя, а косоруких разработчиков игр