Comments 49

Тут скорее нужно почти все отдавать в руки частного бизнеса и контролировать с помощью суперкомпьютеров.

Прозрачность системы + обработка жалоб с помощью ИИ — вот что нужно.

А потом новости будут про коррупцию среди ИИ-чиновников, которые брали взятки процессорным временем и оперативкой.

upd.

Блин, промахнулся мимо нужной ветки.

Поставить его во главе правительства, чтобы он (оно?) принимал единоличные решения на благо государства и все будут только за. А где-нибудь в США народ возмущаться будет в такой ситуации :)

А где-нибудь в США народ возмущаться будет в такой ситуации

И зря. Для государства лучше придерживаться одной, но взвешенной позиции, одного направления. Выборы важнее для разрыва коррупционных связей и создания конкуренции. У ИИ таких проблем не должно быть.

ЗЫ да, я понимаю что коммент выше был в шутливой форме, но тема интересная)

коммунизм это отрицание всякой частной собственности

Это откуда такие выводы? Всегда считал, что коммунизм — это общественная собственность на средства производства.

знаю многих кто был более счастлив в СССР чем сейчас.

хотя там частная собственность была сильно ограничена.

любая частная собственность это автоматическое деление на классы. богатый — бедный.

богатых много не бывает :)

Поставить его во главе правительства, чтобы он (оно?) принимал единоличные решения на благо государства и все будут только за. А где-нибудь в США народ возмущаться будет в такой ситуации :)»

Сальвадор Альенде пытался, наняв Стаффорда Бира. Проект «Киберсин». В результате в Чили к власти пришёл Пиночет.

«Мозг фирмы»

http://www.rulit.me/author/bir-stafford/mozg-firmy-download-free-58096.html

Проект Киберсин

http://biofile.ru/his/30045.html

«При значительной разнице в финансировании проектов, отечественные разработки не уступают, а где-то даже превосходят зарубежные аналоги»и десять и двадцать лет назад. Могу ошибаться, но вот так на вскидку кроме Яндекса не могу вспомнить проектов вышедших на мировой рынок.

Отсюда вывод: Хотя «стартовые позиции в «марафоне искусственного интеллекта» у нашей страны неплохие, но „значительная разница в финансировании проектов“ приведут либо к миграции проектов за рубеж, либо к тихому умиранию.

Вот, если его переформулировать так: «могут ли выходцы из России стать лидерами в «марафоне искусственного интеллекта»». Тогда ответ будет «Да». В России можно найти таланты, но работать и развивать ИИ в этой стране им не получится.

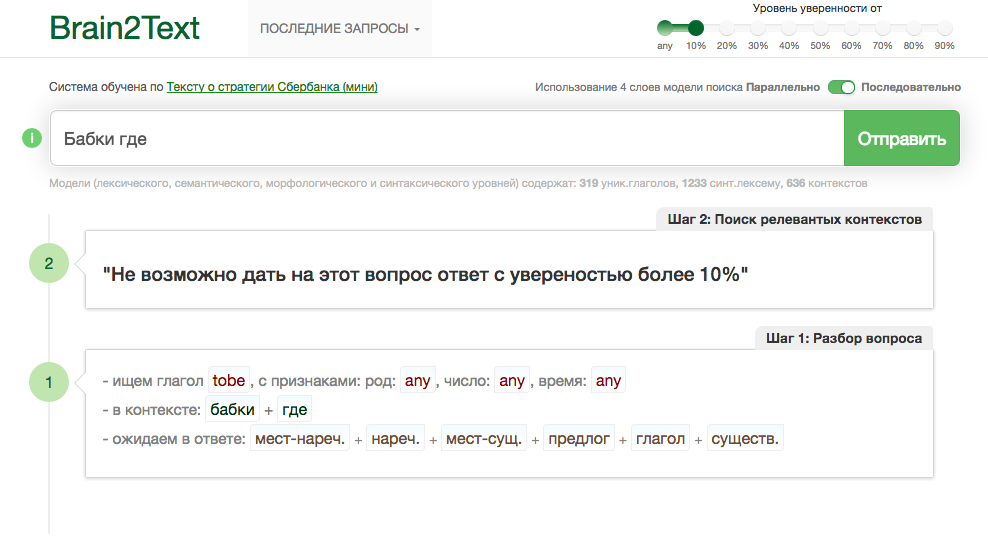

Что это было?

Другая российская разработка — платформа Brain2 компании “Когнитивные системы” — концентрируется на быстрой обработке bigdata в нейромодели знаний для систем ИИ. К примеру, нейромодель для оценки стоимости недвижимости (House Prices), обученная по 79 параметрам 1461 объектов недвижимости, способна предсказать стоимость объекта с незначительной ошибкой (RMSE=0,42), что равнозначно оценке опытного эксперта по недвижимости. При этом на обучение модели ушло всего 20 минут. Для сравнения, у опытного программиста-математика на решение подобной задачи с применением лучшей бесплатной библиотеки для машинного обучения Keras (TensorFlow) уйдет не менее 30 часов, а результат будет незначительно лучше (RMSE ≈ 0,32).

Почему автор сравнивает облачный сервис и фреймворк?

1) Сравнивайте тогда уж Brain2 с Google ML Cloud или MS Azure ML.

2) В рекламной презентации показывать результаты на MNIST'е в районе 81% точности и c местом во 2-й тысяче лидерборда

Им не стыдно за свой сервис?

3) Что за бред про 30 часов работы опытного программиста-математика?

Еще забавляет, что на их сайте, русская версия от английской отличается только языком меню, весь контент не зависимо от выбранного языка будет на русском языке.

Имхо, как-то подозрительно выглядят эти "Когнитивные технологии" — убийцы tensorflow...

Сравнивать надо сравнимое. Для оценки надо взять как минимум 2 параметра – удобство и результат (пока отбросим стоимость).

Мы протестировали основные сервисы

Google ML – это по сути TensorFlow с возможностью использовать ресурсы Google, отсюда и следует, что он для рядового пользователя также не удобен как TensorFlow, хотя конечно очень удобен для программиста. Поэтому, его оценку у него такая же как у TensorFlow.

Правильнее посмотреть другой сервис Google, который мы упомянули:

Так модель созданная в сервисе Google Prediction, для решения уже упомянутой задачи House Prices от Kaggle (сервиса для проведения конкурсов среди специалистов по машинному обучению) показывает RMSE = 7000, что в десятки тысяч раз хуже чем в Brain2.

Задачу MINST как представленная в виде демо в сервисе он решает хорошо – 0,92 точность, но вот другие, которые мы пытались решить увы не может.

2) В рекламной презентации показывать результаты на MNIST'е в районе 81% точности и c местом во 2-й тысяче лидерборда

Оценка должна быть справедливой, наш результат — за 2 минуты во 2-ой тысячи лидеров.

То есть мы не старались особо решать эту задачу «hello world», стать лидерами и тп.

Но мы специально потратили время, чтобы сравнения были объективными

В Google Prediction, со всем чтобы разобраться ушло 30минут, c MS Azure вечность, не хватило сил разбираться с весьма сложным интерфейсом. А вот Amazon порадовал, удобно и хороший результат.

Им не стыдно за свой сервис?

3) Что за бред про 30 часов работы опытного программиста-математика?

Другую задачку с House Prices, решили решать с использованием Кeras(theano) (for TensorFlow), на то чтобы разобраться с возможными решениями часов и выбрать лучшие по данным публикаций ушло примерно 13, подготовить данные (номализовать) обучить и протестировать ушло примерно 17 часов. А результат (0,32) полученный не многим лучше чем у Brain2 (0,42) где все создание моделей автоматизированно и заняло 30 минут!

Есть в лидерборде и варианты с результатом 0.0, но если почитать внимательнее будет понятно, что там была обнаружена уязвимость к выявлению, какие значения в test были неверно классифицированы/спрогнозированы.

Еще забавляет, что на их сайте, русская версия от английской отличается только языком меню, весь контент не зависимо от выбранного языка будет на русском языке.

Да, правда, но так ли это важно…

Отчего, Вы не обратили внимание, на то решение, над которым мы очень много работали Brain2Text. И то, что решения для синтеза предложения из слов пока ни у кого из лидеров рынка не представлено, не говоря об синтезе ответа?

P.S. Научная публикация по решению Brain2Text будет опубликована на arxiv.org месяца через 3

Спасибо за ответы:-)

Хотя объем бреда, по моему, только увеличился:

Сравнивать надо сравнимое. Для оценки надо взять как минимум 2 параметра – удобство и результат (пока отбросим стоимость).

Совершенно не понятно, какой смысл вкладывается в критерий "Результат"… вроде как на любом из представленых фреймворков можно любую модель реализовать...

Задачу MINST как представленная в виде демо в сервисе он решает хорошо – 0,92 точность, но вот другие, которые мы пытались решить увы не может.

92% — это очень плохо. Тупая сетка из пары сверточных и полносвязных слоев натренируется до 97%… а 92 — это даже хуже, чем описаный мной пару лет назад unsupervised метод, дайющий 96%.

Оценка должна быть справедливой, наш результат — за 2 минуты во 2-ой тысячи лидеров.

2 минуты тренировки? Лень проверять, но LeNet на моей не самой топовой GPU тренируется 1-2 минуты до тех 97%.

Другую задачку с House Prices, решили решать с использованием Кeras(theano) (for TensorFlow), на то чтобы разобраться с возможными решениями часов и выбрать лучшие по данным публикаций ушло примерно 13, подготовить данные (номализовать) обучить и протестировать ушло примерно 17 часов. А результат (0,32) полученный не многим лучше чем у Brain2 (0,42) где все создание моделей автоматизированно и заняло 30 минут!

Даже не знаю что сказать:) Может стоит сначала изучать инструмент, а потом им пользоваться...

Отчего, Вы не обратили внимание, на то решение, над которым мы очень много работали Brain2Text. И то, что решения для синтеза предложения из слов пока ни у кого из лидеров рынка не представлено, не говоря об синтезе ответа?

А Siri то как работает?) Ну и там всякие цепочки LSTM'ов и все такое проче...

Никого не хочу обидеть, или оскорбить, но чет какой-то фэйспалм это всё :(

Чтобы не быть голословным, забенчмаркал MNIST.

Вот такая сетка:

def LeNet5(x):

net = tf.reshape(x, [-1, 28, 28, 1])

with tf.variable_scope("conv1"):

net = layers.conv2d_relu(net, [5, 5, 1, 20], [20])

net = layers.maxpool2d(net)

net = tf.contrib.layers.batch_norm(net)

with tf.variable_scope("conv2"):

net = layers.conv2d_relu(net, [5, 5, 20, 50], [50])

net = layers.maxpool2d(net)

net = tf.contrib.layers.batch_norm(net)

fc_size = int(net.get_shape()[1] * net.get_shape()[2] * net.get_shape()[3])

net = tf.reshape(net, [-1, fc_size])

with tf.variable_scope("fc1"):

net = layers.inner_product(net, [fc_size, 500])

net = tf.contrib.layers.batch_norm(net)

net = tf.nn.relu(net)

with tf.variable_scope("fc2"):

net = layers.inner_product(net, [500, 10])

return netЗа 500 итераций сходится к 99% точности. Время тренировки: 50 секунд на GTX980Ti...

А при размере батча в 2048, за 20 секунд сошлось к тем-же цифрам...

«Сергей, спасибо, что пытаетесь вести конструктивный диалог. Дабы он был действительно конструктивным (и полезным читателям), необходимо, чтобы мы сравнивали решения в едином пространстве время-результат. Для этого давайте просто составим своеобразных акт сверки.

Время изучения вопроса, часов – время необходимое, чтобы посмотреть условия задачи, найти и реализовать решение.

С использованием Brain2, для типовых моделей – это значит — скачать данные и загрузить данные в систему Brain2, пометить что класс, а что признак, нажать кнопку «построить модель». Сервис Brain2 ставит задачу – дать возможность создавать нейромодели не программируя, в том числе, человеком, который вообще может не знать, что такое нейросети. Именно для этих целей мы протестировали работоспособность системы на MNIST и HousePrice. Мы не тратили вообще никакого времени, на предобработку и поиск «решения», лучшее решение, подбирала сама система Brain2. При этом мы не сомневаемся, в том, что потратив много больше времени чем 10 минут, могли бы достичь лучших результатов.

К примеру, сколько времени Вам понадобилось, чтобы отладить работу ESOINN для задачи MNIST (кстати интересный алгоритм). А много ли специалистов, кто может разобраться с подобным решением, а сколько стоимость часа специалиста такого уровня…

* Задача решаемая в Brain2Text. На основе естественного текста обучить модель(и) и создать алгоритм с их использованием для поиска набора ЛЕКСЕМ (унифицированных форм слов имеющих план содержания), из которых составить ответ на поставленный вопрос на естественном языке. Т.е. необходимо сначала понять какие слова относятся к ответу, а затем из них синтезировать предложение. Текст для обучения http://sb.brain2.online/files/cache/text_half.txt.

** У нас разработка Brain2Text потребовала 3 месяца для создания и отладки алгоритма и пяти многослойных моделей для возможности его работы: 2 – обработки вопроса, 1 – выбор слов, 1 – расстановки слов влево и вправо, 1 – правильного склонения слова слева и справа.

*** Точность определена, как число корректных предложении полученных на вопрос составленный из слов текста. Список 30 экспертных и 6000 технических вопросов для тестирования готовы предоставить.

Также, интересно получить ссылки на работы, где с применением LSTM составляют предложения из лемм (унифицированных слов) на русском языке. Если есть, то реальные примеры посмотреть как работает.

По поводу Siri, все же нам кажется она зачитывает найденные ответы из интернета, а не составляет их из «мешка слов». А ответы не из интернета выглядят как заготовленные формы с вариациями. В модели Brain2Text нет самого текста или шаблонов ответа, только связи слов!

P.S. Спасибо за найденные опечатки и сотрудничество.

Во-вторых, время на изучение не имеет значения вообще от слова совсем. ML на данный момент не черный ящик, а уж тем более нейронные сети, так что надо учить хотя бы основы. А то, что на какой-то задаче можно за вменяемое время получить результат автоматически, означает, что задача настолько простая, что она даже не стоит рассмотрения. Как конкретный пример — попробуйте хотя бы cifar10, и покажите, что выйдет. Я сомневаюсь, что вы вообще получите там вменяемый результат, разве что у вас есть заточенные под задачу предобученные алгоритмы.

В-третьих, в самой первой таблице у Amazon ML оценки 4 и 5, а интегральная 2.1, а у брейн2 4 и 5 и интегральная 2.8. Как так? Разве что вы не показали какой-то столбец, но тогда какой-вообще смысл так что-то сравнивать?

1) Были уже всякие RapidMiner'ы и прочие тулы для автоматического построения моделей… у всех есть один главный недостаток: когда мы получили какую-то модель, а результат не можем объяснить, то смысла от этой модели никакого:

- Вот получили мы 99% точности… а это точно хорошо, или это жуткий оверфит + плохая тестовая база? А если оверфит, то почему? Недостаточно данных для тренировки, плохие фичи, или слишком большая модель, которая умудрилась запомнить все образы?

- А если ничего путного не натренировалось, то почему? Плохая тренировочная база, или может быть мы пытаемся линейно разделить данные, которые так просто не разделишь… а может быть у нас половина фич — это шум, который все портит? И т.д. и т.п.

И вот тут мы приходим к тому, что человек, который как умная обезьянка тычет по кнопкам, не понимая происходящего, может получить какой-то результат, но что с ним делать дальше — он не знает. Т.е. результат вроде бы есть, но на самом деле его нет.

Ну а в случае этого Barin2, даже результат странный — 81% на MNIST'е говорит о том, что даже на простейших модельных задачах автоматически как-то все не очень круто работает. Как правильно пишут выше: а давайте возьмем cifar10 и попробуем на нем запустить ту-же задачу… скорей всего там все рассыпется.

А если инструмент позиционируется как продвинутый калькулятор, то его корректней сравнивать с Excel, а не tensorflow или torch.

2) Обработкой текста на практике я не занимался почти, т.ч. тут могу ошибаться и, возможно, решение Brain2Text — это что-то прорывное, хотя результаты работы не впечатляют от слова совсем. Но всякие чат-боты — это вроде-бы довольно горячая тема последних пары лет и их лепят все кому не лень. Гугл выдает десятки репозиториев с различными решениями на рекурентных сетях.

Кстати, в табличках не правильно указаны названия TensorFlow и Azure… там разработчики — это точно не пара студентов первого курса?)

Просто как-то нескучными обоями повеяло...

)

А что не так с Россией?

Есть, наприер, success story у авторов Prism: ребята вовремя уловили тренд, вложили денег в high load сервис, способный deep learning тянуть с минимальной задержкой и стали лидерами в области стилизации фотографий.

Ну или findface — крутые ребята, которые сначала на MegaFace победили, и продвигают свою технологию распознавания лиц.

Туда же и Yandex можно отнести, вот уж кто серьезно рисерчем занимается в России.

Ну и по мелочи есть еще куча компаний, кто по большей части на аутсорс делают решения на основе машинного обучения и прочего data science.

Имхо, были бы знания и идеи, а остальные вопросы в этой области решаемы, даже в России.

А саморазвития пока нету как такового.

А шансы у нас самые большие, только русский программер насинячившись до беспамятства может создать реальный ИИ.

В экономиках Казахстана и Турции преобладают позитивные тенденции. ВВП Казахстана в 2012

году увеличился на 5,1%, в ближайшие годы ожидается сохранение достигнутых темпов роста.

Замедление ВВП Турции в 2012 году до 2,2%, вероятнее всего, является временным, в

последующие годы можно прогнозировать повышение темпов роста до 4%.

задаю вопрос

ВВП Казахстана

темпы ВВП Казахстана

и прочих формулировках со словом казахстан, ответ всегда один:

есть замедление ввп турции в 2012 году до 2.2 проц вероятнее всего

Есть мнение, что ИИ хромает :)

Обычный парсер лучше отработает

Есть ли у России шансы на лидерство в «марафоне искусственного интеллекта»