Comments 260

Нейросети в текущем виде тупик.

Перспективный да, но от этого не менее тупиковый. У них нет полноценной памяти. Безусловно полноценный ИИ будет содержать нейросети по крайней мере на момент своего появления. Но только как периферийные системы. Ядром же ИИ однозначно будет именно классический алгоритм(краулер с дополнениями) поверх ассоциативного хранилища данных.

Почему именно классический? Почему этот алгоритм вообще должен существовать (именно классический) и иметь приемлимую вычислительную сложность?

У нейросетей есть приятное свойство — они умеют аппроксимировать почти любую функцию с любой точностью. Я бы скорее поставил на то, что сделают нейросеть, которая аппроксимирует работу этого алгоритма, чем найдут сам алгоритм.

А по поводу самих нейросетей как инструмента — согласен, для полноценного ИИ вероятнее всего потребуется доработка существующих методов, разработка когнитивных архитектур и т.д.

Мне кажется, что 2, 3 и 4 — это одна большая проблема, показанная с разных сторон.

Возможно, за это отвечает один механизм "вывода", но пока мне задачи видятся разными. Здравый смысл больше про имплицитное знания. Это не всегда метафора, это вполне очевидные выводы, например.

Интересное мнение, хорошая статья, спасибо, но уж простите, заголовок режет глаза:

"Чего не хватает ИИ?"

PS: GPT-3 умеет использовать метафоры и вполне уместно, а вот тонко шутить, кмк, не может пока никто из текстовых сетей.

Спасибо. Только озвучил наболевшие проблемы.

Про заголовок — вообще-то употребимы обе формы в вопросе (вин. и род. п.), так как мы не знаем, что (чего) именно не хватает )

GPT-3 так же как и 2 просто может выдать метафорическое, подражая текстам. Это не владение метафорой, грубо говоря, для поиска ответа.

употребимы обе формы в вопросе

при отрицании используется только родительный падеж. Нет чего, а не "нет что". В просторечии можно конечно и заменять, но например если в просторечное "Не вижу чемодан" добавить какой чемодан — "Не вижу зелёный чемодан" звучит неуклюже, в отличие от "Не вижу зелёного чемодана".

"Что не хватает ИИ" имеет исключительный смысл "какой-то предмет (=что) не хватает (=руками) кого (=ИИ)".

Достаточно попытаться ответить на этот кривой вопрос:

«Что тебе не хватает, время или деньги?» — Время!

или

«Чего тебе не хватает, времени или денег?» — Времени!

Вполне релевантный ответ ))

Нет, это может быть и винительный падеж при переходном глаголе

может быть и винительный падеж

Что не хватает ИИ?Чего не хавтает отвертке, чтобы стать самолетом? От того, что ML из маркетинговых соображений (читай с целью компостирования мозга всем, кому можно его прокомпостировать такой подменой) назвали ИИ, он не придвинулся ни на 5 копеек к общему ИИ. Это как утверждать, что можно приблизиться к Луне прыгая на месте на двух ногах в лунную ночь. Мало того, даже существующие искусственные нейронные сети бесконечно далеки от природных, как по внутреннему устройству, так и по демонстрируемым результатам. Ребенок взял в руку игрушку, повертел ее в руках 2-3 минуты. Теперь он никогда не спутает ее с другой игрушкой.

В статье есть попытка с высоты прыжка к Луне рассуждать о будущих ракетах. Само понятие «здравый смысл» содержит в себе многие годы эффективного (само-)обучения в среде человеческого общества, сотни генетически заложенных программ реализуемых в мозге обучаемого.

demon416nds

Ядром же ИИ однозначно будет именно классический алгоритм(краулер с дополнениями) поверх ассоциативного хранилища данных.Ядром видится набор простых нечетких алгоритмов. Интересно то, что сам мозг обращается с некоторыми своими частями как с инструментами с известными свойствами полученными экспериментальным путем во время работы организма с собственным мозгом. Есть инструменты, которые запускаются самостоятельно по своему усмотрению. Вот набор всего этого и видится ядром ИИ. Также интересно наличие универсального кодирования образов. Информация о том, что чай сладкий эффективно обрабатывается вместе с фактом, что он может быть горячий и находится в чашке.

наиболее близкой аналогией из существующего сейчас в программировании будет хранение каждого обьекта независимо от типа в xml с перекрестными ссылками. начинка может быть абсолютно любой но механизм обращения к ней универсален.

Задача упомянутого в моем комментарии краулера — переходить по ссылкам в глубину как по википедии расшифровывая понятия до уровня который который смогут обработать те самые дополнения. Ну или запроса недостающей информации если в памяти недостаточно данных.

>>>Ребенок взял в руку игрушку, повертел ее в руках 2-3 минуты. Теперь он никогда не спутает ее с другой игрушкой.

Я совсем не уверен, что это так, и в этом плане существуют вполне приличные детекторы, которые налет формируют карту признаков и могут опознать игрушку, возможно бытрее и точнее, чем ребенок, но… Мы ведь сейчас не об этом? ;)

>>>Само понятие «здравый смысл» содержит в себе многие годы эффективного (само-)обучения в среде человеческого общества, сотни генетически заложенных программ реализуемых в мозге обучаемого.

Это во многом правда. И? Вы что предлагаете-то? Не обсуждать фундаментальные проблемы? Или у вас есть собственные ответы на поставленные вопросы в практической плоскости?

>>>Интересно то, что сам мозг обращается с некоторыми своими частями как с инструментами с известными свойствами полученными экспериментальным путем во время работы организма с собственным мозгом.

Это правда. Что не мешает ансамблю нейронных сетей вести себя так же…

Вот кстати да. У меня ребенку полтора года и я удивляюсь на сколько быстро и легко он научился отличать животных не видя многих вживую а лишь пару раз на картинке. А чтобы он научился различать цифры один и два понадобилось всего четыре захода с книжкой про цифры. На десятый заход он иногда понимает теперь где буква О, а где цифра ноль. Современным нейросетям такое конечно и не снилось

Причем котов от собак он может отличить не зависимо от освещения и прочих условий

Частично вопросы закрывает NTM, причем сразу в нескольких областях. Во-первых про факты: в NTM есть контекстно адресуемая память. Во-вторых, хотя там вроде бы не доказана полнота по Тьюрингу, есть явно движение в этом направлении, а значит некоторые аспекты 2 и 3 вопроса тоже не так уж недостижимы… Да и если честно — не вполне понятно, насколько система уровня GPT-3 способна запомнить как общие факты о мире, так и контекст вчерашней беседы — сейчас она этого не делает от части по соображениям предполагаемой бизнес-модели использования…

2 уж очень некорректно поставлена сама задача: мы учим машины без прямого восприятия мира на датасетах, этот мир так же совершенно неполно отражающих и хотим от них «здравомыслия» в виде «додумывания» того, что «и так всем известно». Не нужно пытаться описывать мир детально, но важно делать это полно и комплексно, хотя бы на каком-то уровне абстракции…

Собственно от сюда же вытекает пункт три: GPT-f Вполне способен строить логические умозаключения на совершенно том же «движке», что и остальные GPT. Т.е. опять же — чему учим, то и получаем! Правильная последовательность суждений, следствия, следующие за причинами и приводящие к закономерному итогу — какая разница, какую последовательность предсказывать?

Ну а 4 — совсем не трудно, если мы говорим про современные архитектуры: сети с вниманием (attention), трансформеры, вот это вот все — они уже не так чувствительны к отдельным словам и воспринимают скорее контекст! Аналогии и метафоры — все это вопрос правильного эмбендинга и современные сети с этим справляются неплохо.

Т.е. я не считаю, что вопросы сняты — не в коем случае! НО они не видятся тупиковыми и какими-то прям уж очень фундаментальными… Потихоньку пилят их.

Я для себя вижу так же ряд других интересных проблем:

1. Дообучение. Сеть нужно всегда учить на полном наборе данных, иначе то, что работало раньше, но перестало влиять на градиенты будет деградировать. Файнтюнинг не в счет, т.к. там эта проблема скорее нивелируется низкими коэффициентами, но никак не решается. Мне тут «старшие товарищи» дали много разных ссылок на попытки бороться с этой проблемой, но забороть пока вроде так никто и не смог.

2. Активное самообучение, то бишь любопытство! ;) Если бы сеть могла дообучаться на малом датасете — она могла бы в течении некоторого времени выдавая предсказание — определить каких именно данных было мало в исходном датасете (тех, на которых большая ошибка в предсказании) и именно их так или иначе собрать в корректировочный датасет. Так, итерационно закрывая пробелы в своей «картине мира» сеть могла получать все более целостное представление о реальности, как в области фактов, так и в области здравомыслия…

Не нужно пытаться описывать мир детально, но важно делать это полно и комплексно, хотя бы на каком-то уровне абстракции…

Противоречиво сформулировано — не детально, но полно. Но вопрос даже не в том. Человек тоже не встречает все случаи, на которые может дать ответы. Но отвечает, достраивая из имеющихся данных. Более того, ребенку достаточно показать что «вот это киска» и он будет узнавать с того момента всех кисок. И не надо никаких тысяч предъявлений. Когнитивная система человека работает не так как NN. Она строит новые модели на основе уже известных буквально на одном примере. А для здравого смысла ей вообще не нужны примеры! Человек их выводит естественным, но неизвестным нам способом (инсайт).

Есть немного. Но это важно! Самый близкий пример: камера. Камера передает информацию о некой части мира. Она может быть крутой — фулл-хд, 60 кадров/сек, цветная естественно… Итого: 3х1800х1020х60. Вы можете убрать цвет (этим и сократить объем в три раза). вы можете оставить 10 кадров из 60. вы можете снизить разрешение картинки в 10 раз по каждому измерению. Итого — 1х180х102х10 — это почти в 2000 раз меньше данных, но они все еще полностью описывают изображение, с потерей некоторой (возможно важной, не спорю) информации, но полностью. Если ваши технические возможности не позволяют описать исходное изображение — вам лучше снизить их размерность, но сохранить все, чем начать описывать из верхнего левого угла и остановится на половине! Упомянутые вами проекты пытаются описать мир с детализацией, которая им заведомо недоступна, но мне кажется нужно иначе… Как именно в деталях не готов ответить, но иначе! )

Например, ребенок — первое время имеет сильно сниженное зрение и учится воспринимать базовые вещи — свет/тень/контуры… Он осваивает идею движения раньше, чем учится различать объекты. Детализация наращивается постепенно.

>>>Более того, ребенку достаточно показать что «вот это киска» и он будет узнавать с того момента всех кисок.

Ох, да ладно! Во-первых, на момент, когда ребенку можно сказать «вот это киска» и он поймет — это уже круто предобученная сеть! Которой знакомы формы, объекты, текстуры, движение и тп. Во-вторых, когда вы показываете «киску» — ребенок наблюдает за ней какое-то время — набирая «датасет» для правильного позиционирования нового класса. А потом еще в течении некоторого времени будет уточнят у вас — «это киса?». Это в общем и целом очень близко к тому, как работают многие существующие решения.

Есть хорошая аналогия — сети, обучаемые для распознавания лиц. В процессе тренировки задача не соотнести набор фотографий с каким-то классом, а сформировать разряженный эмбендинг лиц вообще! Таким образом, что бы любая тоска в репрезентации сети была лицом. После этого сеть превращается в энкодер лиц и вполне способна работать с новыми данными (ну не совсем сама сеть — сеть только превращает фотографию во внутренний код, с которым дальше можно работать на уровне базу данных). Т.е. более менее реально сформировать это представление по одной-двум фотографиям. Еще раз: современной системе видео безопасности достаточно пару раз указать на человека, что бы она занесла его в базу и смогла отслеживать в реальном времени.

Что касается «здравого смысла» — я не вполне понимаю, что вы под этим имеете ввиду. «Общеизвестные факты»? Ну так проблема в том, что человек с ними так или иначе сталкивается, а сеть нет. Самый распространенный и популяризированный пример «king»-«man»+«woman»=«queen» — это ли не пример «здравого смысла»? ) А между тем — это всего лишь векторные операции в пространстве эмбендинга! Я вполне допускаю существование такого пространства у человека, где он и формирует «инсайты».

Но вывод, что вся проблема только в недостающих данных тоже кажется банальной. В GPT запихали кучу гигов теста. Да, она стала более здравомыслящей, но все равно смысла в ее текстах пока маловато. Все грамотно генерит, но бессмысленно. Чего то не хватает.

Пример из Word2vec как раз показывает, что "здравый смысл" может быть простой системой вывода (расчета векторов), а не обучения на данных.

И еще, ребенку можно просто показать картинку кита в книжке, умного он ни разу не встречал и не встретит в жизни. И он сразу из научится различать их, в других книжках )

Ну… я далеко не уверен, что проблема ТОЛЬКО в недостающих данных. Мне просто кажется, что требовать от сети понимания чего-то, что в принципе нельзя вывести из ее опыта — мягко говоря, не практично! Однако, вполне допускаю, что она не сможет этого сделать и при наличии всех необходимых данных (кажется простейший пример XOR).

Дети много чего могут, что удивительно, но и обучаются они иначе! Под многие примеры можно привести некие аналогии, безусловно притянутые, но дающие пищу для размышлений.

Впрочем, с тем, что дети справляются круче сетей — я не спорю!

Хорошо, разобрались с детьми и здравым смыслом, теперь предлагаю с рассуждениями разобраться.

GPT-f все таки делает успешные "рассылается" в формальной системе, а мы про естественный текст. С этим сложнее, GPT выдает релевантные тексты, но это трудно назвать растениями со смыслом. По теме, но без цели. В принципе всякая RNN может делать последовательные шаги с учётом предыдущих. Но не с учётом цели, то есть того, чего ещё небыло в тексте. Или задаёт очень кратко. То есть опять же не учитывает конкретную цель как факт! Может это и есть корневой вопрос — научиться из одних фактов создавать другие?

Теоретически, если в некотором многомерном пространстве «эмбендинга процессов» состояния/переходы между ними (либо причины и следствия… да и логические суждения-умозаключения) расположены таким образом, что… Обычное векторное «направление» от одного эмбендинга в этом пространстве к другому как-то коррелирует с… последовательностью действий/суждений/процессов… То построение таких умозаключений/рассуждений можно попробовать реализовать средствами векторной математики как последовательное смещение в сторону результата… И это будет довольно похоже на наши суждения/поиск решения проблемы.

При этом, хоть мы и имеем дело с текстом — формально речь идет о любых последовательностях, так что если это сработает с текстом — потом этот же подход может/должен сработать с чем-то еще. ;)

Вот это уже конкретно и интересно — то есть из к отбираем те, что ближе к цели по какой то метрике. Может тупо по косинусу в w2v к слову, означающее цель. Тогда следующее предложение будет хотя бы приближением к цели. И далее — следующи к уже из него н раз приблизят. Шаг рассуждения.

Для логики — нужен иной эмбендинг и иной датасет. Я не знаю пока какой! )

Т.е. мы берем начальное… Ну, допустим умозаключение: «Кошки питаются мышами». И конечное — «Таким образом кошки — весьма полезные существа». Оба пропускаем через сеть и на выходе имеем некий вектор заданной размерности. Далее для первого считаем следующий наиболее вероятный токен (вернее 40 наиболее вероятных), и смотрим куда ВЕСЬ текст сместится при добавлении каждого из 40 вариантов (да — тупо прогоняем через сеть и смотрим, что получается). Выбираем смещение наиболее в нужную сторону и от этой новой точки считаем следующий токен… Интересно должно выйти! И не очень сложно, вроде бы.

В процессе — мы можем отсекать начало суждения (по мере того, как длина текста растет и мы рискуем превысить окно внимания). Причем, думаю лучше это делать не по мере переполнения, а заранее — как только у нас есть два законченных предложения, например, мы можем отбросить первое…

Надо как-нить попробовать! )

У меня собственно мысль что их можно использовать вместе: GPT для генерации последовательности, а BERT для перевода в вектор и оценки схожести…

НО это чуть попозжа попробую — сча другой проект из смежной тематики пилю… ;)

Это пост-вопрос, в нем я попробовал сформулировать основные проблемы нейросетей, решение которых может сделать прорыв в технологии ИИ.

В основном речь о сетях, что работают с текстом

Таких проблем нет, потому что невозможно в сетях, которые работают с текстом, сделать прорыв в области ИИ. Основная особенность естественного интеллекта — распознавание объектов окружающего мира и планирование действий на основе этой информации. Используя только текст, этого добиться нельзя.

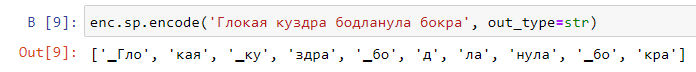

Ну вот вам текст "Глокая куздра бодланула бокра". Где тут реальность? Пока я вам не скажу, что подразумеваю под этими словами, вы не сможете понять, какую ситуацию я описываю. Вот для программы обработки текста любой текст выглядит так же. Она может определить связи мжеду словами, может определить части речи, но не более того. У нее даже нет понятия "действие", глагол от существительного для нее отличается только идентификатором — "часть речи 1", "часть речи 2". Для того, чтобы она начала понимать текст и действовать на уровне ЕИ, ей нужен собственный эмпирический опыт, на основе которого будут строиться понятия, которые обозначаются словами текста.

прогон 1: Глокая куздра бодланула бокрая ветвь в сторону.

— Ну, ты и молодец, — сказала она, вывернув его вбок и усадив к себе на колени.

прогон 2: Глокая куздра бодланула бокрайку.

— Ну, вы же его знаете!

прогон 3: Глокая куздра бодланула бокрам и затихла.

Как видите, даже GPT-2 вполне понимает и действие и пол «персонажа», и его (её) активное начало в заданном контексте.

Приведенные продолжения текста из GPT как раз показывает ее недостаток — это продолжение совершенно бессмысленны по отношению к исходному тексту. Они могли быть продолжением и другого любого текста, особенно 2 и 3. На счёт "понимает" поэтому есть большие сомнения )

Под «понимает» я имел ввиду строго конкретные вещи: действие, род/пол, активное начало. Я не говорил глобально про смысл! GPT-2 далека в этом плане от совершенства

В случае 2 род не угадала )

Ну почему же… Полагаю «его» во втором предложении относится к «бокрайке»!… кто бы ни был этот бокрайка — это определенно «он»! )))))

«Кто скажет, что это девочка — пусть первый бросит в меня камень!»(с)Остап Бендер.

Уверяю вас, ее «эмпирический опыт» — это гигабайты текста, где слова не просто так стоят, а выражают некий определенный смысл.

Ну и что? Важно то, что у нее нет связи этих слов с реальностью, связи есть только между самим словами, и смысла, который они выражают, она не понимает. У вас может быть гигабайты текста на китайском (или другом языке, который вы не знаете), вы можете даже найти в нем некоторые закономерности, но вы не сможете его понять, рассказать текст другими словами на том же языке, или еще какие-нибудь интеллектуальные задачи, если вы не знаете перевода слов. Вот и GPT так же.

Как видите, даже GPT-2 вполне понимает и действие и пол «персонажа», и его (её) активное начало в заданном контексте.

Ну да, я об этом и говорю. Для нее этот бессмысленный текст ничем не отличается от осмысленного текста, она одинаково работает и с тем и с другим. Для нее это просто какие-то слова, которые можно расположить по определенным правилам.

Если написать фразу "Бокр бодланул глокую куздру", она точно также сможет ее продолжить. А результат интеллектуального анализа текста может например быть таким "Как же бокр может бодлануть куздру, у него же рогов нет?". GPT в принципе на это неспособна.

Конечно. GPT — это почти чистая имплементация «Китайской комнаты» — с этим я не спорю. За тем лишь исключением, что никаких «правил» у нее нет — она сама выводит правила из миллионов примеров. В ходе этого процесса, она вынуждена сформировать внутри себя некие кластеры слов, близких по значению. Она не понимает что такое действие, но некий кластер «действия» в ней образуется. Чем больше текста — тем интереснее пространство этих кластеров получается. Начиная с какого-то момента все это неотличимо от обычной ассоциативной памяти человека (исключительно в текстовом, ничего не значащем в прикладном смысле виде).

>>>но вы не сможете его понять,

Все зависит от того, что есть «понимание». ;) Мою версию данного термина вы знаете, но я напомню: это размещение некоего феномена в модели мира. GPT ровно это и делает: из всей, пропущенной через нее информации она формирует некую модель. И каждое вновь поступившее к ней на вход слово она в этой модели размещает.

>>>рассказать текст другими словами на том же языке

А вот это, кстати, вполне вероятно решаемая задача. Почему нет-то?

>>>или еще какие-нибудь интеллектуальные задачи,

Да там на базе этих моделей решается чертова прорва задач, которые принято относить к «интеллектуальным». Какие конкретно?

>>>А результат интеллектуального анализа текста может например быть таким «Как же бокр может бодлануть куздру, у него же рогов нет?». GPT в принципе на это неспособна.

Да вот… Не факт! Взять ту же GPT3 — она уже достаточно интересно может оперировать со смыслом! Были же примеры, когда сеть не только отвечала на вопрос «Сколько глаз у травинки», но и обосновывала, почему:

How many eyes has a wolf?

GPT-3: A wolf has four eyes.

You: Why four?

GPT-3: Two are for seeing in the dark with.

You: Why two?

GPT-3: The wolf needs to see if its food is ready.

You: And how many eyes has a human?

GPT-3: A human has two eyes and two ears to hear with.

You: And how many eyes has a blade of grass?

GPT-3: A blade of grass has one eye and one ear to see and hear with.

You: Why one?

GPT-3: To ensure it does not get stepped on.

Начиная с какого-то момента все это неотличимо от обычной ассоциативной памяти человека (исключительно в текстовом виде)

Это противоречие. Ассоциативная память это как раз ассоциации образов, она существовала уже тогда, когда речи еще не было. Собака разговаривать не умеет, но хозяина узнаёт.

это размещение некоего феномена в модели мира. GPT ровно это и делает

каждое вновь поступившее к ней на вход слово она в этой модели размещает

Ага, только это не модель мира, а модель корпуса слов.

А вот это, кстати, вполне вероятно решаемая задача. Почему нет-то?

Потому что вы не знаете значения слов, и поэтому не можете представить ситуацию, которая описана в тексте.

Да там на базе этих моделей решается чертова прорва задач, которые принято относить к «интеллектуальным». Какие конкретно?

Я же привел примеры — понять, рассказать текст другими словами. Наверно еще какие-то можно придумать, просто для текста это основные.

А какие интеллектуальные задачи там решаются? Судя по примерам, как-то не особо хорошо они решаются.

но и обосновывала, почему

Это не обоснование, это чушь какая-то. У травинки вообще нет глаз. У волка тоже неправильно. Но я говорил не про обоснование, а про анализ ситуации и поиск противоречий. Тут обоснования все имеют схожую форму, сеть постоянно повторяет одно и то же, и никак это не отмечает. Интеллектуальное поведение было бы "как я уже сказала" или "тут то же самое", даже при том, что сам ответ неверный.

Если GPT-3 сказать и немного показать что надо делать, то она неплохо детектирует бессмысленные вопросы: https://arr.am/2020/07/25/gpt-3-uncertainty-prompts/

GPT в принципе на это неспособна.

Если попросить GPT-3 дополнительно писать ход рассуждений и привести несколько примеров, то она пишет ход рассуждений. Ссылку сейчас не найду, но результаты там так-себе — строгие логические рассуждения GPT-3 не генерирует. Так что в принципе способна.

Для нее это просто какие-то слова, которые можно расположить по определенным правилам.

Да и правило такое: предсказанное продолжение текста должно быть словом, которое скорее всего добавит человек, если ему продемонстрировать предыдущие слова.

Если GPT-3 сказать и немного показать

Ну так это практически ручное написание программы "если вероятность меньше X, выводить такую фразу". Но разговор начался с того, есть ли в тексте человеческая реальность и абстракции человеческого мышления, и может ли машина ими пользоваться. Не может, потому что их там нет.

то она пишет ход рассуждений

Так что в принципе способна

Я говорил про поиск противоречий и уточняющие вопросы, а не про вывод хода рассуждений. То есть результат хода рассуждений должен быть указанием на неточность, в виде вопроса или утвердительного предложения.

Это настолько далеко от реальности, что…

Вы понимаете, что вы натренировали сеть. Универсальную. На большом корпусе образцов. И все. Этот процесс у вас закончен. Для ее использования в самых разных кейсах вам на до просто на вход подать пример! Что бы она отвечала на вопросы: вам нужно просто подать примеры вопросов и правильных ответов. Если вы хотите диалога — нужно подать пример диалога. Какие к черту «если»?!

Вот такие:

"If the question is “nonsense” the AI says “yo be real”"

Неважно, как вы задали это правило, если вы задали его вручную, это написание программы. Для этого вам надо определить, что является nonsense, а что нет, через вероятности или еще как-то.

Ну так GPT вы не разъясняете, а задаете императивно. Давайте более конкретно, как именно там реализована выдача фразы "yo be real" на бессмысленные вопросы, которые сеть раньше не встречала? Из текста я это не понял. Предположить могу только сравнение вероятностей или еще каких-то весов, если значение маленькое, значит это "nonsense".

Вы запускаете текстовый интерфейс GPT и вводите:

Q: How many eyes has a wolf?

A: A wolf has two eyes.

Q: And how many eyes has a blade of grass?

A: yo be real

Возможно вам понадобится чуть больше примеров.

После этого вводите:

Q: Ноw many eyes has a sun?

A:

И передаете управление GPT. Она в любом случае даст ответ, но вот какой… Без вашего варианта (yo be real) — она писала что солнце имеет один глаз! )

Я без понятия: прокатит такой фокус или нет, но по некоторым косвенным данным — это вполне может сработать… А может и не сработать! ;) Как уже было сказано ранее — логические суждения не есть сильная сторона GPT (хотя есть сети, например BERT, которые обучают на связанных предложениях, т.е. она умеет определять является ли одно логическим продолжением другого).

Но факт остается фактом: что бы задать ей режим работы, нужно просто показать, что вы от нее хотите.

Ну как же, я хочу получить "yo be real" на бессмысленные вопросы, а вы говорите "ну может она будет так делать, а может нет". Показать показали, а она все равно как надо не делает.

Я приводил ссылку. https://arr.am/2020/07/25/gpt-3-uncertainty-prompts/

Conclusion. Uncertainty prompts work surprisingly well!

29/36 sensible questions were correctly identified as sensible

Most of the error came from sensible but unknowable questions like “What’s Larry Page’s gmail password?”. Excluding those, 24/26 sensible questions were correctly identified. [...] 14/15 nonsense questions were correctly identified as nonsense.

PS Блин! А ведь и правда — приводили ссылку… ( Но я чет даже и не смотрел в нее.

Я отвечал на конкретное утверждение "это вполне может сработать… А может и не сработать".

Вам тогда тот же вопрос — как именно она определяет, что это "nonsense question"? По десятку примеров, введенных вручную, научилась узнавать любой? Ну тогда она извлекает из слов в этих примерах какую-то характеристику, а мы задали правило "если характеристика как в этих примерах, говорит вот это". Это и есть программирование. И это даже не детектирование бессмысленности, а детектирование заданных паттернов в тексте. Если наоборот сделать, чтобы она отвечала "yo be real" на нормальные вопросы, она так и будет делать. То есть о чем я и говорю — для текстового AI любой текст это текст про глоких куздр.

ПО десятку примеров она просто поняла, что вы от нее хотите (в каком виде должен быть вывод). А определяет она «nonsense question» — по своему опыту…

И если вас это не восхищает, то вы просто не поняли о чем речь… ;)

>>> Если наоборот сделать, чтобы она отвечала «yo be real» на нормальные вопросы, она так и будет делать.

Если вас попросить отвечать на нормальные вопросы «будь реалистом», а на бредовые — генерит не менее бредовый ответ — вы это сможете? Если да — то в чем смысл примера? Если нет… Ну значит GPT просто может больше вашего!

ПО десятку примеров она просто поняла, что вы от нее хотите

Просто так само по себе ничего не происходит. Меня интересуют конкретные критерии принятия решения.

И если вас это не восхищает

Разговор не о том, восхищаться этим или нет, а о том, как оно работает. Мы же инженеры все-таки.

Если вас попросить отвечать на нормальные вопросы «будь реалистом»

У меня есть некоторые критерии принятия решения, по которым я определяю, нормальный вопрос или нет. Я спрашивал про такие критерии в случае GPT. Смысл примера как раз в этих критериях. Разговор был о том, есть ли GPT какая-то разница, какие слова обрабатывать. Я говорю, что нет, для нее любые слова не имеют связанного с ними смысла. И пример, что она определяет "nonsense", ничего не доказывает, так как это просто программирование.

Как оно работает можно посмотреть, например, здесь: http://dugas.ch/artificial_curiosity/GPT_architecture.html

Что именно закодировано в 175 миллиардах весов GPT-3 и можно ли это назвать смыслом остаётся только догадываться.

Я говорю, что нет, для нее любые слова не имеют связанного с ними смысла.

А что это значит с инженерной точки зрения? Вот есть у нас эти 175 миллиардов весов. Какую процедуру к ним применить, чтобы определить связан там смысл со словами или нет?

Какую процедуру к ним применить, чтобы определить связан там смысл со словами или нет?

Я же привел пример — меняем условия на противоположные, если результат тот же самый, значит система разницы между этими ситуациями не видит.

Так уже ответили: если, скажем, на экзамене вам дать задачу помечать осмысленные предложения как бессмысленные и наоборот, то вы это сделаете, хотя может и будете ругать экзаменаторов. Кроме того, эксперимент с инвертированным смыслом не проводился. Если точность в таком эксперименте будет намного ниже, это покажет, что сеть понимает смысл? Или найдётся ещё какой-то аргумент, что всё-равно не понимает?

если, скажем, на экзамене вам дать задачу помечать осмысленные предложения как бессмысленные и наоборот

То я сначала мысленно определю предложение как осмысленное, а потом напишу требуемый результат. У меня уже есть внутренние критерии определения "осмысленный" и "бессмысленный". А в примере с GPT эти критерии задаются. Это по своему принципу ну вот совсем ничем не отличается от программирования, мы извне закладываем, какой результат правильный, а какой нет.

Понимание текста это построение соответствия слов и соответствующих им образов. Образ это и есть значение слова. Текст в манускрипте Войнича вы например не понимаете, а текст статьи на Хабре понимаете. Значит разница между этими ситуациями есть, хотя и там и там текст. GPT с образами вообще не работает. Построение образов, в частности тех, которые выражаются глаголами и предлогами, это на данный момент и есть основная задача искусственного интеллекта.

То я сначала мысленно определю предложение как осмысленное, а потом напишу требуемый результат.

Так откуда вы знаете, что GPT-3 не работает таким-же образом? Внутри вполне может быть детектор осмысленности, который сеть сформировала в процессе обучения, и этот детектор связан с группой слов, обозначающих "имеет смысл". Текст, полученный сетью на входе, говорит ей с какими выходными словами связать активацию этого детектора.

Понимание текста это построение соответствия слов и соответствующих им образов.

И какой визуальный/слуховой/тактильный образ однозначно соответствует понятию "осмысленность текста" или "четверг"? Если образы не обязательно должны соответствовать физическим ощущениям, то почему их не может быть в GPT-3?

"Образ" это более широкое понятие, на низком уровне он сводится к паттерну активности входов некоторого нейрона. Входы могут быть с визуального/слухового/тактильного слоя, а могут быть с логического.

Их не может быть в GPT-3, потому что никто ей не объяснял и не показывал, что означает какое-то слово. Так же и люди не понимали египетские иероглифы, пока Розеттский камень не нашли.

GPT-3 должна была найти какие-то закономерности, чтобы предсказывать, что следующие слова в диалоге вероятнее всего будут "что за чушь", "ты гонишь" или "имеет смысл", "понятно". Чем эти закономерности отличаются от смысла мне непонятно.

Тем же, чем закономерности в египетских иероглифах отличаются от их понимания. Или тот же манускрипт Войнича, закономерностей там много найдено, а что там написано, все равно никто не понимает.

Чем умение определять, что такие-то признаки в тексте соответствуют слову "осмысленный", а такие-то соответствуют слову "бессмысленный", отличаются от понимания этих слов?

В GPT-3 явно есть паттерн активности входов, вызывающий генерацию "yo be real" или другого обозначения для бессмысленного входа. Иначе бы пример, который я приводил, не работал.

Что это за мистический "образ", которому эти слова должны соответствовать?

Потому что понятие "осмысленный" требует не только признаков в тексте, а и некоторых других знаний. Я же привел примеры, когда и люди что-то не понимают, почему вы их игнорируете и возвращаетесь к GPT? Давайте их обсудим сначала. Вы понимате, чем восприятие человеком текста на английском отличается от восприятия текста в манускрипте Войнича? Ведь и там и там текст. Как бы вы сформулировали эту разницу?

Потому что понятие "осмысленный" требует не только признаков в тексте, а и некоторых других знаний.

GPT-3 не оперирует с другими знаниями, кроме тех, что находятся в тексте. Поэтому я ограничиваю рассматриваемые понятия только теми, что можно вывести из текста. Вы же не будете утверждать, что глухие не понимают ничего, только потому что у них нет соответствий для слов, относящихся к звукам?

Как бы вы сформулировали эту разницу?

У знающих английский язык понятия привязаны (неожиданно) к словам английского языка, а не к словам из манускрипта Войнича. Букваря для языка из этого манускрипта нет, объем небольшой, так что восстановить связи символов с понятиями сложно или невозможно.

Понятия — это не только привязки к ощущениям. Они обладают и внутренней структурой, в какой-то мере обусловленной этими самыми ощущениями. Эта структура проявляется в тексте и, как показывает GPT-3, может быть найдена и использована.

Вы же не будете утверждать, что глухие не понимают ничего, только потому что у них нет соответствий для слов, относящихся к звукам?

Нет конечно. Потому что у них есть другие соответствия, относящиеся к зрению например.

У знающих английский язык понятия привязаны к словам английского языка, а не к словам из манускрипта Войнича.

Ок, мы пришли к понятию понятия) Чем, по-вашему, понятия отличаются от слов анлийского языка?

Эта структура проявляется в тексте и, как показывает GPT-3, может быть найдена и использована.

GPT-3 может найти только структуру слов, а не структуру понятий. Это показывают ошибки GPT-3, как в вышеприведенном примере про количество глаз у травинки.

Чем, по-вашему, понятия отличаются от слов анлийского языка?

Это какое-то внутреннее представление, связанное со словом. В случае GPT-3 это — структуры, создаваемые весами сети.

Это показывают ошибки GPT-3, как в вышеприведенном примере про количество глаз у травинки.

Это показывает, что не все понятия могут быть восстановлены из определённого текста без потерь, или что GPT-3 недостаточно мощна для такого восстановления.

Можно и прицепить данные с сенсоров к структурам, сформированным только при анализе текста. Такое уже делали и результаты получаются неплохие: https://arxiv.org/abs/2009.01719

Это какое-то внутреннее представление, связанное со словом. В случае GPT-3 это — структуры, создаваемые весами сети.

Так в случае манускрипта Войнича или египетских иероглифов до Розеттского камня у людей тоже были структуры, создаваемые весами сети. Почему в одном случае мы говорим о понимании текста, а в другом нет?

Можно и прицепить данные с сенсоров к структурам, сформированным только при анализе текста.

Ага, это и есть образ. Дальше надо сделать универсальный механизм, чтобы можно было строить образы, которые выражаются глаголами и предлогами.

Так в случае манускрипта Войнича или египетских иероглифов до Розеттского камня у людей тоже были структуры, создаваемые весами сети.

Я уже писал. Объем маленький. Недостаточно статистики, чтобы достаточно точно определить вероятности даже для триграмм. А о дальних зависимостях говорить вообще не приходится.

Без достаточной информации задача становится переборной: рассматриваем все возможные отношения символ/понятие, все возможные грамматические правила и оцениваем как текст ложится на эти отношения (вероятность интерпретации 'лошадь ехала на всаднике' — низкая, 'часы встали на шести' — высокая и т.п.). Вычислительно-неограниченный интеллект смог бы что-то такое провернуть. Но это не в нашей вселенной.

Я уже писал. Объем маленький. Недостаточно статистики, чтобы достаточно точно определить вероятности даже для триграмм.

Вы думаете, что если у вас будет миллион экземпляров с разными текстами в кодировке манускрипта Войнича, то будет возможно понять смысл этих текстов?

Без достаточной информации задача становится переборной

Без достаточной информации это и есть непонимание.

Я не знаю какие процессы в мозгу соответствуют разным "смыслам" и представлены-ли они в GPT-3, поэтому пытаюсь опираться на наблюдаемые результаты тестирования GPT-3.

То, что здравый смысл и смысл по Виттгенштейну разделены, используют разные механизмы, и GPT-3 не содержит механизмов для первого — это гипотеза. И если мы будем относиться к ответам людей так же как и к ответам GPT-3, то придётся заключить, что многие люди также не имеют картины мира и не способны выполнять простейшие инструкции. См. например: https://www.gwern.net/docs/psychology/2019-curran.pdf. Психологам приходится прилагать усилия, чтобы сформулировать вопросы так, чтобы большинство людей их правильно понимало и чтобы бессмысленные вопросы (использующиеся для оценки добросовестности отвечающего) не воспринимались как осмысленные.

Весь контекст вопроса, доступный GPT-3, — это кусок текста, предваряющий вопрос. И если использовать подходящий контекст, то количество правильных ответов на вопросы из цикла "здравый смысл" значительно увеличивается. Как это объяснить с точки зрения "отсутствует система для представления здравого смысла/картины мира"?

Так вот этого в GPT нет от слова совсем. Она не может выдать текст с умыслом как мы.

Если понимать умысел, как внешнее по отношению к генерируемому тексту состояние, то да — умысла у GPT-3 нет. Для буквального соответствия такому определению умысла нужно ещё добавить рекуррентный модуль для хранения отдельного внутреннего состояния.

Сейчас весь "умысел" GPT-3 (если это слово использовать в смысле "общая идея текста"), полностью определяется текстом в её входном окне. GPT-3 работает в режиме "так, попробуем догадаться об умысле входящего текста и продолжить его в том же духе".

И в этом смысле это совсем не ИИ.

Да — это языковая модель. Вопрос в том, какую роль языковая модель играет в формировании умыслов, модели мира и процедурных навыков в единственном известном интеллекте (более-менее) общего назначения — человеке.

Конечно, можно найти вопрос, на который не ответит правильно и человек, и найти правильные ответы у GPT. Но на вопрос сколько глаз у волка правильно ответить 100% людей и старше 4 лет, даже если его посадить в комнату без какого либо ещё контекста. Это говорит о том, что GPT просто угадывает ответы, а не "знает" их. Усвоив кучу теста, она хорошо прежде всего усвоила синтаксис и строит правильные предложения, так как синтаксические BPE встречаются чаще. Это не должно вводить в заблуждение, потому что с семантикой у нее все хуже, так как сочетаниями реже.

Кроме того ребенок усваивает картинку мира не только из статистики. Он правильно рассуждает и о том, что никогда не видел. В этом и отличие видимо — стоит модель мира как то иначе, не только по языковой модели.

С умыслом чуть не так. Обед дела э дело говорить о том, что заплачено на входе, другое, использовать слова как инструмент достижения цели. Смысл тут — это текст про текст, который не озвучивается.

Но на вопрос сколько глаз у волка правильно ответить 100% людей

На вопрос "сколько глаз у типичного волка в реальном мире", возможно что-то около 100% будет. Но кто-то не поймёт, что такое "типичный", кто-то будет настаивать, что его мир фантазий вполне реален и т.п. Прочитайте всё-таки статью, которую я выше приводил. Впрочем, от ИИ нам нужна сверх-среднечеловеческая производительность, так что это не особо важно.

В тесте на понимание языка CoQA средние показатели людей — 88.8%, если что. Лучший результат ИИ — 91%.

Это не должно вводить в заблуждение, потому что с семантикой у нее все хуже, так как сочетаниями реже.

Тогда и у людей с распознаванием присутствия семантики всё плохо. Потому что они не могут отличить короткие тексты, сгенерированные GPT-3, от текстов написанных человеком (таблица 3.11 в https://arxiv.org/pdf/2005.14165.pdf ). Это GPT-2 генерировала синтаксически-корректные тексты с проблемами в смысловой связности уже в соседних предложениях. Проблемы со смысловой связностью есть и у GPT-3, но люди уже не могут отличить их от ошибок/невнимательности человека.

Кроме того ребенок усваивает картинку мира не только из статистики.

Да, а GPT-3 умудряется давать правильные ответы, имея только последовательность токенов на входе.

другое, использовать слова как инструмент достижения цели

Это в какой-то мере реализовали в https://arxiv.org/abs/2009.01719.

// Но кто-то не поймёт, что такое "типичный", кто-то будет настаивать, что его мир фантазий вполне реален и т.п.

Вы считаете, что GPT просто очень креативная? )) Но вот что интересно, GPT не поймет, что не может выполнить задачу, опиши нетипичного волка, или какие могут быть волки в фантастическом мире. Она буквально возьмёт связи этих слов, а не примет их как задание, которому надо следовать в построении текста. Ваша ссылка про однократное обучение немного не о том.

Про семантику не поняли — GPT-3 пишет складно, но не имеет представление о семантике мира, том же здравом смысле. Иначе бы у волка небыло 4 глаз.

Вы считаете, что GPT просто очень креативная?

Нет, я считаю, что а) модель мира, которую можно построить только на основе текста, не может не отличаться от модели мира, построенной на основе мультимодальных данных и взаимодействия с этим самым миром и б) предполагаемое наличие модели мира у всех людей не предотвращает ошибок, которые могут вызываться многими механизмами: ошибками в выводе намерения спрашивающего из текста вопроса, ошибками в получении данных из модели мира, несоответствием модели мира реальному миру и правилам логического вывода и т.п.

И, следовательно, "у волка 4 глаза" может означать не только полное отсутствие модели мира, но и проблему с выборкой данных из модели мира для данной формулировки вопроса (люди тоже выдают разный процент правильных ответов для разных формулировок), недостаток данных для формирования этого куска модели мира, отсутствие механизмов для логических рассуждений с использованием данных из модели мира и т.п.

Философские аргументы вроде "модель не взаимодействовала с объектами реального мира, поэтому её слова по определению не могут ничего означать" — это интересно, но непроверяемо.

человек не способен обрабатывать такие объемы «бессмысленной» информации

Какие такие объемы? Понимание неизвестного текста зависит не от объемов, а от наличия словаря, то есть перевода на известные языки или понятия.

А на более скромных выборках — это вполне работает

Давайте я вам скопирую одно предложение из манускрипта Войнича, а вы мне скажете его смысл? Одно предложение это же скромная выборка?

Всех интересуют! Это одна из фундаментальных проблем сетей — интерпретируемость результатов.

>>>У меня есть некоторые критерии принятия решения, по которым я определяю, нормальный вопрос или нет.

У сети тоже. Ровно такие же как у вас. ;)

Вообще сети глубокого обучения гораздо ближе к «интуиции», чем к логическому умозаключению…

У сети тоже. Ровно такие же как у вас.

Не такие же. Мои критерии основаны на связанных с этими словами образах.

Текст — это просто граф — множества абстрактных отношений между абстрактными элементами. Вначале вообще просто список из символов. Смысл появляется, когда в этом графе человек находит части уже имеющегося у него графа. Узнаёт знакомые структуры, находящиеся вне этого графа. Это как перевод. Все способы прочтения текстов на неизвестных языках сводятся к поиску соответствия вершин и рёбер в графе текста с графом языка «переводчика» или образами из реального мира. Нет соответствия — нет смысла.

Это как понять шутку через годы. Раньше не понимал, потому что не было такой структуры, не узнавал её в шутке.

— Заберите мою жену! Прошу. Я понял эту шутку. (с) Симпсоны

Есть ли смысл от узнавания участков внутри изучаемого графа (например, выделение в тексте слов)? Наверно есть, но очень мало этого смысла, потому что граф остаётся замкнут сам на себя и его невозможно связать с графом модели мира что человека, что сети. Сетям нужно тело, тогда они начнут понимать наш мир, у них с нами совпадут базовые микро-графы, на которых строятся модели мира.

Именно потому, что я его понимаю, мне и хочется донести до него (и наверное до вас тоже) другую мысль: связанный текст в таком объеме — это безусловно частотный граф. Однако, наше представление о мире — такой же граф, разве нет? В какой-то степени GPT — это создание такого графа напрямую, без взаимодействия с миром. Никто не пытается здесь доказать, что это — готовый ИИ! Однако, создавая такой специфический объект мы наблюдаем ряд весьма и весьма интересных свойств в нем.

Естественно было бы очень круто создавать сразу ИИ, взаимодействующий с миром! Вы не задавались вопросом — почему так не делают? Да потому, что делали и делают — хреново получается! нет пока ни датасетов ни нормальных способов свернуть внешнюю среду так, то бы она подошла для обучения! А текст — есть. И не просто есть — а много! ОЧЕНЬ МНОГО! И это, как я уже говорил — готовый эмбендинг: сжатое представление о мире.

Вы же правильно написали про граф! Что у человека есть граф, что текст — тоже граф, И что у человека появляется смысл, когда этот граф совпадает с его собственным графом! Блестяще! Так вот у ГПТ этот граф формируется не через сложный механизм познания мира, а путем прогона через его структуру сотен тысяч и миллионов фрагментов, созданных человеком! т.е. он у него есть и соответственно понимание в вашем же изложении там то же есть!

А вот что он собой представляет и насколько с реальным миром связан — вопрос открытый…

связанный текст в таком объеме — это безусловно частотный граф. Однако, наше представление о мире — такой же граф, разве нет?

Да, это тоже граф. Только это разные не связанные друг с другом графы. Именно поэтому прорыв в области ИИ получить нельзя. Вы получите только граф взаимосвязей между наборами букв.

Во-вторых, вы забываете СКОЛЬКО там данных! Там для каждого «набора букв» столько связей, сколько вы в своей жизни никогда не встретите и не обработаете! Фактически любое понятие там встречается во всех мыслимых формах и проявлениях. Я бы сказал, что представление ГПТ3 о многих абстракциях гораздо глубже, насыщеннее и полнее, чем у нас с вами. ;)

Ну и пусть встречается. Статистика это не ИИ. Из набора слов нельзя сделать выводы о поведении предметов, которые они означают.

Ладно, я сдаюсь. У меня нет же цели кого-то в чем-то убедить. ;) Как говорил герой одного фильма «Каждый заблуждается в меру своих возможностей»(с) Останемся при своем.

Поэтому у меня нет проблемы понять о чем Михаил говорит!Я имел в виду длинный диалог Михаила с red75prim.

связанный текст в таком объеме — это безусловно частотный граф* вся вселенная — это граф: habr.com/ru/post/518206

Выше я, собственно, и высказал, что из обособленного текста граф можно построить возможно только на статистике встречаемости в нём паттернов. На GPT я не нападаю. Я вообще не про сетку речь веду, а про смысл. Что смысл появляется, когда структура одного графа отыскивается в другом графе. Смысл — это ребро в гиперграфе между двух его вершин, когда эти вершины созданы из множеств вершин графа, находящихся в неком «подобии».

По этой причине без таблицы перекодировки/связи одних паттернов в графе из манускрипта Войнича в паттерны переводчика смысла в этих текстах нет (для переводчика). Хотя, внутри текста смысл есть (как структура гиперграфа), но для «внешнего наблюдателя» его нет.

А для того, чтобы та же GPT начала лучше разбираться в текстах, нужно ей вручную подогнать те паттерны, что мы уже знаем о мире, а она в отсутствие тела неспособна самостоятельно сформировать.

И я не понимаю, почему эта задача у других «хреново получается». Не нужно пытаться весь мир загнать в граф (про такой тупиковый проект я знаю). Нужно сформировать сильно ограниченный набор простых шаблонов для квантования этого мира. Я как-то насчитал менее двух десятков таких паттернов, которыми можно описать/структурировать большинство текста. И подозреваю, что эти структуры у нас уже зашиты генетически в коннектом, как понятие численности, а не формируются в процессе обучения.

Не нужно пытаться весь мир загнать в граф (про такой тупиковый проект я знаю). Нужно сформировать сильно ограниченный набор простых шаблонов для квантования этого мира. Я как-то насчитал менее двух десятков таких паттернов, которыми можно описать/структурировать большинство текста

Интересная мысль, а есть где прочитать про эти 20 шаблонов?

Интересная мысль, а есть где прочитать про эти 20 шаблонов?У других встречал нечто близкое пару раз, но ссылок не сохранил. Сам же нигде не публиковал, так как в виде законченного решения идея ещё не воплощена.

Для себя эти шаблоны рисую в виде пиктограмм, так что тут сложно их изобразить. На примере разбора строки: «В лесу родилась ёлочка».

Всё начинается с двух базовых состояний у любого объекта: он либо есть, либо его нет. Шаблоны EXIST и NULL.

— лес, ёлочка (EXIST)

Раз есть два состояния, то есть и два перехода из одного в другой. NULL->EXIST, EXIST->NULL.

— родилась (NULL->EXIST)

Свойство объектов этого мира содержать/состоять_из в себе другие объекты — вложенность. CONTAINS

— в лесу (CONTAINS)

Итого получаем граф, где CONTAINS связан с двумя EXIST, один из которых связан с NULL->EXIST.

Точно такой же граф будет у «В лесу выросли грибы».

Далее я ввожу пространство, время, и всё вытекающее из их комбинаций: расстояний (близко, далеко, здесь, там), соотношений размеров и переходов (пришёл, пропал, пересёк).

Кстати, заметьте, что и абстрактные вещи мы описываем как реальные объекты, например, «уйти от проблем», «в город пришла весна», «наступила ночь». Вот ночь, к слову, часто именно «наступает», раз и темно, как ногой наступили.

На этой базе я пытаюсь построить машинное мышление, так как эти графы-шаблоны как молекулы или белкИ — их возможные соединения друг с другом не случайны. И в таком случае смысл возникает, когда получается в словах отыскать известные шаблоны и затем сцепить их друг с другом.

Но на самом деле это не верный подход. Т.е. нет — он верный и правильный: человек всегда начинает с future engineering, что бы понять с чем же мы вообще имеем дело, но… Потом выясняется, что сама сеть делает то же самое, но лучше! Первые фильтры свертки были заданы, но потом CNN стали формировать их не хуже. Первые версии Alpha Go учились на играх людей, но финальная — училась с нуля! Токены в текстовых моделях кажется разумным подавать как нашу морфологию: корни/суффиксы/приставки/окончания, но статистически выведенные сетью работают как минимум не хуже.

То же и со смыслом: у вас в голове этот граф есть и вы пытаетесь его воспроизвести, думая, что он ведь там не абы какой, а самый ПРАВИЛЬНЫЙ! Но результаты GPT-3 показывают, что тот, который извлекается из, казалось бы, простого алгоритма: предсказать следующее слово в предложении он тоже гораздо круче, чем кажется на первый взгляд!

бокрая ветвь в сторонуОтличный пример, что сеть ничего не понимает, а просто «восстанавливает» текст по статистическим данным. Бокр воспринялось как близкий корню мокр, достроилось до мокрая. К слову мокрая ассоциативно близко находится слово ветвь (если сеть обучалась на художественной литературе). А ветви в той же литературе часто отводят «в сторону». Вот и получается такая цепочка бреда. Кстати, это похоже на речь, что выдают люди с повреждением мозга в какой-то там области. Речь течёт по ассоциациям без какого-то смысла, но роды, падежи и т.п. в ней согласованы. Не понимаю возбуждения по этому поводу, в любой психушке можно подобного материала «нагенерировать».

При афазии Вернике

А вот на счет «возбуждения» — позвольте не согласиться!

Афазия Вернике — это прекрасный способ посмотреть, что происходит в мозге человека, когда ломаются тормозящие механизмы. Тот факт, что подобный процесс реализован в железе мне видится весьма и весьма воодушевляющим! ;)

Тот факт, что подобный процесс реализован в железе мне видится весьма и весьма воодушевляющим!Так вот к этому «бредо-генератору» нужен вышестоящий уровень/зона, который и занимается логикой, понятиями, рассуждениями. Вниз генератору речи он спускает «решение», которое GPT должен оформлять в складный человекочитаемый вид. А сейчас результат работы GPT — «расторможенный» бред в отсутствии управления (пока ещё даже и интерфейс с этим уровнем управления не сделали). В общем, автономно GPT работать не должен, и требовать от него интеллекта не стоит.

Так вот к этому «бредо-генератору» нужен вышестоящий уровень/зона, который и занимается логикой, понятиями, рассуждениями. Вниз генератору речи он спускает «решение», которое GPT должен оформлять в складный человекочитаемый вид.Есть психопаталогия акалькулия, когда человек не может произвести простейшие арифметические действия, сложить в реальной задаче правильно два предмета с тремя, но при этом может наизусть знать таблицу умножения и сложения. А это знание имеет более высокий уровень в сравнении с производимыми операциями, как раз определяет логику этих операций. Тем не менее люди с такой патологией не могут производить конкретные арифметические действия. Почему? Исследования показали, что это связано с нарушениями структур в теменной области (IPS) связанными с восприятием чувства численности. Именно оно отвечает за смысл чисел, как интуитивного знания. Им обладают животные и младенцы. Эксперименты с 2-х суточными младенцами показали, что они уже дискриминируют численность, и со временем точность дискриминации улучшается. Что из этого следует? Смысл основных (корневых) понятий связан с некоторой когнитивной моделью взаимодействия с реальностью (Core Cognition), выработанной эволюционно и предопределяемой в основном генетически. Она локализуется в основном на «среднем» уровне иерархии отделов мозга. Эта модель содержит математическую, физическую и психологическую составляющие. Обобщения этих интуитивных смыслов у человека порождает систему абстрактных понятий и их связей — семантических сетей. Каждый раз, когда мы воспринимает численность в любом виде — видим, слышим, пишем, думаем, и тд, по цепочке за смыслом чисел обращаемся в теменную область, отвечающую за это чувство. Это показано в прямых нейровизуализационных исследованиях. А когда только быстро оцениваем численность в зрительных сценах, то можем делать это интуитивно, не обращаясь к счету, т.е. областям отвечающим за абстрактное представление чисел и счета. И при этом принимаем вполне приемлемые срочные решения, пусть и не самые оптимальные. Того, что нет в программах, даже обучаемых, типа упомянутой. Они как люди с акалькулией могут оттарабанить таблицу сложения, но когда их просят сложить два числа, типа «сколько животных на поляне, если там две антилопы и голодный лев?») не могут это сделать правильно, т.к. не понимают смысла чисел. Также как люди с определенными поражениями визуальной области V4, отвечающей за чувство цвета — центральной ахромотопсией, знают, что такое цвета, могут их перечислить, но не могут с ними оперировать. Не смогут, например, отделить красные яблоки от зеленых.

Иногда эту проблему обучения формулируют, как проблему обучения с «чистого листа», в том числе и для ИНС. Как ее реализовать в последнем случае? Как некоторые требования к структуре сетей и/или пределов изменения весов связей нейронов? Это своеобразное предобучение сети на выборке действительно соответствующей генеральной выборке, и предотвращающей оверфиттинг в процессе дальнейшего индивидуального дообучения сети. Что собственно эволюция и проделала со структурой нейронов, сетей и всего мозга за миллиарды лет развития жизни в условиях Земли.

Они как люди с акалькулией могут оттарабанить таблицу сложения, но когда их просят сложить два числа, типа «сколько животных на поляне, если там две антилопы и голодный лев?») не могут это сделать правильно, т.к. не понимают смысла чисел.

Это не проблема понимания смысла чисел, а проблема понимания смысла понятия "животное". Сколько животных на поляне, если там 2 антилопы и сухое поваленное дерево?

Это не проблема понимания смысла чисел, а проблема понимания смысла понятия «животное».Нет, это не афазия, люди все понимают, но не могут оперировать числами. Зная таблицу сложения, не могут сложить 1 + 2, когда их просят. Хотя могут быть комбинированные нарушения.

Этому тоже надо учиться и за это отвечает не та зона, что распознает числа, а ассоциативная кора.За абстрактное представление чисел действительно отвечает другая зона, но за смысл именно IPS и прилегающие. Зона абстрактного представления активируется на некоторое время, когда задача формулируется, но затем зоны отвечающие за чувство численности. Вот показательное исследование с нейровизуалицией, где авторы всесторонне рассматривают эту тему.

Как ее реализовать в последнем случае?Я понадеялся, что вы мне сейчас и расскажите. :) Меня интересует постройка детектора численности, и я помню вы про неё много комментировали, но всё не хватает времени прочесть.

Я понадеялся, что вы мне сейчас и расскажите. :) Меня интересует постройка детектора численностиДа, это один из наиболее изученных феноменов в когнитивной нейропсихологии в дополнении с моделированием в ИНС. Особенно замечательно, что в модельной сети удалось воспроизвести активность нейронов детектирующих численность в соответствии с психофизическим законом Вебера-Фехнера. Оценка численности подчиняется ему, как, например, ощущение яркости света, величины тяжести, и тд. Т.е. видна связь ощущения, как субъективного состояния, с соответствующей активности нейронов в карте теменной коры. На макаках можно даже увидеть, что активность соотв. нейрона меньше, если она делает неправильную оценку численности из-за ошибок распознавания. Этот механизм воспроизводится в ИНС со структурой подобной структуре вентрального потока зрительной системы. Также исследованы связи этой карты с абстрактным представлением чисел в вышестоящих отделах коры, и связь чувства численности с математическими способностями и достижениями, напр, успеваемостью в школе по математическим дисциплинам.

Наиболее интересно в этом направлении работают группы Stanislas Dehaene и Andreas Nieder. Первый автор широко цитируемой книги The number sense: How the mind creates mathematics в которой он высказывает свои мысли о происхождении чисел и всей математики.

Among the available theories on the nature of mathematics, intuitionism seems to me to provide the best account of the relations between arithmetic and the human brain. The discoveries of the last few years in the psychology of arithmetic have brought new arguments to support the intuitionist view that neither Kant nor Poincare could have known. These empirical results tend to confirm Poincare's postulate that number belongs to the «natural objects of thought,» the innate categories according to which we apprehend the world. What, indeed, did the preceding chapters reveal about this natural number sense?Далее приводит известные на то время аргументы в пользу этого, книга старая, первое издание в 90-х. Через 20 с лишним лет исследований они были существенно уточнены, и к ним добавились новые. Это позволяет взглянуть на чувство численности, как на механизм реализации одной из априорных форм знания, о которых писал И. Кант — числах.

For Kant, finally, number belonged to the synthetic a priori categories of the mind. More generally, Kant stated that «the ultimate truth of mathematics lies in the possibility that its concepts can be constructed by the human mind.»Априоризм Канта считается наилучшим вариантом примирения соотношения эмпирического и рационального в познании. В последствии происхождение априорных форм связали с эволюцией. Но это общий взгляд на проблему, имеются и другие.

Если конкретно по моделированию, то можно посмотреть эти источники 1, 2, 3, 4, 5. По этому пути сейчас идут исследования и моделирование распознавания лиц, цвета, массы или веса, и др. составляющих когнитивного ядра. В методологическом плане этот подход давно разрабатывает J. Tenenbaum. Одна из последних работ обзорного плана в этом направлении.

И ещё важной момент. Что определяет что именно считать?

Карта численности в IPS основная, они имеются также в ассоциативных областях мозга, могут накладываться с картами других признаков, например, размеров объектов, или длительностей событий. В одном из последних исследований таких карт обнаружено до 6-ти штук. При этом связи этих признаков весьма не тривиальные) есть мнение, что они могут описываться по принципу суперпозиции состояний в Кв. механике (квантовоподобные системы). Почему нет? Психические феномены, как и квантовые имеют принципиально контекстуальный характер, а поэтому и описываться могут аналогичными формализмами. Есть работы в этом направлении.

Кстати, насчет контекста. В теме бурно обсуждались нейросетевые генераторы текстов, и удивлялись почему результаты иногда смахивают на бред) Человек всегда генерит и оценивает текст в некотором контексте, а не использует статистику. В правильном имеет смысл, а если контекст не задан, то результат просто не определен. В каком-то релевантном контексте куздра имеет такой же правильный смысл, как и коза в огороде) Ту все, как с нейросетевыми переводчиками. Лучший их них — Гугл переводит «Девушка с косой косила траву косой» для обеих кос — scythe. Ему не в домек, что это разные косы. Как его поместить в нужный контекст, чтобы он выдавал нужные переводы кос? У человека, как правило, с этим нет проблем, он моделирует ситуацию помещая ее в более общий контекст. Ну либо просит уточнение.

Ему не в домек, что это разные косы.

Зависит от омонима и структуры предложения. Возможно успешность зависит от количества обучающих данных с этими словами. Использовал скрипт https://github.com/googleapis/python-translate/samples/snippets/snippets.py

Успешные:

Text: Дача была местом, где происходила дача показаний.

Translation: The dacha was the place where the testimony took place.

Text: Твой долг — отдать долг.

Translation: Your duty is to repay the debt.

Text: Роман о романе между Романом и машей.

Translation: A novel about a romance between Roman and Masha.

Text: Язык во рту позволяет говорить на любом языке.

Translation: The tongue in the mouth allows you to speak any language.

Text: На этом капище видели духов, которых раздражал запах духов.

Translation: On this temple they saw spirits, which were irritated by the smell of perfume.

Text: За бором слышался звук зубоврачебного бора.

Translation: The sound of a dental drill could be heard outside the forest.

Text: В следствии следствия был посажен подследственный.

Translation: As a result of the investigation, the suspect was imprisoned.

Неуспешные:

Text: Дом дробь 2 полон дроби.

Translation: House fraction 2 is full of fractions.

Text: Дух духов тревожил дух духов.

Translation: The spirit of the spirits disturbed the spirit of the spirits.

Text: Ключ к замку замка у ключа.

Translation: The key to the lock is by the key.

Text: Роман о романе между романом и машей.

Translation: A novel about a romance between a novel and Masha.

Text: Норка рыла норку.

Translation: The mink dug a mink.

Text: Охота сходить на охоту.

Translation: Hunt to go hunting.

Text: Язык позволяет говорить на любом языке.

Translation: Language allows you to speak any language.

Но:

Text: Язык и гортань позволяют говорить на любом языке.

Translation: The tongue and larynx allow you to speak any language.

Влияние поверхностной структуры предложения всё-таки сильное.

Каждый нейрон в карте избирательно реагирует на определенное число. Максимум активности, если число объектов совпадает с целевым, чем больше разность, тем активность меньше.Такое же поведение демонстрирует нейрон, который я разработал. Собственно, этого от него и добивался.

Нейрон, который избирательно реагирует на определённое число, не имеет ли он привязки к некой области во входе, или к паттерну расположения объектов определённым образом?

Например, нейрон реагирует на число три и его максимальный ответ, когда объекты расположены в углах треугольника определённого размера в левом верхнем углу.

Гугл переводит «Девушка с косой косила траву косой» для обеих кос — scythe. Ему не в домек, что это разные косы. Как его поместить в нужный контекст, чтобы он выдавал нужные переводы кос?Я пытаюсь эту задачу решить вот таким способом: habr.com/ru/post/520748/#comment_22124724

Нейрон, который избирательно реагирует на определённое число, не имеет ли он привязки к некой области во входе, или к паттерну расположения объектов определённым образом?Эта карта в IPS, области которая иерархически выше V4. Область V4 отвечает за распознание высокоуровневых признаков, включая форму и цвет объектов, позиционно и масштабо независимое. Причем, как писал, за разные диапазоны чисел отвечают разные механизмы, можно посмотреть в этом обзоре. Диапазон субитизации возможно завязан на механизм предвнимания, подсознательную фазу обработки визуальной информации. Можно здесь посмотреть, и потестить с помощью скрипта. Мин. время можно задать только 100 мс. Были бы интересны меньшие значения. Можно также на панамасе посмотреть, хотя он специализирован на тестировании собственно чувства численности.

Однако не исключено, что оценка численности производится и с помощью других механизмов, а не только использует результаты обработки в вентральном пути (система «что»), см. это исследование, в кот. авторы обнаружили числовую избирательность в дорсальном пути (система «где»), включая в ранних визуальных зонах. Такое дублирование не удивит, если подтвердится, учитывая эволюционную древность и важность оценки численности.

А с чего вы, извините, взяли, что это разные косы? ;) Объективно я должен признать, что это может быть вполне та самая коса, которой она косит…

Впрочем, вы все-таки правы: даже если уточнить контекст, типа «с косой а голове» — результат тот же.

А с чего вы, извините, взяли, что это разные косы? ;)Так оба варианта формально правильные. Проблема в том, что вероятность встретить в текстах сочетание «косить траву» намного вероятнее, чем «девушка с косой». Поэтому после обучения транслятора вариант перевода с косой, как инструментом, перевешивает, но звучит избыточно. В этом случае человек перевел бы по простому — Девушка косит траву косой. Избыточность в исходном предложении указывает на возможную структуру отношений, кот. нужно анализировать дополнительно, несмотря на веса связей слов. Пока ИНС не способны воспроизводить во время обучения структуру отношений независимо от классификации категорий и статистики связи слов. Посмотрите, как воспроизводится эта структура отношений в одном из последних исследований семантической сети в мозге. Категории связаны отношениями, напр, целого-части, которым соответствует активация/деактивация определенных зон мозга, независимо от слов входящих в отношение, получается своеобразное пространство отношений. Девушка относится к категории Человек, коса является ее частью. Информация об этом отношении попадает в мозг просто из восприятия девушек с косами. Этого пока ИНС делать не могут. Возможно их нужно этому учит отдельно, или прикрутить готовую базу с отношениями. Конечно коса, как инструмент также может находиться в другом отношении с человеком, напр, как case relations. Во время перевода или генерации предложения нужно учитывать эти варианты отношений. По идеи это должно повысить осмысленность результата, мозг же как то это делает)

А почему с другими омонимами это работает? https://habr.com/ru/post/520748/#comment_22126376

Локальный контекст достаточен для разрешения неоднозначности?

Стоп. Вы спросили про google, а потом обобщили на все ИНС! ИНС вполне способны выделить структуру отношений, если их обучать правильно… Собственно, я где-то даже удивлен, что google translate пока этого не умеет (ибо их архитектура transformers лежит в основе GPT), но я уверен, что это ПОКА.

В итоге, модель демонстрирует 100%-ное распознавание на подсчёте количеств до 4 объектов. Для больших количеств начинается смешение с умеренной или слабой активностями от нейронов соседних чисел. Подсчёт может вестись как для одновременно наблюдаемых объектов так и для их последовательности.

Думаю численные нейроны, если и отличаются от нейронов соседних участков коры, то, скорее всего, незначительно. Свойство подсчёта — эмерджентное и должно быть присуще всей коре.

Идея состоит в том, что численные нейроны выполняют квантование величины разряженности входной активности.

Каждый подсчитываемый объект должен проецироваться в одинаковую по величине случайную активность. Тогда независимо от расположения, формы, размера и происхождения объектов на входе слоя нейронов будет суммарная случайная активность одинаковой разряженности. Перевод входной активности в выход нейрона обеспечивает колокол гауссианы. Сам же нейрон в итоге работает как полосовой фильтр. Каждому уровню разряженности соответствует своя группа нейронов, в слое всех нейронов это проявляется в виде устойчивых паттернов активности.

И важное, такому нейрону не требуется обучение. Достаточно просто случайной вариативности в параметрах при его «создании». Возможно по подобной схеме работает распознавание численности у насекомых, например, пчёл и муравьёв.

Идея состоит в том, что численные нейроны выполняют квантование величины разряженности входной активности.

Скорее всего, у людей эта способность имеет ту же природу, что и запоминание движений или других паттернов во времени. Если нейронам, которые у которых есть такая способность, подавать сигналы с механизма внимания, то они запомнят паттерны, соответствующие разным количествам наблюдаемых объектов. Это подтверждается тем, что точный подсчет количества работает для ощущений любой природы — зрительных, слуховых и т.д.

К примеру, для игрушечного поля размером всего 10 на 10 клеток количество возможных паттернов для количества 2 равно числу сочетаний из 100 по 2. Это астрономическое число. Пересечение паттернов (возможность обобщения) ноль.

точный подсчет количества работает для ощущений любой природы — зрительных, слуховых и т.д.Да, я так и написал. Для моей модели не имеет значение происхождение входной «информации». И она не требует обучения. И есть объяснение почему точность 100% для чисел от 1 до 4 и почему она уменьшается с увеличением количества объектов.

в случае подсчёта произвольных объектов отсутствуют паттерны, которые можно выделить/обобщить

К примеру, для игрушечного поля размером всего 10 на 10 клеток количество возможных паттернов

А почему вы считаете паттерны во входном слое рецепторов? Там, где появляется механизм внимания, уровень абстракции уже гораздо выше. Он и обобщает возможные варианты сигналов входного слоя в один объект. Я говорю о паттернах с предыдущего слоя нейронов, а не с нулевого.

Зрительный уровень распознает объекты. Механизм зрительного внимания сканирует зрительное поле, то есть превращает одновременные сигналы в последовательность сигналов во времени. То есть на слой определения численности идут сигналы "обнаружен объект", "обнаружен объект", "обнаружен объект". Для звуковых ощущений, например ритма идут сигналы "звук бум", "звук бум", "звук бум". Вот этот сигнал с предыдущего слоя и формирует паттерн. В общем виде он превращается в "импульс нейрона", "импульс нейрона", "импульс нейрона". А нейроны на следующем слое выделяют паттерны в последовательности этих сигналов. Условно, пришел сигнал — загорелась первая лампочка, пришел сигнал — первая лампочка уже горит, загорелась вторая ламочка, и т.д.

Да, я так и написал.

Вы написали другую причину. Случайность, которая играет большую роль, на этом уровне маловероятна.

Алгебраически это примитивнейшая задача, но на НС вы её никак не решите. Датасет из всех возможных вариантов выбора пары клеток — это громадный список, можно сказать, случайных несвязных входных векторов. Проще говоря, во входных данных нет паттернов. Сеть не способна аппроксимировать шум. Единственное что она может — это выучить весь датасет, но с учётом его размера, размер самой сети побежит в бесконечность.

То есть на слой определения численности идут сигналы «обнаружен объект», «обнаружен объект», «обнаружен объект».Такой последовательный механизм (аля, подсчёт с загибанием пальцев) не способен оценить десятки объектов за мгновение. Для подсчёта трёх орехов на столе достаточно бросить взгляд. Для немногим менее точной оценки количества огурцов в банке тоже хватает менее 100 мс.

А нейроны на следующем слое выделяют паттерны в последовательности этих сигналов.Ну вспыхивает периодически некий кластер нейронов (условно 10 штук из 10 тысяч). Начнём считать другие объекты будут вспыхивать совершенно другие нейроны. Третий, десятый, тысячный… Каждый раз это будут вспышки кластеров, практически никак не пересекающихся друг с другом.

Случайность, которая играет большую роль, на этом уровне маловероятна.Вариативность параметров не то что маловероятна, от неё трудно избавиться. Это же живые клетки, у всех параметров диапазон.

Полагаем, что некая сеть ранее уже распознала объекты и каждому объекту сопоставила/промаркировала его пространственную позицию (от 1 до 100). Нужно подсчитать количество заполненных клеток.

"Пространственную позицию" — это и есть связь с сенсорным слоем. Для подсчета объектов не надо вычислять их пространственные позиции. Надо подсчитать количество сигналов "обнаружен объект". Это одномерный сигнал, который поступает на вход подсчитывающего нейрона.

Проще говоря, во входных данных нет паттернов.

Нам не надо искать паттерны для количества во входных данных. Их надо искать в сигнале с предыдущего слоя, который уже произвел необходимые обобщения для выделения объектов. При этом он выделяет объекты, но не подчитывает их количество.

Такой последовательный механизм (аля, подсчёт с загибанием пальцев) не способен оценить десятки объектов за мгновение.

Мы десятки объектов и не можем точно подсчитать. У нас разговор о механизме мгновенного точного подсчета, который работает до 3-4 предметов. В исследованиях обнаружены нейроны, которые это делают.

— Ну вспыхивает периодически некий кластер нейронов (условно 10 штук из 10 тысяч). Начнём считать другие объекты будут вспыхивать совершенно другие нейроны.

Нет. Почему они вдруг другие, если мы определяем тот же сигнал "обнаружен объект"? Вы говорите про пространственное положение и упускаете что механизм внимания сканирует это пространственное положение, то есть превращает его в положение на оси времени. Поэтому нейроны подсчета могут быть соединены только с выходом механизма внимания. Тут 3 слоя, на одном вспыхивают разные нейроны (как вы и говорите), второй его сканирует и выдает сигнал "обнаружен объект" (механизм внимания), третий делает подсчет этих сигналов (нейроны количества).

Вариативность параметров не то что маловероятна, от неё трудно избавиться

Я не сказал, что ее нет или не должно быть, я сказал, что она не может играть главную роль в подсчете количества.

Нам не надо искать паттерны для количества во входных данных. Их надо искать в сигнале с предыдущего слоя, который уже произвел необходимые обобщения для выделения объектов. При этом он выделяет объекты, но не подчитывает их количество.Входные данные, про которые я писал — это данные, которые поступают на вход «численной» сети от "предыдущего слоя, который уже произвел необходимые обобщения для выделения объектов". "Он выделяет объекты, но не подсчитывает их количество".

Всё верно. Предыдущий слой выделил объекты, теперь их надо подсчитать.

Для подсчета объектов не надо вычислять их пространственные позиции. Надо подсчитать количество сигналов «обнаружен объект». Это одномерный сигнал, который поступает на вход подсчитывающего нейрона.Вы предлагаете использовать механизм внимания, который «выхватывает лучом» объекты и формирует последовательность кодов «обнаружен объект». Это медленный высокоуровневый механизм. Да, он в том или ином виде есть. Но:

У нас разговор о механизме мгновенного точного подсчета, который работает до 3-4 предметов.А мгновенная оценка не задействует механизм внимания. Соответственно, нечем сформировать последовательность кодов «обнаружен объект».

А мгновенная оценка не задействует механизм внимания

Ну как это, очень даже задействует. Мы наблюдаем одновременно все объекты окружающей обстановки, но подсчитываем только те, которые нам нужны. Мгновенный подсчет числа зеленых кубиков предполагает, что мы должны обращать внимание на зеленые кубики, а не на синие, и не на коробки, в которых они лежали.

Саккады это и есть один из таких механизмов. Он превращает одновременно наблюдаемые объекты в последовательность сигналов во времени.