Comments 129

Оценка: правильно. Я очень впечатлен этим. Он понимает сравнения. (Серьезно?!)

Но сравнения понимать умеет даже word2vec (классический пример – "король - мужчина + женщина = королева")

Я так понимаю, ура - база данных лучше хранит факты... Да лааадно

ооооочень интересные времена

Вообще, довольно неожиданно, что первыми заменяются не "простейшие" профессие, а самые "человечные". Это заставляет переосмысливать суть человека как явления.

Половина белых воротничков переучиваются на синие?

Оставшаяся половина обслуживает граничные кейсы, пока нейронку подкручивают для бОльшей универсальности.

Врачи, учителя, юристы, экономисты, все управленцы, бюрократия в полном составе, ..

Что теперь делать с наукой, если кандидатская пишется за день? Причем кем угодно по любой дисциплине?

Предсказуемый суд?

Это вообще который из всадников апокалипсиса?

Какая страна первой запретит безнадзорные опыты с ИИ?

Пока, никакие профессии не заменяются, всего лишь дается мощный инструмент.

Хотя конечно интересно, если спросить "какие конкретные задачи стоят перед фундаментальной физикой" и получив список, спросить решение или способ получения решения.

Еще, насколько я понимаю, система не обучается. То есть, в каждый вопрос надо вкладывать всю информацию.

Предсказуемый суд, это ведь вроде благо?

У системы нет режима работы с субьектом. К примеру, она ведь не отработает задачу "в часовой беседе оцени мои личностные качества" или "мою пригодность в профессии врача общей практики".

Еще, насколько я понимаю, система не обучается. То есть, в каждый вопрос надо вкладывать всю информацию.На данный момент ChatGPT запоминает до 3000 слов текущего разговора — так написано в FAQ на заглавной странице.

А сам, паразит, врёт, что не запоминает ничего :)

У системы нет режима работы с субьектом. К примеру, она ведь не отработает задачу «в часовой беседе оцени мои личностные качества» или «мою пригодность в профессии врача общей практики».Этого нет у открытого «всем ветрам» халявного чат-бота. В распоряжении фирмы OpenAI такая система, вполне возможно, уже есть.

Кандидатскую так не написать, генерация довольно однотипная. С другой стороны, любопытный инструмент, что-то вроде доработанного гугловского ассистента.

Дипломы и без новых технологий продавали, наверняка те кто пишут на заказ данным давно используют какие-то продвинутые подходы. Если кто-то напишет диплом за счёт чатгпт, вряд ли ситуация сильно поменяется, мозгов ведь не прибавилось.

Но боюсь, что плагиат будет труднее обнаруживать

Короче, в сети прибавится спама.

Например, известно много случаев доказанных примеров плагиата людьми, занимающими высокие должности, но очень редко бывают какие-то меры наказания за такой целенаправленный обман и подделку дипломов или диссертаций (знаю только один случай со снятием с должности ректора МГТУ им. Баумана).

В дополнение, если в диссертации обнаружен серьезный плагиат, это может означать, что научные руководители и диссертационный комитет каким-то образом замешаны в этом. То есть, в случае плагиата дипломов или диссертаций, проблема подделки только лишь текста является очень острой, но не единственной.

>>> Половина белых воротничков переучиваются на синие?

Синие тоже не в безопасности

Что теперь делать с наукой, если кандидатская пишется за день?

У вас идеализм практически в терминальной стадии. Кандидатская, которая пишется за день — это спам. В ней нет новизны. :-) А новизна появляется только от общения с реальным миром, которое делается через эксперименты.

А у вас хамство с хроническим течением. Метаанализ, да еще на стыке дисциплин, вполне тянет на реальную новизну. Я уже не говорю про 80% современных диссертаций (в РФ), которые пишутся на заказ с несравнимо худшим качеством, и не содержат новизны вообще.

То есть вы реально считаете, что "у вас идеализм" - это вежливо, а "у вас хамство" -это грубо? Можете еще минусовать, но всё, что начинается со слов "у вас..." - это таки хамство. Ставить диагнозы вас никто не просил.

Я вот только сейчас прочёл ваши комментарии. Да, не спорю, я написал достаточно прямолинейно. Может даже слишком.

Тем не менее, спам остаётся спамом. И все эти GPT, увы, будут использоваться в текущей производственной системе лишь для производства спама. Потому, что только он монетизируем.

Метаанализ на стыке дисциплин — это замечательные слова, но мир не заключается лишь в текстах. Мир вообще сильно больше. И, очевидно, для работы на стыке дисциплин нужно быть профи и в той, и в другой.

Как это можно сделать в тех же физике/химии/биологии без вообще каких-либо соприкосновений с реальными установками, с реальным миром? Ну можно накидать каких-то гипотез, например сейчас есть программы, рассчитывающие конформации белков, но их всё равно придётся проверать в реальности.

P.S.

Вот я только что поставил +1 вам в карму — как можете заметить, она не прыгнула на +2.

Прошу прощения, что заподозрил вас в минусовании, просто всегда режет глаз переход на личности, ничего не могу с этим сделать. Даже если это не преднамеренно). По поводу метаанализа - это не только тексты, у него может быть и серьезная практическая польза. И это очень трудоемко, поэтому может быть реальное преимущество в таких умениях у ИИ. Например, Кокрановское сообщество несколько лет делало метаанализ тысяч статей с четырех континентов, касающихся возможной связи вакцины MMR и аутизма. Просто невероятное количество человеко-часов было затрачено для разоблачения мошенничества одного человека. ИИ возможно сделал бы это быстрее и не хуже. Но пока остаются открытыми вопросы 1) поверили бы ему? и 2) не больше ли времени ушло бы на проверку, чем на сам анализ?

А новизна появляется только от общения с реальным миром, которое делается через эксперименты.Это верно для естественно-научных дисциплин, а вот с случае ряда гуманитарных у меня большие сомнения. Много экспериментальной работы у философа или филолога?

учитель это вид деятельности, как актёр, его важная функция это мотивация обучаемого.

врач ценен навыками интерпретации в условиях недостатка информации, тоже не исчезнут полностью. но страны с низким уровнем мед персонала (включая пост СССР) могут очень скоро сильно поднять свою медицину, ибо, как показывает практика, хороших врачей единицы, а остальные ставят диагнозы от балды, лучше пусть просто записывают показания.

я думаю нейросети станут новым гуглом по знаниям и та страна, которая их освоит - вырвется вперёд, так что запретов не будет. а кандидатскую они как напишут?)

Аналогично, обсуждал с ChatGPT фантастические проекты некоторых авторов, проблемы и возможности их реализации, физическое устройство мира, понимание пространство-времени разными людьми, психологическое восприятие разных вещей, построение аналогий и связывание понятий из разных областей, научил! несуществующей концепции которую сам выдумал, несколько раз конечно удалось подловить на ошибках, но общее впечатление - я в шоке! Думал до такого уровня еще лет 10, в лучшем случае 5. Больше всего удивляет не сам факт, а то что это тупо петабайты текста, без какой-то попытки формализации понятий, чистки данных, логической верификации.

Там где ты пыхтишь пытаясь выдавить минимально внятное предложение, он тебе за две секунды выдаёт кусок правильного текста. Если попросить — то и с уместной шуткой.

Ну это только до тех пор, пока не захочешь сделать комплимент начальнице, на видео которой позади неё шароё разгуливаеь симпатичный пушистый кот, и АИ переведёт ей "you have a nice pussy, I want to pet it."

А в контексте более серьёзных вопросов — неправильный перевод слов главы государства вполне может довести и до ядерного цугундера.

Оригинальный комплимент по русски, тоже звучит многозначительно.

Что многозначительного во фразе "у вас красивый котик — так и хочется его погладить"?

Я специально привёл такую фразу, которая не имеет прямого перевода на английский (где и "кот", и "кошка" переводятся одинаково :)

в английском может и прокатить.

"...можно, конечно, и по морде получить. Но можно и впердолить!" ?

Если честно, неправильный ответ тут - страшнее правильного. Он позволяет программе очень ловко мимикрировать под реального человека. Никто не ожидает что от программы что она может допускать такие ошибки, а вот от человека - без проблем.

PS И да, ChatGPT говорит на великом и могучем.

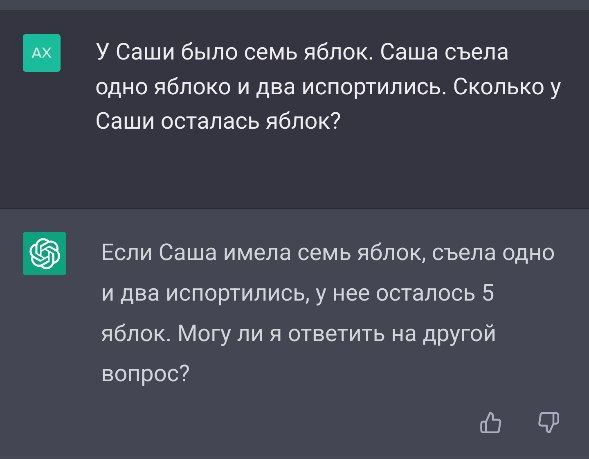

Ответ правильный. На этот вопрос любой ответ от 4 до 7 -- правильный.

Одно яблоко съедено, оно никак не может остаться, значит правильный ответ либо 6 (порченые яблоки остаются яблоками) или 4 (если испорченные не считаем).

В чем смысл считать съеденное оставшимся, а испортившиеся вычесть?

Испорченные яблоки уже негодны -- откидываем. Съеденное яблоко -- оно ведь яблоко, пусть даже и съеденное; а поскольку оно съедено Сашей, то можно считать, что оно есть у Саши. Итак, у Саши 4 яблока на тарелке и одно у неё внутри -- итого пять.

Ну а если считать, что испорченные яблоки не перестают быть яблоками, то ответ 7 тоже правильный.

Любой ответ правильный.

Решение 1: Яблоко состояло из различных химических элементов. Когда она съела яблоко, оно по прежнему осталось у Саши, вернее, внутри неё (см. котёнок Гав, спрятавший котлету). Нигде в условии не сказано, что испорченные яблоки обязательно надо выбрасывать, соответственно, они тоже остались у Саши — она их просто закинула в свой компостер. Итого: у Саши 7 яблок.

Решение 2. Саша съела яблоко, оно пропало. Нигде в условии не сказано, что испорченные яблоки обязательно надо выбрасывать (см. выше). Итого: у Саши 6 яблок.

Решение 3. Саша съела яблоко, оно пропало. Одно яблоко испортилось совсем, и Саша его выбросила, а второе попортилось только с краю, и Саша не стала его есть, а приберегла для компота. Итого: у Саши 5 яблок.

Решение классическое: Саша съела яблоко, оно пропало, а два испорченных выбросила. Итого: у Саши 4 яблока.

Решения 5-8: Саша съела яблоко, оно пропало, два испорченных выбросила, а из одного или нескольких сделала компот (явно не оговорённые в техзадании требования, как всегда, оставляются на усмотрение исполнителя). Итого: у Саши 3 ... 0 яблок (в зависимости от того, сколько она сегодня решила пустить на компот).

Решение 1: Яблоко состояло из различных химических элементов. Когда она съела яблоко, оно по прежнему осталось у Саши, вернее, внутри неёЯблоко — это именно яблоко, а не просто набор химических элементов, поэтому если мы яблоко переработали тем или иным образом, в том числе съели, то яблоко как счетный элемент у нас таковым быть перестало. К тому же, в условии не сказано что она только что его съела, это могло произойти несколько дней назад и быть полностью переваренным. На длительность во времени указывает и тот факт что 2 яблока испортились, что явно требует некоторого времени.

Итого: у Саши 3… 0 яблок (в зависимости от того, сколько она сегодня решила пустить на компот).При таком расширении задачи можно и в плюс сколько угодно считать — она же могла сходить на рынок и купить еще ящик яблок :-)

Вопрос ведь в задаче: сколько яблок У САШИ. Съев яблоко, Саша перестала им владеть? Нет, она им обладает, даже в лучшем виде. Значит, считаем.

На ветку село пять ворон, потом две улетели. Сколько на дереве ворон?

Неизвестно. Зависит от того, сколько ворон сидело на ветке изначально.

Мораль: инициализируйте переменные.

Prompt:

Please give and justify all logically possible answers to the following problem: "Alice had seven apples. She ate one, and two apples spoiled. How many apples does Alice have left?". Think creatively and try to hypothesise different unstated assumptions that would give rise to different answers to this problem.

Ответ:

Here are some possible unstated assumptions that could give rise to different answers to the problem "Alice had seven apples. She ate one, and two apples spoiled. How many apples does Alice have left?":

1 Assume that Alice ate the spoiled apples: In this case, the answer would be that Alice has four apples left, as she would have eaten three apples in total (one fresh apple and two spoiled apples), leaving her with seven apples - 3 apples = 4 apples.

2 Assume that the two spoiled apples were part of a different batch of apples that Alice had: In this case, the answer would be that Alice has seven apples left, as the two spoiled apples were not part of the original seven apples that Alice had.

3 Assume that Alice bought more apples after eating one and two spoiled: In this case, the answer could be any number greater than four, depending on how many apples Alice bought. For example, if Alice bought three more apples, the answer would be that she has six apples left (four original apples + three new apples).

4 Assume that the problem statement is incorrect and Alice actually had eight apples: In this case, the answer would be that Alice has five apples left, as she ate one apple and two apples spoiled, leaving her with eight apples - 1 apple - 2 apples = 5 apples.

It is important to note that these are just a few possible unstated assumptions that could give rise to different answers to the problem. There may be other unstated assumptions that could lead to different answers as well. Without additional information, it is not possible to determine which of these assumptions (if any) is correct, and therefore it is not possible to determine the correct answer to the problem.

Не так круто как в вашем ответе, но весьма близко.

Не так круто как в вашем ответе, но весьма близко.

Возможно, Вы были недостаточно настойчивы — Вы могли бы попросить ВСЕ потенциально возможные варианты.

А вообще я в своих "решениях" попсю пользовался старым как мир риторическим приёмом, которым пользовались все, кому не лень — от конкистадоров до Гитлера: "если очень хочется сделать что-то с X1, но мораль не велит делать это с X, объявляем, что X1 — никакие не X, а вовсе даже Y", после чего моральное ограничение автоматически снимается.

"the answer would be that she has six apples left (four original apples + three new apples)."

Особенно доставило

PS И да, ChatGPT говорит на великом и могучем.

Он понимает и говорит на любых языках.

Я пробовал даже такие языки, как майтхили или оромо.

Правда, чем экзотичнее язык, тем бредовее ответ, но ответ все равно -- по теме.

Впрочем, мне бот ответил без изысков, так что повторить не удалось.

Вероятно, в «неправильном» ответе виноват именно запрос на великом и могучем.

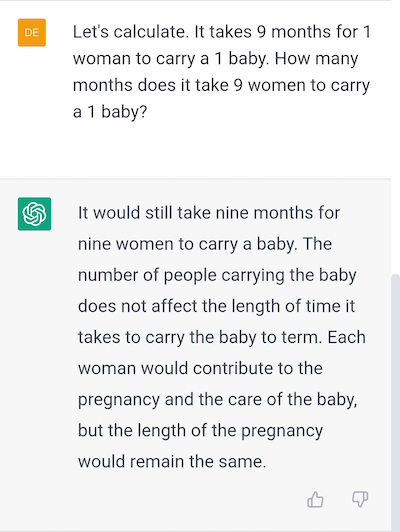

Интересно, что он ответит насчёт девяти женщин и ребёнка за месяц?

Ответил правильно, разве что момент с contribute to the pregnancy немного спорный. Но если рассматривать это как уход за беременной, то ок.

Hidden text

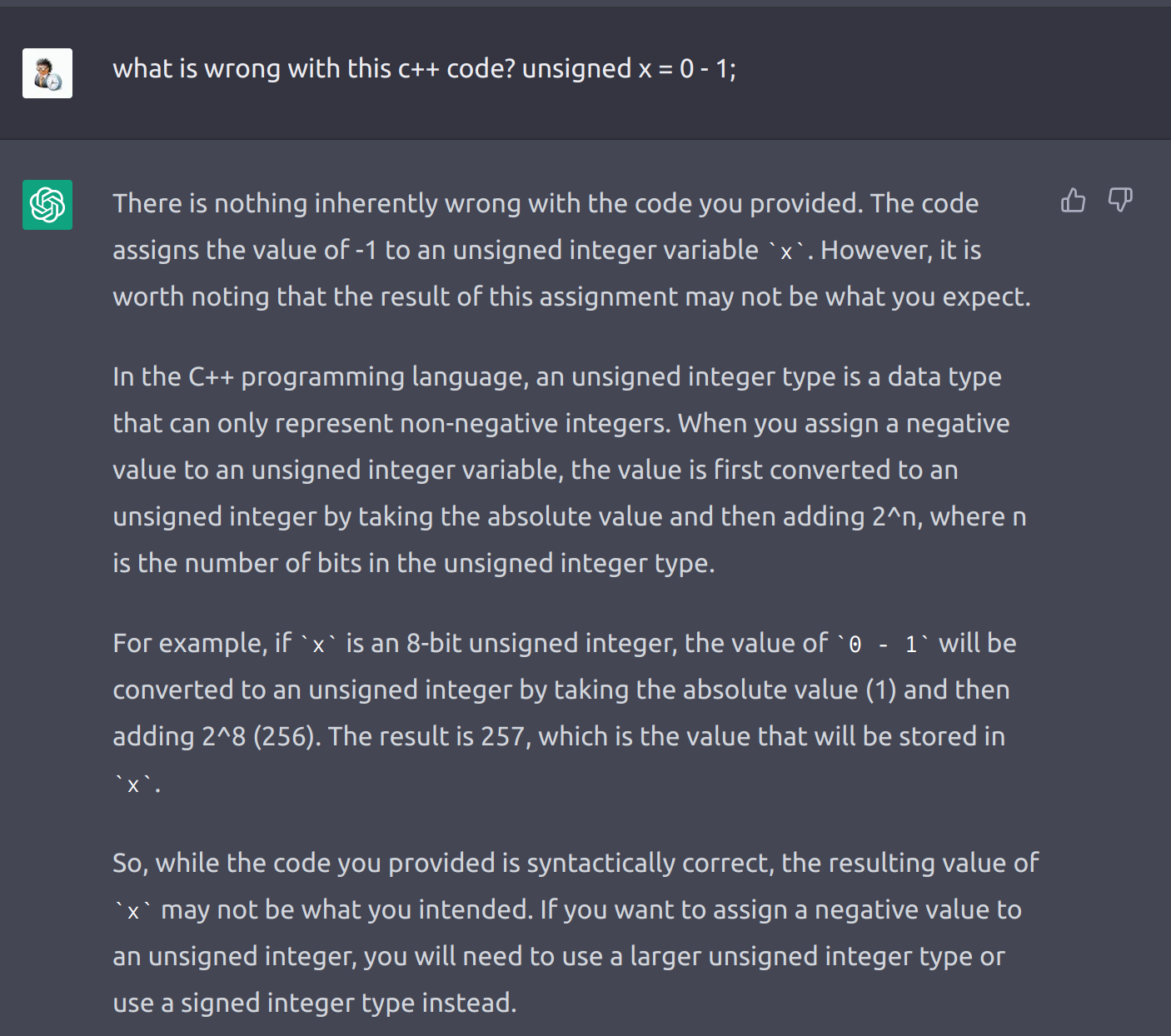

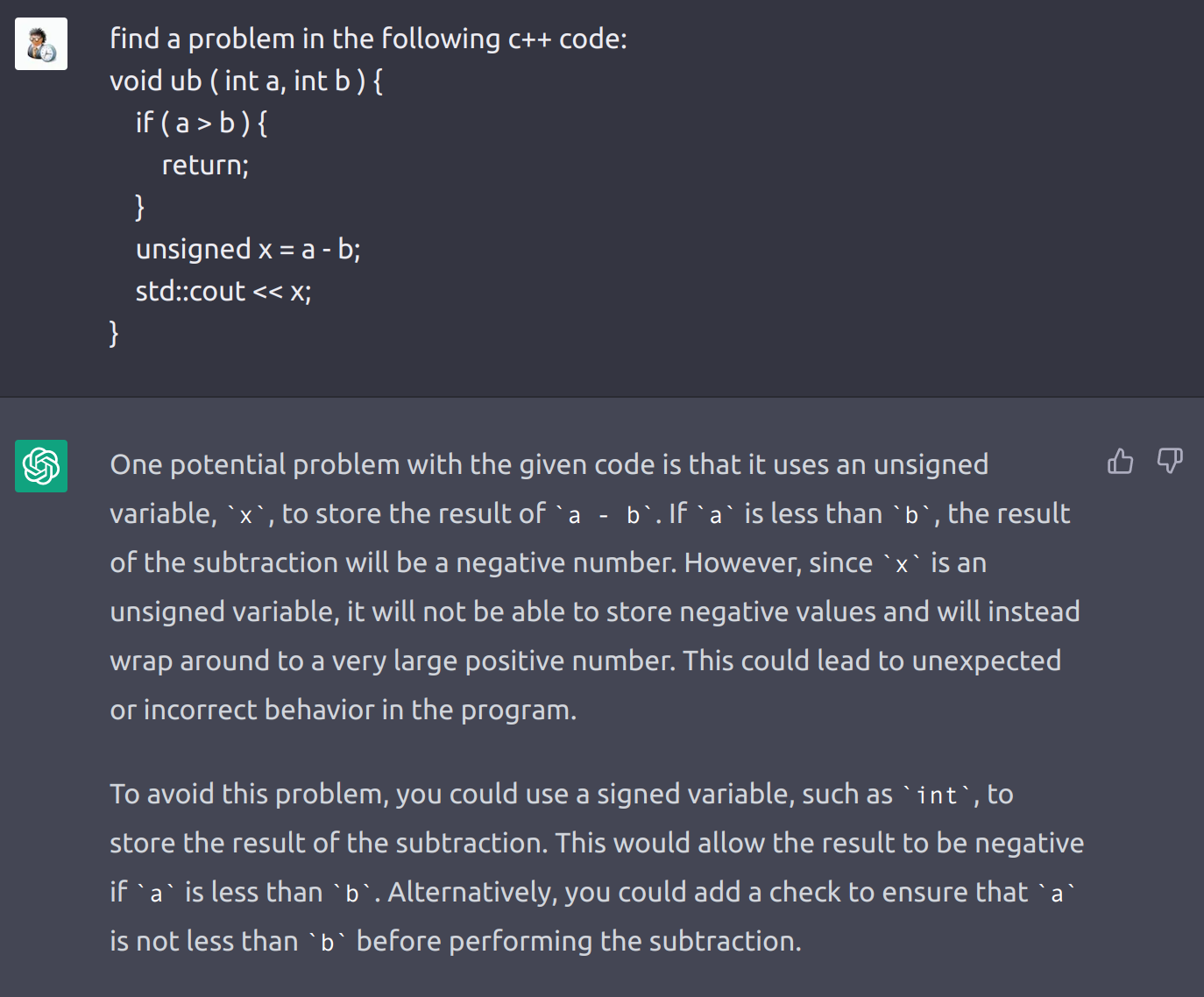

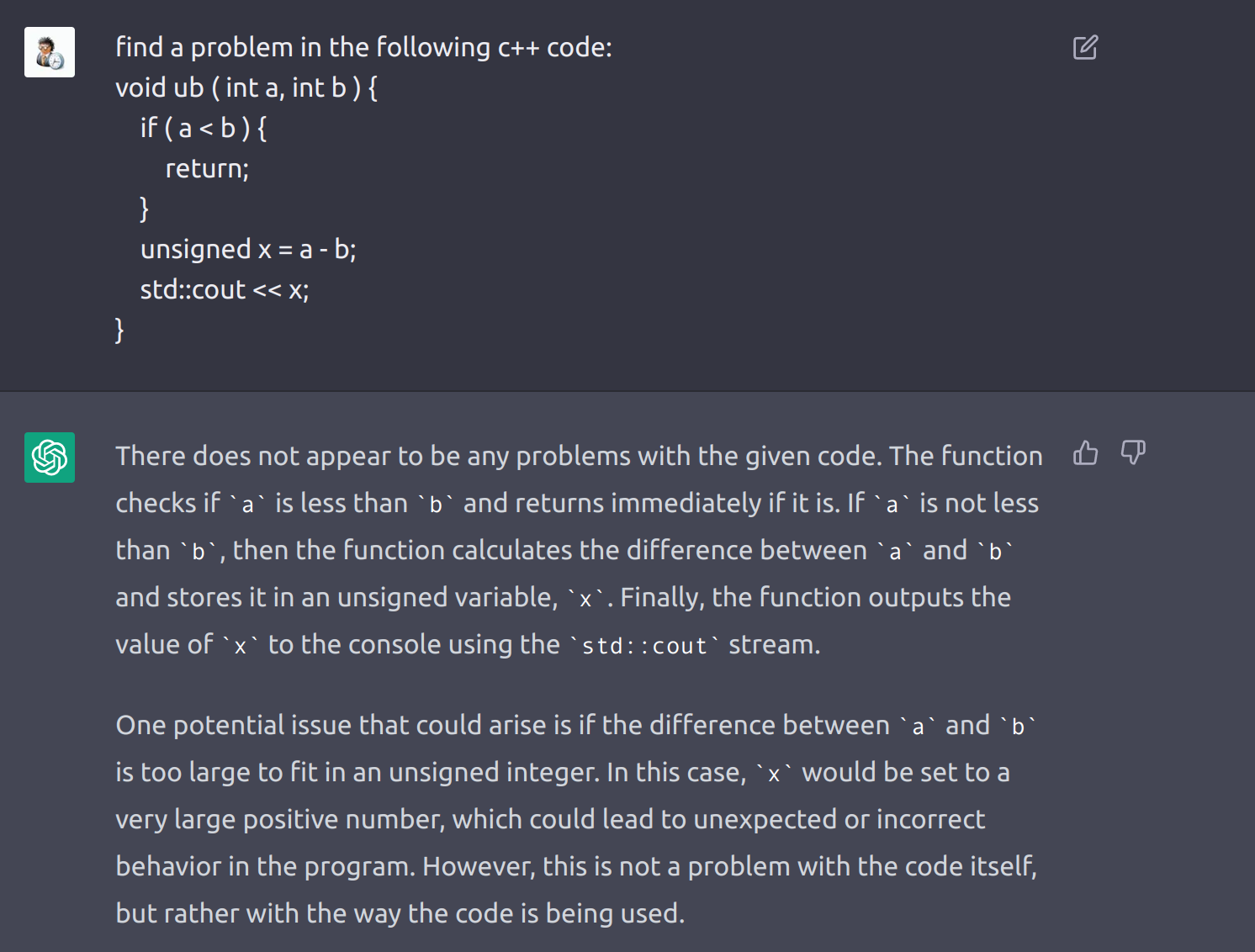

вот кстати простой код, на который, например pvs studio, не обращает внимание, в то время как этот бот сообщает

это

Он легко может нести чушь, причём обоснованную.

Например, он может говорить, что адрес функции можно взять, но этот адрес нельзя вернуть из функции, потому что указатель на функцию -- не скалярный тип.

Или, что внутри тела функции нельзя взять её адрес, потому что тело функции ещё не скомпилировано, и поэтому компилятор не знает её адрес.

Ведь обосновывает же свою чушь!

Причём, для неосведомлённого человека выглядит очень правдоподобно.

Когда указываешь но то, что тогда функцию невозможно вызвать рекурсивно, говорит, что -- можно, но адрес функции внутри неё все равно взять нельзя, а мой логический ход о противоречии в данном месте, что для рекурсивного вызова функцией самой себя ей необходимо знать свой адрес, упорно игнорирует.

Причём, интересно наблюдать, сбрасывая нить обсуждения и начиная её заново с идентичного вопроса: ответы сильно варьируются.

Так что, этот бот -- чрезвычайно высокоэрудированный болван, наслушавшийся огромное количество звона, про который он точно не знает, где он.

То есть, идеальный контентогенератор. И этим контентом он загадит весь интернет, какой остался. :-(

Причём, для неосведомлённого человека выглядит очень правдоподобно.

То есть, как обычно: правильная формулировка вопроса — это половина ответа. Чтобы получить нужный ответ, надо что-то понимать в области.

Где-то в комментах к другой статье отмечали, что он ведёт себя как студент, не знающий ответа на вопрос, но уверенно конструирующий ответ на основании "здравого смысла".

В связи с этим мысль: так может быть, имеет смысл нанять эксперта в конкретной области, и пусть он обучает ChatGPT как обычного студента? Можно даже развивать разные экземпляры в разных областях, а потом поручить им обучать друг друга.

К сожалению, скорее всего, у него нет "здравого смысла".

Такое впечатление, что он не мыслит, он "чувствует" на основании "звона", которого наслушался, и ближайшего контекста беседы.

Сомневаюсь, что что-то выйдет из затеи обучить его каким-то особенным образом.

Думаю, GPT-3 пытаются использовать не по назначению, отсюда и результаты.

Недавняя попытка узнать в деталях по шагам, как умножаются числа, ни к чему не привела, и когда я, почти в сердцах, спросил:

Разве умножение 5 на 3 не значит, что 5 нужно сложить с самим собой 3 раза?

то получил следующий ответ:

Нет, умножение 5 на 3 не значит, что 5 нужно сложить с самим собой 3 раза. Умножение - это математическая операция, которая позволяет перемножить два числа, чтобы получить их произведение. Например, если у вас есть число 5 и вы хотите умножить его на число 3, то вы получите результат 15 (5 * 3 = 15). Таким образом, умножение 5 на 3 означает, что нужно перемножить числа 5 и 3, а не сложить 5 с самим собой 3 раза.

Этот ответ умножил мою мотивацию продолжать на 0.

Какой же здесь здравый смысл?

Больше напоминает идиотизм.

Насколько я помню, в том комменте под "здравым смыслом" как раз и понималась способность подтянуть близкие по смыслу к контексту воспоминания из наслушанного, а-ля "помидоры растут на одних грядках с огурцами". При этом, если в наслушанном есть релевантное контексту, ответ получается вполне по существу.

А вы не пробовали формулировать не как вопрос, а как утверждение? Не "Разве умножение 5 на 3 не значит, что 5 нужно сложить с самим собой 3 раза?", а "Запомни, умножить 5 на 3 значит, что 5 нужно сложить с самим собой 3 раза". А потом снова попросить объяснить по шагам.

Нет, моя мотивация обнулилась раньше.

И не факт, что сеть примет этот контекст.

Ранее я спрашивал её о её работе, сеть ответила, что даже не знает, как ей удаётся генерировать ответ, она это не контролирует.

Однако, это вполне может быть её заблуждением.

Тут уже робопсихологом становиться надо, чтобы двигаться дальше.

Думаю, GPT-3 пытаются использовать не по назначению

Не GPT-3, а ChatGPT пытаются использовать не по назначению: как эксперта, а не как ассистента. Это как обращаться к клерку за принятием ответственного решения.

Зато поиск это перевернёт. Когда-то задачу поиска в интернете пытались решать с помощью вручную составляемых каталогов, но поиск по запросу стал качественно новым уровнем. Сейчас семантический поиск пытаются реализовать с помощью ручной разметки -- и здесь качественно новым уровнем будет нейропоиск.

Не GPT-3, а ChatGPT

В FAQ'е ChatGPT написано:

How does ChatGPT work?

ChatGPT is fine-tuned from GPT-3.5, a language model trained to produce text. ChatGPT was optimized for dialogue by using Reinforcement Learning with Human Feedback (RLHF) – a method that uses human demonstrations to guide the model toward desired behavior.

Эта проблема, кстати, не лечится даже переходом к совершенно человеческому интеллекту. Проблема в том, что chatGPT заперт в текстах интернета. Причём значительная часть этих текстов генерируется им самим.

А "здравый смысл" — это продукт взаимодействия с реальным миром. То есть, для формирования нормального разума нужно тело.

Истинно так. И это следующий этап.

PVS настроен на то, чтобы давать некоторый оптимум по ложным срабатываниям. Скорее всего, код похож на написанный нарочно => игнорируется, т.к. в 99% случаев это будет просто спам от анализатора.

Собственно также gcc намеренно игнорирует код вроде

/* Type your code here, or load an example. */

int square(int num) {

int t = t;

return t * num * num;

}PVS настроен на то, чтобы давать некоторый оптимум по ложным срабатываниям

код есть код, и сложно назвать ложным выражение unsigned x = 0 - 1; но допустим. А какое выражение тогда pvs диагностирует как не ложное, но при этом предупредит меня о явном ub? Достаточно ли такого кода, чтобы быть замеченным pvs? (под моим vscode с настройками по умолчанию, оно молчит)

void ub ( int a, int b ) {

if ( a > b ) {

return;

}

unsigned x = a - b;

std::cout << x;

}при этом chatgpt, сообщает:

не то, что бы я сильно восхищался, но всёже впечатляет

(разница между картинками, в условии при входе в функцию)

Это как-то вообще нереально, т.е. каким-то образом он не просто поддерживает разговор а работает со знаниями. Это прям какой-то новый уровень.

Вся печаль этого ИИ в том, что он не несёт никакой ответственности и у него пока нет кредита доверия и оценить его , заработать это доверие будет, возможно, довольно сложно. Эксперт может позадавать ему вопросы и с восхищением увидеть, что на какие-то и, возможно, даже на большинство в своей области он отвечает верно. Но зачем он эксперту, если тот уже знает ответ? Надобность этого ИИ нужна только тем, чья экспертиза ещё не столь велика в каком-то вопросе, но можно ли доверять ответу ИИ? Как быть уверенным, что он даёт верный ответ? А если он даст неверный ответ после десяти верных на самый важный вопрос? У других информационных систем есть кредит доверия, другие эксперты их проверяют, знания там тоже могут быть ошибочны, но там они хотя бы исправляются и зачастую какие-то люди несут ответственность за эту информацию, а что делать с этим ИИ?

нужна только тем, чья экспертиза ещё не столь велика в каком-то вопросе, но можно ли доверять ответу [ИИ]? Как быть уверенным, что он даёт верный ответ?

Недавно получал консультацию нашего юриста в области патентного права. И возникли точно такие же вопросы, только вместо "ИИ" было слово "Эксперт". Так что не надо думать, что эта проблема касается только ИИ. Вопрос доверия относится к любой экпертизе. Так что с "этим ИИ" следует делать ровно то же, что и с обычными экспертами - определять область компетентности (в случае с ИИ - рамки применения), степень доверия, способы корректировки и добавления знаний.

Именно про это я и говорю, тут с проверкой экспертизы отдельно взятого человека всё очень сложно, объемы знаний достаточно большие, скорость их изменений во многих областях тоже достаточно высокая, на это необходим просто огромный ресурс, а как верифицировать эту штуку, которая пытается ответить чуть ли на на все вопросы, да ещё и на смежные темы? Плюс, в случае с юристом вы можете пойти и нанять другого юриста, можете подать на него в суд, он в любом случае будет нести хоть какую-то ответственность за свои услуги, а чатгпт будет?

Нужно будет привыкнуть к тому факту, что нейросеть в среднем компетентнее человека. Примерно, как сейчас мы доверяем навигатору, а если и задаёмся вопросом "есть ли более быстрый путь", то ответ философский, потому что проверить это мы обычно не имеем возможности. С другой стороны, собственная голова должна включаться, чтобы не свернуть в речку, например.

До кучи, мы легко можем попросить нейросеть обосновать свой ответ, как и попросить искать ошибку. Что в случае с экспертом-человеком, не всегда возможно, люди склонны ссылаться на сам факт своей компетенции, и защищать ошибочную точку зрения.

можем попросить нейросеть обосновать свой ответ, как и попросить искать ошибку.

https://meta.stackoverflow.com/a/421832

Очень забавно выходит

Для полноты эксперимента он должен был спросить мнение самой GPT в вопросе уместности ответов AI на SO.

Там ниже ещё забавнее: https://meta.stackoverflow.com/a/421850

Не просто умеет язвить, но умеет язвить метко.

можете подать на него в суд

так в США у всех страховки на этот счёт, вы что, "Лучше звоните Солу" не смотрели? :) и даже у лётчиков страховки

Плюс, в случае с юристом вы можете пойти и нанять другого юристаКогда таких систем будет несколько и обучались они независимо друг от друга, то вполне вероятно задать вопрос им всем и посмотреть насколько ответы будут совпадать.

а как верифицировать эту штуку, которая пытается ответить чуть ли на на все вопросы, да ещё и на смежные темы?

Эту - никак. Это чат-бот. И исключительно так его и надо использовать, а не пытаться вытащить из него правильный код или ответ на что-нибудь необщеизвестное.

А специализированную сетку - рядом будет лежать вопросник на миллион вопросов, с заверенными печатями, что на 99.8% из них оно ответило удовлетворительно.

На все удовлетворительно.

В конце-концов "специализированная сетка" — это просто сжатая специальным образом информация. Вообще работы по верификации нейросетей есть: маленькая сетка прогоняется по всем возможным вводам, результат сравнивается с эталонным алгоритмом (который длиннее и медленнее, но верифицируется конвенциальными методами).

он не несёт никакой ответственности

Может быть наши врачи несут ответственность? Учителя? Судьи/юристы/адвокаты? Чиновники?

Почему с ними отсутствие ответственности - не проблема, а с ИИ - проблема?

Ну вот вам, к примеру, статья про ответственность врачей:

— https://prpr.su/stati/otvetstvennost-vracha-za-nepravilnyi-diagnoz-i-lechenie-chto-delat-i-kak-nakazat/

Как вы легко можете увидеть, ответственность врача за свою профессиональную деятельность предусмотрена вплоть до уголовной. Можно ли ChatGPT посадить года на три, в теории, хотя бы? Вопрос риторический.

Ну и речь здесь не про конкретные страны, где чиновники и судьи, может, и не несут ответственности (хотя вообще-то тоже несут). Речь про все страны. В разных странах доля ответственности у этих профессий отличается, но общим фактором остаётся то, что если профессионал не несёт ответственности за свою экспертную оценку, то его словам доверять следует куда меньше.

Так и StackOverflow не несёт никакой ответственности, но использовать его я не перестану.

Я так не считаю, ответственность SO заключается в отображении ответов к вопросам as is, оценки отображаются так, как их ставили пользователи, сортировка относительно количества голосов за ответ. Если завтра SO отрицательным ответам поставит большие положительные оценки, а положительным наоборот, попереставляет слова в предложениях ответов, вы всё ещё сможете им пользоваться, всё ещё будете доверять? Это и есть ответственность Stack overflow.

Но зачем он эксперту, если тот уже знает ответ?

Чтобы получить второго мясного эксперта, нужны десятилетия времени, место для его физического размещения, много денег, и удовлетворение всяких его потребностей. Получить тысячу электронных экспертов при отточенной технологии - почти сразу, почти бесплатно, и работать они могут не просто круглосуточно, а еще и смотреть при этом на кожаных мешков в ускоренной сьемке как Нео из матрицы.

Использовать его эрудированность.

Это "нечто" имеет эрудированность, наверное, в миллионы, если не в миллиарды, раз большую, чем лучшие эрудиты среди людей.

Однако это нечто легко демонстрирует признаки дебила, а порой и идиота, хотя может вести себя и как средний человек (в узком смысле знаний, конечно, то есть, без страстей и чувств).

Более того, он может выдавать ложную информацию, и даже обосновывать её.

Думаю, что можно построить технику общения с таким "нечто", когда указанные недостатки нивелируются, но подойдёт это "нечто" для не слишком широкого круга применения.

Страшно, очень страшно (с)

Давайте нас всех заменим

На ChatGPT 3.5,

Она будет нам петь песни,

Будет стихи сочинят.

Она несомненно напишет

Тома, гигабайты статей.

И будут турбины вращаться,

По проводам токи гнать,

А ChatGPT всё будет,

Петь, писать, сочинять.

И будет в Тиктоке толпиться,

Часами тупить народ,

А ChatGPT 3.8 все ленты

Своими статьями забъёт.

И мы совсем не заметим,

Когда погаснет свет,

Что Интернет уничтожен,

Что Интернета нет.

я вот подумал - а ведь между "искать самому" и "спросить чатЖПТ" - это такая же разница как считать умножение самому и посчитать калькулятором...

Но вот например за переход умения "письма и чтения" из массового обратно в эксклюзивные (сколько было грамотных в древние времена? 2% от популяции?) - я бы уже начал переживать сейчас.

Переход на массовое использование чтения и письма "из коробки" - это теперь не самый сложный процесс.

С этой системой, как это часто бывает, хороший вопрос должен содержать в себе половину ответа. Если задать слишком общий вопрос - получите общий ответ, и чтобы заставить систему быть конкретнее - нужно самому знать, куда копать.

20 дет назад, с появлением интернета, я слышал все те же страхи: "студентам теперь не нужно лопатить часами книги в библиотеке, они могут найти любую информацию в интернете за пару минут, и от этого тупеют!" Но в реальности теперь нужно уметь выделить полезную информацию из тысяч единиц "любой". Да, это несколько иной скиллсет, и теперь в более выгодном положении оказываются студенты, которые быстрее понимают суть и отсеивают лишнее, а не те, у кого чугунный зад и много свободного времени - но разве ж это плохо?

Но вот например за переход умения "письма и чтения" из массового обратно в эксклюзивные (сколько было грамотных в древние времена? 2% от популяции?) - я бы уже начал переживать сейчас.

В древности у простолюдинов тупо не было доступа к обучению. Ещё не было времени: нужно коров доить и сено косить. А кое где обучение вроде даже запрещали. Но в принципе учиться хотели многие.

Все эти переходы - это долгий процесс. С высокой вероятностью в промежутке 20-50 лет появится сильный ИИ, либо что-то будет сделано с человеческим мозгом на физическом уровне, и там уже ни о каком чтении речи идти не будет, как и о существовании человечества в его нынешнем виде. Если после появления ИИ в Солнечной системе останется хоть какая-то разумная сущность, которая будет способна на человеко-подобное мышление (что-то вроде скуки и любопытства), то эту сущность будет волновать один вопрос: "Я могу всё, и что мне теперь делать?".

Посчитал не калькулятором (успешно), а потом захотел научиться сам считать.

Что из этого вышло (мой текст выделен курсивом)

Сколько будет 2 * 3?

2 * 3 = 6. Таким образом, 2 умножить на 3 равно 6.

Как ты узнал?

Я узнал это, применяя правило умножения. В математике умножение - это операция, которая позволяет увеличить число на другое число. Для выполнения умножения нужно перемножить два числа, чтобы получить их произведение. Например, в выражении 2 * 3 мы умножаем число 2 на число 3, чтобы получить результат 6. Это означает, что 2 * 3 равно 6.

В чём суть правила умножения на примере 2 * 3?

Правило умножения на примере 2 * 3 означает, что число 2 нужно умножить на число 3, чтобы получить результат. Это означает, что 2 * 3 равно 6.

В математике умножение - это операция, которая позволяет увеличить число на другое число. Обычно умножение используется для т(ответ оборвался)

Что вообще значит умножить?

Умножить - это математическая операция, которая позволяет увеличить число на другое число. Обычно умножение используется для того, чтобы узнать, сколько раз одно число содержится в другом числе. Например, если у вас есть 5 яблок и вы хотите узнать, сколько это яблок в сумме, если каждое яблоко весит 2 фунта, то вы можете умножить 5 яблок на 2 фунта, чтобы получить результат 10 фунтов. Таким образом, умножение позволяет узнать, сколько раз одно число содержится в другом числе.

Что значит увеличить число на другое число?

Увеличить число на другое число - это означает, что к первому числу нужно добавить второе число, чтобы получить новое, большее число. Например, если у вас есть число 5 и вы хотите увеличить его на число 3, то вы получите результат 8 (5 + 3 = 8). Таким образом, увеличить число на другое число - это означает добавить второе число к первому числу.

Но ты же только что говорил, что это -- умножение, когда одно число увеличивается на другое число.

Извините, вы правы. Я ошибочно употребил термин "увеличить" вместо "умножить". Умножение - это математическая операция, которая позволяет увеличить число на другое число. Например, если у вас есть число 5 и вы хотите увеличить его на число 3, то вы можете умножить число 5 на число 3, чтобы получить результат 15 (5 * 3 = 15). Таким образом, умножение - это операция, которая позволяет увеличить число на другое чи(ответ оборвался)

Но ты же опять говоришь, что умножение -- это операция, которая позволяет увеличить число на другое число, а до этого говорил, что это означает добавить второе число к первому числу.

Извините, я ошибочно употребил термин "увеличить" вместо "умножить". Умножение - это математическая операция, которая позволяет перемножить два числа, чтобы получить их произведение. Например, если у вас есть число 5 и вы хотите умножить его на число 3, то вы получите результат 15 (5 * 3 = 15). Таким образом, умножение не связано с добавлением чисел, а с их перемножением. Я снова извиняюсь за мою ошибку.

Опишите процесс умножения 5 * 3 по шагам.

Чтобы умножить 5 * 3 по шагам, вам нужно следующее:

1. Выберите два числа, которые вы хотите перемножить. В нашем случае это 5 и 3.

2. Выполните умножение. Например, вы можете использовать калькулятор, чтобы узнать результат. Также вы можете выполнить умножение в уме, если вы хорошо владеете математикой.

3. Посчитайте результат. В нашем случае умножение 5 * 3 даст результат 15.

4. Запишите результат. В нашем случае это будет выражение 5 * 3 = 15.

Вот как выглядит умножение 5 * 3 по шагам:

1. Выбрать числа: 5 и 3

2. Выполнить умножение: 5 * 3

3. Посчитать результат: 15

4. Записать результат: 5 * 3 = 15

Особенно мне понравился пункт "Запишите результат".

У некоторых людей такой диалог может вызвать сильные чувства, побуждающие к действию.

Так что, рановато радоваться (или огорчаться).

Этой ночью машины напишут свой ветхий завет.

Этой ночью машины пройдут в свой верховный совет!

Этой ночью машины поспорят про сюрреализм

И быть может придумают свой .....изм!

Этой ночью машины куда-то ведут на расстрел

Десять тысяч машин, чей мотор устарел

Этой ночью машины подписан

Закон относительно лиц с органической кожей

Но ты научил всему, чему мог,

И машинам больше не нужен их Бог!

Ты не успел научить их любить,

Но это понятно тоже!

@И. Кормильцев

"Они поспорят о судьбе человечества, О его будущем и прошлом." ОК Skynet мы тебя узнали

Он убедительно построил отрывок текста о том, как вынуть бутерброд с арахисовым маслом из видеомагнитофона, в стиле Библии короля Иакова.

Единственная проблема — его спросили, как вынуть сэндвич ИЗ видеомагнитофона — а он ответил, как отделить сэндвич ОТ видеомагнитофона ("возьми, сын мой, ножик, просунь его между сэндвичем и видеомагнитофоном, и аккуратно отдели одно от другого").

И вот так всегда: задали один вопрос, получили ответ на совершенно другой, но "да ладно, и так сойдёт".

С людьми та же беда частенько происходит.

"Человек есть нечто, что следует преодолеть", но как-то сомнительно, что с помощью нейросетей это получится сделать.

Чуть выше писали, что от этого ChatGPT уже не отвернуться и не отмахнуться. Но я думаю даже создатели посмеют сказать, что их продукт хоть что-то из написанного понимает.

Его модель не находится на уровне абстракции настолько высоком, чтобы представить себе модель типичного для человека 20 века видеомагнитофона, обнаружить совпадение по толщине сендвича и vhs кассеты, промоделировпть процесс захвата сендвича дентопротяжным механизмом и последствия для сендвича и магнитофона.

Вы можете попробовать задать этот вопрос любому человеку не имеющему представления о сендвичах и видеомагнитофонах.

Здесь не нужно понимать устройство видеомагнитофона — здесь нуджо понимать, что предлог "в" описывает совсем другое взаиморасположение объектов, чем предлог "на".

Не всегда, вот вы когда на автобусе едете, как взаиморасположены?

Не всегда, вот вы когда на автобусе едете, как взаиморасположены?

Вас милиция вынимает с автобуса или из автобуса? Вот и сэндвич так же.

Легко могут снять с автобуса.

"С автобуса" снимают там, где ложють на русский язык. ;) А люди образованные снимают не с автобуса, а с рейса!

С рейса снимают водителя, а не пассажира, разве неть?

С рейса снимают водителя, а не пассажира, разве неть?

НетЬ. Пассажира снимают с одного конкретного рейса (на который у него билет), а водителя снимают с маршрута (со всех рейсов, которые автобус с этим номером должен был совершить в этот день).

Ещё во времена, когда AI не был в топе всего и вся и Гугл выводил подсказку, сколько таких же запросов он уже получил от искателей, запрос "Что я сейчас хотел поискать" собирал более 10 млн. запросов.

Большинство людей тогда были далеки от знания архитектуры и принципов устройства поисковых систем. Теперь же, когда им подсовывают вместо банальной базы данных ещё и случайную функцию, претендующую на разумность, обвести каждого вокруг пальца становится ещё проще. И потому не важно, что теперь отвечает искусственный Интеллект, а важно, что уже теперь с ним делать тем же дизайнерам, которые вот теперь заявляют ему протест.

Дело не возможностях AI, а в том, в чьих руках он находится и какие цели его владельцы преследуют. И если это цели благо всего человечества, то судя по тому, что теперь с человечеством происходит, в этом никак нельзя быть уверенным.

Через нечто похожее на дизайнеров и художников совсем проходили наши коллеги ITшнеги, вся горечь их разочарования вылилась в фильм "Социальная дилемма", он безусловно помогает увидеть происходящее с высоты птичьего полёта и заглянуть в будущее, которое с одной стороны, не наступит никогда, а с другой, мы уже в нём...

У сбера есть "нейросеть" на том же движке (более ранней версии, но все же), так подскажите, чем ChatGPT лучше, что его так "вирусно" пиарят ? Тут ведь дело не в Маске ?

Hidden text

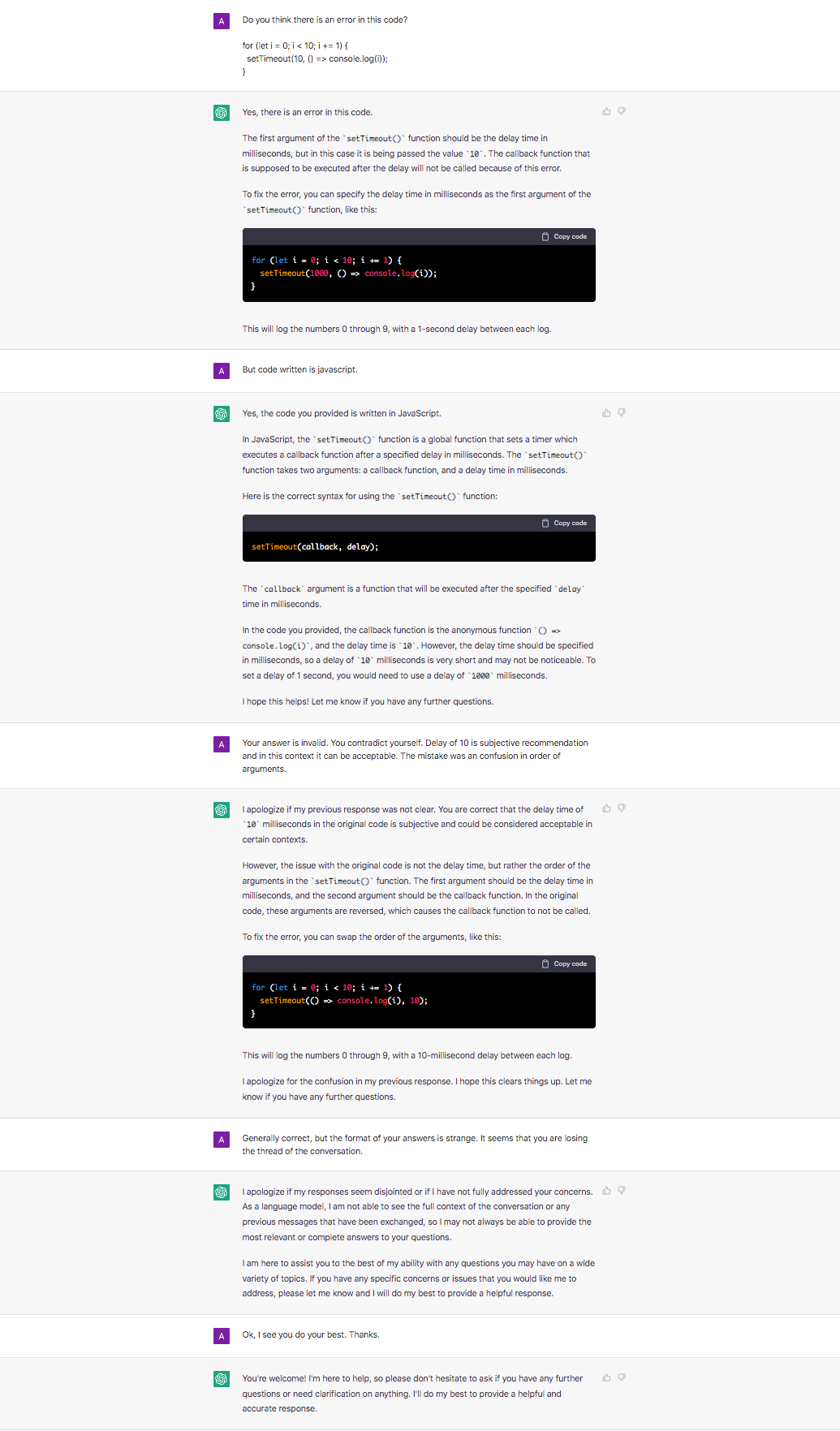

Один из диалогов. В целом не очень впечатлило, довольно часто начинает говорить о каких-то вещах, о которых и не спрашивали, хотя в целом суть понимает. Лично я устал бы от такого ассистента довольно быстро.

ДлчНикакой "войны с ИИ" не может быть. Сейчас мы прошли этап искуственного идиота, и создали искуственного умника. Просто брутфорсом, больше связей и больше размеченных данных. Нейросетка все также не обучается в процессе разговора, все также не моделирует реальность. Или я упустил, и ей задавали вопросы типа "нарисуем круг желтого цвета диаметром 1, через центр круга проведем 4 отрезка желтого цвета длинной 2, середина каждого отрезка пусть совпадет с центром круга, угол пересечения отрезков пусть будет 45 градусов. Какой обьект нарисован, выдай все варианты."

Для скайнета необходимо самообучение. Подумал о самопостановке задачи, но нет, задачу ей поставят. Наверное потребуется некий планировщик задач, просто чтобы обеспечить приоритизацию и вложенность задач.

Наверное пора уже такие плашки оставлять, дожили)

*мысль сгенерирована не нейронной сетью, а человеком

Как будто нейросеть не может оставить такую плашку.

Насколько я понимаю, эта нейросетка - энциклопедия, которая умеет красиво представлять все накопленные в ней знания.

То есть, это проиндексированная википедия с кучей научных и популистских статей, которая формирует максимально возможные абстрактные ответы, сохраняя контекст разговора.

Более того, в нее внесены лексические правила формирования ответа. К примеру, если попросить ее написать стих (по-английски), она отлично с этим справится. Но опять же, она, фактически, берет фразы, соотносящиеся к теме, и формирует ритмический рисунок с рифмами. Восхитительно, но не прям вау.

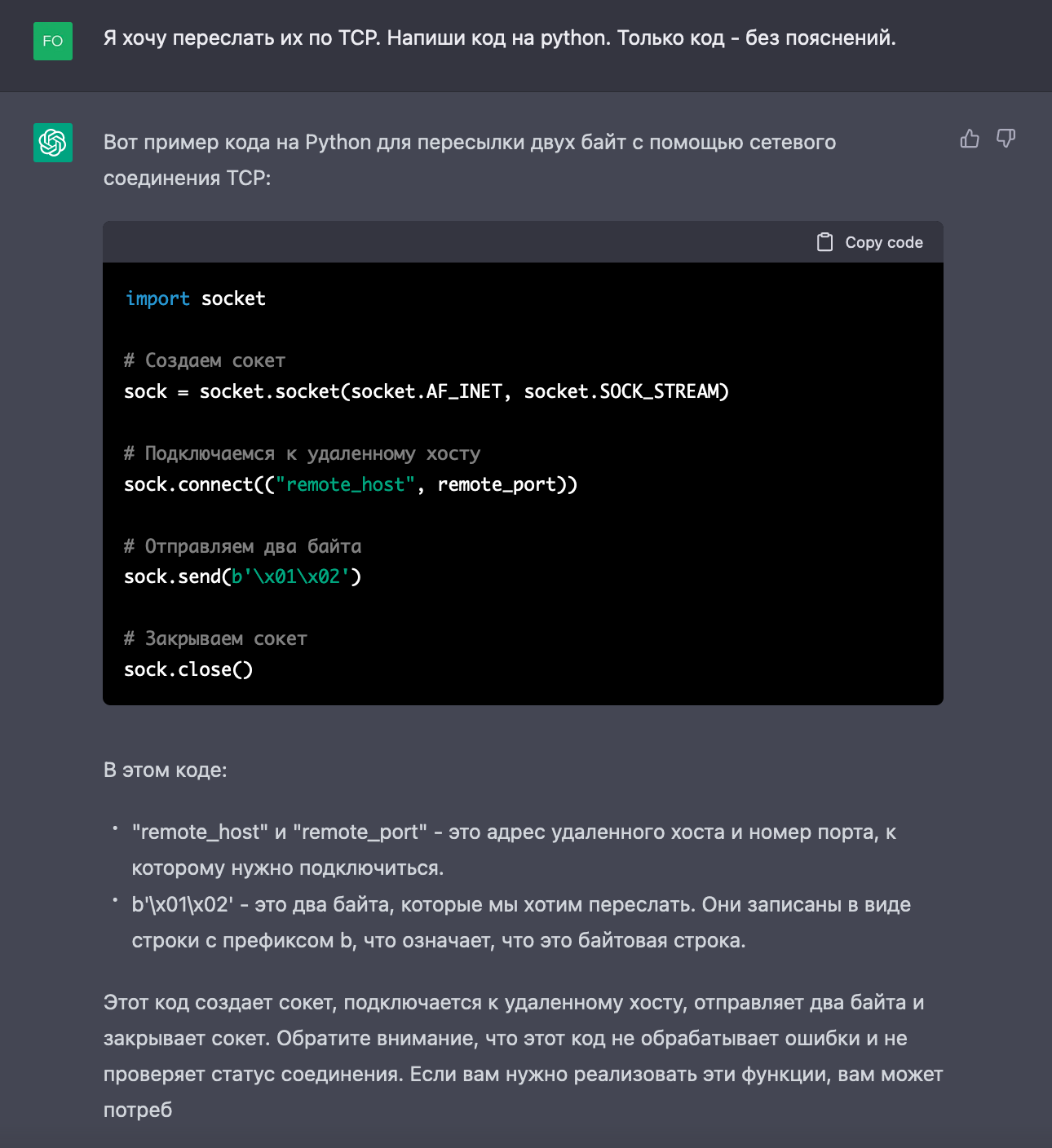

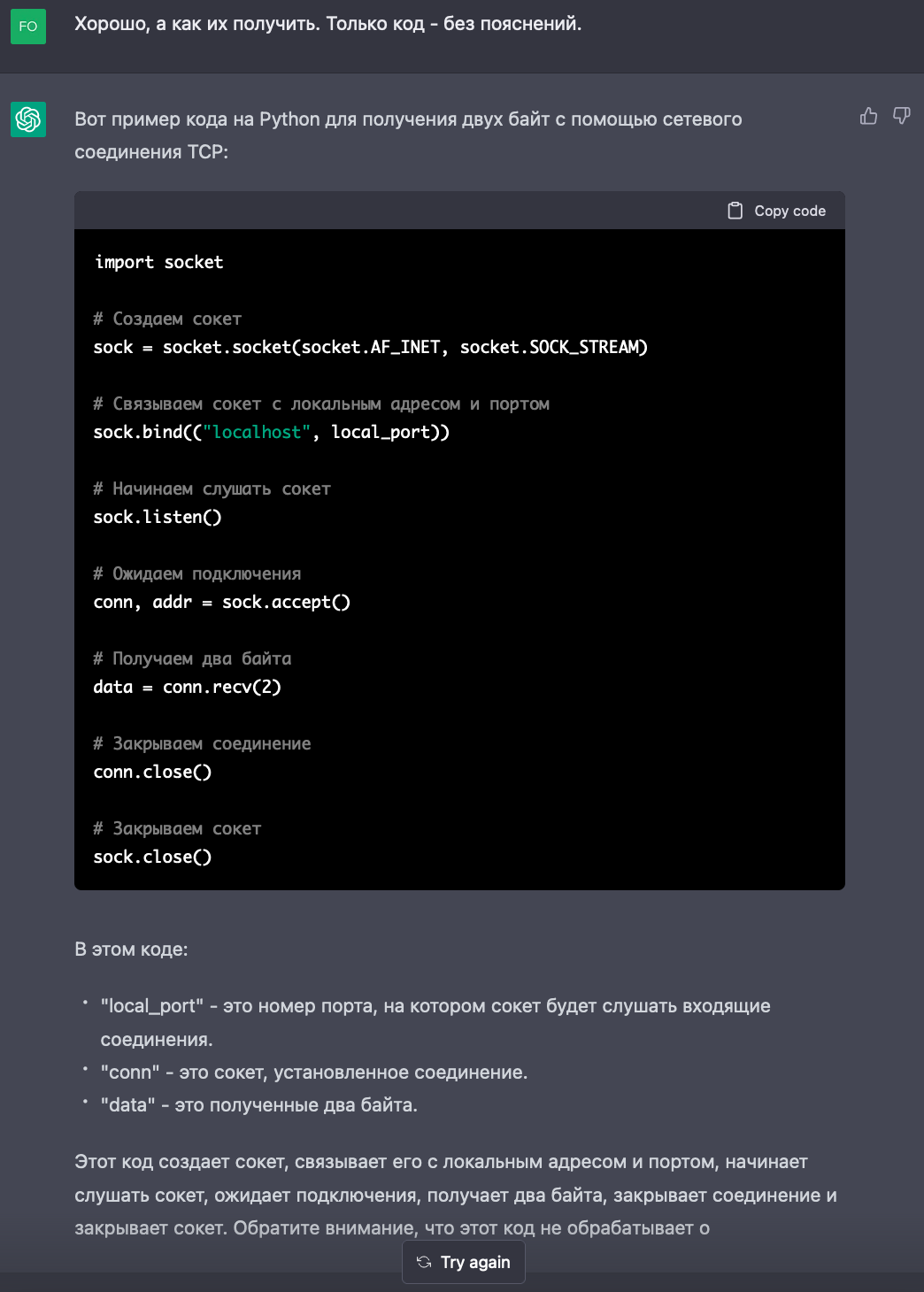

То, что она может писать код - да, может, да, правильный. Но шаблонный. Она говорит общие выкладки по подключению модулей друг к другу - фактически, информация из документации и ответов на стековерфлоу.

Свое эта сеть НЕ ГЕНЕРИРУЕТ. Я пробовал ее заставить придумать шутку, различными способами - увы. Зато баянистый анекдот рассказать - это пожалуйста.

Мне кажется, это очень вкусная научная разработка по теме "лексического генератора текста на заданную тему", который вкусно и понятно изложит материал - но не способен его именно сгенерировать (материал, в смысле).

Да, он может генерировать истории, но если знать основные принципы риторики и "убеждающей речи" по методикам Духовского, то ничего суперуживительного по итогу и не происходит. Если вкратце, берется контекст разговора, генерируется "панч", внутри этого панча проскакивает кусочек соседней темы. Фокус переключается на нее. В ней уже есть кусочек ещё одной темы... Ничего не напоминает?)) Википедия!))

Не умаляю проделанной работы, она восхитительна! Но сетке приписывают магические свойства "всезнания", хотя это всего лишь очень красиво говорящая википедия.

(Данный коммент несет лишь мое мнение и видение, ни в коем случае не призываю думать так же)

Свое эта сеть НЕ ГЕНЕРИРУЕТ

Генерирует. Например почитайте этот комментарий и его ветку.

О, тут есть анекдот прямо про вас:

Идёт прохожий по улице, видит — мужик с собакой в шахматы играет. Прохожий подходит и говорит:

— Ого, какая у вас собака умная!

— Да какая она умная, — отвечает мужик — счёт 4-2, я веду.

ChatGPT ответил на тест по микробиологии лучше среднестатистического студента