Нейронные сети стремительно меняют ландшафт цифрового маркетинга, и SEO не является исключением. Все больше специалистов по поисковой оптимизации обращаются к возможностям искусственного интеллекта, чтобы улучшить свои стратегии, автоматизировать рутинные задачи и добиться более высоких результатов в органической выдаче.

Однако внедрение нейросетей в SEO - это не просто дань моде, а насущная необходимость. С ростом конкуренции и постоянным усложнением алгоритмов поисковых систем традиционные методы оптимизации уже не дают прежнего эффекта. Чтобы оставаться на гребне волны, SEO-специалистам нужно осваивать новые инструменты и подходы, основанные на машинном обучении и обработке больших данных.

Но как именно нейросети могут помочь в SEO? Какие задачи они способны решать уже сегодня, а какие перспективы открывают на будущее? Как выбрать и внедрить подходящие инструменты в свой рабочий процесс? Эти вопросы волнуют многих оптимизаторов - как начинающих, так и опытных профессионалов.

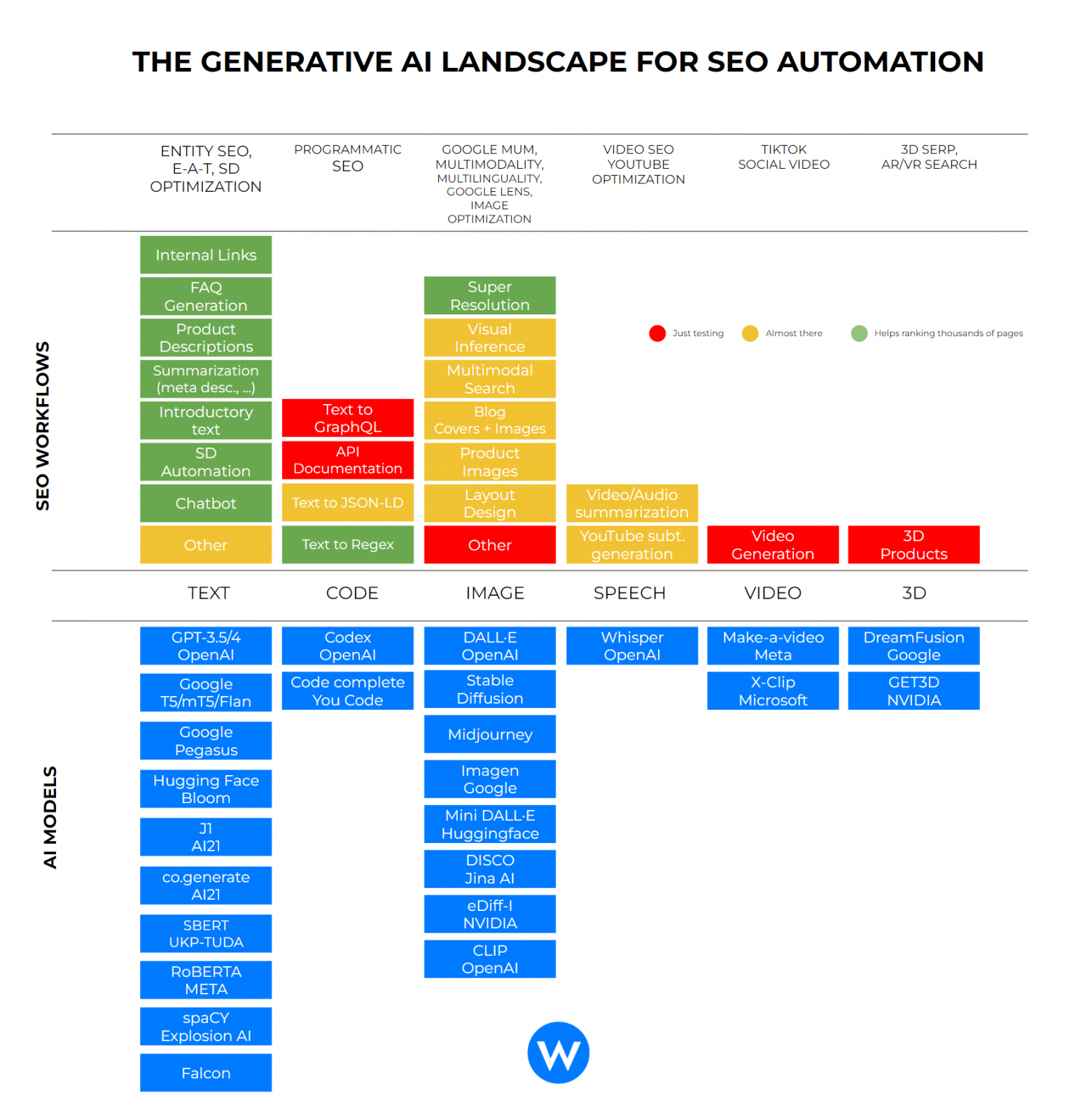

В этой статье мы постараемся дать развернутые ответы на эти вопросы и предоставить максимум полезной информации по теме. Мы подготовили большой обзор инструментов, которые используют как минимум алгоритмы машинного обучения. Наша цель - не просто познакомить вас с трендами на стыке SEO и ИИ, но и вооружить практическими знаниями, которые вы сможете применить в своей работе.

Ну что ж, поехали! Приятного чтения:)

Нейросети для оптимизации текстового контента

Одно из ключевых применений нейросетей в SEO - это генерация и оптимизация текстового контента. Традиционно написание SEO-текстов было трудоемким и времязатратным процессом, требующим от специалистов хорошего понимания принципов релевантности, читабельности и поисковых алгоритмов. Однако с развитием генеративных языковых моделей, таких как GPT, этот процесс может быть в значительной степени автоматизирован и улучшен.

Хочу отметить сразу пару вещей:

В текущих реалиях стоит учитывать, что большая часть инструментов, описываемых в статье, доступны через VPN и на английском.

В контексте данной статьи мы будем говорить о самых последних моделях от OpenAI и Anthropic.

Теперь небольшое введение для тех, кто не сильно знаком с базовыми нейросетями.

Без VPN и абонентской платы нейросети можно использовать на BotHub. BotHub - это передовая платформа-агрегатор, где собраны самые популярные и эффективные нейросети. Здесь вы найдете самые последние модели ChatGPT-4, Midjourney и Claude без необходимости покупать несколько подписок на каждый из ИИ-инструментов, который может быть вам полезен не только в SEO-оптимизации, но в других рабочих и повседневных задачах.

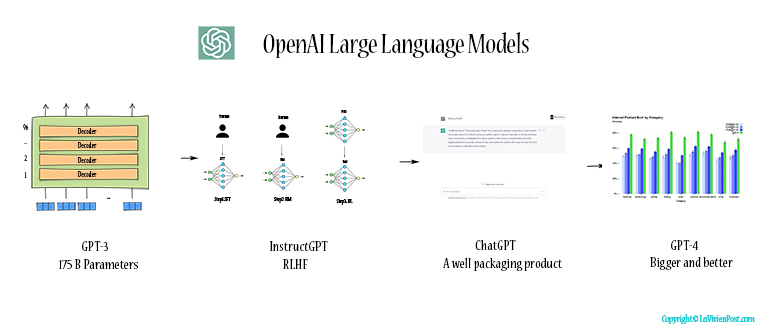

Одним из самых передовых инструментов в этой области является ChatGPT-4 - языковая модель от OpenAI, основанная на архитектуре трансформеров и обученная на огромном массиве текстовых данных. ChatGPT-4 использует многослойную нейронную сеть с attention mechanism, которая позволяет модели учитывать контекст и генерировать связные, релевантные и грамматически правильные тексты на основе заданных пользователем параметров.

Архитектура трансформеров, лежащая в основе ChatGPT-4, революционизировала область NLP. В отличие от традиционных рекуррентных нейронных сетей), трансформеры используют механизм self-attention, позволяющий модели анализировать взаимосвязи между словами в предложении без привязки к их позиции. Это дает возможность эффективно обрабатывать длинные последовательности и улавливать глубокий контекст, что критически важно для генерации связного и релевантного текста.

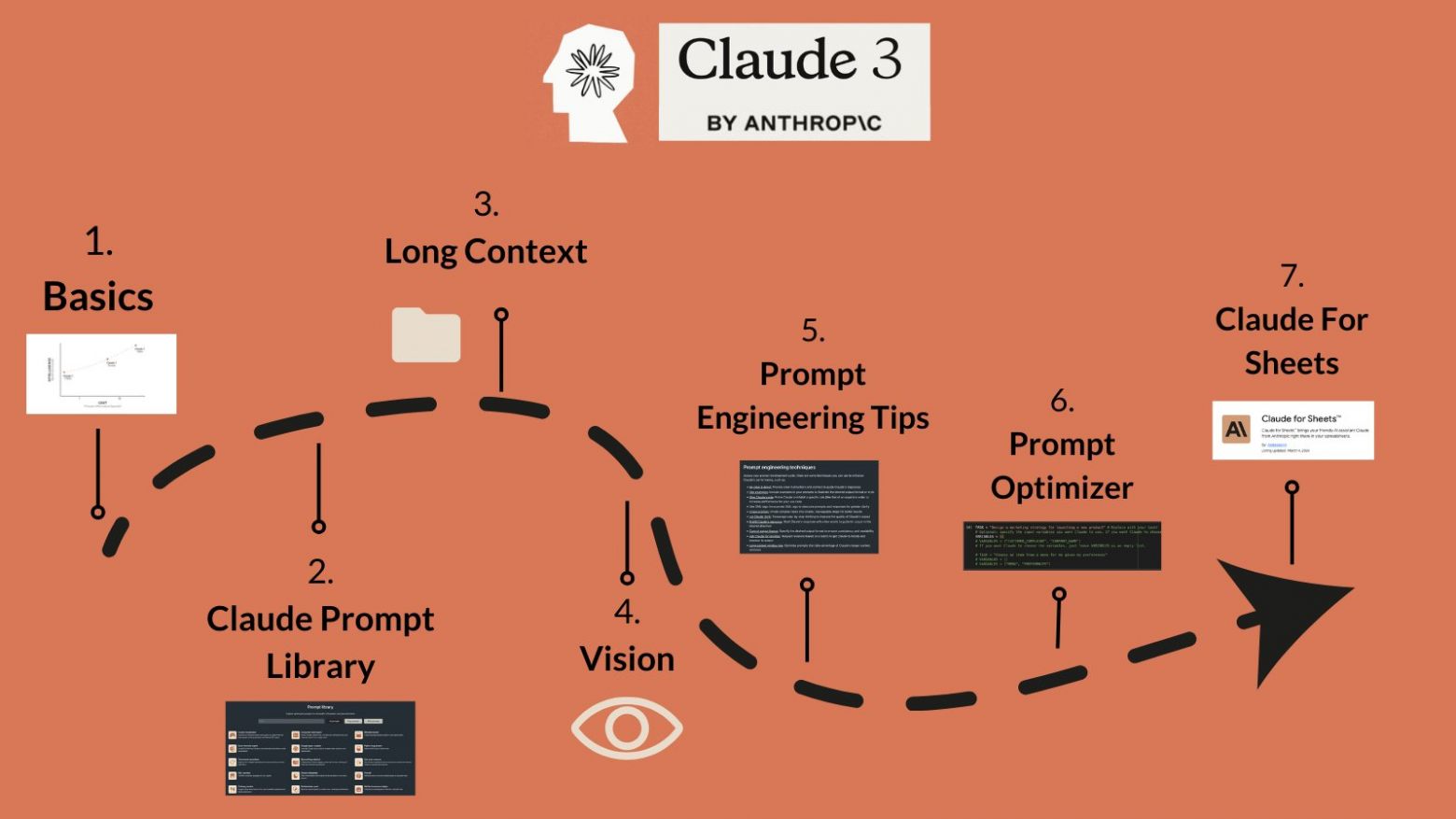

Другой мощный инструмент - это Claude от Anthropic. В основе Claude 3 лежит архитектура Constitutional AI, которая накладывает на модель определенные этические и поведенческие ограничения, заданные разработчиками. Это позволяет генерировать не только качественные, но и безопасные, непротиворечивые тексты, соответствующие заданным правилам и ценностям.

Концепция Constitutional AI - это важный шаг в развитии ответственного и контролируемого ИИ. Благодаря встроенным этическим принципам и ограничениям, модели вроде Claude 3 могут генерировать контент, свободный от токсичности, дезинформации, плагиата и других нежелательных элементов. Это особенно важно для SEO-текстов, которые должны не только привлекать трафик, но и формировать доверие и авторитет бренда в глазах пользователей и поисковых систем.

Но как именно работают эти модели и как их применять для SEO-задач? Давайте разберемся подробнее.

Ключевой особенностью ChatGPT-4 и Claude 3 является их способность к few-shot learning - то есть, они могут адаптироваться к новым задачам и генерировать релевантный контент на основе всего нескольких примеров или инструкций. Это достигается за счет использования техники проектирования запросов или промпт-инжиниринга - формирования особым образом структурированных текстовых запросов, которые направляют модель на решение конкретной задачи.

Промпт-инжиниринг - это искусство и наука создания эффективных текстовых запросов для языковых моделей. Правильно составленный промпт должен четко описывать желаемый результат, задавать необходимые параметры и ограничения, и при этом оставлять модели пространство для креативности и адаптации. Овладение навыками промпт-инжиниринга - ключ к эффективному использованию таких инструментов, как ChatGPT-4 и Claude 3, для решения SEO-задач.

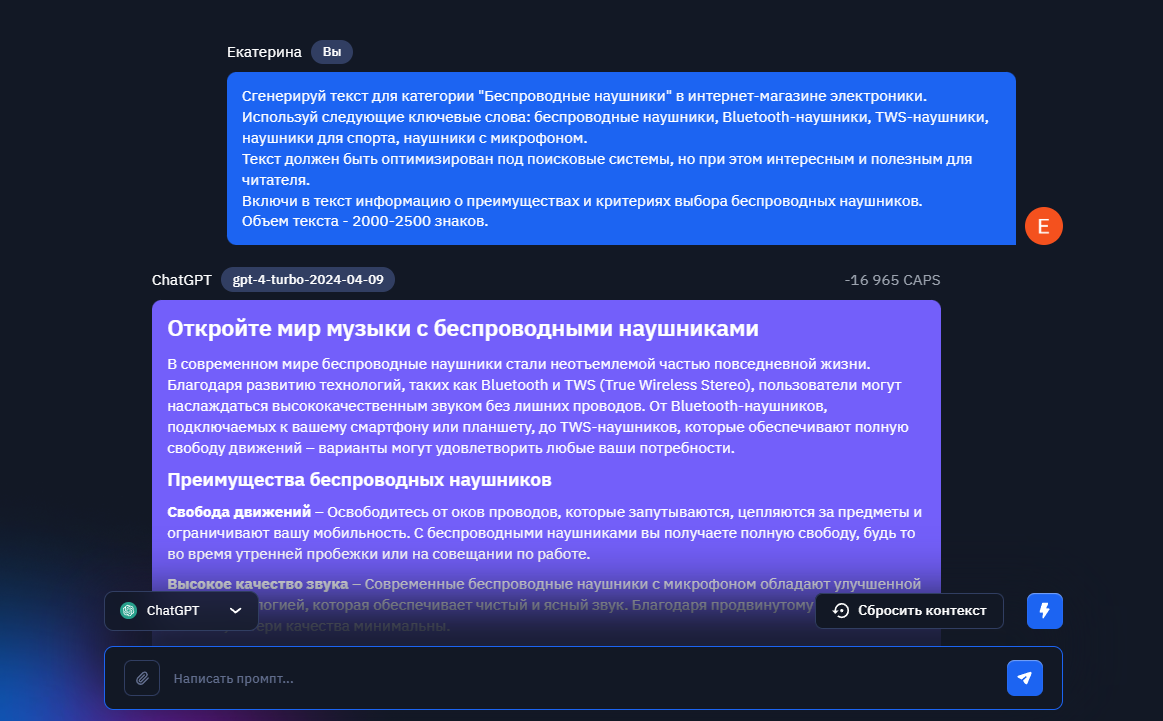

Например, чтобы сгенерировать SEO-оптимизированный текст для страницы интернет-магазина, мы можем сформулировать следующий запрос для ChatGPT-4-Turbo:

"Сгенерируй текст для категории «Беспроводные наушники» в интернет‑магазине электроники. Используй следующие ключевые слова: беспроводные наушники, Bluetooth‑наушники, TWS‑наушники, наушники для спорта, наушники с микрофоном. Текст должен быть оптимизирован под поисковые системы, но при этом интересным и полезным для читателя. Включи в текст информацию о преимуществах и критериях выбора беспроводных наушников.

Объем текста — 2000–2500 знаков."

Такой запрос задает модели четкие параметры желаемого текста: тематику, ключевые слова, требования к оптимизации и полезности для читателя, необходимые информационные блоки и объем. На основе этих инструкций ChatGPT-4-Turbo сгенерирует уникальный текст, который будет соответствовать всем заданным критериям и готов к публикации на сайте.

Аналогичным образом можно использовать и Claude 3, добавив к запросу инструкции по желаемому стилю и тону текста, а также этические ограничения (например, избегать упоминания конкретных брендов или не давать медицинских рекомендаций).

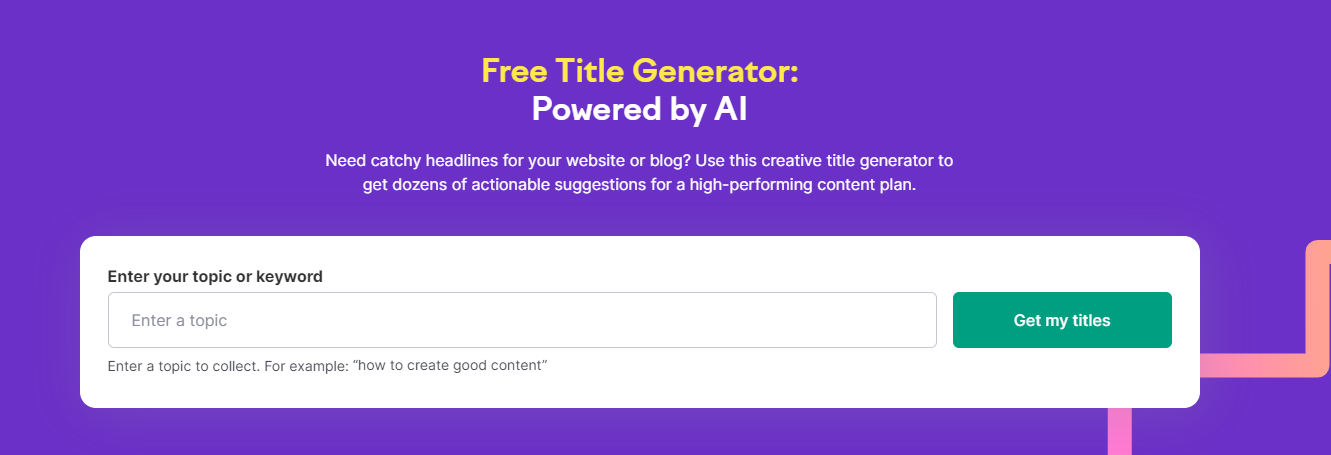

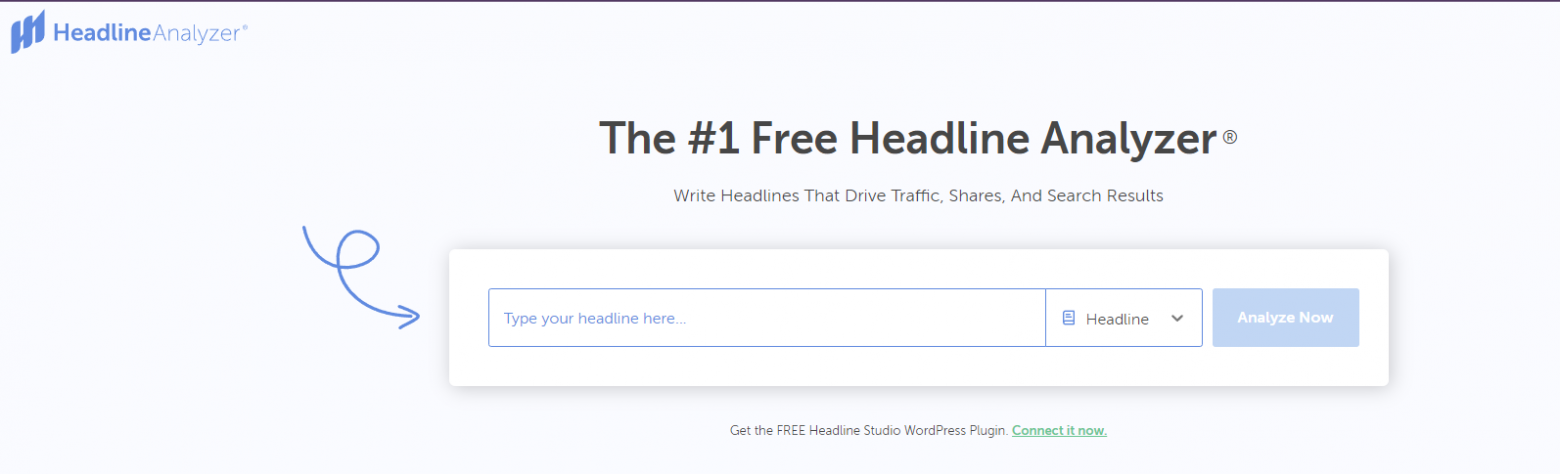

Помимо генерации текстов "с нуля", нейросети могут применяться и для оптимизации уже существующего контента. Такие инструменты, как Title Generator Tool от SemRush и Headline Analyzer, используют алгоритмы машинного обучения для оценки и улучшения заголовков и мета-тегов с точки зрения их привлекательности для пользователей и релевантности для поисковых систем.

TitleGeneratorTool использует технологии обработки естественного языка и глубокого обучения для анализа семантики входного текста и генерации оптимизированных заголовков. Инструмент учитывает такие факторы, как длина заголовка, включение ключевых слов, использование эмоционально окрашенной лексики и другие SEO-параметры. Это позволяет создавать заголовки, которые не только привлекают внимание пользователей, но и хорошо ранжируются в поисковой выдаче.

Headline Analyzer от CoSchedule, в свою очередь, оценивает качество заголовков по целому ряду параметров, включая читабельность, эмоциональный окрас, использование "силовых слов" и общий потенциал кликабельности. Инструмент использует алгоритмы машинного обучения, обученные на большой выборке успешных заголовков, чтобы предсказывать их эффективность и давать рекомендации по улучшению.

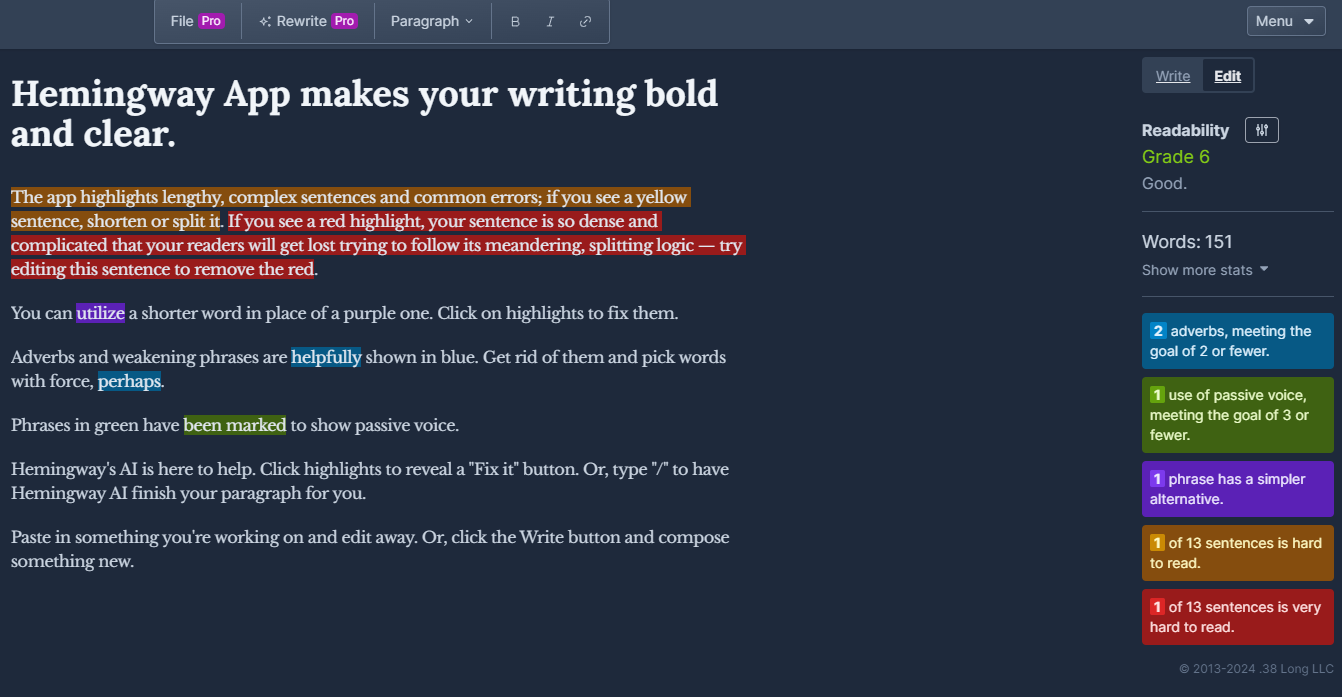

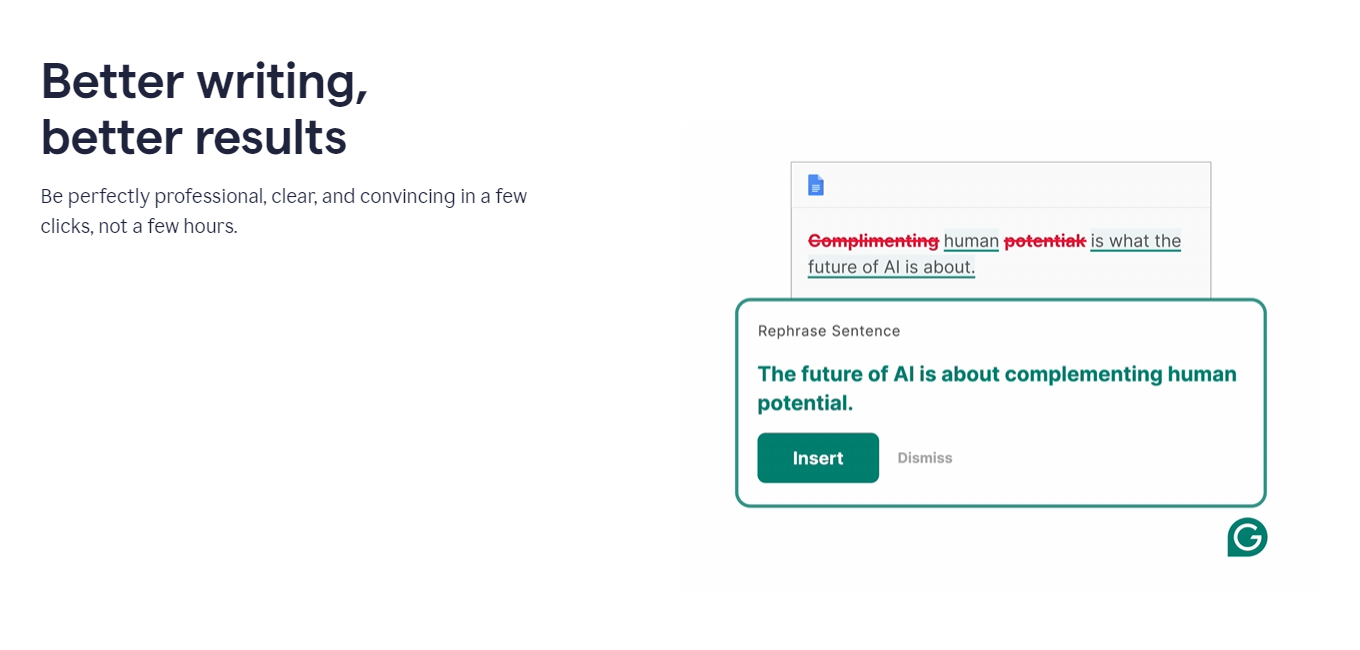

Для повышения качества и релевантности уже написанных SEO-текстов можно использовать такие инструменты, как Hemingway Editor и Grammarly. Они анализируют текст с помощью все тех же алгоритмов NLP и выявляют проблемы с читабельностью, грамматикой, стилем и тональностью.

Hemingway Editor использует набор правил и эвристик для оценки сложности и читабельности текста. Он выделяет сложные предложения, пассивные конструкции, наречия и другие элементы, которые могут затруднять восприятие, и предлагает варианты их упрощения или замены. Такая оптимизация делает текст более легким и привлекательным для читателей, что положительно сказывается на поведенческих факторах и ранжировании в поиске.

Grammarly, в свою очередь, использует передовые алгоритмы машинного обучения для выявления грамматических, стилистических и пунктуационных ошибок в тексте. Инструмент не только предлагает варианты исправления, но и дает развернутые объяснения правил и рекомендации по улучшению текста. Это помогает сделать SEO-контент более качественным, профессиональным и привлекательным для пользователей.

Кроме того, для эффективного применения языковых моделей и алгоритмов NLP необходимо постоянно следить за их развитием, экспериментировать с разными подходами и техниками, и непрерывно обучаться самому. Только в этом случае нейросети смогут стать по-настоящему мощным оружием в арсенале SEO-специалиста и помочь вывести качество текстового контента на новый уровень.

Применение нейросетей для технического SEO

Техническая оптимизация сайта - это важнейший аспект SEO, который влияет на скорость загрузки, удобство навигации, мобильную адаптивность и другие факторы, учитываемые поисковыми системами при ранжировании. И хотя традиционно техническое SEO считалось сферой, где ИИ и нейросети имеют ограниченное применение, последние достижения в области машинного обучения открывают новые возможности для автоматизации и оптимизации технических процессов.

Одно из ключевых направлений применения нейросетей в техническом SEO - это оптимизация скорости загрузки сайтов. Быстрый сайт не только улучшает пользовательский опыт, но и положительно влияет на ранжирование в поиске, особенно после введения алгоритма Google Page Experience Update. Инструменты на базе машинного обучения, такие как GTmetrix и Google PageSpeed Insights, помогают выявлять факторы, замедляющие загрузку страниц, и давать рекомендации по их устранению.

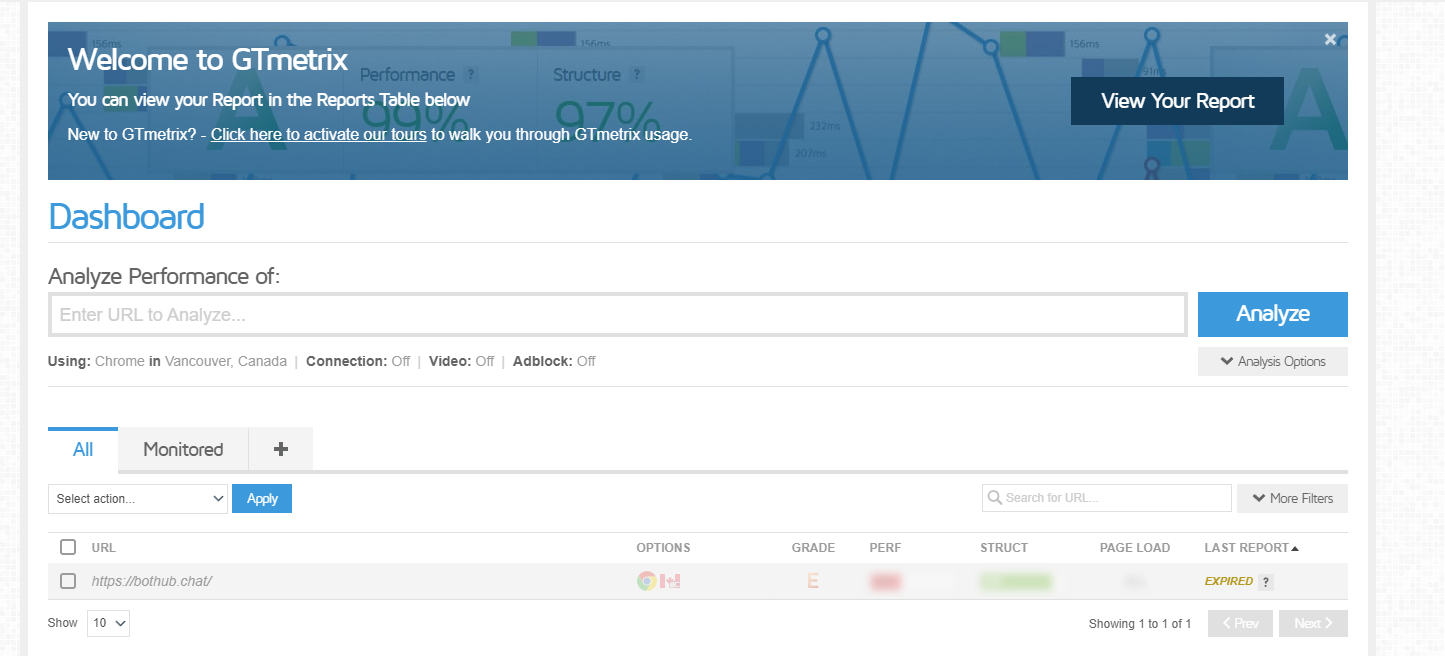

GTmetrix использует комбинацию алгоритмов анализа производительности и эвристических правил для оценки скорости загрузки сайта и выявления потенциальных проблем. Инструмент анализирует такие параметры, как время отклика сервера, размер и количество HTTP-запросов, эффективность кеширования и сжатия, оптимизацию изображений и другие факторы, влияющие на скорость. На основе этого анализа GTmetrix генерирует подробный отчет с оценками по каждому параметру и пошаговыми рекомендациями по оптимизации.

Google PageSpeed Insights, в свою очередь, использует алгоритмы машинного обучения и массивы данных о поведении пользователей для оценки скорости загрузки сайта и его влияния на UX. Инструмент анализирует как лабораторные данные (симуляция загрузки страницы на стандартном оборудовании и подключении), так и полевые данные (реальные метрики от пользователей Chrome). Это позволяет получить комплексную оценку производительности сайта и выявить приоритетные направления для оптимизации.

Но оптимизация скорости - это лишь один из аспектов технического SEO, где нейросети могут быть полезны. Другое перспективное направление - это улучшение пользовательского опыта (UX) на основе анализа поведения пользователей. Инструменты веб-аналитики на базе ИИ, такие как Hotjar и Crazyegg, позволяют отслеживать и анализировать взаимодействие пользователей с сайтом, выявлять проблемные места и возможности для оптимизации.

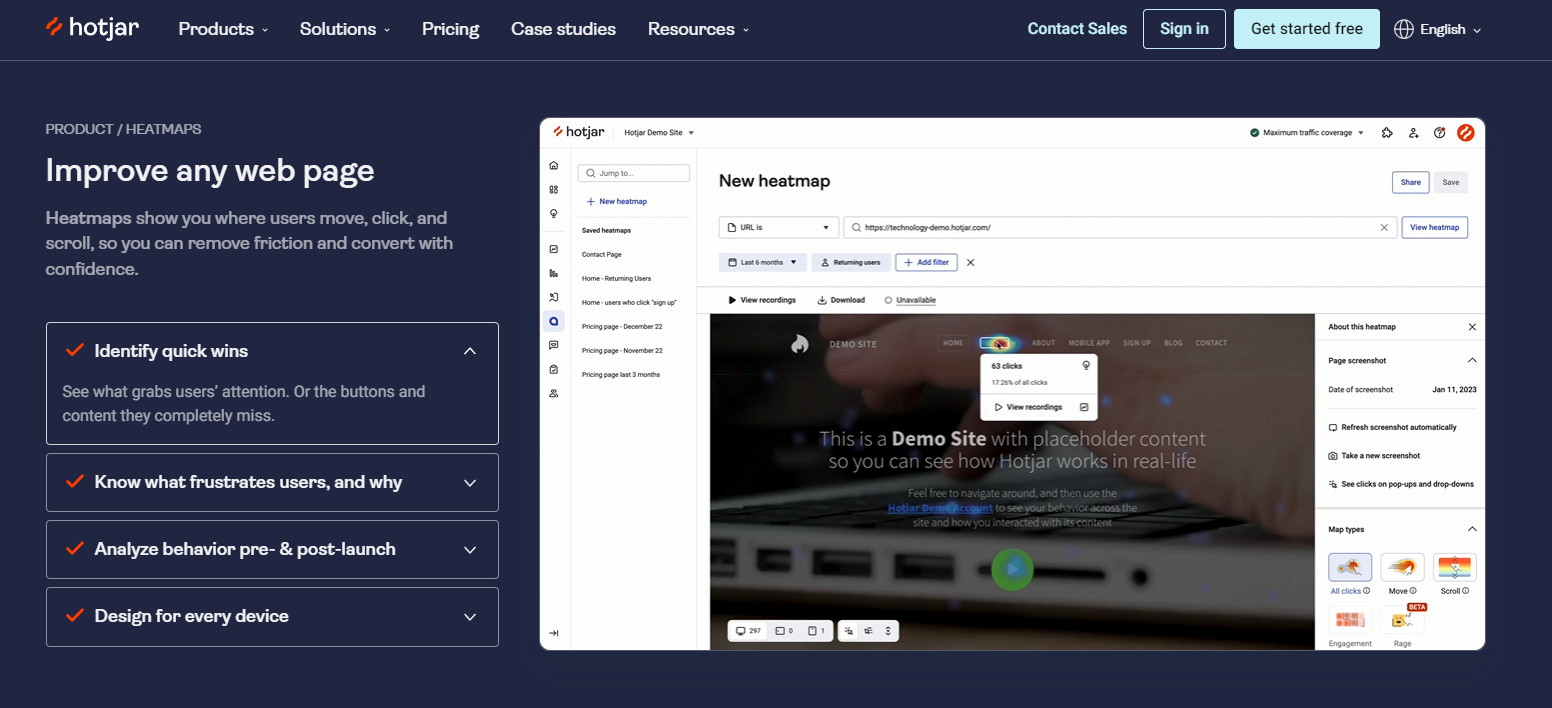

Hotjar использует комбинацию тепловых карт кликов, скроллинга и движения мыши, записей сессий, опросов и других методов для сбора качественных данных о поведении пользователей на сайте. Затем алгоритмы машинного обучения анализируют эти данные, выявляют паттерны и генерируют инсайты для оптимизации UX. Например, на основе анализа тепловых карт можно выявить непопулярные элементы навигации или неочевидные кнопки призыва к действию, а на основе записей сессий - найти страницы с высоким показателем отказов и разобраться в причинах.

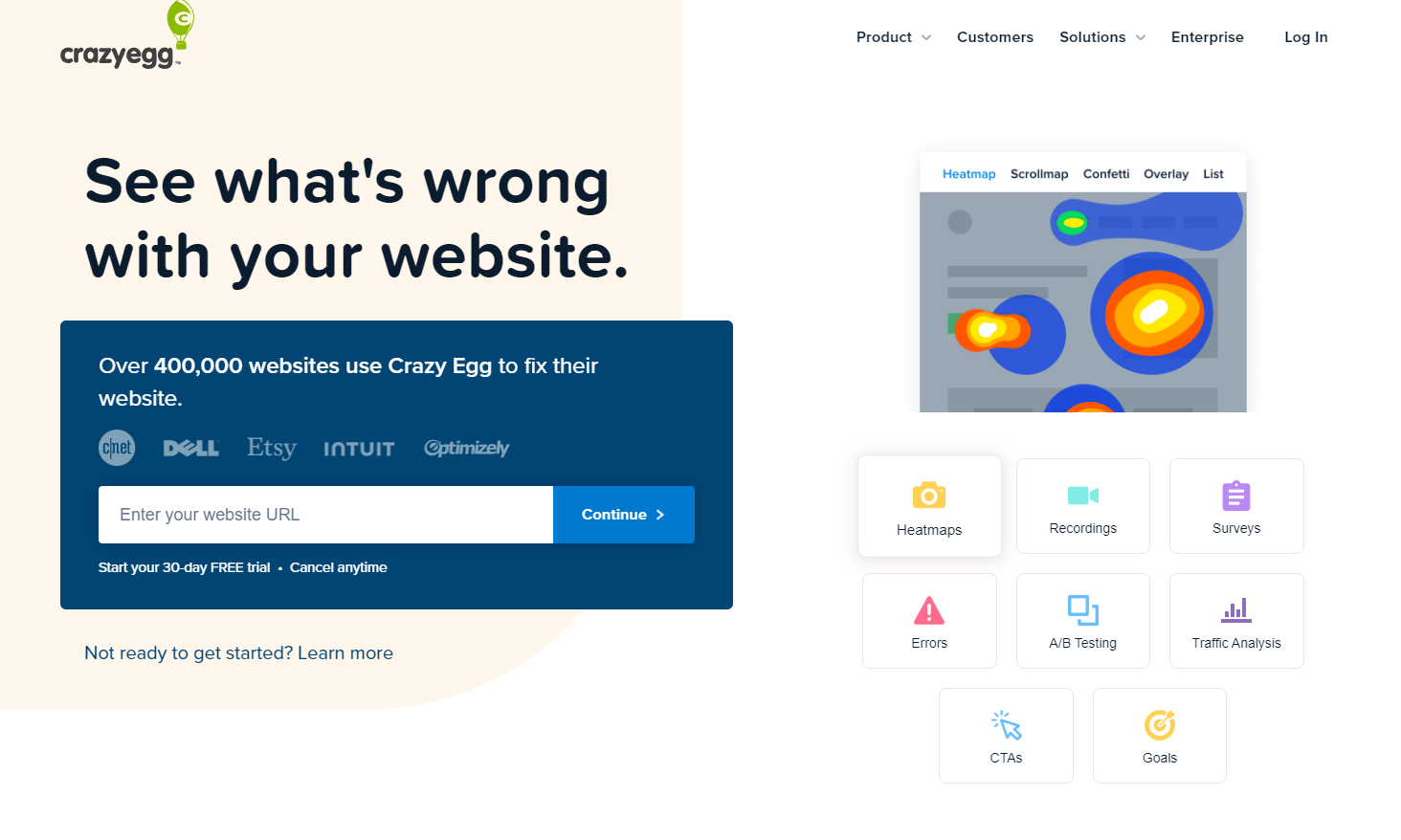

Crazyegg предлагает похожий функционал, включая тепловые карты, запись сессий и А/В-тестирование, но с упором на визуальную аналитику. Инструмент использует передовые алгоритмы для создания наглядных отчетов и визуализаций, которые помогают быстро выявлять проблемы и возможности для оптимизации. Например, функция "Confetti" показывает каждый клик на странице в виде цветной точки, сегментированной по источнику трафика, устройству или другим параметрам. Это позволяет быстро оценить, какие элементы страницы привлекают больше всего внимания и конверсий для разных групп пользователей.

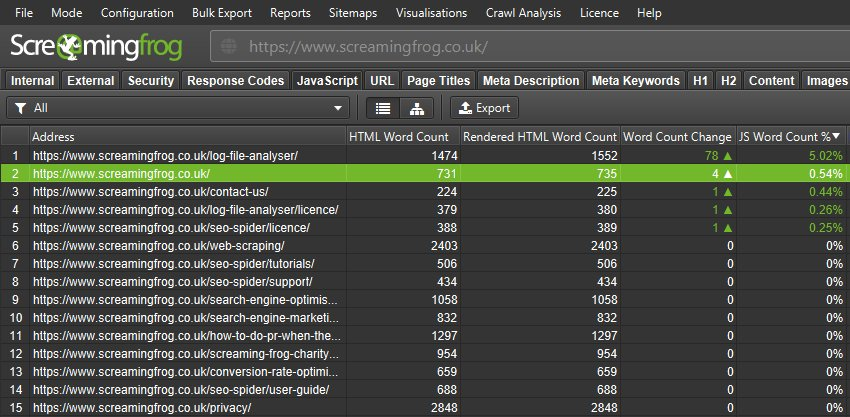

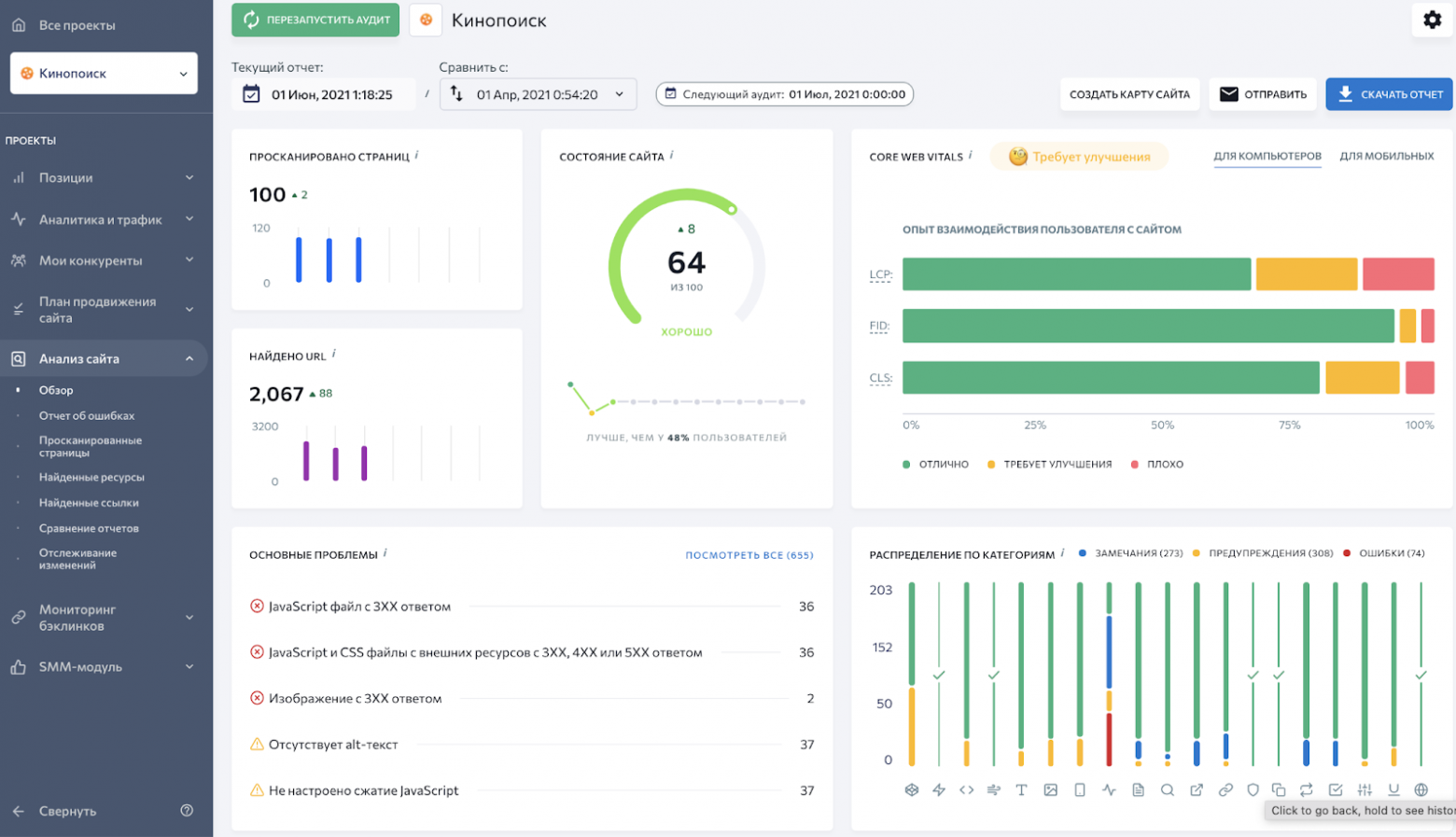

Помимо анализа поведения пользователей, нейросети могут применяться и для автоматизации аудита сайта и выявления технических ошибок. Инструменты на базе ИИ, такие как Lumar (Deepcrawl) и Screaming Frog SEO Spider, помогают сканировать сайты, обнаруживать проблемы с индексацией, дубликатами, перенаправлениями, битыми ссылками и другими техническими факторами, влияющими на SEO.

Lumar использует передовые алгоритмы краулинга и обработки данных для сканирования сайтов на предмет технических ошибок и потенциальных проблем с SEO. Инструмент может анализировать сотни тысяч страниц, выявлять паттерны и аномалии, и генерировать подробные отчеты с рекомендациями по исправлению. Одна из ключевых особенностей Lumar - это способность интегрироваться с Google Search Console, Google Analytics и другими инструментами для сопоставления технических данных с реальными показателями трафика и ранжирования.

Screaming Frog SEO Spider - это десктопный инструмент для технического аудита сайтов, который использует алгоритмы краулинга и анализа данных для выявления широкого спектра проблем с SEO. Инструмент может сканировать сайты на предмет битых ссылок, ошибок в robots.txt и sitemap.xml, дублированного контента, отсутствующих мета-тегов, некорректных заголовков и многих других факторов. Screaming Frog SEO Spider также предлагает функции интеграции с Google Analytics, Google Search Console и другими инструмент��ми для углубленного анализа технических и поведенческих данных.

Внедрение этих инструментов в рабочий процесс технического SEO позволяет автоматизировать многие рутинные задачи, быстрее выявлять и устранять проблемы, и принимать более обоснованные решения по оптимизации сайта.

Нейросети в ссылочном продвижении

Ссылочное продвижение, или линкбилдинг - это один из ключевых факторов внешней оптимизации сайта, который влияет на его авторитетность, видимость в поиске и органический трафик. Несмотря на то, что алгоритмы ранжирования становятся все более сложными и учитывают сотни различных факторов, ссылки по-прежнему остаются одним из главных сигналов, которые поисковые системы используют для оценки качества и релевантности сайтов.

Однако в эпоху постоянно растущей конкуренции и ужесточения требований к качеству ссылок, традиционные методы линкбилдинга становятся все менее эффективными и более трудозатратными. Нейросети и алгоритмы машинного обучения могут автоматизировать и оптимизировать многие процессы, связанные с построением ссылочного профиля.

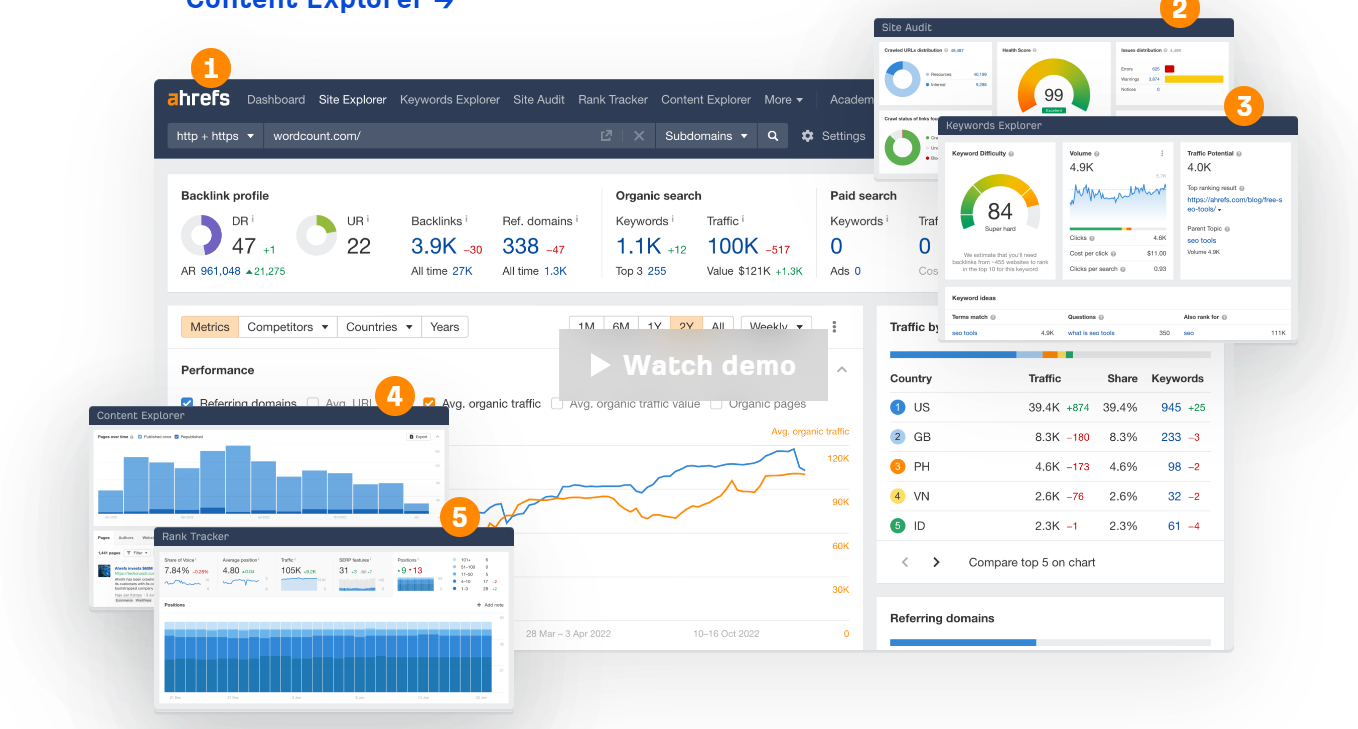

Одно из ключевых применений нейросетей в линкбилдинге - это отбор качественных доноров для размещения ссылок. Алгоритмы машинного обучения, используемые в таких инструментах, как Majestic, Ahrefs и SEMrush, позволяют анализировать огромные массивы данных о ссылочном профиле сайтов и выявлять наиболее авторитетные и релевантные ресурсы для получения ссылок.

Эти инструменты используют комбинацию различных метрик и сигналов, таких как Trust Flow, Domain Rating, Topical Trust Flow, а также алгоритмы анализа естественности ссылочного профиля и выявления потенциальных ссылочных манипуляций. Это позволяет SEO-специалистам быстро находить качественные сайты-доноры, которые не только передают вес и авторитет, но и соответствуют тематике продвигаемого ресурса, что важно для релевантности ссылок.

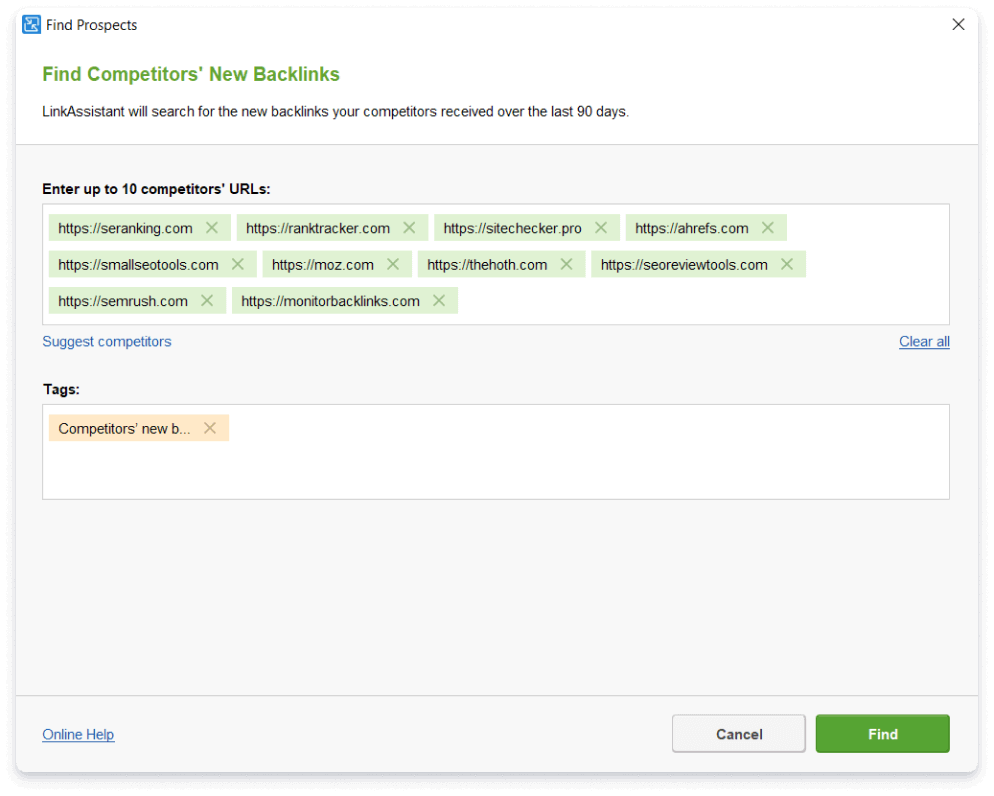

Кроме того, нейросети могут помочь в оптимизации анкор-листа и текстов ссылок. Алгоритмы обработки естественного языка, используемые в таких инструментах, как LinkAssistant и SEO SpyGlass, позволяют анализировать контекст и семантику текстов ссылок, оценивать их релевантность и естественность, а также генерировать рекомендации по оптимизации анкоров и окружающего контента.

Эти инструменты могут автоматически выявлять переоптимизированные или неестественные анкоры, предлагать варианты их диверсификации и улучшения, а также оценивать общее качество и безопасность ссылочного профиля. Это помогает SEO-специалистам избегать потенциальных рисков, связанных с некачественными или спамными ссылками, и строить более естественный и устойчивый ссылочный профиль.

Другое перспективное направление применения нейросетей в линкбилдинге - это автоматизация процессов поиска и контактов с потенциальными донорами. Алгоритмы машинного обучения могут анализировать большие объемы данных о сайтах и их владельцах, выявлять наиболее перспективные площадки для размещения ссылок, а также автоматизировать процессы аутрич-коммуникации и переговоров.

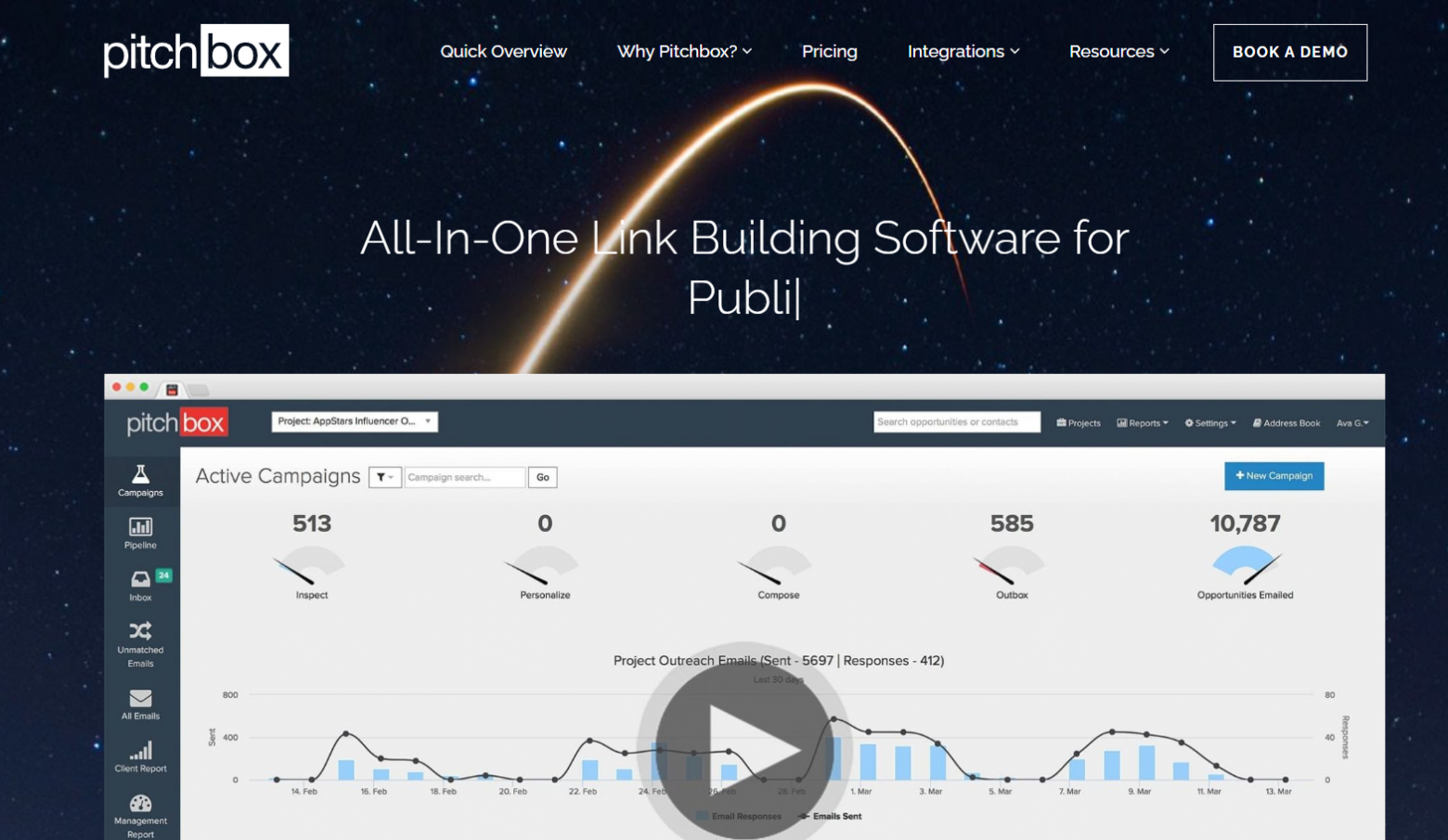

Например, такие инструменты, как Pitchbox и BuzzStream, используют алгоритмы NLP и анализа данных для автоматизации поиска релевантных сайтов, сбора контактных данных владельцев, персонализации и отправки аутрич-писем, а также отслеживания и анализа результатов кампаний. Это позволяет значительно ускорить и масштабировать процессы линкбилдинга, а также повысить их эффективность за счет персонализации коммуникации и фокусировки на наиболее перспективных площадках.

Конечно, как и в случае с другими применениями ИИ в SEO, нейросети и алгоритмы машинного обучения не могут полностью заменить человеческий фактор в линкбилдинге. Построение качественного и естественного ссылочного профиля требует не только технических навыков и инструментов, но и креативности, коммуникабельности и глубокого понимания принципов работы поисковых систем.

Анализ данных и выявление закономерностей

В современном SEO данные играют все более важную роль. По мере того, как алгоритмы поисковых систем становятся все более сложными и учитывают сотни различных факторов, традиционные методы оптимизации, основанные на догадках и интуиции, уступают место data-driven подходу, базирующемуся на анализе больших объемов данных и выявлении закономерностей.

И вот тут на сцену выходят нейросети и алгоритмы машинного обучения, которые способны анализировать гигантские массивы информации, находить неочевидные взаимосвязи и генерировать ценные инсайты для оптимизации SEO-стратегии. От исследования факторов ранжирования и прогнозирования трафика до выявления точек роста и проблемных зон - ИИ-инструменты открывают новые возможности для принятия обоснованных решений на основе данных.

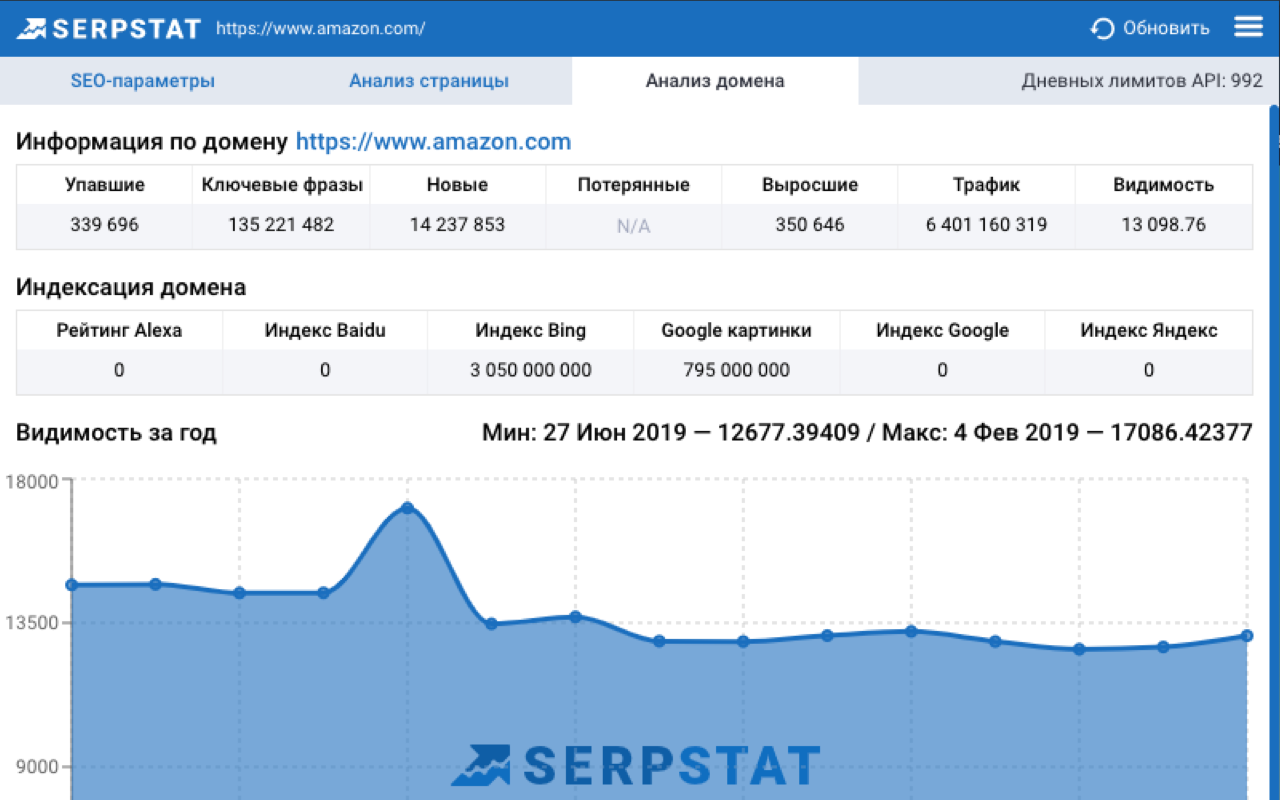

Одно из ключевых применений нейросетей в SEO-аналитике - это исследование факторов ранжирования и их влияния на позиции сайта в поисковой выдаче. Алгоритмы машинного обучения, используемые в таких инструментах, как DataForSEO и SERPstat, позволяют анализировать огромные массивы данных о поисковых запросах, позициях сайтов, ссылочных профилях и других факторах, и выявлять корреляции и закономерности.

Эти инструменты используют такие методы, как регрессионный анализ, деревья решений и нейронные сети, чтобы определить, какие факторы оказывают наибольшее влияние на ранжирование по тем или иным запросам, и как их оптимизация может повлиять на позиции сайта. Например, анализ может показать, что для определенной ниши наличие видео на странице или высокая скорость загрузки являются более важными факторами, чем количество внешних ссылок или плотность ключевых слов.

Другое важное применение нейросетей в SEO-аналитике - это прогнозирование трафика и позиций сайта на основе исторических данных и внешних факторов. Алгоритмы машинного обучения, используемые в таких инструментах, как SE Ranking и Forecast.SEMrush, позволяют строить предиктивные модели, которые учитывают сезонность, тренды, активность конкурентов и другие переменные, влияющие на видимость сайта в поиске.

Эти модели могут помочь SEO-специалистам лучше понять потенциал различных групп запросов, оценить возможный эффект от оптимизации тех или иных страниц, а также поставить реалистичные цели по трафику и конверсиям. Кроме того, прогнозирование позволяет заранее выявлять потенциальные проблемы и риски, такие как сезонные спады или усиление конкуренции, и адаптировать стратегию соответствующим образом.

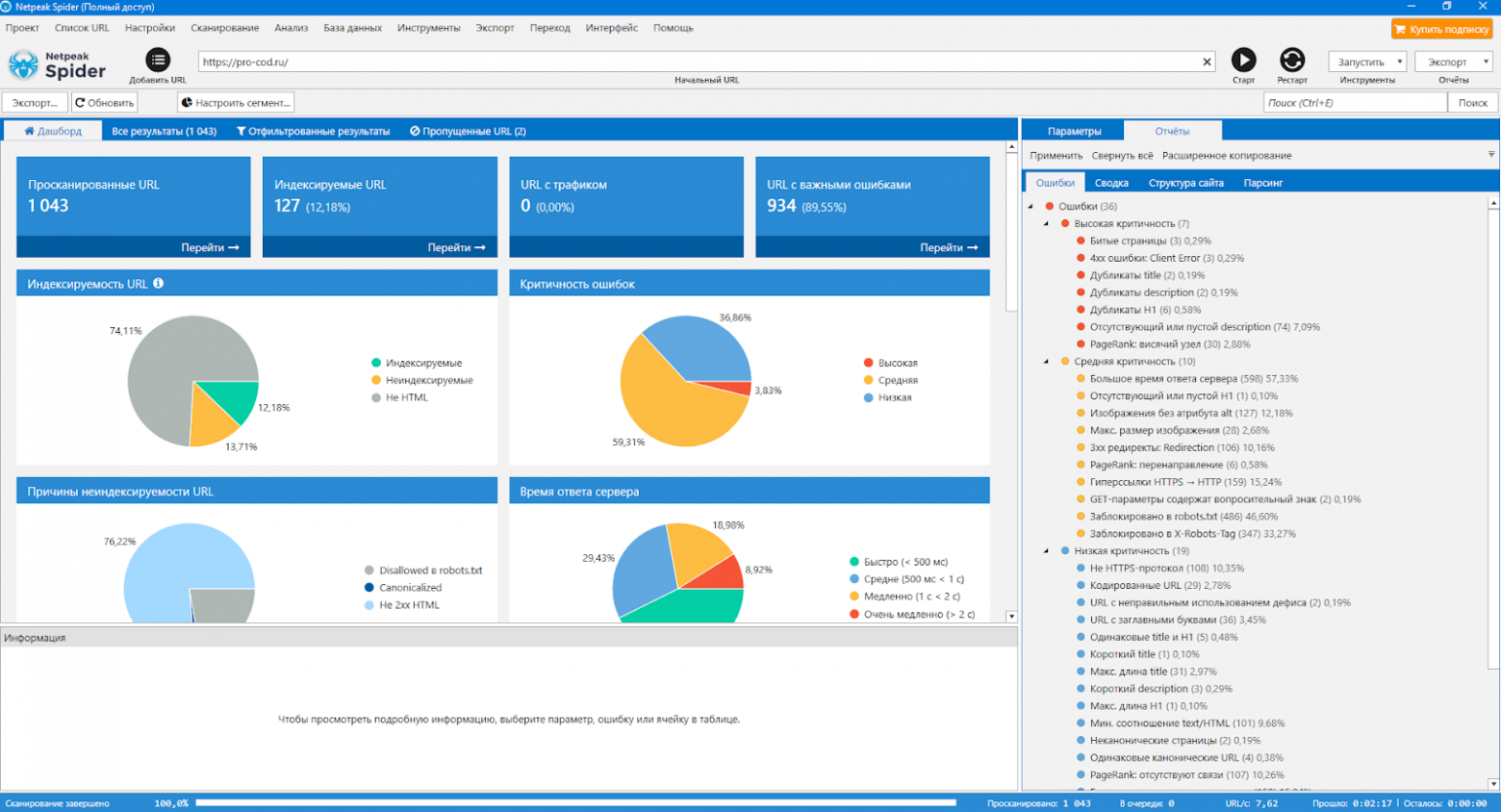

Но нейросети могут помочь не только в прогнозировании будущих результатов, но и в выявлении текущих проблем и точек роста в SEO-стратегии. Алгоритмы машинного обучения, используемые в таких инструментах, как Netpeak Spider и WebSite Auditor, позволяют анализировать большие объемы данных о структуре сайта, контенте, ссылочном профиле и других факторах, и выявлять потенциальные проблемы и возможности для оптимизации.

Эти инструменты могут автоматически находить такие проблемы, как дубликаты контента, битые ссылки, отсутствующие мета-теги, неоптимизированные изображения и другие технические ошибки, влияющие на SEO. Кроме того, они могут выявлять потенциальные точки роста, такие как недооптимизированные страницы с высоким потенциалом трафика, возможности для улучшения внутренней перелинковки или расширения семантического ядра.

Используя эти инсайты, SEO-специалисты могут быстрее находить и устранять проблемы, мешающие росту трафика и позиций, а также выявлять новые возможности для оптимизации и масштабирования своей стратегии. А главное - принимать решения на основе реальных данных, а не догадок и предположений.

Персонализация и повышение конверсий

В современном цифровом маркетинге персонализация играет все более важную роль. По мере того, как пользователи становятся все более требовательными и избалованными выбором, традиционные методы массовой коммуникации теряют свою эффективность. Чтобы привлечь внимание, завоевать доверие и побудить к действию, бренды должны обращаться к каждому посетителю сайта как к индивидуальности, с учетом его уникальных потребностей, предпочтений и поведения.

Нейросети легко справляются с адаптацией под более конкретные запросы пользователей. От динамической персонализации лэндинга и рекомендательных систем до предиктивной аналитики и оптимизации конверсионных путей - ИИ-инструменты открывают новые возможности для повышения релевантности, вовлеченности и конверсий.

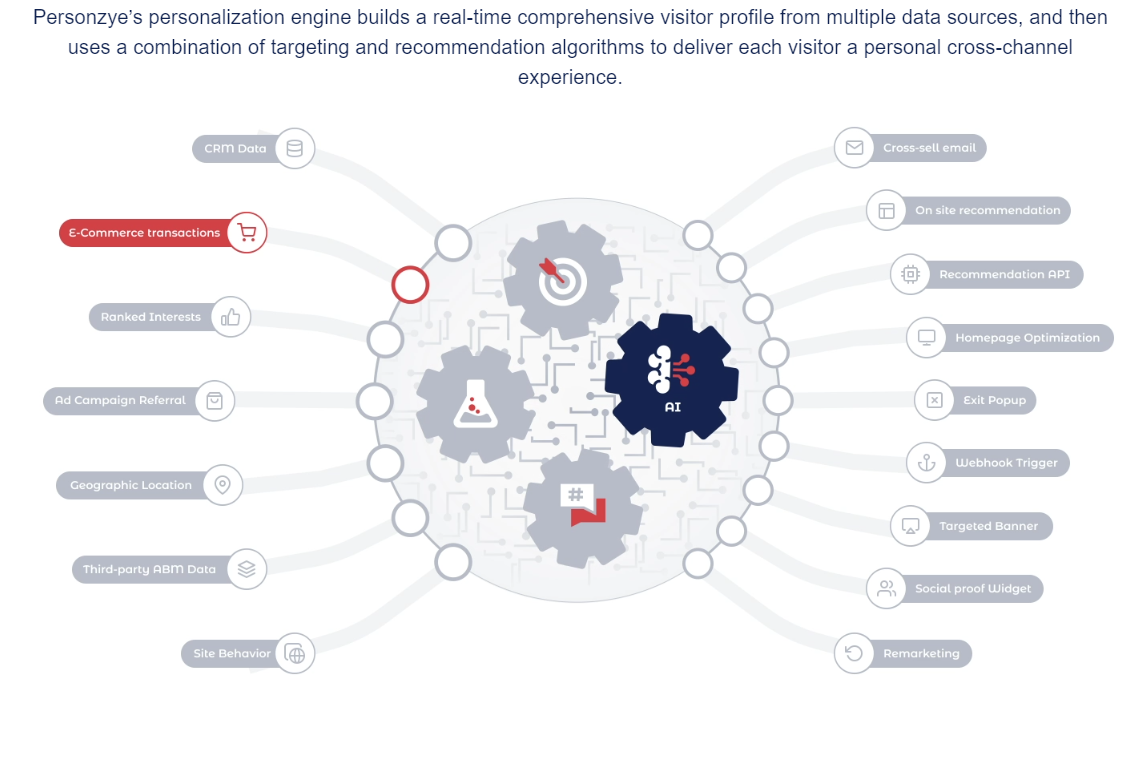

Одно из ключевых применений нейросетей в персонализации - это динамическая адаптация контента и дизайна сайта под индивидуальные характеристики и поведение пользователей. Алгоритмы машинного обучения, используемые в таких инструментах, как Personyze, позволяют в реальном времени анализировать данные о посетителях (источник трафика, поисковые запросы, историю взаимодействия с сайтом, геолокацию и т.д.) и на основе этого персонализировать различные элементы страницы.

Например, если посетитель пришел на сайт по запросу "купить iPhone", система может автоматически подстроить заголовок, изображения и блоки контента под эту конкретную потребность, выделив преимущества и акции, релевантные для данного продукта. Или если алгоритм выявил, что пользователь находится на стадии сравнения различных опций, ему может быть показана таблица сравнения характеристик или калькулятор стоимости.

Динамическая персонализация позволяет значительно повысить релевантность и убедительность коммуникации, что в свою очередь ведет к росту конверсий и лояльности. По данным исследований, персонализированные сайты генерируют на 20-30% больше конверсий, чем generic версии, а также существенно снижают показатели отказов.

Другое важное применение нейросетей в персонализации - это рекомендательные системы и умные поисковые подсказки, которые могут предугадывать потребности и намерения пользователей и предлагать им наиболее релевантные продукты, услуги или контент. Алгоритмы машинного обучения, используемые в таких системах, анализируют паттерны поведения пользователей, их предыдущие покупки, просмотренные страницы, поисковые запросы и другие данные, чтобы выявить закономерности и сгенерировать персонализированные рекомендации.

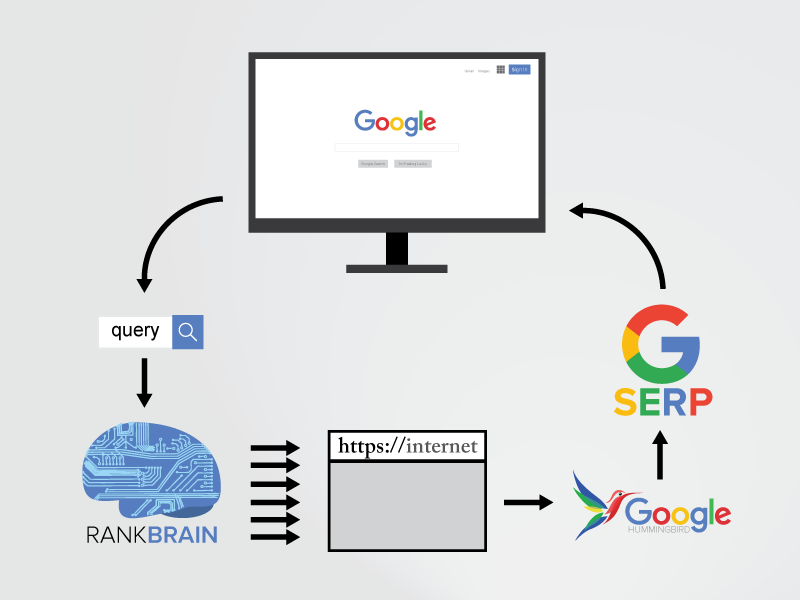

Хорошим примером такой системы является алгоритм RankBrain, который Google использует для персонализации поисковой выдачи. RankBrain анализирует историю поисковых запросов и взаимодействия пользователя с результатами, чтобы лучше понять контекст и намерение каждого запроса и предложить наиболее релевантные страницы. Это не только улучшает пользовательский опыт, но и дает SEO-специалистам возможность оптимизировать свои страницы под конкретные микромоменты и стадии пользовательского опыта.

На уровне отдельных сайтов и интернет-магазинов рекомендательные системы на базе ИИ также могут значительно повысить релевантность и конверсионность. Например, алгоритмы могут анализировать поведение пользователя на сайте и предлагать ему дополнительные товары или услуги, которые могут его заинтересовать, на основе просмотренных страниц, положенных в корзину продуктов или даже поведения похожих пользователей. Это может увеличить средний чек, повысить вовлеченность и снизить показатели отказов.

Но персонализация и повышение конверсий - это не только про адаптацию контента и рекомендации. Нейросети также могут помочь в оптимизации самих конверсионных путей и UX-дизайна на основе предиктивной аналитики и выявления паттернов поведения пользователей. Алгоритмы машинного обучения могут анализировать большие данные о взаимодействии посетителей с сайтом (клики, скроллы, время на странице, путь по воронке и т.д.), чтобы выявлять закономерности, препятствия и точки оттока.

На основе этой информации ИИ-системы могут генерировать рекомендации по оптимизации структуры сайта, расположения элементов на странице, дизайна CTA-кнопок и форм, а также выявлять потенциальные проблемы в юзабилити, которые могут снижать конверсии. Например, если алгоритм заметил, что большой процент пользователей уходит со страницы оформления заказа на шаге выбора способа доставки, это может быть сигналом для упрощения или переосмысления этого шага.

Кроме того, предиктивная аналитика на базе нейросетей может помочь в сегментации аудитории и персонализации маркетинговых кампаний. Анализируя данные о демографии, поведении и предпочтениях пользователей, алгоритмы могут выявлять закономерности и кластеризовать аудиторию на микросегменты со схожими характеристиками. Это позволяет точнее таргетировать рекламу, персонализировать email-рассылки и push-уведомления, а также адаптировать контент и офферы под каждый сегмент.

Примеры успешного применения предиктивной аналитики и персонализации можно найти у таких гигантов e-commerce, как Amazon и Netflix. Их рекомендательные системы, основанные на глубоком анализе больших данных и машинном обучении, генерируют до 35% всех продаж и просмотров соответственно. А персонализированные email-кампании Amazon показывают на 50% большую конверсию, чем массовые рассылки.

Конечно, внедрение ИИ в персонализацию и оптимизацию конверсий - это сложный и многоэтапный процесс, который требует не только технических знаний и инструментов, но и глубокого понимания своей аудитории и бизнес-целей. Важно также учитывать этические аспекты и вопросы конфиденциальности данных, чтобы персонализация не превратилась в навязчивость или вторжение в частную жизнь.

Риски, этика и перспективы применения нейросетей в SEO

Нейросети и алгоритмы машинного обучения открывают новые горизонты для SEO, это неоспоримый факт, который уже становится нашими реалиями. С одной стороны, я вижу огромный потенциал этих технологий - то, как они могут облегчить нам жизнь, автоматизировать рутину и открыть новые возможности для оптимизации. Но с другой стороны, я не могу игнорировать и потенциальные риски и этические дилеммы, которые несет с собой ИИ.

Взять хотя бы вопрос качества и достоверности контента, генерируемого нейросетями. Да, современные языковые модели способны создавать тексты, которые порой сложно отличить от написанных человеком. Но давайте будем честны - они все еще далеки от совершенства и могут допускать фактические ошибки, генерировать бессмысленные или противоречивые утверждения. И если SEO-специалисты будут бездумно полагаться на ИИ и забывать про редактуру и контроль качества, есть риск заполнить интернет некачественным, дезинформирующим контентом. А это, в свою очередь, может подорвать доверие пользователей к поисковым системам и сайтам.

А как насчет конфиденциальности и этичного использования данных? Ведь чтобы персонализировать контент и улучшать пользовательский опыт, нейросетям нужен огромный массив личной информации о каждом из нас. Но готовы ли мы пожертвовать приватностью ради более релевантных рекомендаций? И как мы можем быть уверены, что эти данные не будут использованы во вред? Это серьезные вопросы, на которые пока нет однозначных ответов.

Впрочем, может, я слишком драматизирую. В конце концов, несмотря на все успехи ИИ, он все еще далек от человеческого уровня креативности, эмпатии и этического суждения. И я хочу верить, что если мы научимся использовать сильные стороны нейросетей, но при этом не забывать про наши уникальные человеческие качества, мы сможем достичь невероятных результатов.

Будущее SEO в эпоху нейросетей обещает быть захватывающим и сложным. Но я верю, что при ответственном и креативном подходе, синергия человеческого интеллекта и ИИ может привести к невероятным прорывам и успехам. Так что давайте принимать эту возможность и формировать будущее SEO вместе - рука об руку с нейросетями, но с человеком у руля.

Спасибо за прочтение! Надеюсь, этот материал был для вас полезным:)