Рисуем на тайлах электронной карты в MSSQL

37 мин

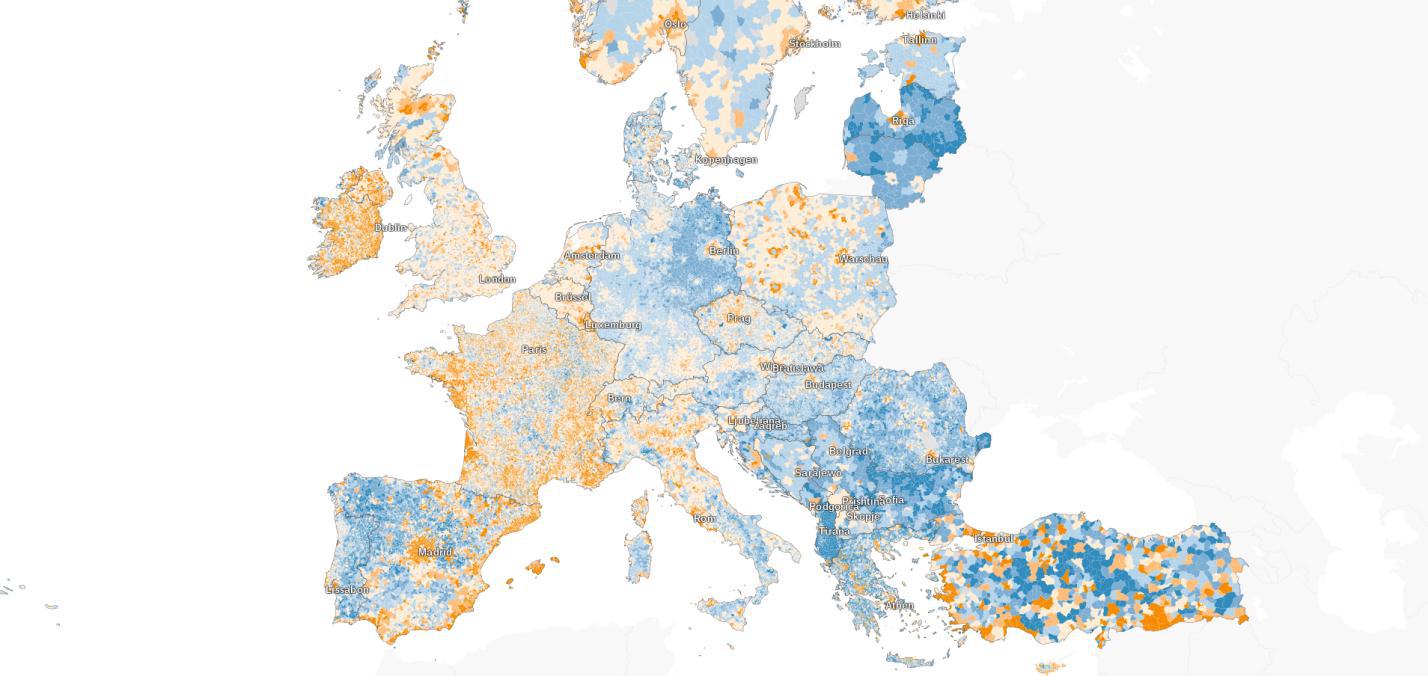

Хочу рассказать читателям хабра-сообщества как используя CLR библиотеку Microsoft.SqlServer.Types можно формировать тайлы для электронной карты. В статье пойдёт речь о генерации списка картографических тайлов для их дальнейшего рендеринга. Будет описан алгоритм генерации тайлов по геометрии объектов, хранящейся в базе данных MS SQL 2008. Весь процесс рендеринга шаг за шагом будет рассмотрен на примере в конце статьи.

Проблема

Исходные данные

Решение

Хранилище тайлов

Этапы подготовки тайлов

Используемые функции

Пример с ломаной линией

Проверка пересечения

Таблицы для хранения образов тайлов

Размещение иконки на тайле

Объединение тайлов

Отрисовка геометрии на тайле

Заключение

Содержание

Проблема

Исходные данные

Решение

Хранилище тайлов

Этапы подготовки тайлов

Используемые функции

Пример с ломаной линией

Проверка пересечения

Таблицы для хранения образов тайлов

Размещение иконки на тайле

Объединение тайлов

Отрисовка геометрии на тайле

Заключение