Как расширять Kubernetes

Материал подготовлен на основе выступления Николая на осенней конференции DevOops 2017. Под катом — видео и текстовая расшифровка доклада.

ПО для работы с контейнерными приложениями

Полгода назад мы закончили миграцию всех наших stateless сервисов в kubernetes. На первый взгляд задача достаточно простая: нужно развернуть кластер, написать спецификации приложений и вперед. Из-за одержимости в вопросе обеспечения стабильности в работе нашего сервиса пришлось сразу начать разбираться с тем, как работает k8s и тестировать различные сценарии отказов. Больше всего вопросов у меня возникало ко всему, что касается сети. Один из таких "скользких" моментов — работа сервисов (Services) в kubernetes.

Полгода назад мы закончили миграцию всех наших stateless сервисов в kubernetes. На первый взгляд задача достаточно простая: нужно развернуть кластер, написать спецификации приложений и вперед. Из-за одержимости в вопросе обеспечения стабильности в работе нашего сервиса пришлось сразу начать разбираться с тем, как работает k8s и тестировать различные сценарии отказов. Больше всего вопросов у меня возникало ко всему, что касается сети. Один из таких "скользких" моментов — работа сервисов (Services) в kubernetes.

В документации нам говорят:

Но на практике все несколько сложнее. Давайте посмотрим, как оно работает на самом деле.

Вам наверняка приходилось восстанавливать кластер Kubernetes после сбоя. Была ли у вас толковая стратегия резервного копирования, не требующая пахать несколько дней? Да, можно делать резервные копии в etcd-кластер, но что если отвалилась только часть кластера или вы используете постоянные тома, вроде AWS EBS?

В таких случаях проще всего использовать утилиту Heptio Ark.

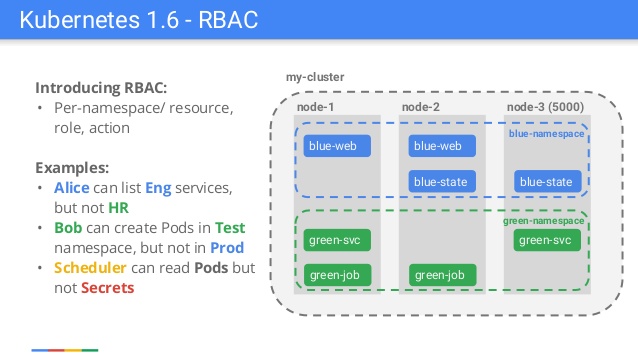

helm init + helm install больше не работал. Внезапно нам потребовалось добавлять «странные» элементы вроде ServiceAccounts или RoleBindings ещё до того, как разворачивать чарт с WordPress или Redis (подробнее об этом см. в инструкции).

Кроме того, у нас уже полным ходом идет перевод книги "Mastering Kubernetes" (2-е издание) и готовится к выходу в сентябре авторская книга о Docker, о которой обязательно будет отдельный пост.

Кроме того, у нас уже полным ходом идет перевод книги "Mastering Kubernetes" (2-е издание) и готовится к выходу в сентябре авторская книга о Docker, о которой обязательно будет отдельный пост.

В этой статье я расскажу как можно запустить kubernetes master внутри LXC-контейнера.

Этод метод работает вполне неплохо с Proxmox и может быть рассмотрен как альтернатива классическому развертыванию kubernetes с несколькими мастерами.

Начинается Слёрм. Трансляция стартовала.

9:15 Автоматизация развертывания инфраструктуры. Ansible

Основы, принципы работы, ускорение ансибля

10:00 Docker, основы практической работы

Docker, его устройство, Dockerfile, docker-compose

11:30 Знакомство с Kubernetes, основные компоненты

Введение в технологию k8s. Описание, применение, концепции

Pod, ReplicaSet, Deployment, Service, Ingress, PV, PVC, ConfigMap, Secret

13:00 Пауза

16:00 Знакомство с Kubernetes: продолжение

Устройство кластера, основные компоненты, отказоустойчивость, сеть k8s — 1 час

17:30 Kubespray, тюнинг и настройка кластера Kubernetes

Особенности настройки серверов Kubernetes

Ansible, установка под Kubespray

Разворачивание кластера с Kubespray

Мероприятие живое. Расписание может плавать.