В недавней статье Роман Янковский высказал интересные мысли о влиянии ИИ на юриспруденцию. Статья Романа под названием «Что не так с ИИ-юристами» имела как сторонников, так и несогласных.

Я решил написать ответ на статью, где постараюсь развить некоторые из поднятых Романом вопросов и пригласить юридическое и IT сообщества к обсуждению прикладной пользы LLM.

Дискуссии об ИИ часто сопровождаются антропоморфизацией, приписыванием ему человеческих качеств – от божественных (или чудесных, что обязано сделать жизнь человека лучше и счастливее) до демонических (он нас поработит). Это мешает объективной оценке его возможностей и рисков.

Вместо того, чтобы анализировать каждый конкретный тезис исходной статьи о возможностях и опасностях ИИ, предлагаю сфокусироваться на самом определении искусственного интеллекта. Существует стойкое ощущение, что определение ИИ, на которых базируются многие рассуждения – часто недостаточно верны, и обсуждение вытекающих из него тезисов может оказаться неконструктивным.

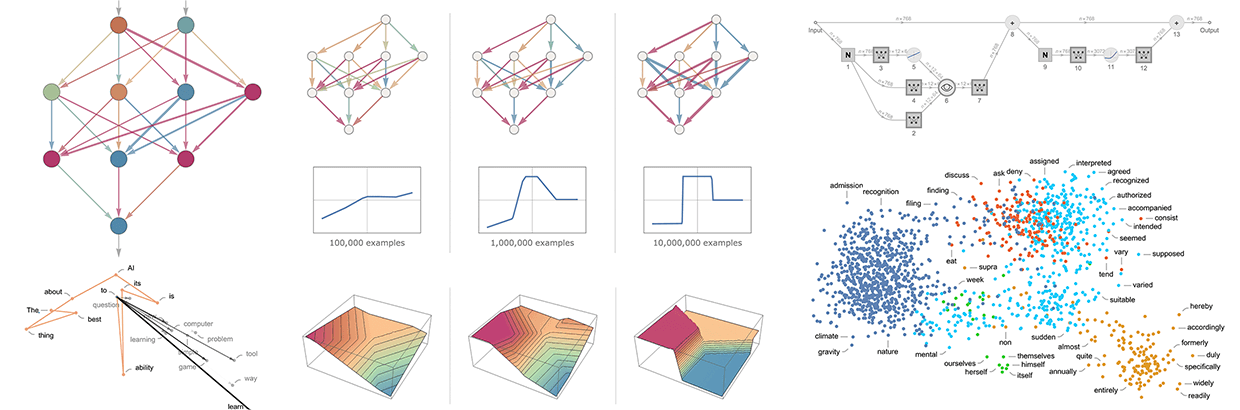

В контексте данной статьи под ИИ, а точнее, под большими языковыми моделями (LLM), мы будем понимать системы, обученные на огромном корпусе документов. Они содержат в себе знание о вероятности того следования слов друг за другом, и на основе этого могут подставлять их наиболее вероятном порядке. Это упрощенное объяснение, внутри LLM более сложная математика, но на выходе примерно так это и работает.

Следовательно, нужно обсуждать, как использовать и кого заменит именно такой инструмент в юридической сфере?