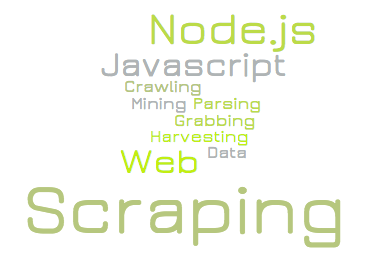

Это первая статья в цикле про создание и использование скриптов для веб-скрейпинга при помощи Node.js.

Это первая статья в цикле про создание и использование скриптов для веб-скрейпинга при помощи Node.js.

- Web scraping при помощи Node.js

- Web scraping на Node.js и проблемные сайты

- Web scraping на Node.js и защита от ботов

- Web scraping обновляющихся данных при помощи Node.js

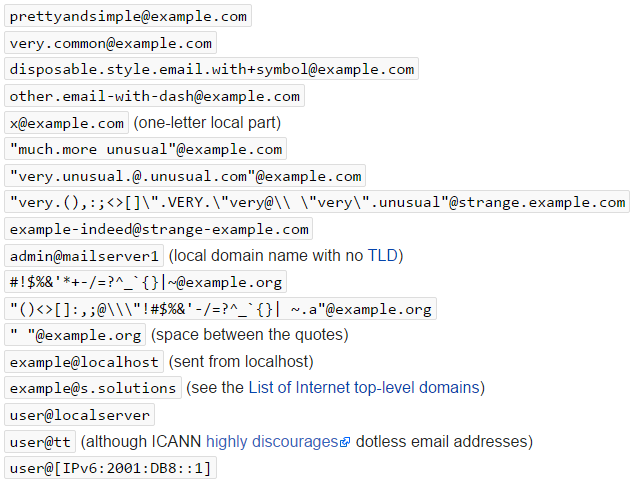

Тема веб-скрейпинга вызывает всё больше интереса как минимум потому, что это неисчерпаемый источник небольших, но удобных и интересных заказов для фрилансеров. Естественно, что всё больше людей пытаются выяснить, что это такое. Однако, довольно трудно понять, что такое веб-скрейпинг по абстрактным примерам из документации к очередной библиотеке. Гораздо проще разобраться в этой теме наблюдая за решением реальной задачи шаг за шагом.

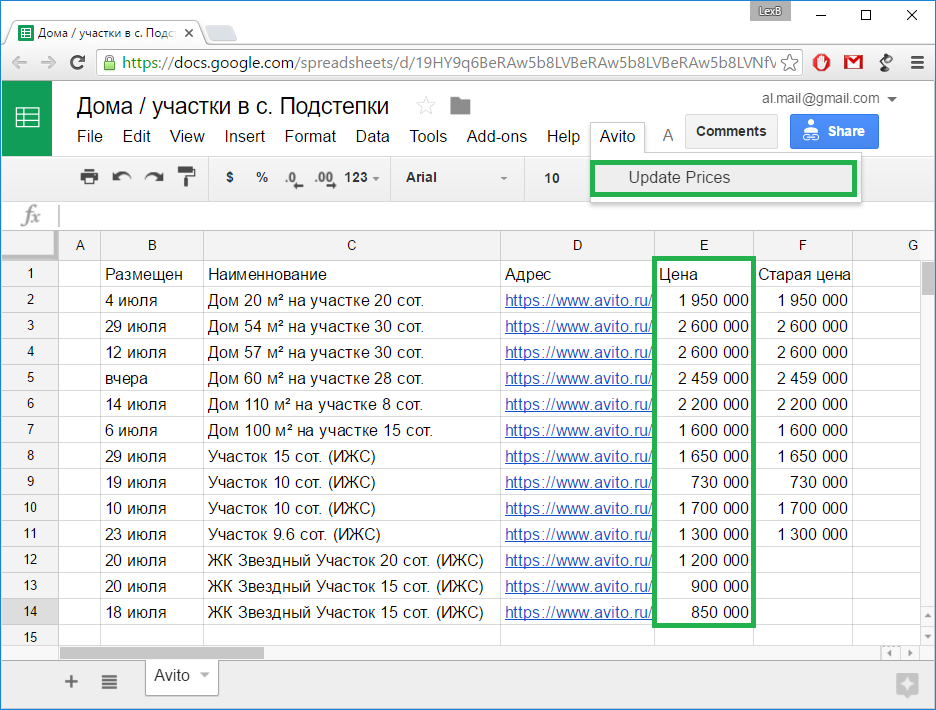

Обычно, задача для веб-скрейпинга выглядит так: есть данные, доступные только на веб-страницах, и их надо оттуда вытащить и сохранить в неком удобоваримом формате. Конечный формат не важен, так как конвертеры никто не отменял. По большей части речь о том, чтобы открыть браузер, пройтись мышкой по ссылкам и скопипейстить со страниц нужные данные. Ну, или сделать то же самое скриптом.

Цель этой статьи – показать весь процесс создания и использования такого скрипта от постановки задачи и до получения конечного результата. В качестве примера я рассмотрю реальную задачу вроде тех, какие часто можно найти, например, на биржах фриланса, ну, а в качестве инструмента для веб-скрейпинга будем использовать Node.js.

Это первая статья в цикле про создание и использование скриптов для веб-скрейпинга при помощи Node.js.

Это первая статья в цикле про создание и использование скриптов для веб-скрейпинга при помощи Node.js.

Это уже четвёртая статья в цикле про веб-скрейпинг при помощи Node.js:

Это уже четвёртая статья в цикле про веб-скрейпинг при помощи Node.js: