Comments 15

В разработке прорывных технологий неважно насколько быстро работает первая версия прототипа (как впрочем и его стоимость/размер/объем).

Когда создавались первые диски объемом несколько мегабайт, они и мечтать не могли, что 50 лет спустя у нас будут диски объемом в несколько терабайт, размером 1 см2 (SD диски) — 10 см2 (NVMe диски), имеющие скорость записи/чтения 3500 МБ/с

Скорость синтеза, кстати, огромна и хорошо запараллеливается.

Эти машины как раз и могут решить классическую проблему множественного доступа "by design"

Эм.

"Репликационная вилка движется со скоростью порядка 100 000 пар нуклеотидов в минуту у прокариот и 500—5000 — у эукариот".

Обычно запускают чтение подряд или, если записано несколько раз подряд — одновременно несколько фрагментов.

Физику не изменить: читать и писать можно только в 1 поток что кремнием, что магнитом, что светом, что молекулой.

Вопрос только в том, на сколько компактно можно хранить данные.

ЗЫ. В суперспирализированнлм состоянии ДНК действительно очень компактно, но для чтения ее разворачивают в месте начала чтения и идут далее по молекуле (напоминает сломанную молнию, которая движется, но не открывает при этом шва).

1. Мы создаем что-то новое

2. Многим людям кажется что это будет невозможно существенно улучшить в ближайшие сотни лет

3. В течении нескольких лет исследователи находят несколько способов улучшить изобретение в десятки — миллионы раз, применяя открытия из других научных областей

К примеру:

— Устройства хранения информации за 50 лет были улучшены в миллионы раз (килобайты => терабайты)

— Алгоритмы распознавания изображений за несколько десятков лет улучшились с «не существуют» до «лучше, чем люди». Многие даже и не мечтали, что ИИ будет лучше ученых в распознавания рака и управлении машинами.

— Микро чипы за несколько десятков лет также были усовершенствованы в тысячи раз (1 ядро@20mhz@микрометры => 64 ядер@3,000mhz@7нм)

— Ракеты только за последние 16 лет были улучшены в десятки 1-й компанией (SpaceX), мы перешли от 1 запуска до десятков запусков (Falcon), хотя об этом даже и не мечтали, многие думали что это невыполнимая задача (даже Nasa не осмелились начать решать эту проблему, до сих пор летают на одноразовых ракетах)

Надо просто обесценивать всё. Художник начал рисовать — самое время подойти и сказать «ну и нафига снова это рисовать, уже же всё нарисовали, и получше чем это». Писатель начал писать — можно заметить, что есть куда более известные и талантливые произведения.

Искусство обесценивания, одним словом.

Интересно другое: мы ни как не можем добиться модели памяти и формирования нейронных связей, но, как топором, пытаемся программировать на ДНК.

Вопрос, конечно, что раньше случится… Но то, что это не эффективный метод, очевидно уже сей час (но самый доступный).

Теперь представьте, что вы реализовали на них алгоритм, который работает с бинарными данными и некоторые биты в процессе вычислений произвольно инвертируются. Алгоритмов, которые устойчивы к таким ошибкам крайне мало.

Тем не менее, эти проблемы решаемы и я как раз недавно читал ряд интересных статей от этих авторов.

Еще интересно попробовать синтез белков с люминисценцией. Тогда можно лазером читать.

Если запрограммировать синтез белка, части которого имеют разную люминисценцию, результат читать будет на порядок проще.

А вот как программировать процесс вычислений тут вопрос.

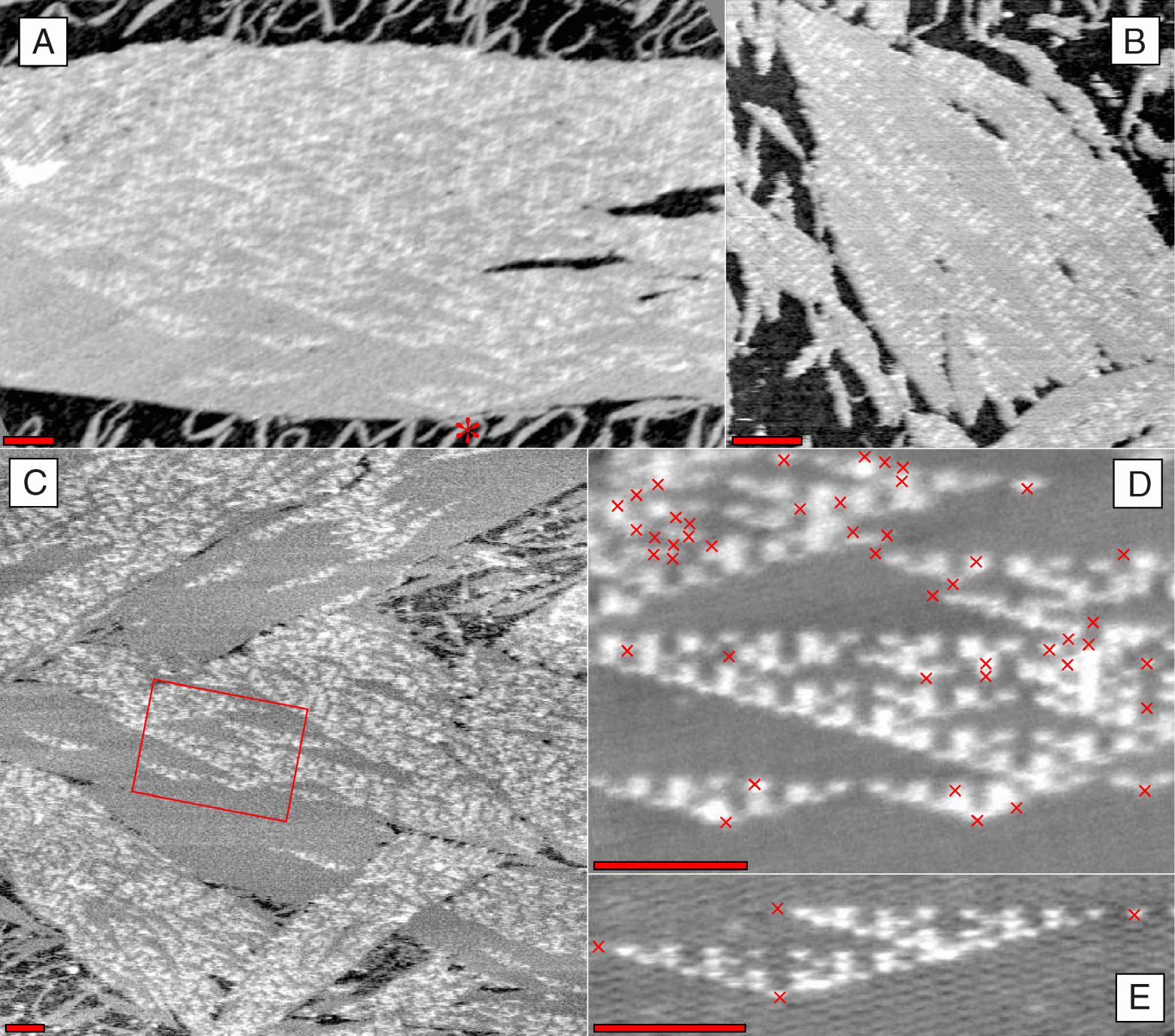

Первый программируемый компьютер на ДНК