Почти 2 эксафлопса на пике, 1 600 000 000 000 000 000 операций в секунду, 21 МВт потребления энергии и эмуляция области человеческого мозга в течение 1 секунды.

Современный суперкомпьютер — это огромная машина, выполняющая триллионы, а иногда и квадриллионы (число с 15 нулями) вычислительных операций.

Хотя в какой-то степени каждый суперкомпьютер — не более чем последовательность кластеров, состоящих из узлов материнских плат с процессорами и ядрами — все эта «кремниевая орава» параллельно обрабатывает огромные массивы данных, предназначенные для решения узкоспециализированных задач.

В то время как обычный компьютер имеет один ЦП, число ядер которого не превышает и 32, среднестатистический суперкомпьютер располагает на своем «борту» тысячами, а то и миллионами ядер.

Одни из самых мощных вычислительных машин на Земле используются во всем: от исследования лучших методов лечения вирусов до раскрытия происхождения Вселенной.

Фундаментальный показатель — скорость суперкомпьютера — определяется количеством арифметических операций с плавающей запятой, которые устройство может выполнить за секунду. Его обычно называют «FLOP».

Однако достижения в области вычислительной мощности внесли свою лепту — пресловутый «флоп» теперь имеет приставку, означающую разряд числа операций: терафлопсы (триллионы) и петафлопсы (квадриллионы). Просто чтобы понимать — iPhone 11 примерно в шесть раз быстрее самого быстрого суперкомпьютера в мире на момент 1993 года.

Кстати, в том же году был запущен проект TOP500 — он собирает статистику и обновляет список самых мощных суперкомпьютеров в мире.

В качестве теста оценки производительности используется бенчмарк Linpack — это означает, что системы ранжируются только по их способности решать набор линейных уравнений.

С другой стороны, TOP500 не стоит рассматривать как универсальный рейтинг — проект отражает лишь способность системы решать линейные уравнения и ничего не говорит о ее производительности при использовании конкретных приложений.

Наверное, это одна из причин, почему рейтинг довольно часто критикуют, но по заверениям создателей проекта бенчмарк Linpack вкупе с определенными арифметическими операциями, пожалуй, единственный существующий способ наиболее адекватно отранжировать суперкомпьютеры.

В этой статье речь пойдет о самых первых строчках списка — лучших вычислительных машинах мира. Что это за системы, зачем они нужны и чем занимаются?

1. Frontier

Hewlett Packard Enterprise Frontier, или как его еще называют OLCF-5 — первый в мире суперкомпьютер с эксафлопсным показателем мощности. Появившись на свет в 2021 году, он до сих пор держит свое непоколебимое лидерство.

Его нескромные 1,102 эксафлопс (1,102 квинтиллиона операций в секунду) почти в 3 раза превышают «дышащего» ему в спину конкурента со 2-й строчки списка, мощность которого не превышает и 0,442 эксафлопс.

Вообще, уже давно ходят слухи, что в Китае существует три непубличные эксафлопсные системы OceanLight, Tianhe-3, The Sugon system. Однако до сих пор эта информация официально никак не подтверждалась.

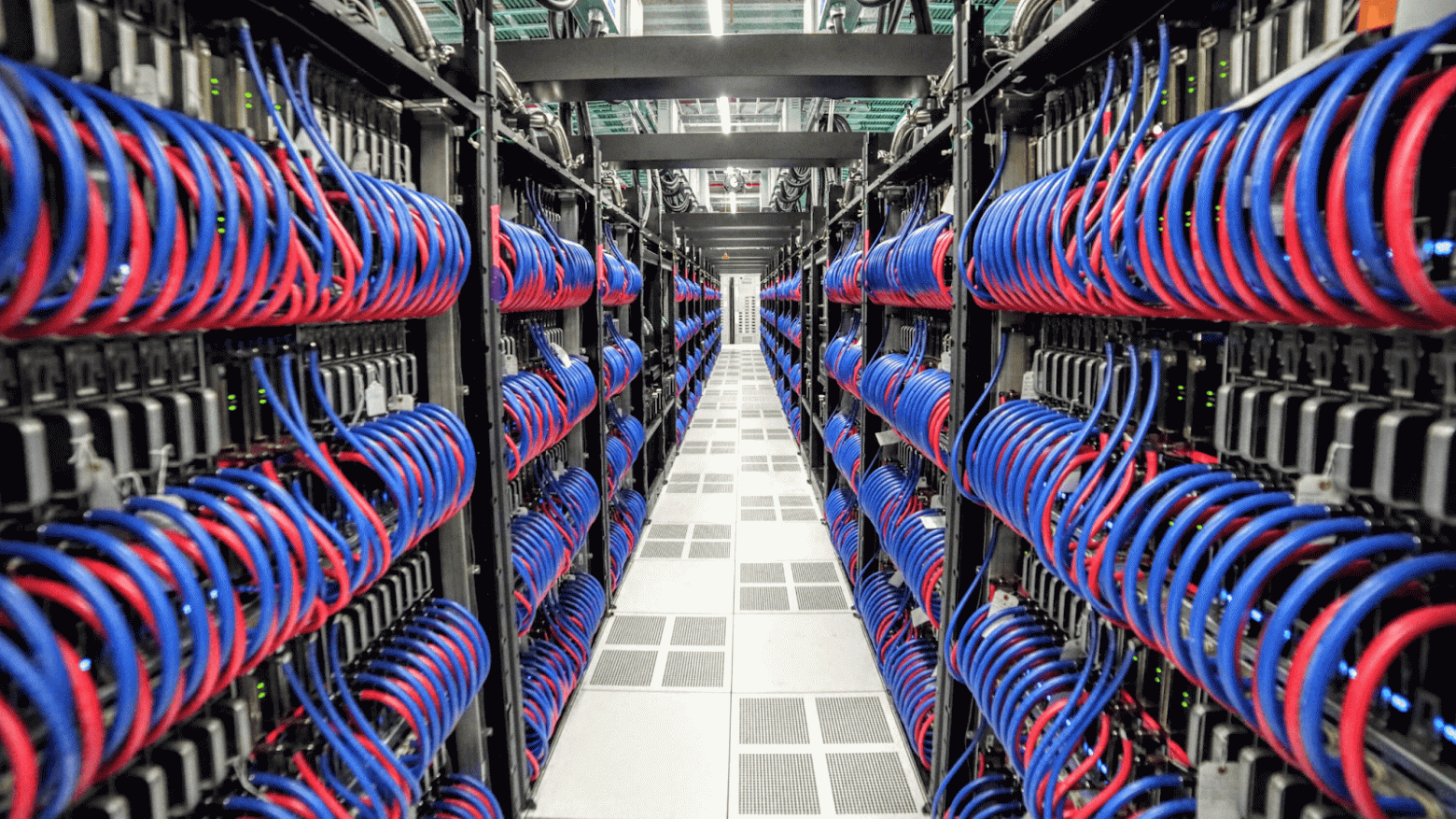

Зайдя посреди солнечного дня в огромный дата-центр вычислительного центра Oak Ridge Leadership Computing Facility, расположенного в городе Ок-Ридж штата Теннесси, вы бы оказались посреди 74-х 19-дюймовых стоек. В каждой размещено по 64 блейд-сервера, в сумме образующих 128 вычислительных узлов.

Каждый узел состоит из одного ЦП, 4 графических процессоров и 5 терабайт флэш-памяти. При этом к каждому графическому процессору припаяно 128 ГБ оперативной памяти.

Блейд-серверы соединены между собой 64-портовым коммутатором HPE Slingshot, обеспечивающим пропускную способность в 12,8 терабит/с. При этом соединительных кабелей (медных или оптических) настолько много, что их суммарная длина составляет 145 км.

Кстати, Frontier имеет жидкостное охлаждение, что обеспечивает в 5 раз большую тепловую емкость (и эффективность) по сравнению с архитектурами с воздушным охлаждением, которые, например, использует Google в своих дата-центрах.

С помощью огромных насосов, мощностью 350 лошадиных сил, через систему прокачивается около 6000 галлонов воды в минуту. Вода предварительно не охлаждается, что делает систему охлаждения довольно энергоэффективной.

Система охлаждения динамическая — она избирательно подстраивается под рабочие нагрузки. Даже не отдельных компонентах плат есть датчики, которые отслеживают температуру и регулируют интенсивность подачи воды.

На «борту» размещены центральные и графические процессоры AMD — около 9 472 64-ядерных процессоров Epyc 7453 «Trento» с тактовой частотой 2 ГГц и 37 888 графических процессоров Radeon Instinct MI250X. В сумме получается 606 208 процессорных ядер и 8 335 360 графических.

Собственная флэш-система хранения данных имеет скорость чтения 75 ТБ/с и скорость записи 35 ТБ/с. В качестве файловой системы используется параллельно распределенной тип Lustre емкостью 700 петабайт. Энергопотребление всего этого «добра» где-то около 21 МВт.

После завершения развертывания всей системы вначале 2022 года стоимость машины составила 600 миллионов долларов. Сразу после выпуска суперкомпьютер возглавил лидерство в списке Green500 (тот же рейтинг, но другая номинация) самых энергоэффективных суперкомпьютеров с производительностью 62,68 гигафлопс/ватт.

В конце 2022 года компьютер все еще находился на стадии тестирования — система страдала от регулярных сбоев при выполнении очень ресурсоемких задач, причем некоторые проблемы были связаны с графическими ускорителями AMD, несущими основную нагрузку.

Поэтому передать Frontier в работу ученым планируют только в 2023-2024 годах. Исследовательские группы, которые получат доступ, еще толком не известны — Ок-Риджская лаборатория рассказывает лишь о нескольких.

Например, проект «Моделирование всего устройства магнитно ограниченной термоядерной плазмы» (WDMApp) планирует использовать быстроту Frontier для симуляции поведения горячей плазмы в токамаках — особых ядерных реакторах, обещающих в будущем получение безопасной энергии из термоядерного синтеза.

Кстати, на сегодня моделирования полностью всей структуры плазмы токамака (ядра и периферии) еще никем не предпринималось — такая задача требует эксафлопсных вычислений с высокой точностью.

Поэтому основная задача WDMApp — объединение различных вычислительных методологий и кодов для описания турбулентных взаимодействий в центре плазмы (ядре) по сравнению с взаимодействиями, возникающими на границе плазмы (периферии).

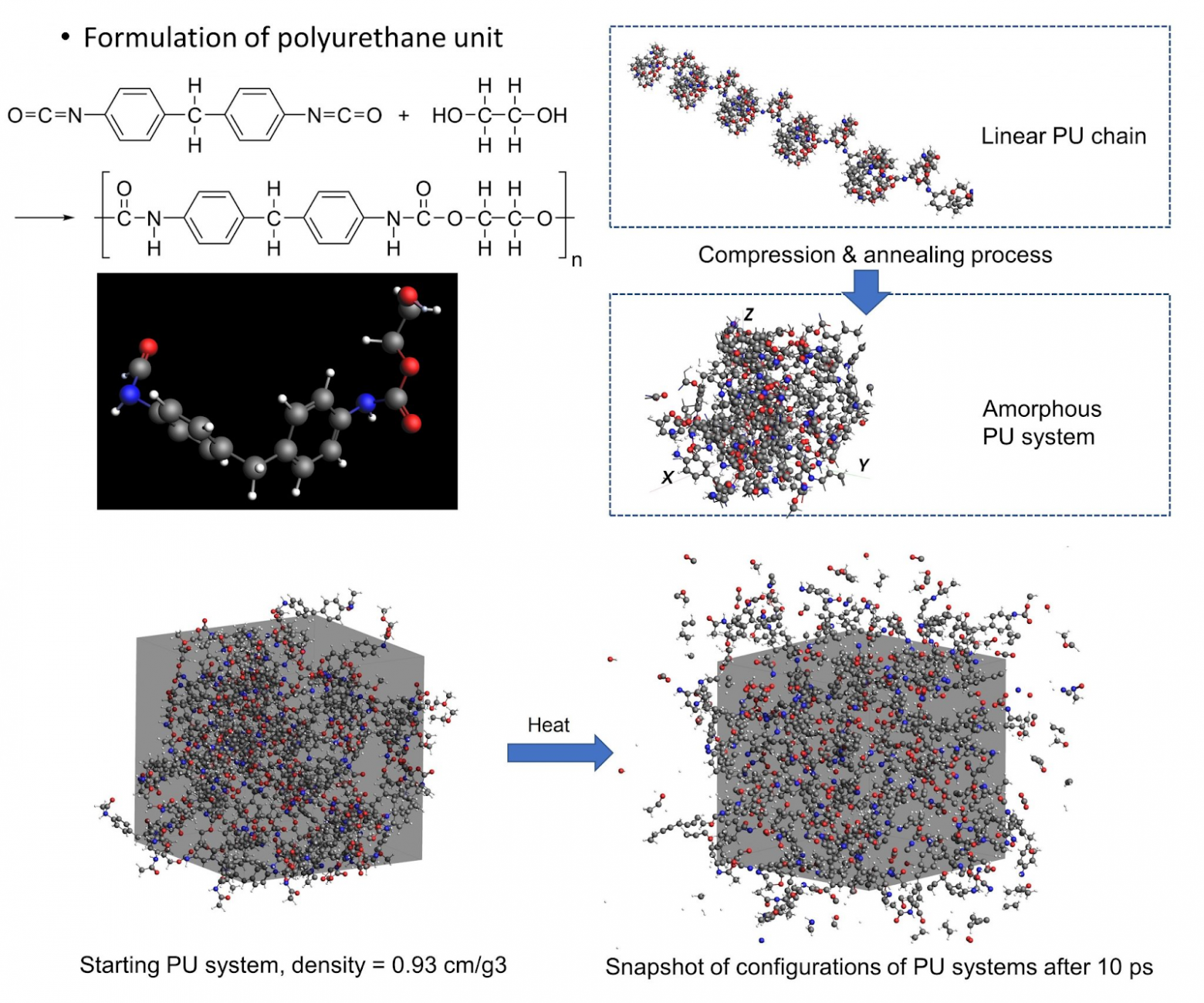

Другой проект, «Эксамасштабная атомистика для точности, длины и времени» (EXAALT), фокусируется на моделировании различных материалов для ядерной энергетики на уровне отдельных атомов — в том числе и материалов токамаков.

Благодаря Frontier исследовательская группа сможет эмулировать движение отдельных атомов, отслеживая состояния виртуальных материалов с высокой временной точностью.

По сути, если вы придумали некий набор характеристик, которые хотели бы получить от материала — легкий, прочный и при этом дешевый, — то на его физическое создание и тестирование уйдет очень много времени. Множество параметров в процессе разработки потребуют определенных изменений, делая процесс создания довольно медленным и дорогим.

А вот виртуальное проектирование материала, его расчет, эмуляция и тестирование могут значительно сократить цикл разработки.

Министерство энергетики США тоже очень хочет заполучить Frontier в свои ряды организация сосредоточилась на паре десятков первостепенных проблем энергетической области и планирует решить с помощью суперкомпьютера.

Задач действительно много — моделирование ядерных реакторов, ветряных электростанций, электросетей, сжигания ископаемого топлива, ДВС наземных турбин. Министерство также хочет смоделировать большую часть межсетевых соединений в стране, чтобы оптимизировать работу линий электропередач.

2. Fugaku

Переместимся в Японию, в крупный научно-исследовательский институт Riken города Вако.

Здесь, начиная с 1917 года, проводятся исследования в области физики, химии, биологии, генетики, медицины, инженерии и высокопроизводительных вычислений.

Институт почти полностью финансируется правительством Японии — годовой бюджет около 90 миллиардов йен (800 миллионов долларов).

Именно тут расположен второй по мощности суперкомпьютер из списка TOP500 — Fugaku, названный в честь альтернативного названия горы Фудзияма.

Разработка системы совместно с IT-гигантом Fujitsu (Фудзицу) началась в 2014 году и была завершена спустя 7 лет — в начале 2021 года. В тот же день Fugaku стал доступен для совместного использования широкому кругу исследователей из академических и промышленных областей.

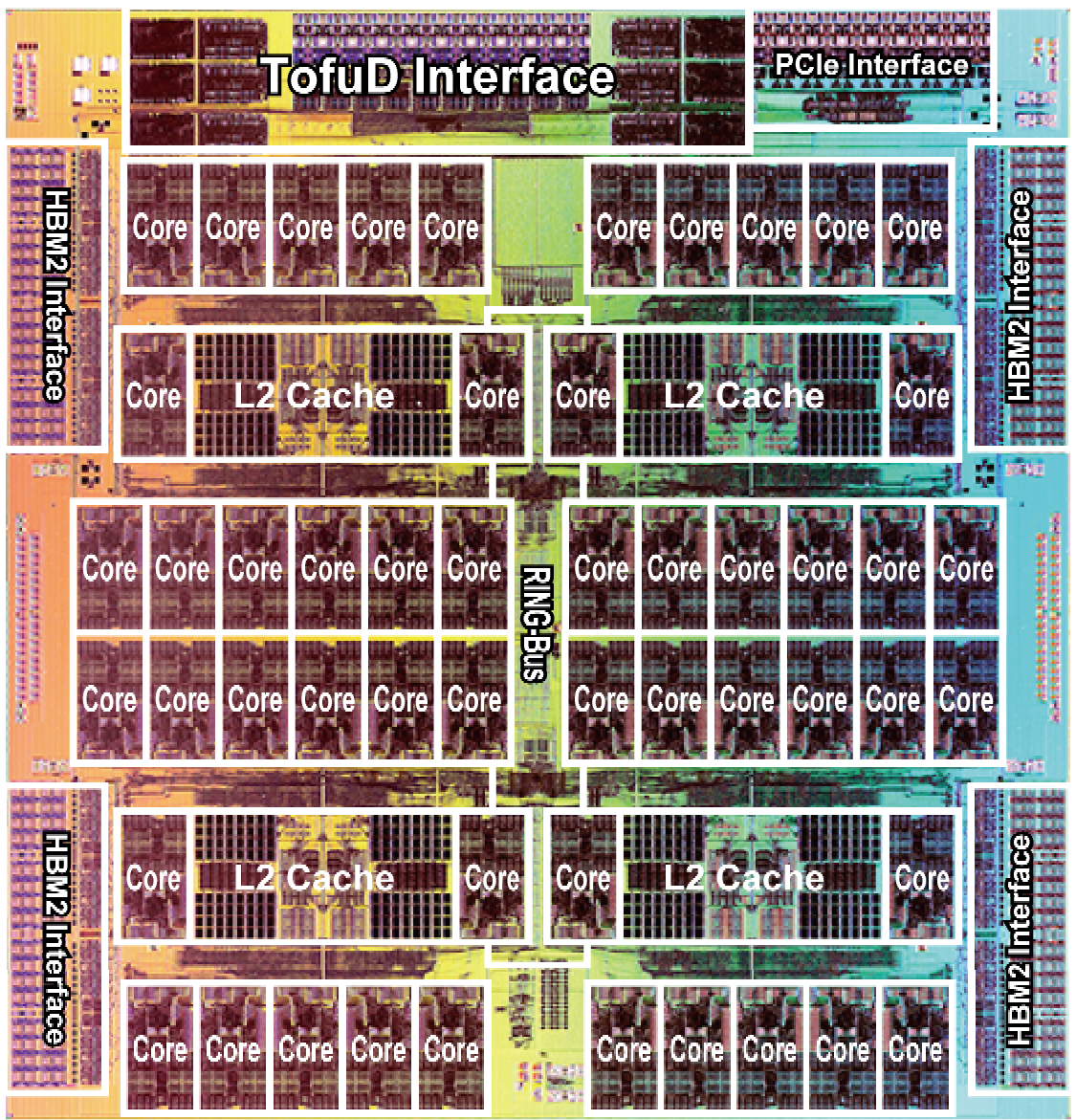

Как уже было сказано выше, мощность Fugaku около 442 петафлопс, хотя энергопотребление намного больше Frontier — почти 30 МВт. Вся система построена на базе PRIMEHPC FX1000 — своего рода «нода», представляющая собой закрытую стойку с блейд-серверами внутри.

Внутри — центральный процессор Fujitsu A64FX на архитектуре ARM, объединяющий 52 процессорных ядра и несколько вспомогательных. Во всем Фугаку таких ядер порядка 150 000 штук. Во всяком случае, по данным TOP500, суммарное количество ядер равняется 7 630 848 единицам.

Все это «дело» работает на легковесной многоядерной операционной системе IHK/McKernel — это своего рода «микс» работающего ядра Linux и дополнительного облегченного ядра McKernel, который называют «интерфейсом гетерогенных ядер» (Interface for Heterogeneous Kernels, IHK).

Высокопроизводительные симуляции выполняются на McKernel, а Linux предназначен для всех других POSIX-совместимых сервисов и приложений.

В 2011 году у восточного побережья острова Хонсю в Японии произошло землетрясение магнитудой 9,0 баллов, вызвавшее разрушительное цунами на побережье Тохоку — тогда погибло 16 000 человек, тысячи получили ранения. Ущерб в сотни миллиардов долларов сделал это стихийное бедствие самым дорогим в истории человечества.

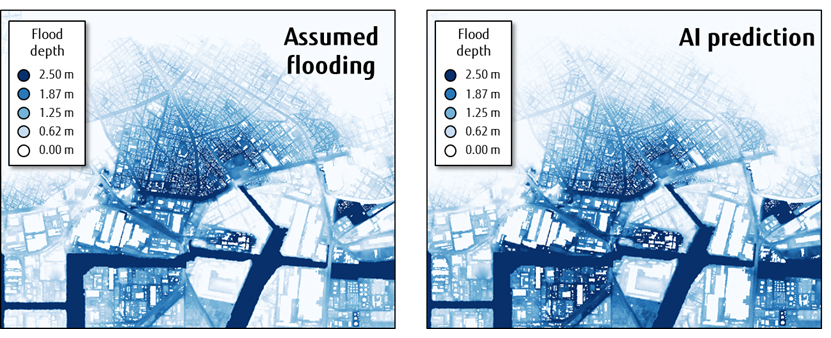

По этой причине многие годы Fujitsu сотрудничала с Международным научно-исследовательским институтом катастроф для реализации новой инициативы — модели искусственного интеллекта для прогнозирования наводнений и цунами в режиме реального времени.

В этом проекте Fugaku использовался для генерации обучающих данных для ИИ — суперкомпьютер смоделировал серию из 20 000 цунами с различными формами волн и их последствиями на суше.

Для этого была разработана новая технология глубокого обучения с двухэтапной конфигурацией — сперва ситуация наводнения представляется в аппроксимированном (и довольно грубом) разрешении, а уже потом ИИ увеличивает разрешение предполагаемых условий, конкретизируя особенности ситуации.

Модель сопоставляет входящие данные о формах волны и качестве береговой линии, генерируя на выходе точные и практически мгновенные прогнозы эффекта цунами на заданную территорию, в частности степень затопления улиц и разрушения зданий.

Уже впоследствии эти данные использовались для обучения ИИ, цель которой заключалась в том, чтобы понимать взаимосвязь между формами волн и затоплением. В конце концов исследователи получают обученную модель, которая может быть запущена на обычном ПК.

Например, когда модель была применена к моделированию цунами в Токийском заливе после сильного землетрясения, она позволила получить очень точные прогнозы с помощью обычного среднестатистического ПК буквально за считанные секунды — результаты совпали с моделями, которые используют эксперты Кабинета министров Японии.

3. LUMI

Консорциум LUMI (Large Unified Modern Infrastructure) — совместное европейское предприятие по высокопроизводительным вычислениям (EuroHPC), которое объединяет ресурсы европейских стран для разработки первоклассных суперкомпьютеров на основе конкурентоспособной европейской технологии.

Членами консорциума являются Финляндия, Бельгия, Чехия, Дания, Эстония, Исландия, Норвегия, Польша, Швеция и Швейцария.

Их суперкомпьютер так и называется — LUMI. С другой стороны, слово «lumi» на финском означает «снег». И хотя он занимает лишь третье место в общемировом топе, он является лидером среди всех европейских суперкомпьютеров.

LUMI размещен в огромном комплексе IT-центра SCS, расположенного в небольшом городке Каяани в Финляндии. Этот финский научный центр принадлежит государству и обслуживается высшими учебными заведениями страны.

Кстати, раньше на его месте располагалась старая бумажная фабрика финской лесопромышленной компании UPM-Kymmene Oyj.

Серверная среда в CSC состоит из нескольких суперкомпьютеров, баз данных и информационных хранилищ, которые связаны друг с другом в своего рода «метакомпьютер». Именно здесь и расположен кластер LUMI.

На его создание государства, имеющие членство в консорциуме, потратили около 150 миллионов евро и окончательно закончили проект в 2022 году — половина мощностей принадлежит совместному предприятию EuroHPC, из них только 20% зарезервировано для малого и среднего бизнеса. Другая половина делится между странами консорциума в соответствии с финансовым вкладом каждой страны.

Компьютер на 100% питается энергией, получаемой от местной гидроэлектростанции Ämmäkoski, а выделяемое им тепло используется для обогрева 20% централизованного теплоснабжения Каяани. Поэтому LUMI можно считать одним из самых экологически эффективных суперкомпьютеров в мире.

Вся система основана на оборудовании Hewlett Packard Enterprise (HPE) и AMD — суперкомпьютере HPE Cray EX, внутри которого 64-ядерные процессоры AMD EPYC и графические карты AMD Radeon Instinct. Этим «кремниевым оркестром» управляет операционная система HPE Cray OS.

Надо сказать, LUMI является системой, большая часть вычислительной мощности которой приходится на ядра графических процессоров. Это архитектура, выбрана в первую очередь из-за ее преимущества в соотношении цена/производительность.

Внутри 32 терабайта оперативной памяти, 7 петабайт флеш-памяти и еще дополнительные 80 петабайт традиционного хранилища — во всех случаях в качестве файловой системы используется Lustre, предназначенная специально для кластерных вычислений с высоким уровнем параллелизма.

Другие дополнительные 30 петабайт зарезервированы для службы управления данными на базе похожей файловой системы Ceph, которая аналогичным образом делит доступное файловое пространство на различные группы узлов в кластере.

Это дает в сумме 117 петабайт памяти с совокупной пропускной способностью ввода-вывода 2 терабайта в секунду.

Одним из примеров исследований, в которых используется LUMI, стал искусственный интеллект, разработанный исследовательской группой университета Тампере — она занимается диагностикой и классификацией рака простаты.

Благодаря LUMI можно сократить время подобных вычислений с трех дней до трех часов, ускоряя процесс тестирования и исследования.

Тут стоит упомянуть концепцию цифровых двойников — виртуальных моделей различных материальных объектов, будь то сердце, тракторный подшипник или атмосфера вокруг планеты. Они необходимы для проверки гипотез, технических решений или прогнозирования поведения изучаемой системы.

В одном из таких проектов LUMI является ключевым инструментом. Инициатива Destination Earth разрабатывает высокоточную цифровую модель Земли в глобальном масштабе, позволяющую прогнозировать взаимодействия между природными явлениями и деятельностью человека.

Передовые модели системы Земли требуют больших вычислительных ресурсов и могут значительно выиграть от ускорения модели графическими процессорами, размещенными в LUMI.

4. Leonardo

Некоммерческий консорциум Cineca, в который входит около 69 итальянских университетов и порядка 27 национальных исследовательских центров — сегодня, наверное, самый крупный, самый мощный и самый старый (основан в 1967 году) суперкомпьютерный центр научных исследований в Италии.

Он расположен в небольшой итальянской коммуне Казалеккьо ди Рено в городе Болонья, и занимается поддержкой научного сообщества с помощью высокопроизводительных вычислений — разрабатывает и проектирует информационные системы для предприятий, здравоохранения и госуправления.

Здесь все еще продолжается строительство суперкомпьютера Leonardo — компоненты оборудования прибыли на 600-метровую (кв.м.) площадку только в июле 2022 года.

Так же, как и LUMI, Leonardo является частью «Европейского совместного предприятия по высокопроизводительным вычислениям» (EuroHPC), получив финансирование в размере 120 миллионов евро от ЕС. Хотя общая стоимость составила около 240 миллионов евро — кроме ЕС, в качестве инвесторов выступили итальянские университеты.

Как сообщает CINECA, система состоит из 155 серверных стоек, в сумме образуя 4992 вычислительных узла. Общая мощность — 255 петафлопс. И как следствие, общее энергопотребление (мощность) гораздо ниже предшественников — всего 6 МВт по сравнению с 21 МВт Frontier.

Суперкомпьютер поделен на три отдельных «модуля». Первый, именуемый «бустерный модуль», состоит из компьютера Atos BullSequana XH2000 с 13824 графическими процессорами Nvidia A100, сгруппированными по четыре на узел — всего 3456 узлов.

Серия суперкомпьютеров BullSequana, разработанная корпорацией Atos — модульная вычислительная платформа, аналогичная стойкам Cray или Fujitsu, которая спроектирована специально для задач с искусственным интеллектом за счет использования графических процессоров.

По заверениям Atos, серия BullSequana X потенциально может работать в эксафлопсном режиме.

Второй модуль называют «модулем, ориентированным на данные» — он состоит из 1536 процессоров Intel Sapphire Rapids.

Эти два модуля дополняются «интерфейсным и сервисным модулем» с двумя системами хранения, общая емкость которых 110 петабайт. Объем оперативной памяти — 2800 терабайт.

В общем, Leonardo (впрочем, как и LUMI) послужит своего рода европейской альтернативой американского Frontier, взвалив на свои плечи задачи по анализу космических данных, расчету новых материалов, прогнозированию изменения климата, анализа нитей ДНК и моделированию цифровых двойников, будь то атмосфера земли или орган человеческого организма.

5. Summit

Еще один быстрый суперкомпьютер родом из США — Summit. Так же, как и Frontier, он находится центре Oak Ridge Leadership Computing Facility (OLCF). Интересно, что в период с ноября 2018 года по июнь 2020 года он занимал первое место среди самых быстрых суперкомпьютеров мира. Потом его, конечно, потеснили другие системы.

Еще в 2014 года Министерство энергетики США решило потратить 325 миллионов долларов на строительство новой высокопроизводительной системы.

Подрядчиками выступили IBM, NVIDIA, Mellanox и Sierra — все они предоставили необходимое оборудование, скомпоновав его в один большой суперкомпьютер, который разместили в здании Ок-Риджской национальной лаборатории штата Теннесси на площади в 873 квадратных метра. Длина всех кабелей почти в 2 раза больше, чем у Frontier — 219 километров.

Каждый узел Summit-а состоит из 2 процессоров IBM POWER9, 6 графических карт Nvidia Tesla, 600 ГБ когерентной памяти (HBM2 и DDR4 SDRAM) и 800 ГБ энергонезависимой оперативной памяти — во всей системе таких узлов 4608 штук с общим число ядер в 2 414 592 единиц.

Все компоненты соединены между собой высокопроизводительной шиной типа NVIDIA NVLink. На весь суперкомпьютер приходится около 27648 графических карт.

Благодаря этому комплекту Summit способен выдавать 200 петафлопс пиковой скорости с энергопотреблением 13 МВт.

После запуска в 2018 году Summit предназначался в первую очередь для гражданских и научных исследований в области космологии, медицины и климатологии.

Например, вместе с инструментами от Google DeepMind и университета Georgia Tech Summit позволяет многократно ускорять точную идентификацию белковых структур и функций в геномах организмах — подходы, основанные на глубоком обучении, определяют белки на основе последовательностей ДНК, способствуя прогрессу в области биотехнологий, биобезопасности и биоэнергетики.

Например, около 10 процентов людей, которым прописаны опиоиды, испытывают полноценную зависимость, однако нет никакого способа узнать, кто из них наиболее склонен.

Дэн Джейкобсон, главный научный сотрудник отдела биологии вычислительных систем Ок-Риджской лаборатории, уже сейчас работает со своей командой над этой проблемой, активно применяя Summit.

Сперва суперкомпьютер помогает в поиске генетических изменений во всей популяции, а затем использует алгоритмы для выявления корреляций между этими изменениями.

Для этого Summit работает с набором данных Управления по делам ветеранов, содержащим медицинские записи о 23 миллионах человек за последние два десятилетия. Он уже нашел геномные корреляции по 600 000 человек — цель состоит в том, чтобы довести их до 2 миллионов.

Как только у команда соберет достаточно большой набор корреляций, их можно будет проверить на нескольких группах: тех, у кого развилась опиоидная зависимость, и контрольной группе, у которых зависимости нет.

Эта операция потребует около 10 сравнений в 16-й степени (10 квадриллионов). Таких операция может потребоваться тысячи, а может даже и сотни тысяч раз.

Возможность выполнять такие расчеты за разумное количество времени открывает двери для новых способов борьбы с растущим кризисом медикаментозной зависимости.

Суперкомпьютеры России

В России тоже есть несколько систем, занимающих не последние строчки в TOP500. Среди отечественных суперкомпьютеров самыми быстрыми считают системы Яндекса — в 2021 году «Червоненкис» занял 19-ю строчку списка ТОП500, получив статус самого производительного компьютера в России и Восточной Европе.

Компьютер был назван в честь советско-российского ученого в области информатики и теоретика машинного обучения Алексея Яковлевича Червоненкиса.

Система состоит из 199 вычислительных узлов на базе 1592 графических карт NVIDIA A100 80G — это 25 472 ядер, выдающих суммарную производительность в 21 петафлопс. Энергопотребление гораздо скромнее — 583 кВт.

Кстати, у Яндекса есть еще два суперкомпьютера — «Галушкин» и «Ляпунов». Оба построены на базе процессоров NVIDIA A100 40G, поэтому их мощность немного скромнее — 16 и 12 петафлопс соответственно.

«Червоненкис» и «Ляпунов» расположены в дата-центре Яндекса в небольшом городе Сасово, а «Галушкин» размещен во Владимире. Все три системы используются для внутренних нужд Яндекса. Именно на них компания обучает свои нейросети, на основе которых работают сервисы Яндекс.Переводчика, Яндекс.Директа, Яндекс.Алисы и многих других приложений.

Еще два суперкомпьютера — Кристофари от Сбербанка, названный в честь первого клиента Сбербанка (владелец первой сберегательной книжки в России) Николая Христофари, и Ломоносов-2 от компании Т-Платформы, размещенный в Научно-исследовательском вычислительном центре МГУ.

Кристофари работает более чем на 1000 графических картах NVIDIA GPU Tesla v100, объединенных в узлы NVIDIA DGX-2 — эффективная производительность всей системы около 6,67 петафлопс. На каждый узел дополнительно приходится по 2 процессора Intel Xeon Platinum 8168 (2,7 ГГц, 24 ядра) и 1,5 Тбайт оперативной памяти.

После того, как в 2019 году Сбербанк запустил коммерческое использование Кристофари, его мощности стали основой облачной платформы, специализирующейся на машинном обучении. Частью своих мощностей компания делится с другими организациями.

Так же, как и Яндекс, Сбербанк использует Кристофари для внутренних задач собственной экосистемы сервисов и приложений — распознаёт речь, анализирует фотографии, генерирует ответы в колл-центрах и даже распознает снимки компьютерной томографии легких в приложении СберЗдоровье.

При этом суперкомпьютер Ломоносов является более старой системой — его эффективная производительность около 2,5 петафлопс, а пиковая — 5 петафлопс.

На текущий момент система состоит из более 3 тысяч узлов на базе процессора Intel Xeon E5-4650V3 Haswell-EP и графических ускорителей NVIDIA K40M. Оборудованием управляет операционная система CentOS 7.

Как видно, эпоха цифровизации побуждает крупнейшие государства мира вкладывать огромные суммы в высокопроизводительные вычисления — суперкомпьютеры требуют регулярной финансовой поддержки, т. к. производительность систем растет из года в года.

Сегодня они применяются в моделировании организмов, прогнозировании погоды, переводе языков, анализе экономики, улучшении криптографии и других специфических, но в тоже время повседневных задачах.

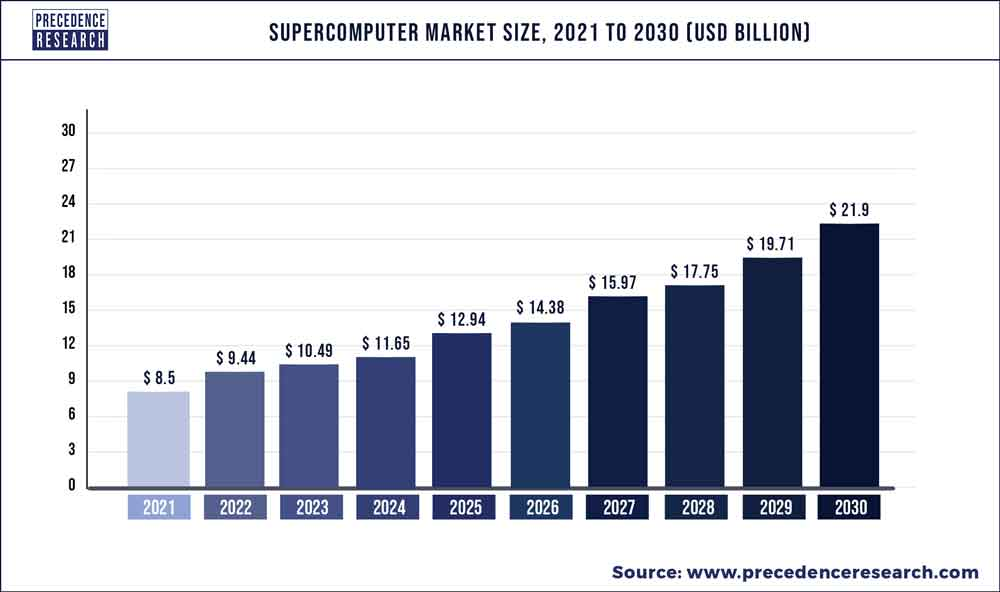

По данным Precedence Research в 2021 году объем мирового рынка суперкомпьютеров оценивался в 8,5 млрд долларов, а к 2030 году достигнет примерно 22 млрд долларов — среднегодовой рост примерно 11%.

Лидером в качестве поставщика оборудования для суперкомпьютеров является Япония, а весь рынок поделен между следующими игроками:

Nvidia (Япония)

NEC Corporation (Япония)

Lenovo (Китай)

Intel (США)

IBM (США)

HPE (США)

Fujitsu (Япония)

Atos (Франция)

Распространение высокопроизводительных вычислений (HPC) зародило новые направления на стыке информатики и естественных наук — вычислительную биологию, вычислительную химию, вычислительную лингвистику и множества других.

В наши дни эти дисциплины решают не только локальные специфические задачи, но и служат основой глобальных систем, кажущихся чем-то привычным для обывателя:

Платежные системы. Быстрая обработка и утверждение платежей, с эффективным обнаружением мошенничества и подозрительных транзакций.

Искусственный интеллект. Машинное обучение, будучи затратной операцией, повышает релевантность контента в социальных сетях и рекламных площадках, прогнозирует атмосферные явления, распознает музыку, переводит текста в фото и видео формате, автоматически добавляет субтитры к видео.

Транспорт. Суперкомпьютеры помогают инженерам заранее просчитывать формы кузова, улучшая аэродинамические показатели. Или моделировать сложные физико-химические процессы, происходящие в двигателях, позволяя найти слабые места и повысить производительность.

В своей книге Life 3.0 известный футурист Макс Тегмарк как-то написал:

«Я думаю, что если нам удастся создать машины, которые будут умнее нас во всех отношениях, это будет либо лучшее, что когда-либо случалось с человечеством, либо худшее. Я оптимистично настроен в отношении того, что с помощью ИИ мы сможем создать великое будущее, но это не произойдет автоматически. Это потребует от нас действительно продумать все заранее и обсудить этот вопрос сейчас».

Каким бы ни было решение, когда дело доходит до будущего суперкомпьютеров просто бизнеса недостаточно — изучение новых концепций и подходов должно стать регулярным и широко распространенным явлением.

Доступ к существующим инновационным технологиям должен иметь как можно большее количество исследовательских групп — только так можно добиться построения быстрых и эффективных систем, решающих все больше и больше сложных проблем.

НЛО прилетело и оставило здесь промокод для читателей нашего блога:

— 15% на все тарифы VDS (кроме тарифа Прогрев) — HABRFIRSTVDS.