ДЦ Берзарина — наш единственный дата-центр в Москве. Организован он аналогично остальным нашим дата-центрам — холодный коридор, откуда оборудование забирает холодный воздух, неконтролируемое по температуре пространство вокруг (горячий коридор), откуда кондиционеры забирают воздух для охлаждения (осушения чистки и т.д. — всё это и есть «кондиционирование») и выпускают обратно в холодный.

(альтернативная ссылка)

Состоит из одной очень длинной серверной, внутри которой находится длинный холодный коридор (2x40 шкафов). Этим он несколько отличается от устройства остальных ДЦ, где коридоров несколько.

На фотографии видно, как мы экономимтепло холод. Слева видны заглушки на место отсутствующих серверов, справа — плёнка, закрывающая неиспользующийся шкаф целиком. Плёнка эффективнее, чем заглушки, но применяется она только для экранирования полностью неиспользующися стоек. Хотя, конечно, выглядит, мягко говоря, не пафосно.

Традиционно, используется нижний подвод холодного воздуха, отверстия только там, где этот воздух нужен. Кстати, в предыдущем посте я ошибся — высота фальшпола аж метр, а не пол-метра.

Вход с двух сторон (на фотографии дверь в холодный коридор, сама серверная вполне себе закрыта на серьёзные металлические двери):

Вид на горячий коридор. Слева — серверные шкафы, справа — промышленные кондиционеры, забирающие воздух из горячего «вокруг», охлаждающие его и гонящие под пол. Сверху виден горизонтальный кабель-канал.

А вот так выглядит «голая стойка». Обратите внимание — 4 юнита «пропадают зря» ради электрических розеток, ещё 3U заняты автоматами и разводкой электричества. Всего в шкафу 42U, полезной нагрузки — 35U.

Как, вероятнее всего, заметили читатели, этот ДЦ загружен совсем не полностью, и да, это намёк.

В отличие от ДЦ на Цветочной, на Берзарина дежурят только инженеры службы поддержки и охрана. Так что автоматическая система пожаротушения обязательна. Разумеется, она газовая (врят ли кто-то морально готов к тому, чтобы его сервер тушили порошком). Кстати, на этой же фотографии можно оценить высоту фальшпола — дверь в помещение находится на высоте «настоящего» пола" — а наверх ведёт лестница. Для подъёма тяжестей используется второй вход (слева на фотографии), где лестницы нет, зато есть возможность использовать погрузчик

Через эти сопла газ подаётся в холодный коридор. Дальше он под собственным давлением и с помощью вентиляторов серверов распространяется в оборудование и в горячий коридор.

Традиционно, видеонаблюдение, доступ в каждое помещение по RFID карточкам (я там разок был, и могу сказать, что впечатление гнетущее — из помещения дл я дежурных даже до туалета без карточки не дойдёшь).

Доступ в серверную предоставляется с помощью считывателя отпечатков пальцев (fingerprint reader). Не могу сказать, что это сильно повышает надёжность системы (см. соответствующую серию Mythbusters), но раз сделали — используем. Заметим, без карточки в серверную всё равно не попасть.

Это Uniflair TDCV2700А — прецизионные кондиционеры. Когда возможно, мы используем фрикулинг (охлаждение хладогена в чиллерах наружным воздухом), благо погода в Москве большую часть года позволяет это делать.

Кондиционеры резервируются по схеме N+1.

Жёлтые трубы ведут к балонам с газом (за ширмами). Кондиционер примитивный, но причина проста: задача бесперебойников — держать серверную, пока дизели запускаются. Для этого воздух в помещении должен быть холодным, а кондиционер отключается (т.к. запитан мимо бесперебойников). Как только дизели включатся, включится и кондиционер, охлаждая результаты работы бесперебойников.

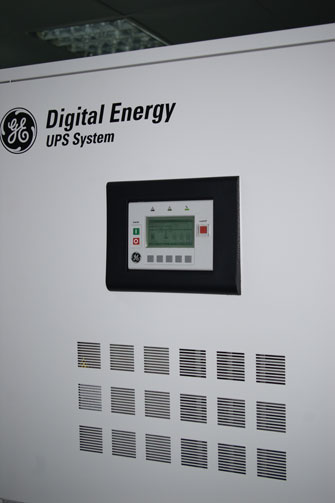

Это General Electrics SG-CE PurePulse S1, всего 6 штук. Они объедены в две группы, в каждой группе 2 основных и один запасной (N+1 резервирование).

В сумме ДЦ обеспечивает 800кВт мощности.

Один из дизель-генераторов: дизель как дизель. Два стартера, две собственные батареи для запуска:

Для связи с миром используются оптические каналы. Вводов в дата-центр два, оба через колодцы. Разумеется, разные колодцы. Оптика идёт до ММТС-9 (96 волокон), столько же до М10. Гигабитный канал связывает Берзарина с нашей сетью в Санкт-Петербурге. Аплинки: Retn, TeliaSonera.

(альтернативная ссылка)

Состоит из одной очень длинной серверной, внутри которой находится длинный холодный коридор (2x40 шкафов). Этим он несколько отличается от устройства остальных ДЦ, где коридоров несколько.

На фотографии видно, как мы экономим

Традиционно, используется нижний подвод холодного воздуха, отверстия только там, где этот воздух нужен. Кстати, в предыдущем посте я ошибся — высота фальшпола аж метр, а не пол-метра.

Вход с двух сторон (на фотографии дверь в холодный коридор, сама серверная вполне себе закрыта на серьёзные металлические двери):

Вид на горячий коридор. Слева — серверные шкафы, справа — промышленные кондиционеры, забирающие воздух из горячего «вокруг», охлаждающие его и гонящие под пол. Сверху виден горизонтальный кабель-канал.

А вот так выглядит «голая стойка». Обратите внимание — 4 юнита «пропадают зря» ради электрических розеток, ещё 3U заняты автоматами и разводкой электричества. Всего в шкафу 42U, полезной нагрузки — 35U.

Как, вероятнее всего, заметили читатели, этот ДЦ загружен совсем не полностью, и да, это намёк.

Противопожарные системы

В отличие от ДЦ на Цветочной, на Берзарина дежурят только инженеры службы поддержки и охрана. Так что автоматическая система пожаротушения обязательна. Разумеется, она газовая (врят ли кто-то морально готов к тому, чтобы его сервер тушили порошком). Кстати, на этой же фотографии можно оценить высоту фальшпола — дверь в помещение находится на высоте «настоящего» пола" — а наверх ведёт лестница. Для подъёма тяжестей используется второй вход (слева на фотографии), где лестницы нет, зато есть возможность использовать погрузчик

Через эти сопла газ подаётся в холодный коридор. Дальше он под собственным давлением и с помощью вентиляторов серверов распространяется в оборудование и в горячий коридор.

Безопасность

Традиционно, видеонаблюдение, доступ в каждое помещение по RFID карточкам (я там разок был, и могу сказать, что впечатление гнетущее — из помещения дл я дежурных даже до туалета без карточки не дойдёшь).

Доступ в серверную предоставляется с помощью считывателя отпечатков пальцев (fingerprint reader). Не могу сказать, что это сильно повышает надёжность системы (см. соответствующую серию Mythbusters), но раз сделали — используем. Заметим, без карточки в серверную всё равно не попасть.

Охлаждение

Это Uniflair TDCV2700А — прецизионные кондиционеры. Когда возможно, мы используем фрикулинг (охлаждение хладогена в чиллерах наружным воздухом), благо погода в Москве большую часть года позволяет это делать.

Кондиционеры резервируются по схеме N+1.

Электричество

Жёлтые трубы ведут к балонам с газом (за ширмами). Кондиционер примитивный, но причина проста: задача бесперебойников — держать серверную, пока дизели запускаются. Для этого воздух в помещении должен быть холодным, а кондиционер отключается (т.к. запитан мимо бесперебойников). Как только дизели включатся, включится и кондиционер, охлаждая результаты работы бесперебойников.

Это General Electrics SG-CE PurePulse S1, всего 6 штук. Они объедены в две группы, в каждой группе 2 основных и один запасной (N+1 резервирование).

В сумме ДЦ обеспечивает 800кВт мощности.

Один из дизель-генераторов: дизель как дизель. Два стартера, две собственные батареи для запуска:

Оптика и каналы связи

Для связи с миром используются оптические каналы. Вводов в дата-центр два, оба через колодцы. Разумеется, разные колодцы. Оптика идёт до ММТС-9 (96 волокон), столько же до М10. Гигабитный канал связывает Берзарина с нашей сетью в Санкт-Петербурге. Аплинки: Retn, TeliaSonera.

Внешний вид здания