Комментарии 120

Что за производитель Netac, кто знает? Постоянно попадается с отличными характеристиками, как будто лидер рынка.

Добрый.

Вполне себе китайский бренд. Взял себе - работает уже полгода.

Купил их флешку для камеры 128гб v30 u1 - оказалось ошибка. Видео писать не хочет, не с первого раза распознаётся в карт-ридере. Полный объём не проверял, для фото в этом нет необходимости. То что заявлены характеристики - вовсе не факт что они имеются. Будьте осторожны.

Только сразу нужно гуглить видео "Netac NV7000 Часть 1: Причина перегрева и выхода из строя контроллера, и как этого избежать!".

Nvme этого производителя использую примерно год,- устанавливаю на него игры. Скорость загрузки уровня увеличилась в разы. Пока работает.

Юзаю двухтеровый N600S во внешнем кармане iODD, и он довольно неплохо себя пока что показывает.

Друг взял популярный Netac NV7000, через полгода отвалился контроллер. Сейчас отправил назад, посмотрим как сработает гарантия, но займет это месяца три.

Лично мне данные ценны, плюс не люблю хлопоты, поэтому предпочел Samsung PM9A1 (он же 980 Pro для OEM).

Взял как-то "первый попавшийся из самых дешёвых" Netac 2,5" N535S 960Gb — заменить в зеркале Kingston A400, который перешёл в режим "satafirm s11" и обратно никак не перешивался — так он грелся в простое до 49, а под нагрузкой 60+. Налепил на него китайский радиатор, поставил под вентилятором — температура упала до 37 — 48. А через 8 месяцев просто перестал читаться.

Всё-таки восстановленный после некоторых танцев Kingston и купленный в то же время Hikvision C100 работают уже полтора года (хотя последний тоже греется).

Один экземпляр — так себе выборка, конечно, но...

В начале 2000х выпускал флешки. А сейчас взялся за SSD.

Купил на днях диск на 1тб. Только у них и кинстонга остались такие диски в форм-факторе mSATA. Пока ничего особенного, кроме того, что скачанные с сайта производителя программы вызвали десятки срабатываний на вирустотале

А, в Firmware SSD диска возможно внедрение на уровне аппаратуры вирусов в каком то виде, и если да, то как это можно узнать или отгородится?

P.S. т.к. есть и такое сообщение

уже полгода ежедневно в системе трудятся два NVME от Netac на 120Гб и 1Тб, мелкий под систему, побольше под игры, брал на алике

Netac и Eaget - два крупнейших китайских производителя из числа тех, которые можно считать подвалом. Цена и качество соответствуют. Я бы такое брать не стал. Лучше берите Teclast, он тоже недорогой, но это нормальный уважаемый бренд с нормальным же качеством.

Цена упала настолько сильно, что терабайтные SSD стали вполне доступными для вендоров ПК. Ранее в таких моделях устанавливали либо HDD, либо же SSD небольшой емкости. Сейчас без проблем можно ставить и терабайтные твердотельные накопители.

А можете написать в Apple, Inc? А то они, кажется, не в курсе... За 250 дополнительных гигабайт просят доплату в $200.

Они особенные, им можно. -_-

Ну так у них SSD с дикими объемами работая живут 10 лет не чихая. Вполне того стоит, если есть соответствующие задачи.

Вполне того стоит, если есть соответствующие задачи.

Пока micron'овские неубиваемые серверные nvme ссд стоят в районе 17 центов за гб при цене эппла в 80 центов за гб - не стоит.

Вот и носите с собой серверную стойку, вместо макбука, воля ваша :)

Пока владельцы макбуков шутят про серверные стойки, я сделаю что-то невиданное для них и самостоятельно поставлю аж в целых два nvme слота в своем ноутбуке micron 7400 pro на 3.84тб и не останусь без штанов (относительно цен эппла). :)

Осталось поставить эппл силикон процессор в ваш ноутбук - если и с этим справитесь «на коленке» (включая обход аппаратной защиты), то на любую технику эппл вам точно будет хватать :)

сделаю что-то невиданное для них и самостоятельно поставлю аж в целых два nvme слота в своем ноутбуке micron 7400 pro на 3.84тб

а что за ноутбук у вас с m.2 22110?

M.2 22 x 80mm available in 400GB, 480GB, 800GB and 960GB; M.2 22 x 110mm available in all listed M.2 capacities.

https://www.microncpg.com/content/dam/micron/ssd-products/7400/flyer/7400_nvme_ssd_product_brief.pdf

вообще dc ssd в формате 2280 немного. а ещё многие dc ssd не умеют толком спать, для ноутбука этом может быть существенно. да и под нагрузкой у них потребление зачастую выше, чем у десктопных моделей (а с охлаждением в ноутбуке проблемы)

всё имеет свой ресурс, в тч. серверные Ssd.

увы, волшебных "неубиваемых" не существует.

Ну для большинства задач вне дата центра ~29пб TBW это практически неубиваемый диск. На одном из моих дисков с кучей виртуалок, которые насилуют диск на запись 24/7, статистика за 3 года примерно такая:

Percentage Used: 4%

Data Units Read: 1,432,094,836 [733 TB]

Data Units Written: 1,521,473,372 [778 TB]

Причем, наверное, треть из этого записал не я, а прошлый владелец.

бывает и так. у Вас весьма мало записи, как для диска с кучей виртуалок.

у меня был интересный случай, клиент за несколько месяцев протёр в ноль пару ssd немалого объёма, причём там была подробная статистика в смарт-е, за эти несколько месяцев произошло ~3200 перезаписей всего объёма диска.

Клиентский софт писал на диски на макс. возможной скорости потоками мелких записей (write amplification был около 11, для такого надо постараться), без остановок . Диски были с ресурсом 1DWPD, те. заявленный ресурс был не только отработан, но и превышен.

p.s. нет, это был не синтетический тест, а реальная работа.

а диски точно серверные были? бешенный waf может получаться при синхронной записи на накопители без plp

да, серверные. Читайте внимательно.

Про серверность там ничего не было написано, только про 1 dwpd, ну так и 860 pro если делить ресурс на три года как раз столько и имеет.

А что за модель была? И что с накопителем случилось? Перестал читаться, перешёл в ro или что?

те. заявленный ресурс был не только отработан, но и превышен

Разве? Ресурс накопителя в dwpd уже включает накладные расходы на waf, можете погуглить JESD219 Enterprise Workload, там в основном запись блоками 4к. Получить заметно меньший заявленного ресурс можно если только писать по 512 байт, но не уверен, что не минуя фс это получится сделать.

Micron -ы DC500 (datacenter) серий.

" Ресурс накопителя в dwpd уже включает накладные расходы на waf, можете погуглить "

не совсем так.

как правило, заявленный ресурс включает в себя накладные расходы, но не любые, а небольшие, причём методика разная для обычных и серверных, и , более того, разная у разных фирм.

И вот WA 11 это гарантированно в несколько раз больше типовых расчётных цифр.

" Получить заметно меньший заявленного ресурс можно если только писать по 512 байт, но не уверен, что не минуя фс это получится сделать. "

вы можете писать даже по 8 байт.

Смотрите, у вас есть логическая операция записи, где размер записываемых данных может быть сколь угодно малым , на уровне приложений (application-level) у вас нет никаких секторов. (Кстати, криво и активно пишущий софт это и есть одна из главных проблем износа.)

Сектора и кластеры это уже уровень ФС, на на уровне физики накопителя есть записываемые и стираемые блоки флэша, плюс таблица трансляции.

Если пишете очень много мелочи, да ещё и на пределе скорости накопителя (не успевает собирать блоки), WA может быть и 10, и 20.

как правило, заявленный ресурс включает в себя накладные расходы, но не любые, а небольшие, причём методика разная для обычных и серверных, и, более того, разная у разных фирм.

гхм, обычно указывают или в соответствии с эталонными нагрузками jedec, или вообще 4k random write (что, в общем-то, достаточно близко, в JESD219 enterprise 67% блоки 4к и 10% меньше 4к).

что-то другое сходу вспоминается только для накопителей на qlc intel/solidigm (и то, если порыться, можно найти «правильные» цифры).

вы можете писать даже по 8 байт.

писать-то могу, но waf считается как отношение записанных в nand данных к переданным накопителю. а накопителю передаются только целые сектора.

ЕМНИП крайне редко пишутся одиночные сектора, обычно всё-таки это минимум 4кб. хотя бы потому, что минимальный размер страницы памяти именно такой, и при буферизованной записи страница помечается как грязная целиком.

так что минимальный размер записи на накопитель 512 байт, обычный — не менее 4096 (и то если не форматировать под сектор 4к, что умеют вроде бы все dc nvme).

Если пишете очень много мелочи, да ещё и на пределе скорости накопителя (не успевает собирать блоки), WA может быть и 10, и 20.

да не должно там быть 20.

вот смотрите, типичный накопитель с dwpd=1 на 960 гигабайт собран на микросхемах на 8 тебибит, это overprovisioning 10% (960e9/1024^4≈87%, но накопителю где-то надо хранить прошивку, ftl и прочую служебную информацию).

то есть, как бы неудачно не был заполнен накопитель, у него должны быть блоки, заполненные не более, чем на 90%. интуиция мне говорит, что на рандомной нагрузке самый малозаполненный блок будет гораздо более свободен, но вот подсчитать это сходу не готов.

итого мы имеем waf=10 в самом худшем (вот почти что невероятном) случае.

если у вас на диске есть свободное место (и работает trim), то всё ещё лучше (в общем-то накопители с dwpd=3 и отличаются обычно только размером заводского op, на тех же микросхемах nand это может быть уже 800, а не 960 гигабайт, что увеличивает op в два с лишним раза)

а вот обработка fsync способна очень увеличить waf. потому что страница nand (минимальная единица записи) гораздо больше, чем 4кб (вроде бы обычно 16кб, но даташиты на современные nand cложно искать).

обычно накопитель ждёт заполнения страницы, но в случае синхронной записи он не может это сделать — он вынужден немедленно записать данные (да ещё и изменения в ftl, это почти наверняка придётся писать в другую страницу).

то есть если от ос пришла команда записи 4 килобайт, накопителю приходится писать 2 страницы, это 32 килобайта! то есть мы имеем waf=8 без учёта необходимости работы сбощика мусора.

именно этим и объясняются очень грустные цифры скорости синхронной записи на накопителях без plp.

Micron -ы DC500 (datacenter) серий.

m500dc? через мои руки именно такая модель не проходила.

на фотографии ионисторы есть, но я встречал на некоторых старых dc ssd заметную (хоть и меньшую, чем на не-dc моделях) просадку скорости при синхронной записи, читай увеличение waf. видимо, реализован какой-то промежуточный алгоритм между «игнорируем fsync, plp нас спасёт» и «пишем сразу в nand во чтобы то ни стало».

может быть он из таких?

" страница nand (минимальная единица записи) гораздо больше, чем 4кб (вроде бы обычно 16кб, но даташиты на современные nand cложно искать). "

В современных (и даже не очень) - больше, 8-16 было очень давно.

" на фотографии ионисторы есть, "

конденсаторы. практически на всех серверных они есть, это одно из отличий.

" это overprovisioning 10% "

overprovisioning зависит от прошивки, а не от флэша, сколько нарезали ,столько и будет.

У серверных обычно больше 10%.

" итого мы имеем waf=10 в самом худшем (вот почти что невероятном) случае. "

это простая излишне оптимистичная оценка. на практике всё сложнее и хуже.

" (и работает trim), "

в случае серверных нагрузок trim чаще нету ,чем есть.

разные ФС, виртуализация и т.д.

в случае серверных нагрузок trim чаще нету, чем есть.

разные ФС, виртуализация и т.д.

гхм, а что за фс в 2023 не поддерживают trim?

что до виртуализации, то vmware очень давно поддерживает, я не говорю про linux и windows.

overprovisioning зависит от прошивки, а не от флэша, сколько нарезали, столько и будет

это банальность из разряда «напряжение на клеммах аккумулятора зависит от степени заряда».

это знание никак не приближает нас к пониманию «какой op у этого накопителя».

это простая излишне оптимистичная оценка. на практике всё сложнее и хуже.

ну так обоснуйте, как при op=10% может оказаться, что waf=20 — единственный выход (думаю не стоит объяснять, что выгодно waf держать максимально низким, не только для ресурса накопителя, но и для производительности).

wear leveling при активной записи особой роли не играет.

не ФС, а бутерброд из ФС и виртуализации.

в реальном мире нельзя просто так войти в ДЦ и разом перестроить всё, ради того, чтобы на ssd работал trim.

наивного вчерашнего студента, который такое предложит (ну как же, оно ведь поддерживает!), выпрут в шею - и будут совершенно правы.

обновление железа и софта плановое, длится годами.

С контейнерами проще, но они далеко не везде.

" это банальность "

это реальность, я имел дело с теми же Самсунгами, где бытовая и серверная модель отличались прошивкой контроллера и наличием конденсаторов.

%% overprovisioning у них - разный.

И работа под постоянной нагрузкой - разная, как и ресурс.

обновление железа и софта плановое, длится годами.

у вас массово в проде rhel 5, windows 2003, esxi 4.1?

навскидку это последние версии, которые совсем не умели trim

P. S. вы так и не ответили на вопрос, что случилось с тем накопителем с waf=11. любопытно же, у меня не очень большая статистика по «перепротёртым» ssd.

гхм, а что за фс в 2023 не поддерживают trim?

а можно не "не поддерживает", а "не использует по умолчанию"? Тогда - большинство. Для большинства файловый систем опция discard в linux выключена по-умолчанию. См. https://wiki.archlinux.org/title/Solid_state_drive со ссылками на rhel/ubuntu/debian и вовсе ядро linux с целым списком девайсов с серьёзными ошибками в прошивках, из-за которых для них персонально отключают часть функциональности.

Вместо discard дистрибьютивы обычно делают в кроне или по systemd таймеру вызов fstrim раз в неделю или около того.

Вместо discard дистрибьютивы обычно делают в кроне или по systemd таймеру вызов fstrim раз в неделю или около того

…, который как раз включен по умолчанию. и делает свою работу.

называть это «trim не поддерживается» или даже «trim по умолчанию выключен» — явное передёргивание.

со ссылками на rhel/ubuntu/debian и вовсе ядро linux с целым списком девайсов с серьёзными ошибками в прошивках, из-за которых для них персонально отключают часть функциональности.

да, для многих накопителей отключено queued trim (а ещё многие просто не умеют), но это актуально только для sata.

ну и да, отключено и отключено, это всего лишь означает немного бо́льшие задержки при выполнении trim.

и да, эти большие списки во многом перестраховка, у самсунга, например, как мне помнится, новые версии прошивки исправляли баги, и даже обнаруживалось, что баг не прошивке, а в ядре, но никто не удаляет накопители из блеклиста (что в общем-то разумно, лучше перестраховаться).

На маке вовсе не постоянно нагруженном легко в год выходит больше 300 терабайт и на чтение и на запись (работаю с космоснимками). Получается, ваших дисков надо десяток для сопоставимой скорости доступа. Так что серверную стойку вам реально приходится таскать вместо одного макбука :)

У вас и кони и люди смешались в одну кучу. Вы уж решите мы про скорость говорим (которая что у микрона, что у макбука плюс-минус одинаковая) или про ресурс (писать 300тб в год на микроновский ссд вы будете почти 99 лет чтобы выработать его гарантийный ресурс, сколько он еще после этого проживет никто не знает, вон самсунги вообще по 10x TBW переживают)

" вон самсунги вообще по 10x TBW переживают) "

не совсем так.

Штатный ресурс рассчитывается с прицелом на то, чтобы к его концу sssd более-менее мог вписаться в стандарты по хранению данных в выключенном виде.

А всё это "превысили в 5 раз!" запросто может обернуться тем, что неделя выключенного ssd - и всё, нету ни данных, ни диска. Хотя можно было бы, не будь дск изношен, рассчитывать минимум на 3-6 мес.

Ну-ну, вы пишите, что за год на ваш диск в режиме 24/7 можно записать примерно 150 терабайт. Вывод - скорость записи весьма печальна, что бы там на этикетке не было указано. Попробуйте датасет на пару терабайт радарных спутниковых данных на вашем «железе» обработать и тогда наглядно поймете, в чем разница.

То есть у аппла какие-то свои, особые ssd? Из рога единорога выструганные?

Сразу демагога видно, и вполне созвучно единорогу. Вы утверждаете, что все ссд, включая собранные китайцами из найденных в утиле, одинаковы? А сколько стоит отличить качественные, каждая фирма и покупатель решают сами - и цены эппл с трехлетней (расширенной) гарантией для многих выглядят привлекательнее, чем шанс на барахло нарваться, покупая хоть в магазине хоть на амазоне вроде бы фирменные ссд (даже если и не вроде, а точно фирменные, это не гарантия отсутствия проблем). Кстати, когда я последний эйр брал с ссд на два терабайта, на амазоне топовые ссд от известных фирм с похожими характеристиками стоили примерно столько же (с доставкой и пошлиной), да и как у них гарантия работает, тот еще вопрос (был такой опыт, что никак). А сравнивать цены сегодня с ценами на момент выпуска устройства - занятие на любителя.

Это те, которые на ВР очки два конца крутят, чтобы ты их потестировал? В такой ситуации лучше сразу в спорт лото писать.

Очень хочется денег (C)

del

А они берут не за объём и не за скорость, а за свой брэнд - хотя внутри, разумеется, чистый ОЕМ.

спецы по ssd, а что скажете за 4TB от Colorful серии SL500? как с живучестью у него? Или еще какие подводные камни?

Очень уж цена заманчива, по сравнению с привычными мне самсунгами

Судя по отзывам у них проблема со смартом(датчик температуры показывает статичные 40 градусов), от партии к партии меняются чипы памяти, так что тут прям лотерея по TBW и говорят что у него трим идет бесконечно долго, что может говорить о проблемах с контроллерами. В схожей ситуации, я бы взял netac.

Вопрос к ТС, а почему в сравнение не были взятые народные samsung pm9a1? Отличные диски по вполне адекватным ценам, и легкодоступные в РФ с алика, в отличии от других дисков из сравнения.

Решена ли проблема внезапной кончины неизношенных SSD с отличным смартом - загадка.

На мой взляд это ключевая проблема!

Перспектива в любой момент остаться без всех своих данных - очень пугает и удерживает от работы только на SSD.

на HDD внезапная смерть тоже возможна.

Поэтому бэкапы, бэкапы, и еще раз бэкапы.

И проверка этих бэкапов.

HDD с большой долей вероятности позволяет вытащить данные при смерти железа.

SSD часто умирает с данными вместе.

" HDD с большой долей вероятности позволяет вытащить данные при смерти железа. "

далеко не всегда. И это дорого.

Соглашусь с первой частью вашего замечания. Поэтому написал "с большой долей вероятности".

Информация дороже. Необходимость бекапов осознаются зачасту ПОСЛЕ смерти носителя.

Просто посмеяться: знаю случай когда почти всю свадьбу переигрывали. Флешка у фотографа умерла.

И их не сдашь в гарантию, а ну как данные там восстановят?

Перспектива в любой момент остаться без всех своих данных - очень пугает

Делайте бекапы. С HDD тоже может произойти много нехорошего, причем внезапно.

Если ваши данные существуют только в единственном экземпляре - значит они не так уж и важны.

так и на hdd такое бывает.

на 100% не решена никем и нигде,

но шансы на такое у нормальных брэндовых дисков (не самых дешёвых серий) многократно ниже, чем е дешёвой китайщины.

Жаль, что при этом вы не снижаете цены. Как подняли в начале 2022 года цены на виртуальное облако не 40% примерно - так эти цены и держите, несмотря на то что курс упал и сейчас примерно на тех же позициях, что и до начала роскомнадзора

Причины простые — SSD гораздо быстрее HDD, они бесшумные, плюс их надежность понемногу повышается

От это настолько спорное утверждение ещё со времен внедрения TLC. Все мои "старые" потребительские ssd уже 8...10 лет работают.

И не было лотереи при покупке, какой контроллер и какая память достанется.

стоимость твердотельных накопителей продолжает снижаться <...> их надежность понемногу повышается

Явное противоречие вижу я в этой фразе...

" SSD гораздо быстрее HDD, они бесшумные, плюс их надежность понемногу повышается. "

Ага, щазз.

Особенно с переходом на QLC надёжность повысилась.

Прям до небес взлетела.

Плюс начали химичить, столкнулся вот с таким 20% от емкости стоит хорошая быстрая флеш, которая самая в начале, потом стоит жопа которая медленная в разы. То есть для примера берем 1Т первые 200Г пишутся на скорости 200МБайт в секунду. Остальные со скоростью 30. Если натравить бенчмарк CrystalDiskMark он покажет да всё нормально он покажет. Типа очень всё хорошо, что на самом деле не так.

Кажется тут дело не в флеш-чипе, а в кеше на самом SSD или ОС ;) Посмотрите графики скорости записи/чтения почти любого SSD на тестах.

Нет, проведён был эксперимент. Было записано первые 200Г. Потом перезагрузка и старт теста ССД, но уже с с занятым местом. И тест сразу начинает показывать низкую скорость, то есть НИКАКОЙ кеш уже тут роли не играет. Если неправ, укажите мою ошибку в тесте.

Тест выглядит нормально :) Интересно. Но флешка сама думаю с одинаковой скоростью работает что в начале что в конце, и чипы там если несколько то одинаковые это точно. Есть только робкая мысль что может FTL (транслятор) забиваться и тупить вдруг начинает. Сам подобного поведения не встречал.

SLC-кэш в разных дисках по разному делают — у некоторых это небольшая выделенная область, а у некоторых кэша как такового нет, они просто пишут сначала на весь свободный объём в режиме SLC, а потом начинают утрамбовывать — "на горячую", если запись продолжается (скорость ступенчато падает), либо втихую при простое (можно заметить, например, по мониторингу температуры: "я уже пол-часа ничего не пишу, а он вдруг снова разогрелся").

Т.е. перезагружать надо было через несколько часов после записи этих 200г.

Неа, одинаковые там чипы. Нюанса два:

при записи данных во flash это не просто взяли и записали байтики (write), а писать можно только в подготовленные, очищенные ячейки (erase). И вот erase - это весьма долго по сравнению с собственно записью, а ещё может выполняться только блоками относительно физической структуры NAND.

как пишется TLC (да и QLC тоже). Это не взяли битики и записали за один раз все 3 (4 у qlc) битики в ячейку. Процесс многостадийный. Следовательно - более медленный. При этом, есть физическая возможность прерваться после записи одного бита в ячейку, затратив при этом соответственно меньше времени (сильно меньше времени).

Ну и вот она, возможность в бенчмарках показать какие-нибудь красивые цифры. Сообщить (discard) накопителю, что данных на нём нет, дать ему время поработать над erase своих ячеек своего флеша. Дать нагрузку на запись, контроллер делает фокус с записью только одного бита в ячейку. Пока есть свободные ячейки (и не дошли до софтовых ограничений в прошивке, например, использовать только такую-то ёмкость в таком стиле) - получаем качественное ускорение записи. Маркетинг в восторге.

А вот как свободные ячейки кончаются, но запись так и не прерывали - скорость записи резко падает. Контроллеру теперь нужно освобождать место на флеше. Читать записанное ранее, переписывать в полноценном TLC режиме, делать erase освобождённых ячеек, писать, в конце концов, то что продолжает требовать записать ОС.

Зато если запись случается нечастыми такими скачками, ОС сообщает об удалении данных (TRIM), а пользователь не забивает диск к 100% - то всё равно остаётся вполне хорошее ускорение для большинства пользователей. Это делают практически все десктопные модели, ориентация на нечастые спринтерские забеги, но не под постоянную запись. Ну а то что маркетинг об этом, разумеется, не скажет - как будто что-то неожиданное.

Да и многие серверные делают так же, вполне себе состоялось деление на разные семейства SSD под Read Intensive (см. выше) или же write-intensive (запись будет плюс-минус стабильна под постоянной пишущей нагрузкой, но дорого).

То есть если я правильно вас понял есть у нас 1Т QLC то первые 250Г пишутся в формате один бит на ячейку, Потом начинает писаться 2 бита на ячейку скорость просаживается, потому что надо прочитать 1 бит и потом записать два? А дальше на 500Г скорость еще раз падает потому-что уже пишется 3 бита на ячейку?

так вам просто некуда писать после быстрого заполнения четверти диска для QLC либо трети диска при TLC. Всё, ёмкость кончилась, если до сих пор писали 1 бит в ячейку. Несколько процентов избыточности флеша вам дадут, но ставить 2тб флеша и продавать как 1тб не будут точно.

А дальше попадаем на серьёзный штраф времени на erase блока, который исключает всякий смысл неполной записи ячейки. По-моему, возможность ускориться есть только для такого псевдо SLC однобитового режима, или же уже нет смысла (а то и возможности) извращаться и нужно писать номинальное количество бит на ячейку.

Как будет падать график - больше от прошивки контроллера зависит, чем от чего-то другого.

есть у нас 1Т QLC то первые 250Г пишутся в формате один бит на ячейку, Потом начинает писаться 2 бита на ячейку скорость просаживается, потому что надо прочитать 1 бит и потом записать два?

Условно да. 1-bit per cell пишется быстро, а потом перезаписывается n-bit per cell в зависимости от установленного флеша. Если забивать накопитель на 100%, а у него нет скрытого резерва, то свободногл места под эти фокусы не будет. А освобождать надо с TRIM - тогда даже самый тугой контроллер должен понять, что место свободно. Т.е. вместо форматирования диска желательно его весь ресетнуть через nvme-cli.

нет, дальше сразу переход из режима псевдо-SLC, 1 бит на ячейку,

в режим 3 или 4 бита на ячейку.

вариантов " 20% от емкости стоит хорошая быстрая флеш, которая самая в начале, потом стоит жопа которая медленная в разы. " не существует.

то, что вы описываете, называется "динамический псевдо-SLC кэш", при этом память одна и та же.

Сначала память работает в более быстром режиме, потом переходит в более ёмкий, но и намного более медленный.

QLC - это расширение возможностей. Кому нужен "одноразовый" SSD (для майнинга, для перекачки тонн инфы в течение короткого срока, для хранения временных файлов и т. д.), те и берут QLC, т. к. дёшево. Их же можно внедрять, например, в школьные или облачные компьютеры, где на самой железке ничего ценного, кроме оси и браузера, нет.

Для нормального использования, конечно, лучше всего TLC, а для тех мест, где требования к надёжности особые - MLC. Дешевеет всё.

Для нормального использования, конечно, лучше всего TLC

ну вот лет через несколько точно так же и про QLC говорить будут, как про TLC лет 5 назад было "кому нужен одноразовый SSD"

Уже и PLC flash из лабораторий выходит, как раз.

Ну, как видите, технологии прогрессируют - может, и QLC станут нормальными. PLC, очевидно, в первые годы будут столь же одноразовыми, а выше них точно ничего не будет.

а для тех мест, где требования к надёжности особые - MLC

даже в серверных накопителях mlc фактически не осталось (несколько старых моделей небольшого объёма с dwpd 10, не уверен даже, что они производятся, а не распродаются остатки)

Зачем тут ссылки на амазон?

Скорее всего потому что в "оригинале" были ссылки на Амазон

Потому что в статье рассматривается ситуация с ценами на SSD в мире, а не ситуация с накладными расходами форвардеров, везущих электронику в РФ. Если интересует последнее - лучше почитать вот эту статью

Затем же что и на newegg. Материал вероятно переводной.

Интересная статья. Сравнивая стоимость на Амазоне и на Яндекс.Маркете, получается, что наши продавцы накидывают около 50% на 1Тб Samsung 980 Pro и 25% на 2ТБ Samsung 980 Pro.

В принципе, понятно, что накладные идут за счет форвардеров, которым все равно, что 256GB, что 4TB везти, но все же жаба душит.

Есть вот такая красота.

Гуглите Industrial SLC SSD. Цены, в зависимости от бренда и объема, в среднем 8-18 баксов за гб.

Тем не менее. Я спрашивал про цену x3-x4 + десятки%, а не x100. За x100 я лучше на hdd посижу, спасибо. Потому что иначе это выглядит как «заплати столько-то или наш контроллер снесёт твои данные, используя TLC-режим».

Думаю тогда вам к серверным U2 дискам Samsung/micron, там хоть и tlc, но хороший tlc. А так же контроллер с коррекцией ошибок и пару конденсаторов для завершения записи при потере питания

хороший tlcХороший — это сколько циклов перезаписи?

Если брать самсунги, то +- столько же сколько на их консьюмерских решениях. Особенность серверных в том, что у них хорошая система обнаружения и исправления ошибок, а так же огромный запас по резервным ячейкам. В некоторых самсунгах запас доходит, если мне не изменяет память, до четверти объема. Но это не отменяет тот факт, что обычно у них ячейки живут больше заявленного срока жизни

Помнится, во времена chia-бума майнеры использовали режим pseudo-SLC, уменьшая доступный объём, увеличивали ресурс в несколько раз...

Вот, из комментов к статье "Разговор с майнером Chia, имеющим 1ПБ ёмкости" (с Хабра статья удалена, но поисковики помнят): команда resize, стр. 70

https://documents.westerndigital.com/content/dam/doc-library/en_us/assets/public/western-digital/collateral/user-guide/user-guide-essd-device-manager.pdf

Всё ещё есть в продаже samsung 970 pro. Это MLC безо всяких кэшей и с постоянной скоростью записи по всему объёму независимо от заполненности.

а что не так с надёжностью tlc?

у меня десятки серверных (и все современные — tlc), за много лет пока из отказов два микрона:

один у хостинг-провайдера по смарту начала расти температура, а потом пропал. что произошло не знаю, хостер просто заменил накопитель (но явно непохоже на проблемы с флеш-памятю, не находите?);

второй тоже микрон, ругался на смарт, тест чтения и записи проходил нормально. при этом данные smart были неконсистентными, поэтому решил перепрошить, после чего он умер )

да, именно эти два накопителя были не особо нагруженными.

до десктопным всё сильно зависит от моделей, бюджетные, как ни удивительно, сыпятся гораздо чаще )))

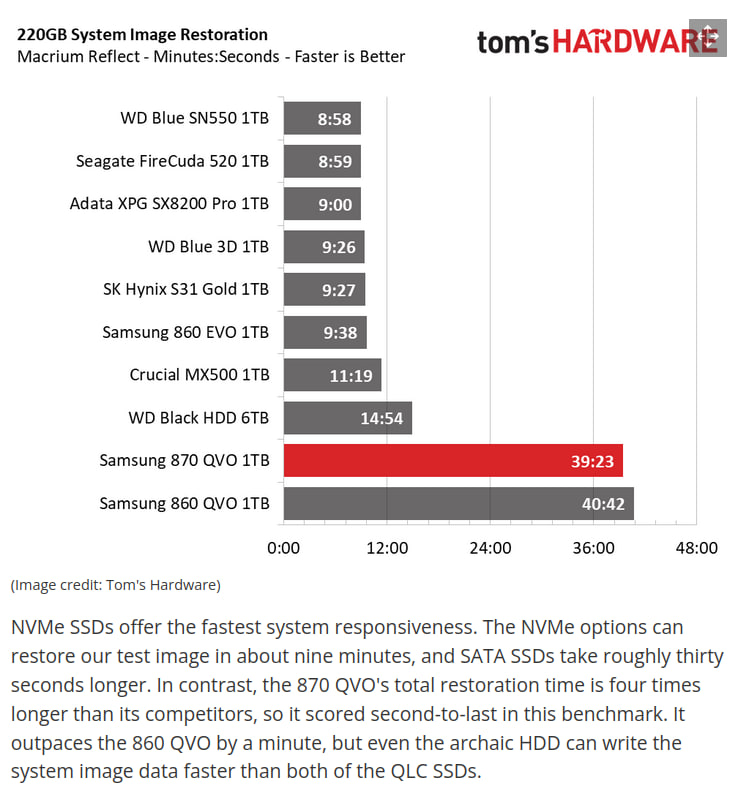

Про Samsung QVO, просто оставлю это здесь

Ниже… есть куда: SSD продолжают дешеветь, и текущая ситуация — не предел