В последнее время набирает популярность идея SDN (Software-defined Networking). На фоне данной концепции, а может и под её влиянием, развивается идея и SDS – Software Defined Storage. Данное направление выглядит перспективным и начинает активно развиваться, к примеру, выход в бета версии VSAN.

Я хотел бы рассказать о решении возможно знакомом многим, и отчасти похожем на VSAN, я говорю о компании Nutanix. Одним из интересных отличием является то, что VSAN 1.0 Beta и его разработка начата только в прошлом году, а Nutanix версии 3.5.2 и существует с 2009 года. Расскажу подробней про это решение.

Nutanix предлагает виртуальную вычислительную платформу для решений VMware vSphere, MS Hyper-V, KVM. Он объединяет вычислительные ресурсы серверов и корпоративную систему хранения в едином решении. Такой подход обеспечивает несколько преимуществ:

- Прогнозируемые расходы на инфраструктуру. Nutanix расширяется блоками и вы всегда сможете сказать сколько будет стоить система в 2, 4, 8 раз более производительная. Вам не придется менять контроллеры СХД на более мощные или докупать лицензии при переходе на более старшую модель СХД.

- Пошаговое расширение. Начав с 3-х узлов вы можете докупать их по необходимости. Без надобности сразу закладывать производительные контроллеры, если планируется быстрый рост требований к ресурсам.

- Упрощение архитектуры. В данном решении не требуется SAN и СХД, что упрощает администрирование.

- Высокая производительность. Использование оперативной памяти, SSD накопителей и локальных дисков позволяет добиться высокой скорости работы и минимальных задержек.

Изначально Nutanix возник как решение для VDI (Virtual Desktop Infrastructure). Потенциал самой платформы, развитие продукта и увеличение функционала вполне позволяют использовать его и для серверной виртуализации.

Пятиминутка маркетинга закончилась, давайте посмотрим, что это такое.

Решение представляет собой x86 серверы с локальными жесткими дисками процессорами памятью. Они выполнены в виде твин серверов 4/2U, 2/2U или один сервер на 2 юнита. Серверы подключаются к сети 10Gb/s (только младшая модель 1Gb/s) и используют данную сеть для всех коммуникаций. Совершенно ничего необычного тут нет, всю магию данного решения делает программное обеспечение. Честно говоря, использовать можно было бы любую платформу, но продается только в связке SW + HW.

Узлы доступны в нижеуказанных конфигурациях. Минимальное количество узлов для заказа 3 шт. В рамках одного кластера возможно использовать разные узлы. Докупать узлы можно поштучно.

| Модель | Процессор | Накопитель | Память | Количество ВМ | Сеть | ||

|---|---|---|---|---|---|---|---|

| NX-1000 Series | Per Node (4 per Appliance) | NX-1050 | 2x Intel Sandy Bridge E5-2620, 12 cores / 2.0 GHz | 400 GB SSD, 4x 1 TB HDDs | 64 GB или 128 GB | до 50 ВМ | 2x 10 GbE, 2x 1 GbE, 1x 10/100 BASE-T RJ45 |

| NX-3000 Series | Per Node (4 per Appliance) | NX-3050 | 2x Intel Ivy Bridge E5-2650v2 16 cores / 2.6 GHz | 2x 400 GB SSD, 4x 1 TB HDDs | 128 GB или 256 GB | до 100 ВМ | 2x 10 GbE, 2x 1 GbE, 1x 10/100 BASE-T RJ45 |

| NX-3051 | 2x 800 GB SSD, 4x 1 TB HDDs | ||||||

| NX-3060 | 2x Intel Ivy Bridge E5-2680v2, 20 cores / 2.8 GHz | 2x 400 GB SSD, 4x 1 TB HDDs | 128 GB, 256 GB или 512 GB | до 115 ВМ | |||

| NX-3061 | 2x 800 GB SSD, 4x 1 TB HDDs | ||||||

| NX-6000 Series | Per Node (2 per Appliance) | NX-6020 | 2x Intel Ivy Bridge E5-2630v2, 12 cores / 2.6 GHz | 1x 800 GB SSD 5x 4 TB HDDs | 32 GB, 64 GB, 128 GB или 256 GB | до 75 ВМ | 2x 10 GbE, 2x 1 GbE, 1x 10/100 BASE-T RJ45 |

| NX-6050 | 2x Intel Sandy Bridge E5-2670, 16 cores / 2.6 GHz | 2x 400 GB SSD, 4x 4 TB HDDs | 128 GB или 256 GB | до 100 ВМ | |||

| NX-6060 | 2x Intel Ivy Bridge E5-2680v2, 20 cores / 2.8 GHz | 128 GB, 256 GB или 512 GB | до 115 ВМ | ||||

| NX-6070 | 2x Intel Sandy Bridge E5-2690, 16 cores / 2.9 GHz | 2x 800 GB SSD, 4x 4 TB HDDs | 128 GB или 256 GB | до 110 ВМ | |||

| NX-6080 | 2x Intel Ivy Bridge E5-2690v2, 20 cores / 3.0 GHz | 128 GB, 256 GB или 512 GB | до 115 ВМ | ||||

| NX-7000 Series | Single Node (1 per Appliance) | NX-7110 | 2x Intel Ivy Bridge E5-2680v2, 20 cores / 2.8 GHz | 2x 400 GB SSD, 6x 1 TB HDDs | 128 GB или 256 GB | Users – GRID K1 vSGA: 8-64, GRID K2 vSGA: 6-48, GRID K2 vDGA: 6; 3x PCIe expansion slots; Up to 2x GRID K1, 3x GRID K2, 1x APEX | 2x 10 GbE, 2x 1 GbE, 1x 10/100 BASE-T RJ45 |

Особо хочу выделить модель NX-7110. Она позволяет устанавливать карты Nvidia Grid K1/K2 и используется для высоконагруженного VDI. Основная линейка это серия NX-3000. Серия NX-6000 отличается большим объемом SATA дисков.

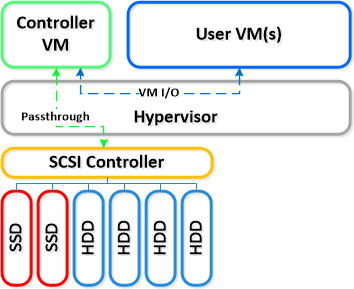

На каждый из узлов устанавливается стандартный гипервизор, и на нем разворачивается ПО Nutanix в виде виртуальной машины. Апплайнс который установлен на каждый узел, использует часть вычислительных ресурсов сервера и «забирает» все жесткие диски, использую PCI-E Pass-through. Соответственно гипервизор не видит диски.

Далее узлы Nutanix (ВМ) объединяются в кластер, узлы называются Controller VM — CVM. Сделать это можно одной командой на любом из узлов или через WEB-интерфейс управления. В принципе, в данный момент СХД готова к работе, остается только презентовать место гипервизорам. Презентация осуществляется по-разному и только «своим» гипервизорам, где есть ВМ Nutanix. В случае VMware – это NFS; Hyper-V – SMN 3.0; KVM – iSCSI.

Что происходит между этими двумя событиями, как это работает?

В общих чертах ответить на этот вопрос может данное видео:

В дополнении к видео хочу рассказать об основных фичах продукта (но не всех) и о принципе работы чуть подробнее.

- Доступность данных.

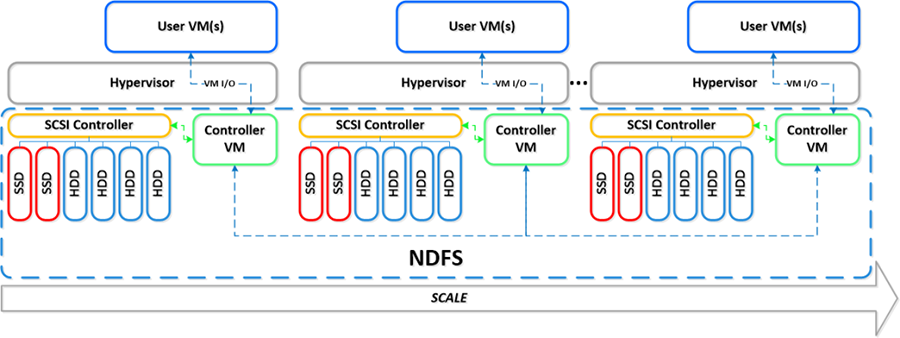

Для управления ресурсами хранения используется Nutanix Distributed Filesystem (NDFS) – распределенная файловая система Nutanix. Она контролирует операции чтения и записи данных, гарантирует целостность данных и резервирует их для защиты от выхода из строя диска или узла. С операциями чтения всё понятно, они происходят по возможности локально. Единственное исключение — это перемещение виртуальной машины. В этом случае узел, на который виртуальная машина переехала, не будет иметь её полной копии. И для операций чтения он будет по сети запрашивать данные с других узлов и в фоновом режиме восстанавливать полную копию у себя. А вот для обеспечения отказоустойчивости необходимо реплицировать данные на другие узлы. Как это происходит: во-первых, необходимо сохранить метаданные. Для этого используется сервисная роль на каждом из узлов (модифицированый Apache Cassandra, для обеспечения консистентности данных — алгоритм Паксос).

Для защиты самих данных используется синхронная репликация между узлами. Nutanix использует такое понятие, как Фактор Репликации (replication factor (RF) — по умолчанию он равен двум. Соответственно, каждый вновь записанный блок имеет две копии: одну локальную, одну на другом узле. В данный момент из командной строки можно поменять RF для каждой ВМ, установив его значение 3, к примеру, мы будем иметь копии на трех узлах. - Производительность.

Высокая скорость работы (IOPS и низкие задержки) в первую очередь обеспечена тем, что большая часть данных хранится локально. Каждый гипервизор имеет свой контроллер в виде CVM, что минимизирует задержки на передачу данных по сети. Помимо этого «горячие» блоки кэшируются в оперативной памяти и на SSD. Операции записи идут на SSD, для этого на диске выделена область кеширования – Oplog. Далее данные распределяются между SATA и SSD. Возможна конфигурация, когда последовательные операции записи пропускают Oplog и идут на SATA диски. Тиринг перемещает данные между SSD и SATA дисками, как это обычно бывает на основе частоты запросов к блокам данных.

Помимо этого возможно включение дедупликации данных, которая снижает занимаемый объем на SSD и в оперативной памяти. Дедупликация как и онлайн компрессия уже включены в стоимость.

К слову о лицензировании и стоимости: отдельно лицензируются две опции – репликация и пост компрессия. Репликация стоит отдельного упоминания. Помимо самого механизма передачи данных, репликация Nutanix, включает в себя механизм автоматизации запуска ВМ на удаленный площадке. По своему функционалу конечно он не сравнится с VMware Site Recovery Manager. Но учитывая, что он лицензируется на узел, а не ВМ, может быть весьма интересен для отдельных сценариев. Производительность на примере VDI в цифрах — Estimated Sizing Guidelines for VDI Deployments.

Стоимость: Мы не можем раскрыть информацию о фактической цене, но по опыту расчётов могу сказать так, в итоге стоимость решения на Nutanix выходит значительно дешевле, чем решение классической архитектуры из 4 двухпроцессорных серверов + СХД (уровня VNX5200, 3PAR 7200) с аналогичным размером SSD/HDD. Оформив заказ в течении недели с момента этой публикации и указав ключевое слово — «Зуммер» и получите скидку до 20% (размер скидки зависит от общей стоимости вашего заказа).

Хочу напомнить, что Вы можете взять данное оборудование у нас в Demo на тестирование. По всем вопросам по Nutanix обращайтесь к нашему руководителю направления — Владимиру Подымову.