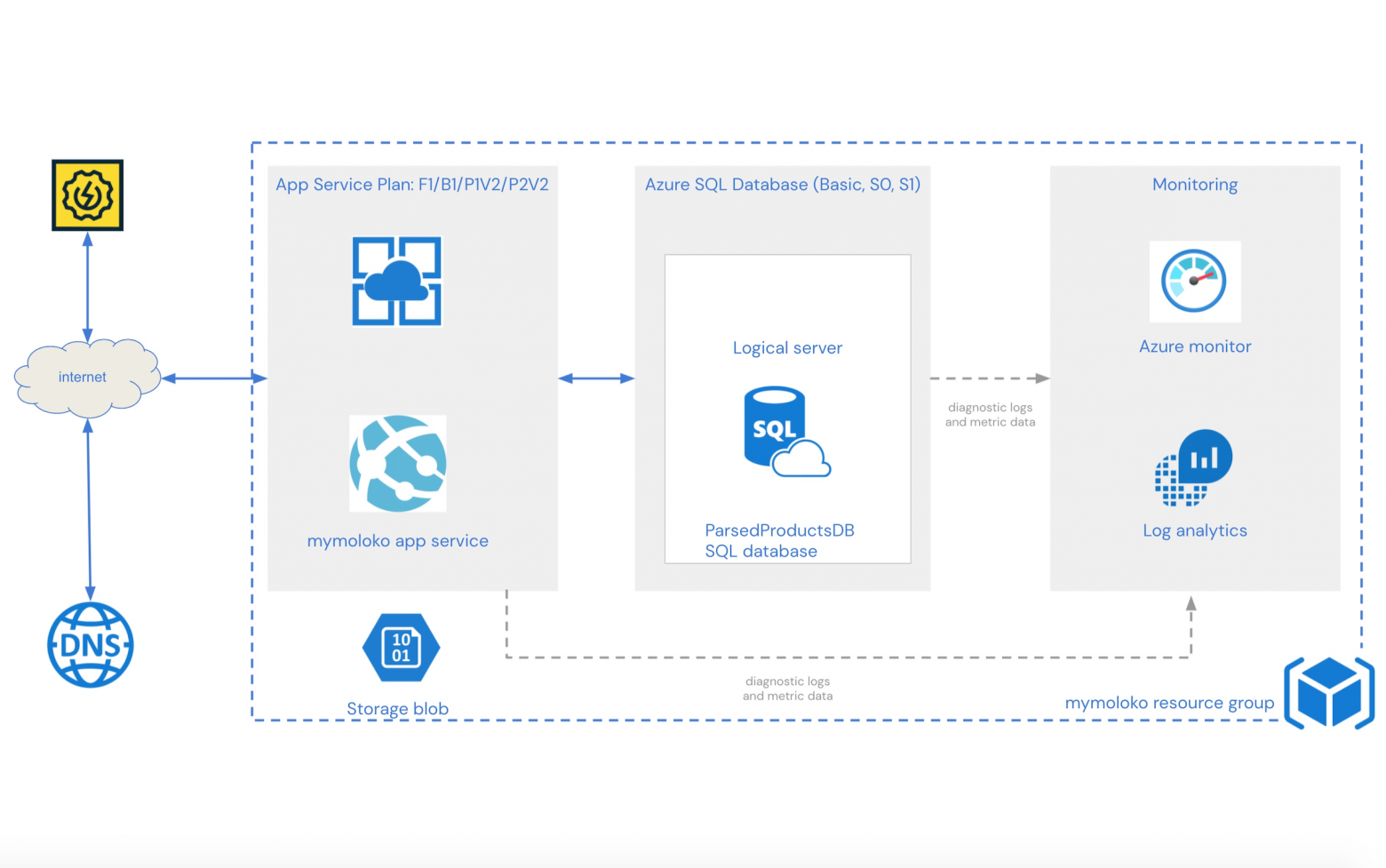

Пастух больших данных: как мы используем Azure Data Factory в качестве единого сервиса для задачи миграции

Многие в ходе проектов сталкиваются с проблемой импорта большого количества данных из источников в облако. Традиционно вопрос решается с помощью различных инструментов, таких как Microsoft SQL Server Integration Services, Oracle data Integrator, средствами СУБД или кастомных разработок. Мы в ГК «КОРУС Консалтинг» много работаем с облачной средой Microsoft Azure. В этой статье хочу поделиться нашим опытом использования Azure Data Factory в качестве единого сервиса для задачи миграции больших объемов данных.

Azure Data Factory позволяет производить интеграцию из разных источников данных с помощью одного инструмента, а также имеет более 400 встроенных коннекторов к внешним источникам. И больше не надо ломать голову и писать их с нуля.