Big Data *

Большие данные и всё о них

Искусственный интеллект, вызовы и риски – глазами инженера

Танцующие инженеры, тщетно надеющиеся исцелиться

Приглашаем на Moscow Data Science Meetup 25 ноября

25 ноября в московском офисе Mail.Ru Group пройдет традиционная встреча сообщества Moscow Data Science. Участники поделятся профессиональным опытом решения практических задач анализа данных и пообщаются в неформальной обстановке. Встреча будет посвящена глубокому обучению. Присоединяйтесь!

Класс удаленного прокси — это не (очень) больно

(Динамическая диспетчеризация спешит на помощь)

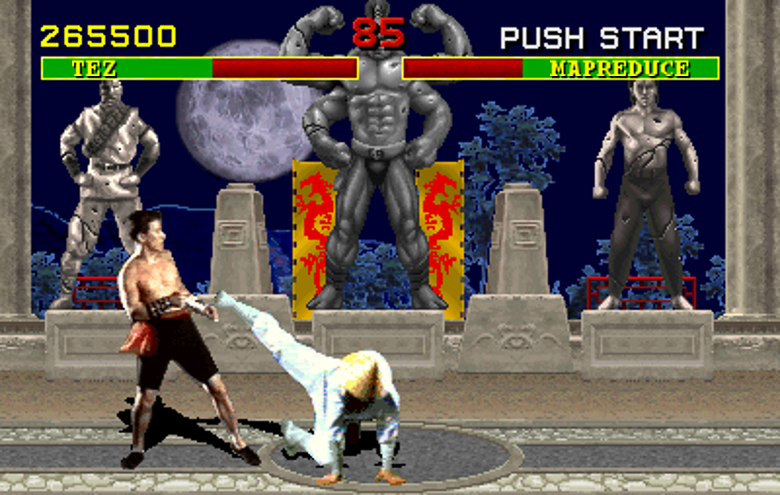

После нескольких статей про MapReduce нам показалось необходимым еще раз отойти в сторону и поговорить про инфраструктуру, которая поможет облегчить построение решения MapReduce. Мы, по-прежнему, говорим про InterSystems Caché, и, по-прежнему, пытаемся построить MapReduce систему на базе имеющихся в системе подручных материалов.

На определенном этапе написания системы, типа MapReduce, встает задача удобного вызова удаленных методов и процедур (например, посылка управляющих сообщений с контроллера на сторону управляемых узлов). В среде Caché есть несколько простых, но не очень удобных методов достичь этой цели, тогда как хочется бы получить именно удобный.

12 кейсов по биг дате: подтвержденные примеры из индустрии, когда биг дата приносит деньги

Кстати, совсем скоро у нас стартует первый набор программы Big Data for Executives, цель которой подготовить руководителя или владельца бизнеса к использованию данных в своей деятельности. Почитать о ней подробнее можно здесь.

Рекомендации на основе изображений товаров

В данной статье я хотел бы рассмотреть на практике вариант построения простейшей рекомендательной системы основанной на схожести изображений товаров. Этот материал предназначен для тех, кто хотел бы попробовать применить Deep Learning, а именно свёрточные нейронные сети, в простом, интересном и практически применимом проекте, но не знает с чего начать.

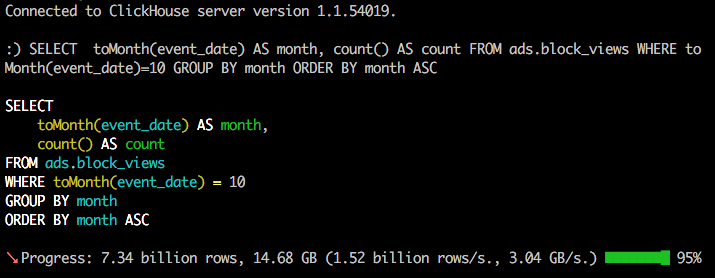

Как запустить ClickHouse своими силами и выиграть джекпот

Мы решили описать простой и проверенный путь для тех, кто хочет внедрить аналитическую СУБД ClickHouse своими силами или просто испробовать ClickHouse на собственных данных. Именно этот путь прошли мы сами в новостном агрегаторе СМИ2 и добились впечатляющих результатов.

В предисловии статьи — небольшой рассказ о наших попытках внедрить Druid и InfluxDB. Почему после успешного запуска ClickHouse мы смогли отказаться от использования InfiniDB и Cassandra.

Как подружить Bagri и MongoDB

После достаточно неплохого отклика, решил написать статью о том как можно наращивать функционал Bagri путем написания расширений (extensions) используя встроенный API системы.

Интервью с вице-президентом по технологической стратегии компании MapR

Много ли надо, чтобы сделать стартап с использованием больших данных и ИИ?

MapReduce из подручных материалов. Часть III – собираем все вместе

В первой (достаточно капитанской) части этой серии мы рассказали про базовые концепции MapReduce почему это плохо, почему это неизбежно, и как с этим жить в других средах разработки (если вы не про Си++ или Java). Во второй части мы-таки начали рассказывать про базовые классы реализации MapReduce на Caché ObjectScript, введя абстрактные интерфейсы и их первичные реализации.

Сегодня пришел наш день! – мы покажем первый пример собранный в парадигме MapReduce, да, он будет странный и не самый эффективный, и совсем не распределенный, но вполне MapReduce.

Создание разделяемого хранилища на базе CEPH RBD и GFS2

Применение R для подготовки и передачи «живой» аналитики другим бизнес-подразделениям

В этой краткой заметке хочу поделиться еще одним вариантом использования R в повседневных бизнес задачах. Этот «use-case» актуален почти для всех компаний, вне зависимости от их размера. Речь идет о подготовке различных оперативных отчетов и аналитических срезов.

Ближайшие события

Как собрать биграммы для корпуса любого размера на домашнем компьютере

Как писать меньше кода для MR, или Зачем миру ещё один язык запросов? История Yandex Query Language

Очень скоро мы поняли, что тут мог бы здорово помочь общий высокоуровневый язык запросов, который бы предоставлял единообразный доступ к уже имеющимся системам, а также избавлял от необходимости заново реализовывать типовые абстракции на низкоуровневых примитивах, принятых в этих системах. Так началась разработка Yandex Query Language (YQL) — универсального декларативного языка запросов к системам хранения и обработки данных. (Сразу скажу, что мы знаем, что это уже не первая штука в мире, которая называется YQL, но мы решили, что это делу не мешает, и оставили название.)

В преддверии нашей встречи, которая будет посвящена инфраструктуре Яндекса, мы решили рассказать о YQL читателям Хабрахабра.

Сравнение аналитических in-memory баз данных

В последние два месяца лета в управлении хранилищ данных (Data Warehouse, DWH) Тинькофф Банка появилась новая тема для кухонных споров.

В последние два месяца лета в управлении хранилищ данных (Data Warehouse, DWH) Тинькофф Банка появилась новая тема для кухонных споров. Всё это время мы проводили масштабное тестирование нескольких in-memory СУБД. Любой разговор с администраторами DWH в это время можно было начать с фразы «Ну как, кто лидирует?», и не прогадать. В ответ люди получали длинную и очень эмоциональную тираду о сложностях тестирования, премудростях общения с доселе неизвестными вендорами и недостатках отдельных испытуемых.

Подробности, результаты и некое подобие выводов из тестирования — под катом.

Когда старый MapReduce лучше нового Tez

Как всем известно, количество данных в мире растёт, собирать и обрабатывать поток информации становится всё сложнее. Для этого служит популярное решение Hadoop c идеей упрощения методов разработки и отладки многопоточных приложений, использующее парадигму MapReduce. Эта парадигма не всегда удачно справляется со своими задачами, и через некоторое время появляется «надстройка» над Hadoop: Apache Tez с парадигмой DAG. Под появление Tez подстраивается и HDFS-SQL-обработчик Hive. Но не всегда новое лучше старого. В большинстве случаев HiveOnTez значительно быстрее HiveOnMapReduce, но некоторые подводные камни могут сильно повлиять на производительность вашего решения. Здесь я хочу рассказать, с какими нюансами столкнулся. Надеюсь, это поможет вам ускорить ETL или другой Hadoop UseCase.

Школа Данных «Билайн», на Неве

Привет, Хабр! Вы уже не раз слышали про то, что мы проводим курсы машинного обучения и анализа данных в Школе Данных «Билайн». Сегодня мы отмечаем уже 6-й выпуск на нашем аналитическом курсе и 4й — на курсе для менеджеров. Только успев выпустить один курс — мы набираем новый. После каждого очередного выпуска мы собираем обратную связь от наших слушателей, анализируем ее и делаем нашу программу еще более насыщенной практикой и примерами из реального бизнеса.

Нам пишут со всей страны и из-за ее пределов с вопросами, когда Школа Данных появится в их городе. Мы откликнулись на эти пожелания и расширяем наше присутствие.

Сегодня мы рады объявить о запуске нашей программы в Петербурге! Мы собрали самых лучших преподавателей в этой славном городе, подготовили замечательную программу и в этом посте расскажем все подробности обучения.

Курс начинается 28-го октября, будет проходить по понедельникам и пятницам в вечернее время с 19.00 до 21.00 в офисе компании «Билайн» по адресу Васильевский остров, 21 линия, д. 6, литер А (ближайшая станция метро «Василеостровская»).

Впереди нас ждет 18 занятий (курс рассчитан на 9 недель), на которых мы постараемся покрыть самые важные темы анализа данных.

Многоуровневый подход NoSQL к обеспечению безопасности больших данных

Обзор курсов по Deep Learning

Вклад авторов

moat 815.0Aleron75 528.0Syurmakov 524.4alexanderkuk 501.03Dvideo 490.0i_shutov 488.0m31 483.2shukshinivan 460.0s_valuev 446.0o6CuFl2Q 445.0