Весной и осенью от имени IAB Russia выпускается карта экосистемы инернет-рекламы и мобильной рекламы. По состоянию на 22 апреля (в версии, приуроченной к РИФ 2014) вкладка веб-аналитики на ней выглядит так.

В нынешние времена то, что раньше было фактоидом (то есть событием, существующим только в мире медиа), уже выполняет функцию факта, вот как и эта карта русского digital. Хотя любому видно, что на схему, где столь мало места для логотипов, попали некоторые нераспространенные у нас средства веб-аналитики, и не попали системы, которые действительно заметны в Рунете.

Нам, Openstat, очень легко подкрепить интуитивное ощущение точными данными количества доменов с установленными системами веб-аналитики — фактами. У нас есть отчеты, полученные краулером Openstat, который обнаружил интернет-счетчики почти на 2 млн. сайтах.

С августа 2013 года краулер Openstat индексирует Рунет, Байнет, Уанет. Общий объем анализируемых данных 5,69 млн. хостов, но фактически краулер индексирует 4,6 млн. «живых» доменов Рунета, дающих ответ 200 Ok. На проиндексированных страницах выделено около одной тысячи сигнатур, соответствующих электронным способам оплаты, CMS, кодам рекламных сетей, средств веб-аналитики и т.д. Собирается также много технометрик, для которых также можно найти подходящие хабы на Хабре. В результате обработки подобных данных составляются различные отраслевые отчеты, с указанием, к примеру, числа сайтов с формами оплаты электронных денег, карт на сайт или интернет-счетчиков, которые стали темой этой записи.

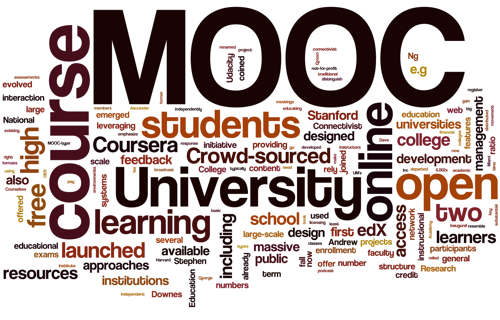

В последнее время на слуху феномен «муков» (MOOC) – массовых открытых онлайн курсов. Платформ для них создано большое множество.

В последнее время на слуху феномен «муков» (MOOC) – массовых открытых онлайн курсов. Платформ для них создано большое множество.