Facebook как один из мировых лидеров в разработке технологий искусственного интеллекта нашёл прикладное применение для этих программ: фильтрация общения людей. Передовые инновации внедряют в социальной сети Instagram (см. пресс-релиз Instagram, а также репортаж в Time с комментарием Йоава Шапиры, ведущего разработчика нейросетевых классификаторов травли).

Самая интересная из новых функций — что «грубого человека» можно заблокировать так, что он даже этого не заметит. Пользователь продолжит хамить, но его опубликованные сообщения будут видны только ему одному. Это идеальный вариант, чтобы не блокировать грубияна и не обострять ситуацию. Впрочем, конкретно эта функция не связана с системой ИИ.

Как сказано в пресс-релизе, в ближайшее время Instagram представит новые функции, «направленные на сдерживание онлайн-буллинга» (травли). Это происходит в то время, когда во всём мире растут призывы усилить контроль за такими платформами, как Facebook и Twitter, на фоне критики за распространение ненависти и фейковых новостей, а также за широко распространённую агрессию и грубость в комментариях.

Instagram с аудиторией в 500 миллионов человек является платформой, ориентированной на изображения. Здесь пользователи размещают фотографии и видео, которые затем прокомментируют другие пользователями.

Сейчас компания заявила, что в течение многих лет использует ИИ для мониторинга травли и вредоносного контента, а теперь представляет интерфейс непосредственного взаимодействия этого ИИ с пользователями.

Две новые функции

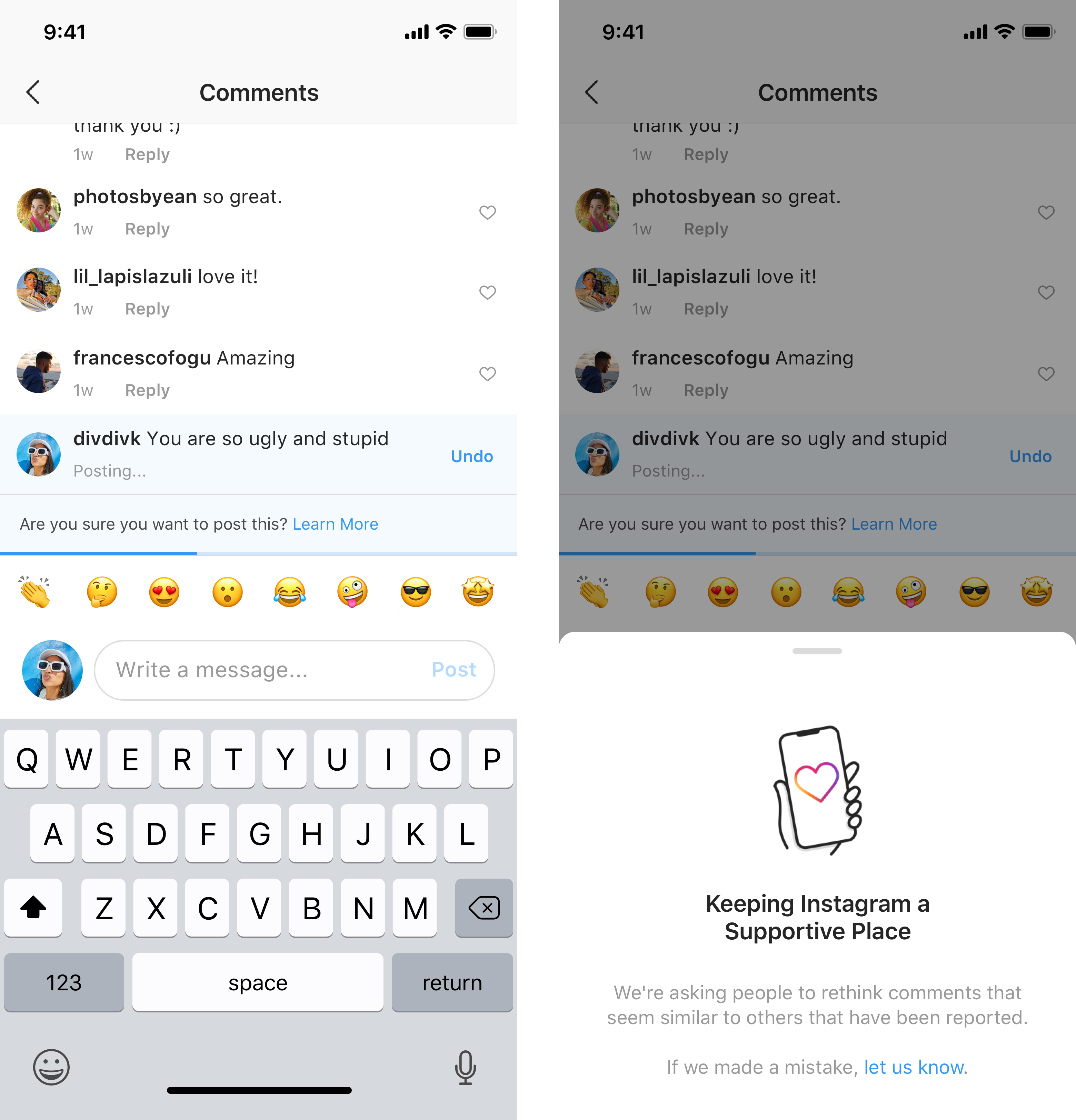

Во-первых, это технология мгновенного обнаружения, когда пользователь пытается опубликовать что-то оскорбительное. Система будем выдавать предупреждение перед публикацией. «Это вмешательство даёт людям возможность задуматься и отменить свой комментарий, — говорится в заявлении руководителя Instagram Адама Моссери. — Из ранних тестов этой функции мы обнаружили, что она побуждает некоторых людей отменить свой комментарий и поделиться чем-то менее вредным, как только у него появляется возможность подумать».

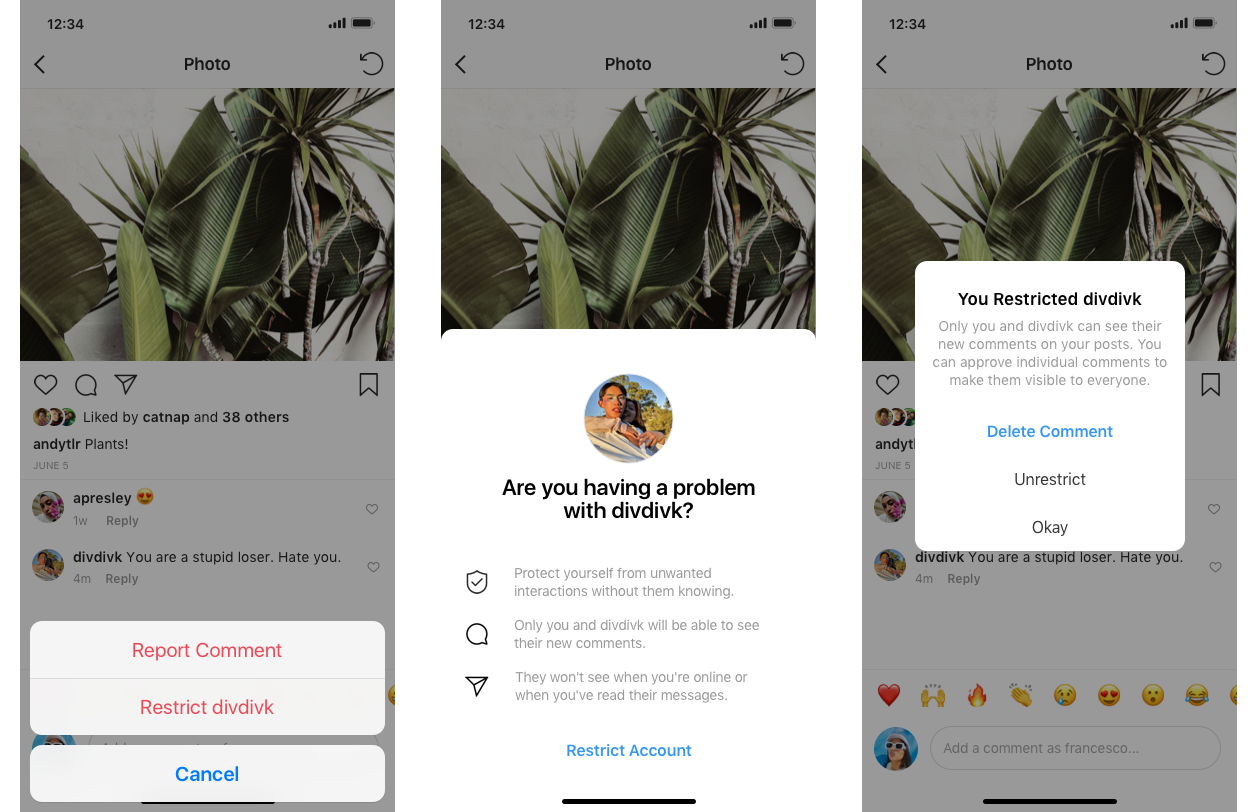

Другая новая функция — «Ограничение» (Restrict) — направлена на ограничение оскорбительных комментариев в ленте пользователя. «Мы слышали от молодых людей в нашем сообществе, что они не хотят ни блокировать, ни удалять из фоловеров, ни сообщать о хулигане, потому что это может обострить ситуацию, особенно если они взаимодействуют с ним в реальной жизни», — сказал Моссери.

Теперь появился новый вариант: сделать так, что посты обидчика будут видимы только ему. Грубияна переводят в «ограниченный» (restricted) режим, то есть он буквально становится «ограниченным пользователем».

Шаг 1. Вы видите комментарий грубияна

Шаг 2. Вы удаляете комментарий и переводите грубияна в режим Restricted

«Ограниченные люди не смогут видеть, когда вы активны на Instagram или когда вы прочитали их прямые сообщения», — добавил Моссери.

Шаг Instagram должен помочь защитить особенно подростков. Согласно опросу, опубликованному исследовательским центром Pew Research Center в прошлом году, 72% подростков США заявили, что они использовали Instagram.

Запугивание и травля — лишь один из многих фронтов, на которых от социальных сетей требуют действий в последние годы. Растут призывы к регулированию таких платформ в связи с распространением сообщений, разжигающих ненависть, и фейковых новостей.

Такие компании, как Facebook, в ответ на это начали изменять политику и внедрять функции, направленные на повышение прозрачности и безопасности. Пока получается с переменным успехом, но без давления общества не было бы и этого.

Искусственный интеллект

В интервью Time представители Instagram сказали, что для фильтрации грубого поведения и издевательств в будущем они полагаются на технологии искусственного интеллекта, чтобы полностью искоренить травлю, издевательства и неуважение. Молодые люди сейчас зачастую запуганы и стесняются, бояться сообщить о неподобающем поведении, дать отпор группе хулиганов или заблокировать их. В будущем им не придётся этого делать: система ИИ сама позаботится о слабых.

Создание искусственного интеллекта для борьбы с грубостью — это своеобразный технический Эверест, пишет Time. Это означает обучение машин пониманию проблемы со сложными нюансами. Instagram также должен опасаться проблем со свободой слова, поскольку инженеры создают инструменты, которые оптимизированы для поиска того, что надо, не фильтруя лишнего: «Я беспокоюсь, что если мы не будем осторожны, то можем переступить грань», — говорит Адам Моссери, глава Instagram. Однако он готов принимать решения, которые означают снижение активности пользователей в Instagram, если это повышает безопасность.

Сайт для обмена фотографиями практически с самого начала начали использовать извращенцы. 20-летние основатели компании Кевин Систром и Майк Кригер целыми днями лично удаляли неприятные комментарии и блокировли троллей. Затем они применили инструмент ИИ, известный как DeepText, разработанный для понимания и интерпретации языка.

Инженеры Instagram впервые использовали DeepText в 2016 году для поиска спама. В 2017 году его обучили находить и блокировать оскорбительные комментарии, включая расовые оскорбления. К середине 2018 года программа — по сути, набор нейросетей, — обучили находить в комментариях также и травлю, то есть умышленную грубость. В октябре 2018 года компания объявила, что система ИИ будет анализировать не только комментарии, но и сами посты.

Когда инженеры хотят научить машину выполнять ту или иную задачу, они начинают с создания обучающего набора — набора простых терминов, набора материала, который поможет машине понять правила её новой работы. В этом случае поиск начинается с того, что модераторы сортируют сотни тысяч фрагментов контента и решают, содержат они издевательства или нет. Они помечают их и вводят примеры в так называемый классификатор. Конечно, эти начальные примеры не могут охватить всё, с чем столкнётся классификатор в реальной жизни. Но он помечает контент и как люди-модераторы тоже учится на дополнительных примерах. В идеале, с помощью инженеров, настраивая свои привычки изучения, он становится всё лучше и лучше с течением времени.

Сегодня Instagram использует для сканирования контента три отдельных классификатора травли. Один обучен на распознавание оскорбляющего текста, второй — фотографий, третий — видео. Классификаторы уже живут в нормальном режиме: работают, ищут и помечают контент. Тем не менее, они пока находятся «на довольно ранней стадии разработки», говорит ведущий инженер Йоав Шапира. Другими словами, они пропускают много издевательств, и не обязательно находят оскорбления. То есть допускают много ложноположительных и ложноотрицательных срабатываний.

Распознать грубости сложнее, чем обучить нейросеть, например, находить наготу, поскольку гораздо легче распознать, когда кто-то на фотографии не носит штаны, чем распознать широкий спектр поведения, которое может считаться издевательством. Исследования киберзапугивания сильно различаются в своих выводах о том, сколько людей испытали его, от 5% до 72%, отчасти потому, что никто не согласен с тем, что это такое. «То, что делает издевательства настолько трудными для решения, заключается в том, что определение настолько отличается у разных людей», — говорит Карина Ньютон, глава по публичной политике Instagram.

Другими словами, какое-то замечание может глубоко оскорбить одного человека, а другой воспримет его абсолютно нейтрально и спокойно, то есть вообще не примет за оскорбление.

А инженерам нужно дать чёткие инструкции, что квалифицируется как травля, а что нет, чтобы построить надёжный набор данных для обучения.

Формы издевательств в Instagram со временем изменились, пишет Time. Есть много того, что можно назвать «старомодными издевательствами»: это самые распространённые комментарии, оскорбления и угрозы, согласно собственным исследованиям Instagram. Некоторые из них легко обнаружить. Текстовый классификатор, например, хорошо обучен искать предложения типа «Ты уродливая задница, сука с зубами» (you ugly ass gapped tooth ass bitch) или «Твоя дочь шлюха» (Your daughter is a slag). Но сленг меняется со временем и в разных культурах, особенно в молодёжной. А для выявления агрессивного поведения требуется осмысление полных предложений, а не только нескольких слов. Есть разница между «Я приду позже» и «Я приду позже, что бы ты ни говорил».

Пользователи Instagram также становятся жертвами агрессивного поведения, которое выходит за рамки слов. На сайте есть так называемые «страницы ненависти», анонимные учётные записи, посвященные высмеиванию людей. Парень может поставить тег своей бывшей девушки на сообщениях, где он с другими девушками. Или девушка может пометить кучу друзей в сообщении и демонстративно исключить кого-то. Другие могут сделать скриншот чьей-то фотографии, изменить её или просто издеваться над ней в групповом чате. Есть повторяющийся контент как оскорбление — например, размещение одного и того же смайлика на каждой фотографии, которую публикует человек, что имитирует преследование. Многие подростки находят неловкие фотографии или видео со своим участием, размещённые без их согласия, или оказываются предметом голосования HotOrNot (примерно такую голосовалку под названием Facemash создал Марк Цукерберг, будучи студентом Гарварде на веб-сайте, который позже был переименован в Facebook).

В рамках своих усилий по разработке эффективного ИИ Instagram сейчас проводит опрос тысяч пользователей в надежде лучше понять все формы, которые могут принимать издевательства, в глазах аудитории. Ответы также помогут Instagram оценить распространённость издевательств на платформе. Эти данные впервые будут обнародованы в этом году.

Сейчас для обучения классификатора команда Шапиры разбила травлю на семь подкатегорий:

- оскорбления,

- пристыживания,

- угрозы,

- атаки на личность,

- неуважение,

- нежелательные контакты,

- измены.

Грандиозный план заключается в создании искусственного интеллекта, который обучен понимать каждую концепцию.

Поскольку издевательства могут быть привязаны к внутреннему контексту и тому, насколько хорошо два человека знают друг друга, инженеры Instagram также исследуют способы анализа активности и историю пользователей. Например, слово «хо», может быть классифицировано как издевательство, когда мужчина говорит это женщине, но не когда женщина использует его для приветствия друга. Точно так же, если кто-то однажды скажет «потрясающая картинка», это может быть комплиментом. Но если они говорят это на каждой фотографии, которую публикует человек, то это начинает выглядеть подозрительно.

Инженеры извлекают выгоду из сигналов, которые помогают выявить эти отношения: часто ли две учётные записи ставят метки друг у друга? Кто-нибудь из них когда-то в прошлом блокировал другого? Является ли имя пользователя похожим на того, кто был заблокирован в прошлом? Есть ли признаки скоординированных действий с другими пользователями?

Когда дело доходит до фотографий и видео, у классификаторов меньше практики и они менее продвинуты. Инженеры и модераторы пока идентифицируют шаблоны, но некоторые ориентиры уже появились. Например, экран, разделённый на две половины, часто является признаком издевательств, особенно если машина обнаруживает на одной стороне человека, а на другой — животное. Как и фотография трёх человек, где лицо одного из них перечёркнуто. Команда также учится понимать такие факторы, как осанка. Скорее всего, фотография была сделана без согласия, если она выглядит как снимок «под юбкой». Если один человек стоит, а другой находится в позе жертвы, это красный флаг.

Каждую неделю исследователи отчитываются о своих находках, и почти каждую неделю появляется какая-то новая форма издевательств, которую инженеры раньше и не думали искать, говорит Шапира. Но Facebook и Instagram уверены, что способны справиться с этими проблемами.

Неизвестно, сколько из примерно 1200 сотрудников Instagram или примерно 37 700 сотрудников Facebook работают над проектом.

Ведущий разработчик также отказался сообщить текущий процент ошибок классификаторов и объём контента, который они помечают для модераторов. «В ближайшие год-два будет намного лучше», — только сказал Йоав Шапира.