Компания NVIDIA выпускает новый коммерческий продукт — NVIDIA Parallel Nsight, который представляет собой пакет инструментов интегрирующихся в Visual Studio 2008 SP1. NVIDIA Parallel Nsight предлагает инструменты для разработки параллельных приложений использующих на полную мощность возможности многоядерных процессоров и современных ускорителей GPU.

В возможности нового продукта входят:

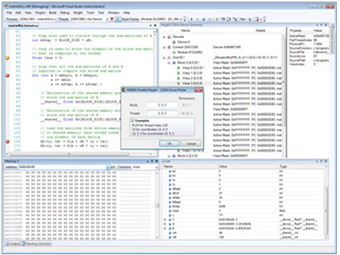

- мощный отладчик с возможностью просмотра тысяч параллельно исполняющихся потоков;

- отладка кода напрямую на GPU;

- просмотр памяти GPU напрямую в Visual Studio;

- обнаружение утечек памяти с помощью инструмента CUDA C/C++ Memory Checker;

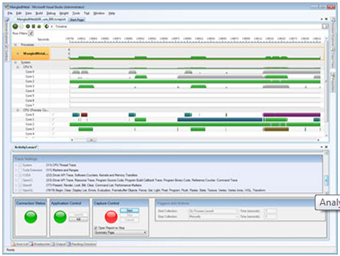

- анализатор событий времени исполнения кода с захватом вызовов API, запуском ядра, обмена памятью;

- подробная визуализация всех событий в окне Visual Studio;

- фильтрация и сортировка событий с помощью инструментов построения отчетов;

- профилирование CUDA с помощью счетчиков производительности GPU;

- графические инструменты и отладчик с отладкой шейдеров HLSL прямо на GPU;

- отладка любого графического или шейдерного приложения;

- графический инспектор с обнаружением вызовов DirectX в реальном времени;

- интерактивная проверка состояния конвейеров GPU, визуализация текстур, геометрии и вычислительных буферов;

- профилировщик, который позволит определить узкие места и потребление ресурсов CPU.

NVIDIA Parallel Nsight будет поставляется в двух вариантах: Standard и Professional (содержит анализатор). Пока, на время выпуска предварительной версии, для загрузки доступна версия Parallel Nsight 1.0 Professional.

Сведения о лицензировании продукта можно найти на этой странице. Обратите внимание: участники академической программы смогут лицензировать инструмент бесплатно.

Ожидается, что со временем инструменты получат обновление и поддержку Visual Studio 2010.