Сегодня у нас на столе новый рэковый сервер Cisco UCS C240 пятого поколения.

Что делает интересным для анбоксинга именно этот сервер Cisco, с учетом того, что перед нами уже его пятое поколение?

Во-первых, серверы Cisco теперь поддерживают последнее поколение процессоров Intel Scalable второго поколения. Во-вторых, теперь можно установить модули Optane Memory для использования множества NVMe-накопителей.

Встают резонные вопросы: разве сервера других вендоров так не умеют? Что в этом такого, ведь это просто x86 сервер? Обо всем по порядку.

Кроме задач отдельно стоящего сервера, Cisco C240 M5 может стать частью архитектуры Cisco UCS. Здесь мы говорим о подключении к FI и полном управлении серверами силами UCS Manager, включая Auto Deploy.

Итак, перед нами “железный” сервер Cisco, пятое его поколение, более 10 лет на рынке.

Сейчас мы откатимся к основам, вспомним, из каких компонентов состоит сервер, и что делает Cisco C240 M5 не просто современным, а по-настоящему передовым.

Давайте посмотрим, что входит в комплект поставки.

Содержание коробки: сервер, KVM Dongle, документы, диск, 2 кабеля питания, монтажный комплект.

Снимаем крышку. Нажимаем, сдвигаем и всё. Никаких отверток и теряющихся болтиков.

Сразу в глаза бросаются зеленые ярлычки. Все элементы, которые поддерживают горячую замену, обладают ими. Например, легко можно без выключения питания всего сервера произвести замену вентиляторов.

Также видим массивные радиаторы, под которыми скрываются новые процессора Intel Scal 2 Gen. Заметим, что это до 56 ядер на 2U-сервер без каких-либо проблем с охлаждением. Плюс поддерживается больше памяти, до 1TB на процессор. Поддерживаемая частота памяти также выросла до 2933 MHz.

Рядом с CPU мы видим 24 слота под оперативную память — можно использовать планки до 128 ГБ или память Intel Optane объемом до 512 ГБ на слот.

Intel Optane открывает перед нами сумасшедшие скорости обработки. Например, его можно использовать как супербыстрый локальный SSD диск.

Сейчас всё больше запросов от заказчиков начинаются со слов: “Хочу больше дисков, больше NVMe накопителей в одной системе”.

На фронтальной стороне мы видим 8 2.5 дюймовых слотов под накопители. Также доступен к заказу вариант платформы на стандартные 24 слота с передней панели.

В зависимости от модификации в первые слоты можно установить до 8 NMVe дисков в форм-факторе U.2.

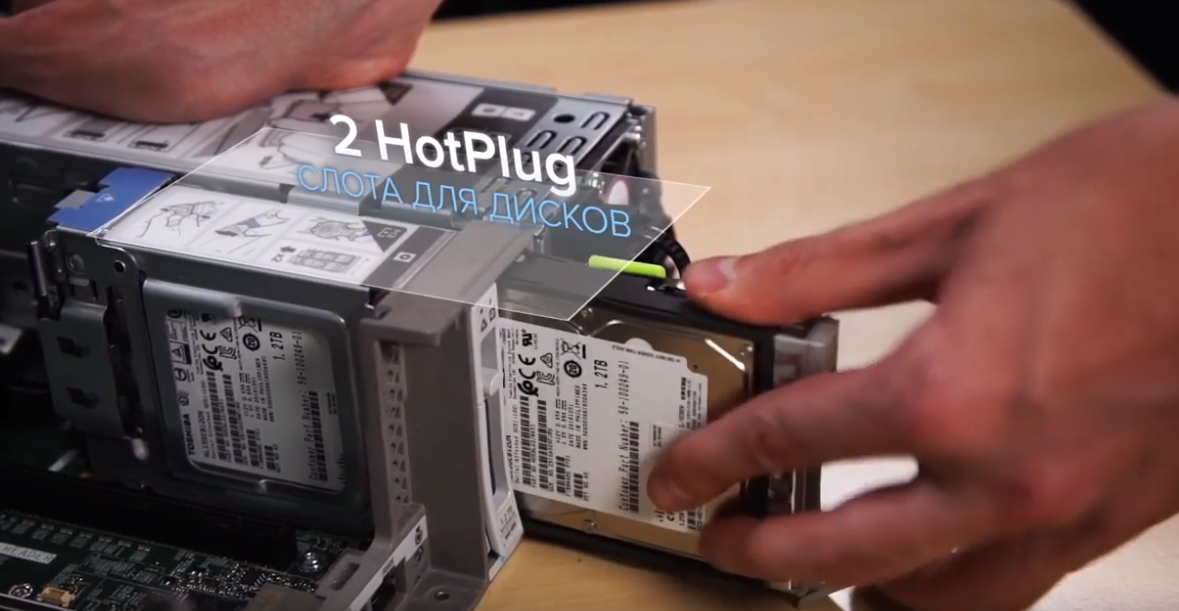

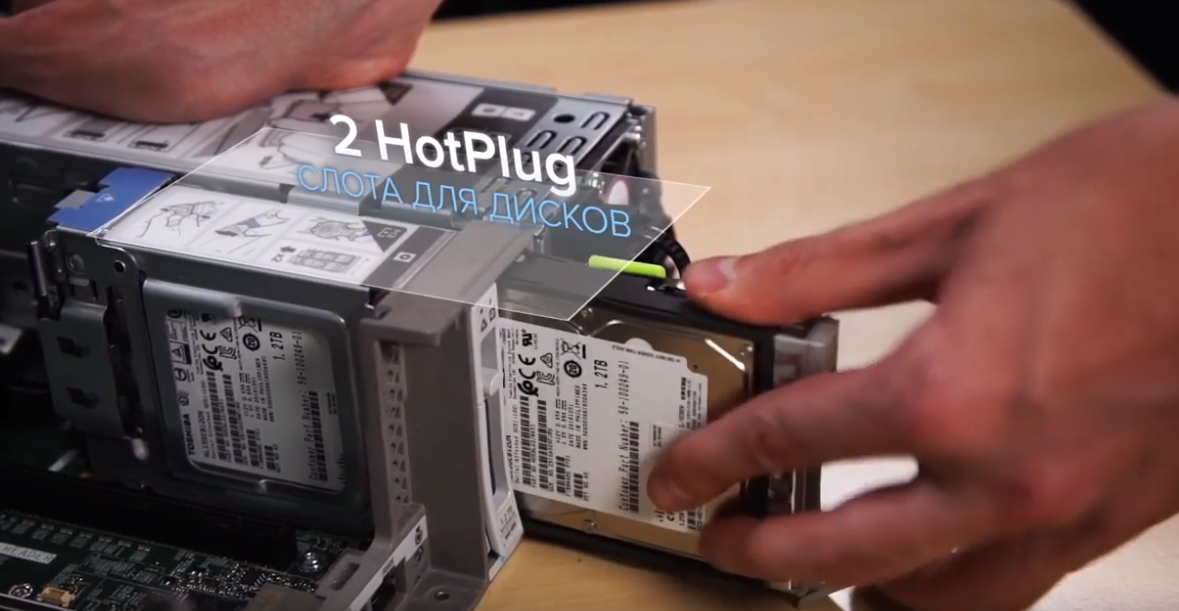

Платформа C240 в целом очень популярна у заказчиков, занимающихся большими данными. Их основной запрос — это возможность иметь накопители для локальной загрузки и желательно hot pluggable.

Ответом на этот запрос стало решение Cisco в С240 M5 добавить сзади сервера два слота под диски с поддержкой горячей замены.

Расположены они правее слотов расширения до блоков питания. Накопители могут быть любыми: SAS, SATA, SSD, NVMe.

Рядом мы видим блоки питания по 1600W. Они также Hot Pluggable и снабжены зелеными ярлычками.

Для работы с дисковой подсистемой в выделенный слот можно установить RAID-контроллер от LSI с 2 ГБ кэша, либо HBA-карточку для прямого проброса.

Например, такой подход используется при построении гиперконвергентного решения Cisco HyperFlex.

Есть другой тип заказчиков, которым диски вообще не нужны. Они не хотят ставить целый RAID-контроллер под гипервизор, но им нравится 2U корпус в плане удобства обслуживания.

Для них у Cisco тоже есть решение.

Представляю модуль FlexFlash:

Две SD-карточки, объемом до 128 ГБ, с поддержкой зеркалирования, для установки гипервизора, например, VMware ESXi. Именно этот вариант мы в ITGLOBAL.COM используем при построении собственных площадок по всему миру.

Для тех заказчиков, кому требуется больше пространства для загрузки ОС, есть вариант модуля на два «саташных» SSD диска в формате M.2, объемом 240 или 960 ГБ каждый. По умолчанию — это программный RAID.

Для накопителей в 240 ГБ есть опция использования Cisco Boot optimized M.2 Raid controller — отдельный аппаратный RAID-контроллер для этих двух SSD накопителей.

Всё это поддерживается всеми ОС: и VMware и Windows, и различными Linux ОС.

Количество PCI-слотов — 6, что характерно для 2U платформы.

Внутри достаточно места. В серверы легко установить два полноценных графических ускорителя от NVidia, например, TESLA M10 в проектах по внедрению виртуальных рабочих столов или последнюю редакцию V100 на 32GB под задачи искусственного интеллекта. Её мы и задействуем в следующем анбоксинге.

С портами дело обстоит следующим образом:

В слот mLOM можно установить только карточки Cisco VIC, которые эффективны как для передачи LAN, так и SAN трафика. При использовании сервера в составе фабрики Cisco UCS, такой подход позволяет единым образом организовать подключение к LAN и SAN сетям без необходимости использования отдельного fc адаптора.

Давайте установим видеоускоритель Nvidia V100. Снимаем второй райзер, убираем заглушку, вставляем карту в PCI слот, закрываем пластик и затем заглушку. Подключаем дополнительное питание. Сначала в карту, потом в райзер. Ставим райзер на место. В целом всё проходит без использования отверток и молотков. Быстро и четко.

В одном из следующих материалов мы покажем его первичную инсталляцию.

Мы также готовы ответить на все вопросы здесь или в комментариях.

Что делает интересным для анбоксинга именно этот сервер Cisco, с учетом того, что перед нами уже его пятое поколение?

Во-первых, серверы Cisco теперь поддерживают последнее поколение процессоров Intel Scalable второго поколения. Во-вторых, теперь можно установить модули Optane Memory для использования множества NVMe-накопителей.

Встают резонные вопросы: разве сервера других вендоров так не умеют? Что в этом такого, ведь это просто x86 сервер? Обо всем по порядку.

Кроме задач отдельно стоящего сервера, Cisco C240 M5 может стать частью архитектуры Cisco UCS. Здесь мы говорим о подключении к FI и полном управлении серверами силами UCS Manager, включая Auto Deploy.

Итак, перед нами “железный” сервер Cisco, пятое его поколение, более 10 лет на рынке.

Сейчас мы откатимся к основам, вспомним, из каких компонентов состоит сервер, и что делает Cisco C240 M5 не просто современным, а по-настоящему передовым.

Давайте посмотрим, что входит в комплект поставки.

Содержание коробки: сервер, KVM Dongle, документы, диск, 2 кабеля питания, монтажный комплект.

Снимаем крышку. Нажимаем, сдвигаем и всё. Никаких отверток и теряющихся болтиков.

Сразу в глаза бросаются зеленые ярлычки. Все элементы, которые поддерживают горячую замену, обладают ими. Например, легко можно без выключения питания всего сервера произвести замену вентиляторов.

Также видим массивные радиаторы, под которыми скрываются новые процессора Intel Scal 2 Gen. Заметим, что это до 56 ядер на 2U-сервер без каких-либо проблем с охлаждением. Плюс поддерживается больше памяти, до 1TB на процессор. Поддерживаемая частота памяти также выросла до 2933 MHz.

Рядом с CPU мы видим 24 слота под оперативную память — можно использовать планки до 128 ГБ или память Intel Optane объемом до 512 ГБ на слот.

Intel Optane открывает перед нами сумасшедшие скорости обработки. Например, его можно использовать как супербыстрый локальный SSD диск.

Сейчас всё больше запросов от заказчиков начинаются со слов: “Хочу больше дисков, больше NVMe накопителей в одной системе”.

На фронтальной стороне мы видим 8 2.5 дюймовых слотов под накопители. Также доступен к заказу вариант платформы на стандартные 24 слота с передней панели.

В зависимости от модификации в первые слоты можно установить до 8 NMVe дисков в форм-факторе U.2.

Платформа C240 в целом очень популярна у заказчиков, занимающихся большими данными. Их основной запрос — это возможность иметь накопители для локальной загрузки и желательно hot pluggable.

Ответом на этот запрос стало решение Cisco в С240 M5 добавить сзади сервера два слота под диски с поддержкой горячей замены.

Расположены они правее слотов расширения до блоков питания. Накопители могут быть любыми: SAS, SATA, SSD, NVMe.

Рядом мы видим блоки питания по 1600W. Они также Hot Pluggable и снабжены зелеными ярлычками.

Для работы с дисковой подсистемой в выделенный слот можно установить RAID-контроллер от LSI с 2 ГБ кэша, либо HBA-карточку для прямого проброса.

Например, такой подход используется при построении гиперконвергентного решения Cisco HyperFlex.

Есть другой тип заказчиков, которым диски вообще не нужны. Они не хотят ставить целый RAID-контроллер под гипервизор, но им нравится 2U корпус в плане удобства обслуживания.

Для них у Cisco тоже есть решение.

Представляю модуль FlexFlash:

Две SD-карточки, объемом до 128 ГБ, с поддержкой зеркалирования, для установки гипервизора, например, VMware ESXi. Именно этот вариант мы в ITGLOBAL.COM используем при построении собственных площадок по всему миру.

Для тех заказчиков, кому требуется больше пространства для загрузки ОС, есть вариант модуля на два «саташных» SSD диска в формате M.2, объемом 240 или 960 ГБ каждый. По умолчанию — это программный RAID.

Для накопителей в 240 ГБ есть опция использования Cisco Boot optimized M.2 Raid controller — отдельный аппаратный RAID-контроллер для этих двух SSD накопителей.

Всё это поддерживается всеми ОС: и VMware и Windows, и различными Linux ОС.

Количество PCI-слотов — 6, что характерно для 2U платформы.

Внутри достаточно места. В серверы легко установить два полноценных графических ускорителя от NVidia, например, TESLA M10 в проектах по внедрению виртуальных рабочих столов или последнюю редакцию V100 на 32GB под задачи искусственного интеллекта. Её мы и задействуем в следующем анбоксинге.

С портами дело обстоит следующим образом:

- Консольный порт;

- Гигабитный выделенный порт управления;

- Два порта usb 3.0;

- Интегрированная 2-х портовая сетевая плата Intel x550 10Gb BASE-T;

- Опциональная mLOM карта, Cisco Vic 1387 двухпортовый адаптер на 40 ГБ.

В слот mLOM можно установить только карточки Cisco VIC, которые эффективны как для передачи LAN, так и SAN трафика. При использовании сервера в составе фабрики Cisco UCS, такой подход позволяет единым образом организовать подключение к LAN и SAN сетям без необходимости использования отдельного fc адаптора.

Давайте установим видеоускоритель Nvidia V100. Снимаем второй райзер, убираем заглушку, вставляем карту в PCI слот, закрываем пластик и затем заглушку. Подключаем дополнительное питание. Сначала в карту, потом в райзер. Ставим райзер на место. В целом всё проходит без использования отверток и молотков. Быстро и четко.

В одном из следующих материалов мы покажем его первичную инсталляцию.

Мы также готовы ответить на все вопросы здесь или в комментариях.