Эксперты из Национального института информатики США предложили охлаждать серверное оборудование, погружая его под воду. В общем-то, эта команда неоригинальна, поскольку первыми погрузили миниатюрный вычислительный центр представители корпорации Microsoft. Но в США рассматривают возможность охлаждения на дне океана не маленького вычислительного центра, а целого ДЦ. Наверное, это даже не самый необычный способ охлаждения оборудования — ведь сейчас для этой цели используют и минеральное масло, и воду и даже жидкий гелий.

Под воду ДЦ решено погрузить по той простой причине, что ее, воды, в океане много. И чем глубже, тем она холоднее. Сейчас, с увеличением количества оборудования в дата-центрах и постоянного повышения его производительности, энергии на системы охлаждения уходит все больше. А поскольку информации генерируется с каждым годом не просто много, а очень много, то и количество дата-центров для ее хранения и обработки будет расти. Следовательно, будут увеличиваться и затраты на поставки энергии, в частности, для систем охлаждения.

Греем, греем, нагреваем

Сейчас увеличивается не только количество дата-центров, оборудования в них, но и плотность размещения оборудования в серверных стойках. Соответственно, тепловыделение растет, и требуется найти максимально эффективную схему рассеивания тепла. Это — одна из приоритетных задач операторов дата-центров.

Если раньше тепловыделение компьютерной техники было очень малым (вспомним Commodore, ZX Spectrum), то сейчас этот показатель возрос многократно. Без радиаторов и разнообразных схем теплоотвода оборудование функционировать просто не может — процессоры и прочие элементы серверов греются очень сильно.

Поэтому нужны более эффективные системы охлаждения, по этой причине операторы и используют воду, минеральное масло, воздух и все прочие теплоносители и хладагенты, пробуя найти «золотую середину» в охлаждении оборудования. Но проблема здесь общая для всех систем — нужен подвод энергии, и ее, энергии, тратится много, какой бы эффективной система охлаждения бы ни была. Конечно, в некоторых регионах можно использовать фрикулинг, но и здесь без электричества не обойтись.

Интеграция с природой

Небольшая или среднего размера компания вынуждена использовать либо мощности стороннего дата-центра, либо строить свой, причем выбор места его создания не так уж и велик. Это транснациональные корпорации вроде Google, Facebook, Amazon могут строить дата-центры чуть ли не в Лапландии. А обычным компаниям такая роскошь непозволительна.

Что касается корпораций, то некоторые из них присмотрели Исландию в качестве региона, где можно без проблем строить дата-центр с системой фрикулинга. Внешний воздух здесь практически всегда прохладен и чист, поэтому особых затрат для охлаждения не требуется.

Те же корпорации используют отводимое от ДЦ тепло для обогрева близлежащих объектов: домов, где проживает персонал, школ и других объектов. Здесь мы видим двойную выгоду — утилизацию тепла и минимальный расход энергии на содержание системы охлаждения дата-центра.

Но ведь в той же Исландии живет всего несколько сотен тысяч человек. А дата-центр должен обеспечивать доступ к своим ресурсам для десятков, сотен или даже миллионов людей, живущих в тысячах километров отсюда. И чем больше будет пользователей, чем более удаленным от цивилизации будет дата-центр, тем большими могут быть задержки. Чтобы этого избежать, ДЦ в некоторых случаях приходится строить рядом с мегаполисами.

Еще один способ — тот, о котором говорилось выше. Погружение серверов и целых ДЦ в морскую пучину. Здесь тоже возникают сложности: морская вода — очень агрессивная среда. С увеличением глубины растет давление. Следовательно, оборудование должно быть очень хорошо защищено.

Но выход есть

Да, исследователи из Национального института информатики США обнаружили свет в конце тоннеля. Они долгое время проводили эксперименты с методами охлаждения оборудования путем погружения его под воду без герметичных корпусов и прочего сопутствующего оборудования. Их решение — специальное гидрофобное покрытие, которое позволяет специально сконструированным серверам под водой. Причем в этом случае нет ни риска короткого замыкания, ни угрозы перегрева оборудования.

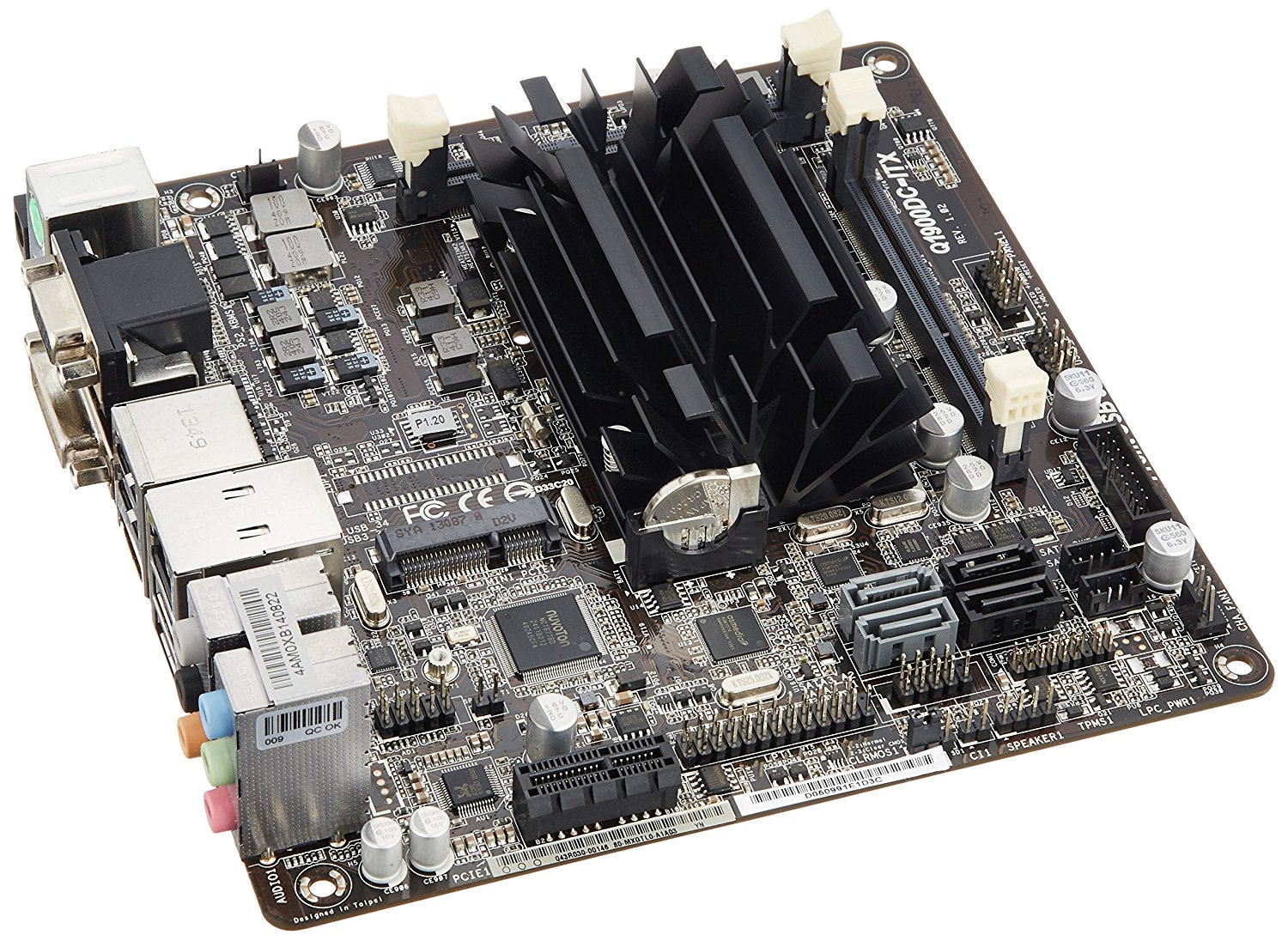

Исследователи использовали для тестов ASRock Mini-ITX

Исследователи во главе с Мичихиро Коибучи и Казуки Фудзивара сначала испробовали покрытие на базе эпоксидной смолы. В этом случае они потерпели неудачу, поскольку покрытие такого рода было очень неравномерным. Второй эксперимент базировался на идее использования алюминиевого корпуса, покрытого водонепроницаемым герметиком. Снова ничего не получилось — вода нашла себе лазейку.

После ряда неудач исследователям повезло. Они опробовали химическое соединение, которое называется параксилол, и все получилось. Это вещество, в газообразном состоянии, специалисты использовали для обработки поверхности корпусов оборудования. Оказалось, в этом случае покрытие наносится равномерно. Параксилол быстро застывает, формируя полностью гидрофобное покрытие толщиной в десятую долю миллиметра. Этого оказалось достаточно для того, чтобы оборудования работало под водой без всяких проблем.

Конечно, говорить о погружении такого оборудования на глубину в десятки метров не приходится, но в течение трех месяцев материнская плата с параксилоловым покрытием работала в воде без проблем. После этого устройства начали пробовать погружать в океан. Эксперимент оказался успешным на половину: часть оборудования продолжало работать, часть — нет, причина — влияние разнообразных живых существ. Каким-то образом некоторые животные повреждали водонепроницаемый слой.

Сейчас эксперименты специалистов продолжаются. Кроме того, авторы работы изучают возможность использования энергии прибоя и приливов для обеспечения оборудования энергией. В этом случае можно говорить о почти полной автономности систем. Конечно, до практической реализации идеи еще далеко, но вероятность того, что она окажется успешной, есть.