Comments 21

За велосипеды лайк :)

0

Как же это люди живут с CEPH без команды разработчиков? Ну да ладно.

А где MS SS Direct? А где ScaleIO? А где нут от нутаникс?

Пост выглядит так, будто вендоры вам прислали свои материалы и вы из них сделали сводную таблицу и из этого написали пост на хабр.

Где тесты отзывы, стенды и прочее? Грустно как-то.

А где MS SS Direct? А где ScaleIO? А где нут от нутаникс?

Пост выглядит так, будто вендоры вам прислали свои материалы и вы из них сделали сводную таблицу и из этого написали пост на хабр.

Где тесты отзывы, стенды и прочее? Грустно как-то.

+6

Как же это люди живут с CEPH без команды разработчиков?

На наш взгляд — это так. Но у всех разные задачи и потребности. Но в любом случае, назвать Ceph «коробочным» решением, как то очень сложно.

А где MS SS Direct?

Ещё сыровато, как говорит сам МС — ещё не для продакшена. Но мы уже посматриваем и в его сторону.

А где ScaleIO?

Эм...4-й столбец.

Где тесты отзывы, стенды и прочее?

Последний блок текста ответит на ваш вопрос.

Грустно как-то.

Печеньку? :)

+2

Ceph — не совсем коробочный продукт. Его использование без штата разработчиков достаточно затруднительно, что сделало его неинтересным для нашей компании.

У меня довольно большой опыт работы с Ceph(три года) и смело могу заявить, что в штате разработчики не нужны вообще. Нужно только хорошо понимать архитектуру и принципы его работы, ну и конечно же читать и анализировать рассылку и http://tracker.ceph.com

При этом записи не являются транзакционными.… Яркий ее представитель — CEPH.

Почему же запись в CEPH не является транзакционным? Вполне себе является транзакционным и даже с учетом количества его репликаций.

+3

Вполне себе является транзакционным и даже с учетом количества его репликаций.

Готовы вас выслушать, а лучше — получить ссылку на доку, где это описано. Возможно, мы действительно имеем мало опыта с Ceph.

пс первый каммент за 6 лет? Видимо мы сильно вас задели? :)

-2

Это написано в их главной архитектурной документации :).

P.S. По поводу 6 лет, так уж сложилось :).

Replication

…

The client writes the object to the identified placement group in the primary OSD. Then, the primary OSD with its own copy of the CRUSH map identifies the secondary and tertiary OSDs for replication purposes, and replicates the object to the appropriate placement groups in the secondary and tertiary OSDs (as many OSDs as additional replicas), and responds to the client once it has confirmed the object was stored successfully.

The client writes the object to the identified placement group in the primary OSD. Then, the primary OSD with its own copy of the CRUSH map identifies the secondary and tertiary OSDs for replication purposes, and replicates the object to the appropriate placement groups in the secondary and tertiary OSDs (as many OSDs as additional replicas), and responds to the client once it has confirmed the object was stored successfully.

P.S. По поводу 6 лет, так уж сложилось :).

+3

Я вот такую вещь вот читал http://docs.ceph.com/docs/hammer/dev/filestore-filesystem-compat/

0

А где IBM Spectrum Accelerate и что-то от Хапе?

0

С IBM у нас, к сожалению, как то не задаются отношения. То у нас с тсм их не вяжется, то предлагали в тест объектный сторадж Cleversafe, который мы от них ожидаем до сих пор и тд… А что касается HPE… при всём моём к ним уважении и любви, у меня с железным StoreVirtual перед новым годом сложилась очень странная ситуация, которая не знаю, решилась уже или нет, но впечатление оставила не очень положительное, да и VSA как то особо не выделяется, что бы прям сильно захотелось его внедрить.

+1

Тоже три года работы с ceph, никаких разработчиков держать не нужно. Вполне коробочный продукт, типа glusterfs или gpfs, в понимании их инсталляции под линукс, через использование которых прошли. Все работает и ставится из пакетов, настраивается достаточно просто и очень гибко. Ну а если нужен gui, то и этого навалом. Да и данные добываются просто, если вдруг по криворукости развалите, как мы на заре использования, неправильно настроив multipath на паре массивов :-)

На мой взгляд, одна из лучших систем для хранения данных на данный момент, а я их немного повидал разных.

Используем и под виртуализацию и для отдачи по nfs, и для прямого подключения как дисков.

Вот хотим на cephfs перейти для хранения файлов пользователей.

На мой взгляд, одна из лучших систем для хранения данных на данный момент, а я их немного повидал разных.

Используем и под виртуализацию и для отдачи по nfs, и для прямого подключения как дисков.

Вот хотим на cephfs перейти для хранения файлов пользователей.

+4

UFO just landed and posted this here

Используем только реплику. А восстанавливали так. По этой статье узнали формат хранения rbd http://www.sebastien-han.fr/blog/2014/09/08/analyse-ceph-object-directory-mapping-on-disk/

Далее написали програмку на питоне, которая доставала кусочки с дисков и сливала их в один файл, после чено просто этот файл подмонтировали, получилось со второго раза и за 3 дня работы программы.

Далее написали програмку на питоне, которая доставала кусочки с дисков и сливала их в один файл, после чено просто этот файл подмонтировали, получилось со второго раза и за 3 дня работы программы.

+2

Вообще статьи Ланита, а уж тем более выводы, как-то серьезно воспринимать нельзя ;)

Ибо очевидная клоунада.

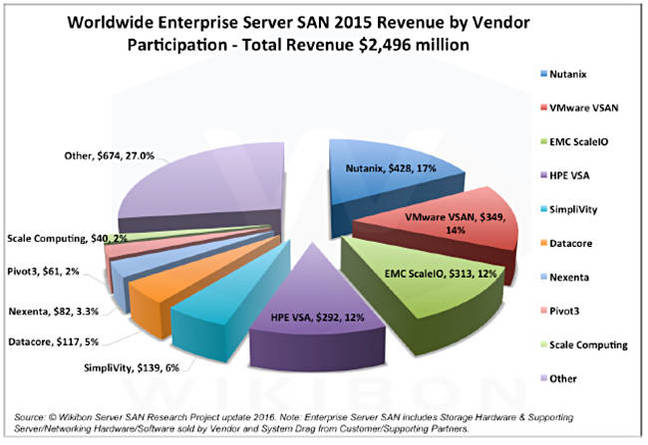

https://www.theregister.co.uk/2016/09/05/wikibon_server_san_takeover/

Достаточно посмотреть на расклад по рынку (Server SAN == SDS)

Ибо очевидная клоунада.

https://www.theregister.co.uk/2016/09/05/wikibon_server_san_takeover/

Достаточно посмотреть на расклад по рынку (Server SAN == SDS)

0

Удивляет то, что в этом обзоре нет программно-определяемых СХД Open-E.

Оригинал: www.open-e.com

На русском языке: www.open-e.pro

Их флагманский продукт JovianDSS очень неплох: zfs со всеми плюшками, кластеризация.

iSCSI, SMB, NFS. Все это высокой доступности. На Open-E, кстати, работает ИТАР-ТАСС.

Оригинал: www.open-e.com

На русском языке: www.open-e.pro

Их флагманский продукт JovianDSS очень неплох: zfs со всеми плюшками, кластеризация.

iSCSI, SMB, NFS. Все это высокой доступности. На Open-E, кстати, работает ИТАР-ТАСС.

0

Sign up to leave a comment.

Программно-определяемые СХД: сравниваем 7 решений