Знакомьтесь, HIGGS — новый метод сжатия LLM от исследователей из Яндекса и ведущих научно-технологических вузов

Исследователи из Yandex Research, НИУ ВШЭ, MIT, KAUST и ISTA разработали новый метод HIGGS для сжатия больших языковых моделей. Его особенность — высокая производительность даже на слабых устройствах без существенной потери качества. Например, это первый метод квантизации, с помощью которого удалось сжать DeepSeek R1 размером 671 млрд параметров без значительного ухудшения модели.

Метод позволяет быстро тестировать и внедрять новые решения на основе нейросетей, экономить время и деньги на разработку. Это делает LLM доступнее не только для крупных, но и для небольших компаний, некоммерческих лабораторий и институтов, индивидуальных разработчиков и исследователей.

Метод уже доступен на Hugging Face и GitHub. Научную статью про него можно прочитать на arXiv. Ну а более простое описание — под катом этой новости.

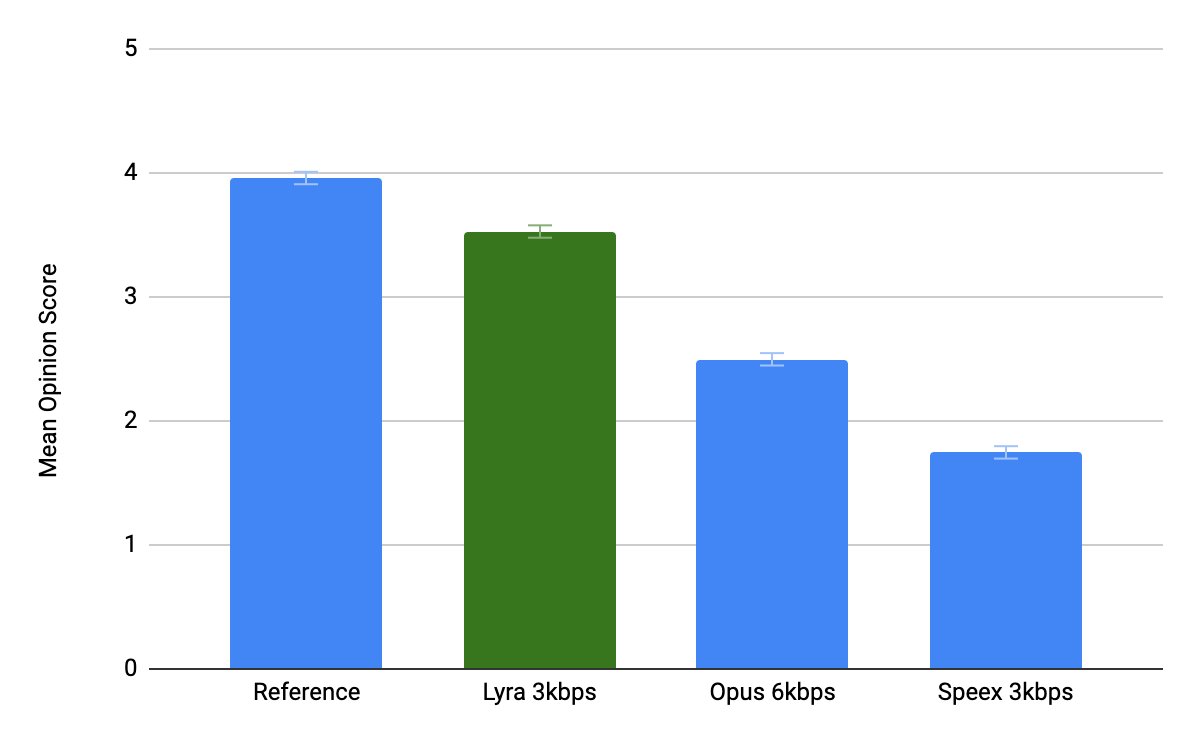

Сегодня видеочаты стали частью нашей повседневной жизни. Хотя пропускная способность сетей растёт, по-прежнему востребована качественная связь на низком битрейте. Проблема особенно для звука, потому что именно звук передаёт информацию в чате. На самом низком битрейте принято использовать параметрические кодеки с роботизированным голосом, а не нормальные кодеки, которые описывают форму сигнала.

Сегодня видеочаты стали частью нашей повседневной жизни. Хотя пропускная способность сетей растёт, по-прежнему востребована качественная связь на низком битрейте. Проблема особенно для звука, потому что именно звук передаёт информацию в чате. На самом низком битрейте принято использовать параметрические кодеки с роботизированным голосом, а не нормальные кодеки, которые описывают форму сигнала.