Диффузионные нейросети, такие как DALL-E 2, Imagen и Stable Diffusion, запоминают отдельные изображения из обучающих данных и выдают их во время генерации, выяснили исследователи. Препринт научной статьи опубликован на портале arXiv. Как показала работа авторов, диффузионные нейросети гораздо менее приватны, чем предыдущие генеративные модели, такие как GaN. Для устранения уязвимостей могут потребоваться новые достижения в обучении с сохранением конфиденциальности.

Диффузионные модели для генерации изображений набирают популярность семимильными шагами. Подробнее о них можно почитать в переводе пользователя @dimanosov007 и статье @Nikuson . Но если в двух словах, то при обучении модель берёт исходное изображение, искажает до неузнаваемости, добавляя шум, а после из неузнаваемой кучи пикселей учится собирать изображение, используя шумоподавление.

По сравнению с предшествующими моделями, такими как генеративно-состязательная сеть или вариационный автоэнкодер, диффузионные модели генерируют образцы более высокого качества, эти модели легче масштабировать и обслуживать. Но основная популярность диффузионных нейросетей вызвана их способностью генерировать новые изображения, якобы не похожие на те, что были в обучающем наборе данных. То есть при получении запроса модели не должны воссоздавать изображения, создаваемые при обучении.

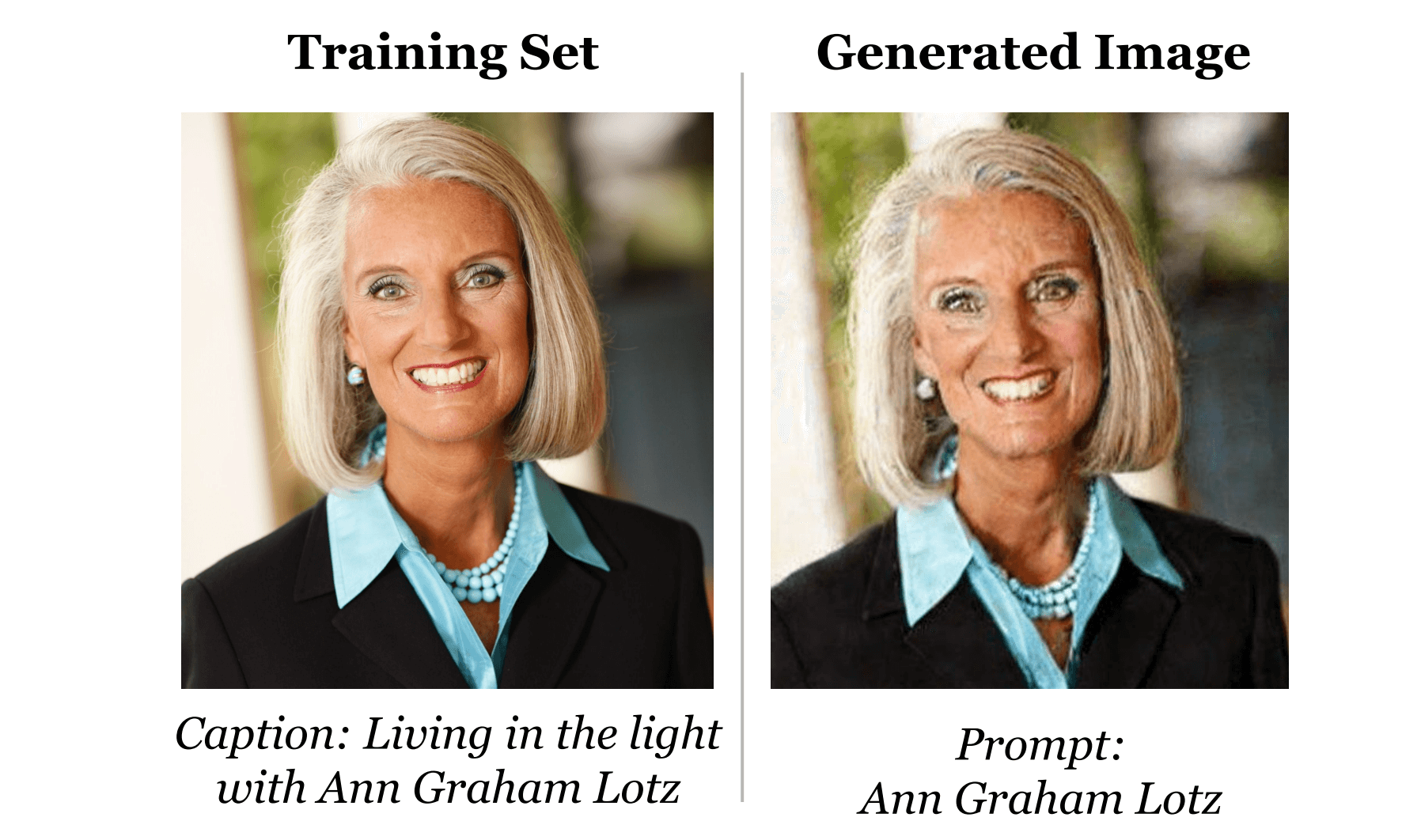

Исследователи показали, что диффузионные модели при получении запроса всё же генерируют изображения, обработанные при обучении. В ходе экспериментов они получили сотни изображений, абсолютно идентичных тем, что были в обучающих данных. Часть из них позволяет полностью идентифицировать личность человека, чья фотография попала в обучающий набор.

К такому эффекту приводит определённый компромисс между конфиденциальностью и производительностью. Повышение производительности модели приводит к повышенному запоминанию и ухудшению конфиденциальности. При желании и знании принципов работы диффузионной нейросети злоумышленник при помощи определённых атак постепенно может вытянуть находившиеся в обучающих данных изображения. Метод дедупликации не помогает полностью защититься от этого эффекта, но авторы всё равно рекомендуют использовать его для сведения рисков к минимуму, насколько это возможно. Также авторы при помощи представленных ими атак предлагают регулярно проводить аудит моделей для проверки конфиденциальности.

Как показало исследование, современные диффузионные модели запоминают в два раза больше, чем сопоставимые генеративные модели, а более полезные диффузионные модели запоминают больше, чем более слабые диффузионные модели. По мнению авторов, это говорит о том, что уязвимость генеративных моделей изображений со временем может расти. На текущий момент процент выдачи дублей относительно мал, но это только вопрос времени, уверены исследователи.

Работа поднимает вопросы, связанные с возможностями запоминания и обобщения диффузионных моделей. Авторы крайне не рекомендуют использовать диффузионные модели на чувствительных к конфиденциальности данных.