Может показаться, что Wi-Fi на стадионе не нужен вообще. Пришёл болеть – так смотри за игрой, а не пости селфи и читай почту. Но нет, Wi-Fi нужен по двум важным причинам. Во-первых, при таком скоплении людей будут крайне быстро разобраны каналы сотовой сети, и большая часть болельщиков останется на время без телефона. Во-вторых, собственно, владельцам стадиона очень хотелось дать специальное мобильное приложение для всех болельщиков.

Внутри – схемы расстановки игроков на поле, статистика по матчу и игрокам, плюс стриминговое видео с камер, чтобы можно было видеть крупным планом в лицах на планшете или телефоне, что происходит. Ну и сразу повторы важных моментов с разных ракурсов.

На радиообследовании

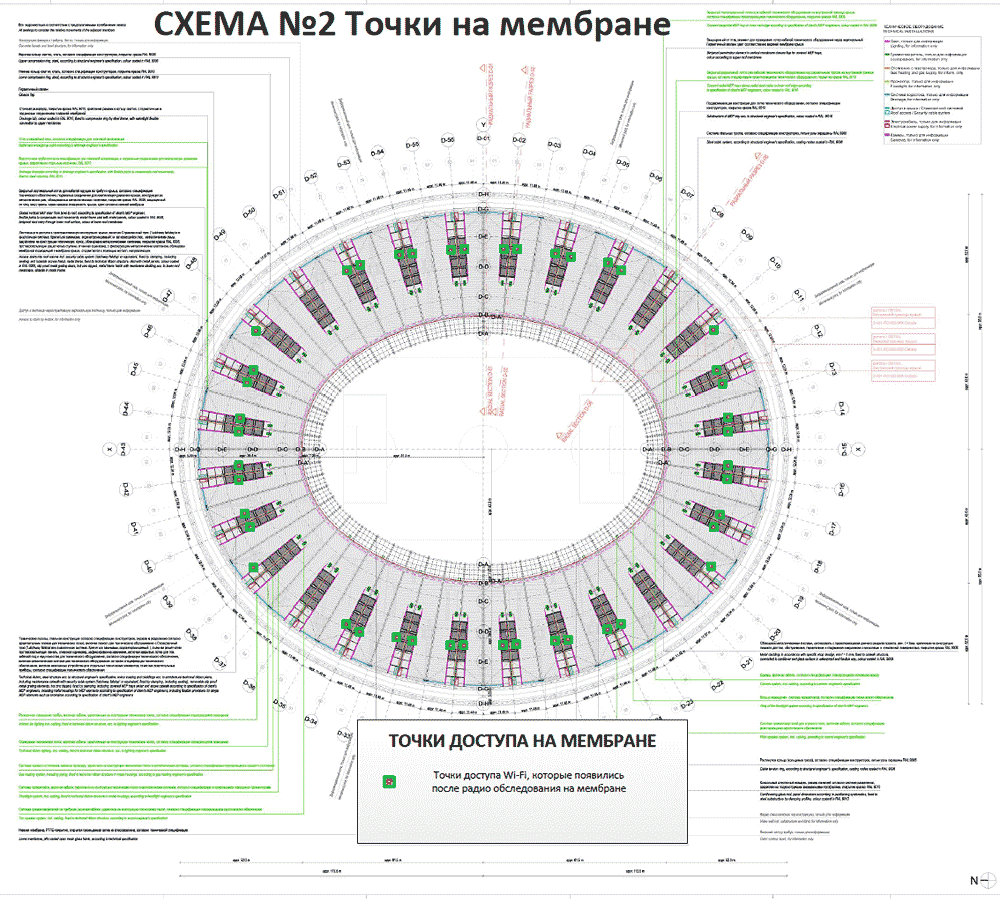

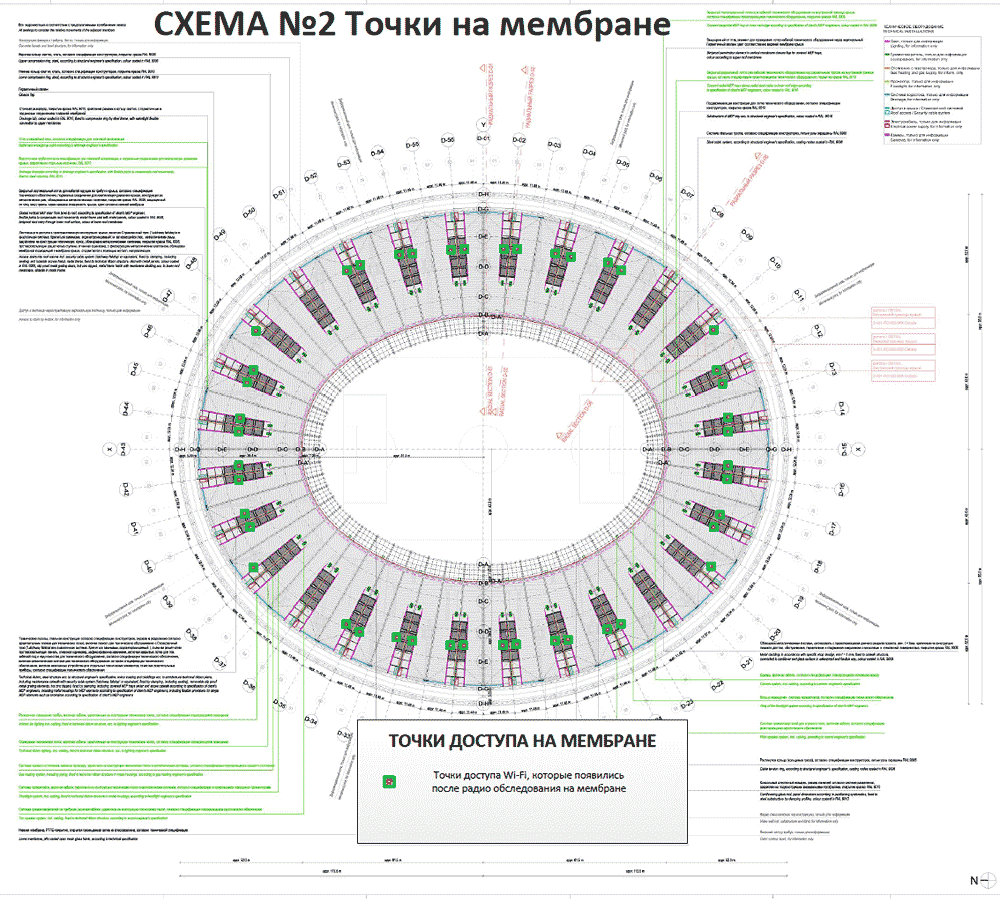

Результат обследования мембраны

Для всего этого нужен быстрый Wi-Fi высокой плотности и с минимальными интерференциональными явлениями. Обычных хотспотов тут не натыкать – нужна хорошая экспертиза радиообследования, плюс специальное оборудование. Результат – 150 хитрых точек доступа с beamforming после довольно нетривиальных работ.

Внутри – схемы расстановки игроков на поле, статистика по матчу и игрокам, плюс стриминговое видео с камер, чтобы можно было видеть крупным планом в лицах на планшете или телефоне, что происходит. Ну и сразу повторы важных моментов с разных ракурсов.

На радиообследовании

Результат обследования мембраны

Для всего этого нужен быстрый Wi-Fi высокой плотности и с минимальными интерференциональными явлениями. Обычных хотспотов тут не натыкать – нужна хорошая экспертиза радиообследования, плюс специальное оборудование. Результат – 150 хитрых точек доступа с beamforming после довольно нетривиальных работ.