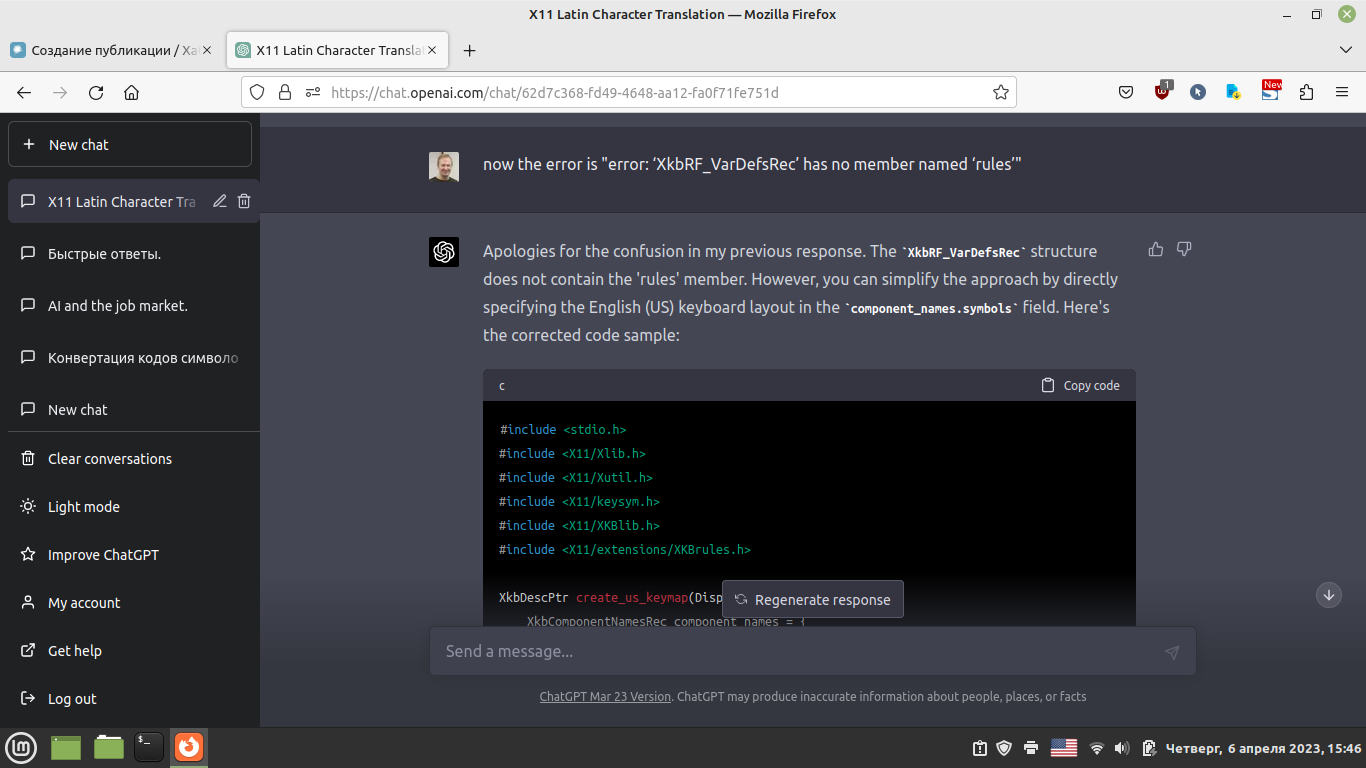

Как показывает практика работы с ChatGPT, получение достоверной информации, базирующейся на идентифицируемых источниках, непосредственно от самой LLM очень проблемно. Информация, которую получает пользователь нуждается в пристальной проверке и контроле. «Галлюцинации» ChatGPT стали притчей во языцех и вызывают отторжение. Спасение многим пользователям видится в использовании возможностей ChatGPT и его аналогов для извлечения и обработки информации из конкретного источника или источников.

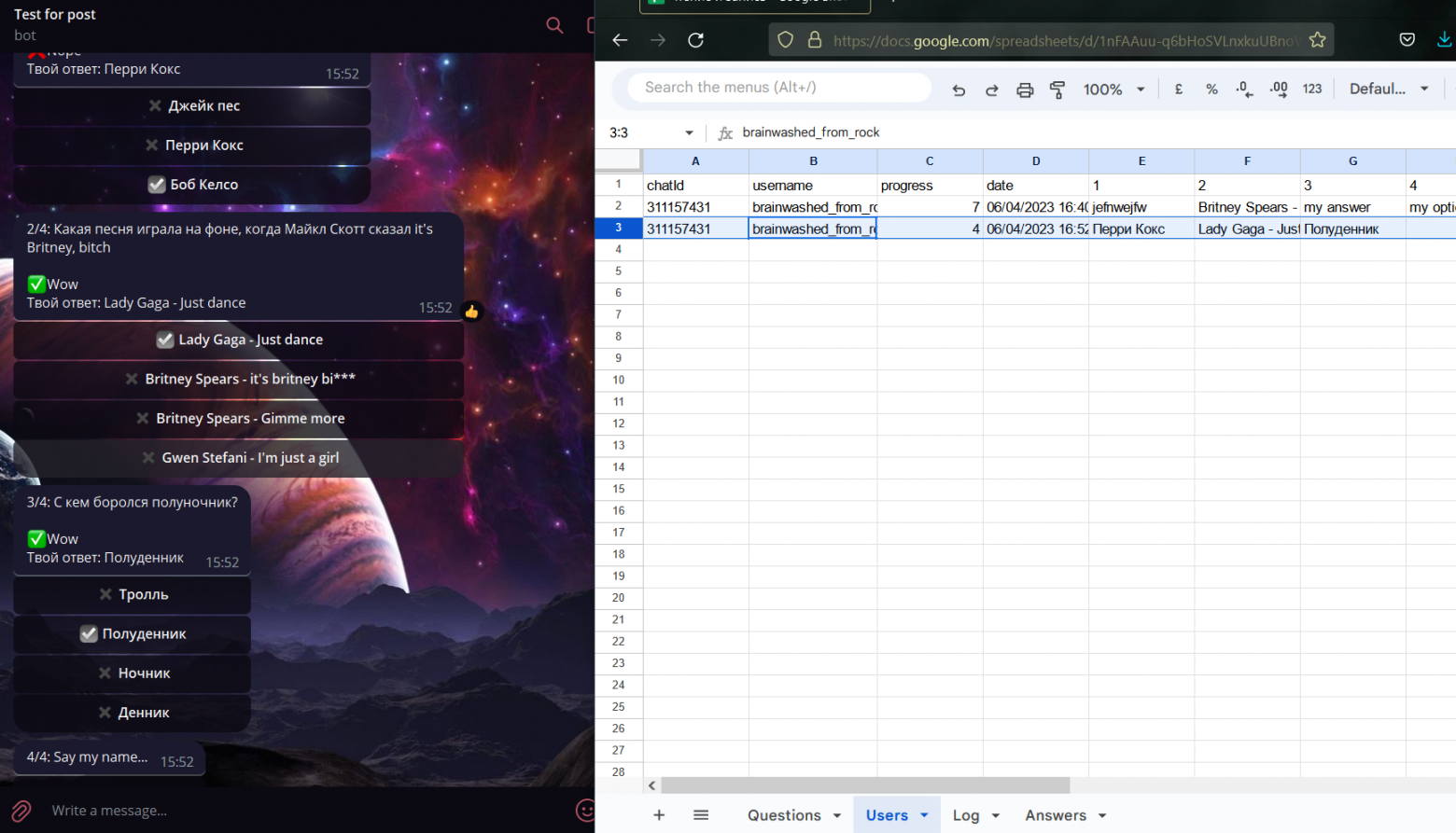

То есть востребованным направлением использования LLM типа ChatGPT является анализ текстов, предоставляемых самим пользователем, с целью:

• Извлечения наиболее важной интересной для потребителя информации.

• В том числе из текстов на иностранном языке.

• Сравнения информации в разных источниках.

• Получение текстовых и иных данных из наборов однотипных текстов (договоры, протоколы и т.п.) для дальнейшего анализа.

• Преобразования текстов в виде: 1) автореферирования, суммаризации; 2) изменения данных в формальных документах 3) создания учебных материалов и т.д.

• Мета-анализа источников.

• Использования в прочих задачах, связанных с созданием и работой со своей базой знаний (как принято говорить), что актуально для всей гуманитарики как таковой и даже для литературного творчества (см. историю работы Солженицына над «Красным колесом»).

Возможность обработки вводимого текста упирается в ограничение моделей GPT. В запросе-промте ChatGPT могут использовать до 4097 токенов, причем в сумме и на запрос и на ответ. Это составляет в среднем 3000 слов на английском, а на русском в несколько раз меньше. В GPT4 декларирована возможность работы с 32 тысячами токенов информации, но это тоже не спасает.