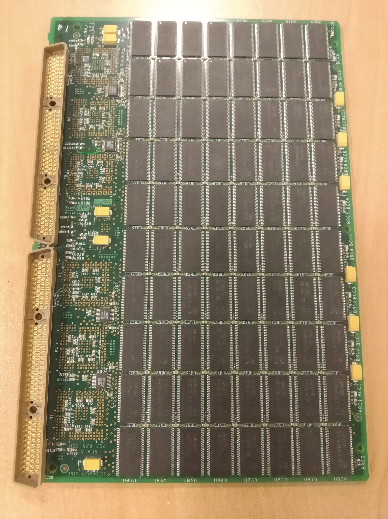

Ходил я тут как-то по нашему складу, искал одну железку для заказчика. Смотрю, знакомая старая железяка — кэш.

Точнее, это ячейка хайэндового дискового массива, представляющая нечто вроде оперативной памяти, но в центре архитектуры Симметрикса

Еще увидели знакомую старую железяку — VNX1. Она интересна не столько гениальной по тем временам архитектурой, сколько тем, как мы однажды разбирали последствия переезда такого массива с этажа на этаж по офису заказчика. Представьте ситуацию: они там четыре года делали проект по госконтракту, который хранился в виде единственной копии на массиве. И решили перевезти железку, не позвав админа, потому что железяка была старая (на три поколения древнее, чем та древность, от которой кеш-плата на фотографии) и сошла с поддержки. Для упрощения переезда решили вынуть все диски, потому что без них стойка получалась легче. Как вы догадываетесь, вопрос только один: что вообще могло в этой истории пойти ТАК?

Железяка имеет физическую адресацию дисков по номеру слота. Слоты для дисков бывают двух типов: рейд-группы массива (большая часть) и диски горячей замены. Массив при втыкании дисков обратно увидел, что это его диски, но начал ругаться на нарушенную адресацию красными лампочками. Местный админ начал подбирать комбинацию из дисков, надеясь, что если угадать с перестановками, лампочки погаснут и всё заведётся. Потому что про многомиллионный проект уже начали задавать неудобные вопросы.

Подстава заключалась только в том, что при втыкании диска в слот горячей замены массив не ворчал на него, а говорил: «О, новый жёсткий диск» и молча его форматировал, и начинал в него что-то писать.

Всего заказчик успел попробовать около 20 рекомбинаций из 200 дисков, из которых девять пришлось на установку новых дисков с данными в слоты горячей замены.

Массив VNX

Итак, к 20-й перестановке, к счастью, они поняли, что что-то идёт не так. Позвали нас собирать массив обратно. На тот момент заказчику казалось, что дело просто в том, что нужно правильно расставить диски, коварство массива с очисткой данных они сильно недооценили.

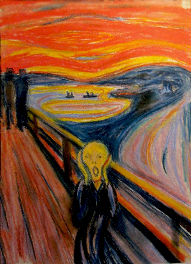

Когда мы чуточку разобрались в ситуации и рассказали, что же именно они сделали, эти лица надо было видеть. Знаете картину «Крик» Мунка? Все думают, что там главный герой кричит, но если присмотреться, можно заметить, что он всеми силами старается выровнять давление в черепе после шокирующего воздействия окружающей среды. То есть крик — это всё вокруг, а он просто жертва. Вот так же выглядели те, кто не сделал бекап.

К счастью, у истории хороший финал — один из немногих в играх на рекомбинацию против бездушных массивов. Как я уже сказал, к моменту нашего приезда они успели грохнуть девять дисков и частично записать на них технические данные. К счастью, по какому-то невероятному для них совпадению, это были диски из разных (!) рейд-групп, то есть каждый раз сохранялась избыточность. Парни несколько раз подряд выиграли в русскую рулетку с пистолетом, а не револьвером.

Мы подготовили и расставили все диски, включили массив, он подцепился (ни один диск в переезде не пострадал) и спокойно начал ребилд. Дальше появился полный доступ к консистентным и полным данным. Заказчики отняли руки от головы.

Мораль истории: массивы могут быть коварны.

А компоненты для таких коварных массивов, используемых в госконтрактах, мы всё ещё храним. Некоторым железякам ЗИПа больше 20 лет, относительно недавно, например, ушёл последний из нашего запаса 486-й процессор в АСУ ТП-компьютер на заводе, управляющий станком. Когда сломается и он, наверное, клиенты сделают апгрейд.

Но давайте покажу ещё несколько интересных железок у нас на хранении. Склад выглядит вот так вообще:

Вот компаковские сервера:

Когда я приходил на работу в КРОК в 2008 году, они уже были старые — ну, вы можете это понять по тому, как написано название компании HP на их корпусе.

Вот тут видно прогресс, вместо одного Pentium III там стало два или даже четыре процессора. Обратите внимание, эти сервера запирались на замок

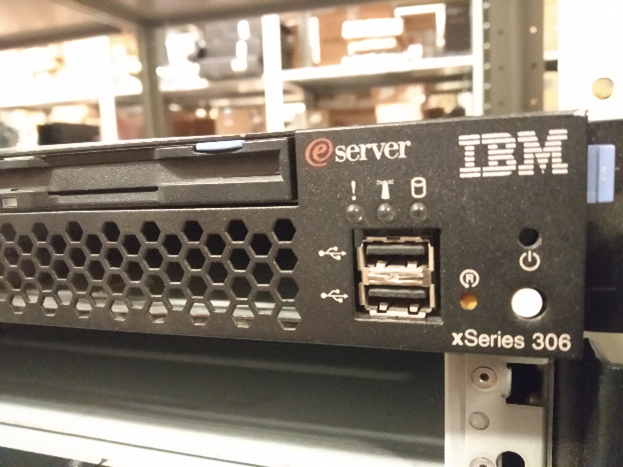

Вот обычный сервер IBM. Такие серваки в принципе вообще не изменились внешне. Он примечателен тем, что не примечателен вообще ничем.

Собственно, он как был железкой смутного назначения, так и остался, только теперь на новых написано Lenovo.

А вот это уже штука хитрее, но всё так же смутна:

Это P-серия блейдов HP. Я видел её только в лабораториях и в ЗИПе, но никогда — в проде. Никто из моих знакомых и коллег тоже не видел её в проде. Если вы вдруг знаете, с чем она конкурировала и для чего была незаменима, — скажите, пожалуйста, но вместо неё в проде всегда стояло что-то другое. Но такая штука существовала, вот доказательство.

А это динозавр из эпохи, когда Sun были отдельной компанией. Внутри был один из последних классических RISC-процессоров без довешивания фич. На топовых серверах этой линейки можно было менять оперативную память в онлайн-режиме, а на самых крутых — процессоры. Правда, я обслуживал только младшие сервера линейки и так ни разу не делал. На практике всегда было проще потушить сервер, сделать замены и вернуть его в бой — на этом же сходились все инженеры, которые обслуживали это железо. Железяка связана у меня с большой обидой, потому что я обслуживал похожие (в ЗИПе 440 и 240, я работал с 290) полгода, а дальше должен был ехать на повышение квалификации учиться в ЮАР. Но в солнечную страну я так и не поехал, потому что Sun разорился. Потом съездил в Америку и Германию от EMC и Хитачи, но пингвинов и львов так и не увидел.

А это ленточные библиотеки. Выглядят достаточно старомодно, но современные модели принципиально ничем не отличаются от моделей 20-летней давности. Собственно, вендор это тоже заметил. Наверное, поэтому поменял цвет панелей по бокам, чтобы отличать новые от старых. Отлично работают много где по стране, на них чаще всего хранится бекап Судного дня.

Кстати, про бекап Судного дня. Был у нас потрясающий случай с Симметриксами на заводе. Два массива в синхронизации, но у одного при перепланировании электрики в здании отключили дисковый шкаф. Просто взяли и увели все диски в офлайн. Что характерно, заметили только через полтора года — дело в том, что эти массивы очень коварные и самостоятельные. В случае отказа локальных дисков они присылают админу личное письмо и идут смотреть, что в синхронной реплике. Заказчик купил обновление массива, приезжает инженер ставить обновление. Мы вдвоём заходим в серверную — а серверный шкаф выключен. Полтора года работал без дисков, ни единой ошибки. Данные в порядке. Стали разбираться, почему нет писем — оказалось, при заведении почты вместо .ru указали .ri. Шкаф включили, массив его примерно неделю ребилдил, потом продолжил работать.

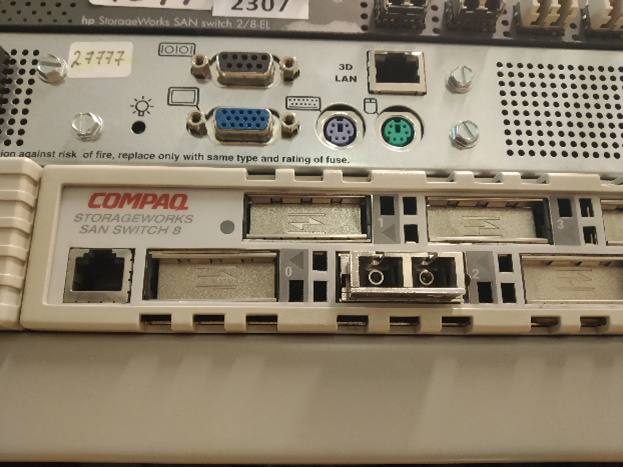

Это древнющий свитч, который вымер, кажется, под тысячу лет назад, но у нас лежит и кого-то ждёт. С учётом, что недавно была перепись предпокойников по стране, это означает, что его прод-коллега всё ещё трудится на заводе где-нибудь в Сибири и радует простых сибирских мужиков нормальными разъёмами. Они там были крупные.

Кстати, про разъёмы со свитчами. В одной крупной серверной один раз админ заказчика увидел свободно висящий из свитча кабель и воткнул его обратно (чем запустил слияние двух фабрик и оторвал все диски от всех фабрик внутри ЦОДа). Или вот другая история произошла пару лет спустя — кабель (уже питания) свисал из сервера, и втыкание его обратно вызвало очень быструю цепочку событий, которые привели к отключению подстанции. Что в обоих случаях заставляло людей так обращаться с железом, мы не знаем. У нас нет админопсихологов.

А это первый лоуэндовый массив HP из известных мне, который смог Fibre Channel. А выше него лежат контроллеры старой-старой EVA — это была суперпродвинутая линейка для своего времени. Делалась она с той архитектурой, которая стала современной существенно позже, по функционалу тоже было круто. HP вообще очень многие интересные проекты закрыл, потому что здесь и сейчас они не приносили денег или чего-то ещё — это были процессоры Альфа (DEC), кластеры VAX, эти вот массивы и так далее.

С массивами самая частая роковая ошибка — выбрать не то направление репликации, я пару раз на такое выезжал. Но один раз было ещё круче. Звонит заказчик, говорит: «Всё плохо, массив недоступен, паника-паника». Я смотрю на интерфейс управления массивом — все LUN’ы в онлайне, всё зелёное. Говорю: «Друзья, давайте соберёмся и проверим пункт 1 таких тикетов: об одном ли мы массиве говорим». Утверждают, что о том. Присылают свои логи — всё офлайн. Я смотрю — снова всё онлайн, в интерфейсе чисто. Говорю: «Друзья, это странно, в такой ситуации надо взять паузу и разобраться». Заказчик же паникует, хочет срочно — и отдаёт команду на перезагрузку массива. А дальше гениальная фраза:

— Ой! А у нас второй массив тоже отвалился!

Вот ещё контроллер от компании, которая теперь называется по-другому:

Кстати, до сих пор ни разу не видел ни одного битого контроллера с 2013 года. Диски летят регулярно, но это расходник. А вот контроллеры делают на века. Как и center plane Симметриксов, к слову, но вот её-то я как раз видел на замену. Напомню, там полутораметровая текстолитовая плата, вокруг которой построена стойка. И чтобы её поменять (что по задумке создателей делать не придётся никогда в жизни), нужно разобрать примерно всё и заодно ещё отогнуть в одном месте заземление. Именно тогда я узнал новые границы русского мата: мой коллега, который выяснил, что именно ему предстоит менять, матерился на всём протяжении процесса, и первые полчаса — без повторов.

А вторая история — почему именно с 2013-го. Дело в том, что тогда было солнечное затмение. Его даже в Москве можно было видеть. Мы в то время обслуживали EMC. Обычно за год бывает один-два случая, когда в RAID 5 вылетает два диска сразу. Это ситуация предсказуемая, и из их массива можно сохранить данные. Но полтора месяца было по три-четыре случая в неделю, причём вылетали сразу и диски, и оперативка. И именно тогда дохли единичные контроллеры. Помню, как мы смеялись ещё раньше над сановскими кодами ошибок про космическое излучение, но вот пригодились же.

Вот здесь модель подставки предлагаю вам определить самостоятельно:

Похожие подставки устанавливались в ещё одну эпичную железяку IBM 306 в 2007 году: у неё материнская плата собиралась из пяти частей с разъёмами. Мы её называли «чёртов конструктор». Другой «чёртов конструктор» — это был Violin, который некоторое время бесил нас в облаке. В теории с массивами всё было хорошо, очень правильная архитектура, современные подходы, отказ от оверхеда жёстких дисков… На практике сейлзы сказали нам, что пара заказчиков не хочет заходить в наше облако, потому что знает, что у нас Виолины, а у них были такие же. В итоге мы вскоре заменили их на делловские системы. Те обычно не преподносят неприятных сюрпризов.

Кстати, один из наших ЦОДов. Мы на нём испытывали защитную капсулу-шлюз, которая должна была пропускать админов по одному. Так вот, из-за неё главный архитектор не мог попасть внутрь. Дело в корейской системе стандартов. Наш архитектор был мужиком под 2 метра ростом и в самом расцвете сил. Корейские инженеры же даже представить себе не могли, что один человек может столько весить. С их точки зрения, в капсулу пыталось пройти два человека, что категорически делать нельзя.

Поскольку я больше про массивы, расскажу лучший известный случай из практики, где человеческая паника победила. Итак, 31 декабря, банк, тесты генератора перед новым годом, чтобы если что — 3 января не остаться без питания. Команда его погоняла, убедилась, что всё хорошо, но забыла заправить. 2 января в ЦОДе выключили питание, и они штатно перешли на генераторы. Хайэндовый массив очень крутой, он может штатно пережить два выключения питания. При пропадании луча он перешёл на свои внутренние батареи, корректор раскидал кеш, завершил все сессии и лёг спать. Включается генератор, всё поднимается, массив продолжает работать. Через час в генераторе кончается горючка, снова всё отключается. Массив хайэндовый, все дела. Батареи, раскидать кеш, корректное завершение, штатный офлайн. Местные админы паникуют и включают батареи — массив включается. Батареи кончаются через 40 минут. Батареи массива зарядиться не успели. Массив в хламину, никаких целых данных на нём больше нет, заказчик в восторге, а я в особенном, потому что полетел на другой край страны из деревни под Тулой.

Кстати, лететь с кусками массива отдельное удовольствие. Сначала ты объясняешь охране аэропорта, что эти коробки ты открывать не будешь и в сканер не положишь. Потом — на стойке, почему у тебя два билета и на втором полетит микросхема. Потом ещё раз диалог с охраной. Потом объясняешь пассажиру рядом, что вот эту штуку трогать не надо. Потом два бортпитания — мне и контроллеру. К счастью, накладные с суммой 40-60 тысяч долларов за плату действуют достаточно убедительно.

Хотя, конечно, этот случай с генератором — это не так эпично, как когда заказчик узнал на тестировании питания ЦОДа, что на монтаже кто-то перепутал фазу и ноль в одном критичном узле.

А, да, и у нас один раз массив играл в Монте-Кристо. Дисковый шкаф на 16 свинцовых батарей по 22 килограмма и 190 дисков, около 1800 килограмм итого. Его закатили в ЦОД, поставили, а дальше стойка в течение примерно трёх минут плавно уходила под фальшпол, прогибая всё вокруг.

Точнее, это ячейка хайэндового дискового массива, представляющая нечто вроде оперативной памяти, но в центре архитектуры Симметрикса

Еще увидели знакомую старую железяку — VNX1. Она интересна не столько гениальной по тем временам архитектурой, сколько тем, как мы однажды разбирали последствия переезда такого массива с этажа на этаж по офису заказчика. Представьте ситуацию: они там четыре года делали проект по госконтракту, который хранился в виде единственной копии на массиве. И решили перевезти железку, не позвав админа, потому что железяка была старая (на три поколения древнее, чем та древность, от которой кеш-плата на фотографии) и сошла с поддержки. Для упрощения переезда решили вынуть все диски, потому что без них стойка получалась легче. Как вы догадываетесь, вопрос только один: что вообще могло в этой истории пойти ТАК?

Железяка имеет физическую адресацию дисков по номеру слота. Слоты для дисков бывают двух типов: рейд-группы массива (большая часть) и диски горячей замены. Массив при втыкании дисков обратно увидел, что это его диски, но начал ругаться на нарушенную адресацию красными лампочками. Местный админ начал подбирать комбинацию из дисков, надеясь, что если угадать с перестановками, лампочки погаснут и всё заведётся. Потому что про многомиллионный проект уже начали задавать неудобные вопросы.

Подстава заключалась только в том, что при втыкании диска в слот горячей замены массив не ворчал на него, а говорил: «О, новый жёсткий диск» и молча его форматировал, и начинал в него что-то писать.

Всего заказчик успел попробовать около 20 рекомбинаций из 200 дисков, из которых девять пришлось на установку новых дисков с данными в слоты горячей замены.

Массив VNX

Что вообще могло пойти так?

Итак, к 20-й перестановке, к счастью, они поняли, что что-то идёт не так. Позвали нас собирать массив обратно. На тот момент заказчику казалось, что дело просто в том, что нужно правильно расставить диски, коварство массива с очисткой данных они сильно недооценили.

Когда мы чуточку разобрались в ситуации и рассказали, что же именно они сделали, эти лица надо было видеть. Знаете картину «Крик» Мунка? Все думают, что там главный герой кричит, но если присмотреться, можно заметить, что он всеми силами старается выровнять давление в черепе после шокирующего воздействия окружающей среды. То есть крик — это всё вокруг, а он просто жертва. Вот так же выглядели те, кто не сделал бекап.

К счастью, у истории хороший финал — один из немногих в играх на рекомбинацию против бездушных массивов. Как я уже сказал, к моменту нашего приезда они успели грохнуть девять дисков и частично записать на них технические данные. К счастью, по какому-то невероятному для них совпадению, это были диски из разных (!) рейд-групп, то есть каждый раз сохранялась избыточность. Парни несколько раз подряд выиграли в русскую рулетку с пистолетом, а не револьвером.

Мы подготовили и расставили все диски, включили массив, он подцепился (ни один диск в переезде не пострадал) и спокойно начал ребилд. Дальше появился полный доступ к консистентным и полным данным. Заказчики отняли руки от головы.

Мораль истории: массивы могут быть коварны.

А компоненты для таких коварных массивов, используемых в госконтрактах, мы всё ещё храним. Некоторым железякам ЗИПа больше 20 лет, относительно недавно, например, ушёл последний из нашего запаса 486-й процессор в АСУ ТП-компьютер на заводе, управляющий станком. Когда сломается и он, наверное, клиенты сделают апгрейд.

Ещё железо

Но давайте покажу ещё несколько интересных железок у нас на хранении. Склад выглядит вот так вообще:

Вот компаковские сервера:

Когда я приходил на работу в КРОК в 2008 году, они уже были старые — ну, вы можете это понять по тому, как написано название компании HP на их корпусе.

Вот тут видно прогресс, вместо одного Pentium III там стало два или даже четыре процессора. Обратите внимание, эти сервера запирались на замок

Вот обычный сервер IBM. Такие серваки в принципе вообще не изменились внешне. Он примечателен тем, что не примечателен вообще ничем.

Собственно, он как был железкой смутного назначения, так и остался, только теперь на новых написано Lenovo.

А вот это уже штука хитрее, но всё так же смутна:

Это P-серия блейдов HP. Я видел её только в лабораториях и в ЗИПе, но никогда — в проде. Никто из моих знакомых и коллег тоже не видел её в проде. Если вы вдруг знаете, с чем она конкурировала и для чего была незаменима, — скажите, пожалуйста, но вместо неё в проде всегда стояло что-то другое. Но такая штука существовала, вот доказательство.

А это динозавр из эпохи, когда Sun были отдельной компанией. Внутри был один из последних классических RISC-процессоров без довешивания фич. На топовых серверах этой линейки можно было менять оперативную память в онлайн-режиме, а на самых крутых — процессоры. Правда, я обслуживал только младшие сервера линейки и так ни разу не делал. На практике всегда было проще потушить сервер, сделать замены и вернуть его в бой — на этом же сходились все инженеры, которые обслуживали это железо. Железяка связана у меня с большой обидой, потому что я обслуживал похожие (в ЗИПе 440 и 240, я работал с 290) полгода, а дальше должен был ехать на повышение квалификации учиться в ЮАР. Но в солнечную страну я так и не поехал, потому что Sun разорился. Потом съездил в Америку и Германию от EMC и Хитачи, но пингвинов и львов так и не увидел.

А это ленточные библиотеки. Выглядят достаточно старомодно, но современные модели принципиально ничем не отличаются от моделей 20-летней давности. Собственно, вендор это тоже заметил. Наверное, поэтому поменял цвет панелей по бокам, чтобы отличать новые от старых. Отлично работают много где по стране, на них чаще всего хранится бекап Судного дня.

Кстати, про бекап Судного дня. Был у нас потрясающий случай с Симметриксами на заводе. Два массива в синхронизации, но у одного при перепланировании электрики в здании отключили дисковый шкаф. Просто взяли и увели все диски в офлайн. Что характерно, заметили только через полтора года — дело в том, что эти массивы очень коварные и самостоятельные. В случае отказа локальных дисков они присылают админу личное письмо и идут смотреть, что в синхронной реплике. Заказчик купил обновление массива, приезжает инженер ставить обновление. Мы вдвоём заходим в серверную — а серверный шкаф выключен. Полтора года работал без дисков, ни единой ошибки. Данные в порядке. Стали разбираться, почему нет писем — оказалось, при заведении почты вместо .ru указали .ri. Шкаф включили, массив его примерно неделю ребилдил, потом продолжил работать.

Это древнющий свитч, который вымер, кажется, под тысячу лет назад, но у нас лежит и кого-то ждёт. С учётом, что недавно была перепись предпокойников по стране, это означает, что его прод-коллега всё ещё трудится на заводе где-нибудь в Сибири и радует простых сибирских мужиков нормальными разъёмами. Они там были крупные.

Кстати, про разъёмы со свитчами. В одной крупной серверной один раз админ заказчика увидел свободно висящий из свитча кабель и воткнул его обратно (чем запустил слияние двух фабрик и оторвал все диски от всех фабрик внутри ЦОДа). Или вот другая история произошла пару лет спустя — кабель (уже питания) свисал из сервера, и втыкание его обратно вызвало очень быструю цепочку событий, которые привели к отключению подстанции. Что в обоих случаях заставляло людей так обращаться с железом, мы не знаем. У нас нет админопсихологов.

А это первый лоуэндовый массив HP из известных мне, который смог Fibre Channel. А выше него лежат контроллеры старой-старой EVA — это была суперпродвинутая линейка для своего времени. Делалась она с той архитектурой, которая стала современной существенно позже, по функционалу тоже было круто. HP вообще очень многие интересные проекты закрыл, потому что здесь и сейчас они не приносили денег или чего-то ещё — это были процессоры Альфа (DEC), кластеры VAX, эти вот массивы и так далее.

С массивами самая частая роковая ошибка — выбрать не то направление репликации, я пару раз на такое выезжал. Но один раз было ещё круче. Звонит заказчик, говорит: «Всё плохо, массив недоступен, паника-паника». Я смотрю на интерфейс управления массивом — все LUN’ы в онлайне, всё зелёное. Говорю: «Друзья, давайте соберёмся и проверим пункт 1 таких тикетов: об одном ли мы массиве говорим». Утверждают, что о том. Присылают свои логи — всё офлайн. Я смотрю — снова всё онлайн, в интерфейсе чисто. Говорю: «Друзья, это странно, в такой ситуации надо взять паузу и разобраться». Заказчик же паникует, хочет срочно — и отдаёт команду на перезагрузку массива. А дальше гениальная фраза:

— Ой! А у нас второй массив тоже отвалился!

Вот ещё контроллер от компании, которая теперь называется по-другому:

Кстати, до сих пор ни разу не видел ни одного битого контроллера с 2013 года. Диски летят регулярно, но это расходник. А вот контроллеры делают на века. Как и center plane Симметриксов, к слову, но вот её-то я как раз видел на замену. Напомню, там полутораметровая текстолитовая плата, вокруг которой построена стойка. И чтобы её поменять (что по задумке создателей делать не придётся никогда в жизни), нужно разобрать примерно всё и заодно ещё отогнуть в одном месте заземление. Именно тогда я узнал новые границы русского мата: мой коллега, который выяснил, что именно ему предстоит менять, матерился на всём протяжении процесса, и первые полчаса — без повторов.

А вторая история — почему именно с 2013-го. Дело в том, что тогда было солнечное затмение. Его даже в Москве можно было видеть. Мы в то время обслуживали EMC. Обычно за год бывает один-два случая, когда в RAID 5 вылетает два диска сразу. Это ситуация предсказуемая, и из их массива можно сохранить данные. Но полтора месяца было по три-четыре случая в неделю, причём вылетали сразу и диски, и оперативка. И именно тогда дохли единичные контроллеры. Помню, как мы смеялись ещё раньше над сановскими кодами ошибок про космическое излучение, но вот пригодились же.

Вот здесь модель подставки предлагаю вам определить самостоятельно:

Похожие подставки устанавливались в ещё одну эпичную железяку IBM 306 в 2007 году: у неё материнская плата собиралась из пяти частей с разъёмами. Мы её называли «чёртов конструктор». Другой «чёртов конструктор» — это был Violin, который некоторое время бесил нас в облаке. В теории с массивами всё было хорошо, очень правильная архитектура, современные подходы, отказ от оверхеда жёстких дисков… На практике сейлзы сказали нам, что пара заказчиков не хочет заходить в наше облако, потому что знает, что у нас Виолины, а у них были такие же. В итоге мы вскоре заменили их на делловские системы. Те обычно не преподносят неприятных сюрпризов.

Кстати, один из наших ЦОДов. Мы на нём испытывали защитную капсулу-шлюз, которая должна была пропускать админов по одному. Так вот, из-за неё главный архитектор не мог попасть внутрь. Дело в корейской системе стандартов. Наш архитектор был мужиком под 2 метра ростом и в самом расцвете сил. Корейские инженеры же даже представить себе не могли, что один человек может столько весить. С их точки зрения, в капсулу пыталось пройти два человека, что категорически делать нельзя.

Ещё байки

Поскольку я больше про массивы, расскажу лучший известный случай из практики, где человеческая паника победила. Итак, 31 декабря, банк, тесты генератора перед новым годом, чтобы если что — 3 января не остаться без питания. Команда его погоняла, убедилась, что всё хорошо, но забыла заправить. 2 января в ЦОДе выключили питание, и они штатно перешли на генераторы. Хайэндовый массив очень крутой, он может штатно пережить два выключения питания. При пропадании луча он перешёл на свои внутренние батареи, корректор раскидал кеш, завершил все сессии и лёг спать. Включается генератор, всё поднимается, массив продолжает работать. Через час в генераторе кончается горючка, снова всё отключается. Массив хайэндовый, все дела. Батареи, раскидать кеш, корректное завершение, штатный офлайн. Местные админы паникуют и включают батареи — массив включается. Батареи кончаются через 40 минут. Батареи массива зарядиться не успели. Массив в хламину, никаких целых данных на нём больше нет, заказчик в восторге, а я в особенном, потому что полетел на другой край страны из деревни под Тулой.

Кстати, лететь с кусками массива отдельное удовольствие. Сначала ты объясняешь охране аэропорта, что эти коробки ты открывать не будешь и в сканер не положишь. Потом — на стойке, почему у тебя два билета и на втором полетит микросхема. Потом ещё раз диалог с охраной. Потом объясняешь пассажиру рядом, что вот эту штуку трогать не надо. Потом два бортпитания — мне и контроллеру. К счастью, накладные с суммой 40-60 тысяч долларов за плату действуют достаточно убедительно.

Хотя, конечно, этот случай с генератором — это не так эпично, как когда заказчик узнал на тестировании питания ЦОДа, что на монтаже кто-то перепутал фазу и ноль в одном критичном узле.

А, да, и у нас один раз массив играл в Монте-Кристо. Дисковый шкаф на 16 свинцовых батарей по 22 килограмма и 190 дисков, около 1800 килограмм итого. Его закатили в ЦОД, поставили, а дальше стойка в течение примерно трёх минут плавно уходила под фальшпол, прогибая всё вокруг.